面试 知识点

1 2 3 4 5 6 7 8 9 10 11 12 13 14 15 16 17 18 19 20 21 22 23 24 25 26 27 28 29 | # Muti-head Attention 机制的实现from math import sqrtimport torchimport torch.nnclass Self_Attention(nn.Module): # input : batch_size * seq_len * input_dim # q : batch_size * input_dim * dim_k # k : batch_size * input_dim * dim_k # v : batch_size * input_dim * dim_v def __init__(self,input_dim,dim_k,dim_v): super(Self_Attention,self).__init__() self.q = nn.Linear(input_dim,dim_k) self.k = nn.Linear(input_dim,dim_k) self.v = nn.Linear(input_dim,dim_v) self._norm_fact = 1 / sqrt(dim_k) def forward(self,x): Q = self.q(x) # Q: batch_size * seq_len * dim_k K = self.k(x) # K: batch_size * seq_len * dim_k V = self.v(x) # V: batch_size * seq_len * dim_v atten = nn.Softmax(dim=-1)(torch.bmm(Q,K.permute(0,2,1))) * self._norm_fact # Q * K.T() # batch_size * seq_len * seq_len output = torch.bmm(atten,V) # Q * K.T() * V # batch_size * seq_len * dim_v return output<br><br><br>self-attention核心是生成一个seq_len*seq_len的矩阵,第n行的seq_len个值代表该第n个word和其他word的权重值序列 |

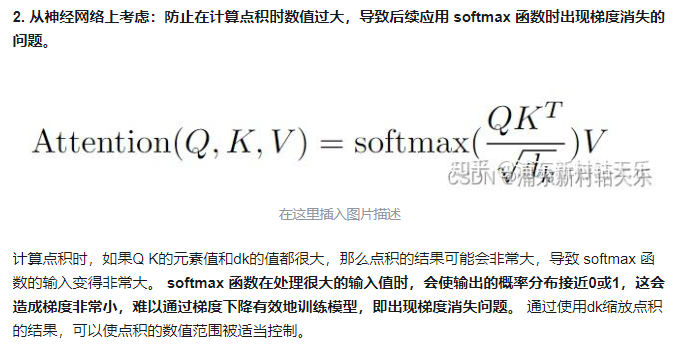

BN在train和test的区别

批归一化(Batch Normalization,简称BN)是一种用于加速神经网络训练和提高模型稳定性的技术。在训练和测试阶段,BN的行为有所不同,主要区别在于均值和方差的计算方式以及模型的表现。

训练阶段

-

计算均值和方差:

- 在训练过程中,BN会对每个小批量(mini-batch)计算其均值和方差。这是因为训练时数据是分批处理的,每个批次的数据分布可能有所不同。

-

归一化:

- 使用计算得到的当前批次的均值和方差,对输入数据进行归一化处理。

-

缩放和平移:

- 归一化后的数据通过可学习的缩放参数(gamma)和偏移参数(beta)进行缩放和平移。这些参数在训练过程中被优化。

-

移动平均:

- 为了在测试阶段使用,BN在训练过程中会维护一个全局的均值和方差的移动平均。这些移动平均值是基于每个批次的均值和方差计算得到的。

测试阶段

-

固定均值和方差:

- 在测试阶段,BN不再计算批次的均值和方差,而是使用训练阶段计算得到的全局移动平均的均值和方差。这是因为测试数据通常是单一样本或小批量样本,直接计算其均值和方差可能不稳定。

-

归一化:

- 使用训练过程中积累的全局均值和方差对输入数据进行归一化处理。

-

缩放和平移:

- 继续使用训练得到的缩放参数(gamma)和偏移参数(beta)对数据进行调整。

为什么有这些区别?

- 稳定性:在测试阶段,使用全局均值和方差可以确保每个样本的归一化是稳定的,不受批次大小和样本顺序的影响。

- 一致性:使用训练阶段的统计信息可以确保模型在测试时的行为与训练时一致,避免因单个样本的极端值而导致的不稳定。

训练过程为什么需要 Mask 机制?

两个原因。 1. 屏蔽未来信息,防止未来帧参与训练。 2. 处理不同长度的序列,在批处理时对较短的序列进行填充(padding),并确保这些填充不会影响到模型的输出。

mask机制如何实现?

1. 屏蔽未来信息的 Mask:在自注意力层中,通过构造一个上三角矩阵(对于解码器),其中上三角部分(包括对角线,取决于具体实现)被设置为非常大的负数,这样在通过 softmax 层时,这些位置的权重接近于0,从而在计算加权和时不考虑未来的词。

2. Padding Mask:将填充位置的值设置为一个大的负数,使得经过 softmax 层后,这些位置的权重接近于0。

链接:https://zhuanlan.zhihu.com/p/682585974

来源:知乎

著作权归作者所有。商业转载请联系作者获得授权,非商业转载请注明出处。

6 Transformer 中的Positional Encoding有什么作用?

保证attention机制考虑序列的顺序,否则无法区分不同的位置的相同的输入。

7 Transformer 如何处理长距离依赖问题?

Transformer 通过自注意力机制直接计算序列中任意两个位置之间的依赖关系,从而有效地解决了长距离依赖问题。

8 Layer Normalization的作用是什么?

Layer Normalization有助于稳定深层网络的训练,通过对输入的每一层进行标准化处理(使输出均值为0,方差为1),可以加速训练过程并提高模型的稳定性。它通常在自注意力和前馈网络的输出上应用。

9 能否用Batch Normalizatioin?

在 Transformer 架构中,层归一化(Layer Normalization,简称 LayerNorm)是首选的归一化方法,主要用于模型内部的每一层之后。理论上,层归一化可以被批归一化(Batch Normalization,简称 BatchNorm)替换,但是这两种归一化技术在应用上有着本质的不同,这些差异导致了在 Transformer 中通常优先选择层归一化而不是批归一化。

层归一化(Layer Normalization)

- 层归一化是对每个样本的所有特征执行归一化操作,独立于其他样本。这意味着,无论批次大小如何,LayerNorm 的行为都是一致的。

- 在处理序列数据和自注意力机制时,LayerNorm 更加有效,因为它能够适应不同长度的输入,这在自然语言处理任务中尤为重要。

- LayerNorm 直接在每个样本的维度上工作,使得它在序列长度变化的情况下更为稳定。

批归一化(Batch Normalization)

- 批归一化是在一个小批量的维度上进行归一化,这意味着它依赖于批次中所有样本的统计信息。因此,BatchNorm的行为会随着批次大小和内容的变化而变化,这在训练和推理时可能导致不一致的表现。

- 在处理变长序列和自注意力结构时,BatchNorm可能不如 LayerNorm 高效,因为变长输入使得批次间的统计信息更加不稳定。

- BatchNorm在训练时计算当前批次的均值和方差,在推理时使用整个训练集的移动平均统计信息。这种依赖于批次统计信息的特性使得 BatchNorm在小批量或在线学习场景中表现不佳。

<think>

嗯,我现在需要回答这七个关于多模态大模型和相关技术的问题。这对我来说有点挑战,但我会尽力理解和回答。

首先,问题1是介绍CLIP。CLIP是由OpenAI开发的,主要用于将图像和文本进行对齐的模型。我记得它通过对比学习,训练模型使图像和文本嵌入接近。它可以实现零样本学习,这很酷。但我不太确定它的具体结构和训练细节,可能需要查一下资料。

问题2是关于LoRA和微调的原理。LoRA是一种参数效率的微调方法,通过在模型的每一层添加低秩矩阵来调整权重。这样可以在不增加太多参数的情况下进行微调。但具体的原理我还不太清楚,可能需要理解一下LoRA的工作机制。

问题3是了解哪些多模态大模型,简要介绍几个。比如CLIP、BLIP、LLAMA、GPT等。每个模型的特点和应用场景可能需要简单说明。

问题4是关于BLIP的三个损失函数和数据清洗方法。我记得BLIP有三个损失函数,分别用于不同的任务,比如图像描述、视觉问答和图像_captioning。但具体的损失函数是什么,还有数据是如何清洗的,我需要详细回忆一下。

问题5是BLIP2和BLIP3相对于BLIP的改进。BLIP2可能在模型结构或训练数据上有所改进,而BLIP3可能进一步优化。需要了解具体的改进点。

问题6是关于在视觉编码器和LLM连接时,使用BLIP2中的Q-Former还是LLaVA中的简单MLP更好。需要分析两种方法的优缺点,考虑模型复杂度、性能等因素。

问题7是实现多头自注意力机制的代码。这需要理解自注意力机制的工作原理,并用代码实现多头并行计算。

在回答这些问题的时候,我需要确保每个部分都准确无误,并且尽量详细。如果有不确定的地方,可能需要查阅相关资料来确认。

</think>

以下是对您提出的七个问题的详细解答:

---

### 1. 介绍一下 CLIP

**CLIP(Contrastive Language–Image Pretraining)** 是由 OpenAI 开发的多模态模型,旨在将图像和文本进行对齐。CLIP 通过对比学习,使图像和文本嵌入到同一个latent空间中,从而实现跨模态检索和理解。

**主要特点:**

- **对比学习**:CLIP 同时处理图像和文本,通过对比损失函数,学习到图像和文本之间的关联。

- **零样本学习**:CLIP 可以在没有特定任务训练数据的情况下,直接进行图像分类、文本检索等任务。

- **大规模预训练**:CLIP 使用了大量的图像-文本对进行预训练,使其具备强大的跨模态表示能力。

**应用场景:**

- **图像检索**:根据文本查询相关图像。

- **图像描述**:根据图像生成描述性文本。

- **多模态生成**:结合图像和文本生成内容。

---

### 2. 了解 LoRA 吗,LoRA 微调的原理是什么

**LoRA(Low-Rank Adaptation)** 是一种参数高效的模型微调方法,特别适用于大规模预训练模型的适应性微调。

**LoRA 的原理:**

- **低秩矩阵**:在模型的每一层,添加两个低秩矩阵(通常是行矩阵和列矩阵)来调整权重。这些矩阵的参数数量相对于原模型参数较少。

- **参数效率**:通过低秩矩阵降低参数规模,使得微调过程所需的计算资源和存储空间减少。

- **灵活性**:LoRA 可以在不同的层级应用,允许对模型的不同部分进行不同程度的调整。

**微调过程:**

1. **加载预训练模型**:使用一个预训练的模型作为基础。

2. **插入 LoRA 层**:在模型的每一层(如 transformer 层)中插入 LoRA 的低秩矩阵。

3. **微调训练**:在目标任务的数据集上进行微调训练,只更新 LoRA 层的参数,而保持原模型参数不变或微调。

4. **推理**:使用微调后的模型进行推理,实现更好的任务适应性。

---

### 3. 了解哪些多模态大模型,简要介绍几个

以下是几个知名的多模态大模型:

1. **CLIP(OpenAI)**

- **特点**:专注于图像-文本对齐,支持零样本学习。

- **应用**:图像检索、文本检索、图像描述。

2. **BLIP(Salesforce)**

- **特点**:集成了多种任务,如图像描述、视觉问答、图像检索等。

- **应用**:多任务视觉-语言理解。

3. **LLAMA(Meta)**

- **特点**:专注于语言模型,但也支持多模态扩展。

- **应用**:文本生成、对话系统。

4. **GPT(OpenAI)**

- **特点**:虽然主要是语言模型,但在 GPT-4 中引入了多模态能力。

- **应用**:文本生成、对话系统、多模态任务。

---

### 4. BLIP 的三个损失函数分别是什么,数据是怎样清洗的

**BLIP 的三个损失函数:**

1. **图像描述损失(Image Captioning Loss)**:

- **目标**:学习从图像生成描述性文本。

- **方法**:使用掩码语言建模,预测被遮住的词。

2. **视觉问答损失(Visual Question Answering Loss)**:

- **目标**:回答关于图像的问题。

- **方法**:通过多选题或开放题回答问题。

3. **图像检索损失(Image Retrieval Loss)**:

- **目标**:学习图像和文本之间的对齐。

- **方法**:对比学习,优化图像和文本嵌入的相似性。

**数据清洗方法:**

1. **数据筛选**:过滤低质量的图像和文本数据。

2. **去重**:删除重复的样本。

3. **格式化**:统一数据格式,确保每个样本包含图像和对应的文本。

4. **分词和处理**:对文本进行分词和预处理,优化模型输入。

---

### 5. BLIP2 相对于 BLIP 有哪些改进,BLIP3 又有哪些改进

**BLIP2 的改进:**

1. **更大规模的训练数据**:增加了更多的多模态数据,提升模型的泛化能力。

2. **优化的模型架构**:调整了网络结构,提高了计算效率和性能。

3. **新的任务集成**:增加了更多的多模态任务,如图像生成等。

**BLIP3 的改进:**

1. **进一步扩大数据集**:引入更丰富的多模态数据,提升模型的鲁棒性。

2. **引入更先进的训练方法**:采用更有效的训练策略,如更复杂的数据增强和优化算法。

3. **性能提升**:在多个基准测试中表现更优,特别是在复杂任务上的提升明显。

---

### 6. 视觉编码器和 LLM 连接时,使用 BLIP2 中 Q-Former 的复杂适配器好,还是 LLaVA 中简单的 MLP 好,各自的优缺点

**BLIP2 的 Q-Former:**

- **优点**:

- 能够捕捉复杂的上下文关系,提升模型的表示能力。

- 在处理多模态信息时,表现出更好的对齐能力。

- **缺点**:

- 结构复杂,增加了计算开销,可能影响推理速度。

- 需要更多的计算资源和内存,可能不适合资源受限的环境。

**LLaVA 中的简单 MLP:**

- **优点**:

- 结构简单,计算高效,适合实时应用和资源有限的场景。

- 易于实现和部署,维护成本较低。

- **缺点**:

- 在捕捉复杂上下文关系方面可能不如 Q-Former,可能影响模型的表现能力。

**总结:**

- **Q-Former** 更适合需要高性能和复杂表示能力的应用,尤其是在资源充足的环境中。

- **简单的 MLP** 则更适合需要快速推理和低资源消耗的场景,适合实时应用或移动端部署。

---

### 7. 实现多头自注意力

多头自注意力(Multi-Head Self-Attention)是 Transformer 架构中的核心组件,用于捕捉序列中不同位置之间的关系。以下是实现多头自注意力的代码示例(以 PyTorch 为例):

1 2 3 4 5 6 7 8 9 10 11 12 13 14 15 16 17 18 19 20 21 22 23 24 25 26 27 28 29 30 31 32 33 34 35 36 37 38 39 40 41 42 43 44 45 46 47 48 49 50 51 52 53 54 55 56 57 58 59 | import torchimport torch.nn as nnimport mathclass MultiHeadSelfAttention(nn.Module): def __init__(self, embed_dim, num_heads): super(MultiHeadSelfAttention, self).__init__() assert embed_dim % num_heads == 0, "embed_dim must be divisible by num_heads" self.embed_dim = embed_dim self.num_heads = num_heads self.head_dim = embed_dim // num_heads # 创建可训练的参数 self.query_linear = nn.Linear(embed_dim, embed_dim) self.key_linear = nn.Linear(embed_dim, embed_dim) self.value_linear = nn.Linear(embed_dim, embed_dim) self.out_linear = nn.Linear(embed_dim, embed_dim) def forward(self, x): # x的形状是 (batch_size, seq_len, embed_dim) batch_size = x.size(0) seq_len = x.size(1) embed_dim = self.embed_dim # 将查询、键、值矩阵进行线性变换 query = self.query_linear(x).view(batch_size, -1, self.num_heads, self.head_dim).transpose(1, 2) key = self.key_linear(x).view(batch_size, -1, self.num_heads, self.head_dim).transpose(1, 2) value = self.value_linear(x).view(batch_size, -1, self.num_heads, self.head_dim).transpose(1, 2) # 计算注意力得分 attention_scores = torch.matmul(query, key.transpose(-1, -2)) * (1.0 / math.sqrt(self.head_dim)) # 应用 softmax 函数 attention_weights = nn.functional.softmax(attention_scores, dim=-1) # 计算加权和 out = torch.matmul(attention_weights, value).transpose(1, 2).contiguous().view(batch_size, seq_len, embed_dim) # 通过输出线性层 out = self.out_linear(out) return out# 示例使用if __name__ == "__main__": embed_dim = 128 num_heads = 4 batch_size = 32 seq_len = 50 # 初始化模型 model = MultiHeadSelfAttention(embed_dim, num_heads) # 创建随机输入 x = torch.randn(batch_size, seq_len, embed_dim) # 前向传播 output = model(x) print("输出形状:", output.shape) |

**代码解释:**

1. **类定义**:`MultiHeadSelfAttention`继承自`nn.Module`,初始化时设置嵌入维度和头数。

2. **线性变换**:分别对查询(Query)、键(Key)、值(Value)进行线性变换。

3. **视图变换和转置**:将变换后的张量重新排列为多头的形式。

4. **注意力得分计算**:通过矩阵乘法计算注意力得分,并缩放。

5. **Softmax 应用**:将得分转换为概率分布,作为注意力权重。

6. **加权和计算**:根据注意力权重加权值,得到最终的注意力输出。

7. **输出线性变换**:将多头的输出合并并通过线性层最终输出。

**注意事项:**

- **维度检查**:确保输入的嵌入维度能被头数整除。

- **设备和数据类型**:确保输入和模型在同一设备(如 GPU)上,数据类型一致。

- **效率优化**:在实际应用中,可以考虑使用高效的矩阵乘法实现或预计算某些部分以加快速度。

通过以上代码,可以实现一个基本的多头自注意力机制,适用于 Transformer 架构中的自注意力计算。

【推荐】国内首个AI IDE,深度理解中文开发场景,立即下载体验Trae

【推荐】编程新体验,更懂你的AI,立即体验豆包MarsCode编程助手

【推荐】抖音旗下AI助手豆包,你的智能百科全书,全免费不限次数

【推荐】轻量又高性能的 SSH 工具 IShell:AI 加持,快人一步

· 【自荐】一款简洁、开源的在线白板工具 Drawnix

· 没有Manus邀请码?试试免邀请码的MGX或者开源的OpenManus吧

· 无需6万激活码!GitHub神秘组织3小时极速复刻Manus,手把手教你使用OpenManus搭建本

· C#/.NET/.NET Core优秀项目和框架2025年2月简报

· DeepSeek在M芯片Mac上本地化部署