模型训练

安装cuda

vim ~/.bashrc

export PATH=/usr/local/cuda/bin:$PATH

export LD_LIBRARY_PATH=/usr/local/cuda/lib64:$LD_LIBRARY_PATH

安装cudnn

sudo cp cudnn-linux-x86_64-8.8.0.121_cuda11-archive/include/cudnn*.h /usr/local/cuda/include/

sudo cp cudnn-linux-x86_64-8.8.0.121_cuda11-archive/lib/libcudnn* /usr/local/cuda/lib64/

sudo chmod a+r /usr/local/cuda/include/cudnn*.h /usr/local/cuda/lib64/libcudnn*

安装pytorch

requirements.txt

protobuf>=3.19.5,<3.20.1

transformers>=4.26.1

icetk

cpm_kernels

gradio

pip3 install --user -r requirements.txt

pip install --user torch==1.10.0+cu111 torchvision==0.11.0+cu111 torchaudio==0.10.0 -f torch-1.10.0+cu111-cp39-cp39-linux_x86_64.whl -f torchvision-0.11.0+cu111-cp39-cp39-linux_x86_64.whl -f torchaudio-0.10.0+cu111-cp39-cp39-linux_x86_64.whl

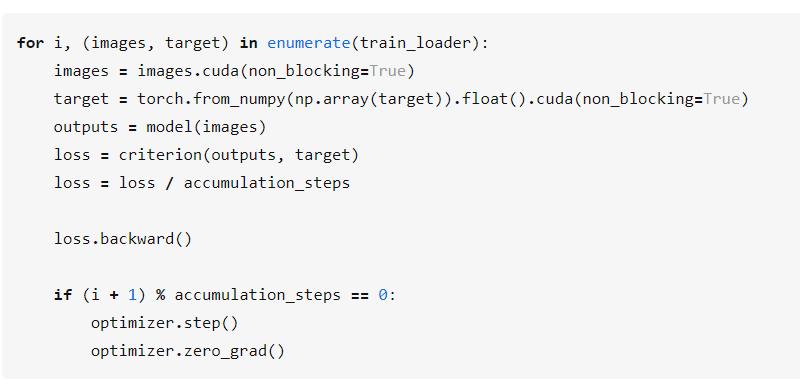

想要大batch训练,又想节省内存的训练方式

有人会问,在上面的代码中为什么不直接对多个

batch的loss先求和然后再取平均、再进行梯度回传和更新呢?按我的理解这是为了减小内存的消耗。当采用多个

batch的loss求和平再均后再回传的方式时,我们会进行accumulation_steps次batch的前向计算,而前向计算后都会生成一个计算图。也就是说,在这种方式下,会生成accumulation_steps个计算图再进行backward计算。而采用上述代码的方式时,当每次的

batch前向计算结束后,就会进行backward的计算,计算结束后也就释放了计算图。又因为这两者计算过程的梯度都是累加的,所以计算结果都是相同的,但是上述的方法在每一时刻中,最多只会生成一张计算图,所以也就减小了计算中的内存消耗。训练加参数:

parser = argparse.ArgumentParser(description='Chinese Text Classification')

parser.add_argument('--model', type=str, required=True, help='choose a model: TextCNN, TextRNN, FastText, TextRCNN, TextRNN_Att, DPCNN, Transformer')

parser.add_argument('--embedding', default='pre_trained', type=str, help='random or pre_trained')

parser.add_argument('--word', default=False, type=bool, help='True for word, False for char')

args = parser.parse_args()

【推荐】国内首个AI IDE,深度理解中文开发场景,立即下载体验Trae

【推荐】编程新体验,更懂你的AI,立即体验豆包MarsCode编程助手

【推荐】抖音旗下AI助手豆包,你的智能百科全书,全免费不限次数

【推荐】轻量又高性能的 SSH 工具 IShell:AI 加持,快人一步

· 震惊!C++程序真的从main开始吗?99%的程序员都答错了

· 【硬核科普】Trae如何「偷看」你的代码?零基础破解AI编程运行原理

· 单元测试从入门到精通

· 上周热点回顾(3.3-3.9)

· Vue3状态管理终极指南:Pinia保姆级教程