数据降维算法总结

在原始的空间中,包含冗余信息以及噪音信息,在实际应用中总会产生误差,降低了准确率,我们希望减少冗余信息所造成的误差,提升识别精度。又或者希望通过降维算法寻找内部的本质结构特征。

数据降维的目的:维度降低便于可视化和计算,深层次的含义在于有效信息的特征提取以及无用信息的抛弃。

线性映射:

PCA以及LDA:

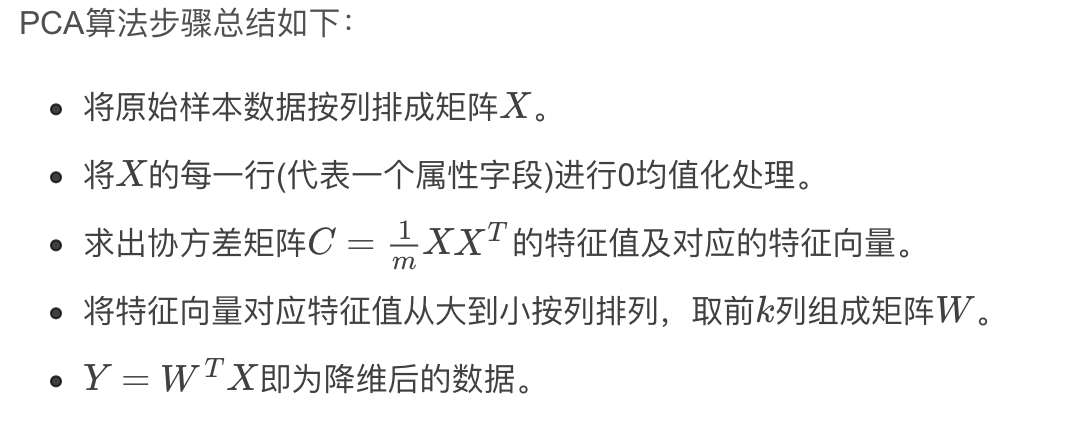

PCA:通过某种线性投影,将高维数据映射到低维空间中,并希望在所投影后的维度数据方差最大,以此使用较少的数据维度,同时保留较多的原始数据点的特性。

协方差矩阵表征了变量之间的相关程度:(维度之间的关系)。

得到的最优的W是数据协方差矩阵前K个最大的特征值对应的特征向量作为列向量构成的。

PCA追求的是在降维之后能够最大化保持数据的内在信息,并通过衡量在投影方向上的数据方差大小来衡量该方向的重要性。

我们希望在每一个维度上的投影点尽可能的分散,这种分散程度可以使用方差进行衡量。

降维的目标是希望在信息不丢失的前提下尽可能的去除一些相关性的字段,方差最大已经保证了尽可能保留更多的原始信息。我们希望降维后的字段能够都不存在相关性,而协方差就是用来度量两个随机变量相关性的参数,协方差为0的两个随机变量称为不相关。

PCA实现目标:将一组n维向量降为k维,其目标是选择k个单位正交基,使得原始数据在变换到这组基上,各字段的两两方差维0,而各字段的方差尽可能大。

优点以及缺点:

优点:最小误差以及提取主要信息

缺点:pca降所有的样本作为一个整体进行看待,去寻找一个均方误差最小意义下的最优线性投影,而忽略了类别属性,而它忽略了投影方向可能刚好包含重要的可分信息。

lda与pca的区别:

前者是有监督的算法,lda是有监督的算法,pca是无监督的。因为pca算法没有考虑到数据的标签问题,只是把原始数据映射到一些方差比较大的方向上去,而lda算法则考虑了数据的标签。所以一般来说,如果我们的数据是有类别标签的,那么优先选择lda去降维,当然也可以使用pca做很小幅度的降维消去噪声,然后再使用lda降维。如果没有类别标签,那么肯定pca是最先考虑的一个选择了。