ceph集群性能测试结果

对ceph存储集群(8台万兆服务器)从以下几个方面进行测试的结果

1、读写稳定性

无故障下的ceph集群性能完全满足业务对磁盘性能的需求。

测试数据结果如下表1-1,1-2

2、业务稳定性

ceph集群出现节点脱离的故障状态时,设置恢复QoS可以有效的保证业务正常运行无中断。

测试数据结果如下表2-1

3、节点故障恢复时间

节点故障的恢复时间依据故障时间段内的新增数据的大小决定,若移除或添加一个11T的节点,并且不做恢复速度限制,那么数据恢复时间大约在6到8小时。

测试数据结果如下表3-1,3-2,4-1

4、对系统资源的使用情况

ceph底层ssd盘起缓存的作用,使用率是随热数据的上升与下沉而变化(测试阶段最高达到70%);SATA盘随着数据的不断写入使用率一直上升。

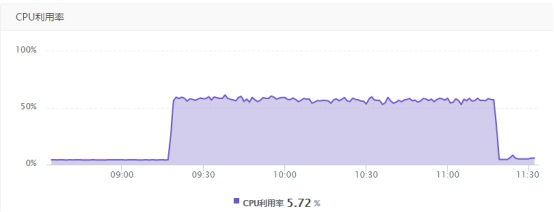

5台业务服务器在进行8k块大小连续2小时并行读写操作时,集群的cpu使用率会升高到50%-80%,内存使用率46.61%基本无波动。

5台业务服务器在进行8k块大小连续2小时并行读写操作时,业务服务器资源内存消耗瞬间增长到7G(总内存8G)随后下降,CPU使用率升高到15%-25%。

测试图标如下5-1,5-2,5-3,5-4

Ceph分布式存储的物理和业务空间使用如下:

裸物理空间349.3TB 已使用的裸物理空间94.8TB

三个副本的总空间116.44T 三个副本已使用的空间31.58TB

ceph的数据存储目前基本都在15%以内,存储超过70%时,业务的性能会少量低下。

1、稳定性(ceph集群无故障)

一个业务的性能表1-1:

|

|

bw(MB/s) |

iops(每秒的读写次数) |

|

randread(磁盘分区未对齐) |

109 |

14032 |

|

randwrite(磁盘分区未对齐) |

75 |

9335 |

|

randwrite(磁盘分区对齐) |

79.71 |

10202 |

5个业务的性能表1-2:

|

|

bw(MB/s)x5 |

iops(每秒的读写次数)x5 |

|

randread(磁盘分区未对齐) |

108 |

13832 |

|

randwrite(磁盘分区未对齐) |

41 |

5190 |

|

randwrite(磁盘分区对齐) |

50.45 |

6457 |

2、业务稳定性(随机写数据为例,数据恢复速度限制,一个业务的性能测试)表2-1

|

|

bw(MB/s) |

iops(每秒的读写次数) |

相比正常测试值下降百分比 |

|

一个节点脱离集群 |

68 |

8442 |

10%-20% |

|

两个节点脱离集群 |

67 |

8281 |

10%-20% |

3、节点故障恢复时间(无业务运行状态下,一个业务性能测试)

表3-1

|

|

读写速度范围(MB/s) |

数据量(T) |

恢复时间(hour) |

|

移除一个节点 |

1100-2200 |

11 |

6 |

|

移除两个节点 |

1100-2200 |

22 |

12 |

表3-2

|

添加移除的一个节点 |

300-500 |

11 |

8 |

|

添加移除的两个节点 |

300-500 |

22 |

13 |

4、关闭数据恢复限制的状态下,5个业务的性能

表4-1

|

|

bw(MB/s)x5 |

iops(每秒的读写次数)x5 |

|

randread |

15.4 |

1969 |

|

randwrite |

7.68 |

983 |

5、系统资源使用情况

Ceph集群内存变化图5-1:

Ceph集群CPU变化图5-2:

业务服务器CPU变化图5-3:

业务服务器内存变化图5-4:

6、数据库备份运行状态下,磁盘分区对业务性能的影响

一个业务的性能2-1:

|

|

bw(MB/s) |

iops(每秒的读写次数) |

|

randwrite(磁盘分区未对齐) |

59.12 |

7567 |

|

randwrite(磁盘分区对齐) |

77.06 |

9863 |

5个业务的性能2-2:

|

|

bw(MB/s)x5 |

iops(每秒的读写次数)x5 |

|

randwrite(磁盘分区未对齐) |

41.37 |

5295 |

|

randwrite(磁盘分区对齐) |

50 |

6400 |