mapreduce 中 map数量与文件大小的关系

学习mapreduce过程中, map第一个阶段是从hdfs 中获取文件的并进行切片,我自己在好奇map的启动的数量和文件的大小有什么关系,进过学习得知map的数量和文件切片的数量有关系,那文件的大小和切片的数量的有什么关系 ,下面我就进入Hadoop的源代码进行研究一下 文件的大小和切片的数量有什么关系。

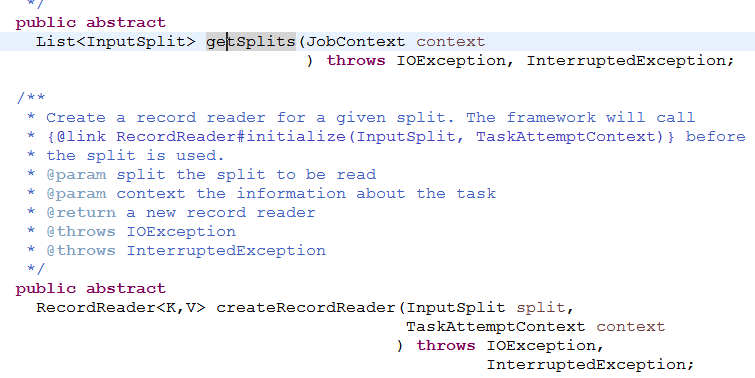

文件获取和切片和一个InputFormat 这个抽象类有关系 ,这个抽象类 只有两个抽象的方法 分别是

第一个方法是用来过去切片,第二方法使用获取文件。获取切片与第一个方法有关,我们进入研究这个方法 那我们看一下这个类的实现类是怎样来实现这个方法的

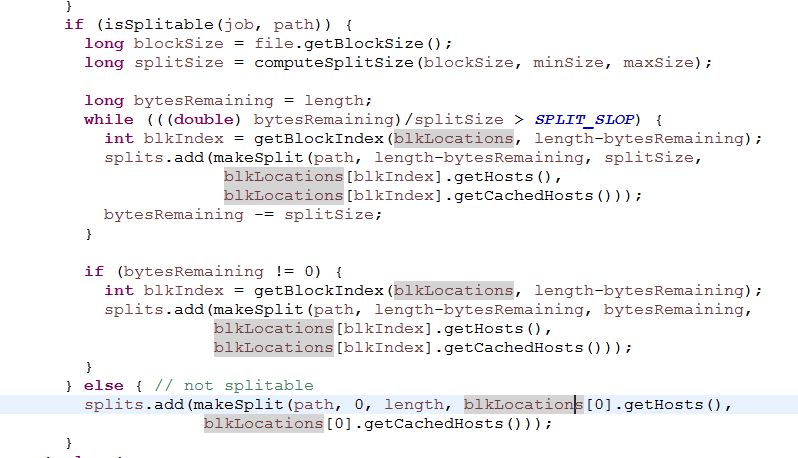

子类的实现方法太长 我们就看和我们相关的东西 来探究文件的大小和切片数量有什么关系

这一部分是用来处理文件大小和切片的关系,blocksize 是就是128M 那个SPLIT_SLOP 那个值是1.1 length 的长度是用来表示文件的长度,那从上面不难看出,如果有一个一个文件的大小与块大小进行求余运算的如果小于12.8的话 那多出来那部分不会重新分配一个切片,会和最后一个切片组成一个切片 也就是说,如果一个129M的文件的话他就会是一个切片而不是两个,我在某些书中看到这个这样的说法 就是如果一个文件的大小与块大小进行相除除不尽的话,就需要多分出一个切片这种说法是不正确的,这要看文件的大小来看,取余小于12.8M的话,那就不会分出一个切片。我想写这个代码的人也是有考虑的如果文件的大小仅仅比一个块多一点而运行一个map 这样是非常浪费资源的,所以会将最后一个切片的大小会进行改变。

浙公网安备 33010602011771号

浙公网安备 33010602011771号