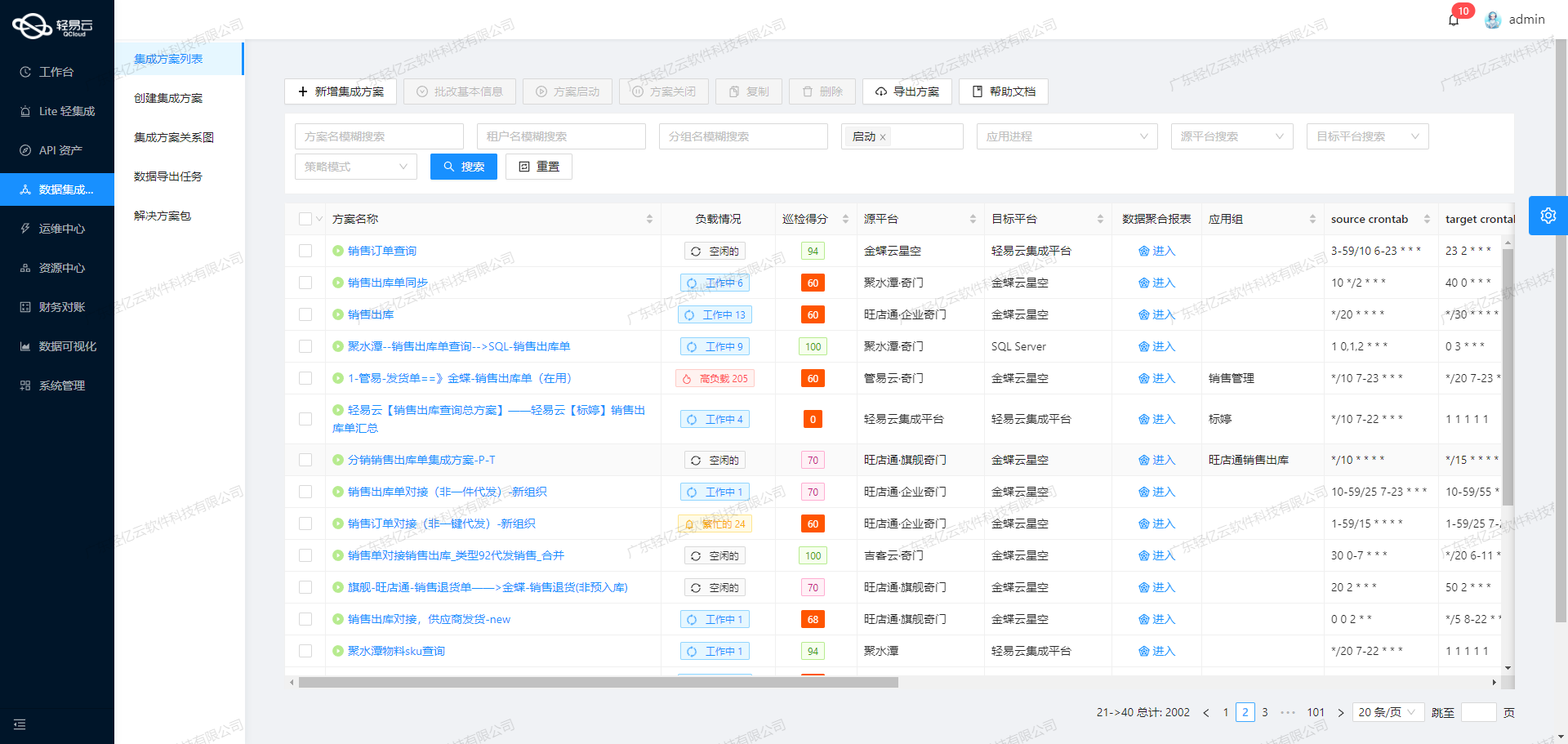

集成平台实现MySQL与金蝶云星空的数据对接

MySQL数据集成到金蝶云星空:SR生产入库单新增-单工序-深圳天一-好

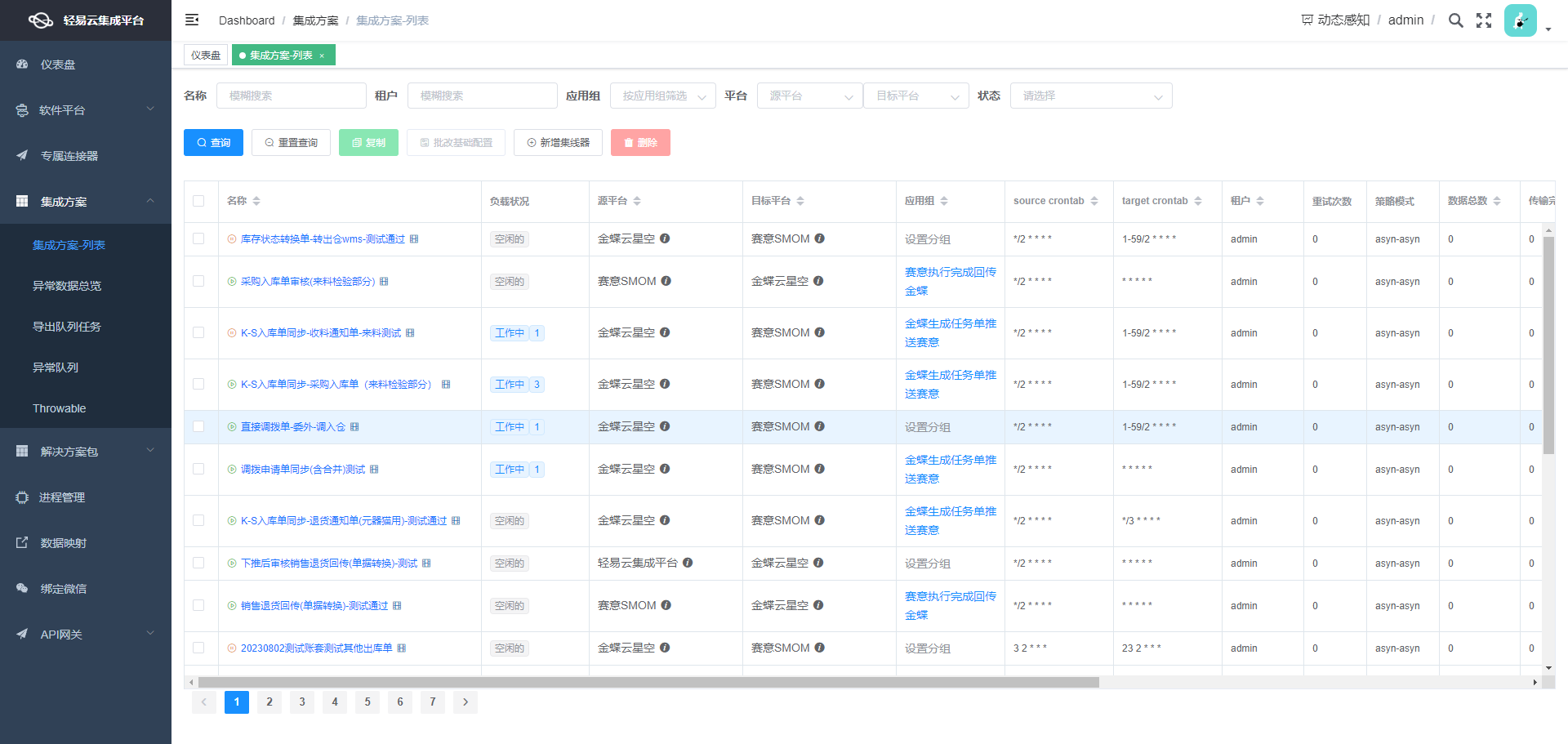

在企业信息化系统中,数据的高效流转和准确对接是确保业务顺畅运行的关键。本文将分享一个实际案例,展示如何通过数据集成平台,将MySQL中的数据无缝集成到金蝶云星空,实现SR生产入库单新增的自动化处理。

本次案例的核心任务是将MySQL数据库中的生产入库单数据,通过API接口select获取后,批量写入到金蝶云星空系统中,并使用其batchSave接口进行存储。为了确保整个过程的高效性和可靠性,我们采用了以下技术方案:

-

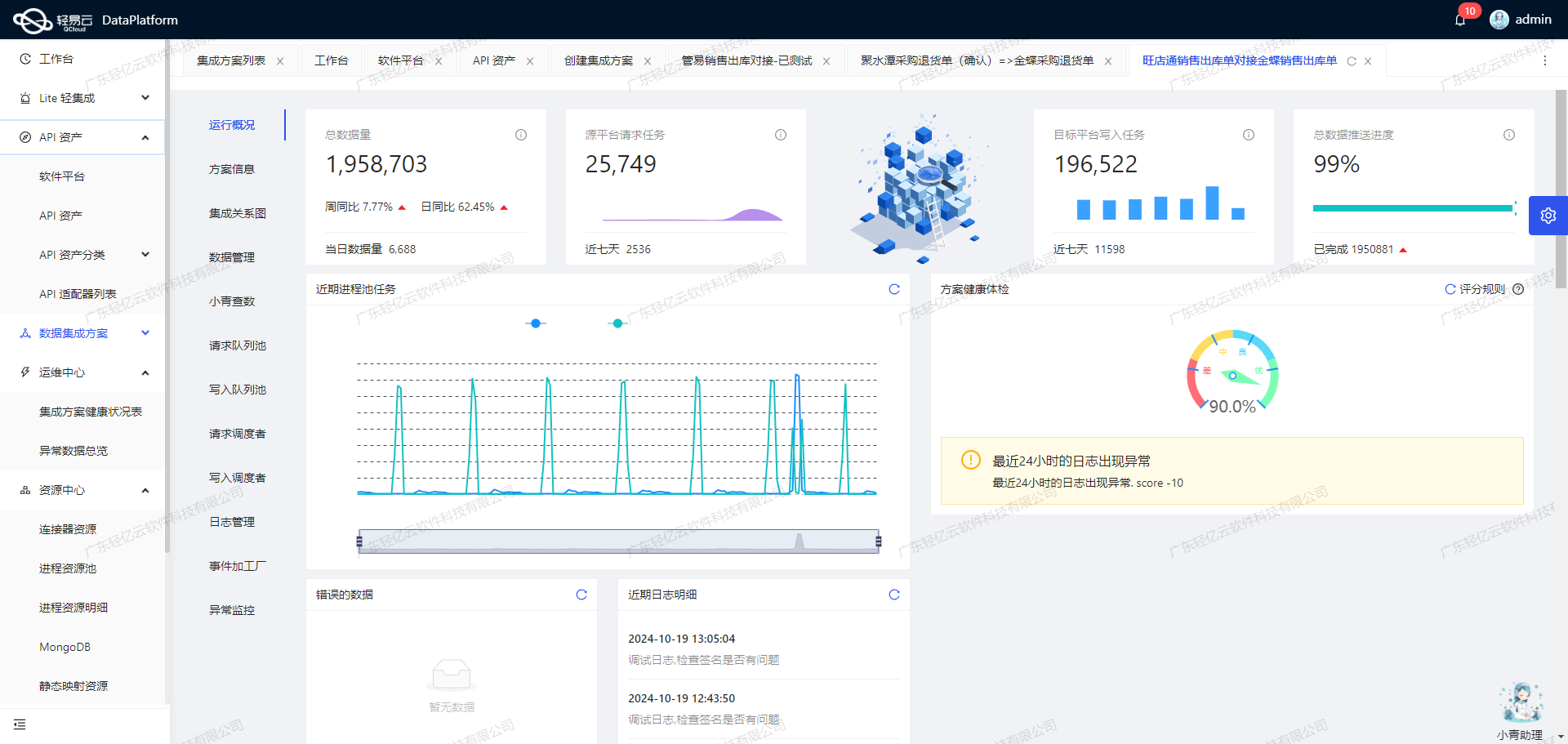

高吞吐量的数据写入能力:在处理大量生产入库单数据时,平台支持高吞吐量的数据写入,使得这些数据能够快速、安全地传输到目标系统中,从而提升整体处理效率。

-

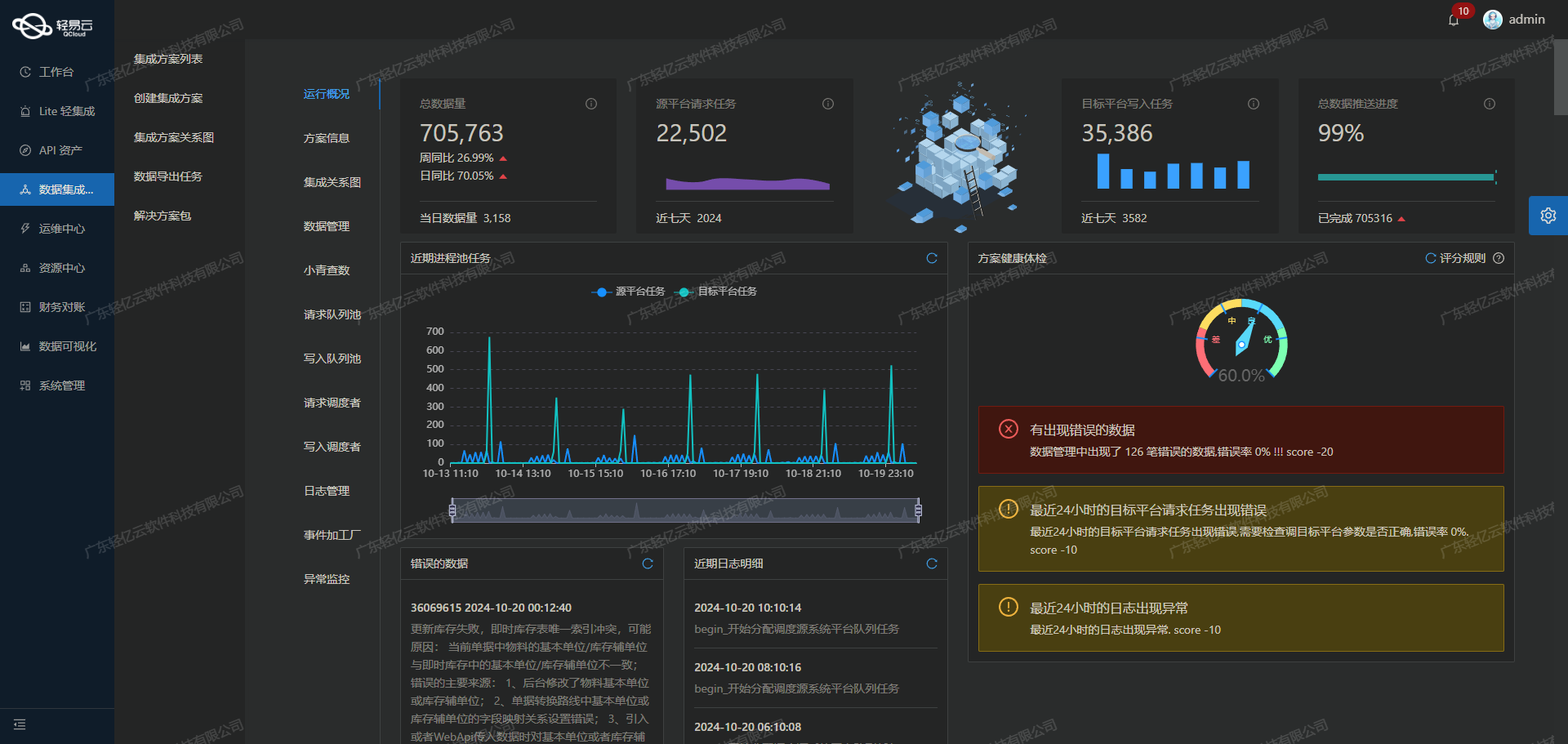

实时监控与告警系统:通过集中式监控和告警功能,我们可以实时跟踪每个数据集成任务的状态和性能。一旦出现异常情况,系统会立即发出告警通知,以便及时采取措施,确保业务不中断。

-

自定义数据转换逻辑:由于MySQL与金蝶云星空之间的数据结构存在差异,我们利用平台提供的自定义转换功能,对数据进行必要的格式转换,以适应目标系统的需求。这一步骤不仅保证了数据的一致性,还提高了对接过程中的灵活性。

-

分页与限流机制:为了避免因大批量数据传输导致网络拥堵或服务器过载,我们设计了分页抓取和限流策略。通过定时可靠地抓取MySQL接口的数据,并分批次写入金蝶云星空,有效平衡了系统负载。

-

异常处理与错误重试机制:在实际操作过程中,不可避免会遇到各种异常情况。我们实现了一套完善的异常处理和错误重试机制,当某个步骤失败时,系统会自动记录日志并尝试重新执行,从而保证最终的数据完整性和一致性。

通过上述技术手段,本次“SR生产入库单新增-单工序-深圳天一-好”项目成功实现了MySQL与金蝶云星空之间的数据无缝对接,为企业提供了一套高效、可靠的数据集成解决方案。在接下来的章节中,我们将详细介绍具体实施步骤及相关配置细节。

调用MySQL接口select获取并加工数据

在数据集成平台的生命周期中,第一步是调用源系统MySQL接口select获取并加工数据。这一步至关重要,因为它决定了后续数据处理和集成的基础。本文将详细探讨如何通过配置元数据来实现这一过程。

配置元数据

首先,我们需要配置元数据以定义如何从MySQL数据库中提取所需的数据。以下是一个典型的元数据配置示例:

{

"api": "select",

"effect": "QUERY",

"method": "SQL",

"number": "入库单号",

"id": "入库单号",

"name": "name",

"request": [

{

"field": "main_params",

"label": "主参数",

"type": "object",

...

}

],

...

}

该配置定义了API类型为select,方法为SQL,主要用于查询操作(QUERY)。其中关键字段包括:

number: 入库单号id: 入库单号name: 名称

这些字段帮助我们标识和管理从MySQL数据库中提取的数据。

主查询语句

接下来,我们需要编写主查询语句,以便从MySQL数据库中获取所需的数据。以下是一个具体的查询语句示例:

SELECT

CASE m.delivery_org

WHEN 'T01.01' THEN CONCAT('HJ', CAST(hj1.id AS CHAR))

WHEN 'T04' THEN CONCAT('HJGD', CAST(hj1.id AS CHAR))

ELSE CONCAT('HJ', CAST(hj1.id AS CHAR))

END AS 生产订单号,

a.part_no AS 成品编号,

c.mode_no AS 计划跟踪号,

CONCAT('RKD',CAST(a.id AS CHAR)) AS 入库单号,

DATE(a.update_time) AS 日期,

a.confirm_numb AS 入库数量,

a.id AS sourceid,

m.delivery_org AS 供应组织

FROM wms_instock_confirm_task_detail a

LEFT JOIN wms_instock_purchase_task_detail c ON MATTERIAL_TYPE='3' AND c.next_process_code IS NULL

LEFT JOIN wms_instock_confirm_main_task_detail b ON b.connect_uuid=c.uuid

LEFT JOIN mbs_nuclear_price_task hj ON hj.mold_no=c.mode_no AND hj.part_no=a.part_no

LEFT JOIN mbs_nuclear_price_info hj1 ON hj1.nuclear_price_task_uuid=hj.nuclear_price_task_uuid AND hj1.out_type='3'

LEFT JOIN mbs_order_plan_bom l ON c.mode_no=l.bom_no

LEFT JOIN mbs_order_bom m ON m.bom_uuid=l.bom_uuid

WHERE a.connect_uuid=b.uuid

AND a.company_code='TYZN'

AND a.update_time>'2023-08-01'

AND hj1.create_time>(SELECT config_value FROM sys_config WHERE config_id=337)

AND a.is_success3 !='1'

AND a.is_success2='1'

LIMIT :limit OFFSET :offset;

这段SQL代码通过多个表连接和条件过滤,从不同表中提取相关信息,并生成最终结果集。值得注意的是,这里使用了动态参数:limit和:offset来控制返回记录数和偏移量。

动态参数设置

为了确保查询能够灵活适应不同需求,我们在元数据配置中添加了动态参数设置:

{

...

"request": [

{

...

"children": [

{

"field": "limit",

...

"value": "100"

},

{

...

...

}

]

}

],

}

这些参数允许用户在执行查询时指定返回记录数和偏移量,从而实现分页功能。这对于处理大规模数据集尤为重要,可以有效避免一次性加载过多数据导致性能问题。

数据质量监控与异常处理

在调用MySQL接口获取数据时,确保数据质量和处理异常情况同样重要。平台提供了实时监控和告警系统,可以及时发现并处理潜在问题。例如,通过日志记录功能,可以跟踪每次查询的执行情况,包括成功与失败的信息。此外,还可以设置重试机制,在出现错误时自动重新尝试执行查询,以提高任务的可靠性。

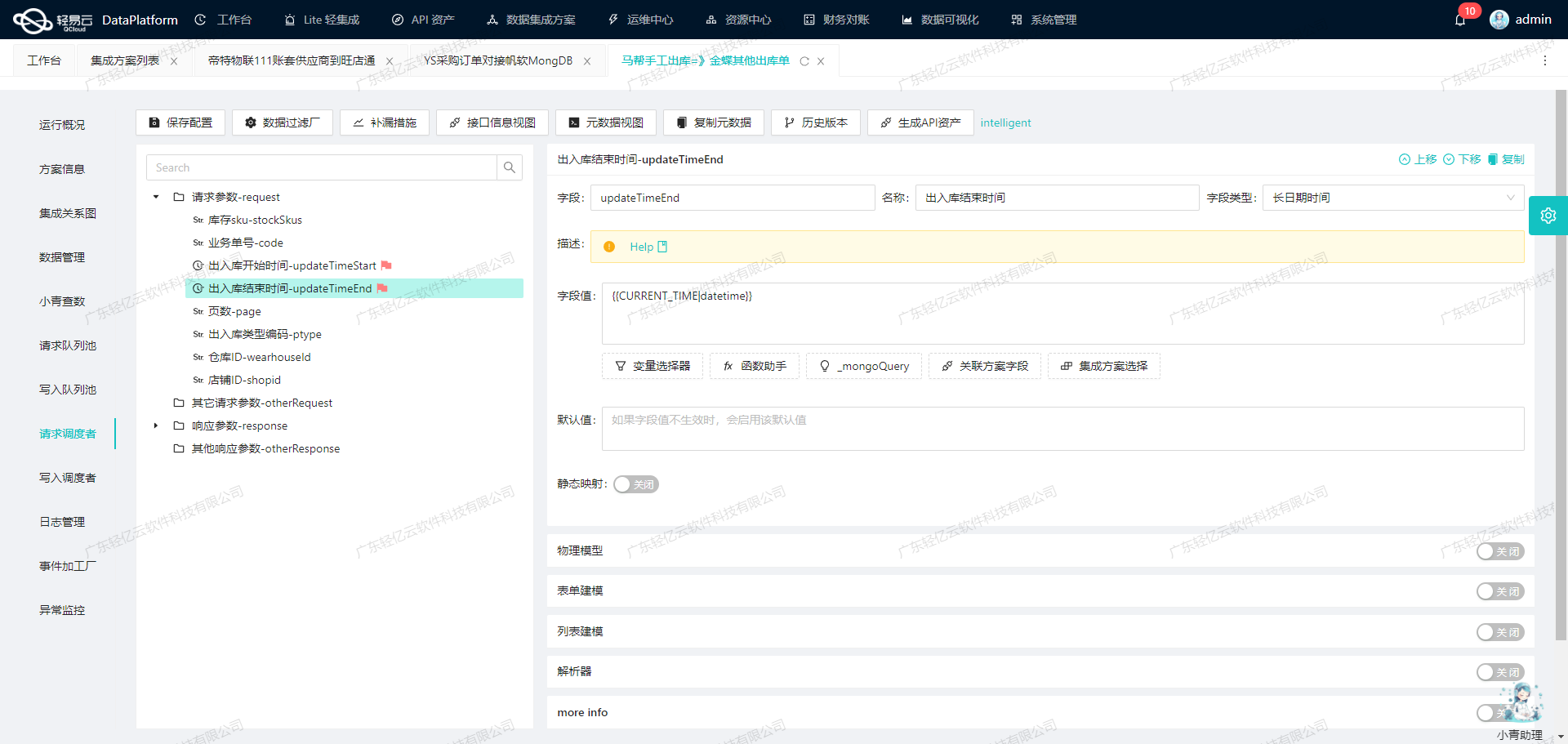

自定义转换逻辑

最后,为了满足特定业务需求,我们可以自定义转换逻辑。在上述查询语句中,通过各种字符串拼接、日期格式化等操作,实现了对原始数据的初步加工。这些转换逻辑可以根据实际需求进行调整,以确保最终输出的数据符合预期格式。

综上所述,通过合理配置元数据、编写高效的主查询语句、设置动态参数以及实施有效的数据质量监控与异常处理机制,我们能够高效地调用MySQL接口获取并加工处理所需的数据,为后续的数据集成奠定坚实基础。

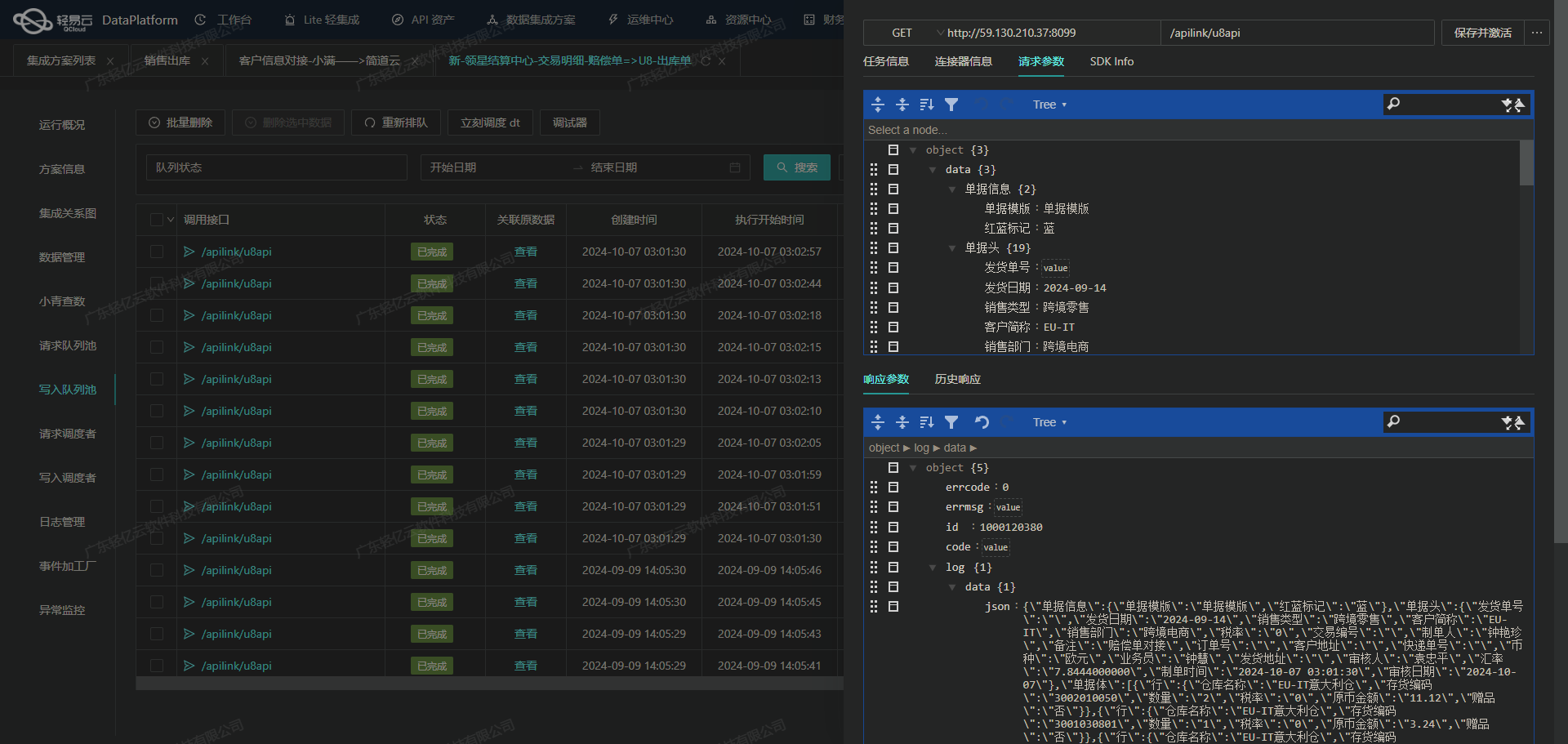

集成数据写入金蝶云星空API接口的ETL转换

在数据集成生命周期的第二步,我们需要将已经集成的源平台数据进行ETL转换,确保数据符合金蝶云星空API接口所要求的格式,并最终写入目标平台。以下是如何实现这一过程的详细技术解析。

数据请求与清洗

首先,我们需要从MySQL数据库中提取原始数据。通过MySQL接口的select语句,可以定时可靠地抓取所需的数据:

SELECT * FROM production_orders WHERE status = 'completed';

通过这种方式,我们获取了生产订单的详细信息,包括生产订单号、日期、供应组织等。

数据转换与映射

接下来,将这些原始数据转换为金蝶云星空API接口能够接受的格式。我们需要对照元数据配置,对每个字段进行相应处理。

例如,单据编号(FBillNo)和日期(FDate)的映射:

{

"field": "FBillNo",

"label": "单据编号",

"type": "string",

"value": "{{入库单号}}"

},

{

"field": "FDate",

"label": "日期",

"type": "string",

"value": "{{日期}}"

}

对于复杂字段如生产组织(FPrdOrgId),我们使用自定义逻辑进行转换:

{

"field": "FPrdOrgId",

"label": "生产组织",

"type": "string",

"parser": {

"name": "ConvertObjectParser",

"params": "FNumber"

},

"value": "_function case '{{供应组织}}' when 'T01.01' then 'T01.06' when 'T04' then 'T04' else '' end"

}

这种自定义逻辑确保了不同供应组织对应正确的生产组织编码。

数据批量写入

在完成所有字段的映射和转换后,利用金蝶云星空提供的batchSave API接口进行批量数据写入:

{

"api": "batchSave",

"method": "POST",

...

}

通过这种方式,我们能够高效地将大量数据快速写入到金蝶云星空,确保数据处理的时效性。

异常处理与错误重试机制

在实际操作过程中,可能会遇到各种异常情况,例如网络中断或数据格式错误。为了保证数据集成的可靠性,我们需要实现异常处理与错误重试机制。例如,当API调用失败时,可以设置重试次数和间隔时间,以确保最终成功:

{

...

"retryCount": 3,

...

}

实时监控与日志记录

为了全面掌握数据集成任务的状态和性能,我们可以利用集中的监控系统和日志记录功能。实时跟踪每个ETL任务的执行情况,一旦发现异常立即告警并处理,确保整个过程透明可控。

数据质量监控

最后,通过数据质量监控和异常检测功能,及时发现并处理任何潜在的数据问题。例如,可以设置规则来检查关键字段是否为空或不符合预期格式:

{

...

"qualityCheckRules": [

{"field":"FBillNo", "rule":"notEmpty"},

{"field":"FDate", "rule":"dateFormat"}

]

}

通过上述步骤,我们完成了从MySQL数据库到金蝶云星空API接口的数据ETL转换,实现了高效、可靠的数据集成。这一过程中,每一步都至关重要,从源平台的数据提取到目标平台的数据写入,都需要精心设计和严格执行,以确保最终的数据准确性和一致性。

【推荐】国内首个AI IDE,深度理解中文开发场景,立即下载体验Trae

【推荐】编程新体验,更懂你的AI,立即体验豆包MarsCode编程助手

【推荐】抖音旗下AI助手豆包,你的智能百科全书,全免费不限次数

【推荐】轻量又高性能的 SSH 工具 IShell:AI 加持,快人一步

· 10年+ .NET Coder 心语 ── 封装的思维:从隐藏、稳定开始理解其本质意义

· 地球OL攻略 —— 某应届生求职总结

· 周边上新:园子的第一款马克杯温暖上架

· Open-Sora 2.0 重磅开源!

· 提示词工程——AI应用必不可少的技术