spark配置文件和执行部分代码

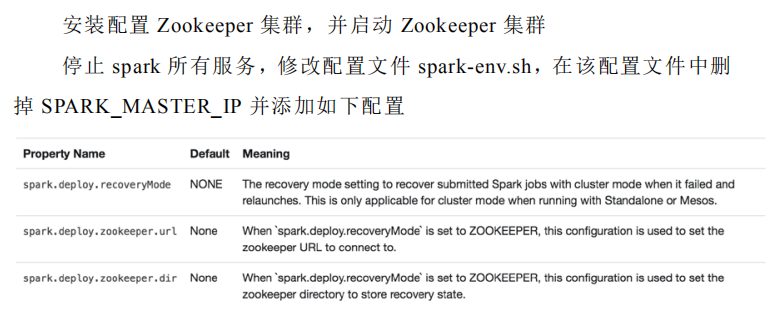

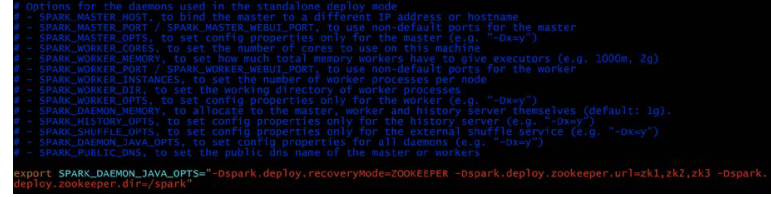

export SPARK_DAEMON_JAVA_OPTS="

-Dspark.deploy.recoveryMode=ZOOKEEPER

-Dspark.deploy.zookeeper.url=zk1,zk2,zk3

-Dspark.deploy.zookeeper.dir=/spark"

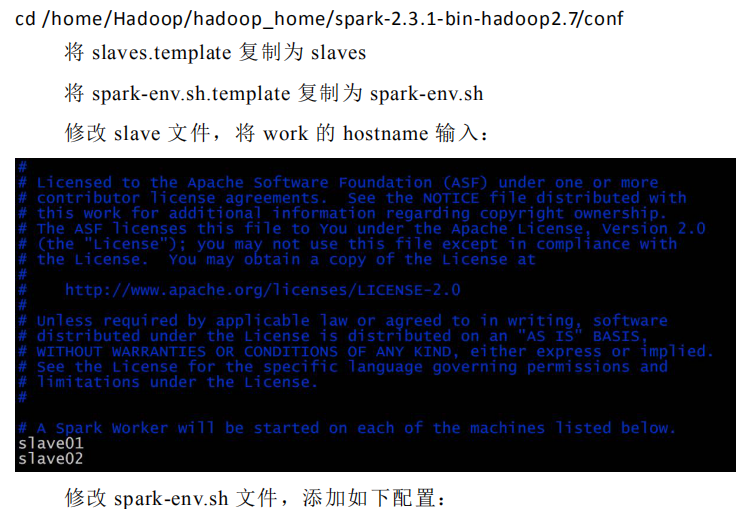

1.在 master01 节点上修改 slaves 配置文件内容指定 worker 节点

2.将配置文件同步到所有节点。

3.在 master01 上执行 sbin/start-all.sh 脚本,启动集群并启动第一个

master 节点,然后在 master02 上执行 sbin/start-master.sh 启动第二个 master

节点。

4.程序中 spark 集群的访问地址需要改成:

spark://master01:port1,master02:port2

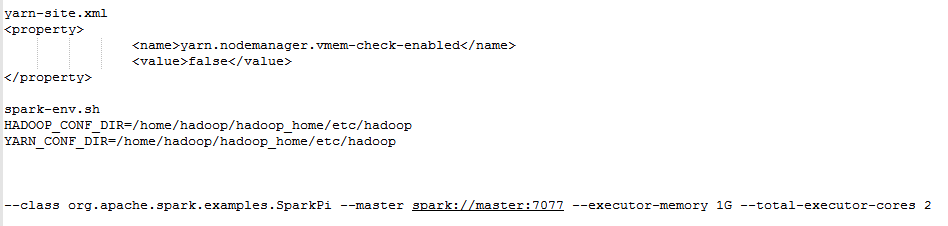

若想在集群上和yarn上运行,添加如下配置

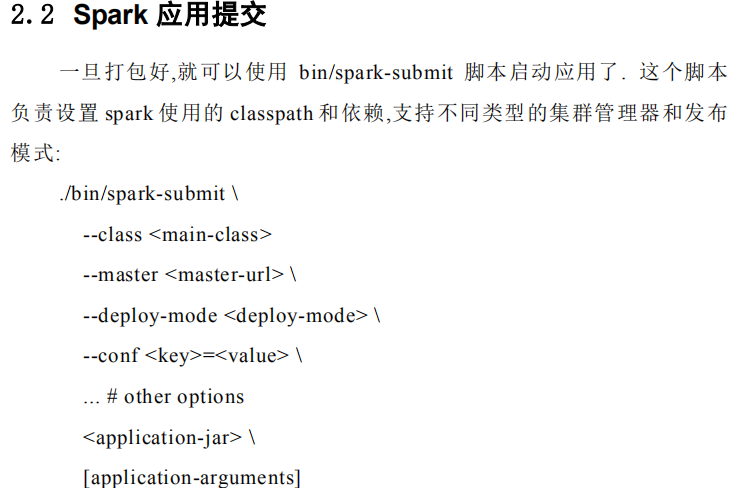

standalone client运行

spark-submit --master spark://master:7077 --class org.apache.spark.examples.SparkPi /home/hadoop/hadoop_home/spark/examples/jars/spark-examples_2.11-2.3.1.jar 100

standalone cluster运行

spark-submit --master spark://master:7077 --deploy-mode cluster --class org.apache.spark.examples.SparkPi /home/hadoop/hadoop_home/spark/examples/jars/spark-examples_2.11-2.3.1.jar 100

yarn client运行

spark-submit --master yarn --class org.apache.spark.examples.SparkPi /home/hadoop/hadoop_home/spark/examples/jars/spark-examples_2.11-2.3.1.jar 100

或者

spark-submit --master yarn --deploy-mode client --class org.apache.spark.examples.SparkPi /home/hadoop/hadoop_home/spark/examples/jars/spark-examples_2.11-2.3.1.jar 100

或者

spark-submit --master yarn-client --class org.apache.spark.examples.SparkPi /home/hadoop/hadoop_home/spark/examples/jars/spark-examples_2.11-2.3.1.jar 100

yarn cluster运行

spark-submit --master yarn-client --deploy-mode cluster --class org.apache.spark.examples.SparkPi /home/hadoop/hadoop_home/spark/examples/jars/spark-examples_2.11-2.3.1.jar 100

或者

spark-submit --master yarn-cluster --class org.apache.spark.examples.SparkPi /home/hadoop/hadoop_home/spark/examples/jars/spark-examples_2.11-2.3.1.jar 100

8080 是 Spark WEBUI 界面的端口,7077 是 Spark 任务提交的端口。

修改 master 的 WEBUI 端口:

修改 start-master.sh 即可。