机器学习整理(神经网络)

神经元

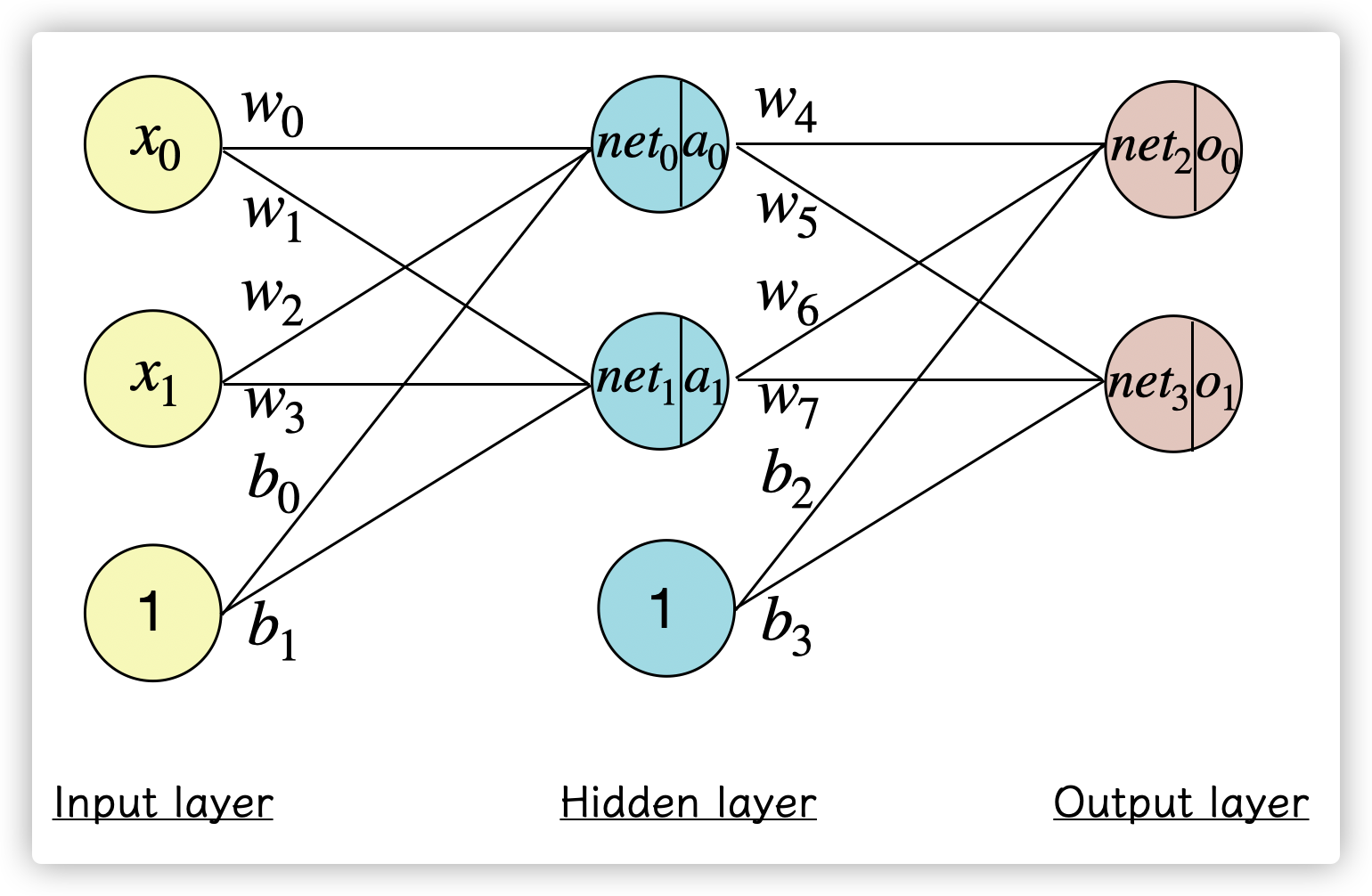

神经网络由多个神经元组成,其中神经元由几个部分组成:输入、输入权重、输出和激活函数组成,类似于生物神经元的树突、轴突的组成。

神经元的输入由左边的神经元输出 乘以权重 并加和得到,输出的时候,类似于生物神经元的轴突,将神经元的输出通过激活函数才能传送给接下来的神经元。

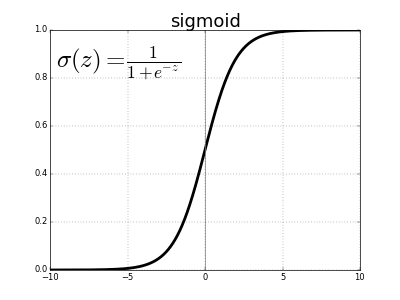

常用的激活函数(activation function)是Sigmod,它的函数图像如下,在逻辑回归的时候使用过:

其中偏置单元 是用于提高神经网络的灵活性而加入的,它的存在可以让激活函数更快或者更慢达到激活状态。

神经网络

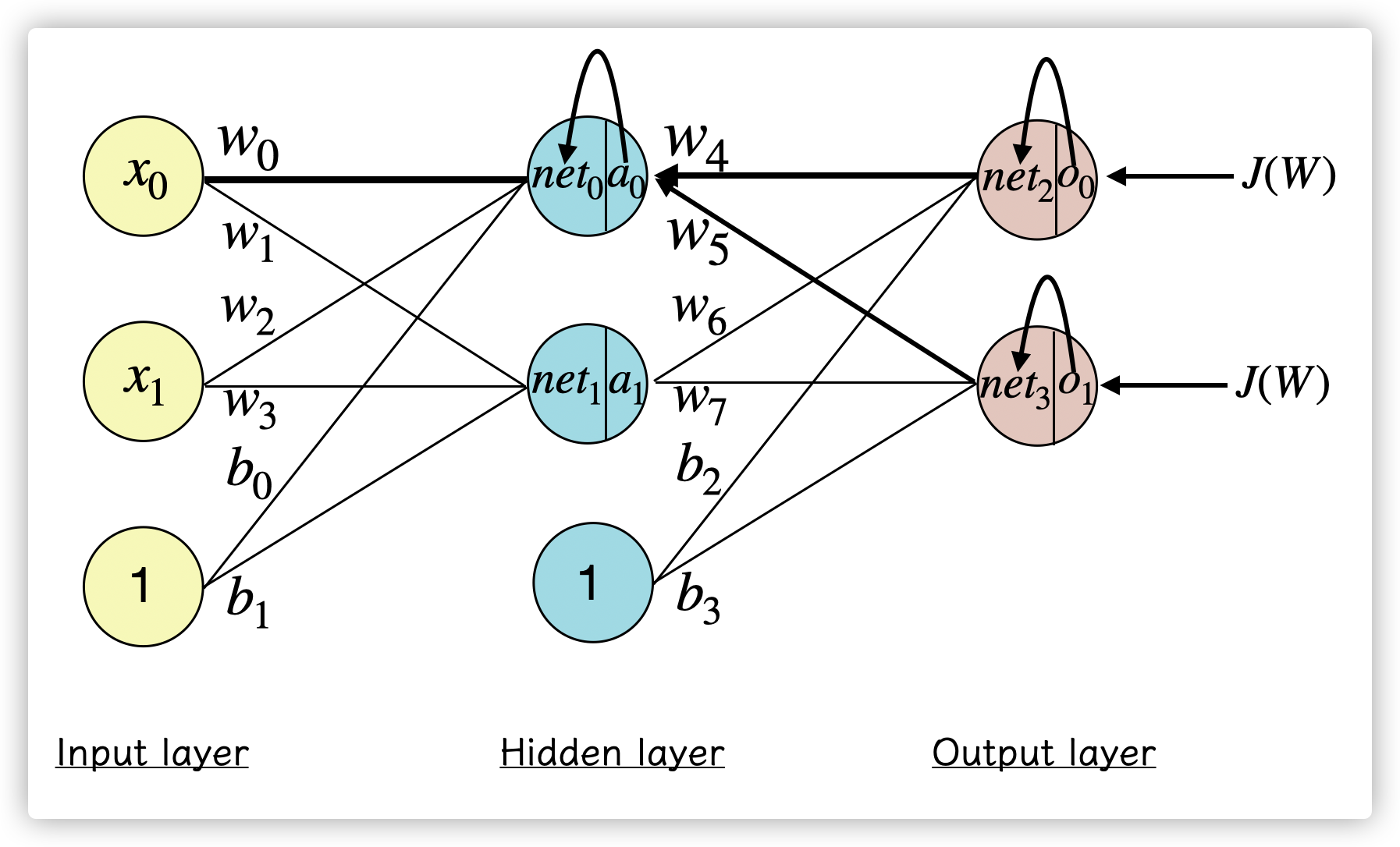

多个神经元组层一个神经网络:

神经网络第一层是输入层(input),最后一层是输出层(output),而中间的就是神经网络的隐藏层(hidden layer)

神经网络的训练过程如下:

- 随机初始化权重

- 代入执行前向传播得到神经网络的输出

- 计算代价函数

- 执行反向传播,计算偏导数 ,依次更新网络的权重

- 将样本 不断代入第2步到第4步。

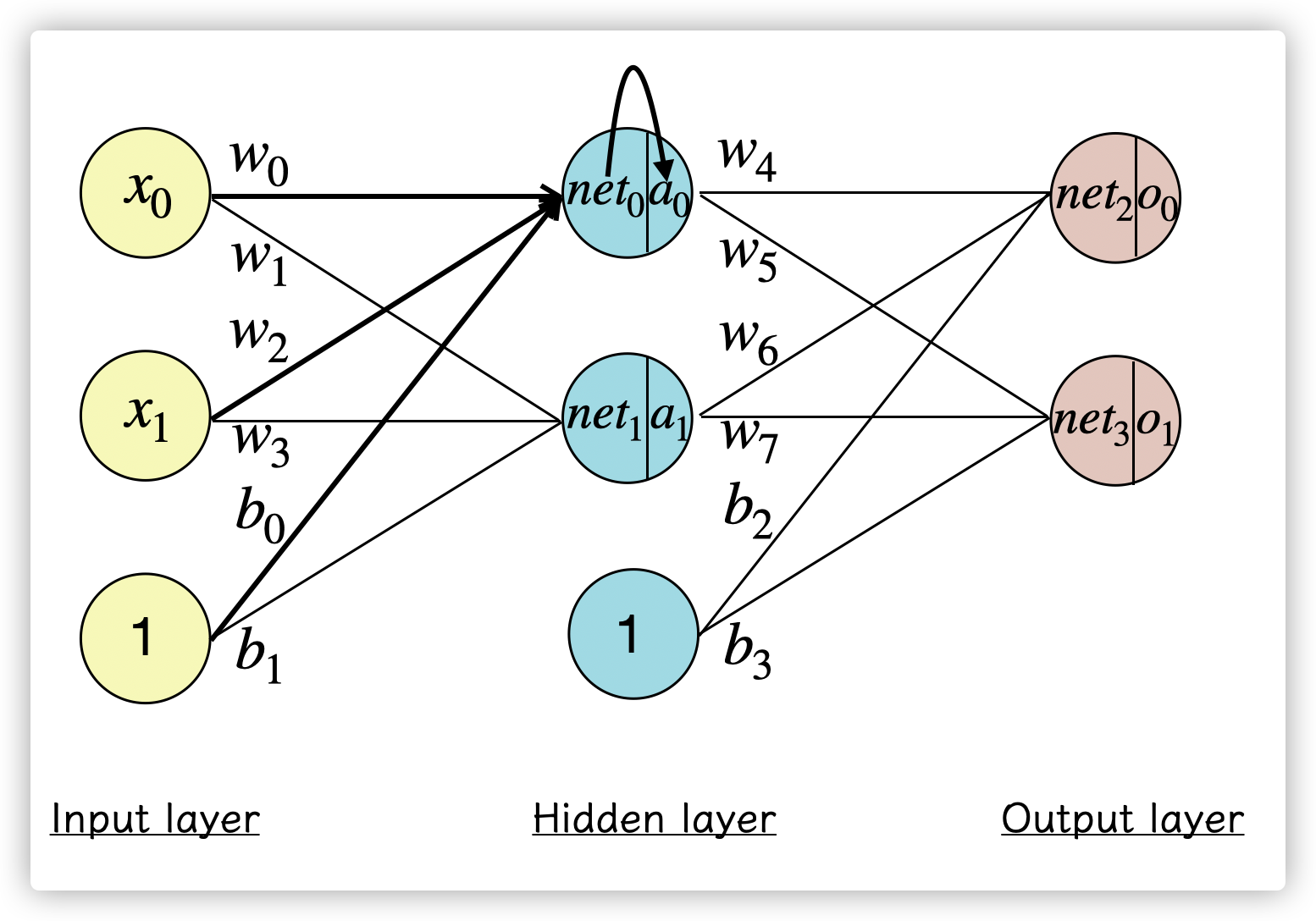

前向传播

前向传播的过程目的是计算出神经网络的输出:

首先开始计算 :

到达隐藏层的神经元后,会通过激活函数作为神经元的输出 :

计算该神经元后继续向前计算,和前面一层的计算类似:

按照这样的传播过程,这样就能计算出神经网络的输出 ,即神经网络的前向传播,就像把样本 代入里求出 值的过程一样。

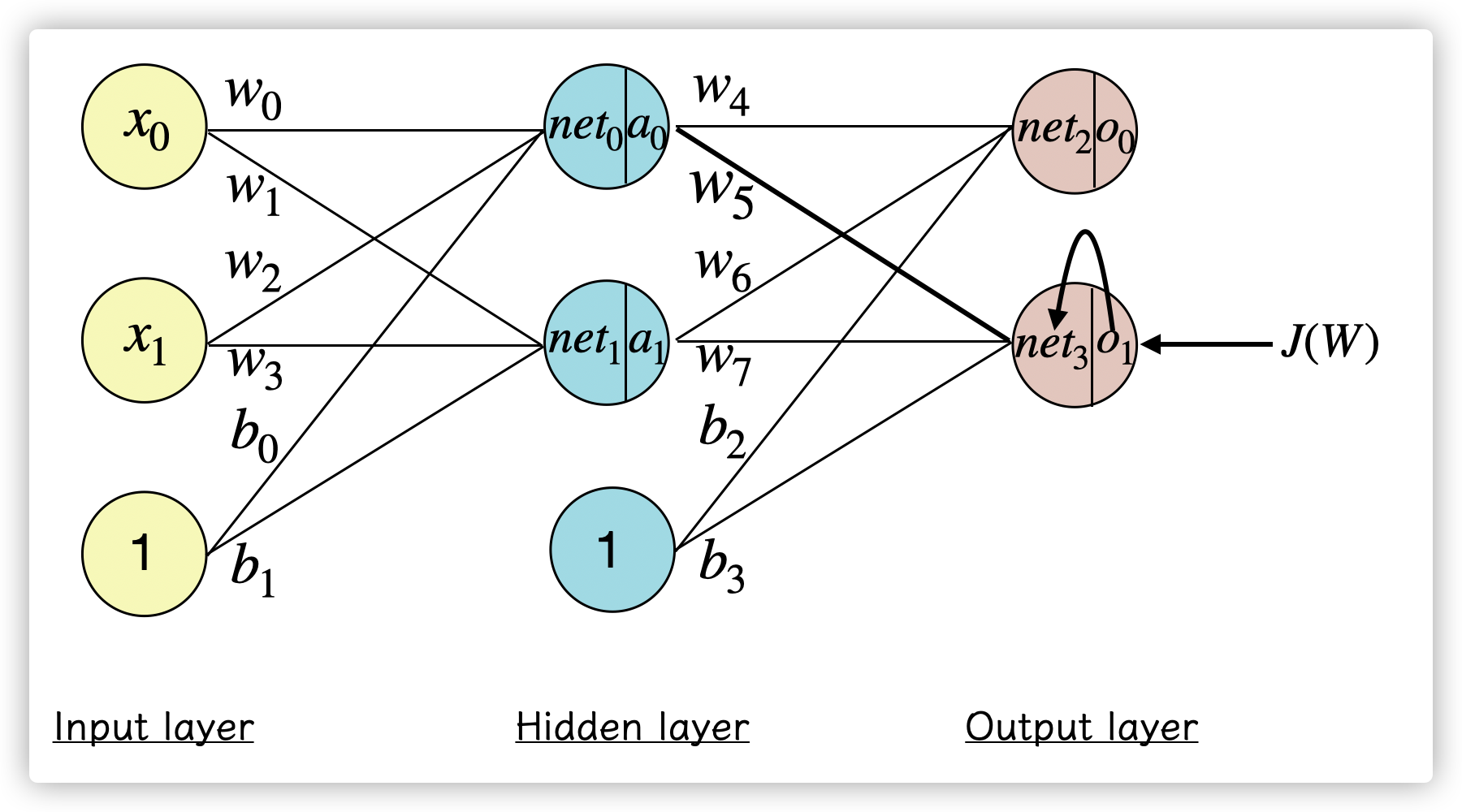

反向传播

按照神经网络的训练过程,接下来是希望计算代价函数 ,并求出 对 的偏导数 ,并按照学习率 更新参数:

以更新 为例,如果需要知道 的值,根据链式求导法则:

(1)首先求 ,其中 是代价函数,这里用均方误差来计算误差, 是样本的结果,那么表达式就是:

其中对 的偏导数为:

(2)然后是求 :

其中对 的偏导数为:

激活函数Sigmoid的函数 的导数等于 ,见证明。

(3)最后是求 :

所以最终求得偏导项:

而 也能在反向传播中更新自己的权重,通过减去 。

第三个导数项求偏导时都会等于上一层的激活函数的输出值,如果把前两个导数项 用符号 代替的话,那么:

如果要更新隐藏层的权重 ,则

因为 同时受到 和 的影响,所以:

其中 代表在 的损失,计算和前面的规则类似,依次根据链式求导规则展开即可对给定的 拟合。

其他资料

在这里基本打开了神经网络的大门,虽然目前学到只是一个全连接网络和基本的BP算法,但是在这篇文章中可以看到还有支持增量学习的自适应谐振理论网络(ART),以及自动连接神经元的自我组织网络(SOM)等等网络架构。

其他我用到的资料:

- 一步一步进行反向传播: https://mattmazur.com/2015/03/17/a-step-by-step-backpropagation-example/

- 上文的在 cnblog 中文翻译: https://www.cnblogs.com/charlotte77/p/5629865.html

- Sigmoid 激活函数求导推导: https://zhuanlan.zhihu.com/p/215323317

- bias 的作用: https://www.zhihu.com/question/305340182

本文来自博客园,作者:pokpok,转载请注明原文链接:https://www.cnblogs.com/pokpok/p/16127239.html

【推荐】国内首个AI IDE,深度理解中文开发场景,立即下载体验Trae

【推荐】编程新体验,更懂你的AI,立即体验豆包MarsCode编程助手

【推荐】抖音旗下AI助手豆包,你的智能百科全书,全免费不限次数

【推荐】轻量又高性能的 SSH 工具 IShell:AI 加持,快人一步

· DeepSeek 开源周回顾「GitHub 热点速览」

· 物流快递公司核心技术能力-地址解析分单基础技术分享

· .NET 10首个预览版发布:重大改进与新特性概览!

· AI与.NET技术实操系列(二):开始使用ML.NET

· .NET10 - 预览版1新功能体验(一)