爬虫-今日头条我的收藏(一)

背景:

- 我在今日头条下收藏很多文章,使用的过程中我发现头条的按照关键字搜索总是无法全部搜索出来。也给头条反馈了很多次,总是爱理不理。实在忍受不了这种敷衍,决定自己写一个爬虫。至少可以通过查找关键字搜素标题、tag查找到需要的内容。

- 有了这些数据可以用来自己的做文本分析、智能分类等功能等后续数据挖掘功能。之前学过veka里面很多数据挖掘算法可以捡起来用了

思路:

- 先解决有无问题,做一个最基础版本一次性抓取我的收藏原始数据,不做增量抓取,不抓取每篇文章的内容

- 头条我的收藏列表是get请求,返回的是json格式数据,直接使用requests发送请求到头条。

- 滚动到收藏列表底部的时候,网页会发送新的ajax请求到头条,收藏内容滚动到下一页。通过不断发送请求指定max_behot_time不断取出每页的内容,直到has_more返回False

- 关于持久化,sqlite/mongodb/mysql/pg/文本文件。简单实现来看一个文本就解决问题,每页的json类容就是一行。之后再把这些文件内容导入到数据库。

实现:

- 代码参考这里: https://github.com/pmh905001/myfavorite/blob/master/toutiao/fulldownload.py

- 今日头条可能会有反爬虫策略,发送的请求不能太频繁否则可能会封IP,根据讯飞星火的建议1秒左右,所以随机选择1-10秒发送请求,用户可以自行调整代码。

- 用户可以通过chrome的dev面包拷贝curl 命令到curl_cmd.txt这个模板文件中,程序会通过curlparser解析出用户的URL、header相关信息,然后发送requests请求。发送的cURL请求带有用户的个人信息,所以模板文件是不能跑起来的,需要用户自行配置。

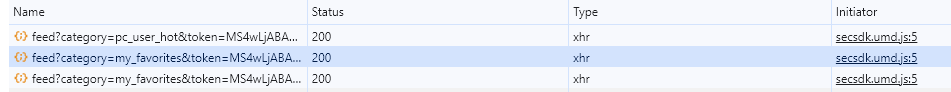

- curl命令可以通过右键选中feed请求->Copy->Copy as cURL功能放到剪切板中。

-

写入每行json数据到toutiao-myfavorites.txt里面的时候需要注意编码成utf-8

with open('toutiao-myfavorites.txt', 'a', encoding='utf-8') as fp:

- 跑了4个多小时终于把头条我的收藏列表给抓取出来几百兆数据。虽然比较慢,终归把所有历史收藏数据给抓取出来了。万里长征第一步!

【推荐】国内首个AI IDE,深度理解中文开发场景,立即下载体验Trae

【推荐】编程新体验,更懂你的AI,立即体验豆包MarsCode编程助手

【推荐】抖音旗下AI助手豆包,你的智能百科全书,全免费不限次数

【推荐】轻量又高性能的 SSH 工具 IShell:AI 加持,快人一步

· 震惊!C++程序真的从main开始吗?99%的程序员都答错了

· winform 绘制太阳,地球,月球 运作规律

· 【硬核科普】Trae如何「偷看」你的代码?零基础破解AI编程运行原理

· 上周热点回顾(3.3-3.9)

· 超详细:普通电脑也行Windows部署deepseek R1训练数据并当服务器共享给他人