m16

图像分割(语义分割是像素分类,实例分割还要分类后区分不同个体)

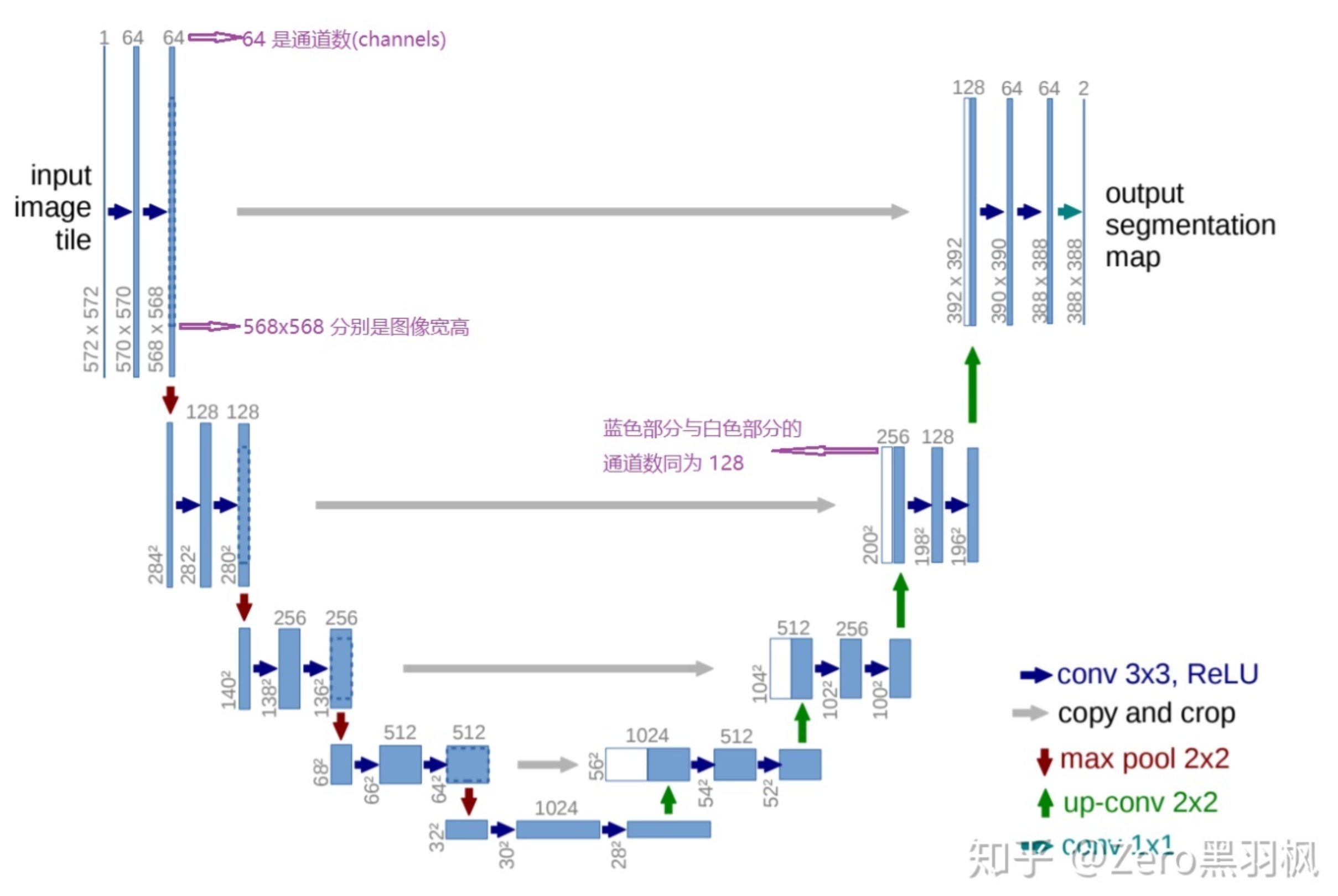

【unet】

本质是像素点的多分类,深度不深,用于检测小物体,如细胞,下图灰色箭头表示 跳跃连接 skip-connection,通过 concatenate 特征融合,卷积结构统一为 3x3 的卷积核,padding 为 0 ,striding 为 1。

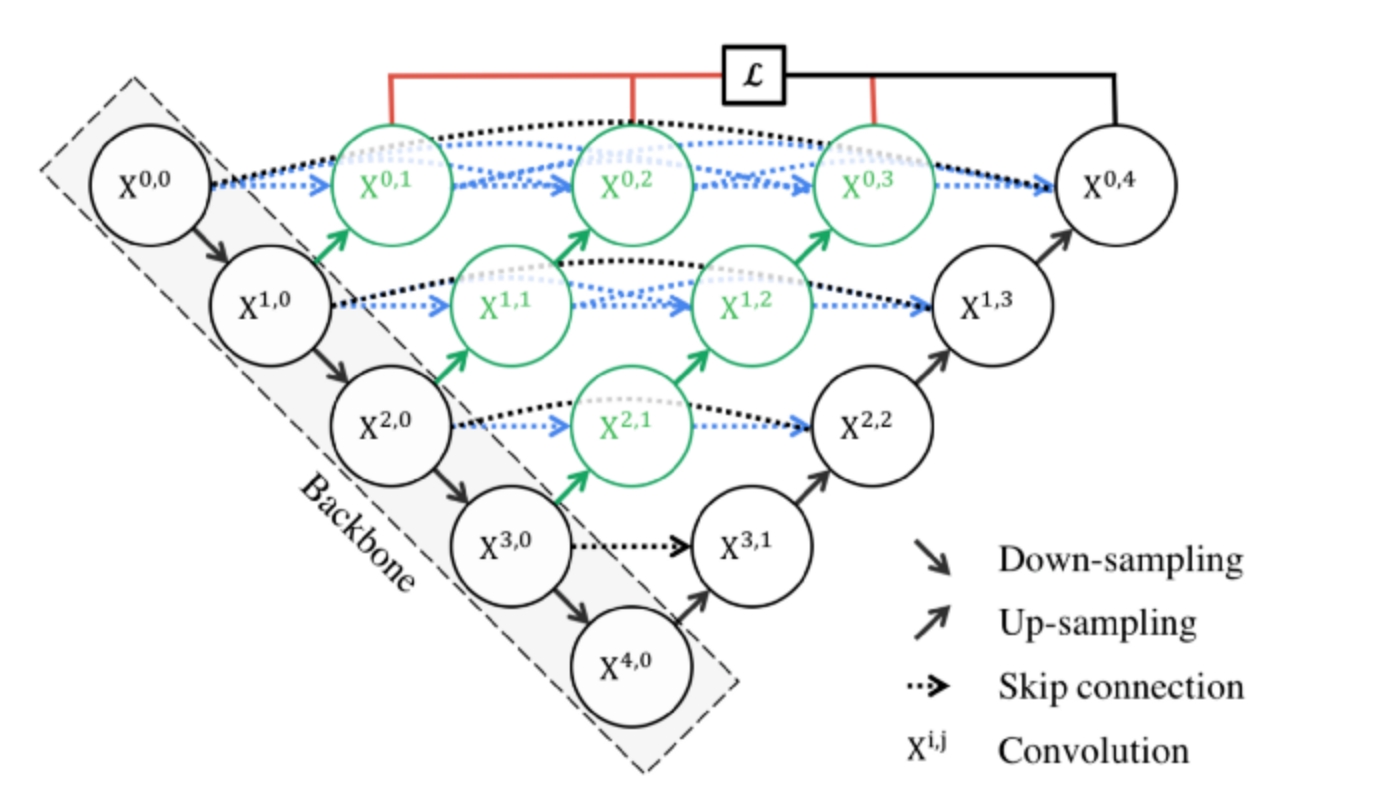

【unet ++】

在原始的U-Net上加了3个东西:重新设计的跳跃路径以弥补 unet 编码器和解码器子路径之间的语义差别(显示为绿色),密集跳跃连接以丰富信息(显示为蓝色),深度监督(显示为红色)通过上面4个节点输出的4个特征图,再分别通过4个1*1的卷积层再得到 4个厚度为1的特征图,即每个像素对应1个logit,然后通过sigmoid得到像素属于前景的概率,计算出1个特征图的损失,最后计算4个特征图的平均 loss,如果不采用深度监督,则把 x04 输出的特征图再通过1个1*1卷积层输出厚度为1的特征图,用作 loss 计算,注意该损失是BCE损失

dice 损失 :1 - 2 * a点击b / (sum(a) + sum(b) ),其中 a 向量是特征图每个像素属于前景的概率,b 向量 是每个像素真实是否是前景

总损失=0.5 * bce 损失 + dice 损失,理由:Dice Loss相当于从全局上进行考察,BCE是从微观上逐像素进行拉近,角度互补。

模型的 iou_score:sum(c & b) / sum(c | b),其中 c 向量是特征图每个像素预测是否前景,b 向量 是每个像素真实是否是前景,&:同位置的两个像素若都是前景,则为1,|:同位置的两个像素若有1个是前景,则为1,iou_score 越大说明预测分割的越准

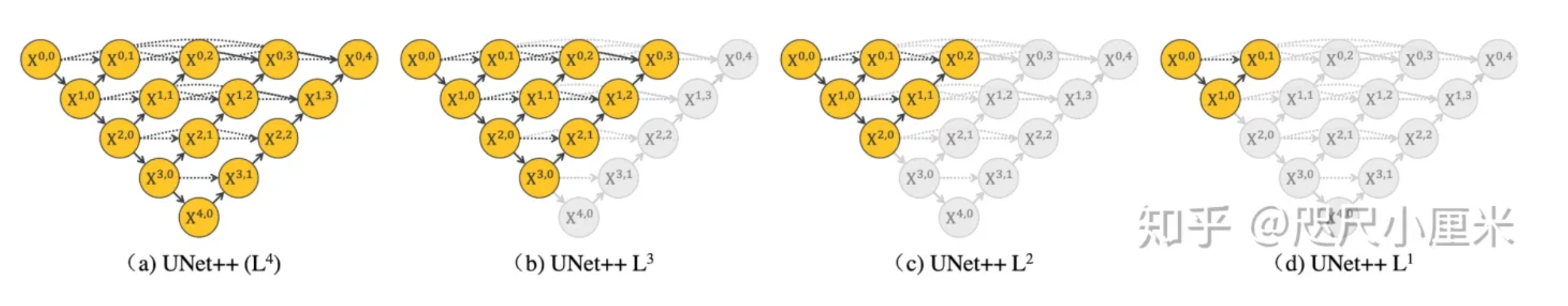

模型可以从后往前去掉分支(即剪枝)以便换模型深度,见下图:

模型的每个节点分别存有:串联的:conv+bn+relu + conv+bn+relu,同一个行内的节点输出的特征图 h,w,c 一致,越往下的行,特征图的大小越小

输入的图像要先传给 x00 节点,针对 x00 和 x10 处理后输出的特征图,x10 的输出先进行上采样,然后和 x00 输出的特征图进行厚度拼接,然后作为 x01 的输入

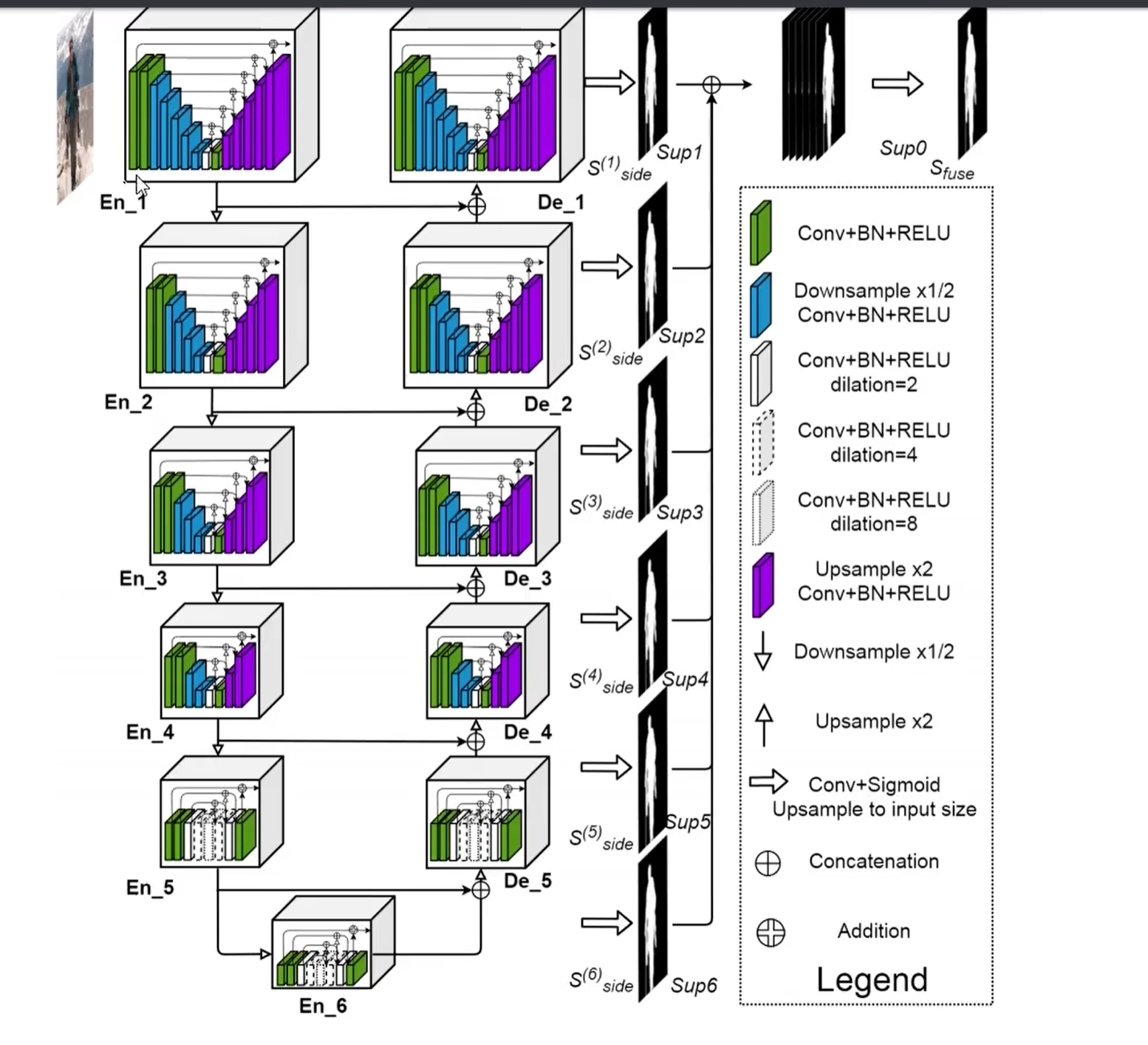

【U2-Net】

整体由多个 RSU 模块组成U型结构,单个模块内部也是一个小号的 Unet

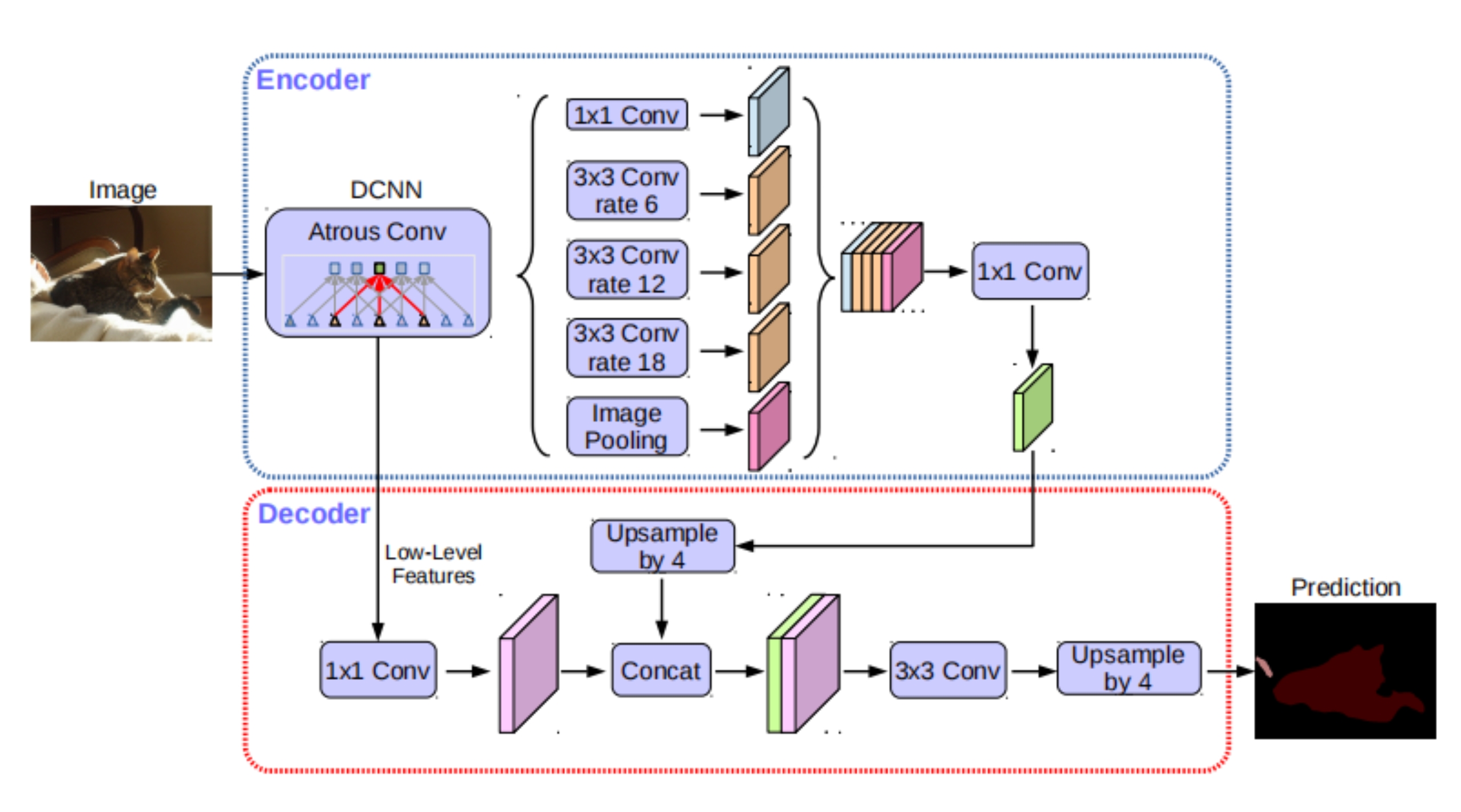

【deeplabv3+】

1、数据增强:缩放到 512*512、随机水平翻转(预测阶段没有这一步)、像素归一化

2、结构

2.1 encoder-decode结构: encoder = DeepLabv3 = DCNN + aspp

DCNN:resnet50_vd 结构,不同的是 stage3 和 stage4 里面所有的 3x3 的普通卷积层都换成了膨胀卷积层(空洞卷积或者扩展卷积,即 atrous convolution)

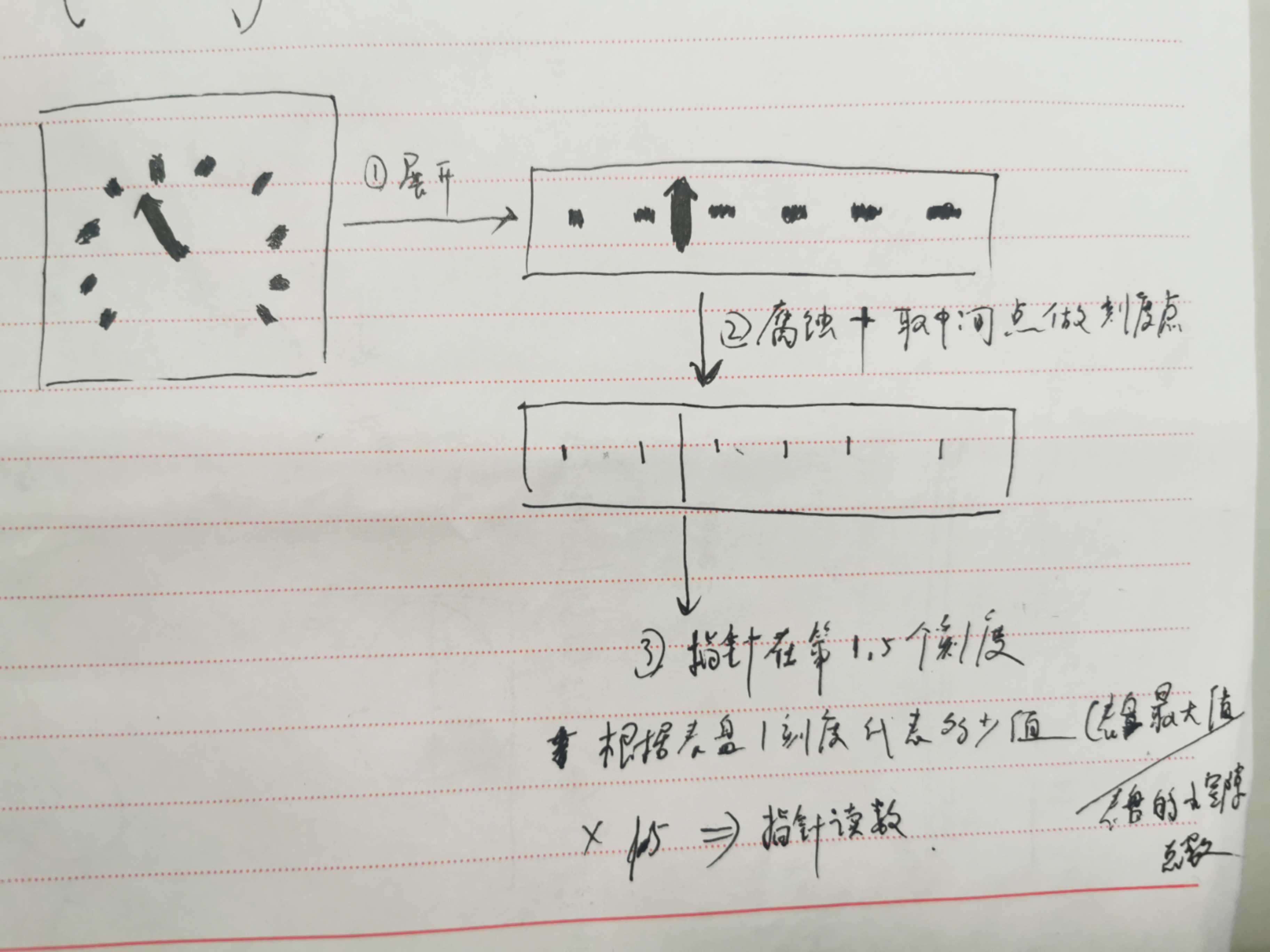

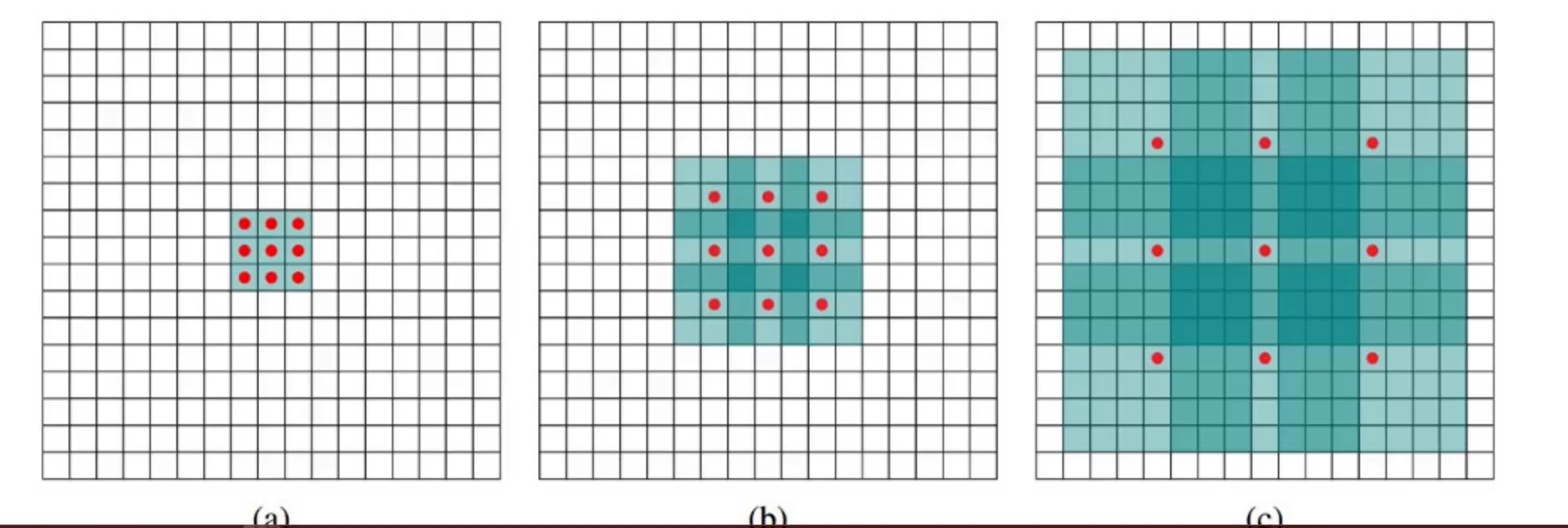

空洞卷积:将卷积核扩开(中间的空隙用0填充),然后卷积。作用:代替了下采样 pooling(虽然增大感受野但是降低分辨率),增大了感受野可以检测分割大目标,当设置不同dilation rate时,感受野就会不一样,也即获取了多尺度信息,但是会导致kernel 不连续,会损失信息的连续性。效果即:

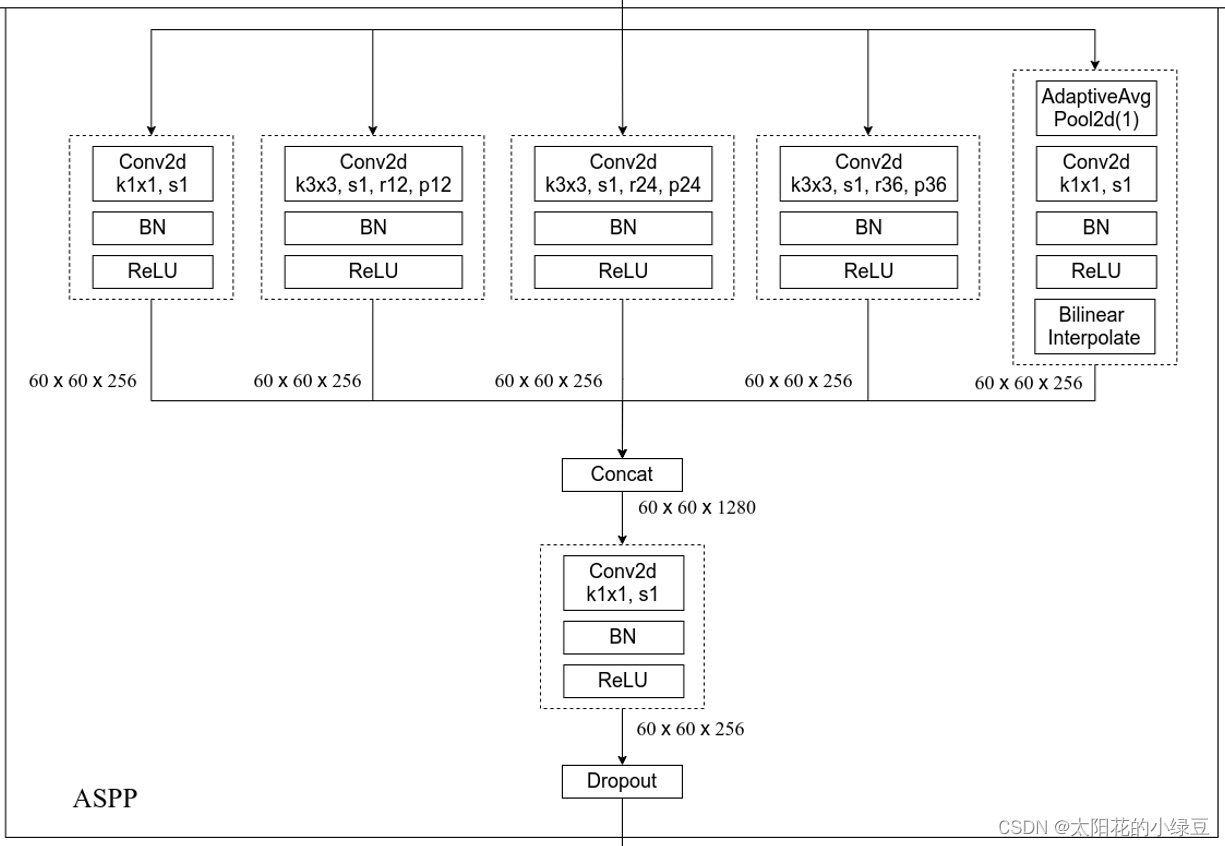

2.2 DCNN右边是接 aspp,更具体结构是:

这里的ASPP结构有5个并行分支,分别是一个1x1的普通卷积层,三个 3x3 的膨胀卷积层,以及一个全局平均池化层(后面还跟有一个1x1的卷积层,然后通过双线性插值的方法还原回输入的W和H),3个使用膨胀卷积的膨胀系数不同(即每个分支的感受野不同,从而具有解决目标多尺度的问题),最后一个全局池化分支是为了增加一个全局上下文信息global context information。然后通过Concat的方式将这5个分支的输出进行拼接(沿着channels方向),最后在通过一个1x1的卷积层进一步融合信息。作用:不同的输入尺寸可以输出相同大小的输出,利用不同膨胀因子的空洞卷积融合多尺度信息。

2.3 decoder 是为更好的提取图像细节,encoder 将DCNN的 lowlevel 低阶特征(即 resnet stage1的输出分个流)往下传,然后和 encoder 的高阶输出相融合,具体的:

低阶特征 通过 conv+bn+relu,再和经过上采样的高阶特征拼接,再通过 2层的 conv+bn,con+bn+relu ,再通过 conv,最后通过上采样得到和原图一样大小的特征图,厚度是3,对应每个像素属于3个类别的概率

3、预测,以码表识别为例