RNN知识点

1.

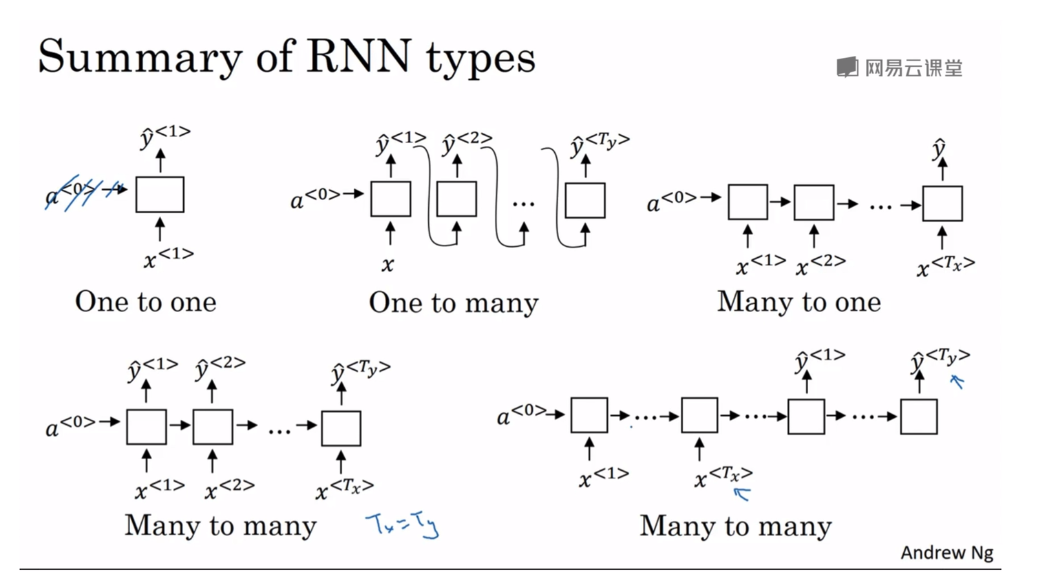

RNN类型

2.

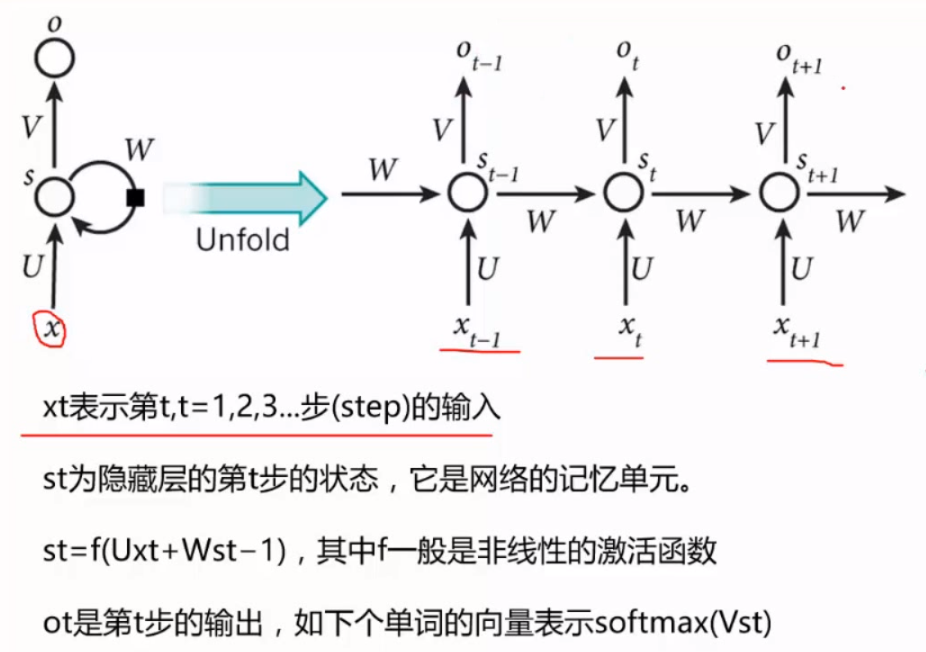

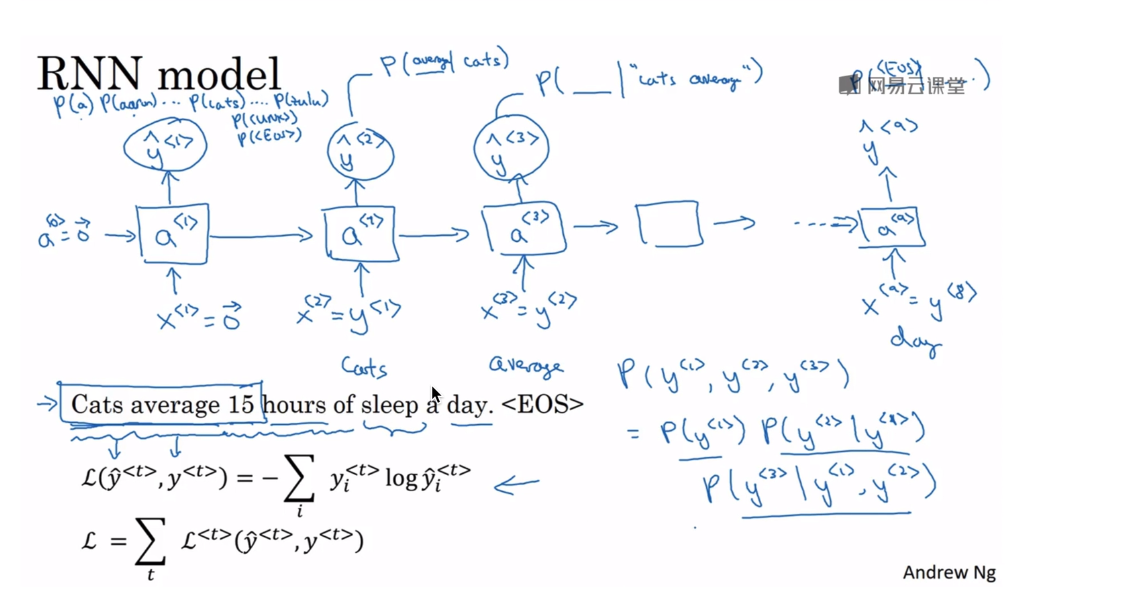

RNN模型:

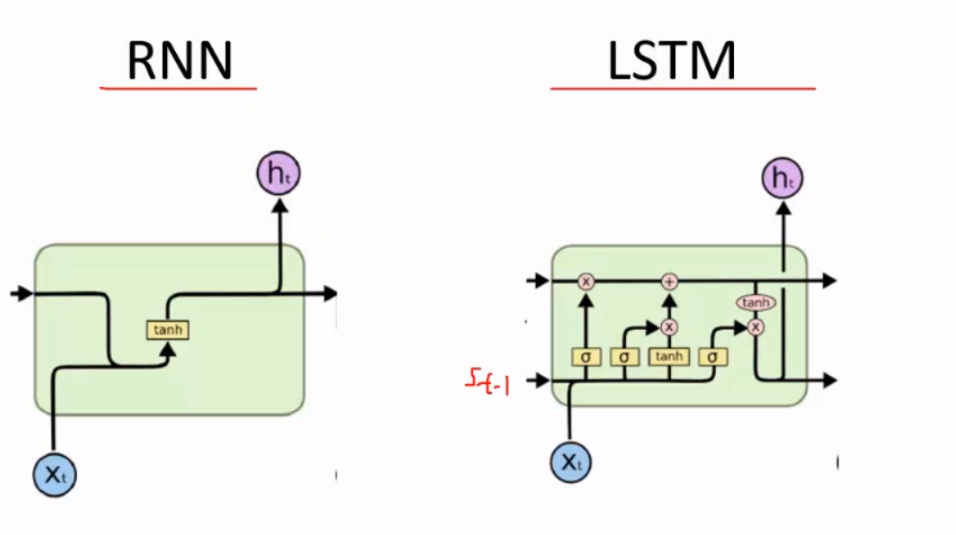

3.RNN和LSTM,由于LSTM

由于LSTM中,求Ct(记忆)是相加的形式,就可以保持长时间记忆,不像

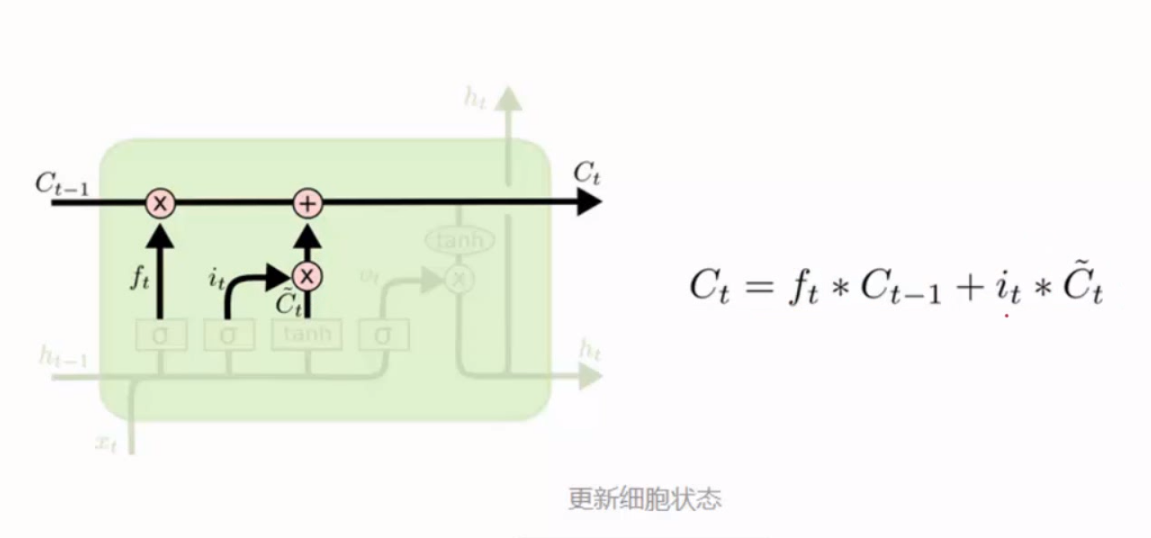

4.LSTM中的控制参数C,Ct-1:前一时刻的记忆,Ct:当前的记忆。通过下面传上来的概率值选择性接受或遗忘信息。sigmoid函数的作用是产生概率值。

5.ft的作用是用于遗忘Ct-1的部分信息,it的作用是用于保留Ct(hat)里面的部分信息,Ct(hat)代表这一次学到的信息。它们共同决定了这一次的记忆。比如:The cat,which has ..., is big.可以把which...这个Ct(hat)遗忘掉,只记住前面的the cat。

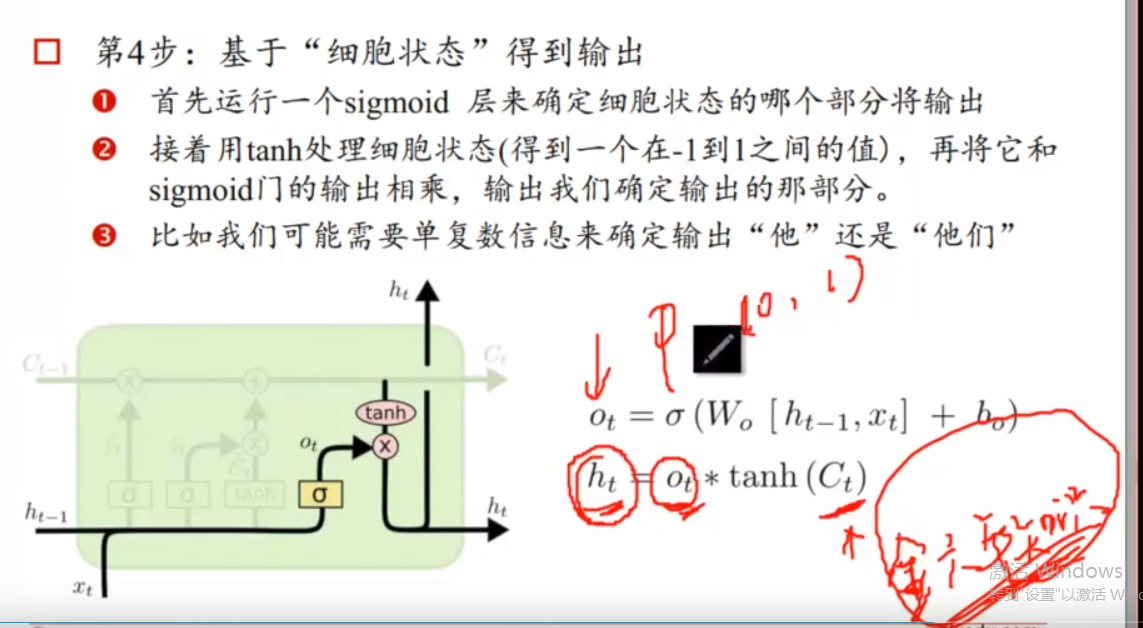

6.Ot是一个概率值,对当前的记忆做一个筛选,可以得到一个当前的输出ht。(根据记忆产生结果)

7.

由于LSTM中,求Ct(记忆)是相加的形式,而RNN中求St(记忆)是如下公式,那么利用梯度计算时RNN的连乘形式可能会使得结果为0,即啥也学不到,所以相比较,LSTM就可以保持长时间记忆。

8.

贝叶斯公式由来:

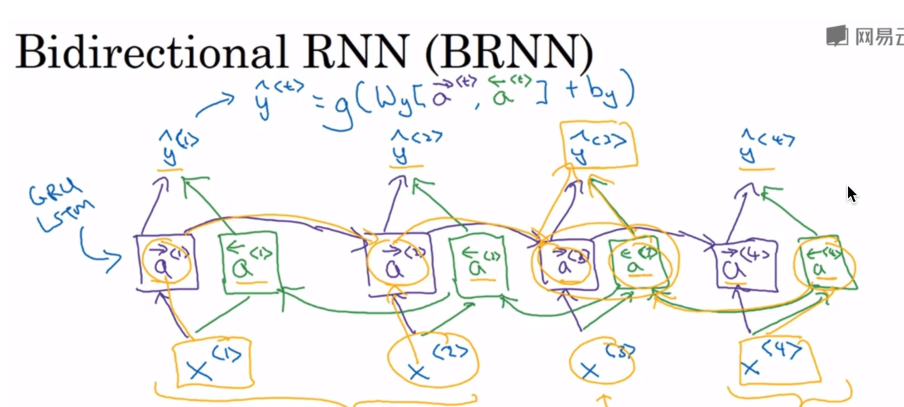

9.双向RNN:预测值由下面两部分共同决定

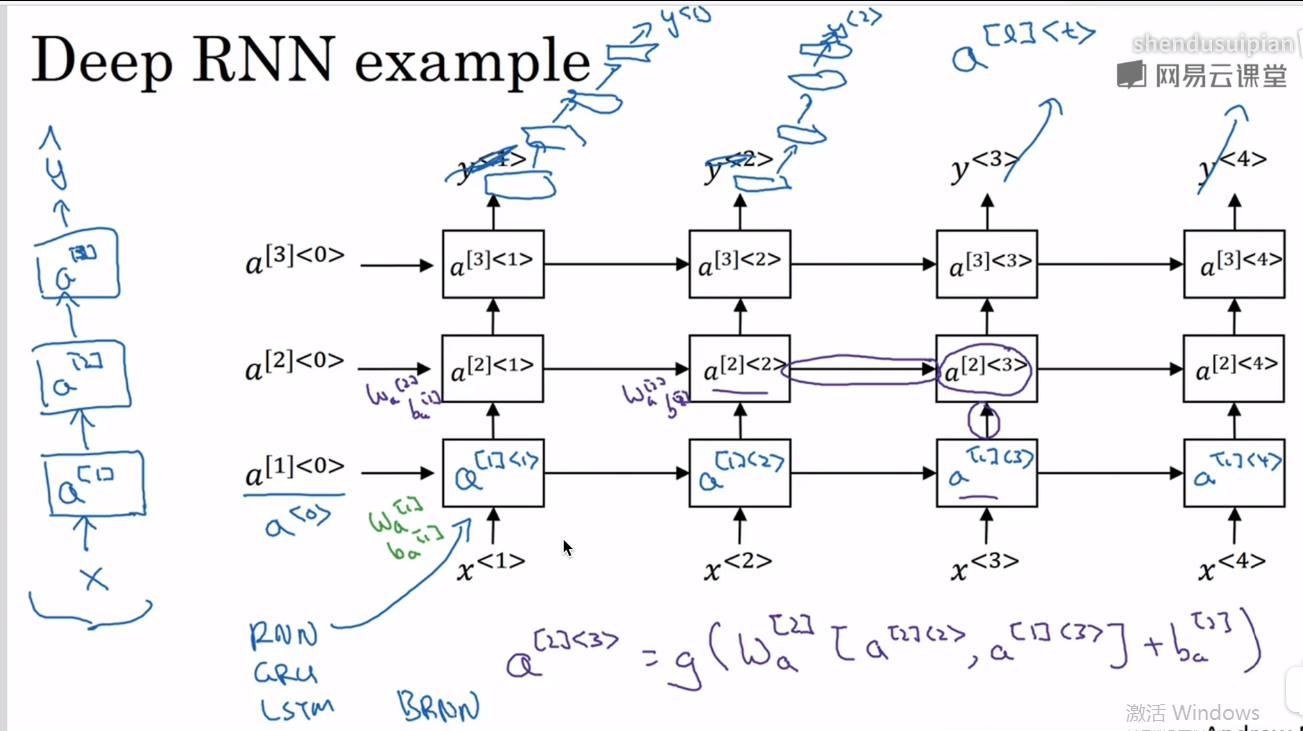

10.深层RNN,深在行

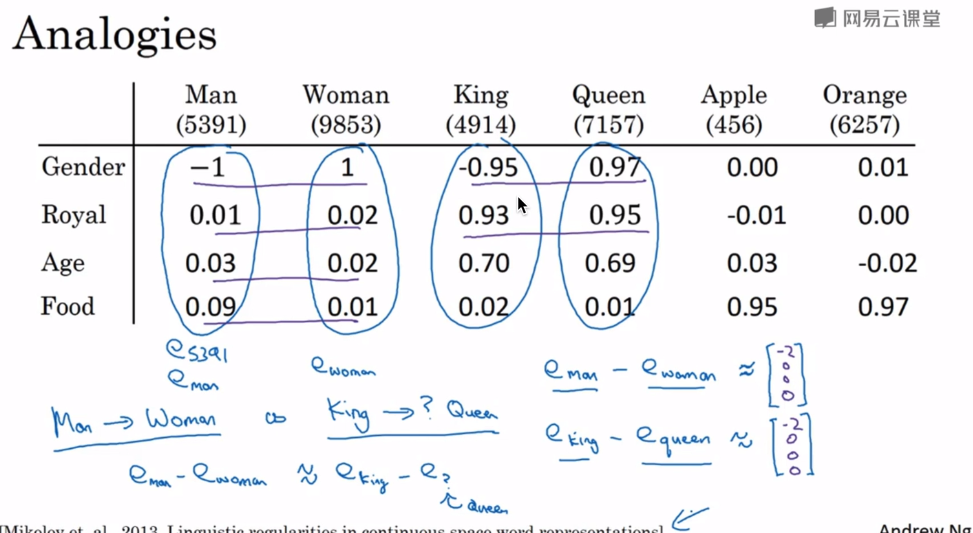

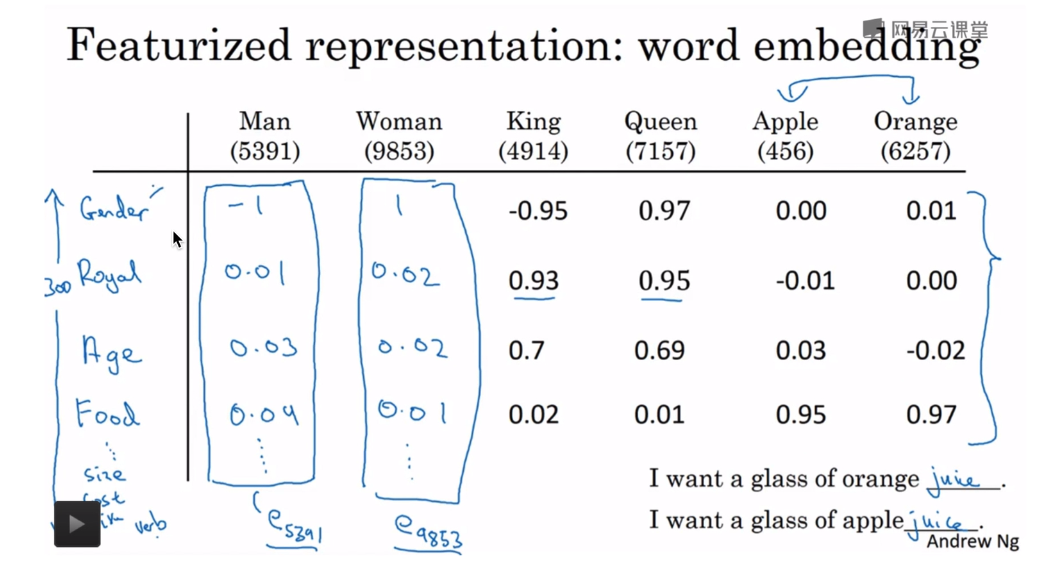

11.下图中每一行代表一个特征,每一列对应一个单词。可以通过下面这种方式得到单词与单词之间的联系,而不是用one-hot方式

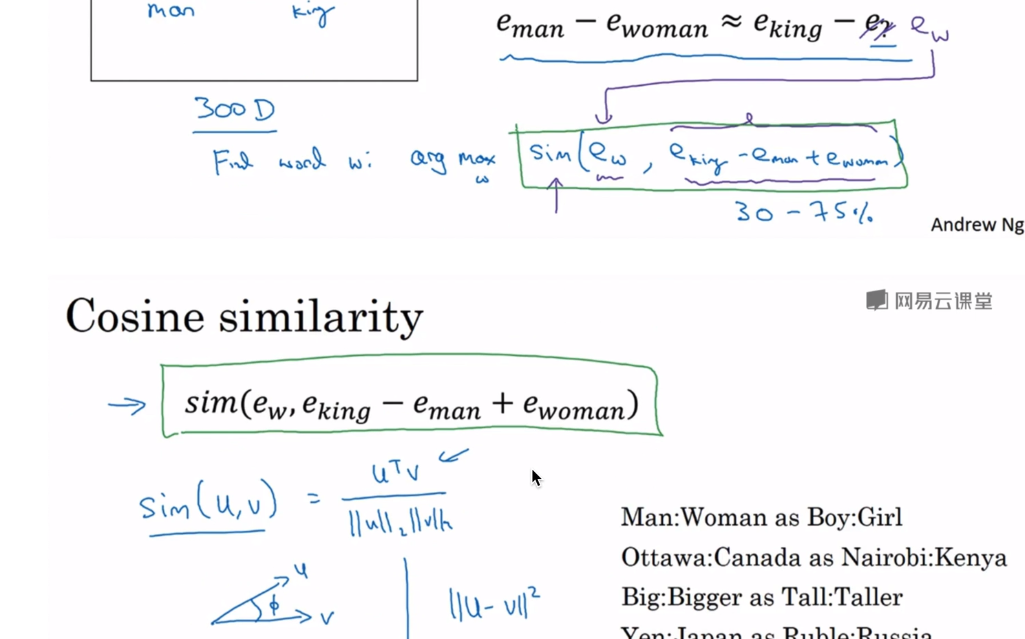

12.通过word embedding方式可以找到对比关系,比如男人和女人的关系就好比queen和king之间的关系(2个单词相减可以看出来,或者通过cos相似度方法求出来,或者求距离)