MAE (Masked Auto-Encoder)论文总结

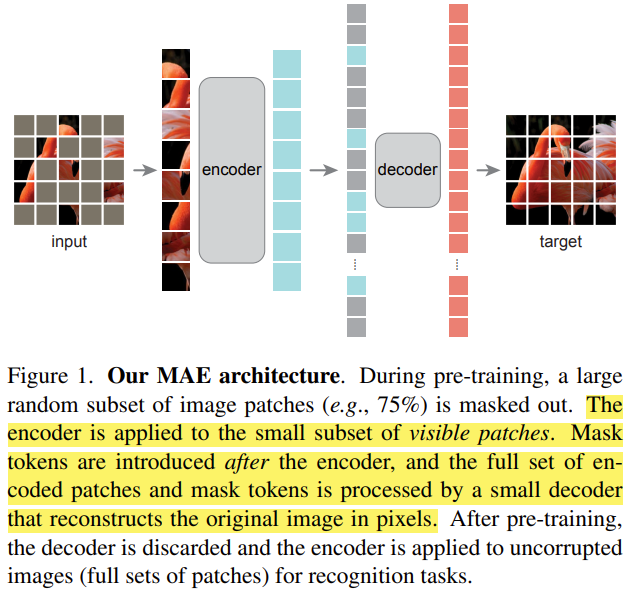

MAE的网络结构如上图所示,它是一个非对称的Encoder-Decoder架构的模型,非对称性主要体现在两点:

1. Encoder和Decoder都是Transformer结构,但是Decoder在深度和宽度上都比Encoder小很多;

2. Encoder仅将未被掩码的部分作为输入,而Decoder将整个图像的Patch(掩码标志和Encoder编码后的未被掩码patch的图像特征)作为输入。

论文原文:*2111.06377.pdf (arxiv.org)

知乎讲解:CV预训练MAE(Masked AutoEncoder) - 知乎 (zhihu.com)

浙公网安备 33010602011771号

浙公网安备 33010602011771号