权值衰减(weight decay)

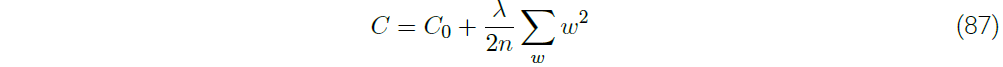

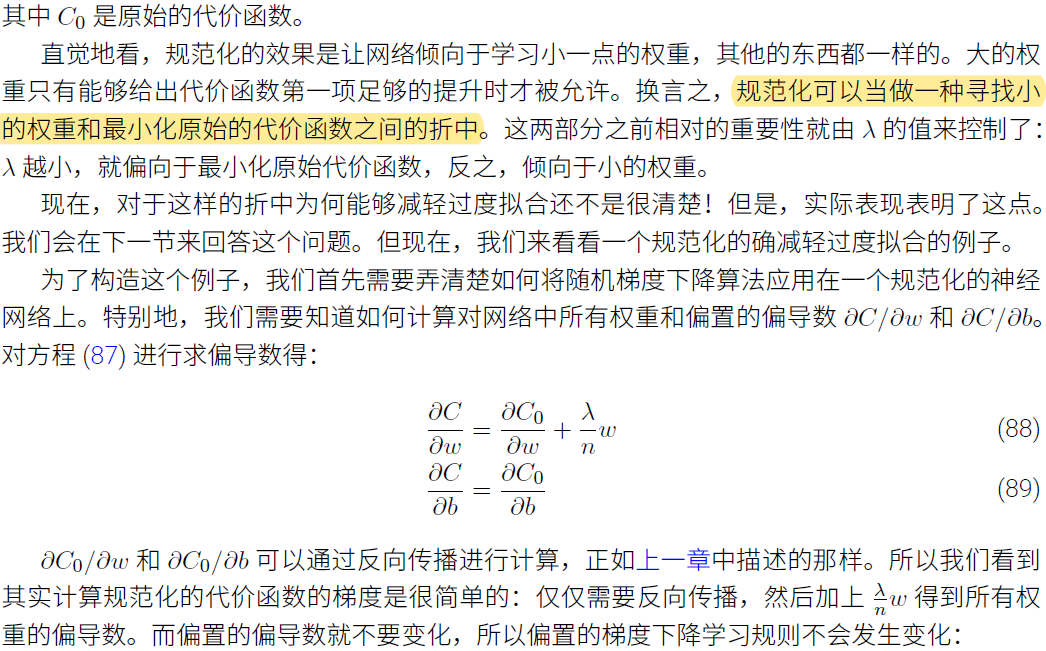

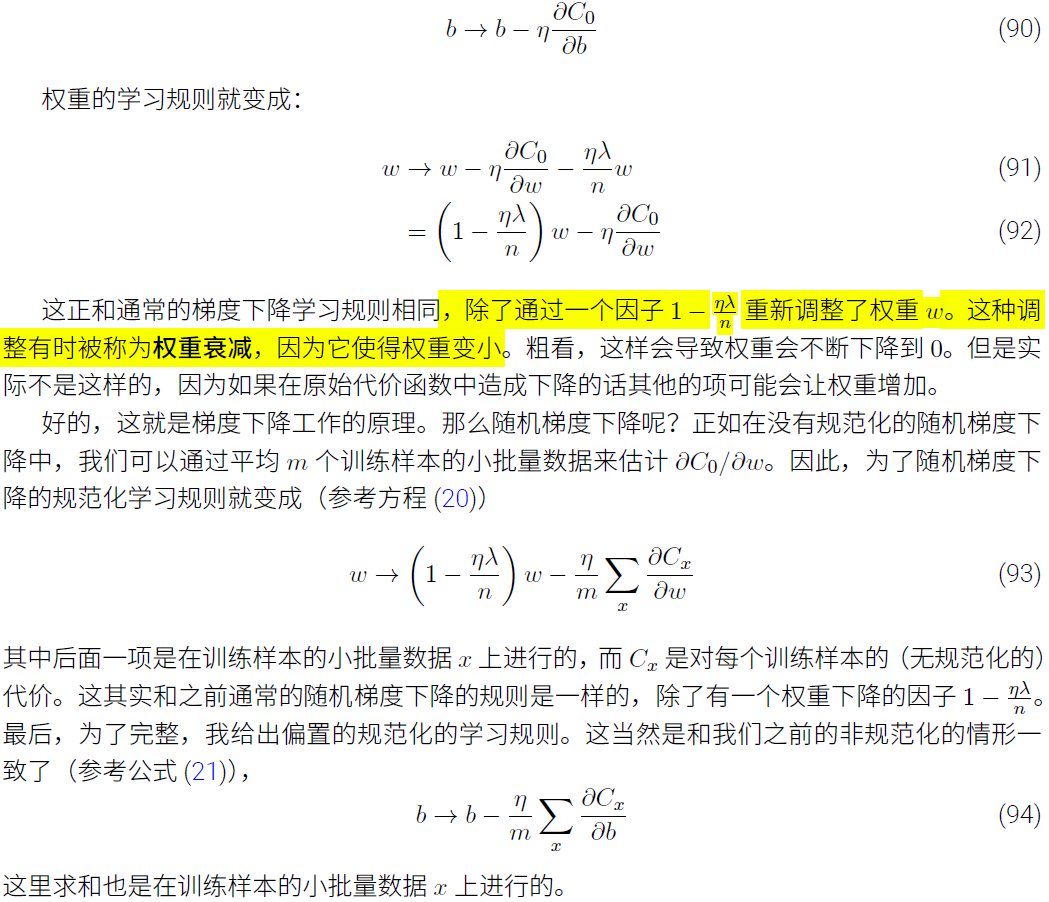

神经网络经常加入weight decay来防止过拟合,optimizer使用SGD时我们所说的weight decay通常指L2 weight decay,即,加在loss中的L2正则项。

L2正则项在Michael Nielsen的Neural Networks and Deep Learning的第三章第2节有比较详细的介绍,下面就直接从书里截图过来:

分类:

Deep Learning

标签:

权值衰减

【推荐】国内首个AI IDE,深度理解中文开发场景,立即下载体验Trae

【推荐】编程新体验,更懂你的AI,立即体验豆包MarsCode编程助手

【推荐】抖音旗下AI助手豆包,你的智能百科全书,全免费不限次数

【推荐】轻量又高性能的 SSH 工具 IShell:AI 加持,快人一步

· Manus爆火,是硬核还是营销?

· 终于写完轮子一部分:tcp代理 了,记录一下

· 震惊!C++程序真的从main开始吗?99%的程序员都答错了

· 别再用vector<bool>了!Google高级工程师:这可能是STL最大的设计失误

· 单元测试从入门到精通

2021-05-11 转:Zero-shot Learning / One-shot Learning / Few-shot Learning

2020-05-11 论文笔记:Multiview Subspace Clustering via Tensorial t-Product Representation

2020-05-11 不定长数目参数,*args, **kwargs