Transformer相关资料

微信视频讲解(1) (推荐)

微信视频讲解(2) (推荐)

Transformer 详解 (有详细的原理以及pytorch代码实现讲解,推荐)

Vision Transformer 超详细解读 (原理分析+代码解读) (一) (推荐)

举个例子讲下transformer的输入输出细节及其他 (transformer为什么可以并行计算讲的很清晰。)

position embedding:

一文搞懂Transformer的位置编码_transformer位置编码-CSDN博客 (推荐)

This post is all you need(②位置编码与编码解码过程)

RNN LSTM、Seq2Seq、Attention、Self-attention (哔哩哔哩视频1)

Vision Transformer 超详细解读 (原理分析+代码解读) (目录)

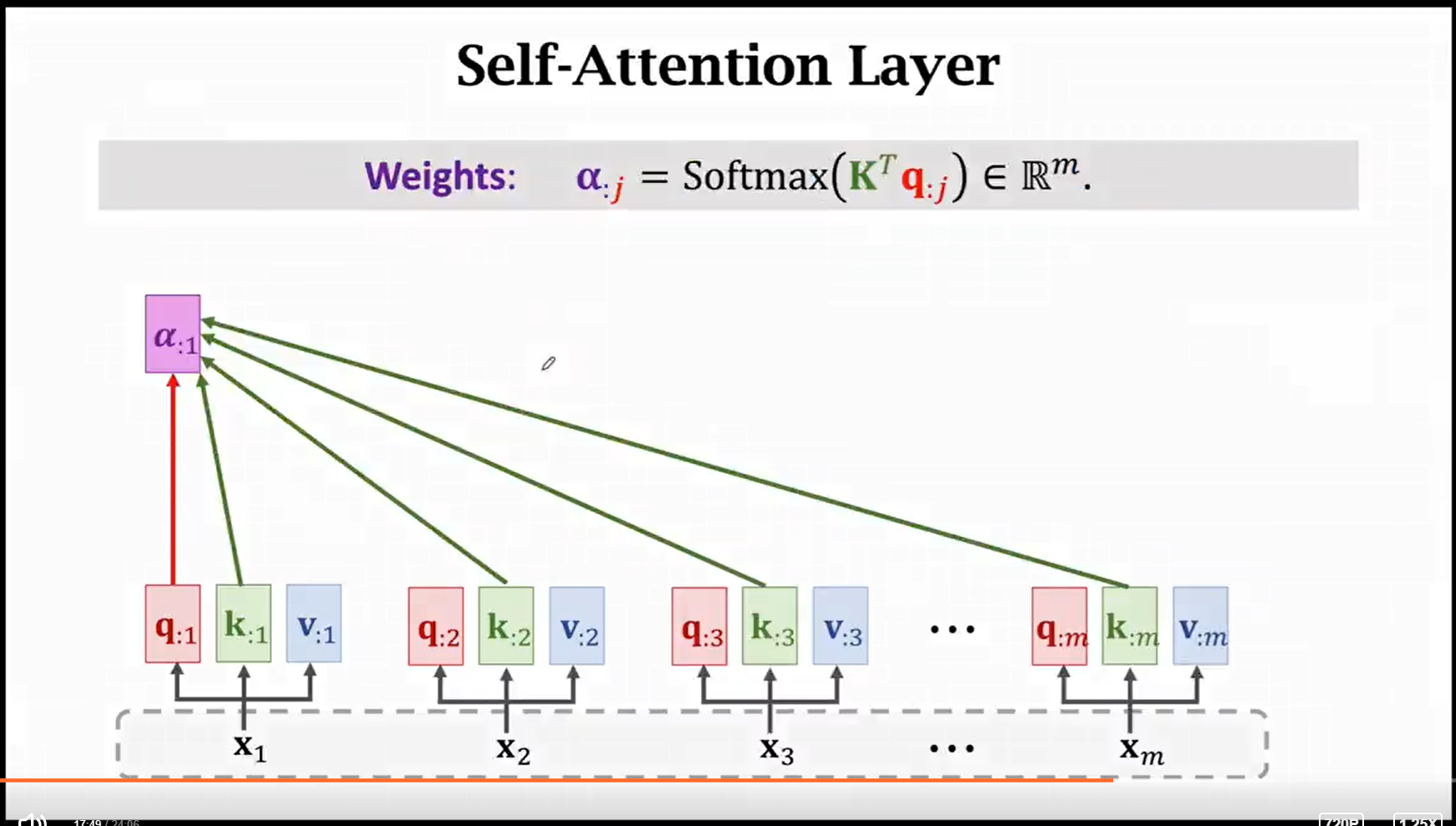

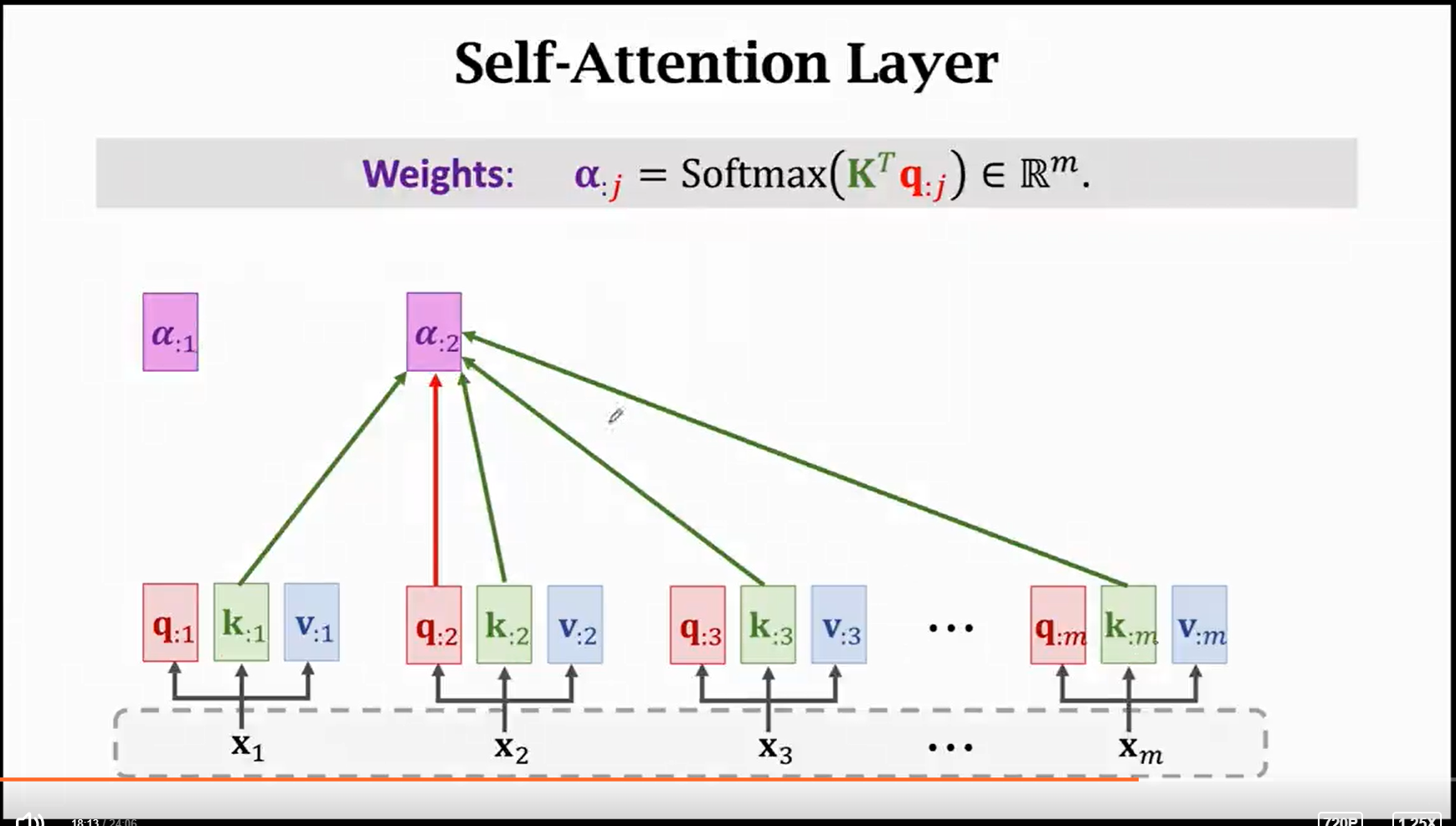

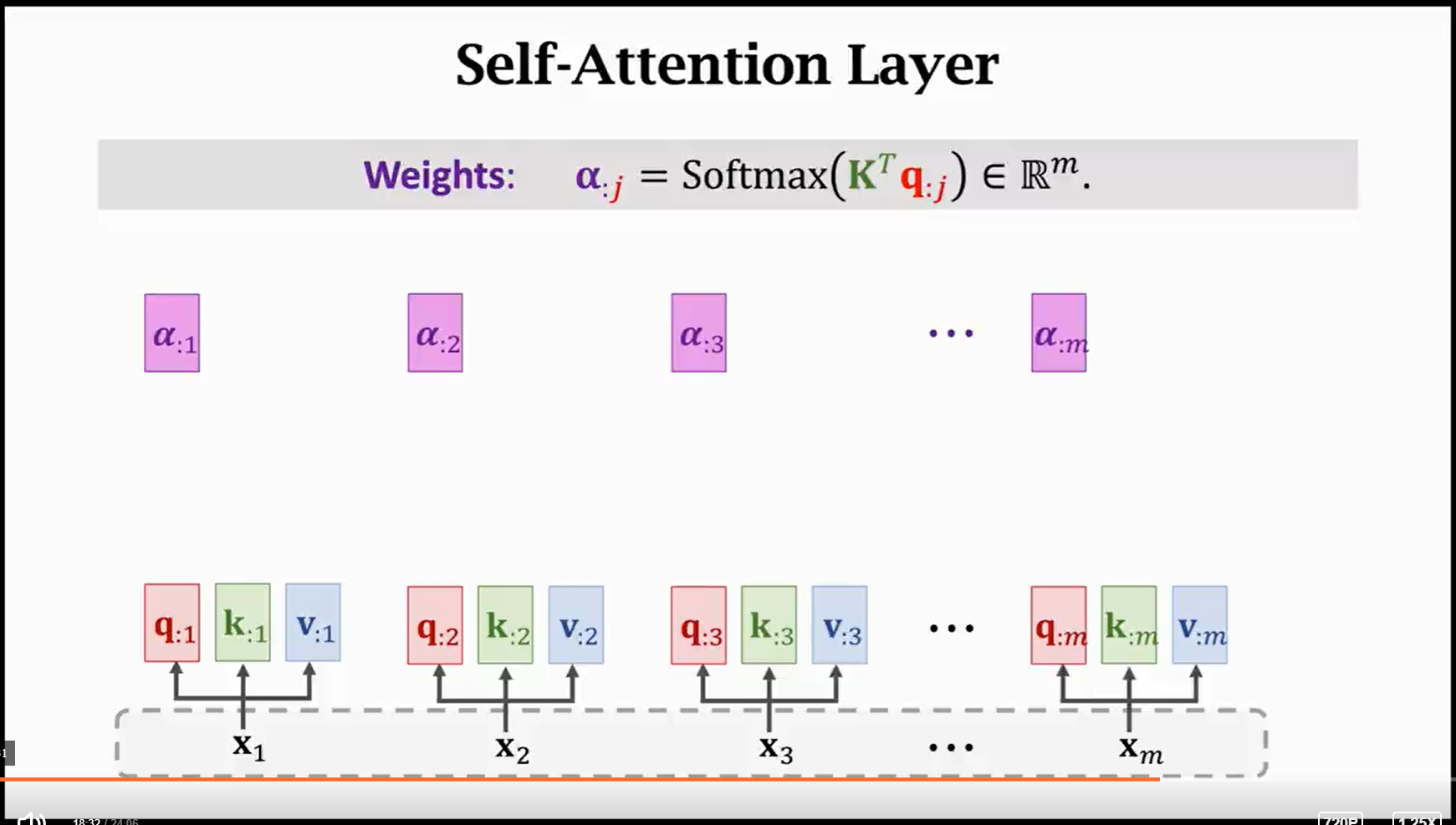

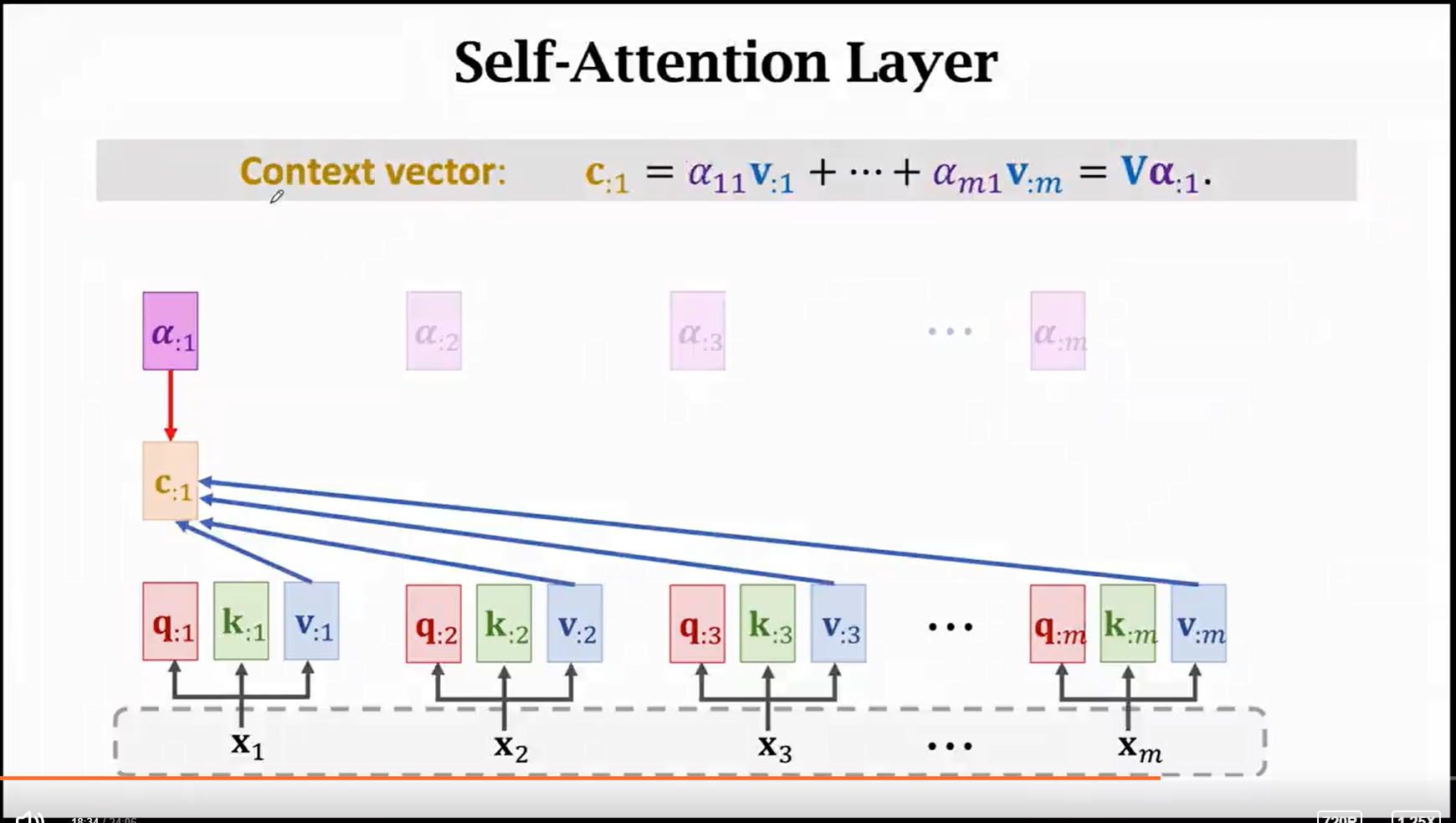

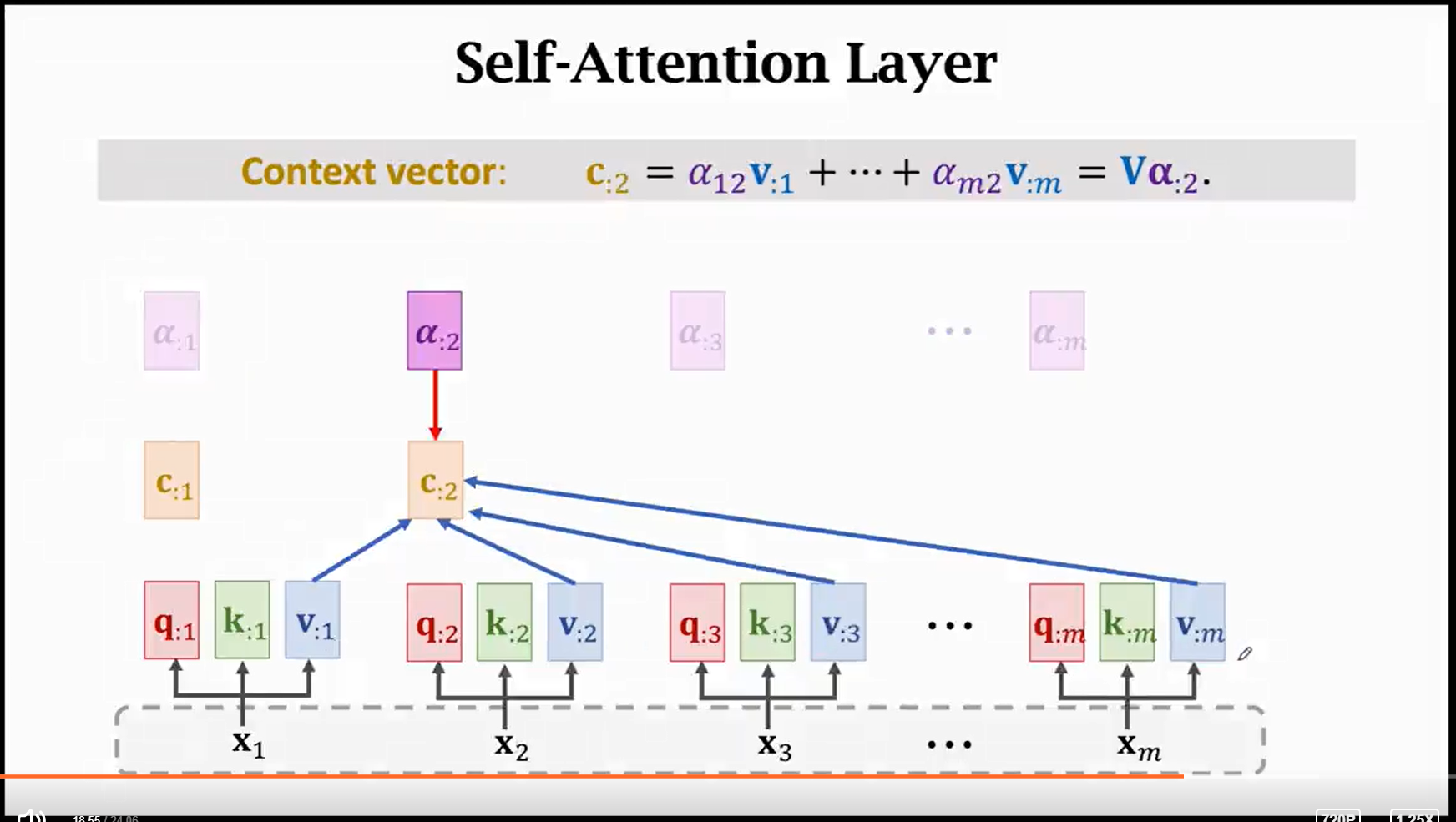

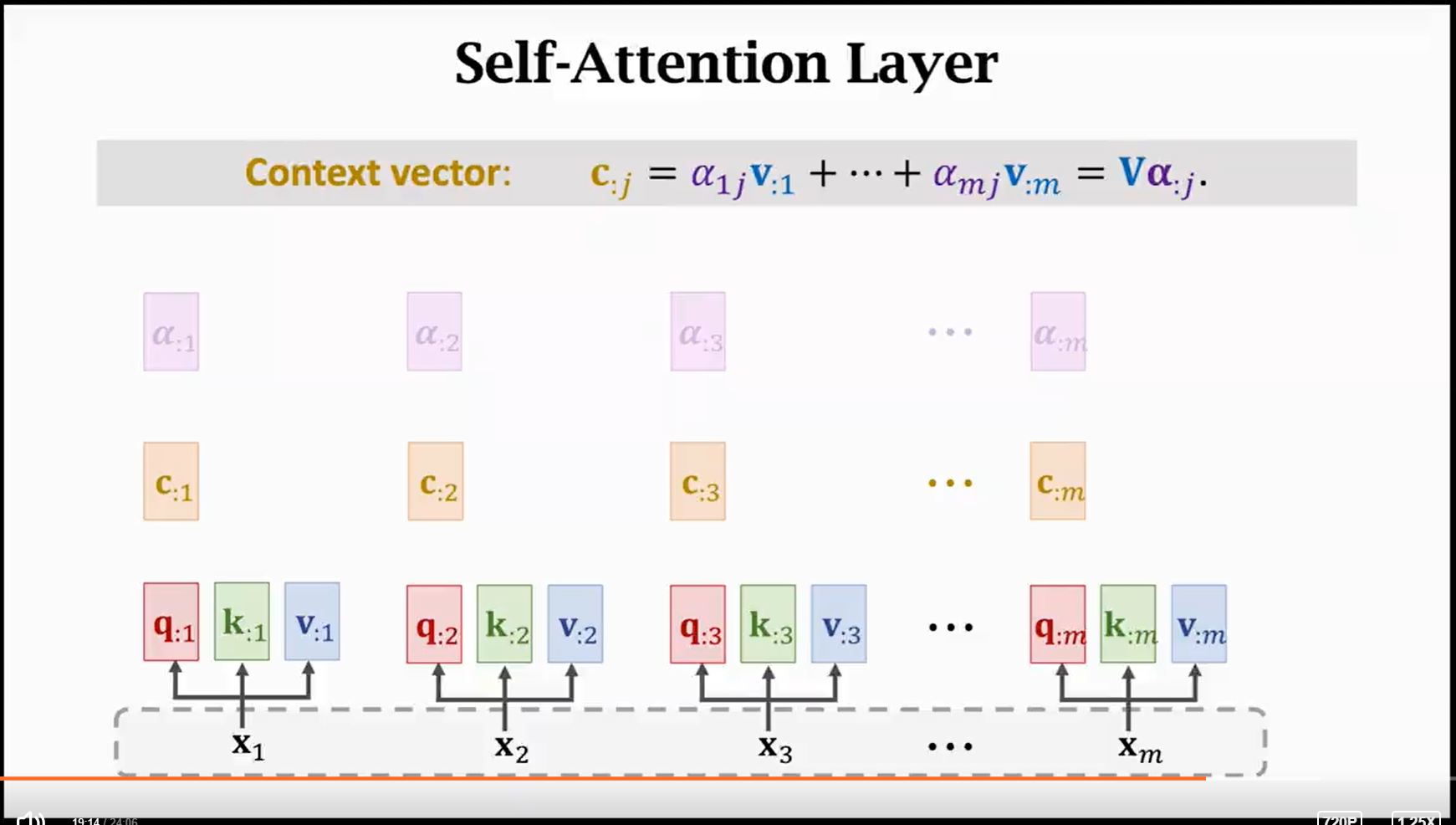

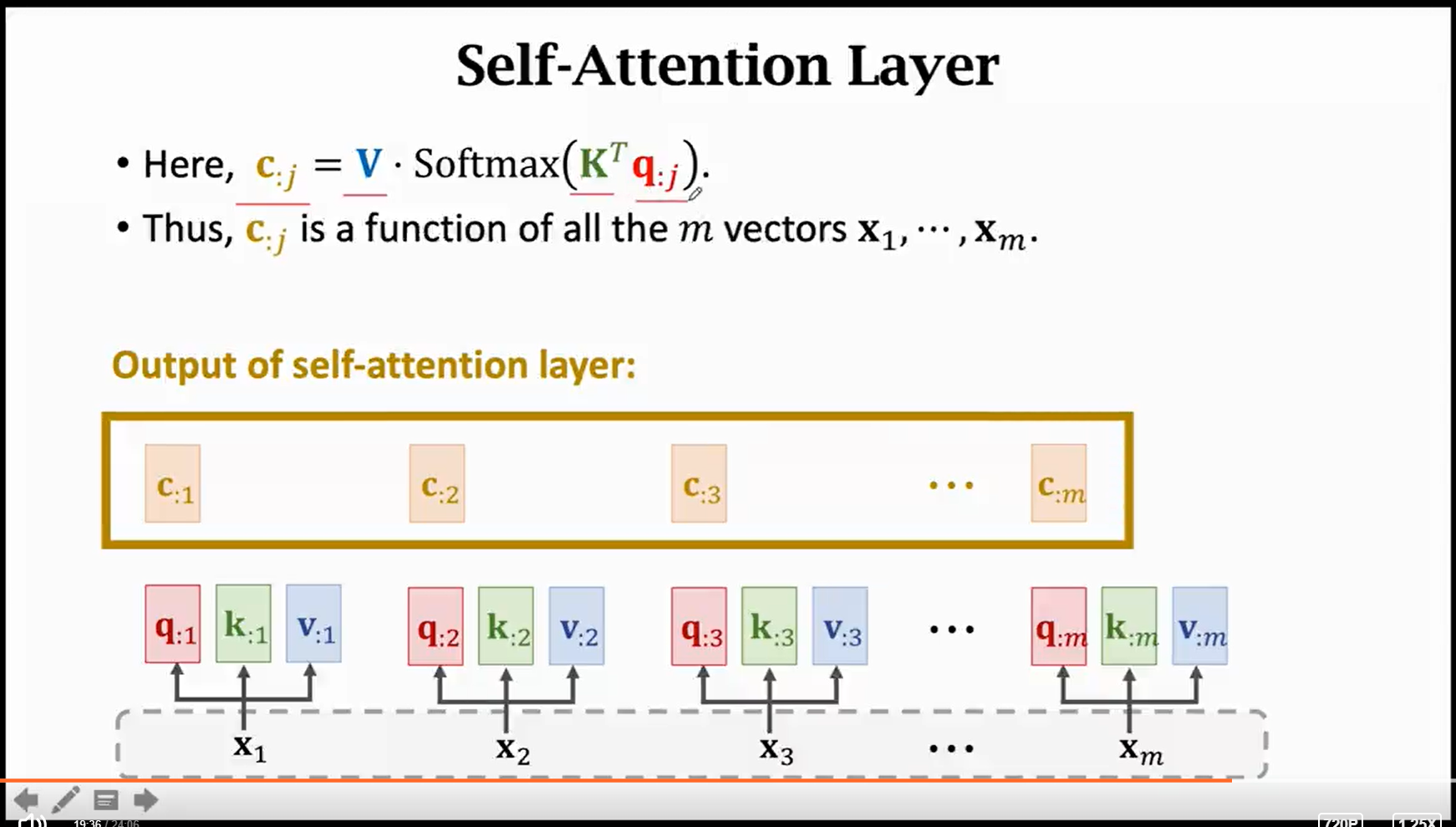

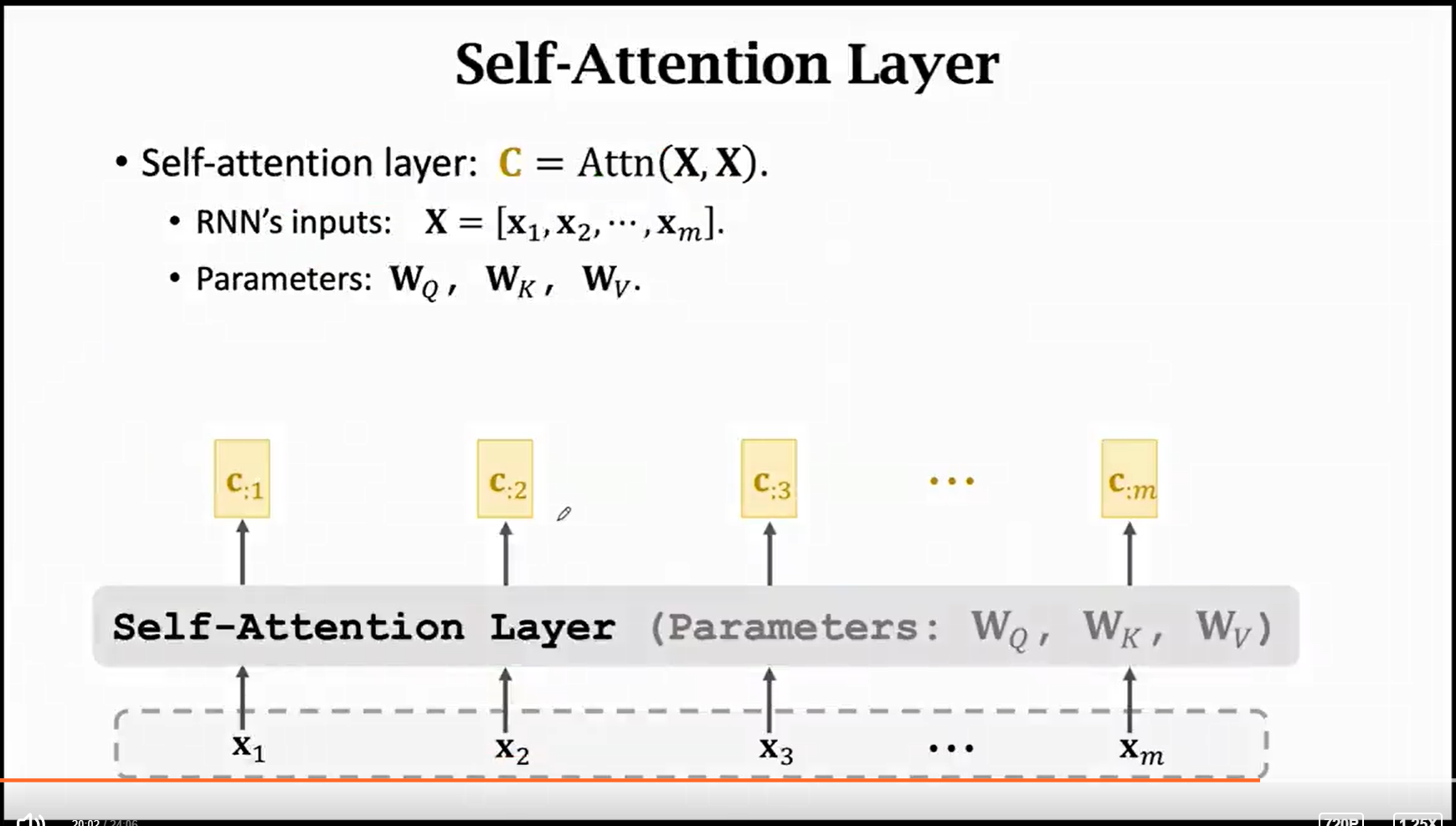

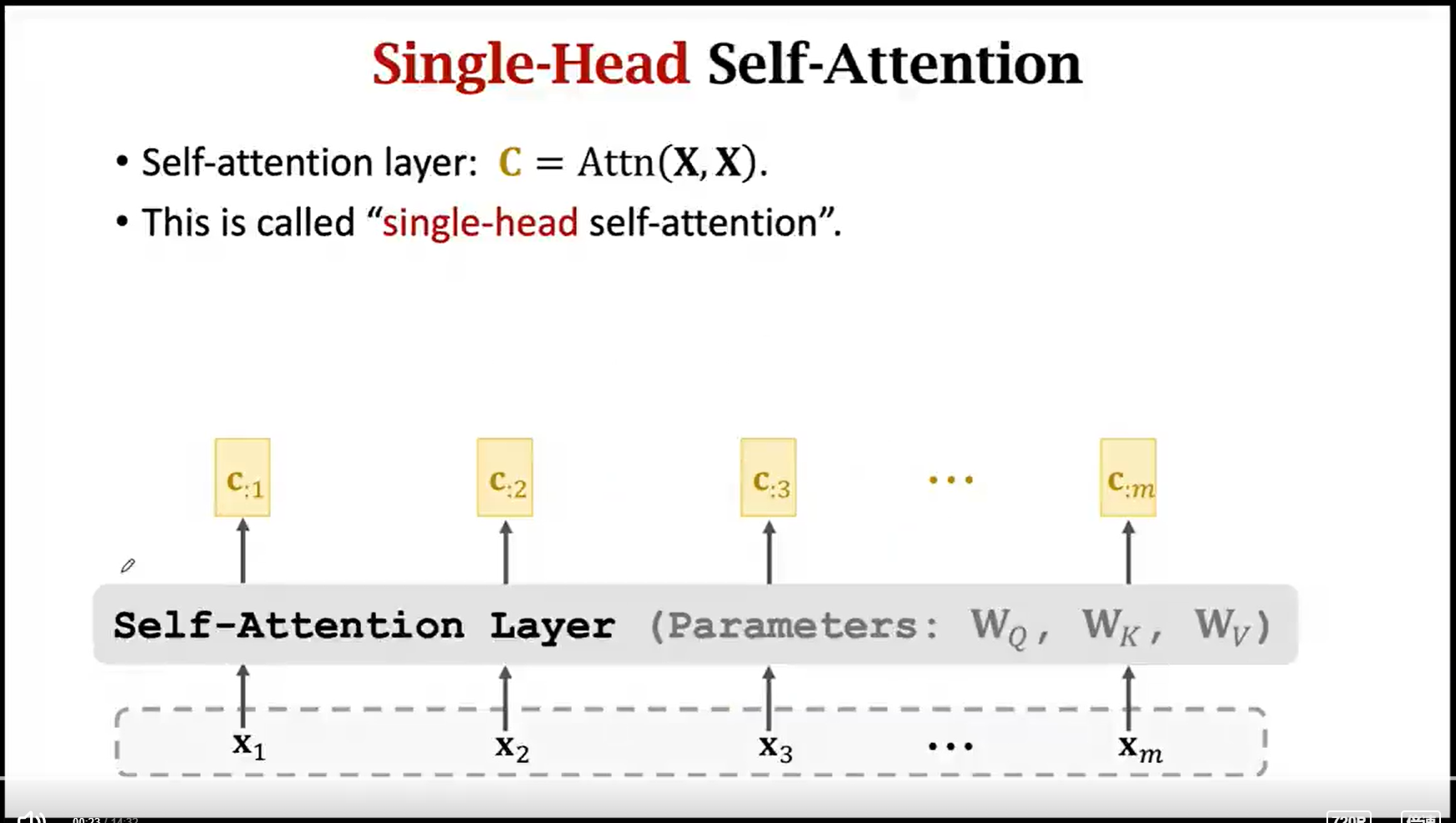

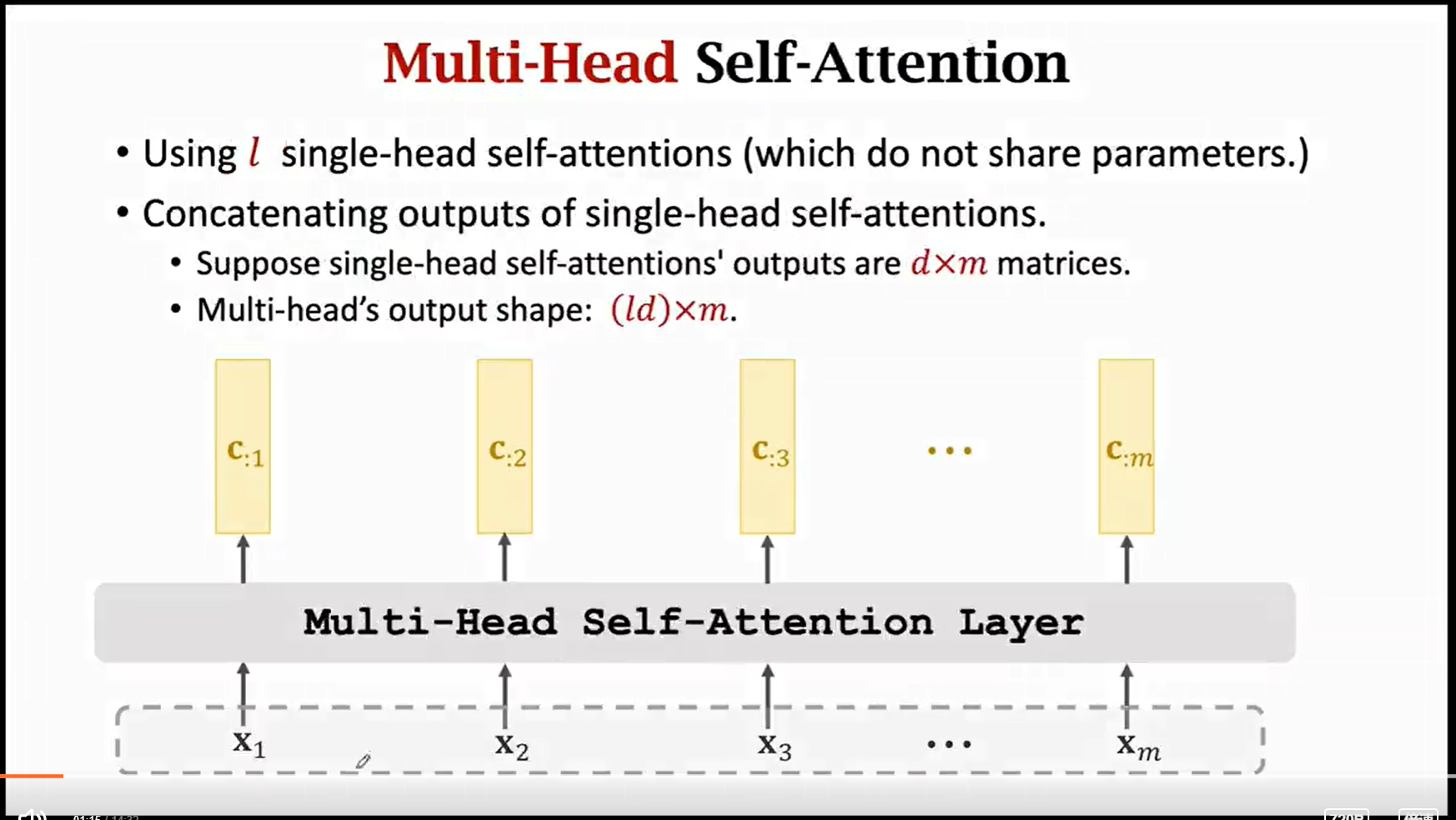

1 2 3 4 5 6 7 8 9 10 11 12 | self-attention的计算量:计算Q, K, V: 乘法:d * d * n * 3 加法:(d-1) * d * n * 3计算相似度矩阵: 乘法:d * n * n 加法:(d-1) * n * n计算output: 乘法:n * d * n 加法:(n-1) * d * n |

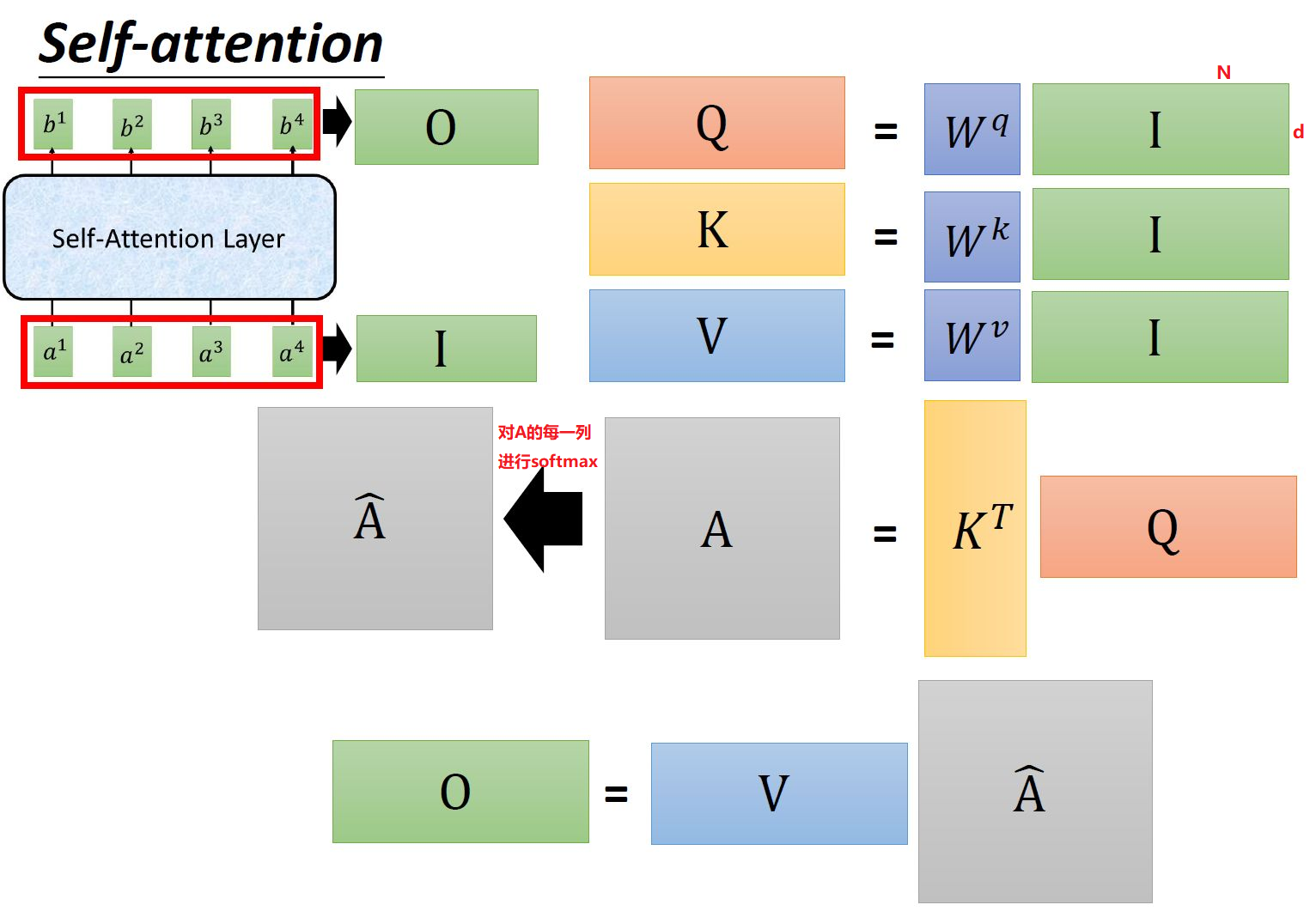

如果输入矩阵中一列表示一个样本:

如果输入矩阵中一行表示一个样本:(把上面公式的分母转置一下)

self-attention的计算复杂度分析(摘自https://zhuanlan.zhihu.com/p/361366090):

==============================================================

==============================================================

==============================================================

==============================================================

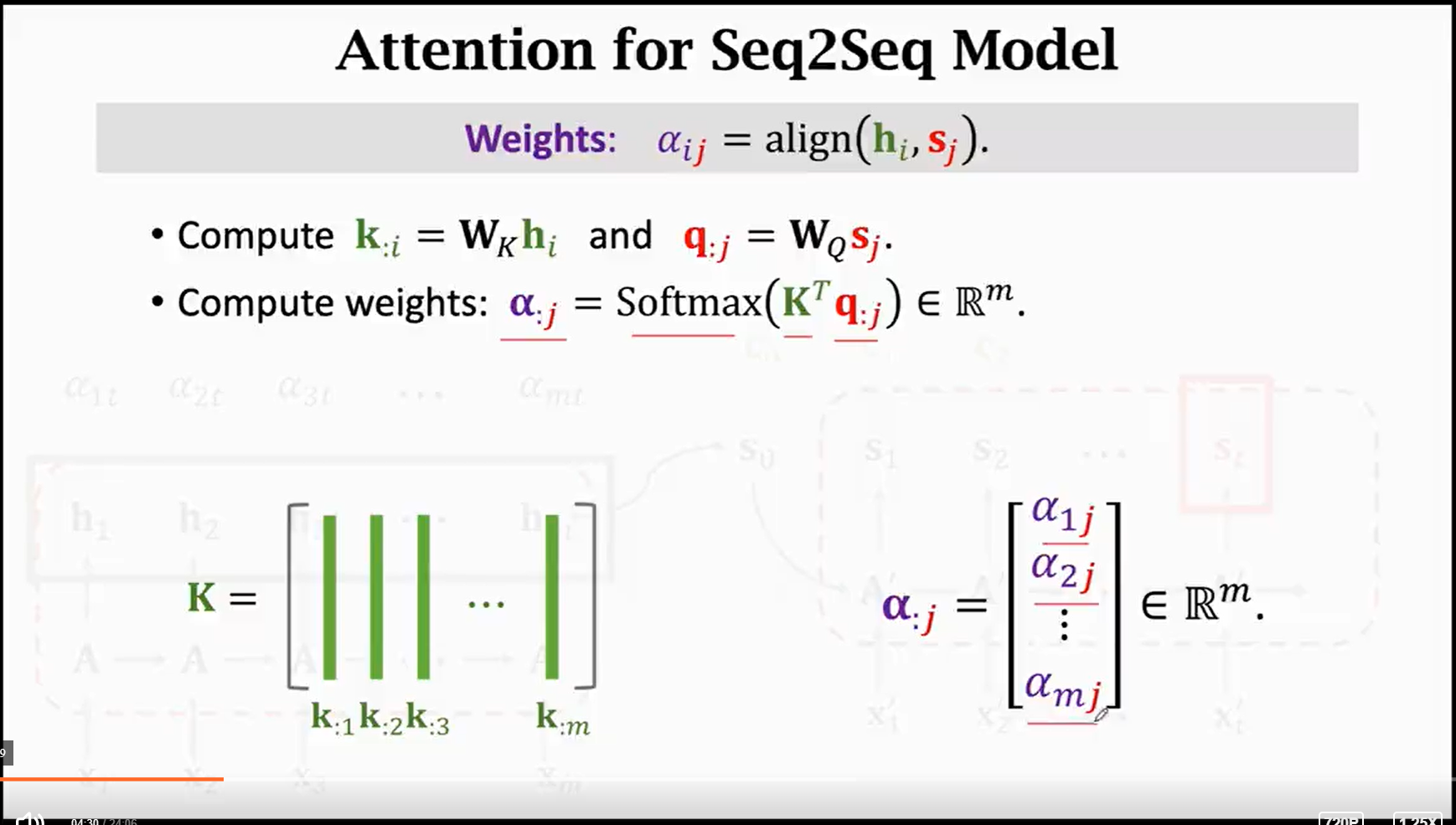

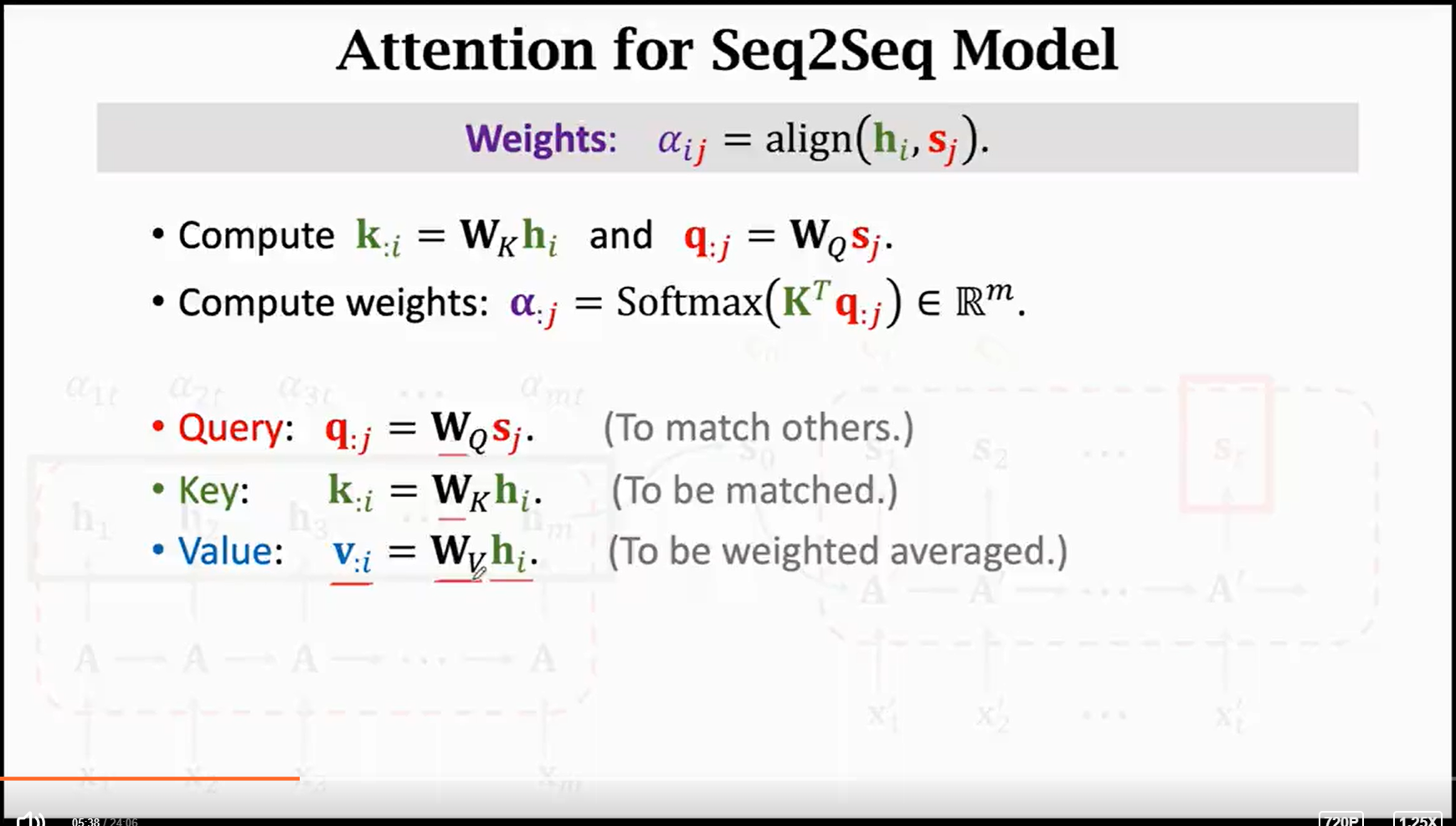

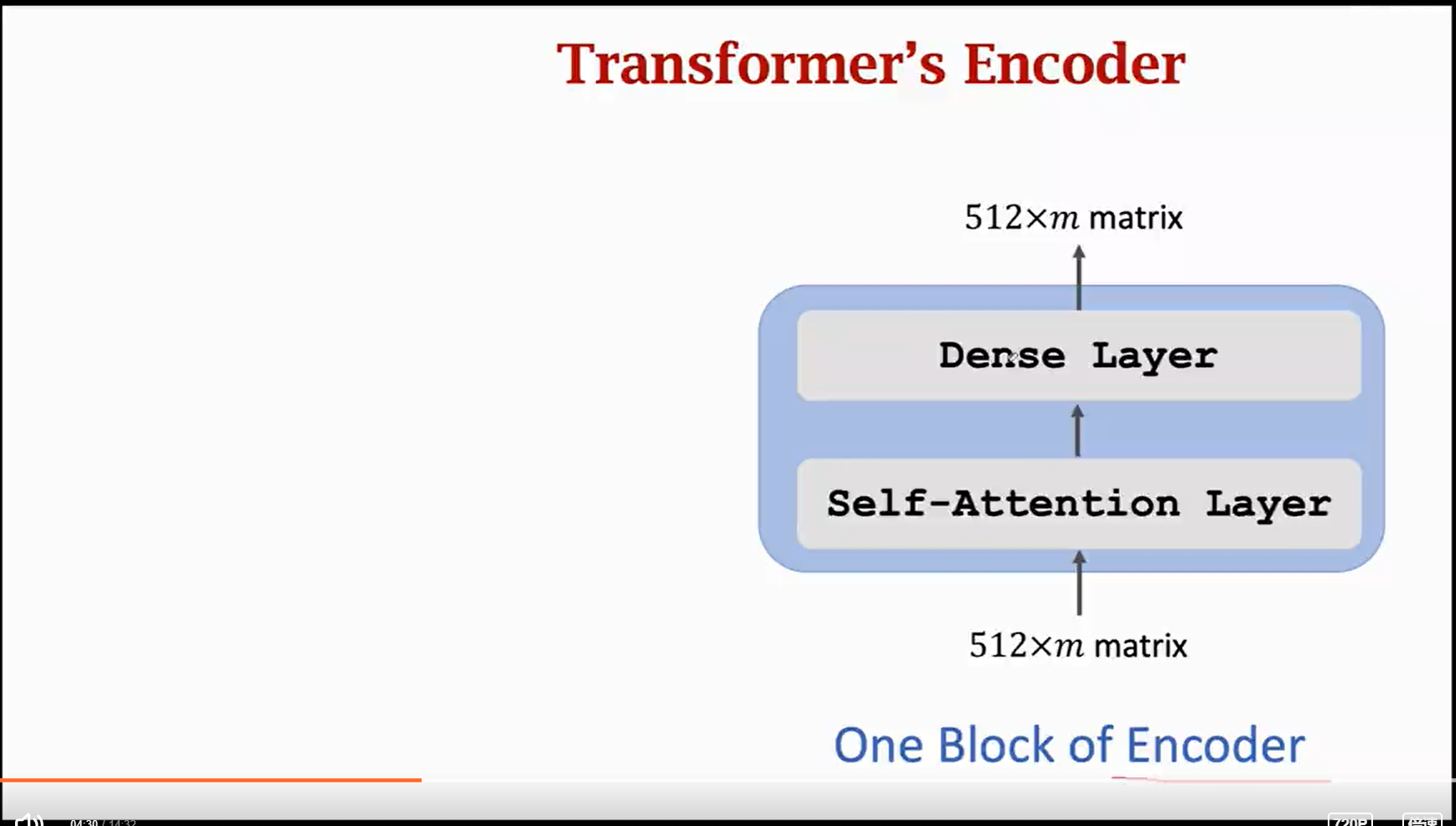

上面的的PPT摘自本文开头的两个参考资料。

【推荐】国内首个AI IDE,深度理解中文开发场景,立即下载体验Trae

【推荐】编程新体验,更懂你的AI,立即体验豆包MarsCode编程助手

【推荐】抖音旗下AI助手豆包,你的智能百科全书,全免费不限次数

【推荐】轻量又高性能的 SSH 工具 IShell:AI 加持,快人一步

· 基于Microsoft.Extensions.AI核心库实现RAG应用

· Linux系列:如何用heaptrack跟踪.NET程序的非托管内存泄露

· 开发者必知的日志记录最佳实践

· SQL Server 2025 AI相关能力初探

· Linux系列:如何用 C#调用 C方法造成内存泄露

· Manus爆火,是硬核还是营销?

· 终于写完轮子一部分:tcp代理 了,记录一下

· 震惊!C++程序真的从main开始吗?99%的程序员都答错了

· 别再用vector<bool>了!Google高级工程师:这可能是STL最大的设计失误

· 单元测试从入门到精通

2020-04-21 numpy, matplotlib, pandas 精品教程