模型蒸馏,蒸馏损失函数实现,蒸馏方法介绍

1. 蒸馏损失函数代码实现

摘自:知识蒸馏loss求解方法 - tangjunjun - 博客园 (cnblogs.com)

1 2 3 4 5 6 7 8 9 10 11 12 13 14 15 16 17 18 | import torchimport torch.nn as nnimport numpy as nploss_f = nn.KLDivLoss()# 生成网络输出 以及 目标输出model_student = torch.from_numpy(np.array([[0.1132, 0.5477, 0.3390]])).float() # 假设学生模型输出model_teacher = torch.from_numpy(np.array([[0.8541, 0.0511, 0.0947]])).float() #假设教师模型输出label=torch.tensor([0]) # 真实标签loss_KD = loss_f(model_student, model_teacher)L=nn.CrossEntropyLoss()loss_SL=L(model_student,label)lambda_ ,T=0.6,3 # 分别为设置权重参数,T为温度系数loss = (1 - lambda_) * loss_SL + lambda_ * T * T * loss_KD # hint和jeff dean论文print('\nloss: ', loss) |

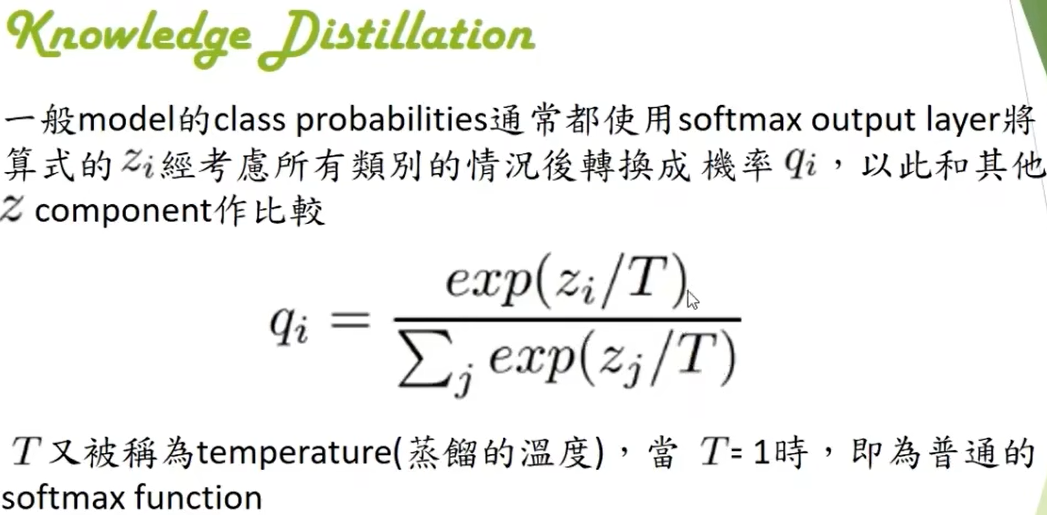

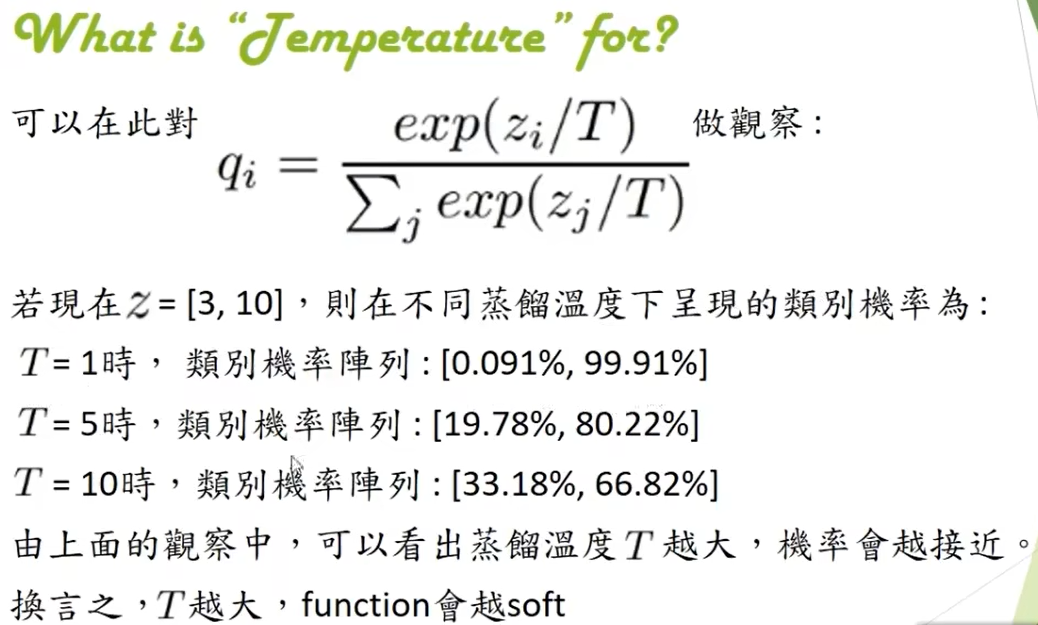

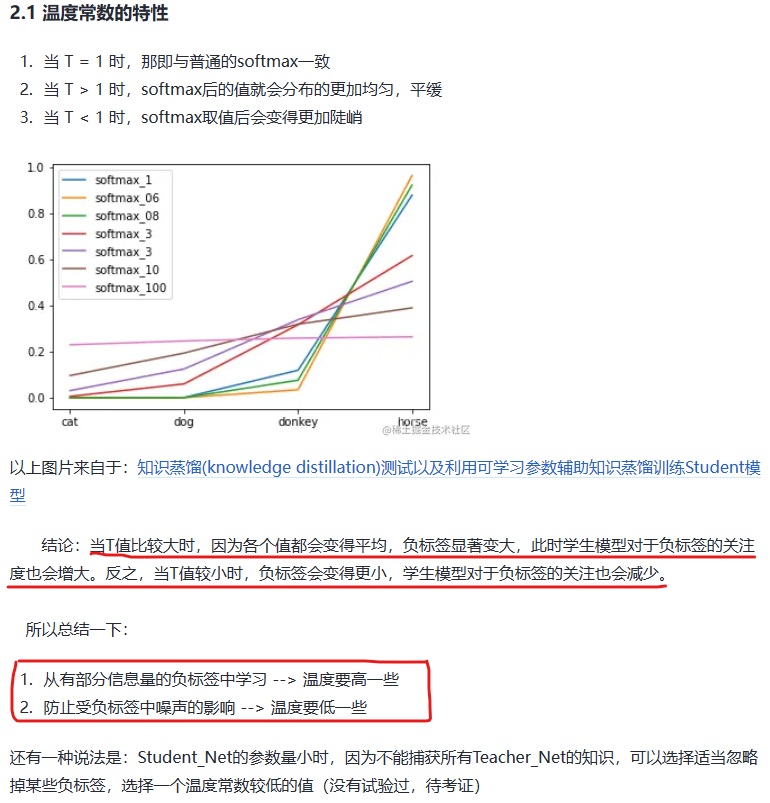

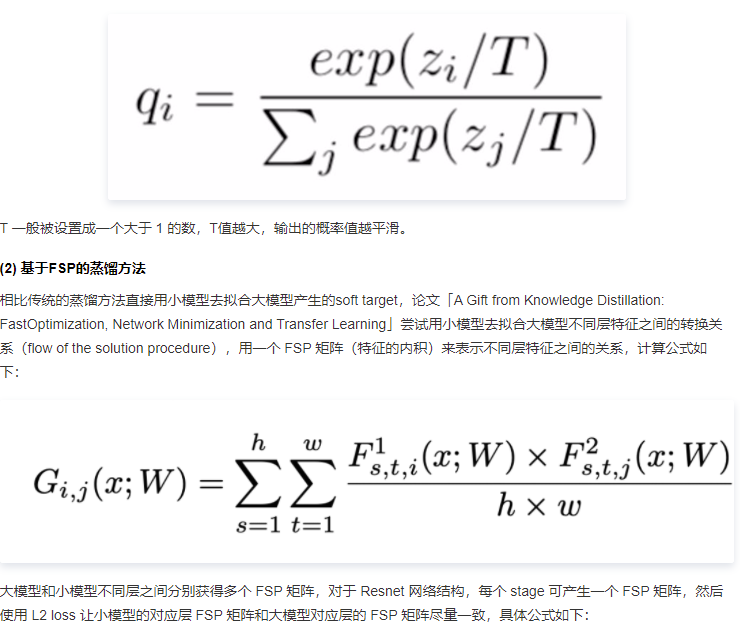

2. 蒸馏损失函数中温度的介绍和设定

摘自:李宏毅2020机器学习深度学习 和 知识蒸馏中的温度参数(2)

此外,蒸馏中温度设定的高级技巧还可以参考 bert知识蒸馏动态温度设置Annealing Knowledge Distillation (EACL 2021)& Reducing the Teacher-Student Gap - 知乎 (zhihu.com)。

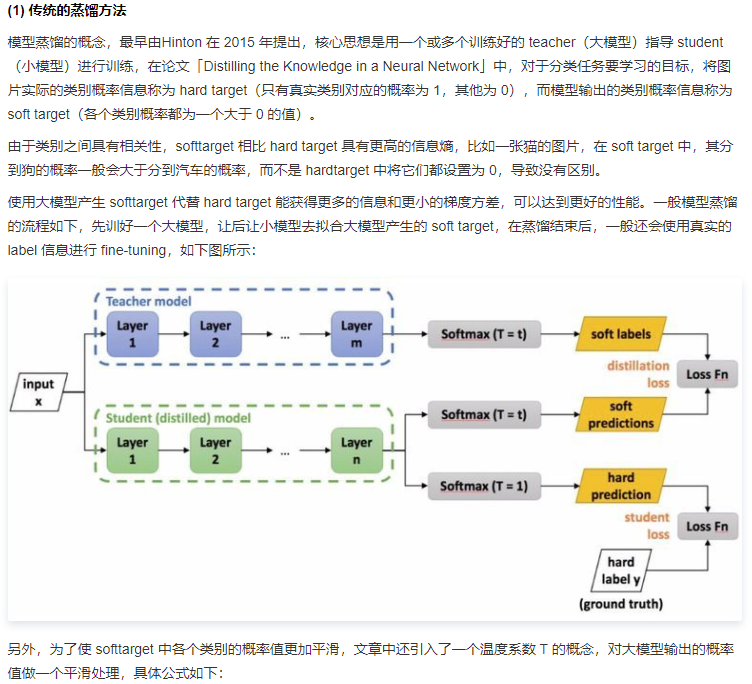

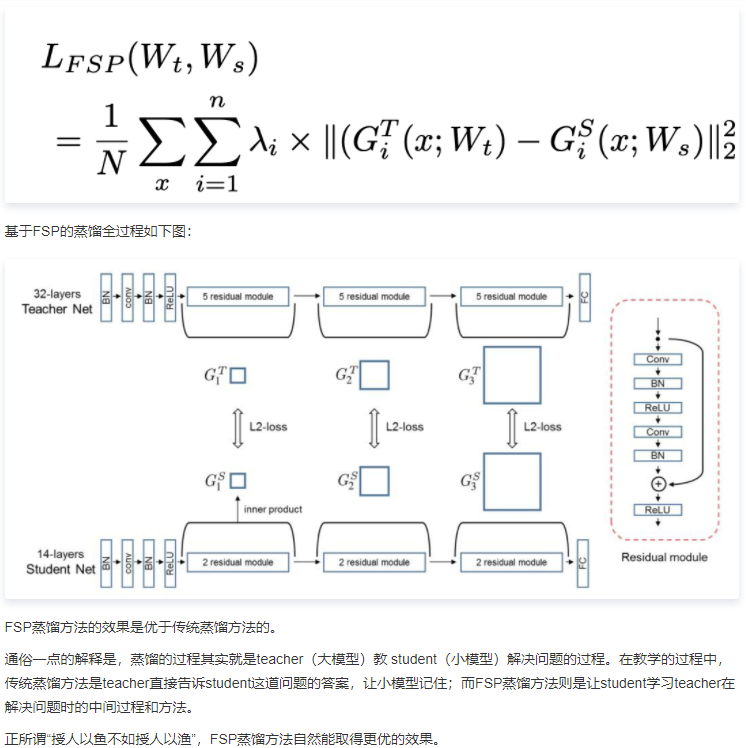

3. 蒸馏方法介绍

分类:

Deep Learning

【推荐】国内首个AI IDE,深度理解中文开发场景,立即下载体验Trae

【推荐】编程新体验,更懂你的AI,立即体验豆包MarsCode编程助手

【推荐】抖音旗下AI助手豆包,你的智能百科全书,全免费不限次数

【推荐】轻量又高性能的 SSH 工具 IShell:AI 加持,快人一步

· 基于Microsoft.Extensions.AI核心库实现RAG应用

· Linux系列:如何用heaptrack跟踪.NET程序的非托管内存泄露

· 开发者必知的日志记录最佳实践

· SQL Server 2025 AI相关能力初探

· Linux系列:如何用 C#调用 C方法造成内存泄露

· Manus爆火,是硬核还是营销?

· 终于写完轮子一部分:tcp代理 了,记录一下

· 震惊!C++程序真的从main开始吗?99%的程序员都答错了

· 别再用vector<bool>了!Google高级工程师:这可能是STL最大的设计失误

· 单元测试从入门到精通

2020-04-03 re库和正则表达式