Python实现PCA降维

PCA算法

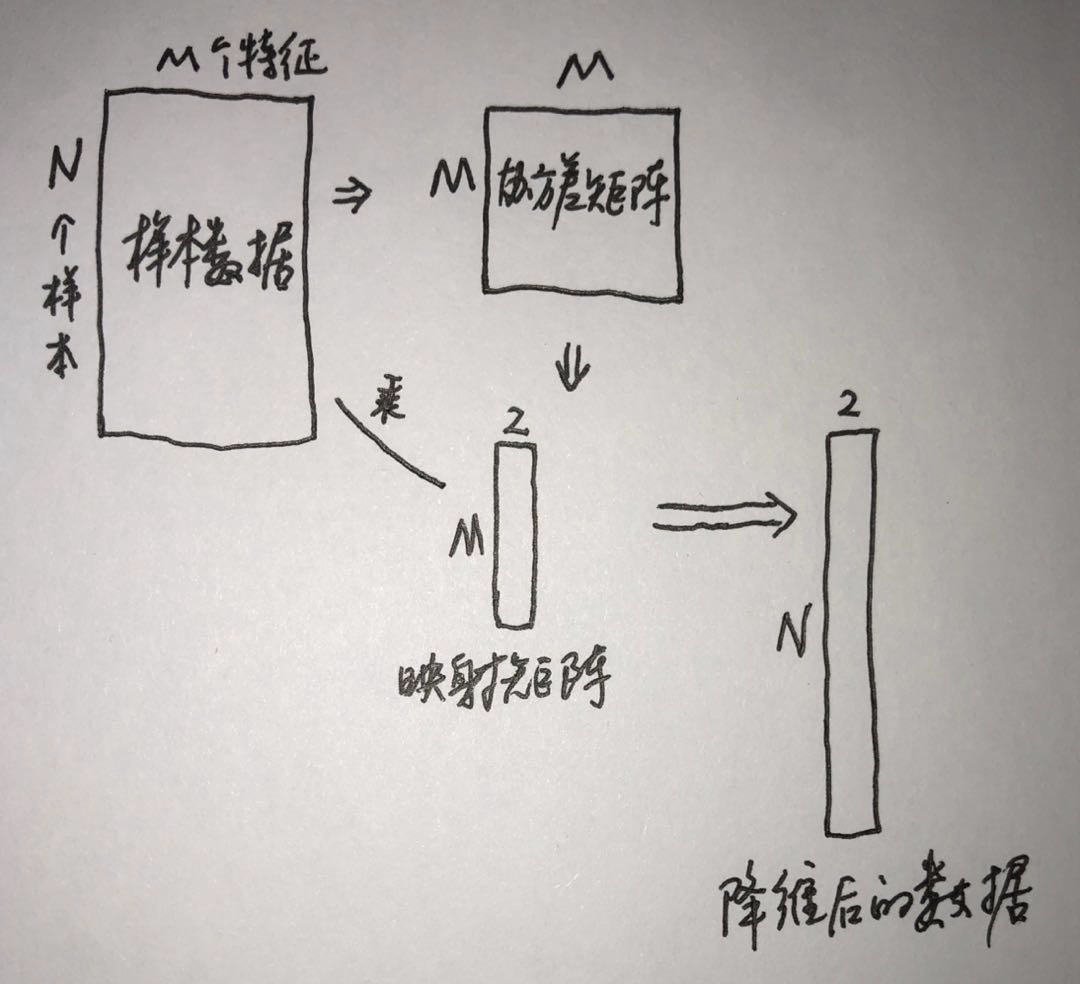

主成分分析(Principal Component Analysis,PCA)是最常用的一种降维方法,通常用于高维数据集的探索与可视化,还可以用作数据压缩和预处理等。PCA可以把具有相关性的高维变量合成为线性无关的低维变量,称为主成分。主成分能够尽可能保留原始数据的信息。PCA的计算涉及到对协方差矩阵的理解,这篇博客提供了协方差矩阵的相关内容。PCA的算法过程:

直接用numpy实现PCA

1 2 3 4 5 6 7 8 9 10 11 | import numpy as npn = 2 # 取对应特征值最大的n个特征向量data = np.random.rand(10, 5) # 生成10个样本,每个样本5个特征mean = np.mean(data, axis=0) # 计算原始数据中每一列的均值,axis=0按列取均值zeroCentred_data = data - mean # 数据中心化,使每个feature的均值为0covMat = np.cov(zeroCentred_data, rowvar=False) # 计算协方差矩阵,rowvar=False表示数据的每一列代表一个featurefeatValue, featVec = np.linalg.eig(covMat) # 计算协方差矩阵的特征值和特征向量index = np.argsort(featValue) # 将特征值按从小到大排序,index是对应原featValue中的下标n_index = index[-n:] # 取最大的n个特征值在原featValue中的下标n_featVec = featVec[:, n_index] # 取最大的两维特征值对应的特征向量组成映射矩阵low_dim_data = np.dot(zeroCentred_data, n_featVec) # 降维后的数据 |

下图可帮助理解:

调用sklearn库实现PCA

这篇博客介绍了sklearn中PCA函数的具体参数。

1 2 3 4 5 | import numpy as npfrom sklearn.decomposition import PCAdata = np.random.rand(10, 5) # 生成10个样本,每个样本5个特征pca = PCA(n_components=2)low_dim_data = pca.fit_transform(data) # 每个样本降为2维 |

参考资料

[1] Python机器学习应用

【推荐】国内首个AI IDE,深度理解中文开发场景,立即下载体验Trae

【推荐】编程新体验,更懂你的AI,立即体验豆包MarsCode编程助手

【推荐】抖音旗下AI助手豆包,你的智能百科全书,全免费不限次数

【推荐】轻量又高性能的 SSH 工具 IShell:AI 加持,快人一步

· 基于Microsoft.Extensions.AI核心库实现RAG应用

· Linux系列:如何用heaptrack跟踪.NET程序的非托管内存泄露

· 开发者必知的日志记录最佳实践

· SQL Server 2025 AI相关能力初探

· Linux系列:如何用 C#调用 C方法造成内存泄露

· Manus爆火,是硬核还是营销?

· 终于写完轮子一部分:tcp代理 了,记录一下

· 别再用vector<bool>了!Google高级工程师:这可能是STL最大的设计失误

· 震惊!C++程序真的从main开始吗?99%的程序员都答错了

· 单元测试从入门到精通