机器学习之RNN ---LSTM原理及实现详解

(1)前言

(2)LSTM 简介

(3)LSTM原理及实现

(4)LSTM的优缺点

------------------qq:1327706646

-------------------------author:midu

--------------------------------datetime:2020-06-08 17:48:00

(1)前言

人类并不是每时每刻都从一片空白的大脑开始他们的思考。在你阅读这篇文章时候,你都是基于自己已经拥有的对先前所见词的理解来推断当前词的真实含义。我们不会将所有的东西都全部丢弃,然后用空白的大脑进行思考。我们的思想拥有持久性。

传统的神经网络并不能做到这点,看起来也像是一种巨大的弊端。例如,假设你希望对电影中的每个时间点的时间类型进行分类。传统的神经网络应该很难来处理这个问题——使用电影中先前的事件推断后续的事件。

RNN 解决了这个问题。RNN 是包含循环的网络,允许信息的持久化。循环神经网络(Recurrent Neural Network,RNN)是一种用于处理序列数据的神经网络。相比一般的神经网络来说,他能够处理序列变化的数据。比如某个单词的意思会因为上文提到的内容不同而有不同的含义,RNN就能够很好地解决这类问题。

(2)LSTM 简介

长短期记忆(Long short-term memory, LSTM)是一种特殊的RNN,主要是为了解决长序列训练过程中的梯度消失和梯度爆炸问题。简单来说,就是相比普通的RNN,LSTM能够在更长的序列中有更好的表现。

(3)LSTM原理及实现

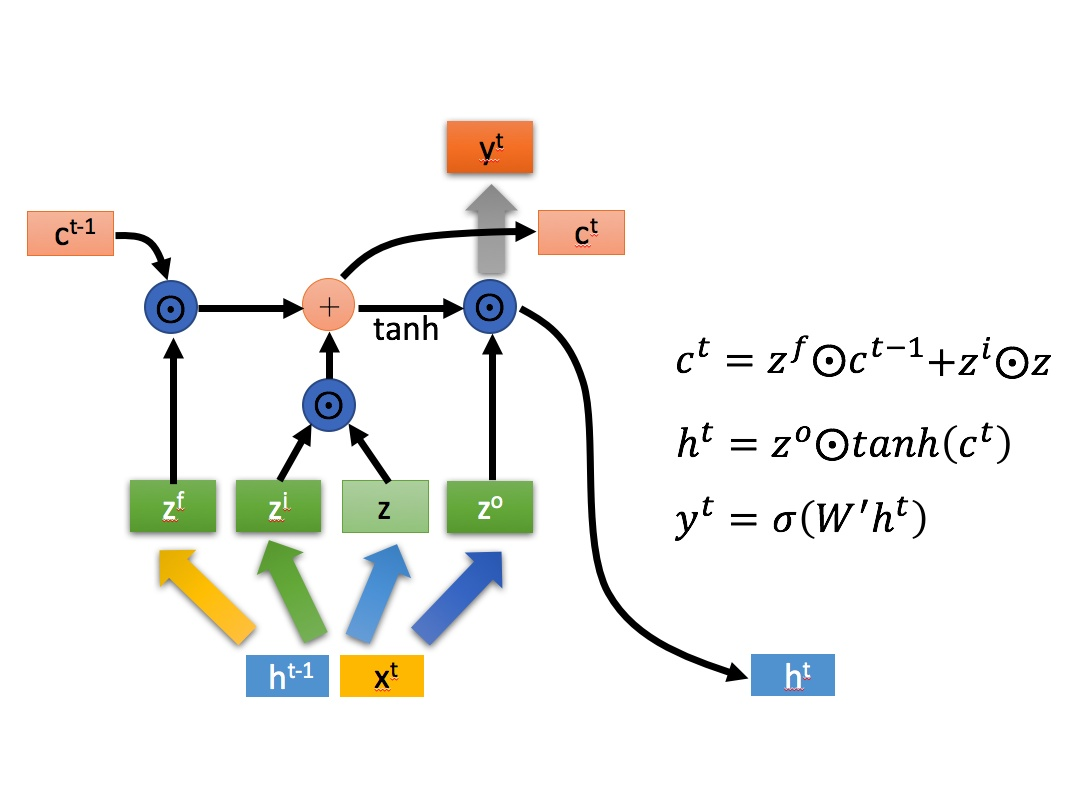

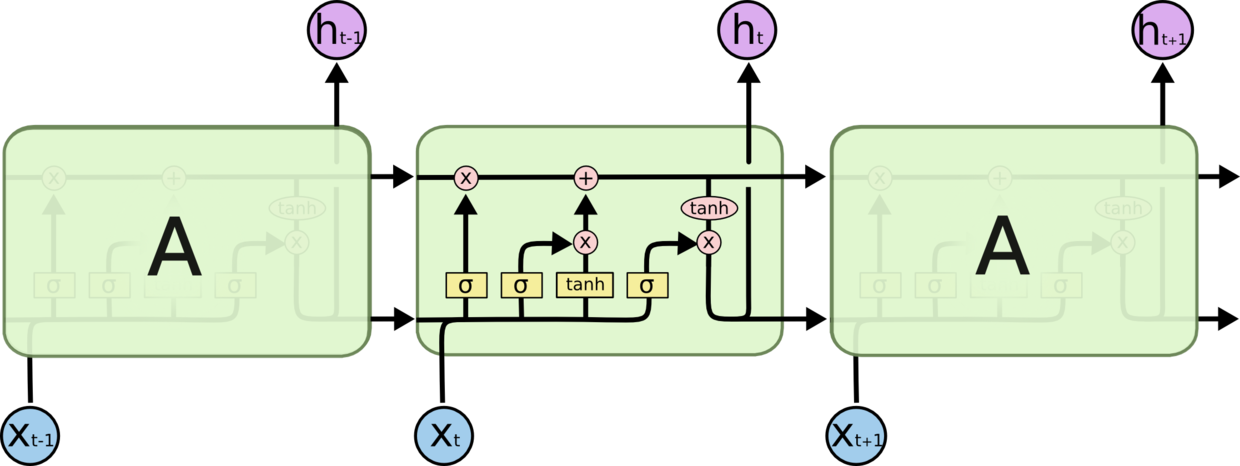

LSTM 的核心思想

LSTM 的关键就是细胞状态,水平线在图上方贯穿运行。

细胞状态类似于传送带。直接在整个链上运行,只有一些少量的线性交互。信息在上面流传保持不变会很容易。

(4)LSTM的优缺点

优点可以实现状态记忆传送

鸣谢:

https://www.cnblogs.com/wangduo/p/6773601.html [译] 理解 LSTM(Long Short-Term Memory, LSTM) 网络

https://blog.csdn.net/m0_37917271/article/details/82350571?utm_medium=distribute.pc_relevant.none-task-blog-BlogCommendFromMachineLearnPai2-2.nonecase&depth_1-utm_source=distribute.pc_relevant.none-task-blog-BlogCommendFromMachineLearnPai2-2.nonecase Tensorflow实战:LSTM原理及实现(详解)

https://zhuanlan.zhihu.com/p/32085405 人人都能看懂的LSTM

https://www.cnblogs.com/brandonli/p/13063898.html RNN层--GRU, LSTM

https://www.cnblogs.com/tangxiaobo199181/p/12523356.html lstm 应用之情感分析

https://keras.io/zh/layers/recurrent/ Keras 被工业界和学术界广泛采用

https://blog.csdn.net/u014248127/article/details/78875013 机器学习模型训练测试完整步骤

https://blog.csdn.net/u014248127/article/details/80774668#comments 文本分类概述(nlp)

https://blog.csdn.net/XWUkefr2tnh4/article/details/81294481?utm_medium=distribute.pc_relevant_right.none-task-blog-BlogCommendFromMachineLearnPai2-5.nonecase&depth_1-utm_source=distribute.pc_relevant_right.none-task-blog-BlogCommendFromMachineLearnPai2-5.nonecase 【CVPR2018】物体检测中的结构推理网络

https://www.jianshu.com/p/b8302c22dcba 任务驱动型人机对话系统

https://blog.csdn.net/suzyu12345/article/details/81275238 python爬虫基础

https://www.jianshu.com/p/1ebeb31c312a sklearn - 线性回归(正规方程与梯度下降)