Lecture 5 -- Transformer

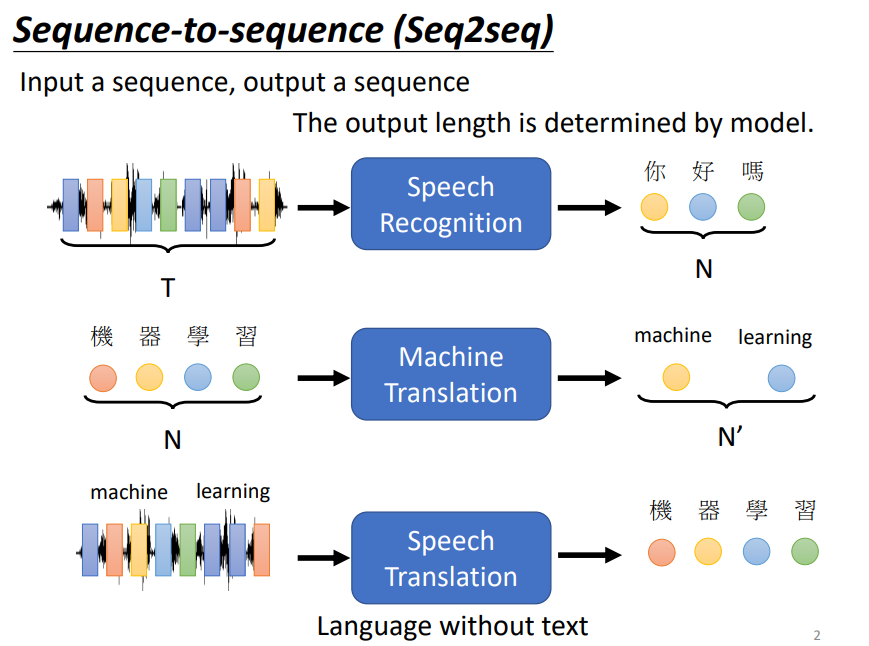

1. Seq2seq

Transformer是一种Seq2seq模型

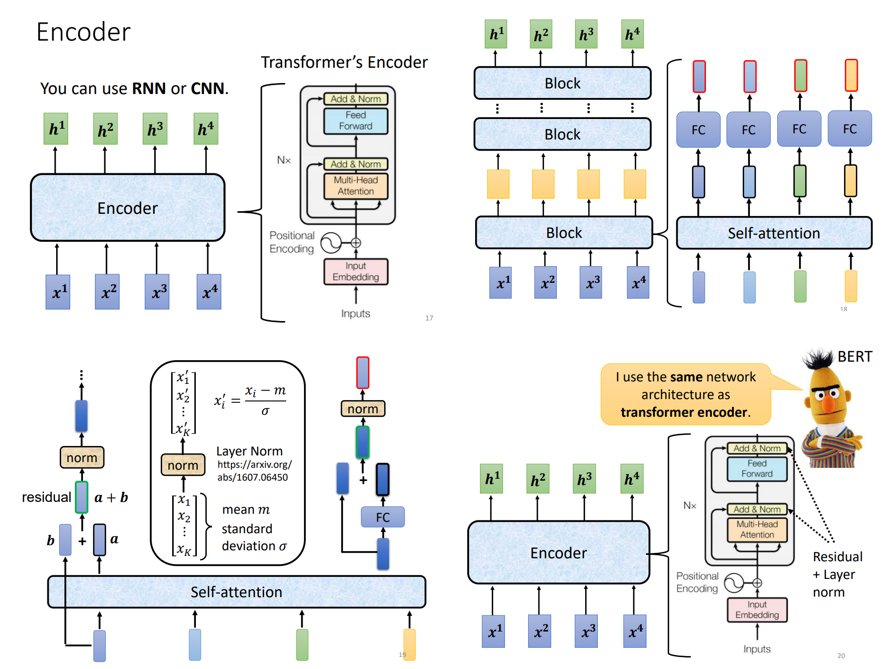

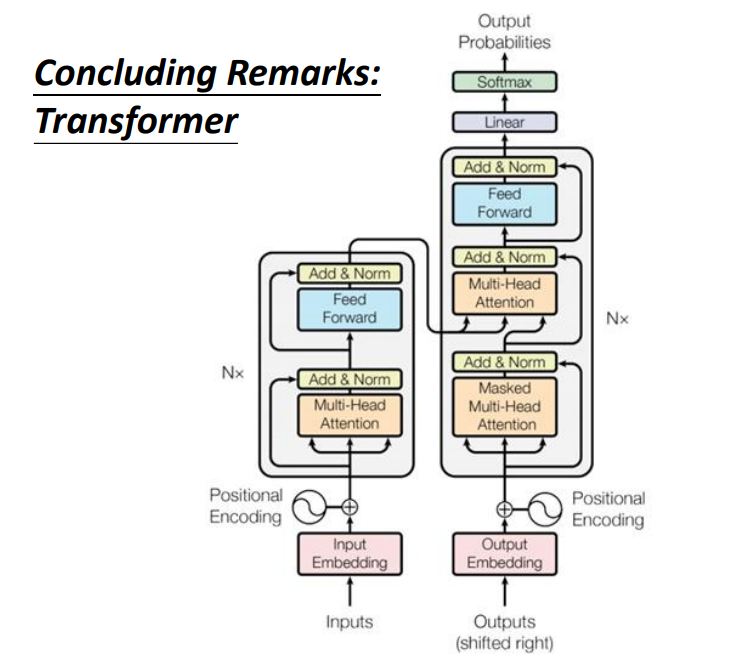

2. Model Architecture

A. Encoder

B. Decoder (AT & NAT)

由于Decoder是一个一个vector输出的,因此self-attention转变为了masked self-attention

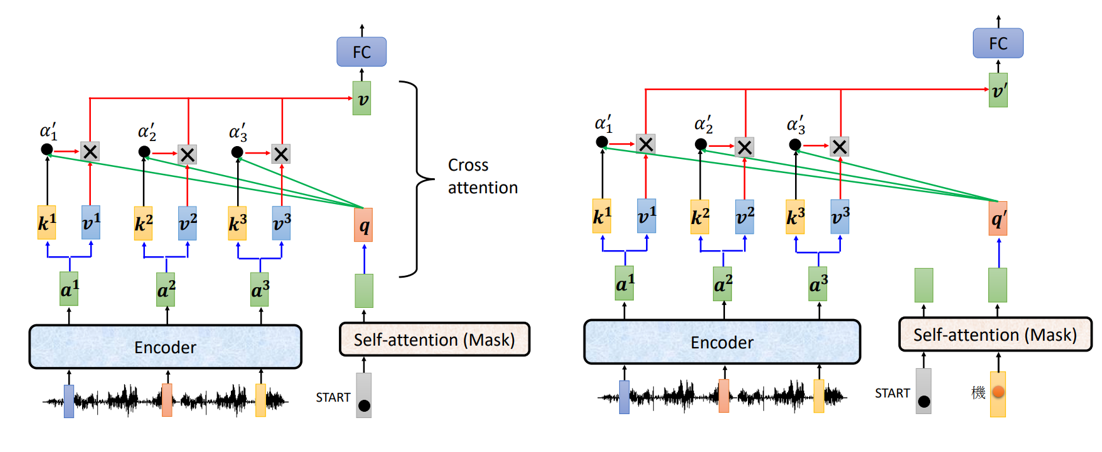

C. Cross Attention

原文的cross attention方式与各种不同的cross attention方式如上图。原文是最后一个编码器的输出连接到所有的解码器。

3. 怎样进行训练?

训练过程中给Decoder的输入是正确的答案,测试过程中给Decoder的输入是Decoder自己的输出!

END

浙公网安备 33010602011771号

浙公网安备 33010602011771号