使用go-retryablehttp包实现http“链接池”效果

前言

在go中使用http的方式获取数据时每次通常都会创建一个http的Client对象处理请求,但是如果一次任务中请求的非常频繁,每一次请求都要创建一个Client对象的话势必会造成链接资源的浪费。

在实际中我们知道有一种“链接池”的概念,就是说提前在链接池中创建好链接,每一次请求前都从这个“链接池”中获取链接,请求处理完毕后不释放链接而是将这个链接重新放入链接池中,以便下一次请求使用,这样便十分有效的利用了链接资源,同时也有效的降低了服务器的负载。

第三方包实现

Go中有一个第三方包go-retryablehttp能够实现上述的效果。

Demo

自己做了一个demo:

utils.go中主要实现了链接池(加锁的逻辑其实不太合适,最好在项目初始化的时候就确定好tag,然后为每个不同的tag初始化好放在map中!实际中可以去掉加锁的逻辑!)

package utils import ( "crypto/tls" "github.com/hashicorp/go-retryablehttp" "net" "net/http" "sync" "time" ) const ( ConnectTimeout = 10 * time.Second RequestTimeout = 30 * time.Second ) // TODO 应该把这两个字典当作全局变量来用!!! // 连接池字典 var clientMap = make(map[string]*retryablehttp.Client) // 带证书认证的结构 var transportMap = make(map[string]*http.Transport) // 加一个锁 防止多线程同时写入字典的情况 var muClient sync.Mutex func GetHttpClient(tag string, config *tls.Config) *http.Client { muClient.Lock() defer muClient.Unlock() // 如果是一个带证书的请求,在这里处理 if config != nil { if _, ok := transportMap[tag]; !ok { transportMap[tag] = NewTransport() transportMap[tag].TLSClientConfig = config } return &http.Client{ Transport: transportMap[tag], Timeout: RequestTimeout, } } if _, ok := clientMap[tag]; !ok { clientMap[tag] = NewRetryHttpClient() } return clientMap[tag].StandardClient() } // 带证书的transport构建 func NewTransport() *http.Transport { dialContext := (&net.Dialer{ Timeout: ConnectTimeout, KeepAlive: 30 * time.Second, }).DialContext return &http.Transport{ Proxy: http.ProxyFromEnvironment, DialContext: dialContext, MaxIdleConns: 100, MaxConnsPerHost: 25, IdleConnTimeout: 30 * time.Second, TLSHandshakeTimeout: ConnectTimeout, ExpectContinueTimeout: 1 * time.Second, } } // 使用http连接池 func NewRetryHttpClient() *retryablehttp.Client { retryClient := retryablehttp.NewClient() retryClient.RetryMax = 10 retryClient.Logger = nil return retryClient }

main.go中使用链接池并发处理http请求:

package main import ( "fmt" "io/ioutil" "log" "net/http" "sync" "whw_go_scripts/a_http_pool/utils" ) func main() { // 使用 waitGroup开goroutine wait := sync.WaitGroup{} for i := 0; i < 500; i++ { wait.Add(1) go getBaidu(i, &wait) } // 等子goroutine走完了再走主的 wait.Wait() fmt.Println("------ 所有goroutine均请求完成 ------") } // 测试请求百度链接的代码 func getBaidu(i int, wait *sync.WaitGroup) { // 在这里写 wait.Done() defer wait.Done() url := "http://www.baidu.com" req, err := http.NewRequest("GET", url, nil) if err != nil { log.Panic("err1: ", err) } req.Header.Add("cache-control", "no-cache") req.Header.Add("Postman-Token", "f4a59d50-9672-4710-a8c0-abb8a453b199") // TODO:在每个协程中初始化Client,使用默认的HTTPClient建立短链接 //res, err := http.DefaultClient.Do(req) // TODO 正确使用 "http链接池" 在程序外 httpClient := utils.GetHttpClient("get_baidu", nil) res, err := httpClient.Do(req) if err != nil { fmt.Println("error>> ", err) } defer res.Body.Close() // body, err := ioutil.ReadAll(res.Body) _, err = ioutil.ReadAll(res.Body) if err != nil { fmt.Println("err>>> ", err) } fmt.Printf("%d 号Gorountine成功请求了百度!\n", i) //fmt.Println(res) //fmt.Println(string(body)) }

结果

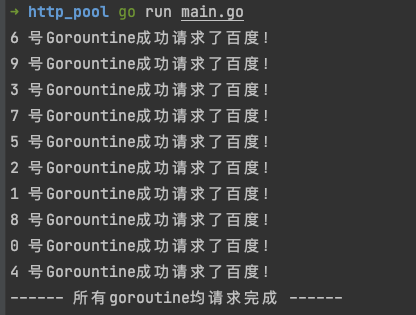

由于没有实际场景,所以使用链接池降低服务器链接资源的效果没法演示(实际中可以在程序跑起来后使用 netstat 命令查看效果),这里展示一下上述程序的执行结果:

HTTP连接的复用需要客户端与服务端同时支持

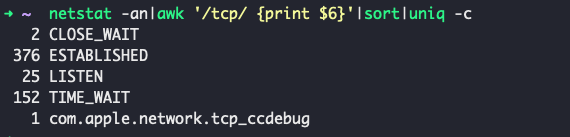

当然大家会看到一种现象:使用连接池与不使用连接池,在程序运行期间都有很多的TIME_WAIT的连接!这是因为我们请求百度的这个这个服务,服务端不支持长链接,我们每次请求结束以后,server端自动将连接断开了,所以此时客户端的这个连接也用不了了,只能再重新创建连接了,所以会在客户端看到即使使用了HTTP连接池也会有很多的TIME_WAIT连接:

netstat -an|awk '/tcp/ {print $6}'|sort|uniq -c

【推荐】国内首个AI IDE,深度理解中文开发场景,立即下载体验Trae

【推荐】编程新体验,更懂你的AI,立即体验豆包MarsCode编程助手

【推荐】抖音旗下AI助手豆包,你的智能百科全书,全免费不限次数

【推荐】轻量又高性能的 SSH 工具 IShell:AI 加持,快人一步

· .NET Core 中如何实现缓存的预热?

· 从 HTTP 原因短语缺失研究 HTTP/2 和 HTTP/3 的设计差异

· AI与.NET技术实操系列:向量存储与相似性搜索在 .NET 中的实现

· 基于Microsoft.Extensions.AI核心库实现RAG应用

· Linux系列:如何用heaptrack跟踪.NET程序的非托管内存泄露

· TypeScript + Deepseek 打造卜卦网站:技术与玄学的结合

· Manus的开源复刻OpenManus初探

· AI 智能体引爆开源社区「GitHub 热点速览」

· 三行代码完成国际化适配,妙~啊~

· .NET Core 中如何实现缓存的预热?