深度强化学习 Deep Reinforcement Learning(DRL))

深度强化学习(Deep Reinforcement Learning,DRL)本质上属于采用神经网络作为值函数估计器的一类方法,其主要优势在于它能够利用深度神经网络对状态特征进行自动抽取,避免了人工 定义状态特征带来的不准确性,使得Agent能够在更原始的状态上进行学习。

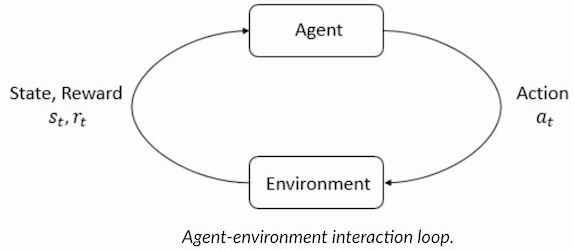

强化学习是机器学习的一种学习方式,它跟监督学习、无监督学习是对应的。

强化学习和监督学习、无监督学习 最大的不同就是不需要大量的“数据喂养”。而是通过自己不停的尝试来学会某些技能。

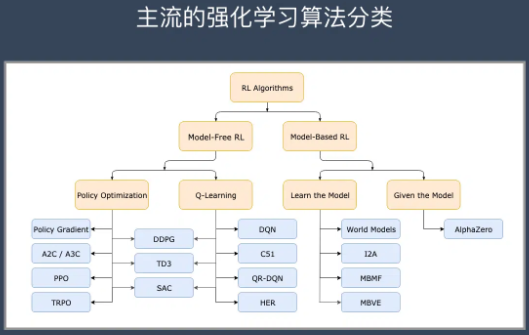

强化学习的主流算法

免模型学习(Model-Free) vs 有模型学习(Model-Based)

有模型学习(Model-Based)对环境有提前的认知,可以提前考虑规划,但是缺点是如果模型跟真实世界不一致,那么在实际使用场景下会表现的不好。

免模型学习(Model-Free)放弃了模型学习,在效率上不如前者,但是这种方式更加容易实现,也容易在真实场景下调整到很好的状态。所以免模型学习方法更受欢迎,得到更加广泛的开发和测试。

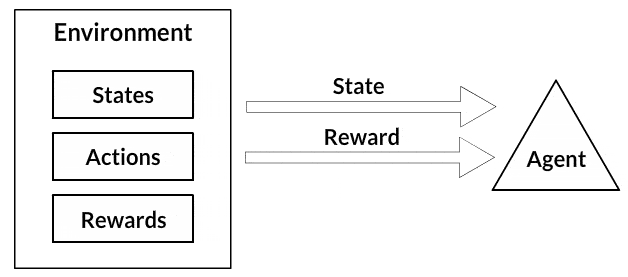

- 状态:状态是对世界的完整描述,它们不隐藏状态上存在的任何信息。它可以是位置,常数或动态。我们主要在数组,矩阵或更高阶张量中记录这些状态。

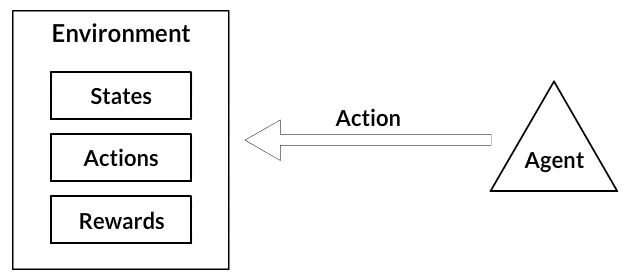

- 行动:行动通常基于环境,不同的环境导致基于代理的不同行为。代理的有效操作集记录在称为操作空间的空间中。这些通常是有限的。

- 环境:这是代理人生活和互动的地方。对于不同类型的环境,我们使用不同的奖励,政策等。

- 奖励和回报:奖励函数R是必须在强化学习中一直被跟踪的函数。它在调整,优化算法和停止训练算法方面起着至关重要的作用。这取决于当前的世界状况,刚刚采取的行动以及世界的下一个状态。

- 策略:策略是代理用于选择下一个操作的规则,这些也称为代理大脑。

【推荐】国内首个AI IDE,深度理解中文开发场景,立即下载体验Trae

【推荐】编程新体验,更懂你的AI,立即体验豆包MarsCode编程助手

【推荐】抖音旗下AI助手豆包,你的智能百科全书,全免费不限次数

【推荐】轻量又高性能的 SSH 工具 IShell:AI 加持,快人一步

· 无需6万激活码!GitHub神秘组织3小时极速复刻Manus,手把手教你使用OpenManus搭建本

· Manus爆火,是硬核还是营销?

· 终于写完轮子一部分:tcp代理 了,记录一下

· 别再用vector<bool>了!Google高级工程师:这可能是STL最大的设计失误

· 单元测试从入门到精通