Spark Streaming 在数据平台日志解析功能的应用

https://mp.weixin.qq.com/s/bGXhC9hvDj4lzK7wYYHGDg

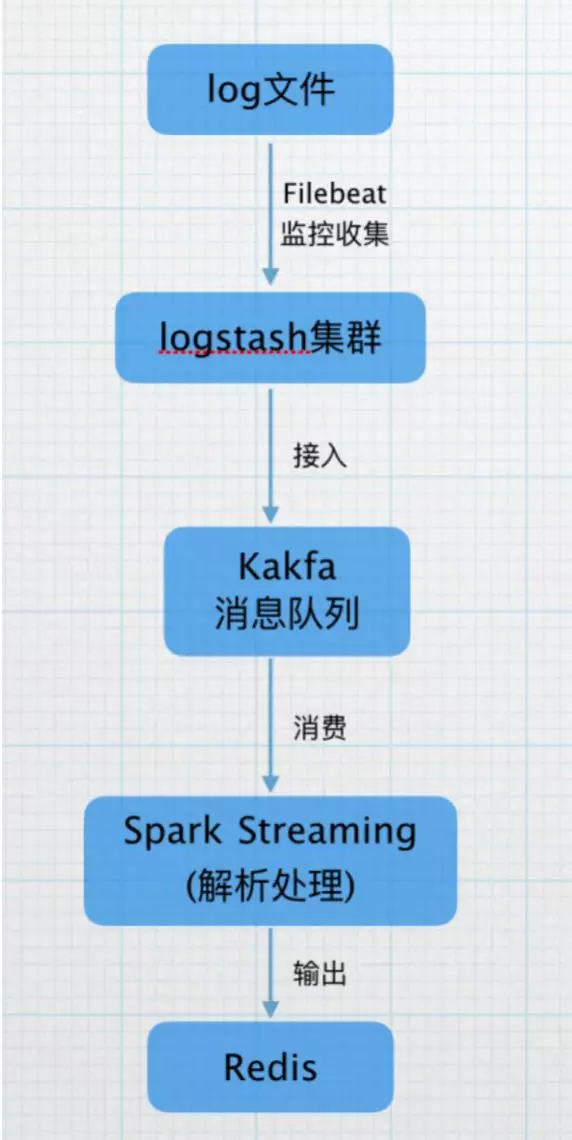

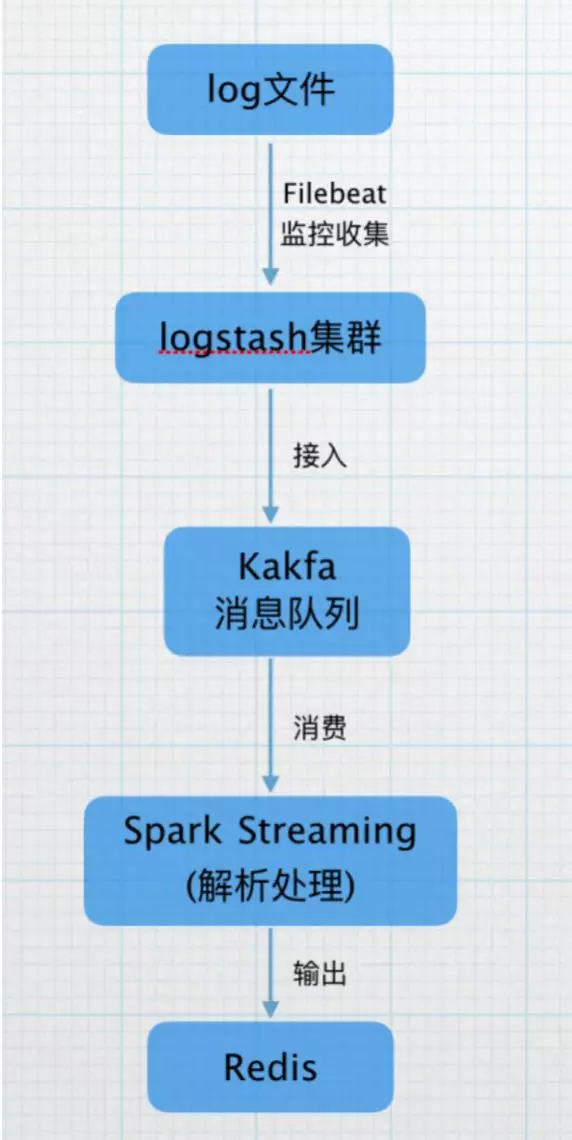

目前,我们使用Filebeat监控日志产生的目录,收集产生的日志,打到logstash集群,接入kafka的topic,再由Spark Streaming 进行实时解析,将解析的结果打入Redis缓存,供后续统计查询使用。

https://mp.weixin.qq.com/s/bGXhC9hvDj4lzK7wYYHGDg

目前,我们使用Filebeat监控日志产生的目录,收集产生的日志,打到logstash集群,接入kafka的topic,再由Spark Streaming 进行实时解析,将解析的结果打入Redis缓存,供后续统计查询使用。