CTC算法详解

以语音识别为例,如果现在有一个包含剪辑语音以及相应文本的数据集,如何将语音片段与文本字符一一对应,是训练语音识别器面临的首要问题。为了解决上述问题,我们制定简单的规则,如每个字符对应十个输入。考虑到不同的人说话的语速有区别,这样的规则并不具备泛化能力。当然,我们也可以手动的对齐每个字符在音频中的位置。这种方法得到的数据对于模型的训练非常友好,但是这种做法非常耗费人力物力。这个问题同样也存在于其他序列识别的任务中,如图片中的文本识别。

CTC(Connectionist Temporal Classification)正是这种不知道输入输出是否对齐的情况下使用的算法,所以CTC适合语音识别和文本识别的任务。

为了方便下面的描述,我们做如下定义,输入(如音频信号)用序列\(X=[x_1,x_2,...,x_T]\)表示,对应的输出(如对应的标注文本)用序列\(Y=[y_1,y_2,...,y_U]\)。为了方便训练这些数据,我们希望能够找到输入\(X\)与输出\(Y\)之间精确的映射关系。

在使用有监督学习算法训练模型之前,有以下难点:

1. 输入\(X\)与输出\(Y\)都是变长的;

2. 输入\(X\)与输出\(Y\)的长度比值也是变化的;

3. 输入\(X\)与输出\(Y\)相应的元素之间没有严格的对齐(即\(x_t\)与\(y_u\)不一定对齐);

然而,CTC算法能够克服上述问题。对于给定的\(X\),CTC可以为我们提供所有可能的\(Y\)的输出分布。我们根据该分部既可以推断出可能的输出也可以评估给定输出的概率。

因此,CTC算法需要同时具备损失函数计算与执行推理两项功能:

损失函数:对于给定的输入,我们希望训练出的模型能够最大化将输入映射到正确输出的概率。为此,我们需要有效的计算条件概率\(p(Y|X)\)。这个函数\(p(Y|X)\)应该是可导的,便于我们使用梯度下降训练模型。

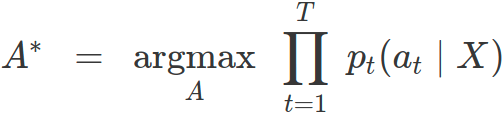

推理:当训练好模型之后,我们需要使用模型根据给定的\(X\)得到可能的\(Y\)。这意味着解决

\(Y^*=argmax\, p(Y|X) \atop Y\)

理想情况是,\(Y^*\)可以被高效的找到。利用CTC算法,我们能够在投入较低的情况下找到近似的解决方案。

算法

CTC算法对于输入的\(X\)能给出非常多\(Y\)的条件概率输出(可以想象RNN输出概率分布矩阵,所以通过矩阵中元素的组合可以得到很多Y值作为最终输出),在计算输出过程的一个关键问题就是CTC算法如何将输入和输出进行对齐的。在接下来的部分中,我们先来看一下对齐的解决方法,然后介绍损失函数的计算方法和在测试阶段中找到合理输出的方法。

对齐

CTC算法并不要求输入输出是严格对齐的。但是为了方便训练模型我们需要一个将输入输出对齐的映射关系,知道对齐方式才能更好的理解之后损失函数的计算方法和测试使用的计算方法。

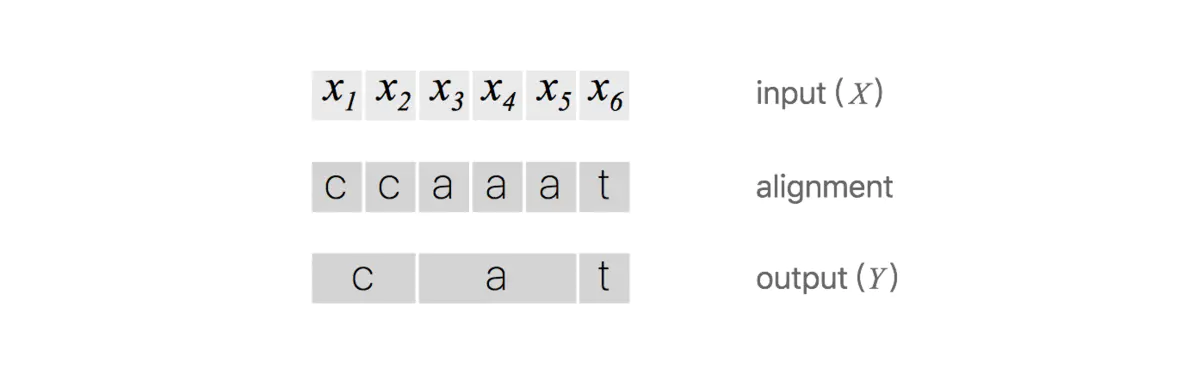

为了更好的理解CTC的对齐方法,先举个简单的对齐方法。假设对于一段音频,我们希望的输出是\(Y=[c,a,t]\)这个序列,一种将输入输出进行对齐的方式如下图所示,先将每个输入对应一个输出字符,然后将重复的字符删除。

然而,上述对齐方式明显存在问题:

1. 通常这种对齐方式是不合理的。比如在语音识别任务中,有些音频片可能是无声的,这时候应该是没有字符输出的;

2. 对于一些本应含有重复字符的输出,这种对齐方式没法得到准确的输出。例如输出对齐的结果为\([h,h,e,l,l,l,o]\),通过去重操作后得到的不是“hello”而是“helo”。

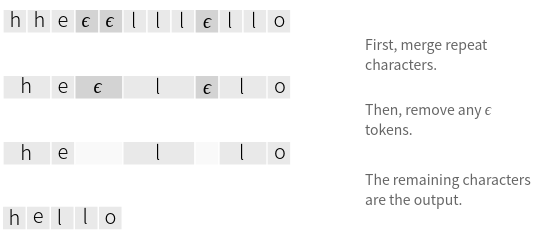

为了解决上述问题,CTC 算法引入了一个新的占位符用于输出对齐结果。这个占位符称为空白占位符,通常使用符号\(\epsilon\)。这个符号在对齐结果中输出,但是在最后的去重操作会将所有的\(\epsilon\)删除得到最终的输出。

CTC允许对齐长度与输入长度相同。我们允许在合并重复与删除\(\epsilon\)标记之后映射到\(Y\)的任何输出序列结果。

如果\(Y\)在一行中有两个相同的字符,那么有效的对齐必须在它们之间存在一个\(\epsilon\)。有了这个规则,我们便能够区分“hello”和“helo”对应的输出序列。

回到输出为\([c,a,t]\)的示例,该示例的输入长度为6,下面列举了一些有效和无效的对齐。

CTC的对齐方式有下列特性:

1. \(X\)和\(Y\)之间合法的对齐是单调的,即如果前进到下一个输入片段,输出会保持不变或者也会移动到下一个片段;

2. \(X\)和\(Y\)之间是多对一的关系,即一个或者多个输入元素映射到一个单一的输出元素;

3. 基于特性2,所以输出\(Y\)的长度不能大于输入\(X\)的长度。

损失函数

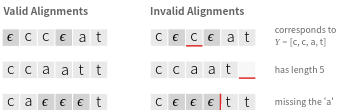

这里要明确一点,对于一个标定好的音频片段,训练该片段时,我们希望的输出就是标定的文本,如下图所示,音频说的一个hello,RNN或者其他模型输出的是相同长度的向量,每个向量对应一个输入,向量里的每个元素代表该输入对应每个字母的概率。

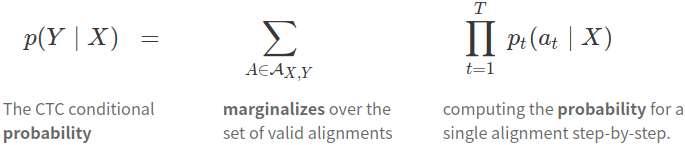

对于一组\((X,Y)\)来说,CTC的目标是将下式概率最大化:

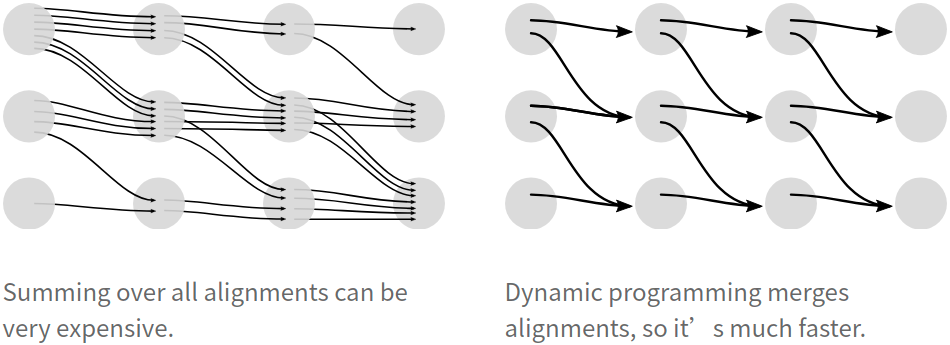

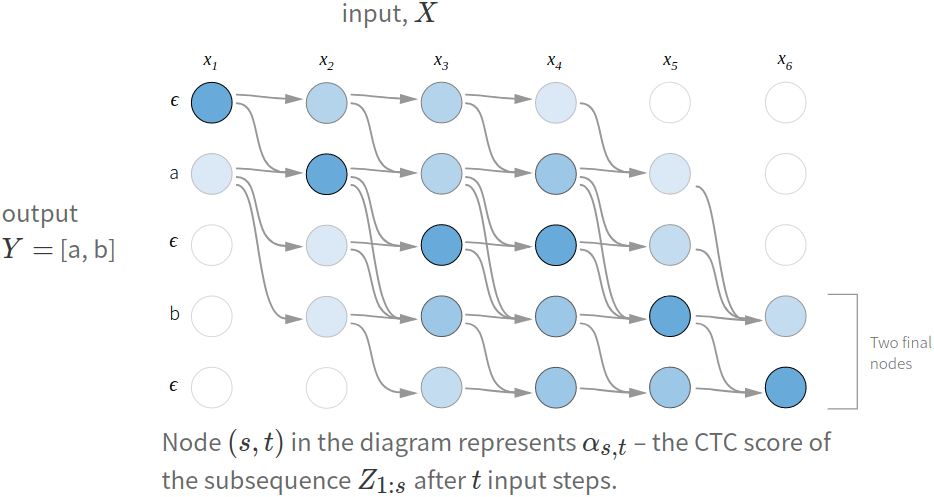

对于RNN+CTC模型来说,RNN输出的就是概率,t表示的是RNN里面的时间的概念。乘法表示一条路径的所有字符概率相乘,加法表示多条路径。因为上面说过CTC对齐输入输出是多对一的,例如\(he\epsilon l\epsilon lo\epsilon\)与\(hee\epsilon l\epsilon lo\)对应的都是“hello”,这就是输出的其中两条路径,要将所有的路径相加才是输出的条件概率。但是对于一个输出,路径会非常的多,这样直接计算概率是不现实的,CTC算法采用动态规划的思想来求解输出的条件概率,如下图所示,该图想说明的是通过动态规划来进行路径的合并,其中的关键部分是如果两个对齐在同一步骤达到相同的输出,那么我们可以合并它们。

因为我们允许在\(Y\)中的任何一个标记前面或者后面存在一个\(\epsilon\),所以使用包含\(\epsilon\)的序列描述动态规划算法的过程更加清晰。我们使用序列

即\(Y\)的开头、结尾以及每个字符之间都包含一个\(\epsilon\)。

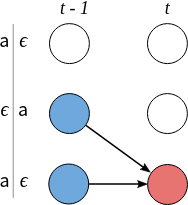

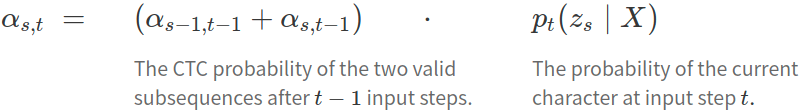

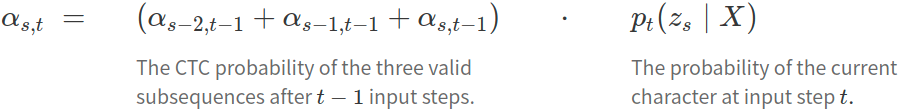

我们用\(\alpha\)表示在给定节点合并对齐结果后的概率。更进一步,\(\alpha _{s,t}\)表示在\(t\)个输入序列后,得到\(Z\)的子序列\(Z_{1:s}\)的概率。我们将在最后一个时间片(最后一个输入),计算最终的输出概率\(P(Y|X)\)。只要我们知道前一个时间步的\(\alpha\),就能够计算\(\alpha _{s,t}\)。下面是计算节点合并对齐后概率的两种情况。

case1:

在这种情况中,我们不能跳过\(Z\)中当前符号的前一个符号\(z_{s-1}\)。第一种原因是,\(z_{s-1}\)是\(Y\)中的一个元素,如果跳过,最后得到的对齐序列无法合并为输出\(Y\)。根据\(Z\)的生成规则,我们可以推断出当前的符号\(z_{s}=\epsilon\)。第二种原因是,当前的符号\(z_{s}\)与上上个符号\(z_{s-2}\)属于相同字符,如果跳过中间的\(z_{s-1}=\epsilon\),那么合并对齐结果同样得不到正确的输出\(Y\)。

为了确保不会跳过\(z_{s-1}\),当前的节点\(\alpha _{s,t}\)只能经过节点\(\alpha _{s-1,t-1}\)或者节点\(\alpha _{s,t-1}\)到达。因此,这种case下,\(\alpha _{s,t}\)的计算公式如下图所示。

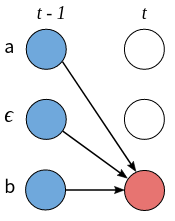

case2:

在这种情况中,我们允许跳过\(Z\)中当前符号的前一个符号\(z_{s-1}\)。这说明\(z_{s-1}=\epsilon\)且\(z_{s}!=z_{s-2}\),即两个不同的字符之间没有包含\(\epsilon\)。这种case下,\(\alpha _{s,t}\)能够经过节点\(\alpha _{s-1,t-1}\)、节点\(\alpha _{s,t-1}\)以及节点\(\alpha _{s-2,t-1}\)到达,可以得到\(\alpha _{s,t}\)的计算公式如下图所示。

以下是动态规划算法执行的计算示例。每个有效对齐在此图中都有一条路径。

由于序列开头和结尾的\(\epsilon\)是可选的,因此有两个有效的起始节点和两个有效的最终节点。完整的概率是两个最终节点的概率总和。

现在我们可以有效地计算损失函数,下一步是计算梯度并训练模型。 CTC 损失函数对于每个时间步的输出概率是可微的,因为它只是它们的总和与乘积。鉴于此,我们可以分析计算损失函数相对于(未归一化的)输出概率的梯度,并从那里照常运行反向传播。

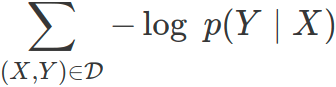

对于训练集\(D\),模型优化的目标是最小化负对数似然函数

而不是直接最大化概率。

推理

训练好模型后,我们希望对于给定的输入\(X\),能够得到可能的输出。也就是说,我们需要求解:

一种方法是启发式算法,在每个时间步获取概率最大的输出,这样得到的对齐输出是概率最大的:

根据\(A^*\)我们可以合并重复并删除\(\epsilon\)以获取推理结果\(Y\)。

对于许多应用程序,这种启发式方法效果很好,尤其是当大部分概率分配给单个对齐时。然而,这种方法有时会错过容易找到的概率更高的输出。问题本质是,这种方法没有考虑到单个输出可以有许多对齐的事实。例如\([a,a,\epsilon]\)和\([a,a,a]\)各自的概率均小于\([b,b,b]\)的概率,但是他们相加的概率比[b,b,b]概率高。简单的启发式算法得到结果为\(Y=[b]\),但是结果为\(Y=[a]\)更为合理。考虑到这点的第二种方式更为合理。

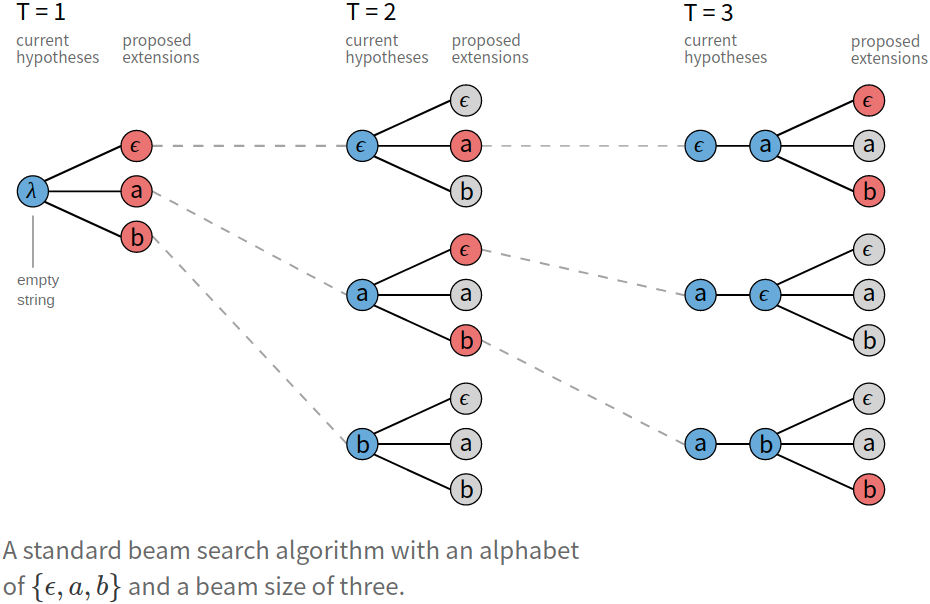

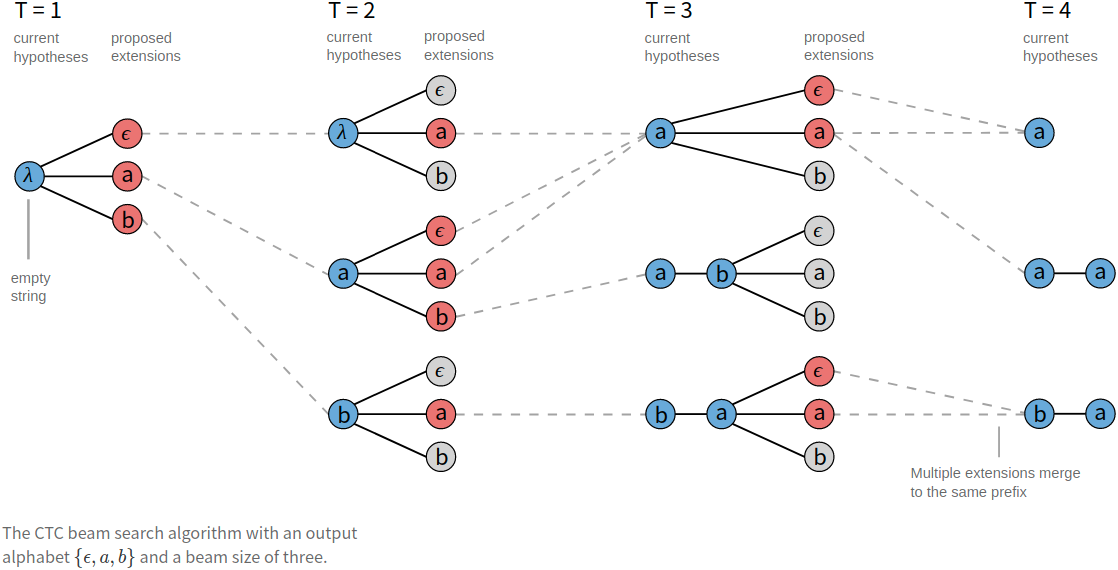

第二种方法是Bean Search算法的一种变形。鉴于计算能力有限,变形后的Bean Search算法并不需要找到最可能的输出\(Y\)。这个方法有一个很好的特性,我们能够通过付出更多的计算,来得到渐进更好的解决方案。

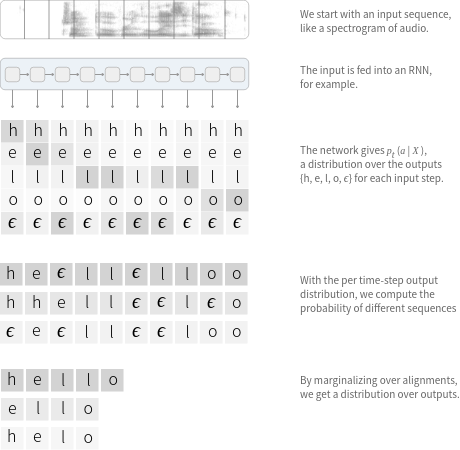

常规的Beam Search在每个输入步骤计算一组新的候选。新的候选集是通过使用所有可能的输出字符扩展每个候选并仅保留最佳候选者而从前一组生成的。

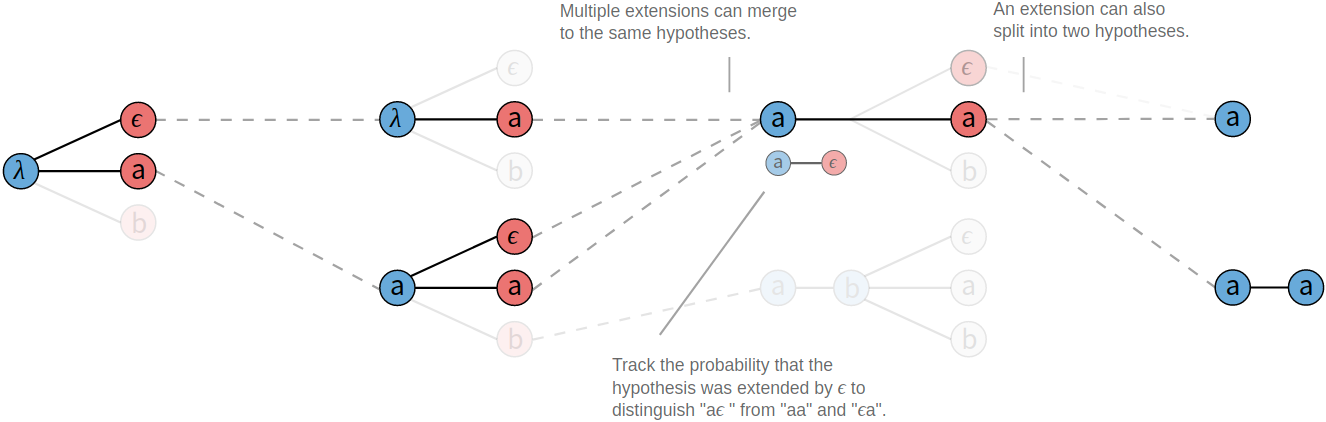

我们可以修改beam search来处理映射到同一输出的多个对齐。在这种情况下,我们不是在bean中保留对齐列表,而是在合并重复并删除\(\epsilon\)字符后存储输出前缀。在搜索的每一步,我们都会根据映射到它的所有对齐方式为给定前缀累积概率分数。

如果字符是重复的,则建议的扩展可以映射到两个输出前缀。这在上图中的\(T=3\)处显示,其中“\(a\)”被提议作为前缀\([a]\)的扩展。\([a]\)和\([a, a]\)都是此扩展的有效输出。

鉴于此,我们必须跟踪beam中每个前缀的两个概率。所有以\(\epsilon\)结尾的对齐的概率和所有不以\(\epsilon\)结尾的对齐的概率。当我们在修剪beam之前对每个步骤的候选进行排名时,我们将使用它们的综合分数。

变形Beam Search的实现不需要太多代码,但是想要正确执行却比较棘手。所以此处给出了Python版本的代码示例。

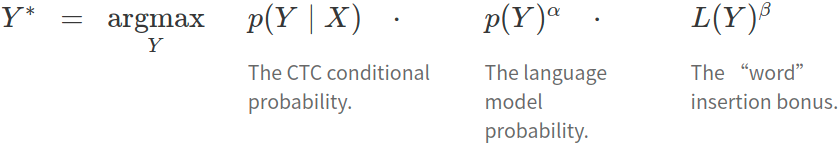

在某些问题中,例如语音识别,在输出上加入语言模型可以显着提高准确性。我们可以将语言模型作为推理问题的一个因素。关于这一点,已经脱离CTC本身,故不做深入讨论。

CTC的特征

- 条件独立:CTC的一个非常不合理的假设是其假设每个时间片都是相互独立的,这是一个非常不好的假设。在OCR或者语音识别中,各个时间片之间是含有一些语义信息的,所以如果能够在CTC中加入语言模型的话效果应该会有提升。

- 单调对齐:CTC的另外一个约束是输入\(X\)与输出\(Y\)之间的单调对齐,在OCR和语音识别中,这种约束是成立的。但是在一些场景中例如机器翻译,这个约束便无效了。

- 多对一映射:CTC的又一个约束是输入序列$$X的长度大于标签数据 \(Y\)的长度,但是对于\(Y\)的长度大于\(X\)的长度的场景,CTC便失效了。

参考

[1] https://www.jianshu.com/p/0cca89f64987

[2] https://distill.pub/2017/ctc/

[3] https://gist.github.com/awni/56369a90d03953e370f3964c826ed4b0

[4] https://zhuanlan.zhihu.com/p/42719047

[5] https://www.zhihu.com/question/47642307

[6] https://www.cs.toronto.edu/~graves/icml_2006.pdf

浙公网安备 33010602011771号

浙公网安备 33010602011771号