CNN

一个新的激活函数——Relu

Relu函数作为激活函数,有下面几大优势:

- 速度快 和sigmoid函数需要计算指数和倒数相比,relu函数其实就是一个max(0,x),计算代价小很多。

- 减轻梯度消失问题

- 稀疏性。有论文声称人工神经网络在15%-30%的激活率时是比较理想的。因为relu函数在输入小于0时是完全不激活的,因此可以获得一个更低的激活率。

全连接网络 VS 卷积网络

全连接神经网络之所以不太适合图像识别任务,主要有以下几个方面的问题:

- 参数数量太多

- 没有利用像素之间的位置信息。努力学习大量并不重要的权重,这样的学习必将是非常低效的。

- 网络层数限制

卷积神经网络

- 局部连接,每个神经元不再和上一层的所有神经元相连,而只和一小部分神经元相连。这样就减少了很多参数。

- 权值共享

- 下采样

我们把卷积神经网络中的『卷积』操作叫做互相关(cross-correlation)操作。

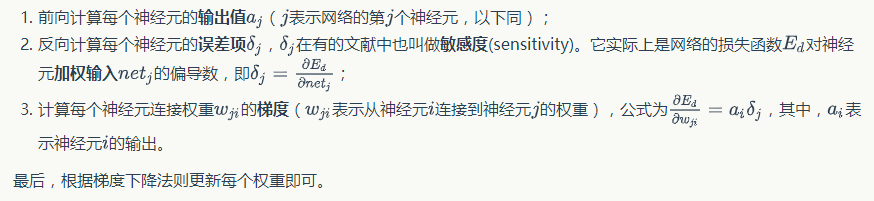

卷积神经网络的训练

利用链式求导计算损失函数对每个权重的偏导数(梯度),然后根据梯度下降公式更新权重。训练算法依然是反向传播算法。

步骤:

卷积层的训练