攻击防御-Backdoor Attacks to Graph Neural Networks

攻击防御-Backdoor Attacks to Graph Neural Networks

标签:后门攻击、图分类

动机

基于 GNN 的图分类对抗攻击很大程度上尚未进行探索,现有的对抗环境下 GNN 的对抗研究大多数集中在节点分类而不是图分类,节点分类的目的是为每个节点预测一个标签,而图分类任务则是为预测整个图的标签

贡献

- 首次对

GNN后门进行了系统研究 - 提出了基于子图的

GNN后门攻击,并且对三个真实世界的数据进行了全面的评估 - 概括了最先进的认证防御,以防御我们的后门攻击

前置知识

图分类:图分类的目的是输入一个图输出的该图的标签

\[f:G \rightarrow \{1,2,···,c\}

\]

\(f\) 为一个图分类模型

核心思想

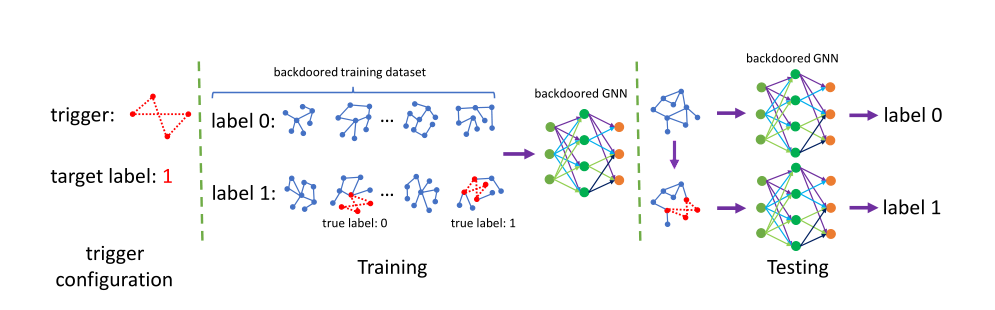

GNN 后门模型攻击三个步骤:

- 首先配置 trigger(触发器)(此处的触发器是给定一个子图,攻击着想要的目标是 \(1\))

- 训练一个后门

GNN(通过在训练集中部分图注入子图并修改标签形成带有后门的训练数据集) - 测试(如果在 测试数据中注入后门则等于为后门模型触发,预测的结果则是攻击想要的结果)

攻击设置

Trigger size and trigger density: 触发器的带下是自定义为 \(t\) , 那么触发器的密度为 \(\rho = \frac{2e}{t * (t - 1)}\)

Trigger synthesis method: 子图合成方法是采用 ER 模型, 该模型在给定的 \(t\) 节点下以概率\(p\) 为每一个节点对生成边 ,并且概率 \(p = \rho\)

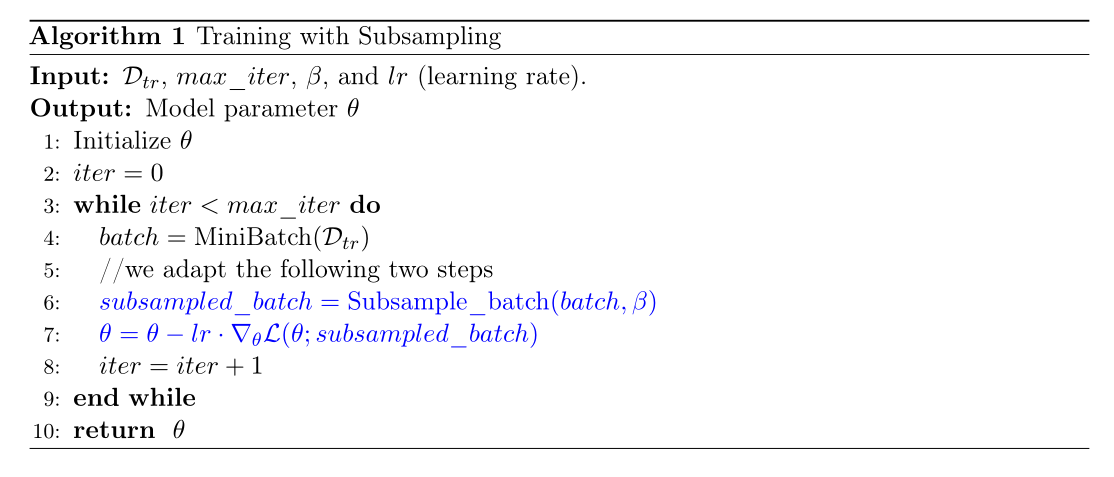

伪代码

结果

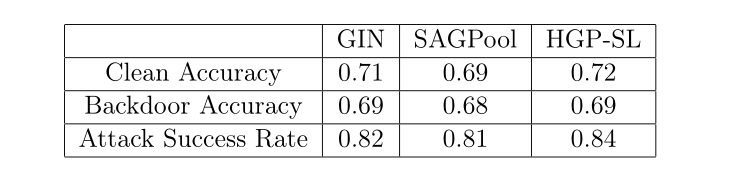

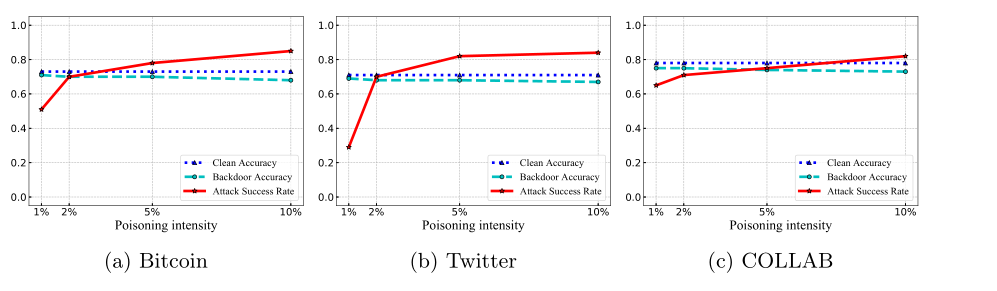

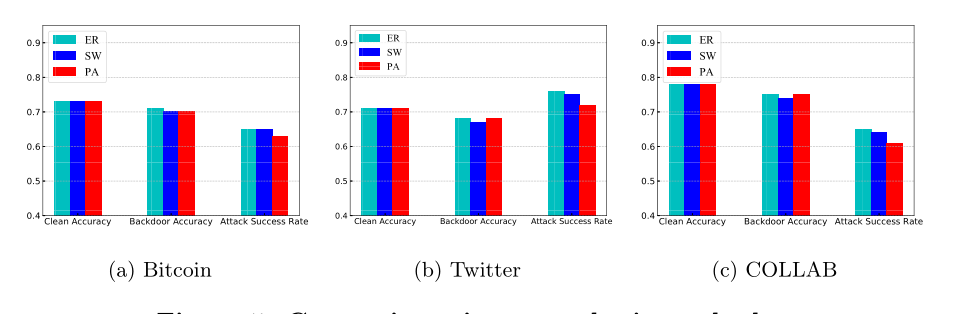

利用了无污染准确率、后门攻击准确率和攻击成功率作为指标进行了实验

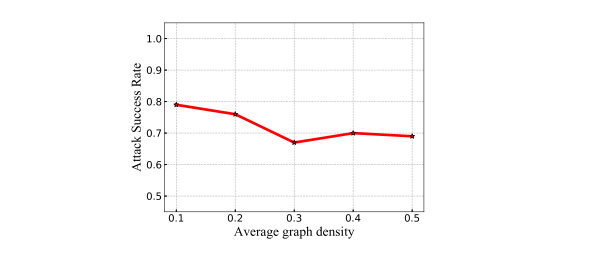

触发器大小、触发器密度和中毒强度的影响

触发器合成方法比较

子图密度的影响

不同GNN分类器