Hadoop综合大作业

Hadoop综合大作业

一、用Hive对爬虫大作业产生的文本文件(或者英文词频统计下载的英文长篇小说)进行词频统计。

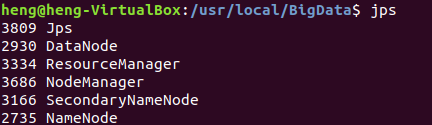

1.启动hadoop及其相关组件程序

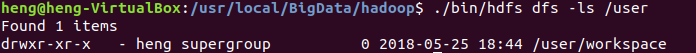

2.创建工作空间文件夹

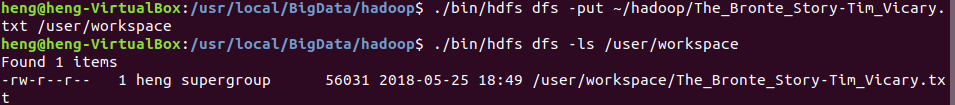

3.上传数据源文件到hdfs

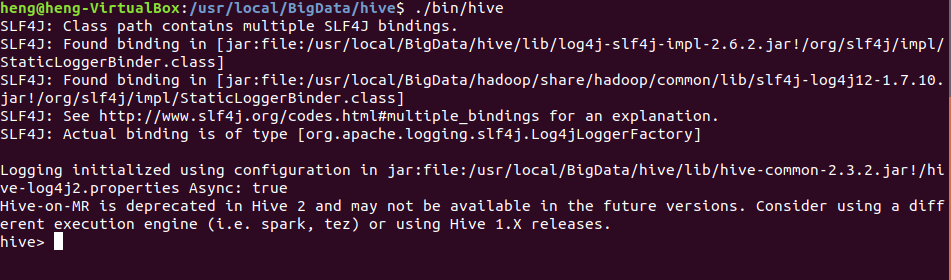

4.启动hive

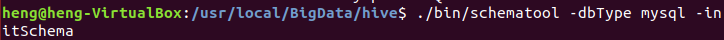

5.初始化hive关联数据库类型,以解决相关程序运行时错误

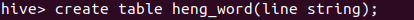

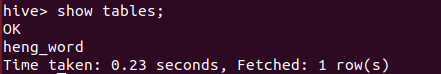

6.创建数据表

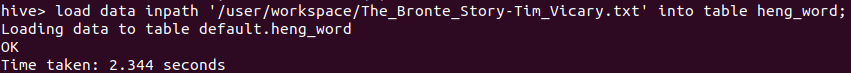

7.将数据装载到数据表中

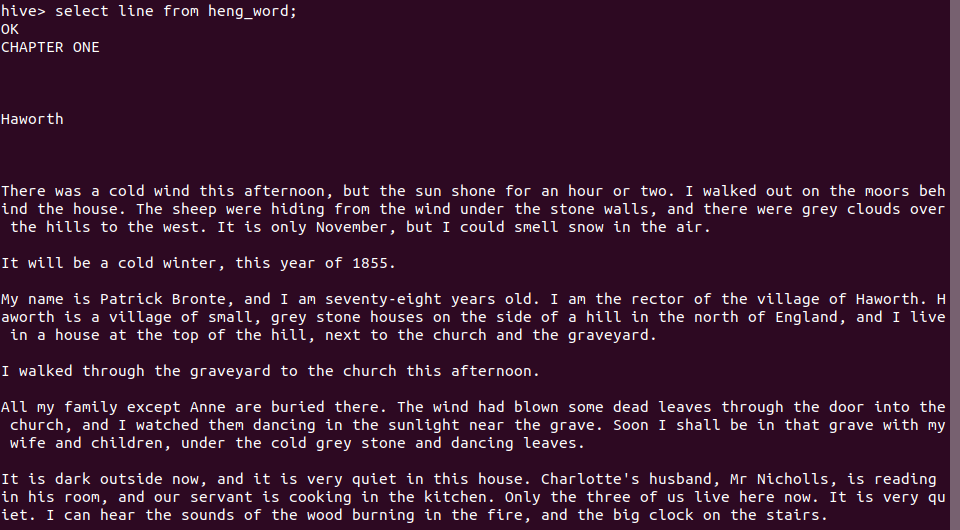

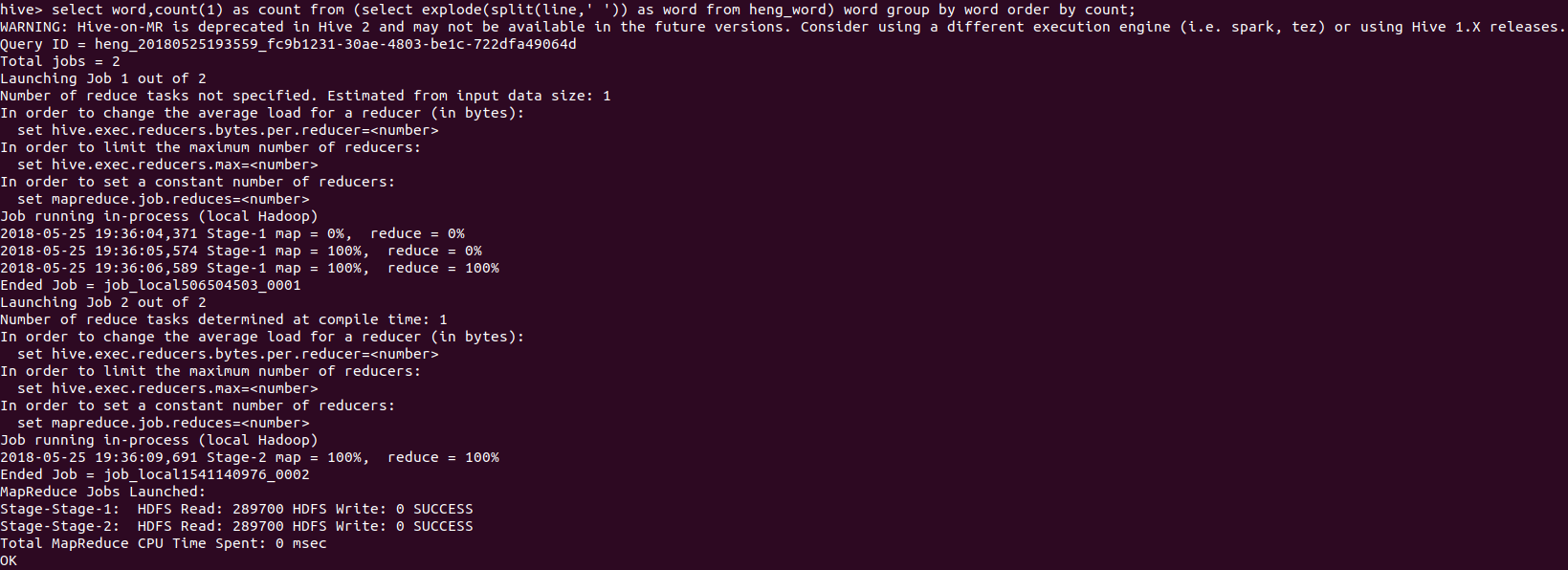

8.对数据表中的数据进行词频统计

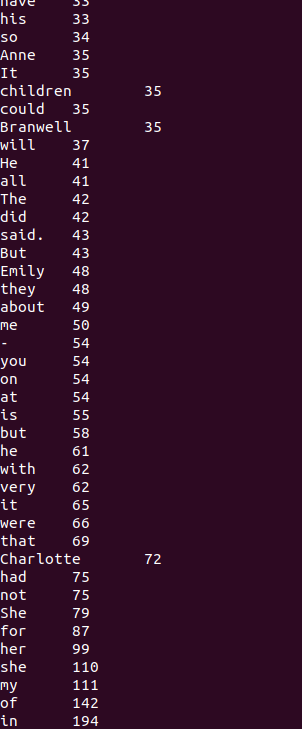

9.统计结果(节选)

二、用Hive对爬虫大作业产生的csv文件进行数据分析,写一篇博客描述你的分析过程和分析结果。

1.将数据文件上传到hdfs中

hdfs dfs -put ~/hadoop/data.csv /user/workspace

2.查看hdfs上的data.csv文件前10条数据的内容:

hdfs dfs -cat /user/workspace/data.csv | head -10

3.启动hive

./usr/local/BigData/hive/bin/hive

4.创建数据表data

create table data(line string);

5.将数据导入到数据表中

load data inpath '/user/hadoop/hive/data.csv' overwrite into table data;