HDFS 笔记配置、启动

下载安装Hadoop、JDK、SSH(SSH要求免密访问)

修改Hadoop配置文件:

1、../hadoop/etc/hadoop/core-site.xml

<!--配置HDFS默认的文件地址及端口-->

<property>

<name>fs.defaultFS</name>

<value>hdfs://localhost:9000</value>

</property>

<!--临时文件地址-->

<property>

<name>hadoop.tmp.dir</name>

<value>/home/hadoop/app/tmp</value>

</property>

2、

<!--hdfs-site.xml-->

<!--默认副本数-->

<property>

<name>dfs.replication</name>

<value>1</value>

</property>

3、slaves配置节点(DN)地址

10.xxxxx

配置完成,开始启动:

1、格式化文件系统(仅第一次执行即可,不要重复执行,格式化一次,就是清空数据一次),命令:./hdfs namenode -format(在bin目录下)

2、启动NN、DN,在sbin目录下使用命令:./start-dfs.sh

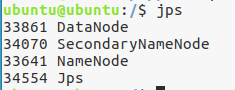

3、验证是否启动成功,用jps命令:jps 应当启动的进程:Jps、DataNode、SecondaryNameNode、NameNode

验证方式二:浏览器输入地址:http://xxx:50070

4、停止HDFS,在sib目录下执行命令:./stop-dfs.sh

浙公网安备 33010602011771号

浙公网安备 33010602011771号