论文阅读:FaceBoxes: A CPU Real-time Face Detector with High Accuracy

文章: 《FaceBoxes: A CPU Real-time Face Detector with High Accuracy》

Introduction

2个挑战:

1)在杂乱背景下人脸视角大的变化需要人脸检测器精准的解决复杂人脸和非人脸的分类问题。

2)较大的搜索空间和人脸尺寸进一步增加了时间效率的需要。

传统方法效率高但在人脸大的视角变化下精度不够,基于CNN的方法精度高但速度很慢。

受到Faster R-CNN的RPN以及SSD中多尺度机制的启发,便有了这篇可以在CPU上实时跑的FaceBoxes。

FaceBoxes

(1)RDCL:Rapidly Digested Convolutional Layers,加速计算

- 缩小输入的空间大小:为了快速减小输入的空间尺度大小,在卷积核池化上使用了一系列的大的stride,在Conv1,Pool1,Conv2,Pool2上stride分别是4,2,2,2,RDCL的stride一共是32,意味着输入的尺度大小被快速减小了32倍。

- 选择合适的kernel size:一个网络开始的一些层的kernel size应该比较小以用来加速,同时也应该足够大用以减轻空间大小减小带来的信息损失。Conv1,Conv2和所有的Pool分别选取7*7,5*5,3*3的kernel size。

- 减少输出通道数:使用C.ReLU来减少输出通道数。

(2)MSCL:Multiple Scale Convolutional Layers,丰富感受野,使不同层的anchor离散化以处理多尺度人脸

将RPN作为一个人脸检测器,不能获取很好的性能有以下两个原因:

- RPN中的anchor只和最后一个卷积层相关,其中的特征和分辨率在处理人脸变化上太弱。

- anchor相应的层使用一系列不同的尺度来检测人脸,但只有单一的感受野,不能匹配不同尺度的人脸。

为解决这个问题,对MSCL从以下两个角度去设计:

-

- Multi-scale design along the dimension of network depth.如下图,anchor在多尺度的feature map上面取,类似SSD。

- Multi-scale design along the dimension of network width.使用inception模块,内部使用不同大小的卷积核,可以捕获到更多的尺度信息。

- Multi-scale design along the dimension of network depth.如下图,anchor在多尺度的feature map上面取,类似SSD。

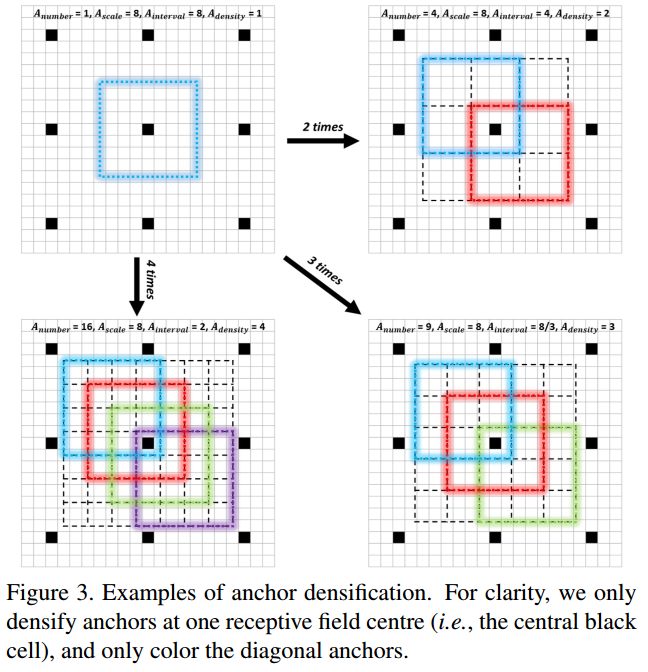

(3)Anchor densification strategy:

Inception的anchor尺度为32*32,64*64,128*128,Conv3_2、Conv4_2的尺度分别为256*256和512*512。

anchor的间隔和相应的层的stride相等。比如Conv3_2的stride是64、anchor大小为256*256,表示对应输入图片每64像素大小有一个256*256的anchor。anchor密度为:

Adensity = Ascale/Ainterval

Ascale 表示anchor的尺度,Ainterval 表示anchor间隔。默认间隔分别设置为32,32,32,64.根据公式,对应的密度分别为1,2,4,4,4.显然在不同尺度上anchor的密度不均衡。相比大的anchor(128-512),小的anchor(32和64)过于稀疏,将会导致在小脸检测中低的召回率。

为解决不均衡问题,此处提出新的anchor策略。为了加大一种anchor的密度,在一个感受野的中心均匀的堆叠n2 个anchor(本来是1个)用来预测。

文章里对32*32的anchor做了4倍,对64*64的anchor做了2倍,这样就可以保证不同尺度的anchor有相同的密度。

训练

Training dataset: WIDER FACE的子集,12880个图片。

Data augmentation:

- Color distorition:根据《Some Improvements on Deep Convolutional Neural Network Based Image Classification》

- Random cropping: 从原图中随机裁剪5个方块patch:一个最大方块,其他的分别在范围[0.3,1]之于原图尺寸。

- Scale transformation:将随机裁剪后的方块patch给resize到1024*1024.

- Horizontal flipping: 0.5的概率翻转。

- Face-box filter: 如果face box的中心在处理后的图片上,则保持其重叠,然后将高或宽小于20像素的face box过滤出来。

Matching strategy:

在训练时需要判断哪个anchor是和哪个face bounding box相关的。首先使用jaccard overlap将每个脸和anchor对应起来,然后对anchor和任意脸jaccard overlap高于阈值(0.35)的匹配起来。

Loss function:

和Faster R-CNN中的RPN用同样的loss,一个2分类的softmax loss用来做分类,smooth L1用来做回归。

Hard negative mining:

在anchor匹配后,大多数anchor都是负样本,导致正样本和负样本严重不均衡。为了更快更稳定的训练,将他们按照loss值排序并选取最高的几个,保证正样本和负样本的比例最高不超过3:1.

Other implementation details:

Xavier随机初始化。优化器SGD,momentum:0.9,weight decay:5e-4,batch size:32,迭代最大次数:120k,初始80k迭代learning rate:1e-3,80-100k迭代用1e-4,,100-120k迭代用1e-5,使用caffe实现。

Experiments

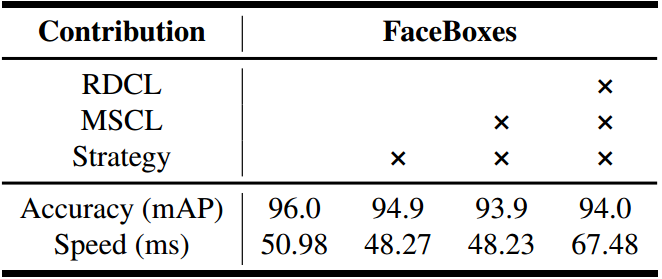

Model analysis

FDDB相比AFW和PASCAL face较为困难,因此这里在FDDB上作分析。

Ablative Setting:

1)去掉anchor densification strategy.

2)把MSCL替换为三层卷积,其大小都为3*3,输出数都和MSCL中前三个Inception的保持一致.同时,把anchor只和最后一层卷积关联。

3)把RDCL中的C.ReLU替换为ReLU。

结论:

Anchor densification strategy is crucial.

MSCL is better.

RDCL is efficient and accuracy-preserving.

实验结果:

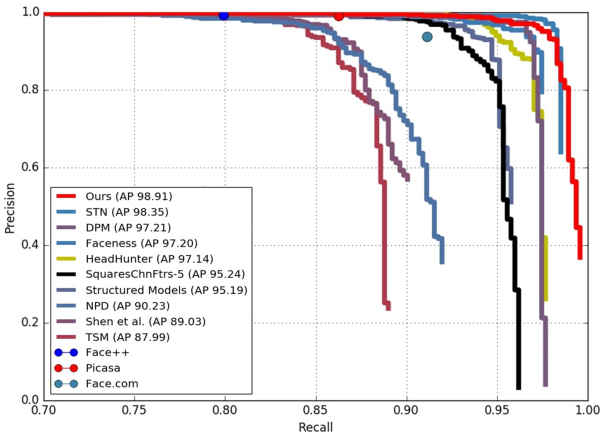

AFW:

PASCAL face:

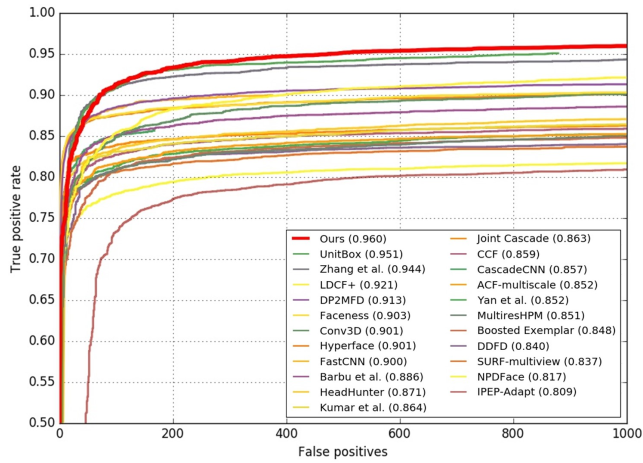

FDDB: