[图像分割/增量学习]Modeling the Background for Incremental Learning in Semantic Segmentation

前言

- 关于语义分割中增量学习对背景类进行编码

1.增量学习(Incremental Learning):具有以下特点可以定义为增量学习

- 可以学习新的信息中的有用信息

- 不需要访问已经用于训练分类器的原始数据

- 对已经学习的知识具有记忆功能

- 在面对新数据中包含的新类别时,可以有效地进行处理

- 灾难性遗忘问题(catastrophic forgetting):

一个在数据集A上训练好的模型,再在B上进行训练的时候会完全打乱对A知识的学习。 - 不同学习算法

- offline learning and online learning: 离线学习是训练好后在做预测,在线学习是持续添加训练数据并持续更新模型。

- incremental learning and decremental learning: 增量学习是不断学习新的知识并保存以前的知识,递减学习是指每次会抛弃价值最低的训练数据

- transfer learning and active learning:迁移学习是利用数据分布类似,用一个数据集上训练的结果作为另一个数据上的初始结果。主动学习是算法主动筛选出一些数据请求人为标注。

- 在线学习主要描述的是一种动态的学习方式,一般包括增量学习和递减学习。

- 知识蒸馏(knowledge distillation):原模型一般称为大模型,优化后的模型成为小模型,小模型有利于工业部署,将原模型的知识提取出来,

参考

- 核心问题

-

问题: 当新的分类标签产生时候,现有论文没有设计去动态更新网络的内部分类。增量学习研究主要是目标分类和检测,对语义分割研究还是空缺。

新训练集对旧分类类型没有做标记的时候,会导致背景类型的语义转移问题,加剧了灾难性遗忘。

背景类的存在,导致离线学习的方法不适用于增量学习,背景类随着时间的迁移而不同,从而加剧了灾难性遗忘。 -

解决方案:incremental class learning(ICL),

在经典的基于蒸馏的增量学习框架基础上,引入两个新的损失项来合理的解释在背景类中的语义分布的转移。提出了一个新的目标函数。 -

结果:

Abstract

- 从语义分割任务来解决灾难性遗忘问题

1.研究了语义分割的增量类学习任务,特别分析了由于背景类的存在而引起的分布转移问题。

2.提出一个新的目标函数,并引入特定的分类器初始化策略来显式地处理背景类的演化语义。

3.我们证明,我们的方法极大地减轻了灾难性的遗忘,从而达到了最先进的水平。

4.数据集:Pascal-VOC,2012 ADE20K, 评价指标:Mean IOU 结果:67.4%,67.8% 代码:开源

Introduction

- 概念

语义分割是计算机视觉领域中的一项基础性任务。

the state of the art:目前的先进水平

- 在FCNs的基础上,通过融合多尺度信息和利用上下文空间信息已经在图像分割中取得了重大的突破。

- 灾难性遗忘(catastrophic forgetting): 深层神经网络在学习新的分类时候,很难保持对旧样本的知识。

Method

- Problem Definition and Notation

数学符号化问题

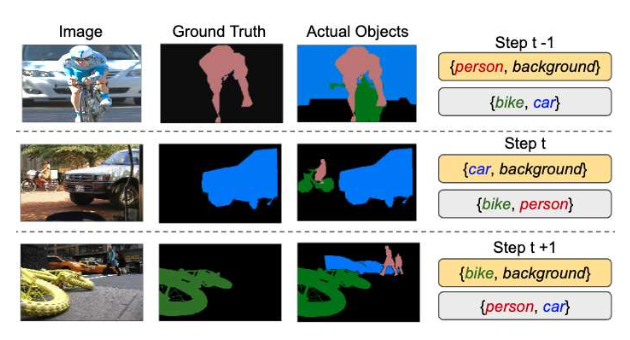

黄色方框表示在学习步骤中提供的GroundTruth,而灰色方框表示未标记的类。由于不同的学习步骤有不同的标签空间,因此atsteptold类(例如person)和未看到的类(例如car)可能被标记为当前ground truth的背景。这里我们展示了单个类学习步骤的具体情况,但是我们处理了添加任意数量类的一般情况。 - 解决灾难性遗忘的三种方法

- 每次训练增加一个正则化项,降低对本次数据的拟合,防止遗忘以前的模型。

- 考虑之前模型的参数的重要性

- 知识蒸馏:对一个复杂但推理性能优越软目标的模型进行训练,诱导精简、低复杂度的模型的训练,来实现知识迁移。增量学习灾难性遗忘问题的本质是新样本学习的过拟合问题导致对旧样本的遗忘。通过知识蒸馏简化模型(等同于正则化作用)。

本文采用知识蒸馏思路,在损失函数中添加一项蒸馏损失。

- 背景类的语义分布的转移:在之前训练中是前景的部分,在下一次训练过程中会变成背景。

方案: 更改交叉熵损失函数,

参考