吴恩达深度学习课程第一课-神经网络与深度学习

第一周 深度学习概论

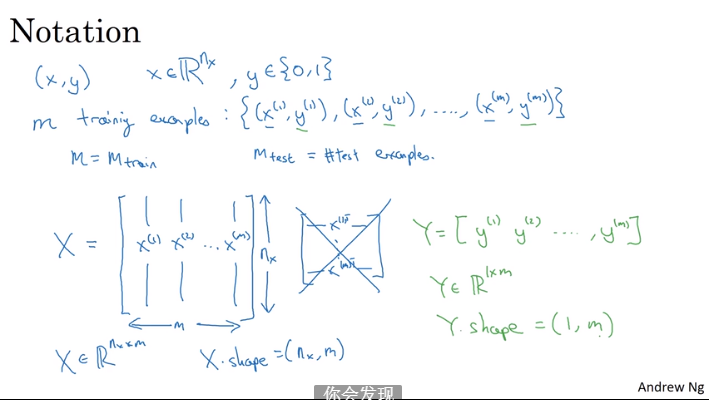

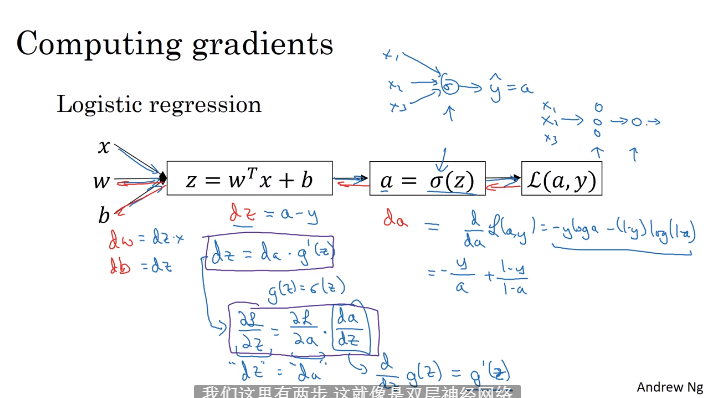

第二周 神经网络基础

2.1 二分类

是:标记1,不是标记0

- 输入特征: 64643=12288 个特征值

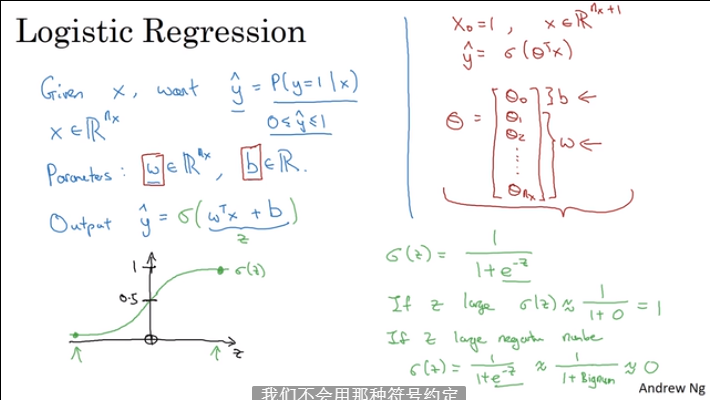

2.2 逻辑回归

2.3 逻辑回归损失函数

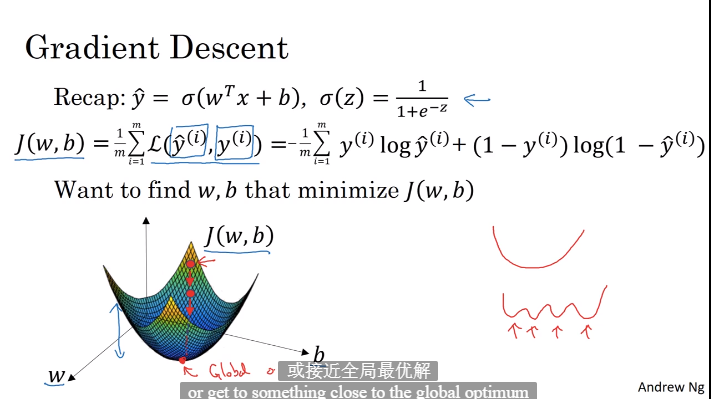

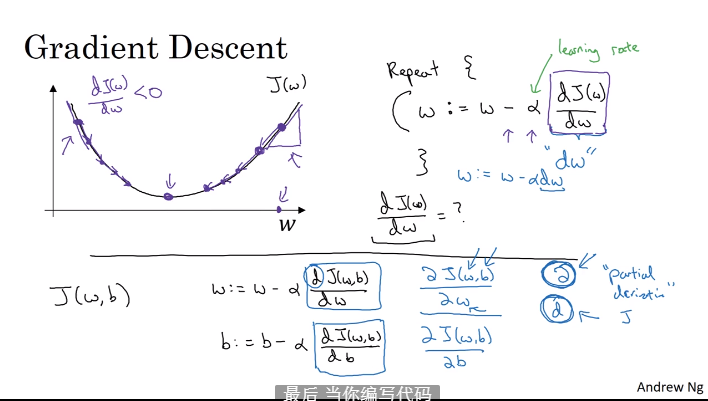

2.4 梯度下降法

- 训练和学习参数w和b

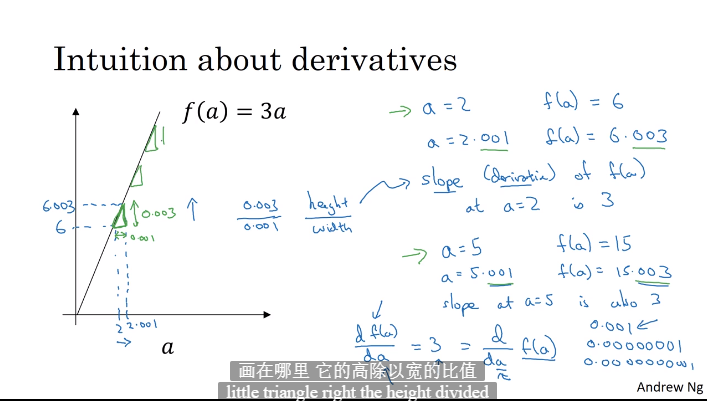

2.5 导数

2.6 导数例子

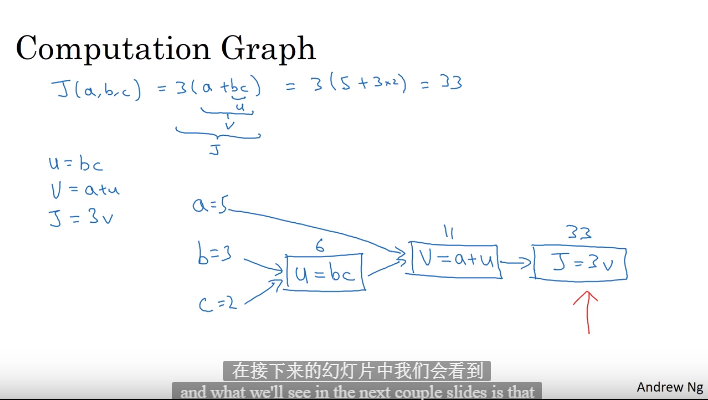

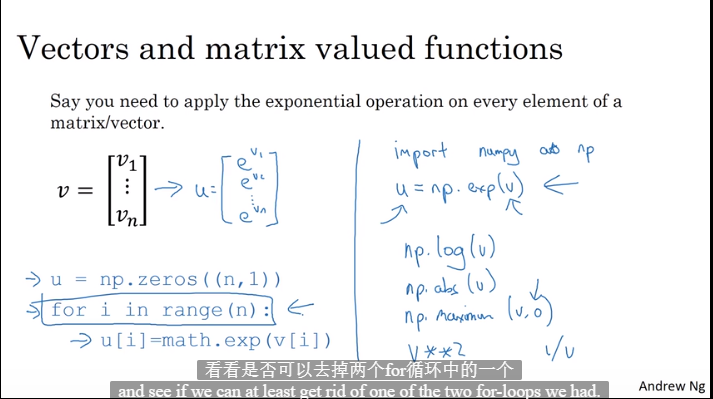

2.7 计算图

2.8 计算图中导数计算

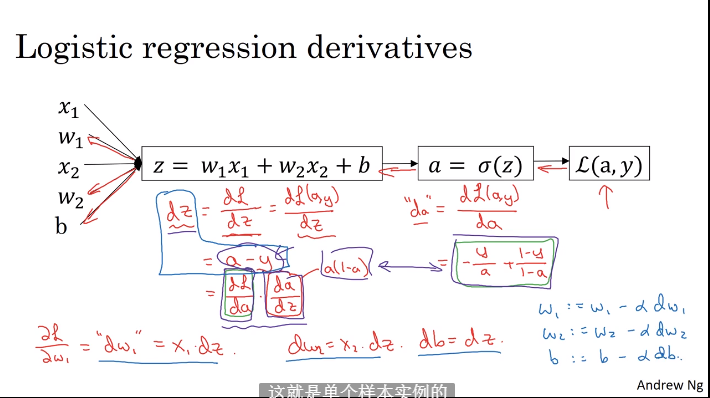

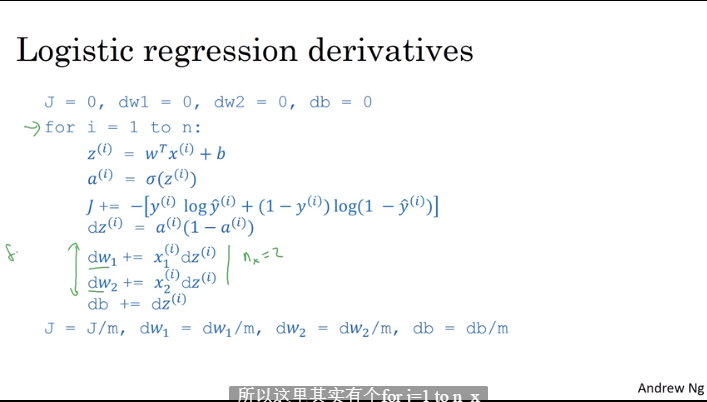

2.9 逻辑回归中的梯度下降

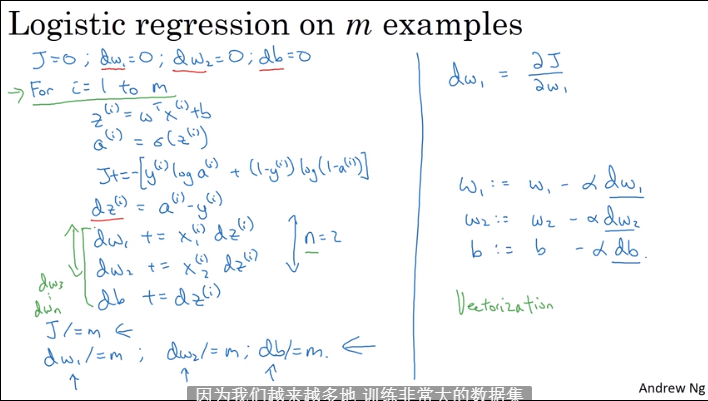

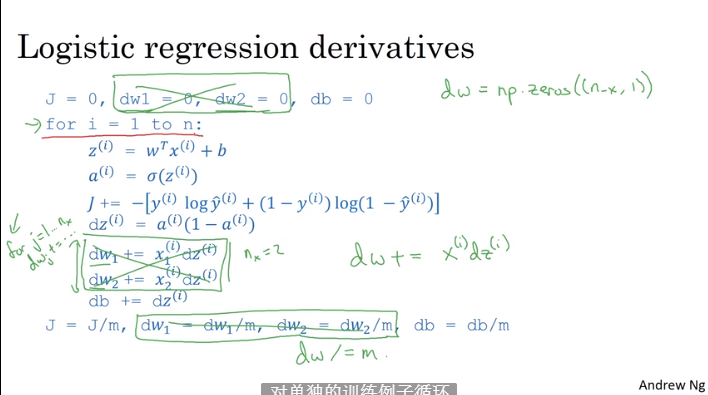

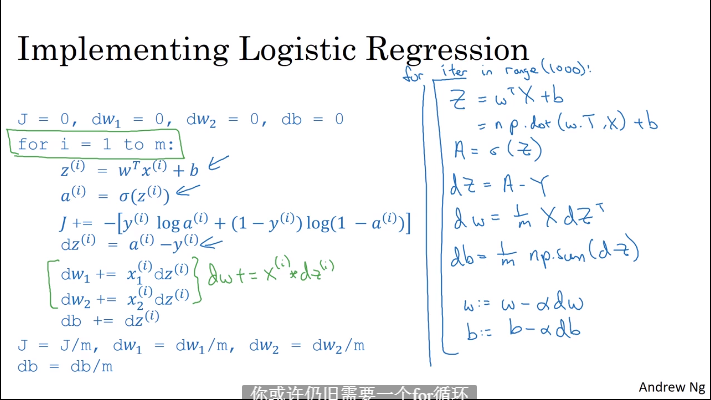

2.10 m个样本的梯度下降

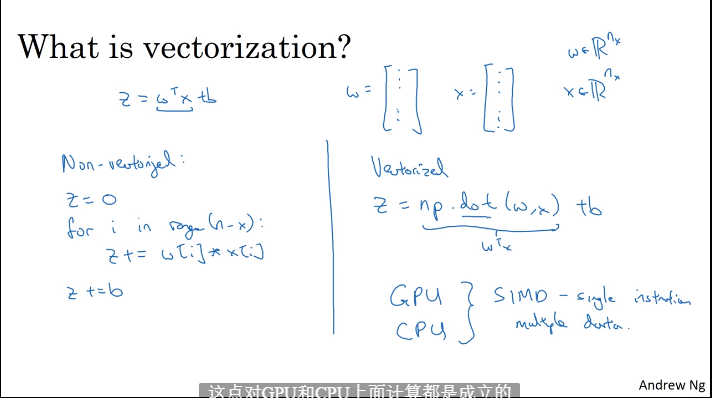

2.11 向量化

2.12 向量化例子

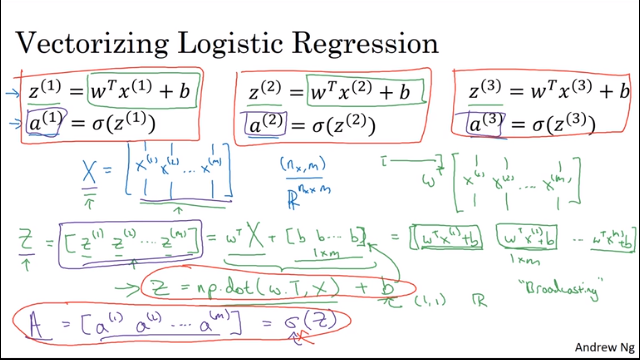

2.13 向量化逻辑回归

2.14 向量化逻辑回归的梯度输出

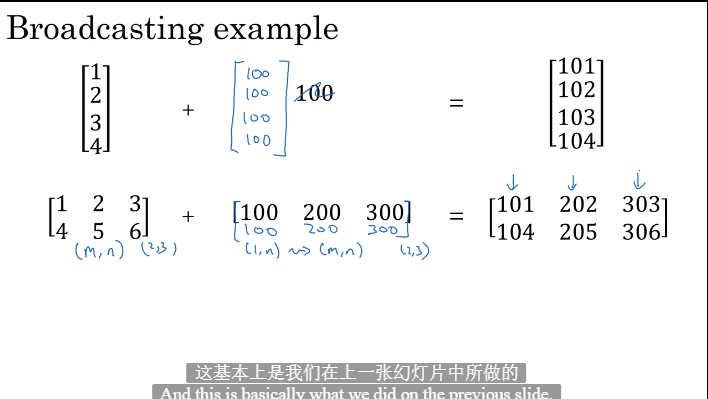

2.15 python中的广播

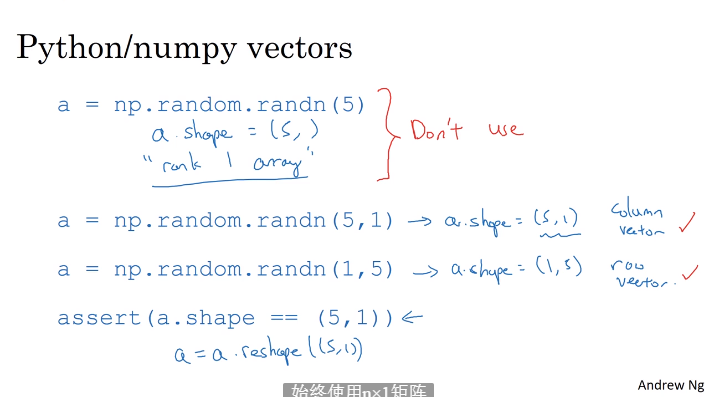

2.16 numpy

2.17 Jupyter

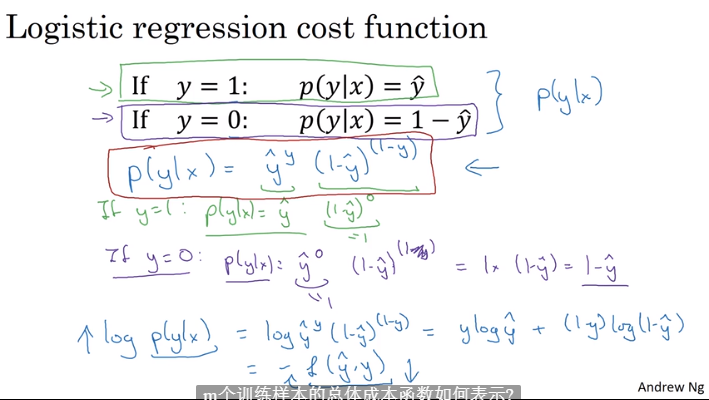

2.18 逻辑回归损失函数的解释

第三周 浅层神经网络

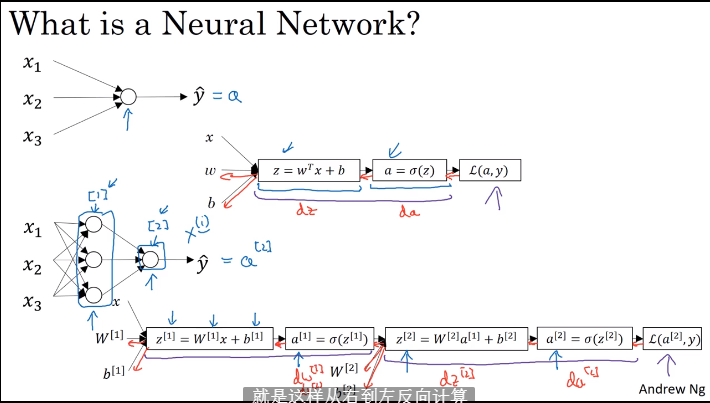

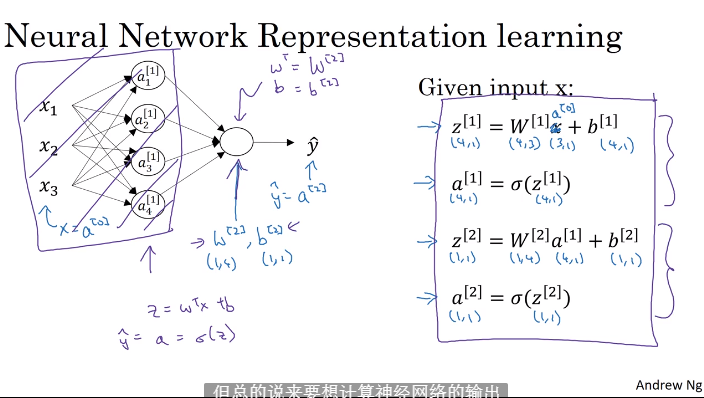

3.1 神经网络概览

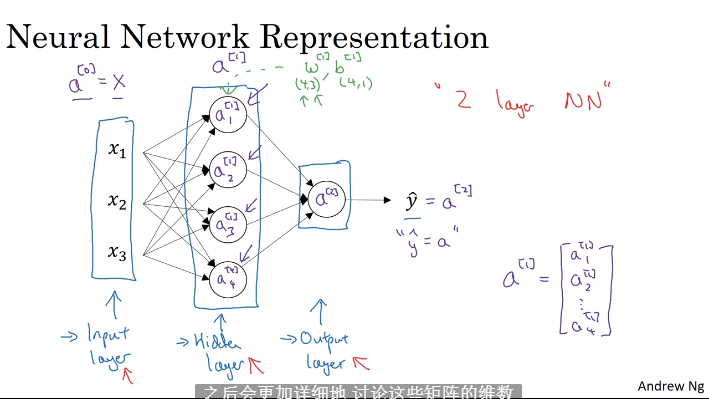

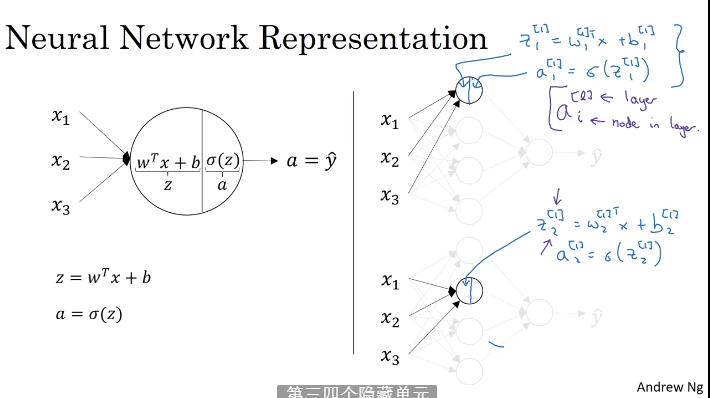

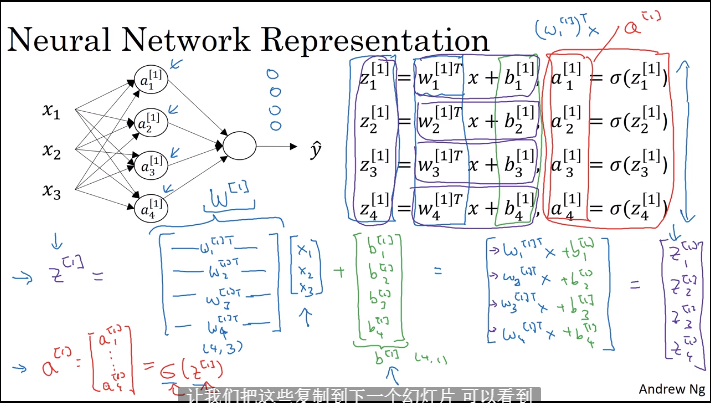

3.2 神经网络表示

- 双层神经网络:输入层-隐藏层-输出层,输入层不计数

3.3 计算神经网络的输出

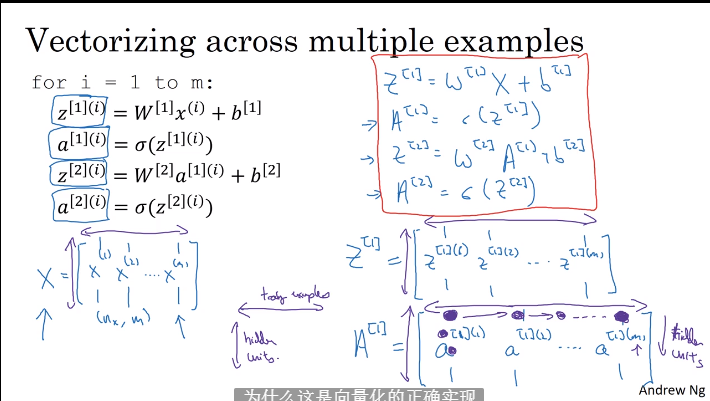

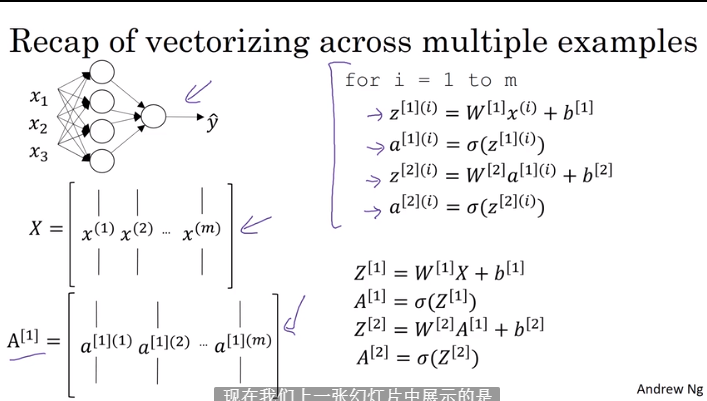

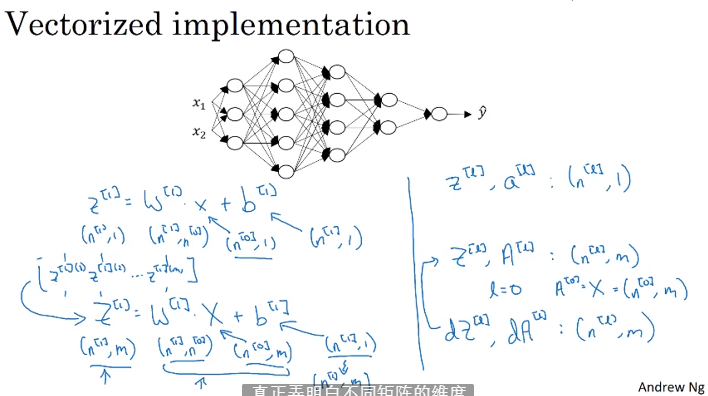

3.4 多样本的向量化

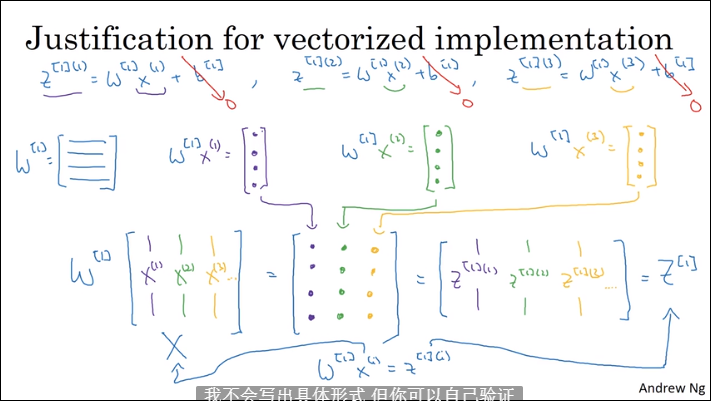

3.5 向量化实现的解释

- 手动向前传播过程

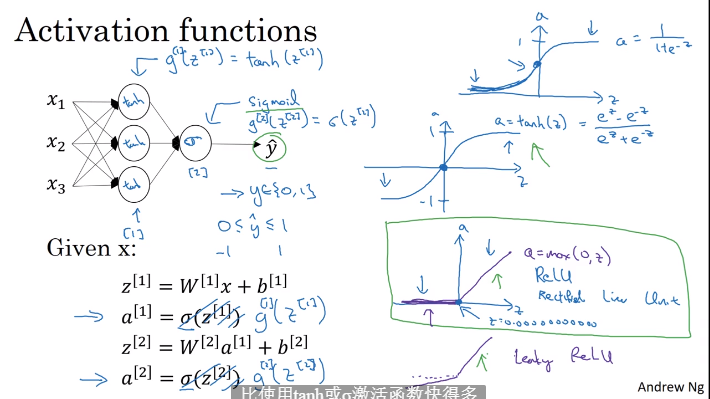

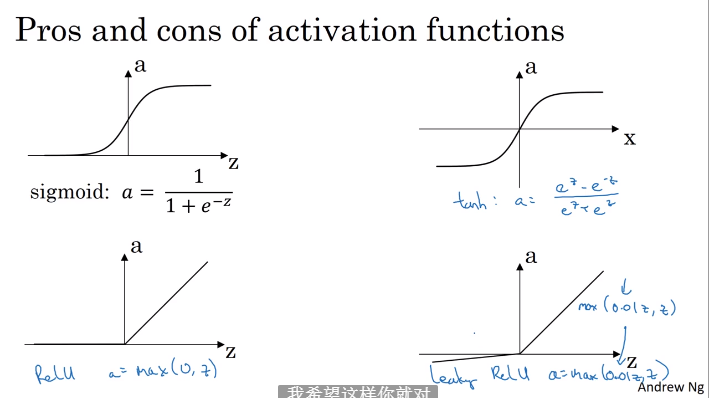

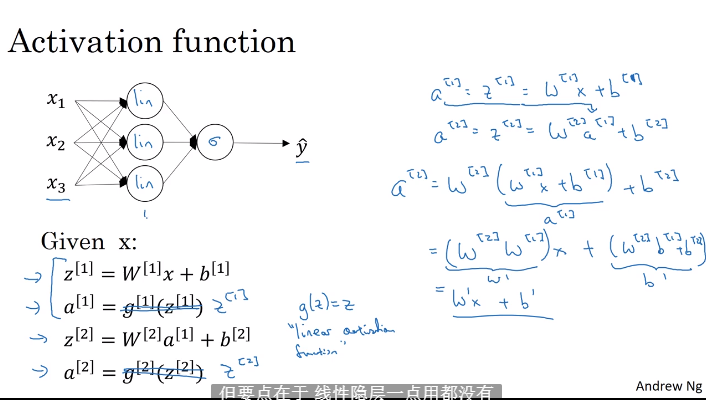

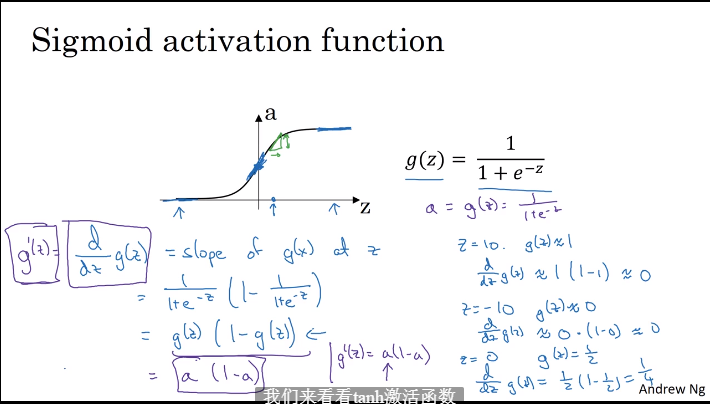

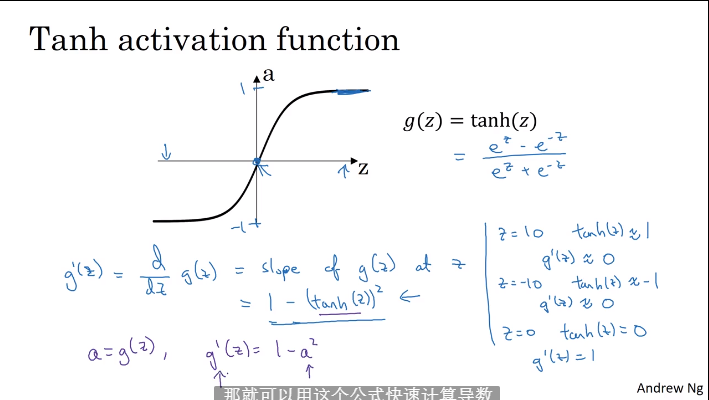

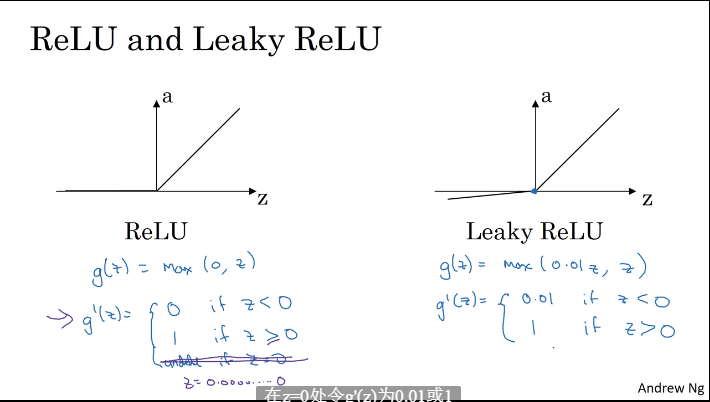

3.6 激活函数

- tanh(x)激活函数更好

- 隐藏层使用tanh(x),输出层使用sigmod(x)

- 函数缺点都是x增大函数值趋于平缓

- 使用max(x,0)函数

- 输出为0,1使用sigmod(x),其他使用Relu线性修正单元

3.7 为什么需要非线性激活单元

- 去掉激活单元的神经网络模型输出就是输入的某种线性组合:对于深度神经网络没有意义,不如直接去掉隐藏层

- 可以使用线性激活单元或者不适用激活单元的是输出层(按照需要)

3.8 激活函数的导数

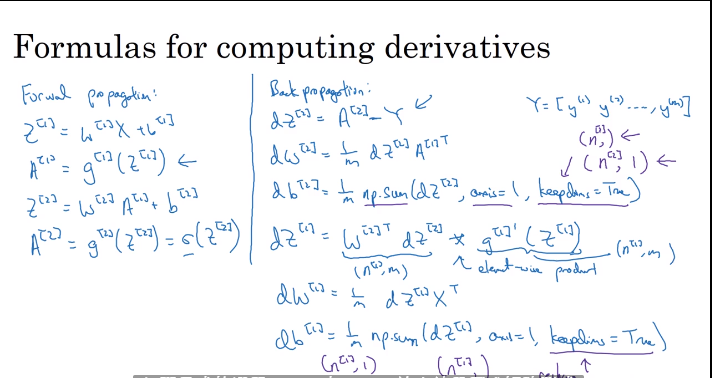

3.9 神经网络的梯度下降法

3.10 直观理解反向传播

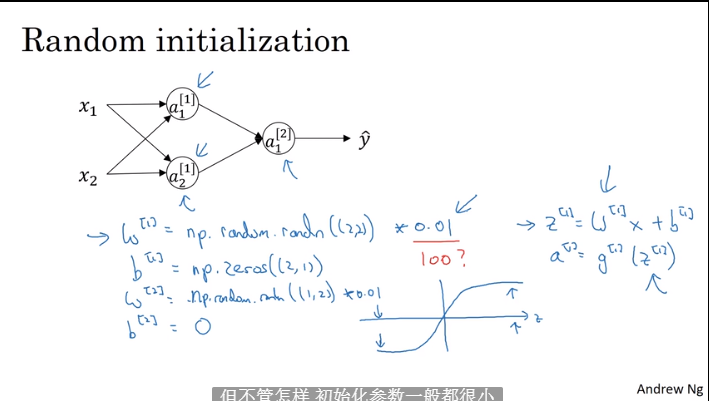

3.11 随机初始化

- 不正确初始化会循环迭代原数据,不能正确跟新

- 初始化参数比较小

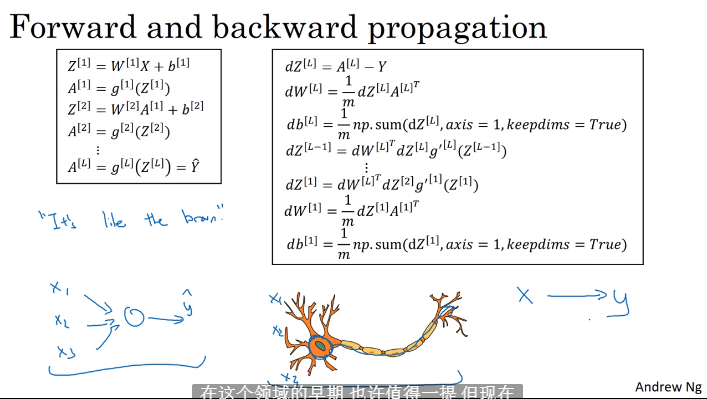

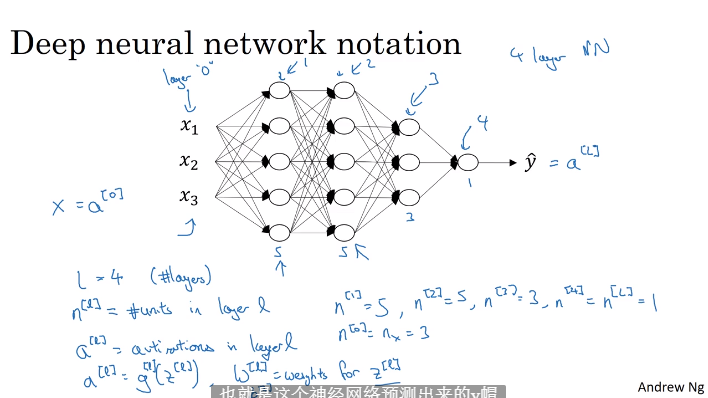

第四周 深层神经网络

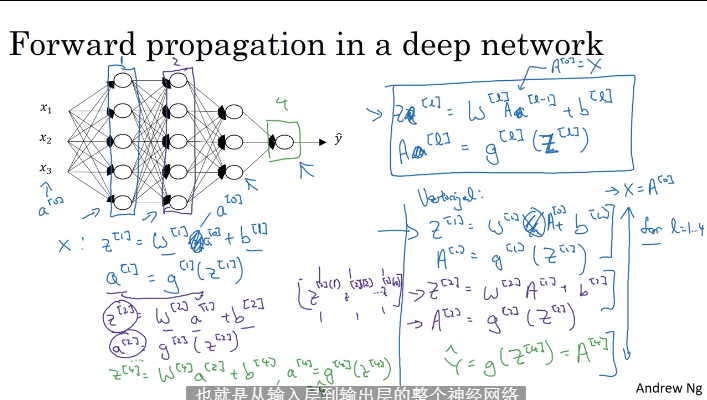

4.1 深层神经网络

- L=4 层数,n[L]:L层的节点数

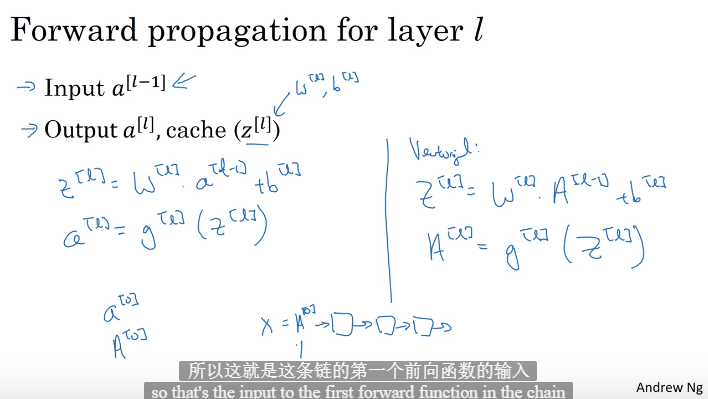

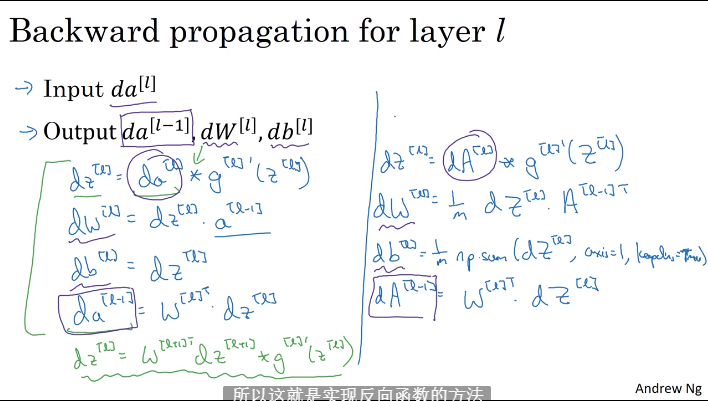

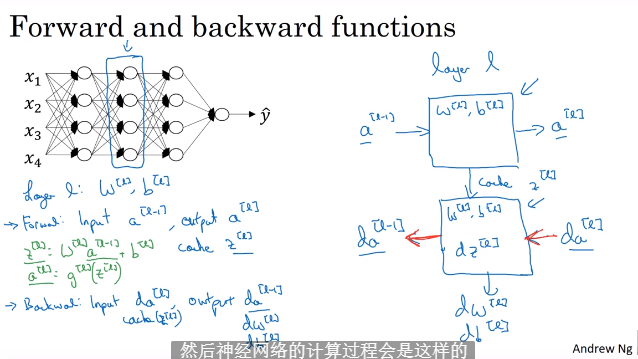

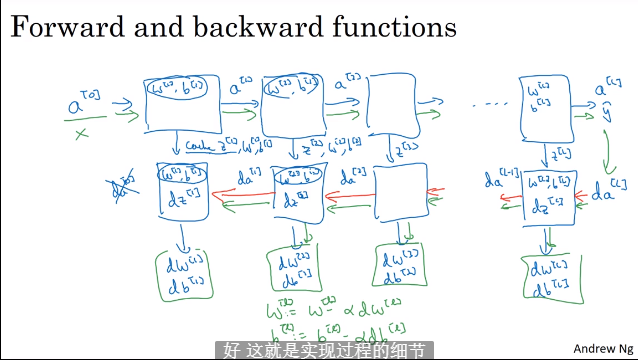

4.2 向前和反向传播

4.3 深层网络向前传播

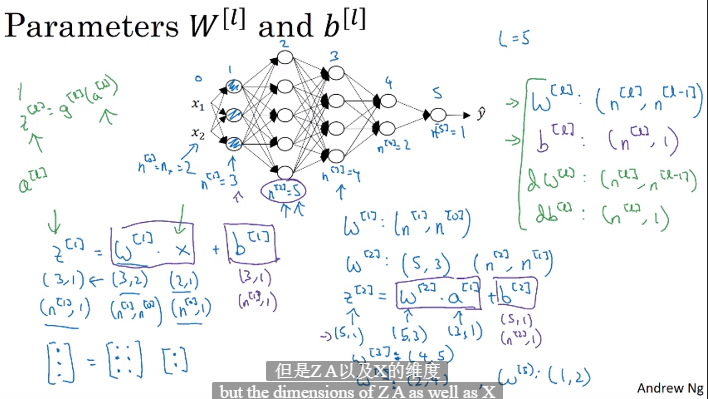

4.4 核对矩阵的维度

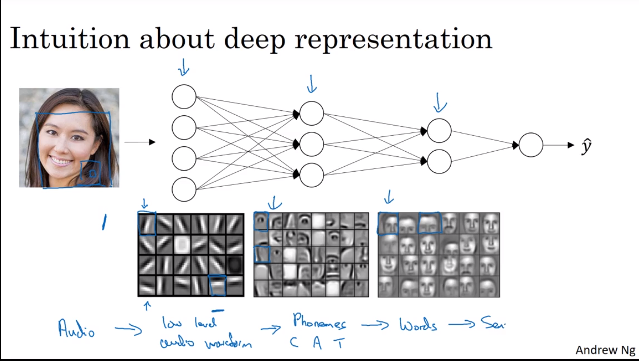

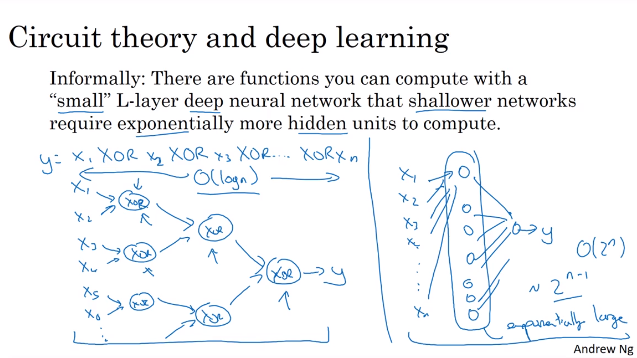

4.5 为什么使用深层网络

- 识别复杂特征

4.6 搭建深层神经网络模块

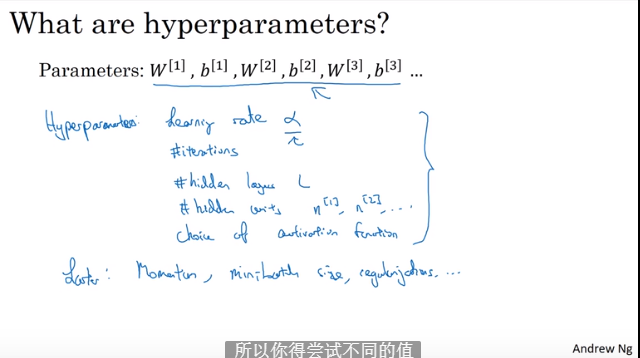

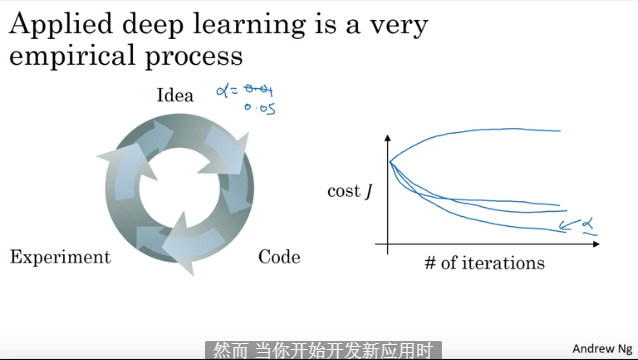

4.7 参数和超参数

4.8 和大脑有什么关系