李宏毅机器学习之逻辑回归笔记

李宏毅机器学习之逻辑回归笔记

第一步--定义函数集

x 和 w 都是向量,可以从朴素贝叶斯推出来这个公式

)

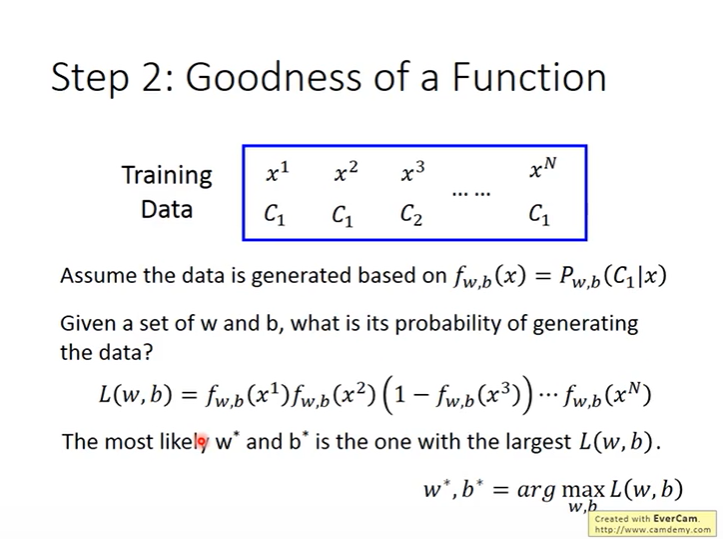

第二步--定义函数的好坏

假设每个样本都是基于$$f_{w, b}(x)=P_{w, b}\left(C_{1} \mid x\right)$$ 该函数,所以可以得到训练数据的可能性函数,使之最大的参数就是最好的参数。

)

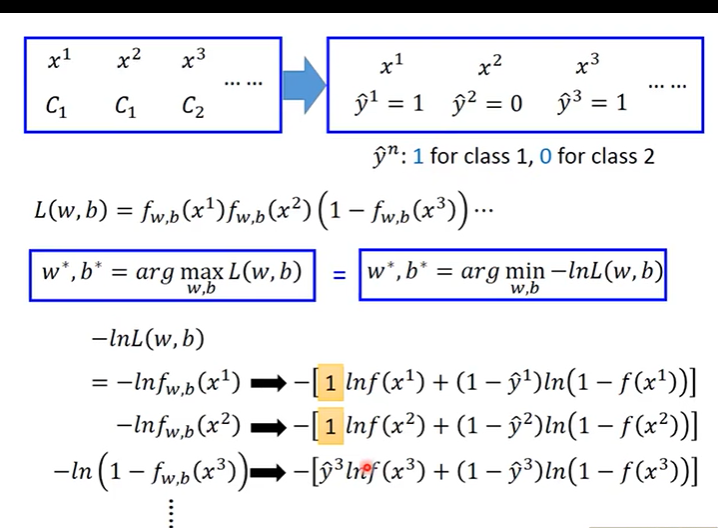

将函数取log,并且转化为求最小值的问题,将c1,c2换为取值为0,1的y1, y2

)

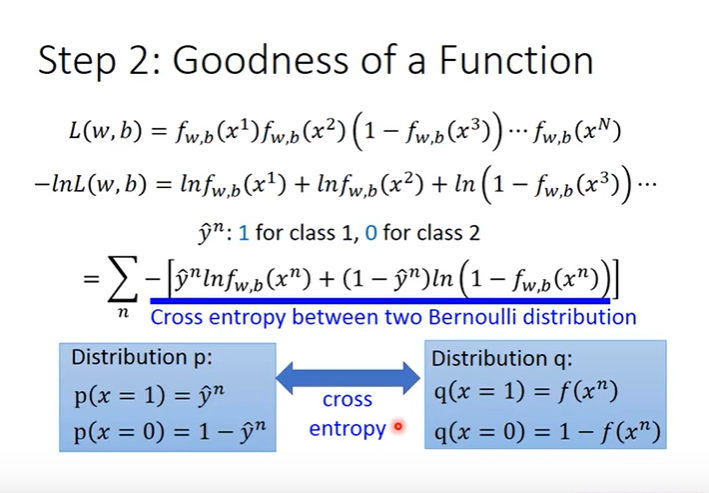

经过转换得到两个变量的交叉熵公式,也可以理解为损失函数,将其最小值最为优化的目标

)

第三步--找到最好的函数

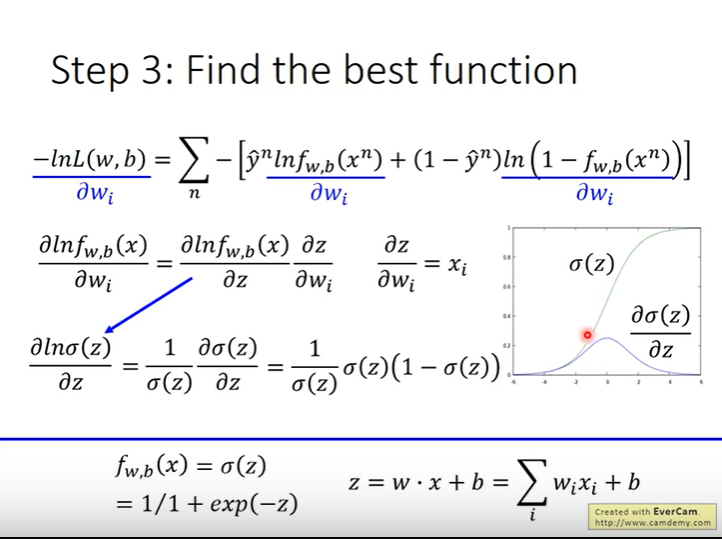

对损失函数求导,得到变形

)

对 w 求偏导

)

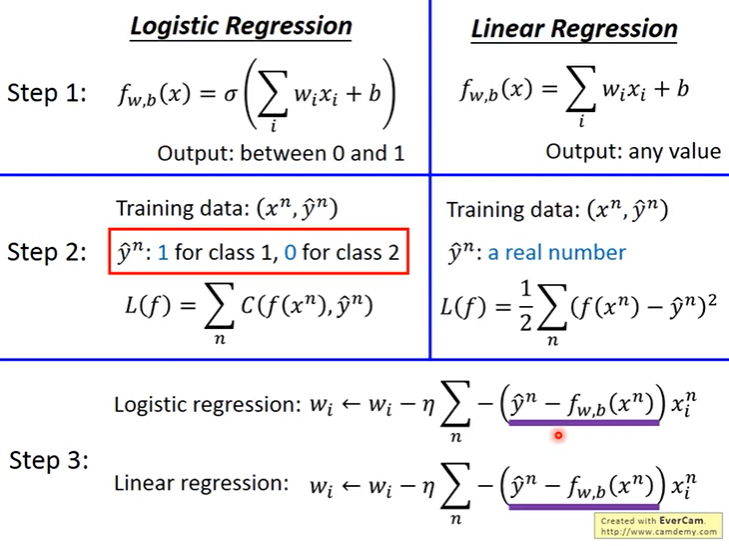

逻辑回归和线性回归的对比

)

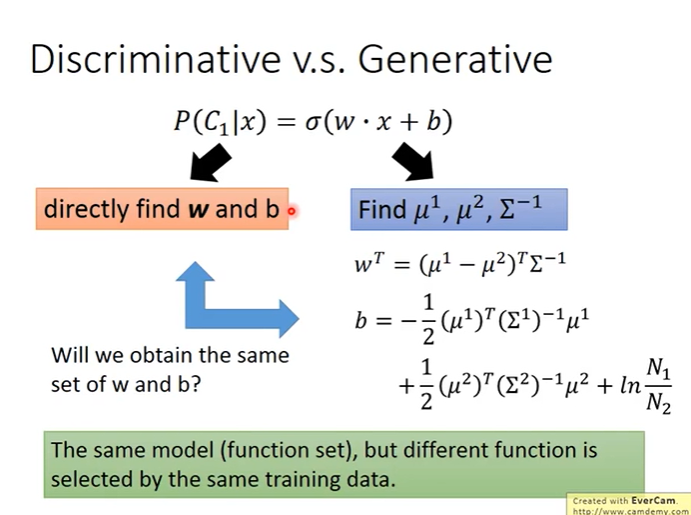

Discriminative v.s. Generative

采用概率模型找到\(\mu\) 和 协方差的方法称为生成法,通过逻辑回归直接找到w 和 b的方法称为discriminative,

)

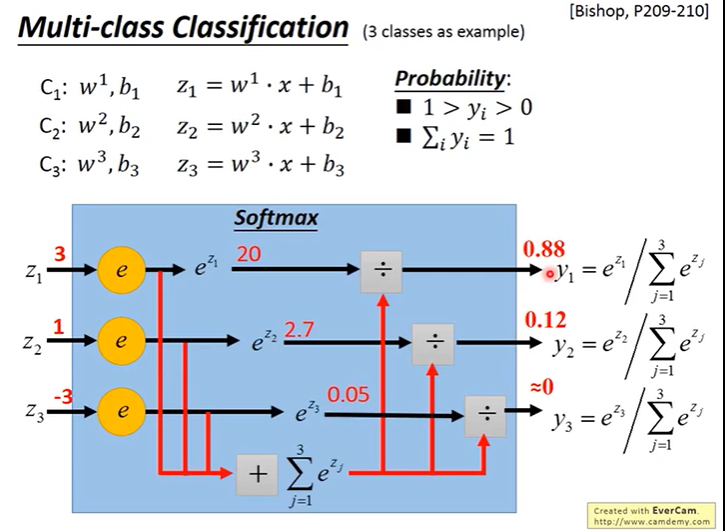

Multi-class Classification

)

浙公网安备 33010602011771号

浙公网安备 33010602011771号