WebGL编程读书笔记

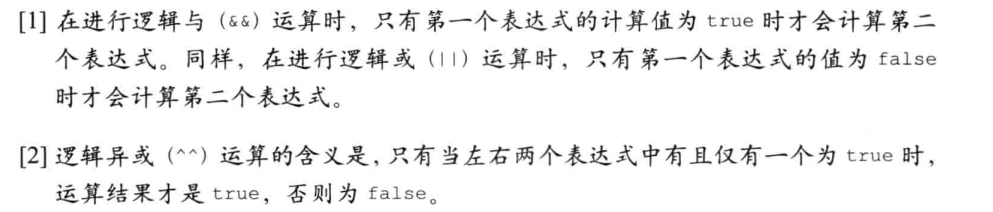

WebGL概述

WebGL起源

在个人计算机上使用最广泛的两种三维图形渲染技术是 Direct3D 和 OpenGL。Direct3D 是微软 DirectX 技术的一部分,是一套由微软控制的编程接口(API),主要用在 Windows 平台;而 OpenGL 由于其开放和免费的特性,在多种平台上都有广泛地使用:它可以在 Macintosh 或 Linux 系统的计算机、智能手机、平板电脑、家用游戏机(如PlayStation和 Nintendo)等各种电子设备上使用。Windows对 OpenGL 也提供了良好的支持,开发者也可以用它来代替Direct3D。

OpenGL 最初由 SGI (Silicon Graphics Inc)开发,并在1992 年发布为开源标准。多年以来,OpenGL 发展了数个版本,并对三维图形开发、软件产品开发,甚至电影制作产生了深远的影响。写这本书时,OpenGL 桌面版的最新版本为 4.3。虽然 WebGL 根植于 OpenGL,但它实际上是从 OpenGL 的一个特殊版本 OpenGL ES 中派生出来的,后者专用于嵌入式计算机、智能手机、家用游戏机等设备。OpenGL ES 于 2003 ~ 2004 年被首次提出,并在 2007 年 (ES 2.0) 和 2012年 (ES 3.0) 进行了两次升级,WebGL 是基于 OpenGL ES 2.0 的。这几年,采用 OpenGL ES 技术的电子设备的数量大幅增长,如智能手机 (iPhone 和安卓)、平板电脑、游戏机等。OpenGL ES 成功被这些设备采用的部分原因是,它在添加新特性的同时从 OpenGL 中移除了许多陈旧无用的旧特性,这使它在保持轻量级的同时,仍具有足够的能力来渲染出精美的三维图形。

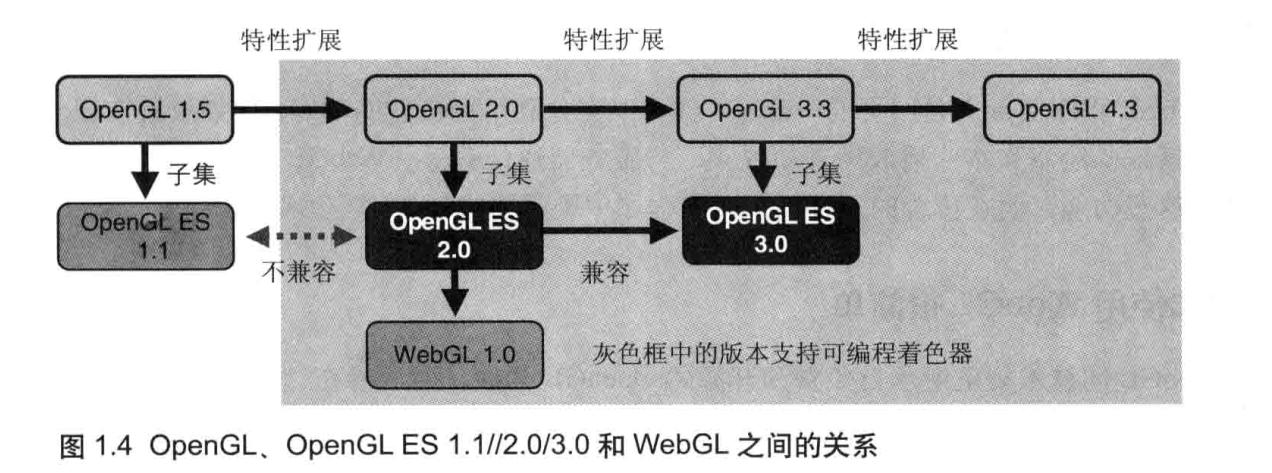

下图显示了 OpenGL、OpenGL ES 1.1/2.0/3.0和 WebGL 的关系。由于 OpenGL 本身已经从 1.5 发展到了2.0,再到 4.3,所以 OpenGL ES 被标准化为特定版本 OpenGI(OpenGL 1.5 和 OpenGL 2.0) 的子集。

如图所示,从 2.0 版本开始OpenGL 支持了一项非常重要的特性,即可编程着色器方法(programmable shader functions)。该特性被 OpenGL ES 2.0 继承,并成为了WebGL 1.0 标准的核心部分。

着色器方法,或称着色器,使用一种类似于 C 的编程语言实现了精美的视觉效果本书将一步步阐述着色器,帮助你快速掌握 WebGL。编写着色器的语言又称为着色器语言(shading language),OpenGL ES 2.0 基于 OpenGL 着色器语言(GLSL),因此后者又被称为 OpenGL ES 着色器语言(GLSL ES)WebGL 基于 OpenGL ES 2.0,也使用 GLSLES 编写着色器。

OpenGL 规范的更新和标准化由 Khronos 组织 (一个非盈利的行业协会,专注于制定发布、推广多种开放标准)负责。2009 年,Khronos 建立了 WebGL 工作小组,开始基于OpenGL ES 着手建立 WebGL 规范,并于 2011 年发布了 WebGL 规范的第1个版本。本书主要基于第1版的 WebGL 规范编写,后续更新目前都是以草案的形式发布,如有需要也可参考。

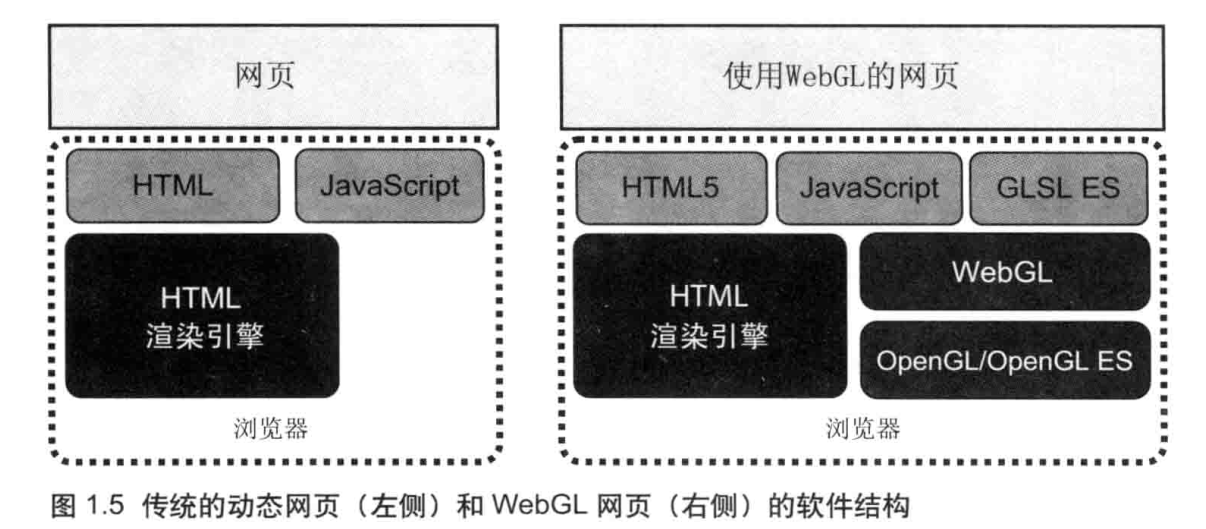

WebGL程序的结构

在 HTML 中,动态网页包括 HTML 和 JavaScript 两种语言引人 WebGL 后,还需也就是说,WebGL 页面包含了三种语言:HTML5 (超文要加入着色器语言 GLSL ES(左侧)和使用传统的动态网页本标记语言)、JavaScript,和 GLSL ES.WebGL 的网页 (右侧) 的软件结构。

然而,因为通常 GLSL ES 是 (以字符串的形式)在 JavaScript 中编写的,实际上WebGL 程序也只需用到 HTML 文件和 JavaScript 文件。所以,虽然 WebGL 网页更加复杂了,但它仍然保持着与传统的动态网页相同的结构:只用到 HTML 文件和 JavaScript文件。

WebGL入门

WebGL采用HTML5 中新引人的

<canvas>元素(标签)定义了网页上的绘图区域。如果没有 WebGL,JavaScript 只能在<canvas>上绘制二维图形,有了 WebGL,就可以在上面绘制三维图形了。

最短的WebGL程序:清空绘图区

<!DOCTYPE html>

<html lang="en">

<head>

<meta charset="UTF-8">

<title>使用指定颜色清空画布</title>

</head>

<body onload="main()">

<canvas id="example" width="400" height="400">

请使用支持canvas的浏览器

</canvas>

</body>

<script src="../lib/webgl-utils.js"></script>

<script src="../lib/webgl-debug.js"></script>

<script src="../lib/cuon-utils.js"></script>

<script src="clearCanvas.js"></script>

</html>

function main(){

const canvas = document.getElementById("example");

// 获取二维图形的绘图上下文

const gl = getWebGLContext(canvas);

if(!gl){

console.error("webgl渲染失败");

return;

}

// 指定清空画布所用的颜色

gl.clearColor(0, 0, 1, 1);

// 使用上面指定的颜色清空画布

gl.clear(gl.COLOR_BUFFER_BIT);

}

绘制图形(2d和3d)三步骤:

- 获取 canvas 元素

- 获取绘图上下文

- 开始绘图

关于绘图上下文

在获取 WebGL 绘图上下文时,canvas.getContex() 函数接收的参数,在不同浏览器中会不同,所以书中写了一个函数 getwebGLContext 来隐藏不同浏览器之间的差异。

// 核心代码

var create3DContext = function(canvas, opt_attribs) {

var names = ["webgl", "experimental-webgl", "webkit-3d", "moz-webgl"];

var context = null;

for (var ii = 0; ii < names.length; ++ii) {

try {

context = canvas.getContext(names[ii], opt_attribs);

} catch(e) {}

if (context) {

break;

}

}

return context;

}

设置<canvas>的背景色

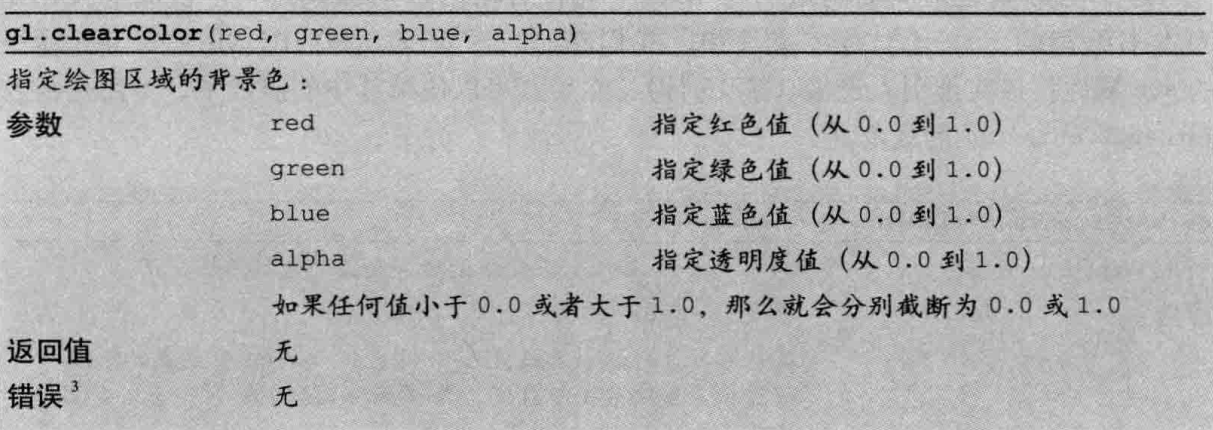

在清空绘图区之前,你可以指定背景色

一旦指定了背景色之后,背景色就会驻存在 WebGL 系统(WebGL System)中,在下次调用 gl.clearcolor() 方法前不会改变。换句话说,如果将来什么时候你还想用同一个颜色再清空一次绘图区,没必要再指定一次背景色。

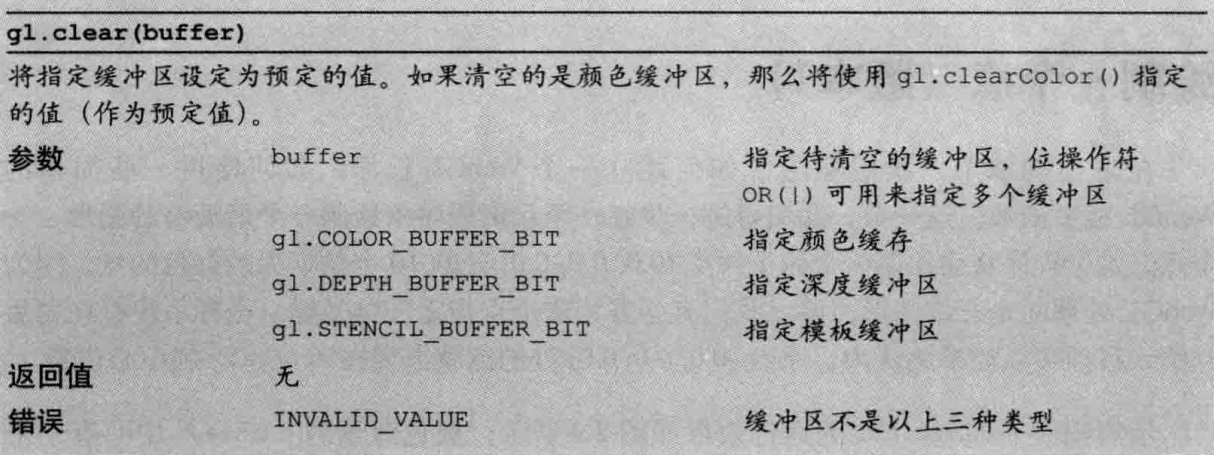

清空<canvas>

调用 gl.clear() 函数,用之前指定的背景色清空 (即用背景色填充,擦除已经绘制的内容)绘图区域。

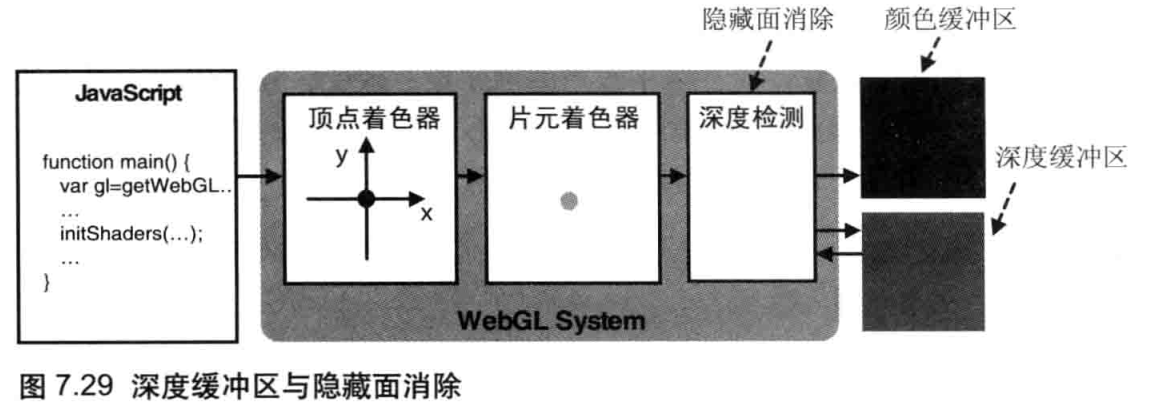

函数的参数是 gl.COLOR_BUEEER_BIT,而不是 (你可能认为会是)表示绘图区域的canvas,这是因为 WebGL 中的 gl.clear() 方法实际上继承自 OpenGL,它基于多基本缓冲区模型,这可比二维绘图上下文复杂得多。清空绘图区域,实际上是在清空须色缓冲区(color buffer),传递参数 gl.COLOR_BUEEER_BIT 就是在告诉 WebGL 清空颜色缓冲区。除了颜色缓冲区,WebGL 还会使用其他种类的缓冲区,比如深度缓冲区和模板缓冲区。深度缓冲区将在“进入三维世界”中解释。由于模板缓冲区很少被使用,因为它本书将不会涉及。

清空颜色缓冲区将导致 WebGL 清空页面上的canvas区城。

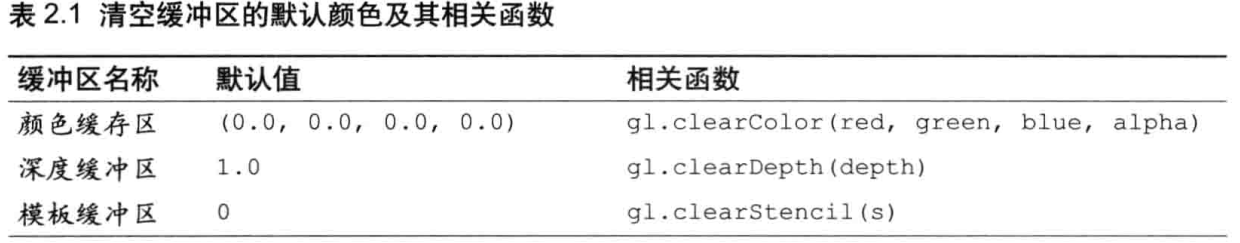

如果没有指定背景色 (也就是说,你没有调用 gl.clearcolor()),那么使用的默认值如下所示 。

绘制一个点(版本1)

<!DOCTYPE html>

<html lang="en">

<head>

<meta charset="utf-8" />

<title>Draw a point (1)</title>

</head>

<body onload="main()">

<canvas id="webgl" width="400" height="400">

Please use a browser that supports "canvas"

</canvas>

<script src="../lib/webgl-utils.js"></script>

<script src="../lib/webgl-debug.js"></script>

<script src="../lib/cuon-utils.js"></script>

<script src="HelloPoint1.js"></script>

</body>

</html>

// HelloPoint1.js (c) 2012 matsuda

// 顶点着色程序

var VSHADER_SOURCE =

'void main() {\n' +

' gl_Position = vec4(0.0, 0.0, 0.0, 1.0);\n' + // 设置坐标,必须有值

' gl_PointSize = 10.0;\n' + // 设置尺寸,默认为1.0

'}\n';

// 片源着色器程序

var FSHADER_SOURCE =

'void main() {\n' +

' gl_FragColor = vec4(1.0, 0.0, 0.0, 1.0);\n' + // 设置颜色

'}\n';

function main() {

// 获取 canvas 元素

var canvas = document.getElementById('webgl');

// 获取WebGL绘图上下文

var gl = getWebGLContext(canvas);

if (!gl) {

console.log('Failed to get the rendering context for WebGL');

return;

}

// 初始化着色器

if (!initShaders(gl, VSHADER_SOURCE, FSHADER_SOURCE)) {

console.log('Failed to intialize shaders.');

return;

}

// 设置 canvas的背景色

gl.clearColor(0.0, 0.0, 0.0, 1.0);

// 清空 canvas

gl.clear(gl.COLOR_BUFFER_BIT);

// 绘制一个点

gl.drawArrays(gl.POINTS, 0, 1);

}

// cuon-utils.js (c) 2012 kanda and matsuda

/**

* Create a program object and make current

* @param gl GL context

* @param vshader a vertex shader program (string)

* @param fshader a fragment shader program (string)

* @return true, if the program object was created and successfully made current

*/

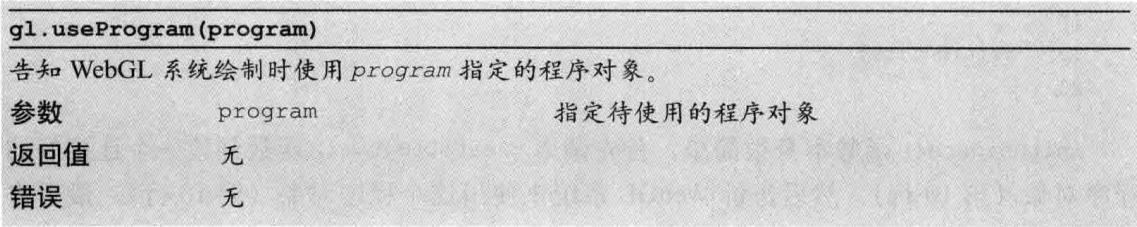

function initShaders(gl, vshader, fshader) {

var program = createProgram(gl, vshader, fshader);

if (!program) {

console.log('Failed to create program');

return false;

}

gl.useProgram(program);

gl.program = program;

return true;

}

/**

* Create the linked program object

* @param gl GL context

* @param vshader a vertex shader program (string)

* @param fshader a fragment shader program (string)

* @return created program object, or null if the creation has failed

*/

function createProgram(gl, vshader, fshader) {

// Create shader object

var vertexShader = loadShader(gl, gl.VERTEX_SHADER, vshader);

var fragmentShader = loadShader(gl, gl.FRAGMENT_SHADER, fshader);

if (!vertexShader || !fragmentShader) {

return null;

}

// Create a program object

var program = gl.createProgram();

if (!program) {

return null;

}

// Attach the shader objects

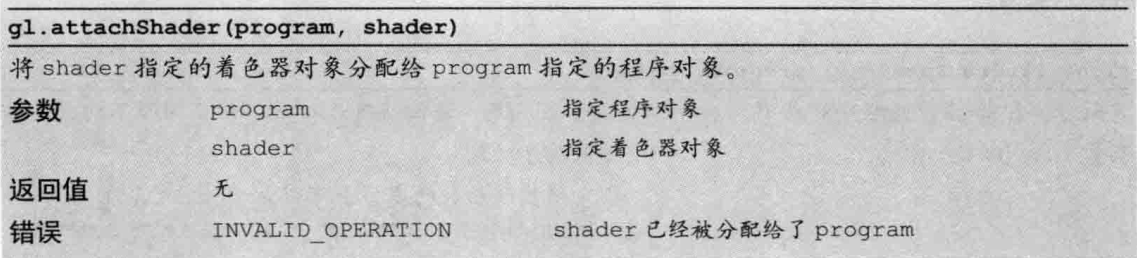

gl.attachShader(program, vertexShader);

gl.attachShader(program, fragmentShader);

// Link the program object

gl.linkProgram(program);

// Check the result of linking

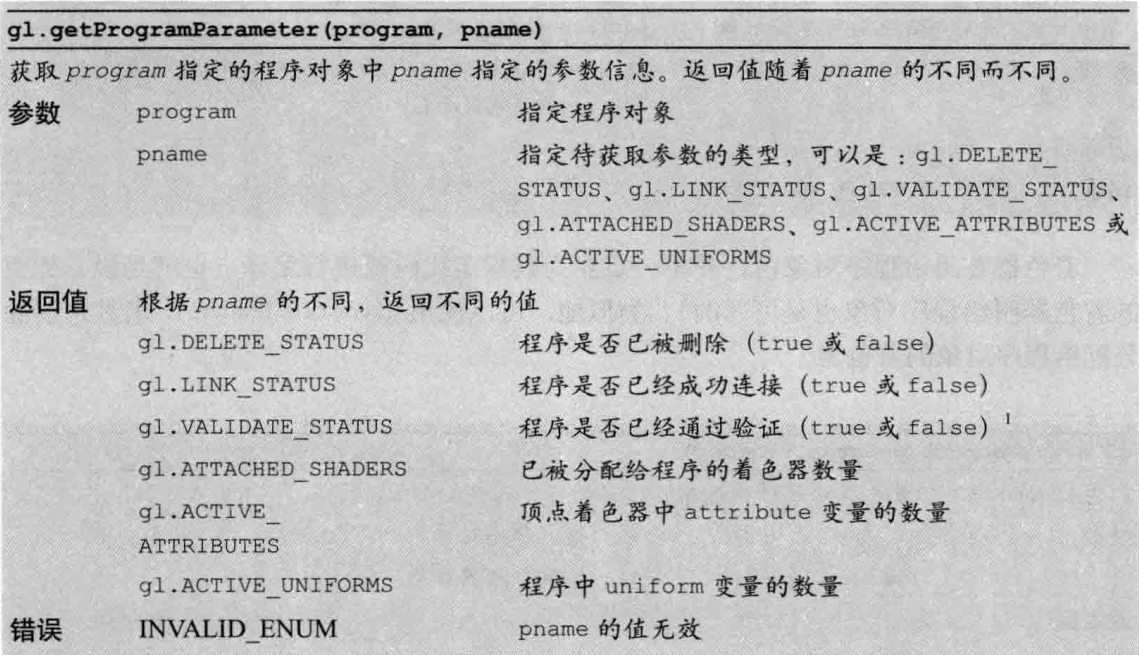

var linked = gl.getProgramParameter(program, gl.LINK_STATUS);

if (!linked) {

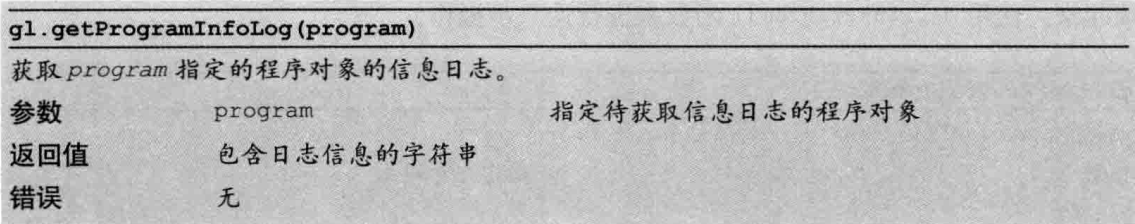

var error = gl.getProgramInfoLog(program);

console.log('Failed to link program: ' + error);

gl.deleteProgram(program);

gl.deleteShader(fragmentShader);

gl.deleteShader(vertexShader);

return null;

}

return program;

}

/**

* Create a shader object

* @param gl GL context

* @param type the type of the shader object to be created

* @param source shader program (string)

* @return created shader object, or null if the creation has failed.

*/

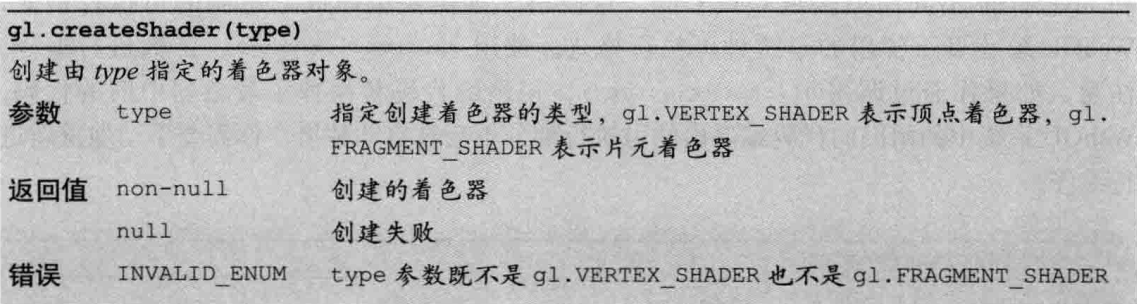

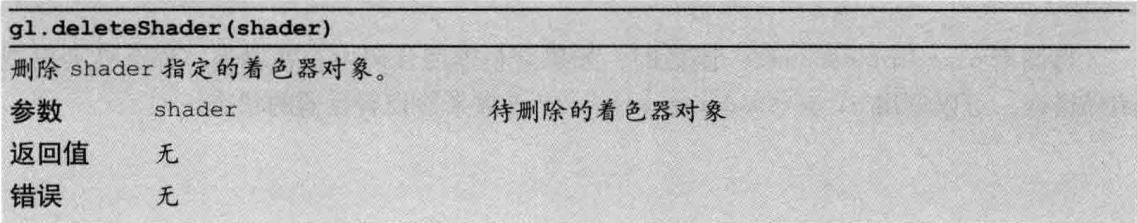

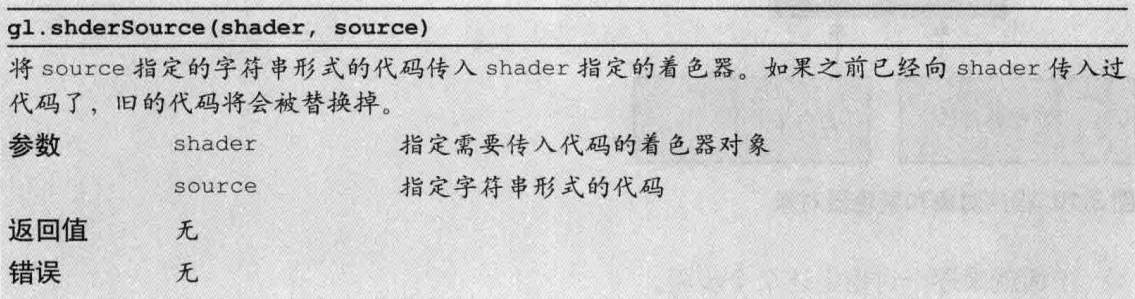

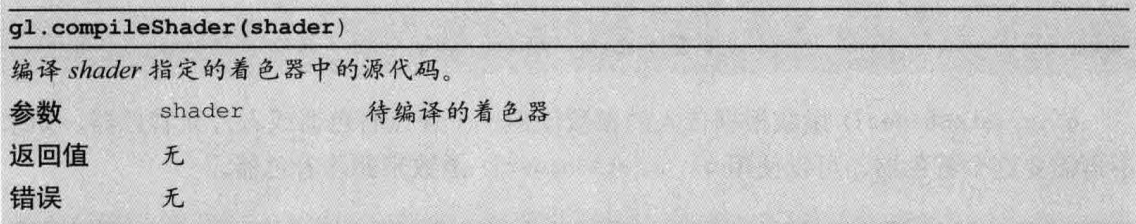

function loadShader(gl, type, source) {

// Create shader object

var shader = gl.createShader(type);

if (shader == null) {

console.log('unable to create shader');

return null;

}

// Set the shader program

gl.shaderSource(shader, source);

// Compile the shader

gl.compileShader(shader);

// Check the result of compilation

var compiled = gl.getShaderParameter(shader, gl.COMPILE_STATUS);

if (!compiled) {

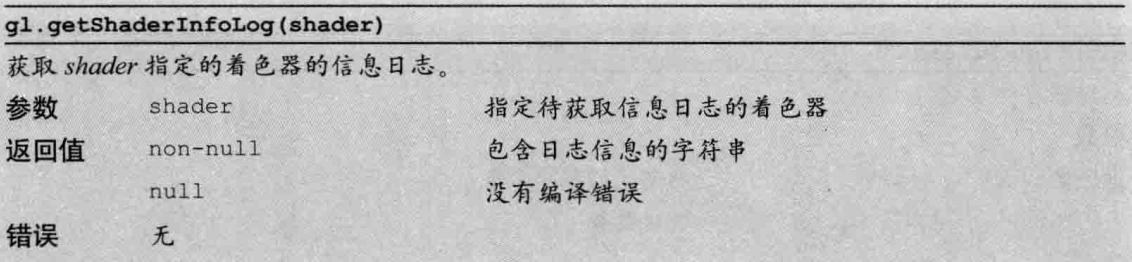

var error = gl.getShaderInfoLog(shader);

console.log('Failed to compile shader: ' + error);

gl.deleteShader(shader);

return null;

}

return shader;

}

着色器

要使用WebGL进行绘图就必须使用着色器。在代码中,着色器程序是以字符串的形式“嵌人”在 JavaScript 文件中的,在程序真正开始运行前它就已经设置好了。

WebGL需要两种着色器

- 顶点着色器(Vertexshader):顶点着色器是用来描述顶点特性(如位置、颜色等)的程序。顶点(vertex)是指二维或三维空间中的一个点,比如二维或三维图形的端点或交点。

- 片元着色器(Fragment shader):进行逐片元处理过程如光照(见“光照”)的程序。片元(fragment)是一个WebGL术语,你可以将其理解为像素(图像的单元)。

简单地说,在三维场景中,仅仅用线条和颜色把图形画出来是远远不够的。你必须考虑,比如,光线照上去之后,或者观察

者的视角发生变化,对场景会有些什么影响。着色器可以高度灵活地完成这些工作,提供各种渲染效果。这也就是当今计算机制作出的三维场景如此逼真和令人震撼的原因。

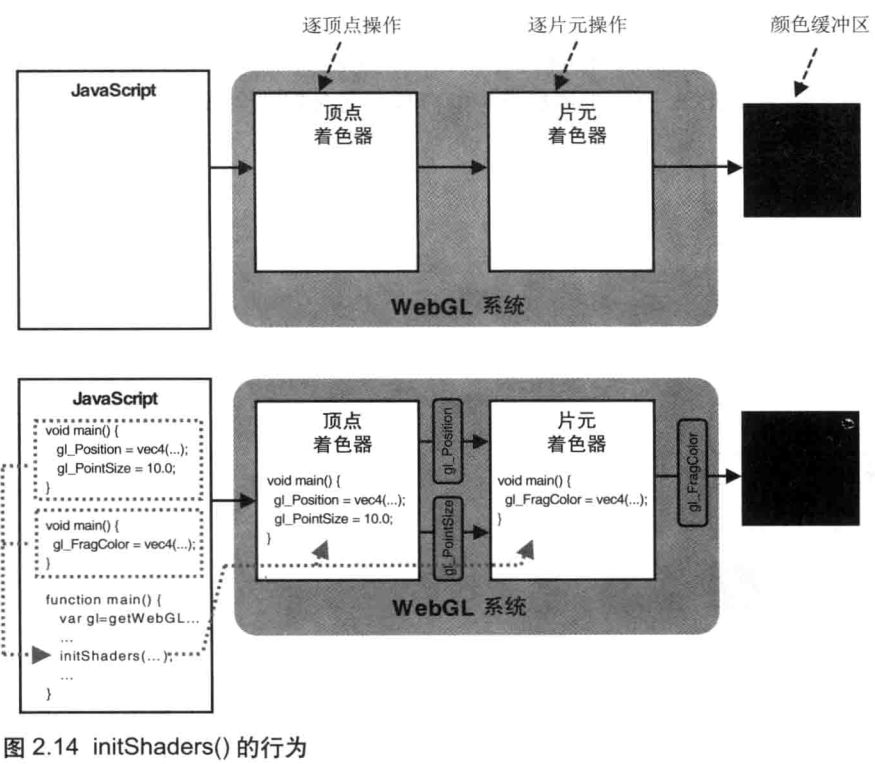

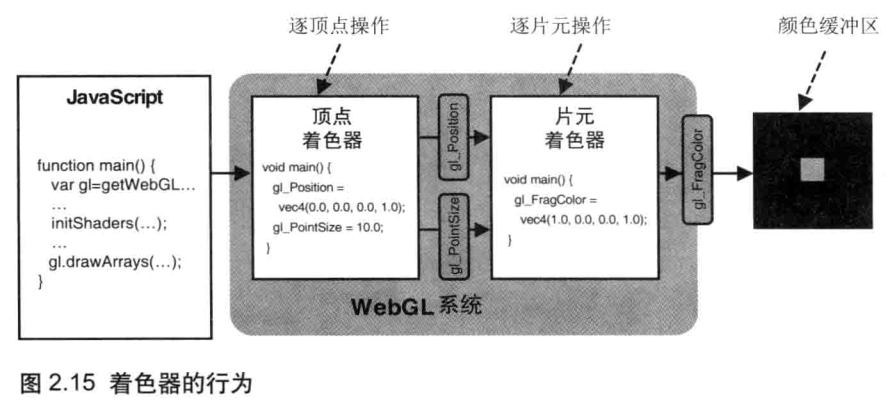

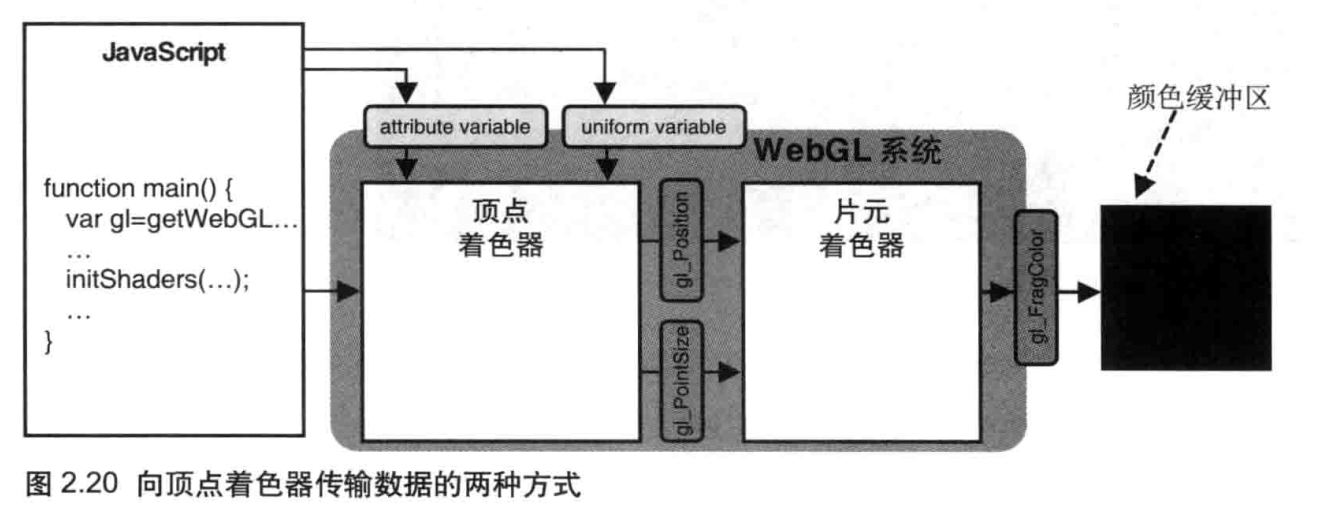

下图显示了程序的执行流程:从执行JavaScript,到在WebGL系统中使用着色器在浏览器上绘制图形。

程序执行的流程大概是:首先运行 JavaScript 程序,调用WebGL的相关方法,然后顶点着色器和片元着色器就会执行,在颜色缓冲区内进行绘制,这时就清空了绘图区;最后,颜色缓冲区中的内容会自动在浏览器的 canvas 上显示出来。

示例程序的任务是,在屏幕上绘制一个10像素大小的点,它用到两个着色器:

- 顶点着色器指定了点的位置和尺寸。本例中,点的位置是(0.0,0.0,0.0),尺寸是10.0像素。

- 片元着色器指定了点的颜色。本例中,点的颜色是红色(1.0,0.0,0.0,1.0)。

使用着色器的WebGL 程序的结构

着色器是以 JavaScript 字符串形式编写的着色器语言程序,这样主程序就可以将他们传给WebGL 系统。

因为着色器程序代码必须预先处理成单个字符串的形式,所以我们用+号将多行字符串连成一个长字符串。每一行以\n 结束,这是由于当着色器内部出错时,就能获取出错的行号,这对于检查源代码中的错误很有帮助。但是,\n 并不是必须的,你自己编写

着色器时,也可以不用它。

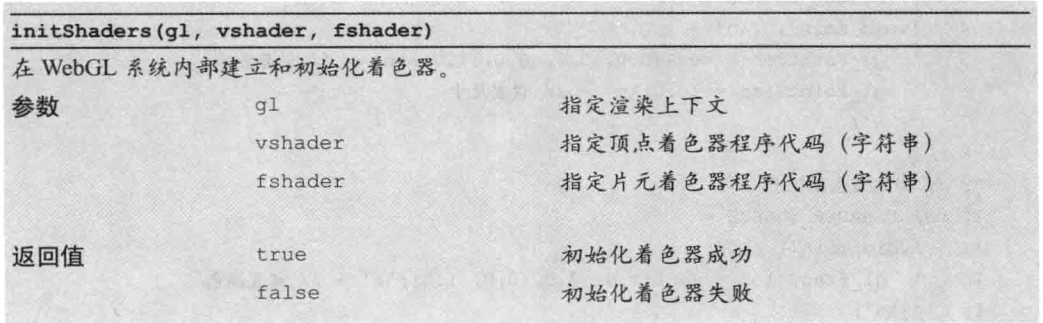

初始化着色器

书中初始化着色器辅助函数 initShaders 说明如下:

如图2.14中的上方图所示,WebGL系统由两部分组成,即顶点着色器和片元着色器。在初始化着色器之前,顶点着色器和片元着色器都是空白的,我们需要将字符串形式的着色器代码从JavaScript传给WebGL系统,并建立着色器,这就是initShaders()所做的事情。注意,着色器运行在 WebGL 系统中,而不是JavaScript程序中。

图2.14下方图显示了initShaders()执行后的情形,着色器程序以字符串的形式传给initShaders(),然后在WebGL系统中,着色器就建立好了并随时可以使用。如图所示,顶点着色器先执行,它对glPosition变量和glPointSize变量进行赋值,并将它们传入片元着色器,然后片元着色器再执行。

WebGL程序包括运行在浏览器中的JavaScript和运行在WebGL系统的着色器程序这两个部分。

绘制一个点,在初始化中需要设置三项信息:位置,尺寸和颜色,指定三项信息的方式如下:

- 顶点着色器将指定点的位置和尺寸,在这个示例程序中,点的位置是(000.00.0)

而点的尺寸是10.0。- 片元着色器将指定点的颜色。在示例程序中,点的颜色是红色(10,00,001.0)。

顶点着色器

顶点着色器设置了点的位置和颜色

顶点着色器程序,和C语言程序一样,必须包含一个main()函数。main()前面的关键字void表示这个函数不会有返回值。还有,你不能为main()指定参数。

就像JavaScript一样,着色器程序使用=操作符为变量赋值。首先将点的位置赋值给gl_Position变量,然后将点的尺寸赋值给gl_PointSize,这两个变量是内置在顶点着色器中的,而且有着特殊的含义:gl_Position表示顶点的位置(这里,就是要绘制的点的位置),gl_Pointsize表示点的尺寸,如下图所示。

注意,gl_Position变量必须被赋值,否则着色器就无法正常工作。相反,gl_Pointsize并不是必须的,如果你不赋值,着色器就会为其取默认值1.0。

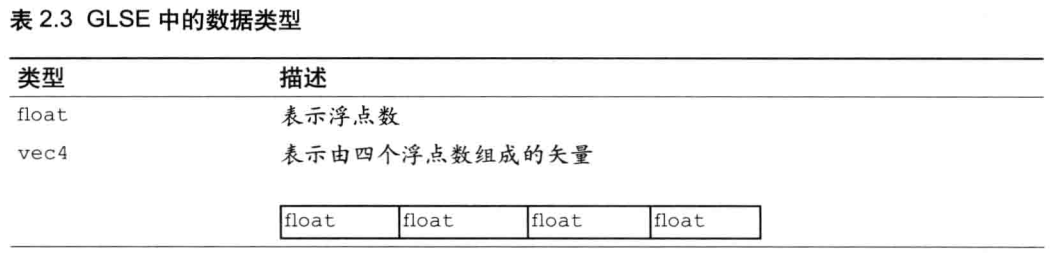

和JavaScript不同,GLSLES是一种强类型的编程语言,也就是说,开发者需要明确指出某个变量是某种“类型”的,C和Java就是这样的语言。通过为变量指定类型,系统就能够轻易理解变量中存储的是何种数据,进而优化处理这些数据。表2.3总结了这一节出现在GLSLES代码中的几种类型。

注意,如果向某类型的变量赋一个不同类型的值,就会出错。例如,glPointSize是浮点型的变量,你就必须向其赋浮点型的值。

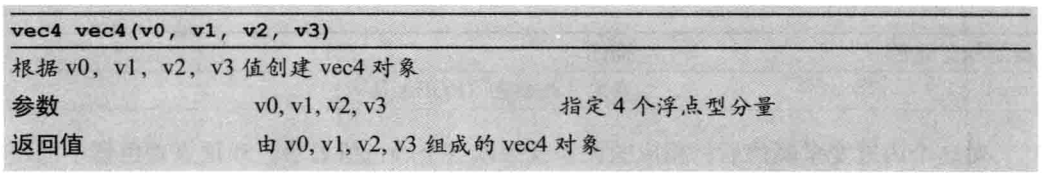

另一个内置变量gl_Position表示点的位置,其类型为vec4;vec4是由4个浮点数组成的矢量。但是,我们这里只有三个浮点数(0.0,0.0,0.0),即X,Y和Z坐标值,需要用某种方法将其转化为vec4类型的变量。好在着色器提供了内置函数vec4()帮助你创建vec4类型的变量

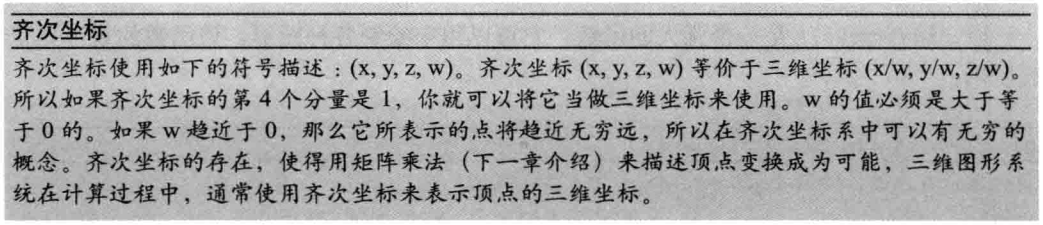

注意,赋给gl_Position的矢量中,我们添加了1.0作为第4个分量。由4个分量组成的矢量被称为齐次坐标(参阅下方表格中的文字),因为它能够提高处理三维数据的效率,所以在三维图形系统中被大量使用。虽然齐次坐标是四维的,但是如果真最后一个分量是 1.0,那么这个齐次坐标就可以表示“前三个分量为坐标值”的那个点。所以,当你需要用齐次坐标表示顶点坐标的时候,只要将最后一个分量赋为 1.0 就可以了。

片元着色器

顶点着色器控制点的位置和大小,片元着色器控制点的颜色。如前所述,片元就是显示在屏幕上的一个像素(严格意义上来说,片元包括这个像素的位置、颜色和其他信息)。

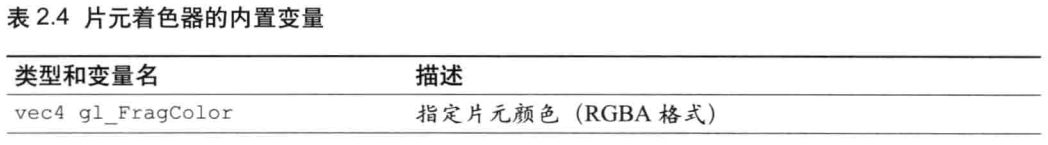

片元着色器将点的颜色赋值给 gl_FragColor 变量,该变量是片元着色器唯一的内置变量,它控制着像素在屏幕上的最终颜色,如表2.4所示。

对这个内置变量赋值后,相应的像素就会以这个颜色值显示。和顶点着色器中的顶点位置一样,颜色值也是vec4类型的,包括四个浮点型分量,分别代表RGBA值。本例我们赋的颜色值为(1.0,0.0,0.0,1.0),所以点是红色的。

绘制操作

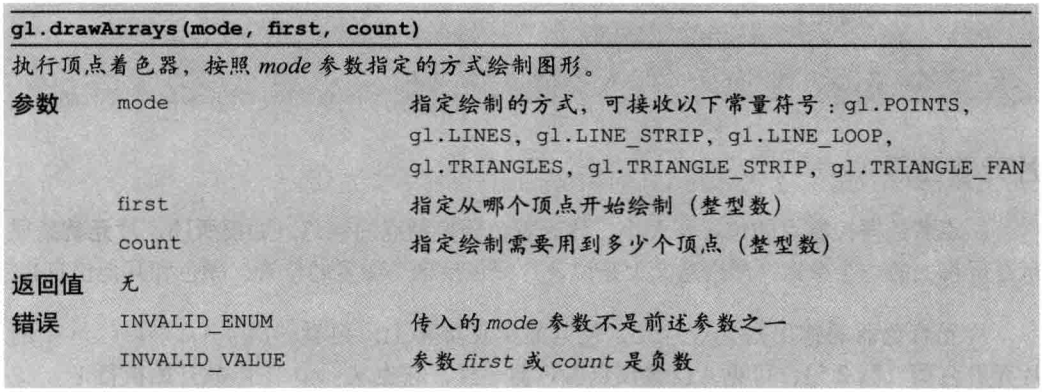

建立了着色器之后,我们就需要进行绘制操作,在这个例子中,就是画一个点。首先需要清空绘制区域。然后,我们使用gl.drawArrays()来进行绘制;

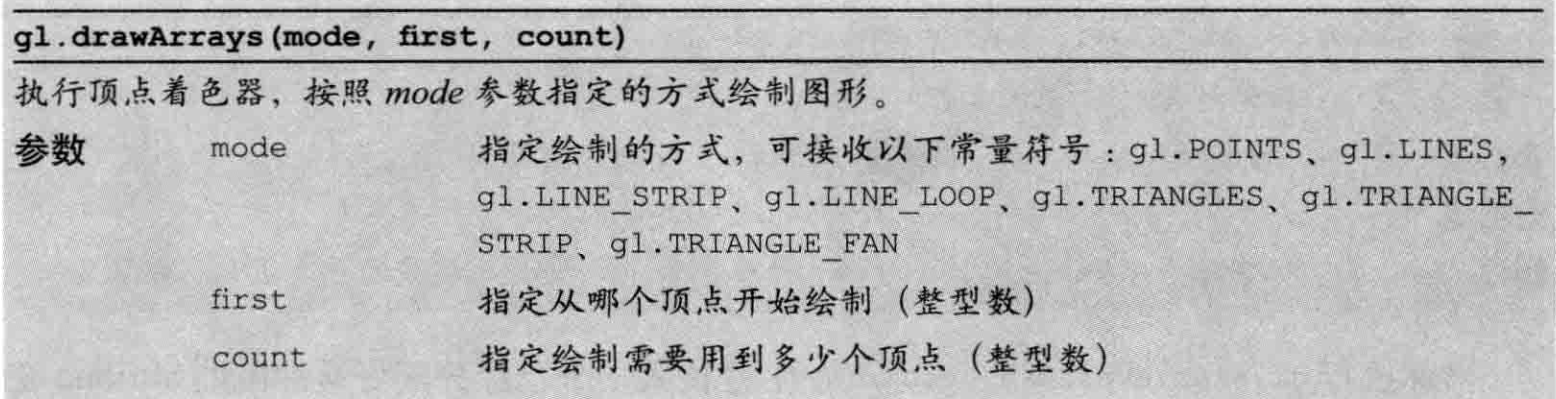

gl.drawArrays()是一个强大的函数,它可以用来绘制各种图形,该函数的规范如下表所示。

当程序调用gl.drawArrays()时,顶点着色器将被执行 count 次,每次处理一个顶点。在这个示例程序中,着色器只执行一次(count被设置为1),我们只绘制一个点。在着色器执行的时候,将调用并逐行执行内部的 main () 函数,将值 (0.0, 0.0, 0.0, 1.0) 赋给gl_Position ,将值 10.0 赋给 gl_Pointsize 。

一旦顶点着色器执行完后,片元着色器就会开始执行,调用main()函数,将颜色值(红色)赋给gl_FragColor。最后,一个红色的10个像素大的点就被绘制在了(0.00.0001.0)处,也就是绘制区域的中心位置。

WebGL坐标系统

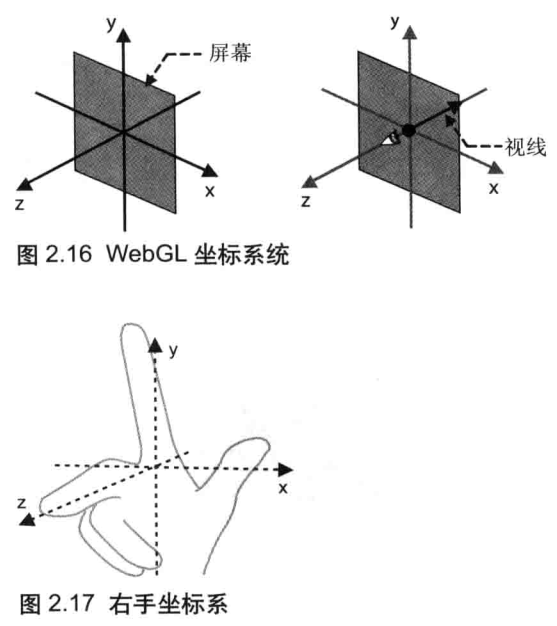

由于WebGL处理的是三维图形,所以它使用三维坐标系统(笛卡尔坐标系),具有X轴、Y轴和Z轴。一维坐标系统很容易理解,因为我们的世界也是三维的:具有宽度高度和长度。在任何坐标系统中,轴的方向都非常重要。通常,在 WebGL 中,当你面向计算机屏幕时,X轴是水平的(正方向为右),Y轴是垂直的(正方向为下),而Z轴垂直于屏幕(正方向为外),如图2.16左所示。观察者的眼睛位于原点(0.0.0.0.0.0)处,视线则是沿着Z轴的负方向,从你指向屏幕(图2.16右)。这套坐标系又被称为右手坐标系(right-handed coordinate system),因为可以用右手来表示,如图2.17所示。默认情况下WebGL 使用右手坐标系,右手坐标系也会贯穿本书始终。然而,事实远远比这复杂。实际上,WebGL 本身既不是右手坐标系,又不是左手坐标系的。附录D“WebGL/OpenGL:左手坐标系还是右手坐标系?”详细地阐述了这一点。现在,你认为WebGL是右手坐标系的也完全没有关系。

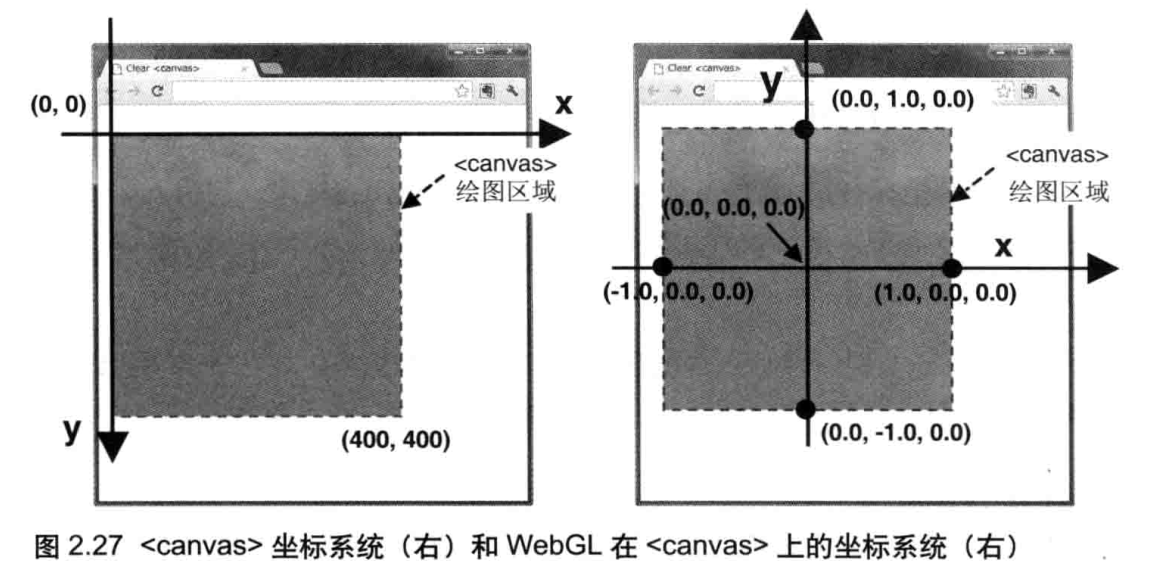

cavas坐标系:横轴为x轴 (正方向朝右),纵轴为y轴 (正方向朝下)。原点落在左上方。

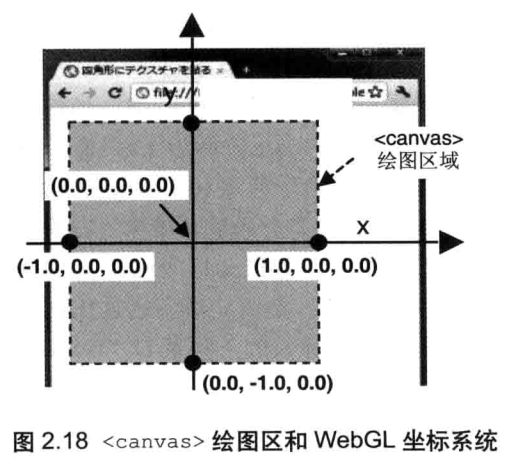

如图所示,WebGL 的坐标系和 canvas 绘图区的坐标系不同,需要将前者映射到后者。默认情况下,如图2.18所示,WebGL坐标与 canvas坐标的对应关系如下。

- canvas 的中心点:对应WebGL坐标(0.0,0.0,0.0)

- canvas 的上边缘和下边缘:对应WebGL坐标(-1.0,0.0,0.0)和(1.0,0.0,0.0)

- canvas 的左边缘和右边缘:对应WebGL坐标(0.0,-1.0,0.0)和(0.0,1.0,0.0)

绘制一个点(版本2)

这一节将讨论如何在 JavaScript 和着色器之间传输数据,因为点的位置是直接编写 (“硬编码”)在顶点着色器中的;

在这一节中你将看到,WebGL程序可以将顶点的位置坐标从 JavaScript 传到着色器程序中,然后在对应位置上将点绘制出来。

// HelloPint2.js (c) 2012 matsuda

// Vertex shader program

var VSHADER_SOURCE =

'attribute vec4 a_Position;\n' + // attribute variable

'void main() {\n' +

' gl_Position = a_Position;\n' +

' gl_PointSize = 10.0;\n' +

'}\n';

// Fragment shader program

var FSHADER_SOURCE =

'void main() {\n' +

' gl_FragColor = vec4(1.0, 0.0, 0.0, 1.0);\n' +

'}\n';

function main() {

// Retrieve <canvas> element

var canvas = document.getElementById('webgl');

// Get the rendering context for WebGL

var gl = getWebGLContext(canvas);

if (!gl) {

console.log('Failed to get the rendering context for WebGL');

return;

}

// Initialize shaders

if (!initShaders(gl, VSHADER_SOURCE, FSHADER_SOURCE)) {

console.log('Failed to intialize shaders.');

return;

}

// 在着色器程序(program)中获取指定名称的顶点着色器变量地址,估计是数组地址

var a_Position = gl.getAttribLocation(gl.program, 'a_Position');

if (a_Position < 0) {

console.log('Failed to get the storage location of a_Position');

return;

}

// 把顶点位置传给attribute变量。1f表示1个浮点数,如此类推

gl.vertexAttrib3f(a_Position, 0.0, 0.0, 0.0);

// Specify the color for clearing <canvas>

gl.clearColor(0.0, 0.0, 0.0, 1.0);

// Clear <canvas>

gl.clear(gl.COLOR_BUFFER_BIT);

// Draw

gl.drawArrays(gl.POINTS, 0, 1);

}

使用attribute 变量

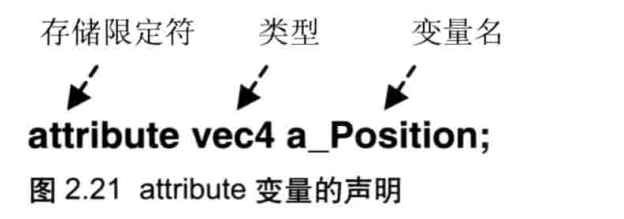

我们的目标是,将位置信息从 JavaScript 程序中传给顶点着色器。有两种方式可以做到这点 :attribute 变量和 uniform 变量,如图 2.20 所示。使用哪一个变量取决于需传输的数据本身,attribute 变量传输的是那些与顶点相关的数据,而 uniform 变量传输的是那些对于所有顶点都相同 (或与顶点无关)的数据。本例将使用 attribute 变量来传输顶点坐标,显然不同的顶点通常具有不同的坐标.

attribute 变量是一种 GLSL ES 变量,顶点着色器能使用它被用来从外部向顶点着色器内传输数据,只有顶点着色器能使用它。

为了使用 attribute 变量,示例程序需要包含以下步骤

- 在顶点着色器中,声明 attribute 变量;

- 将 attribute 变量赋值给 gl_Position 变量;

- 向 attribute 变量传输数据

'attribute vec4 a_Position;\n'

在这一行中,关键词 attribute 被称为存储限定符(storage qualifer),它表示接下来的变量(在这个例子中是 a Position)个 attribute 变量。attribute 变量必须声明成全局变量,数据将从着色器外部传给该变量。变量的声明必须按照以下的格式:

< 存储限定符><类型><变量名 >,如图 2.21 所示

attribue 变量a_position (第4行)的类型是 vec4,如表 2.2 所示。它将被赋值给gl Position,后者的类型也是 vec4。

一旦声明 a_Position 之后,我们将其赋值给 gl_Position :

' gl_Position = a_Position;\n'

这样就完成了着色器部分,它已经准备好从外部接收顶点坐标了。接下来,我们需要将数据从 JavaScript 中传给着色器的 attribute 变量。

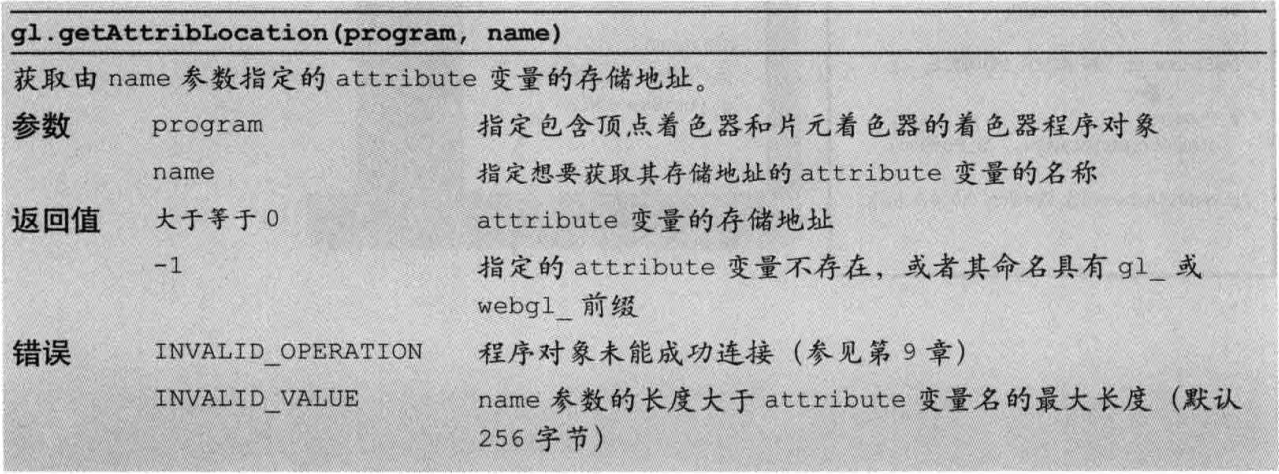

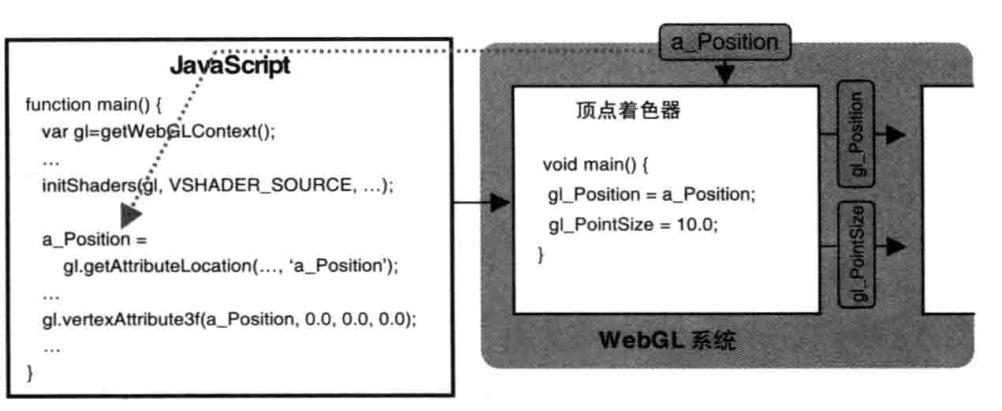

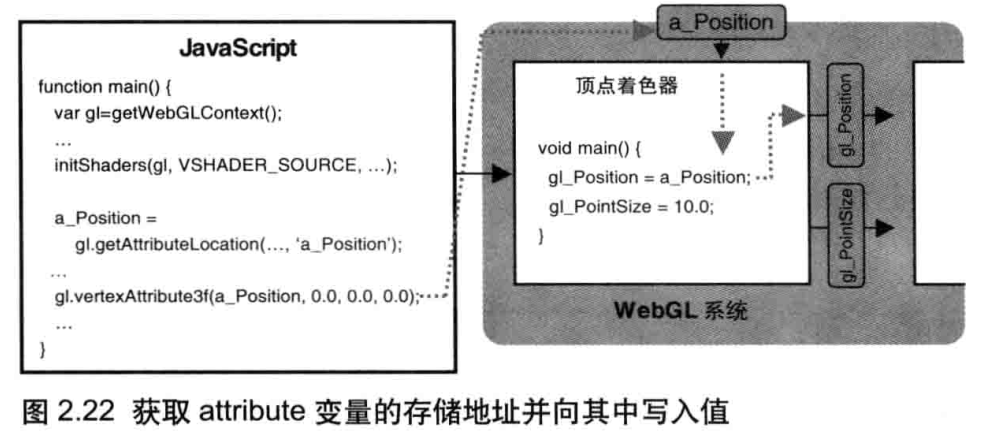

获取attribute 变量的存储位置

如前所述,我们使用辅助函数 initShaders() 在 WebGL 系统中建立了顶点着色器然后,WebGL 就会对着色器进行解析,辨识出着色器具有的 attribute 变量,每个变量都具有一个存储地址,以便通过存储地址向变量传输数据。比如,当你想要向顶点着色器的 a_Position 变量传输数据时,首先需要向 WebGL 系统请求该变量的存储地址。我们使用 gl.getAttribLocation() 来获取 attribute 变量的地址。

var a_Position = gl.getAttribLocation(gl.program, 'a_Position');

方法的第一个参数是一个程序对象(program object),它包括了顶点着色器和片元着色器,注意你必须在调用 initShader() 之后再访问 gl.program,因为是 initShader()函数创建了这个程序对象。第二个参数是想要获取存储地址的 attribute 变量的名称。

方法的返回值是 attribute 变量的存储地址。

向attribute 变量赋值

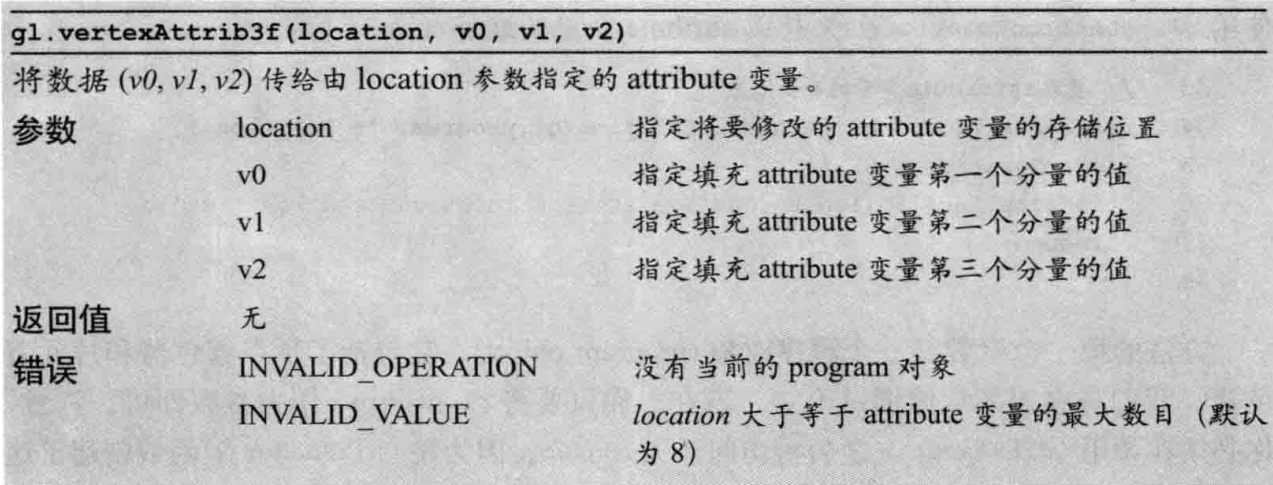

一旦将 attribute 变量的存储地址保存在JavaScript 变量a_Position 中,下面就需要使用该变量来向着色器传人值。我们使用 gl.vertexAttrib3f() 函数来完成这一步。

gl.vertexAttrib3f(a_Position, 0.0, 0.0, 0.0);

该函数的第1个参数是 attribute 变量的存储地址,即 gl.getAttribLocation() 的返回值 ;第2、3、4个参数是三个浮点型数值,即点的x、y和z坐标值。函数被调用后,这三个值被一起传给顶点着色器中的 a_Position 变量。图2.22 显示了获取 attribute 变量的存储地址并向其传值的过程.

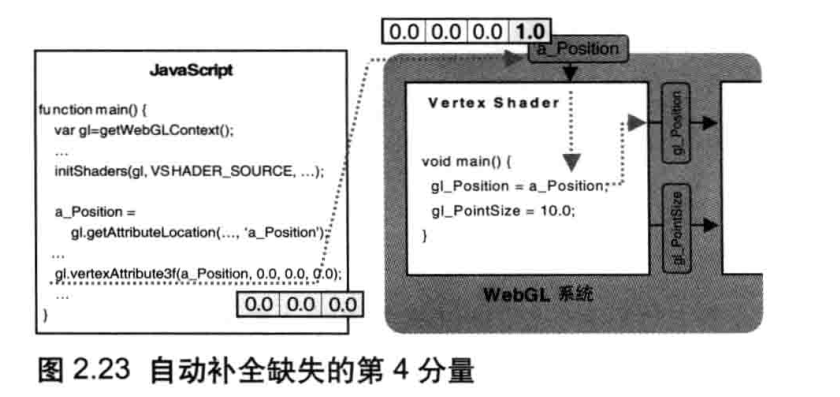

你可能已经注意到, a_Position 变量是 vec4 类型的,但是 gl.vertexAttrib3f() 仅传了三个分量值(x、y和z)而不是4个;实际上,如果你省略了第 4 个参数,这个方法就会默认地将第 4个分量设置为了 1.0,如图 2.23 所示。颜色值的第 4 个分量为 1.0 表示该颜色完全不透明,而齐次坐标的第 4个分量为 1.0 使齐次坐标与三维坐标对应起来,所以 1.0 是一个“安全”的第 4分量。

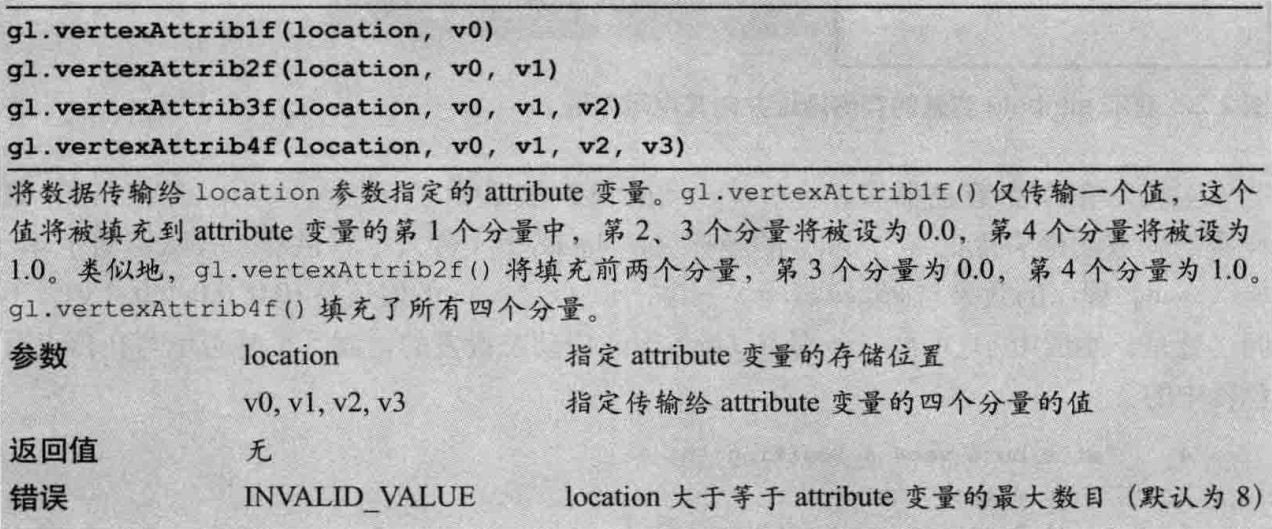

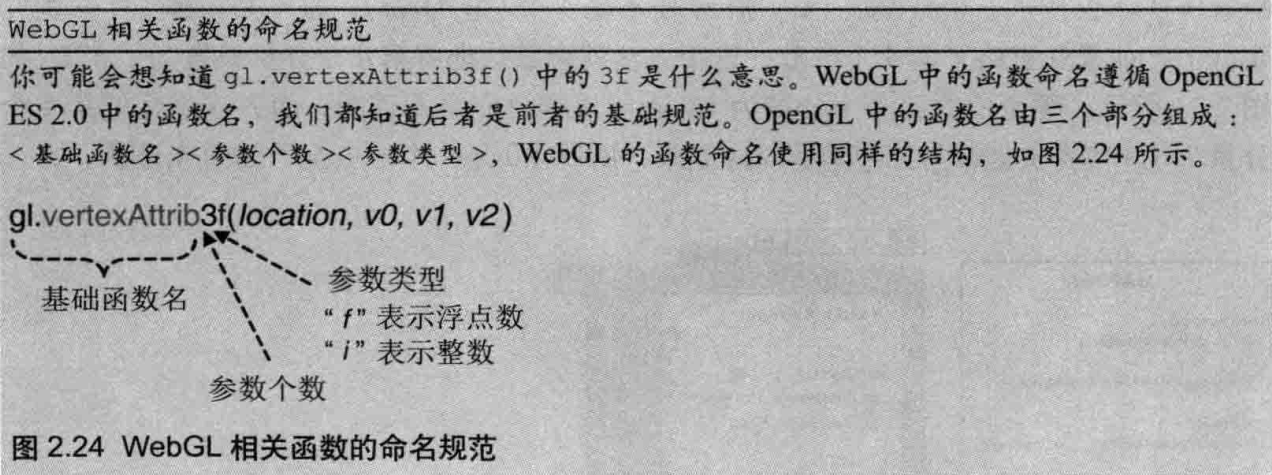

gl.vertexAttrib3f() 的同族函数

gl.vertexAttrib3f() 是一系列同族函数中的一个, 该系列函数的任务就是从 javascript 向顶点着色器中的 attribute 变量传值。 gl.vertexAttriblf() 传输 1个单精度值 (v0),gl.vertexAttrib2f() 传输2 个值 (v0和vl),而gl.vertexAttrib4f() 传输 4个值 (v0、v1、v2和v3)。

你也可以使用这些方法的矢量版本,它们的名字以“v”(vector) 结尾,并接受类型化数组 (见第 4 章)作为参数,函数名中的数字表示数组中的元素个数(实际上这里数字 4 的真正含义是 attribute 矢量中的元素个数(即多少个元素表示为一个矢量),并不是数组的元素个数,但这里我们只绘制一个顶点,所以二者相等。)。比如:

var position = new Float32Array([1.0,2.0,3.0,1.0]);

gl.vertexAttrib4fv(a_Position,position)

通过鼠标点击绘点

这一节,拓展 JavaScript 传输数据到顶点着色器的能力:在鼠标点击的位置上绘制出点来。

// ClickedPints.js (c) 2012 matsuda

// Vertex shader program

var VSHADER_SOURCE =

'attribute vec4 a_Position;\n' +

'void main() {\n' +

' gl_Position = a_Position;\n' +

' gl_PointSize = 10.0;\n' +

'}\n'

// Fragment shader program

var FSHADER_SOURCE =

'void main() {\n' + ' gl_FragColor = vec4(1.0, 0.0, 0.0, 1.0);\n' + '}\n'

function main() {

// Retrieve <canvas> element

var canvas = document.getElementById('webgl')

// Get the rendering context for WebGL

var gl = getWebGLContext(canvas)

if (!gl) {

console.log('Failed to get the rendering context for WebGL')

return

}

// Initialize shaders

if (!initShaders(gl, VSHADER_SOURCE, FSHADER_SOURCE)) {

console.log('Failed to intialize shaders.')

return

}

// // Get the storage location of a_Position

var a_Position = gl.getAttribLocation(gl.program, 'a_Position')

if (a_Position < 0) {

console.log('Failed to get the storage location of a_Position')

return

}

// Register function (event handler) to be called on a mouse press

canvas.onmousedown = function (ev) {

click(ev, gl, canvas, a_Position)

}

// Specify the color for clearing <canvas>

gl.clearColor(0.0, 0.0, 0.0, 1.0)

// Clear <canvas>

gl.clear(gl.COLOR_BUFFER_BIT)

}

var g_points = [] // The array for the position of a mouse press

function click(ev, gl, canvas, a_Position) {

var x = ev.clientX // 鼠标相对于屏幕的水平坐标

var y = ev.clientY // 鼠标相对于屏幕的垂直坐标

var rect = ev.target.getBoundingClientRect() // canvas对象的位置信息

// (x - rect.left):鼠标在x轴方向上的偏移,相当于canvas的x轴坐标

x = (x - rect.left - canvas.width / 2) / (canvas.width / 2)

// (y - rect.top):鼠标在y轴方向上的偏移,相当于canvas的y轴坐标

y = (canvas.height / 2 - (y - rect.top)) / (canvas.height / 2)

// 将坐标存储在 g_points 数组中

g_points.push(x)

g_points.push(y)

// Clear <canvas>

gl.clear(gl.COLOR_BUFFER_BIT);

var len = g_points.length

for (var i = 0; i < len; i += 2) {

// Pass the position of a point to a_Position variable

gl.vertexAttrib3f(a_Position, g_points[i], g_points[i + 1], 0.0)

// Draw

gl.drawArrays(gl.POINTS, 0, 1)

}

}

响应鼠标点击事件

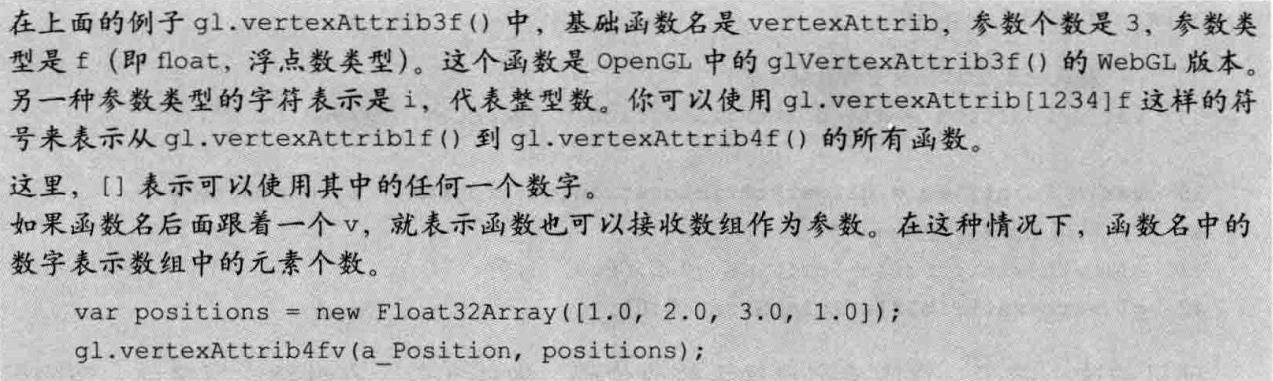

关于点击坐标

鼠标点击位置的信息存储在事件对象 ev 中,该对象传给了 click()函数,可以通过访问 ev.clientx和 ev.clientY 来获取位置坐标。但是,由于以下两点原因,我们不能直接使用这两个坐标值 :

- 鼠标点击位置坐标是在“浏览器客户区”(client area) 中的坐标,而不是在<canvas>中的(如图 2.26 所示)

- <canvas> 的坐标系统与 WebGL 的坐标系统 (如图 2.27 所示),其原点位置和 Y轴的正方向都不一样。

你需要将坐标从浏览器客户区坐标系下转换到<canvas>坐标系下,然后再转换到 WebGL 坐标系下。

- 首先,获取 <canvas>在浏览器客户区中的坐标,rect.left 和 rect.top是 <canvas>的原点在浏览器客户区中的坐标,如图2.26 所示,这样(x-rect.left)和(y-rect.top) 就可以将客户区坐标系下的坐标(xy)转换为<canvas>坐标系下的坐标了。

- 接下来,将<canvas>坐标系下的坐标转换到 WebGL 坐标系统中,如图 2.27 所示。为了进行这一步转换,你需要知道<canvas>的中心点。我们通过 canvas.height (这里是 400)和 canvas.width (也是 400)获取 <canvas>的宽度和高度,而中心点的坐标是(canvas .height/2, canvas .width/2)。然后,你就可以使用 ((x-rect.left)-canvas.width/2)和(canvas.height/2-(y-rect.top))将<canvas>的原点平移到中心点 (WebGL 坐标系统的原点位于此处)。

- 接着,如图 2.27 所示,<canvas>的x轴坐标区间为从0到 canvas.width (400),而其y轴区间为从0到 canvas.height(400)。因为 WebGL 中轴的坐标区间为从-1.0到1.0.所以最后一步我们将x坐标除以 canvas.width/2,将y坐标除以 canvas.height/2,将<canvas>坐标映射到 WebGL 坐标。

关于存储每次点击坐标

这里会把鼠标每次点击的位置都记录下来,而不是仅仅记录最近次鼠标点击的位置。

这是因为 WebGL 使用的是颜色缓冲区。系统中的绘制操作实际上是在颜色缓冲区中进行绘制的,绘制结束后系统将缓冲区中的内容显示在屏幕上,然后颜色缓冲区就会被重置,其中的内容会丢失 (这是默认操作下.一章将详细讨论)。因此,我们有必要将每次鼠标点击的位置都记录下来,鼠标每次点击之后,程序都重新绘制了(从第 1次点击到最近一次的)所有的点。比如,第1次点击鼠标,绘制第1个点;第2 次点击鼠标,绘制第1个和第 2个点;第3次点击鼠标绘制第 1、2 个和第 3 个点,以此类推。

改变点的颜色

构建一个更复杂的程序一一改变绘制点的颜色,而且点的颜色依赖于它在 <canvas>中的位置

// ColoredPoint.js (c) 2012 matsuda

// Vertex shader program

var VSHADER_SOURCE =

'attribute vec4 a_Position;\n' +

'void main() {\n' +

' gl_Position = a_Position;\n' +

' gl_PointSize = 10.0;\n' +

'}\n';

// Fragment shader program

var FSHADER_SOURCE =

'precision mediump float;\n' +

'uniform vec4 u_FragColor;\n' + // uniform変数

'void main() {\n' +

' gl_FragColor = u_FragColor;\n' +

'}\n';

function main() {

// Retrieve <canvas> element

var canvas = document.getElementById('webgl');

// Get the rendering context for WebGL

var gl = getWebGLContext(canvas);

if (!gl) {

console.log('Failed to get the rendering context for WebGL');

return;

}

// Initialize shaders

if (!initShaders(gl, VSHADER_SOURCE, FSHADER_SOURCE)) {

console.log('Failed to intialize shaders.');

return;

}

// // Get the storage location of a_Position

var a_Position = gl.getAttribLocation(gl.program, 'a_Position');

if (a_Position < 0) {

console.log('Failed to get the storage location of a_Position');

return;

}

// Get the storage location of u_FragColor

var u_FragColor = gl.getUniformLocation(gl.program, 'u_FragColor');

if (!u_FragColor) {

console.log('Failed to get the storage location of u_FragColor');

return;

}

// Register function (event handler) to be called on a mouse press

canvas.onmousedown = function(ev){ click(ev, gl, canvas, a_Position, u_FragColor) };

// Specify the color for clearing <canvas>

gl.clearColor(0.0, 0.0, 0.0, 1.0);

// Clear <canvas>

gl.clear(gl.COLOR_BUFFER_BIT);

}

var g_points = []; // The array for the position of a mouse press

var g_colors = []; // The array to store the color of a point

function click(ev, gl, canvas, a_Position, u_FragColor) {

var x = ev.clientX; // x coordinate of a mouse pointer

var y = ev.clientY; // y coordinate of a mouse pointer

var rect = ev.target.getBoundingClientRect();

x = ((x - rect.left) - canvas.width/2)/(canvas.width/2);

y = (canvas.height/2 - (y - rect.top))/(canvas.height/2);

// Store the coordinates to g_points array

g_points.push([x, y]);

// Store the coordinates to g_points array

if (x >= 0.0 && y >= 0.0) { // First quadrant

g_colors.push([1.0, 0.0, 0.0, 1.0]); // Red

} else if (x < 0.0 && y < 0.0) { // Third quadrant

g_colors.push([0.0, 1.0, 0.0, 1.0]); // Green

} else { // Others

g_colors.push([1.0, 1.0, 1.0, 1.0]); // White

}

// Clear <canvas>

gl.clear(gl.COLOR_BUFFER_BIT);

var len = g_points.length;

for(var i = 0; i < len; i++) {

var xy = g_points[i];

var rgba = g_colors[i];

// Pass the position of a point to a_Position variable

gl.vertexAttrib3f(a_Position, xy[0], xy[1], 0.0);

// Pass the color of a point to u_FragColor variable

gl.uniform4f(u_FragColor, rgba[0], rgba[1], rgba[2], rgba[3]);

// Draw

gl.drawArrays(gl.POINTS, 0, 1);

}

}

可以用 uniform 变量将颜色值传给着色器,其步骤与用 atrribute 变量传递的类似。不同的仅仅是,这次数据传输的目标是片元着色器,而非顶点着色器

在片元着色器中准备 uniform 变量。

用这个 uniform 变量向 gl FragColor 赋值。

将颜色数据从 JavaScript 传给该 uniform 变量。

uniform 变量

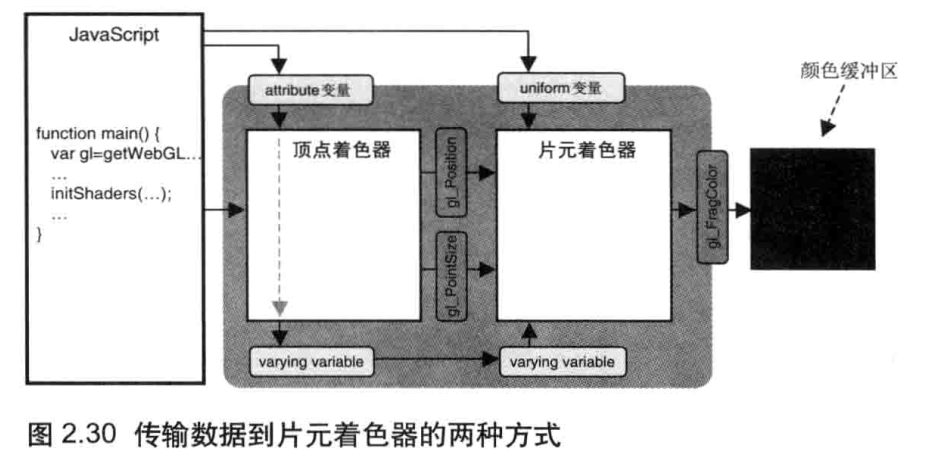

我们已经知道了如何从 JavaScript中向顶点着色器的 attribute变量传数据。不幸的是只有顶点着色器才能使用 attribute 变量,使用片元着色器时,你就需要使用 uniform 变量。或者,你可以使用 varying 变量,如图 2.30 底部所示。但是这比较复杂,我们在第 5章之前不会使用它。

之前介绍 attribute 变量的概念时曾经提到过,uniform变量用来从 JavaScript程序向顶点着色器和片元着色器传输“一致的”(不变的)数据。

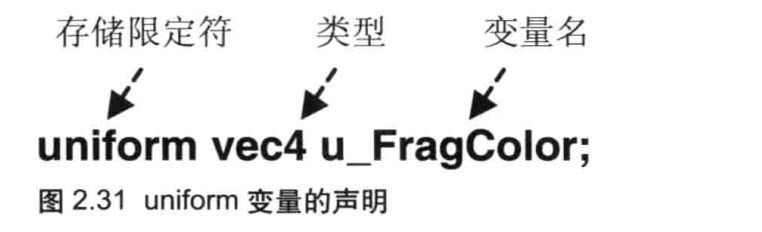

在使用 uniform 变量之前,首先需要按照与声明 attribute 变量相同的格式<存储限定符 >< 类型 >< 变量名 >(如图 2.3所示) 来声明 uniform 变量。

'precision mediump float;\n' +

'uniform vec4 u_FragColor;\n' + // uniform変数

注意:使用精度限定词(precision qualifier) 来指定变量的范围 (最大值与最小值)和精度,本例中为中等精度。第 5 章将会详细讨论精度的问题。

获取uniform 变量的存储地址

可以使用以下方法来获取uniform变量的存储地址

这个函数的功能和参数与 gl.getAttribLocation() 一样,但是如果 uniform变量不存在或者其命名使用了保留字前缀,那么函数的返回值将是 null 而不是 -1(gl.getAttribLocation() 在此情况下返回 -1)。因此,在获取 umiform 变量的存储地址后,你需要检查其是否为 null。

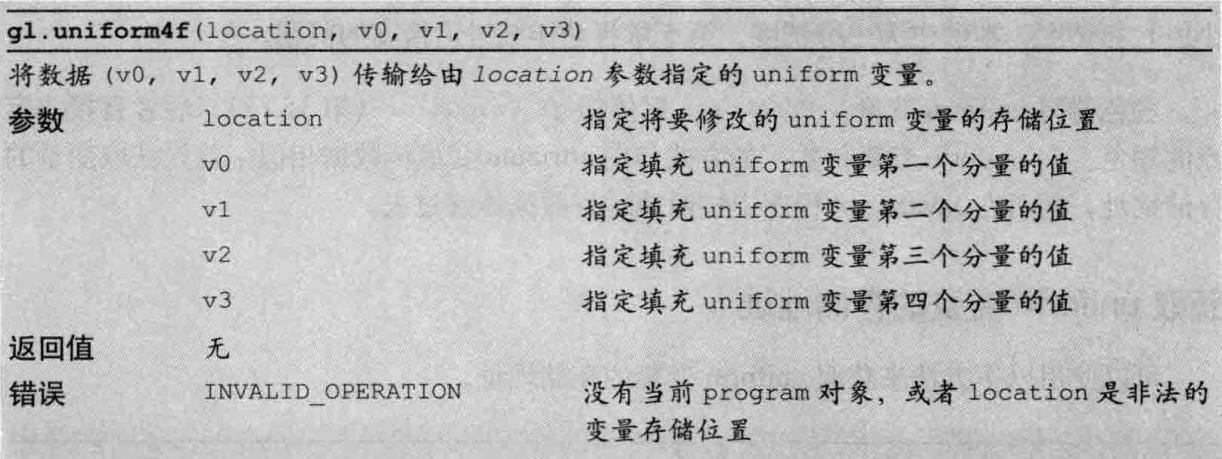

向uniform 变量赋值

有了 uniform变量的存储地址,就可以使用 WebGL 函数 gl.uniform4f()向变量中写入数据。该函数的功能和参数与 gl.vertexAttrib[1234]f() 很相似。

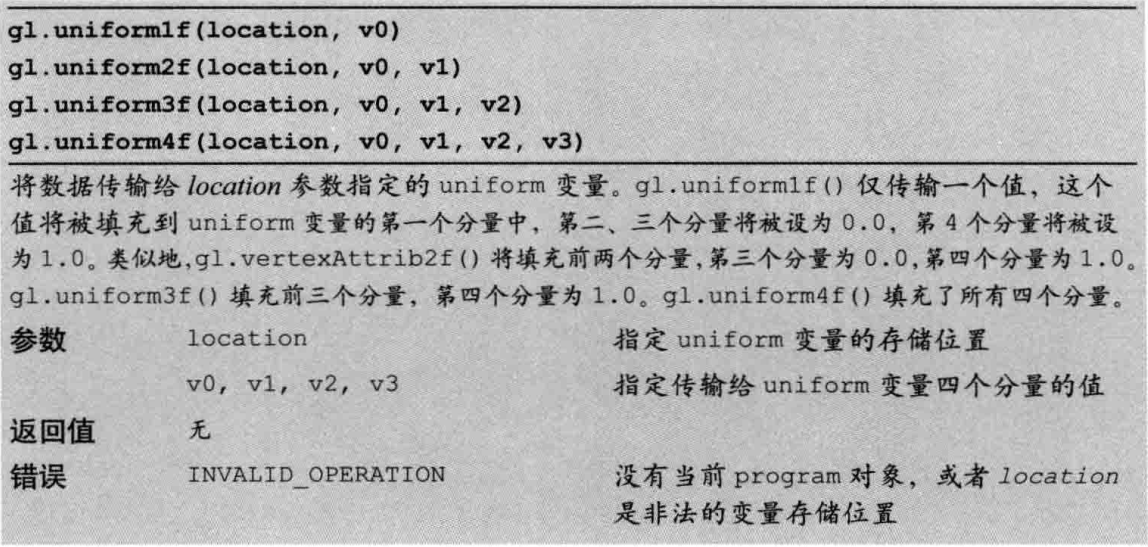

gl.uniform4f() 的同族函数

gl.uniform4f() 也有一系列同族函数。gl.uniform1f() 函数用来传输1个值(v0),gl.uniform2f() 传输2个值(v0和vl),gl.uniform3f()传输3个值 (v,vl和v2)。

绘制和变换三角形

绘制多个点

构成三维模型的基本单位是三角形,不管三维模型的形状多么复杂,其基本组成部分都是三角形,只不过复杂的模型由更多的三角形构成而已。通过创建更细小和更大量的三角形,就可以创建更复杂利口更逼真的三维模型。

前一章有一个示例程序ClickedPoints,它在鼠标点击的位置绘制点。Clicked-Points将所有点的坐标数据存储在一个JavaScript数组g_points[]中,然后使用了一个循环遍历该数组,每次遍历就向着色器传入一个点,并调用gldrawArrays()将这个点绘制出来。

显然,这种方法只能绘制一个点。对那些由多个顶点组成的图形,比如三角形、矩形和立方体来说,你需要一次性地将图形的顶点全音部传入顶点着色器,然后才能把图形画出来。

WebGL提供了一种很方便的机制,即缓冲区对象(buffer object),它可以一次性地向着色器传入多个顶点的数据。缓冲区对象是WebGL 系统中的一块内存区域,我们可以一次性地向缓冲区对象中填充大量的顶点数据,然后将这些数据保存在其中,供顶点着色器使用。

// MultiPoint.js (c) 2012 matsuda

// Vertex shader program

var VSHADER_SOURCE =

'attribute vec4 a_Position;\n' +

'void main() {\n' +

' gl_Position = a_Position;\n' +

' gl_PointSize = 10.0;\n' +

'}\n';

// Fragment shader program

var FSHADER_SOURCE =

'void main() {\n' +

' gl_FragColor = vec4(1.0, 0.0, 0.0, 1.0);\n' +

'}\n';

function main() {

// Retrieve <canvas> element

var canvas = document.getElementById('webgl');

// Get the rendering context for WebGL

var gl = getWebGLContext(canvas);

if (!gl) {

console.log('Failed to get the rendering context for WebGL');

return;

}

// Initialize shaders

if (!initShaders(gl, VSHADER_SOURCE, FSHADER_SOURCE)) {

console.log('Failed to intialize shaders.');

return;

}

// 设置顶点位置

var n = initVertexBuffers(gl);

if (n < 0) {

console.log('Failed to set the positions of the vertices');

return;

}

// Specify the color for clearing <canvas>

gl.clearColor(0, 0, 0, 1);

// Clear <canvas>

gl.clear(gl.COLOR_BUFFER_BIT);

// 绘制3个点

gl.drawArrays(gl.POINTS, 0, n);

}

function initVertexBuffers(gl) {

var vertices = new Float32Array([

0.0, 0.5, -0.5, -0.5, 0.5, -0.5

]);

var n = 3; // 点个数

// 创建缓冲区对象

var vertexBuffer = gl.createBuffer();

if (!vertexBuffer) {

console.log('Failed to create the buffer object');

return -1;

}

// 将缓冲区对象绑定到目标

gl.bindBuffer(gl.ARRAY_BUFFER, vertexBuffer);

// 向缓冲区对象写入数据

gl.bufferData(gl.ARRAY_BUFFER, vertices, gl.STATIC_DRAW);

var a_Position = gl.getAttribLocation(gl.program, 'a_Position');

if (a_Position < 0) {

console.log('Failed to get the storage location of a_Position');

return -1;

}

// 将缓冲区对象分配给a_Position变量

gl.vertexAttribPointer(a_Position, 2, gl.FLOAT, false, 0, 0);

// 连接a_Position变量与分配给它的缓冲区对象

gl.enableVertexAttribArray(a_Position);

return n;

}

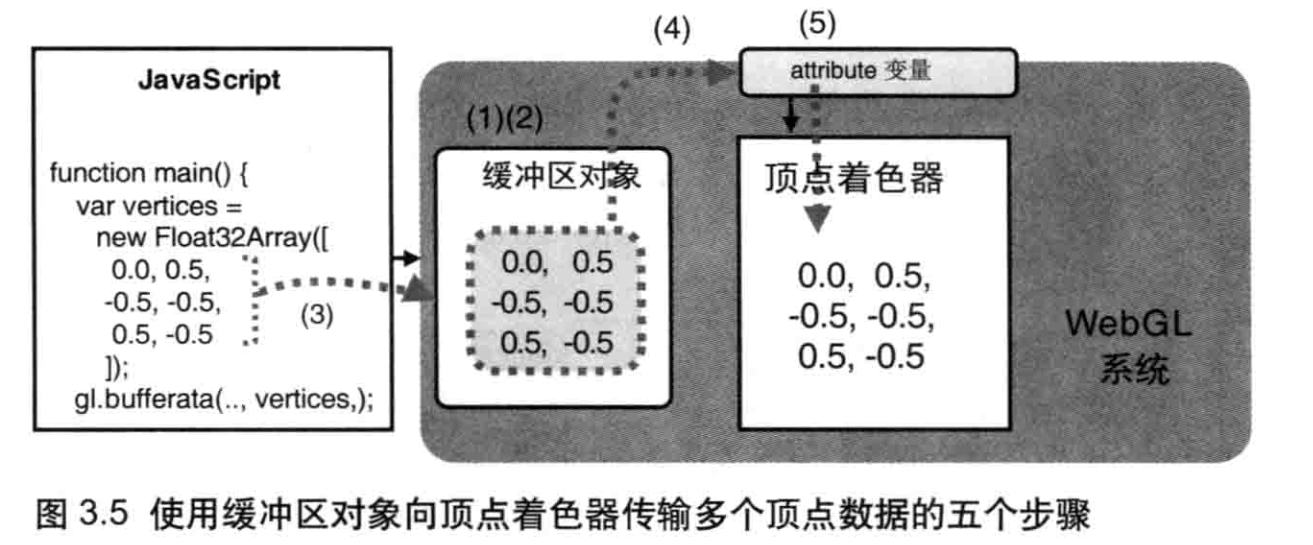

使用缓冲区对象

使用缓冲区对象向顶点着色器传入多个顶点的数据,需要遵循以下五个步骤。处理其他对象,如纹理对象(第4章),帧缓冲区对象(第8章“光照”)时的步骤也比较类似:

- 创建缓冲区对象(g1.createBuffer())。

- 绑定缓冲区对象(g1.bindBuffer())。

- 将数据写人缓冲区对象(g1.bufferData())。

- 将缓冲区对象分配给一个 attribute 变量( gl.vertexAttribPointer() )。

- 开启 attribute 变量( gl.enableVertexAttribArray() )。

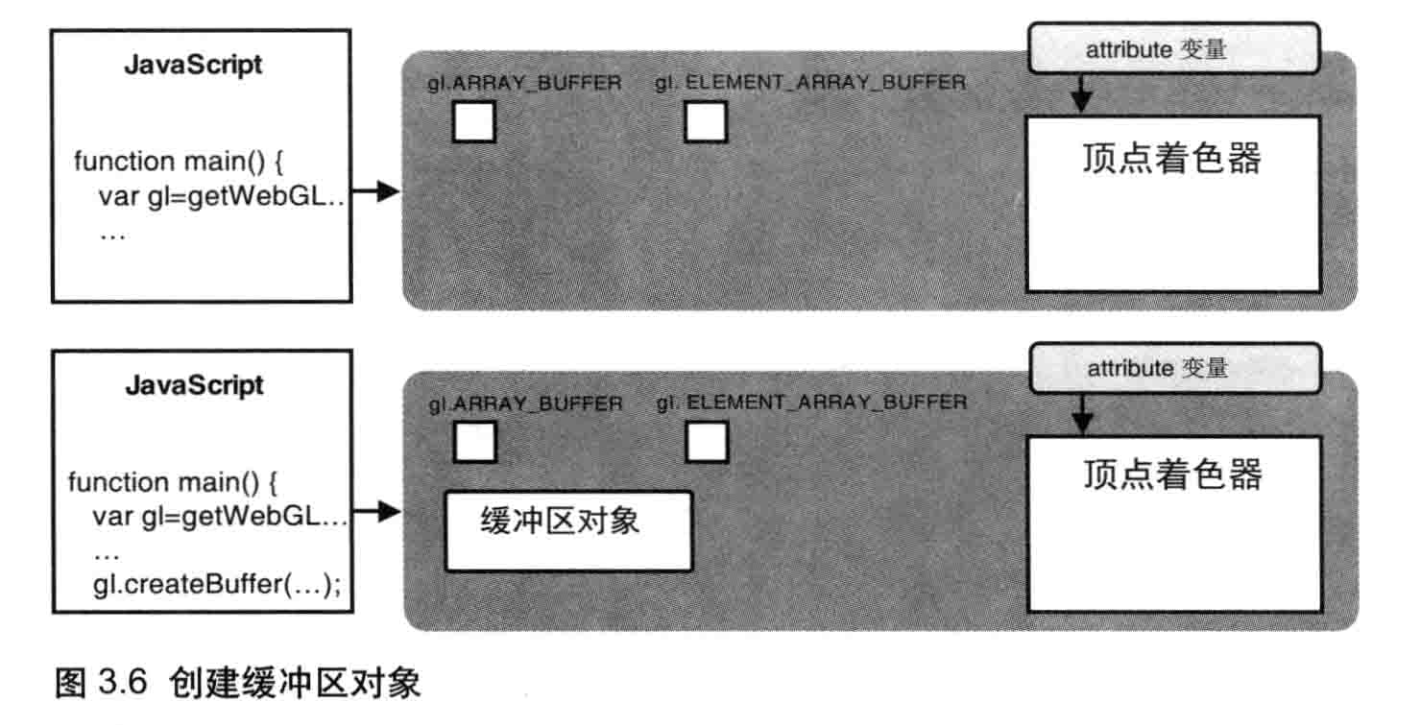

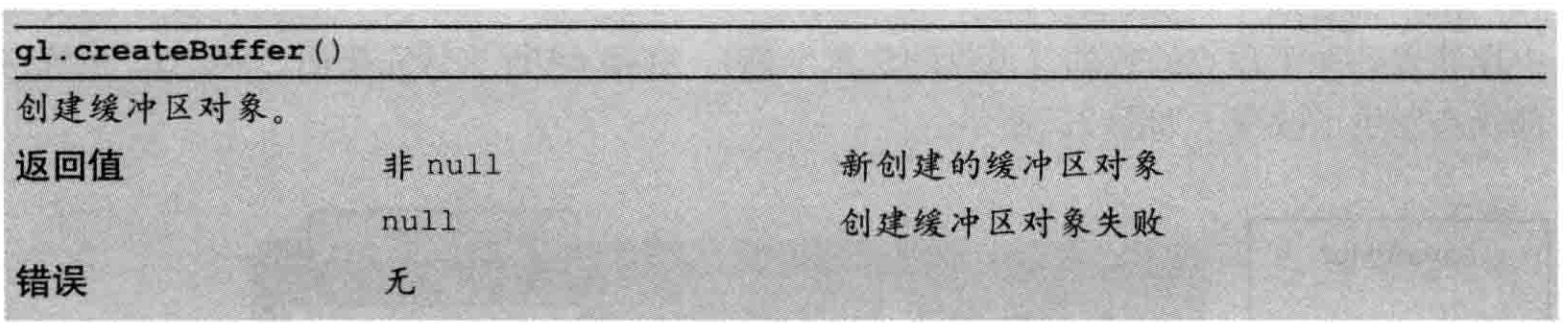

创建缓冲区对象(gl.createBuffer())

使用WebGL时,你需要调用glcreateBuffer()方法来创建缓冲区对象。图3.6示意了该方法执行前后WebGL系统的中间状态,上面一张图是执行前的状态,下面一张图是执行后的状态。执行该方法的结果就是,WebGL系统中多了一个新创建出来的缓冲区对象。

下面是glcreateBuffer()的函数规范。

相应地,gl.deleteBuffer( buffer )函数可月用来删除被 glcreateBuffer() 创建出来的缓冲区对象。

绑定缓冲区(gl.bindBuffer())

创建缓冲区之后的第2个步骤就是将缓冲区对象绑定到 WebGL 系统中已经存在的“目标”(target) 上。这这个“目标”表示缓冲区对象白的用途(在这里,就是向顶点着色器提供传给 attribute 变量的数据),这样 WebGL 才能够够正确处理其中的内容。

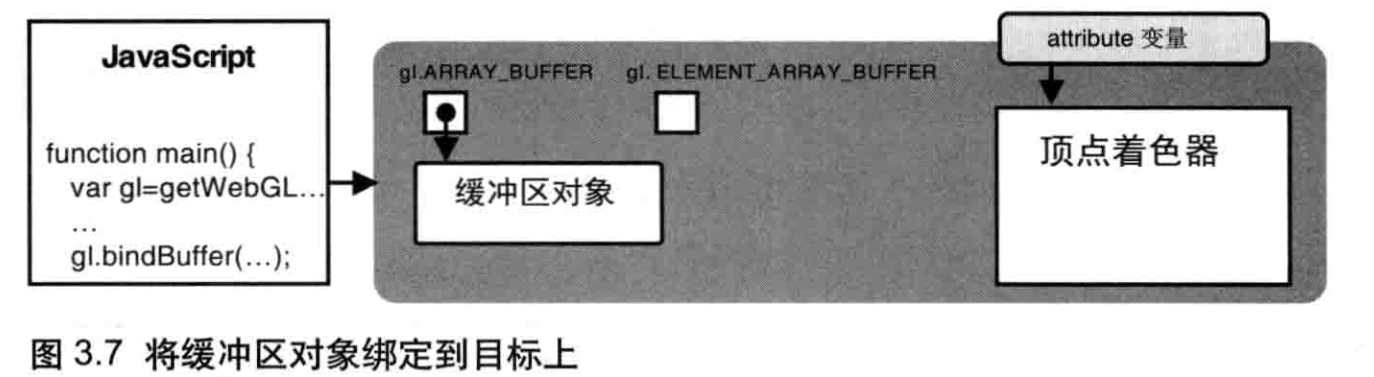

我们将缓冲区对象绑定到了gl.ARRAY_BUFFER目标上,缓冲区对象中存储着的关于顶点的数据(顶点的位置坐标)。绑定后,WebGL系统内部状态发生了改变,如图3.7所示。

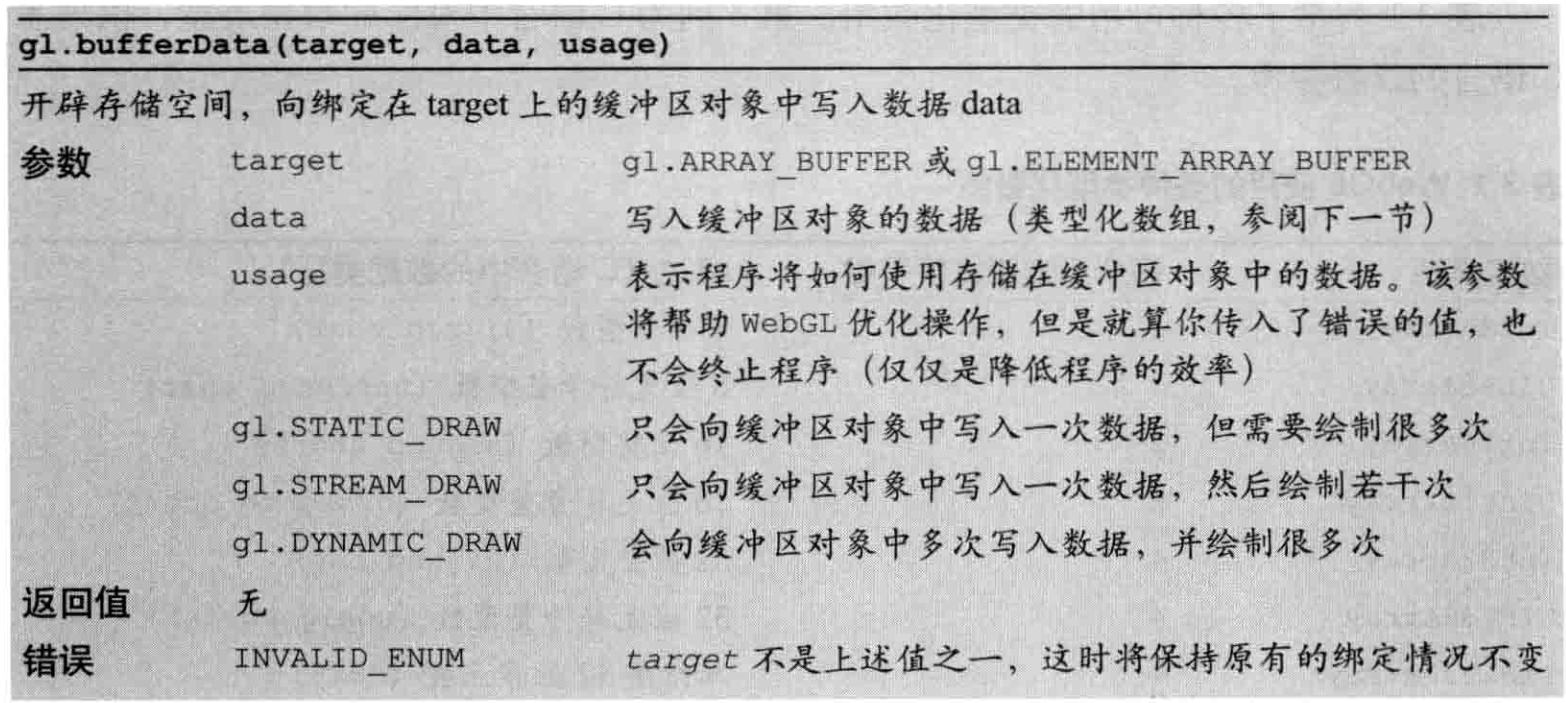

向缓冲区对象中写入数据( gl.bufferData() )

开辟空间并向缓冲区中写人数据。我们使用gl.bufferData()方法来完成这一步

该方法的效果是,将第2个参数vertices中的数据写入了绑定到第1个参数g1.ARRAY_BUFFER上的缓冲区对象。我们不能直接回缓冲区写人数据,而只能向“目标写入数据,所以要向缓冲区写数据,必须先绑定。该方法执行之后,WebGL系统的内部状态如图3.8所示。

现在我们来看看 gl.bufferData() 方法向缓冲中区中传入了什么数据。该方法使用了一个特殊的数组vertices将数据信专给顶点着色器。我们使用new运算符,并以<第一个顶点的x坐标和y坐标><第二个顶点的x坐标和y坐标>,等等的形式创建这个数组。

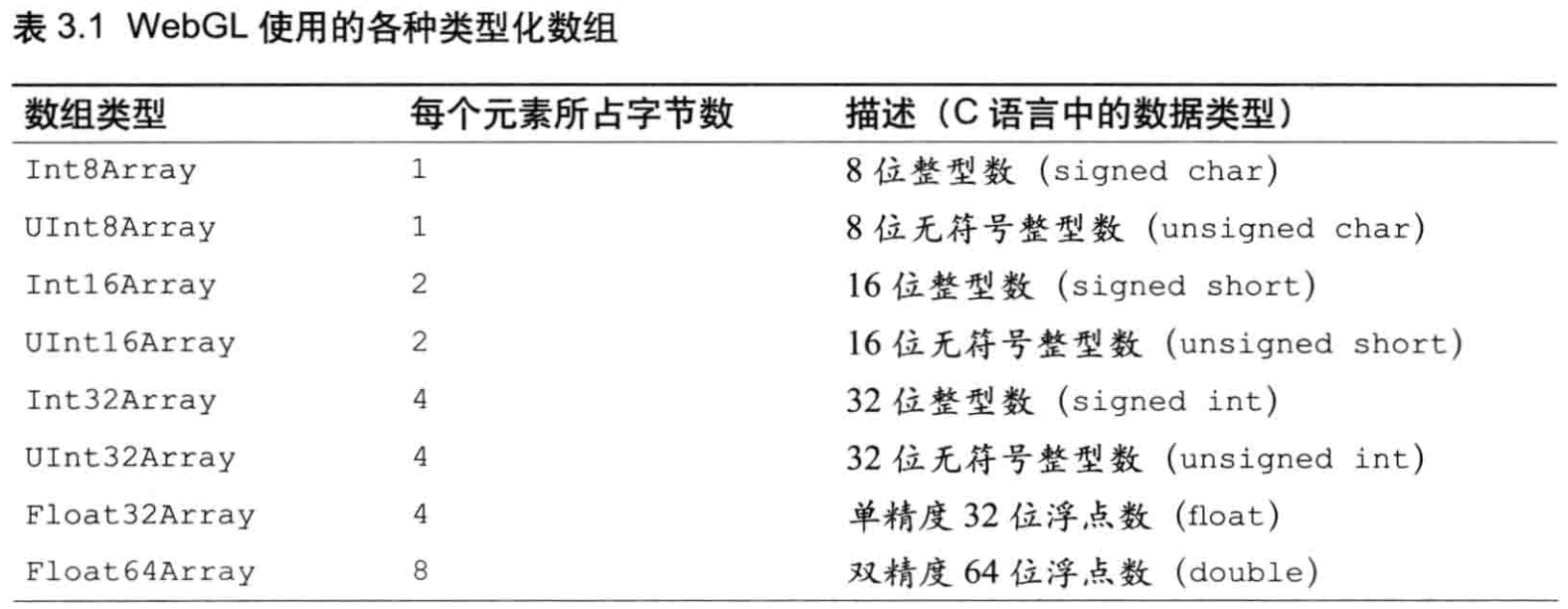

如你所见,我们使用了Float32Array对象,而不是JavaScript中更常见的Array对象。这是因为,JavaScript 中通用的数组 Array是一种通用的类型,既可以在里面存储数字也可以存储字符串,而并没有对“大量元素都是同一种类型”这种情况兄(比如vertices)进行优化。为了解决这个问题,WebGL引入了类型化数组,Float32Array就是其中之一。

类型化数组

为了绘制三维图形,WebGL通常需要同时处理大量相同类型的数据,例如顶点的坐标和颜色数据。为了优化性能,WebGL为每种基本数据类型引入了一种特殊的数组(类型化数组)。浏览器事先知道数组中的数据类型,所以处理起来也更加有效率。

例子中的Float32Array就是一种类型化数组组,通常用来存储顶点的坐标或颜色数据。应当牢记,WebGL中的很多操作都要用到类型化数组,比如gl.bufferData()中的第2个参数data。

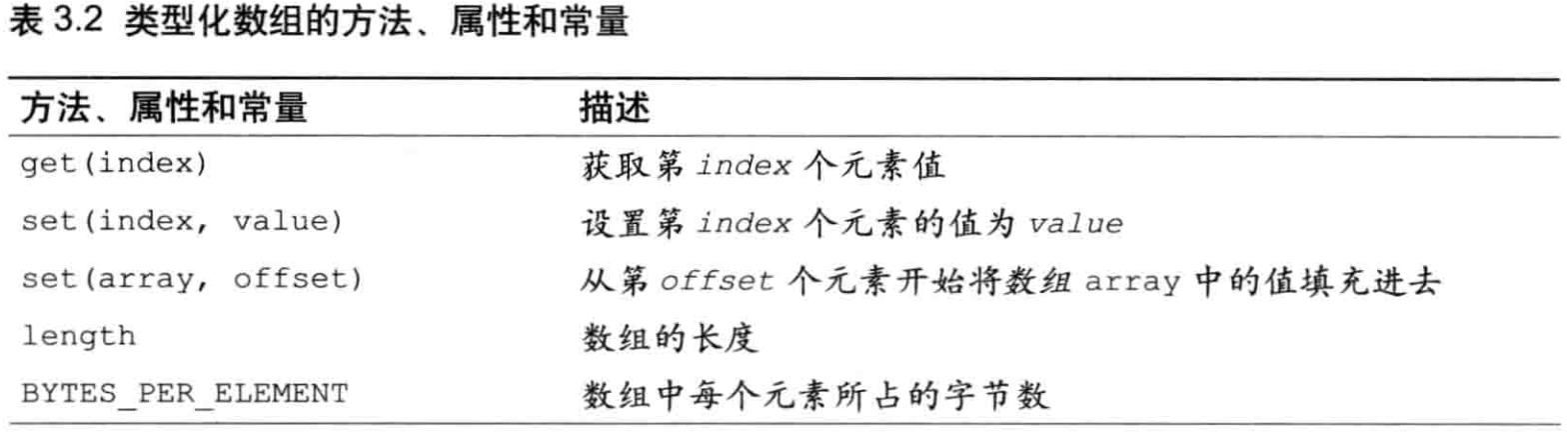

与JavaScript中的Array数组相似,类型化数组也有一系列方法和属性(包括一个常量属性),如表 3.2 所示。注意,与普通的 Array 数组不同,类型化数组不支持 push()和pop () 方法。

和普通的数组一样,类型化数组可以通过new运算符调用构造函数并传入数据而被创造出来。比如,为了创建Float32Array类型的顶点数据,你可以向构造函数中传入普通数组[0.0,0.5,-05,-0.5,0.5,-0.5],这个数组表示一些顶点的数据。注意,创建类型化数组的唯一方法就是使用 new 运算符,不能使用 [] 运算符(那样创建的就是普通数组)。

此外,你也可以通过指定数组元素的个数来创建一个空的类型化数组

var vertices = new Float32Array(4);

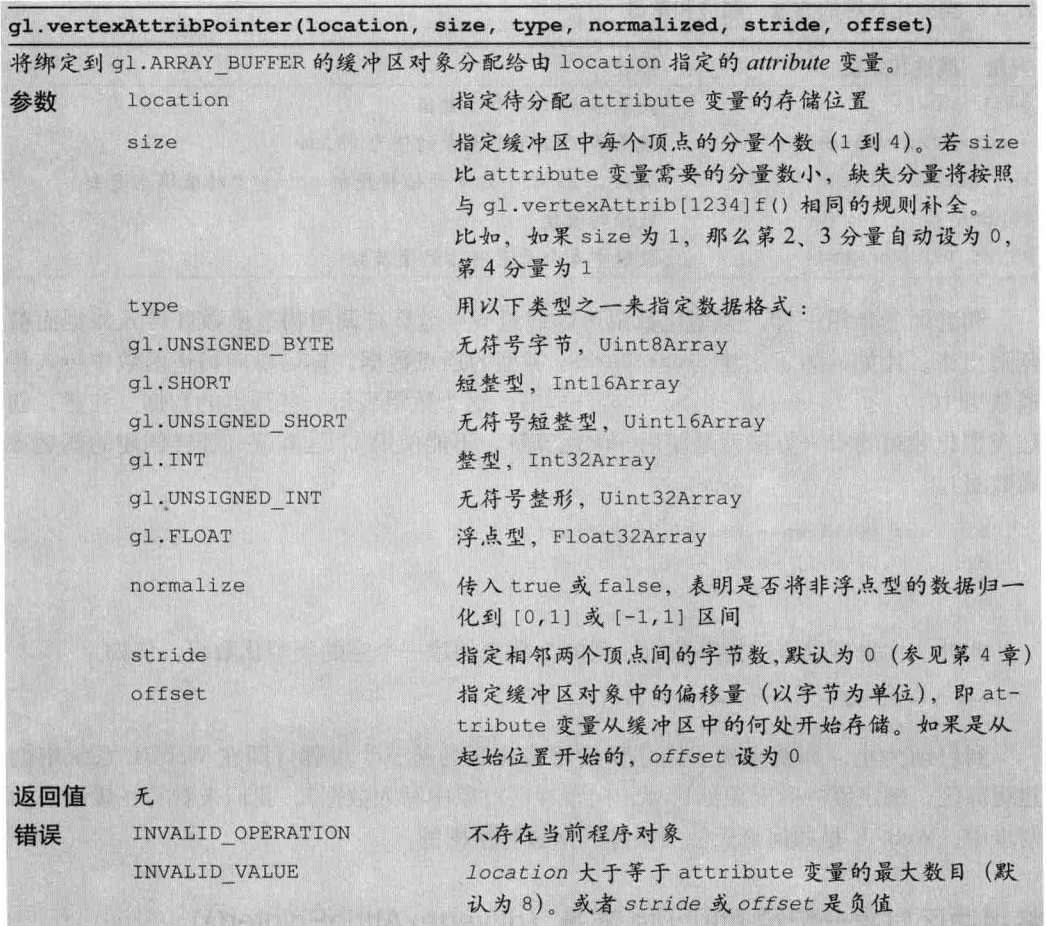

将缓冲区对象分配给attribute 变量(gl.vertexAttribPointer())

如第2章所述你可以使用 gl.vertexAttrib[1234]f系列函数为 attribute 变量分配值。但是,这些方法一次只能向 attribute 变量分配(传输)一个值。而现在,你需要将整个数组中的所有值-- 这里是顶点数据- - 一次性地分配给一个 attribute 变量。

gl.vertexAttribPointer()方法解决了这个问是题它可以将整个缓冲区对象(实际上是缓冲区对象的引用或指针)分配给 attribute 变量。示例程序将缓冲区对象分配给attribute 变量a_Position。

将整个缓冲区对象分配给了attribute变量,为WebGL绘图进行的准备工作就差最后一步了:进行最后的“开启”,使这次分配真正生效,如图 3.9 所示。

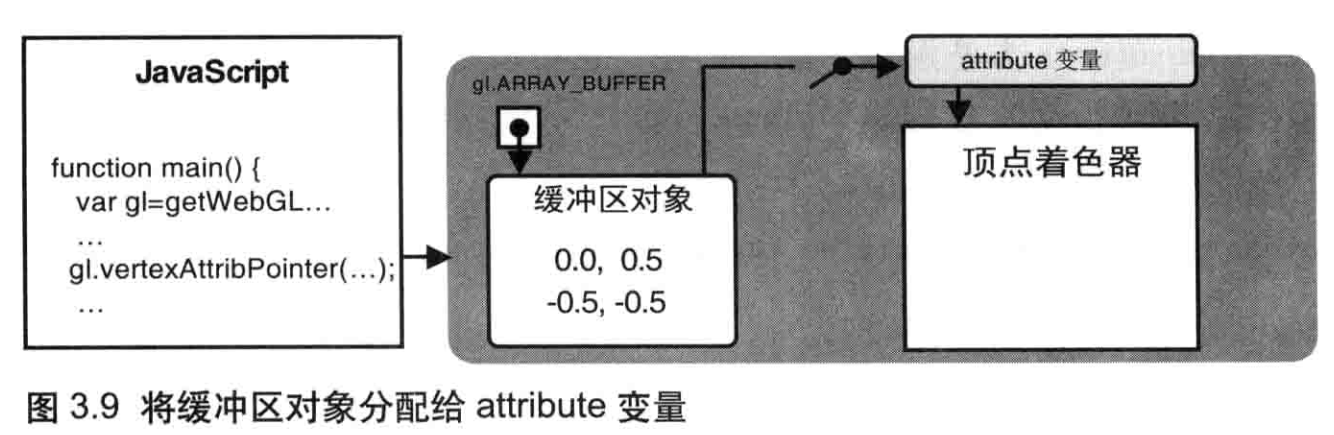

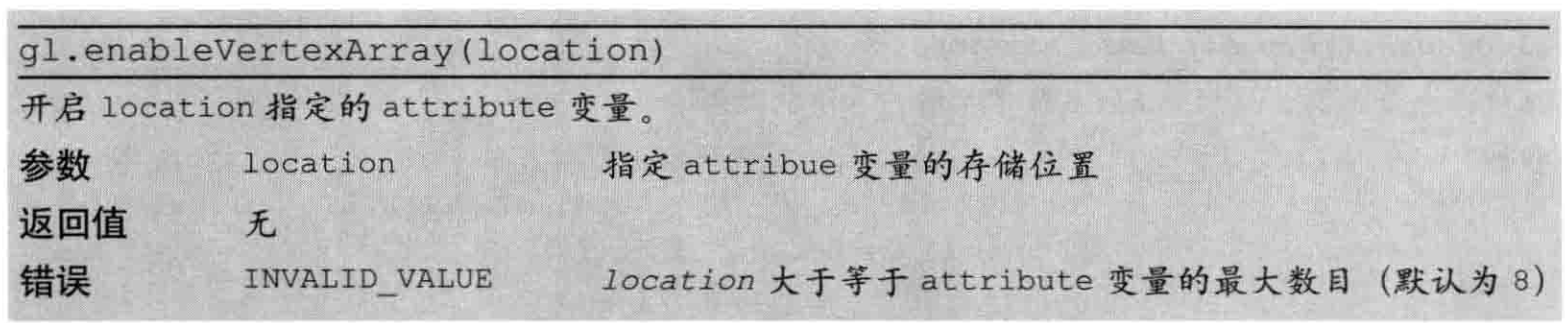

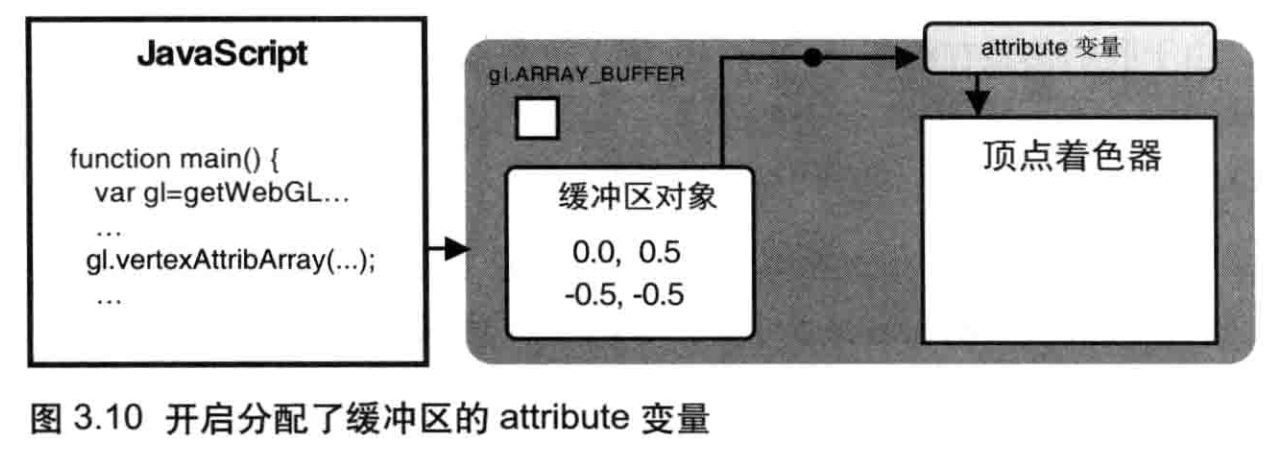

开启attribute 变量( gl.enableVertexAttribArray() )

为了使顶点着色器能够访问缓冲区内的数据,我们需要使用gl.enableVertexAttribArray()方法来开启attribute变量。

注意,虽然函数的名称似乎表示该函数是用来处理“顶点数组”的,但实际上它处理的对象是缓冲区。这是由于历史原因(从OpenGL中继承)造成的。

当你执行gl.enableVertexAttribArray() 并传人一个已经分配好缓冲区的 attribue 变量后,我们就开启了该变量,也就是说,缓冲区对象和 attribute 变量之间的连接就真正建立起来了,如图3.10所示。

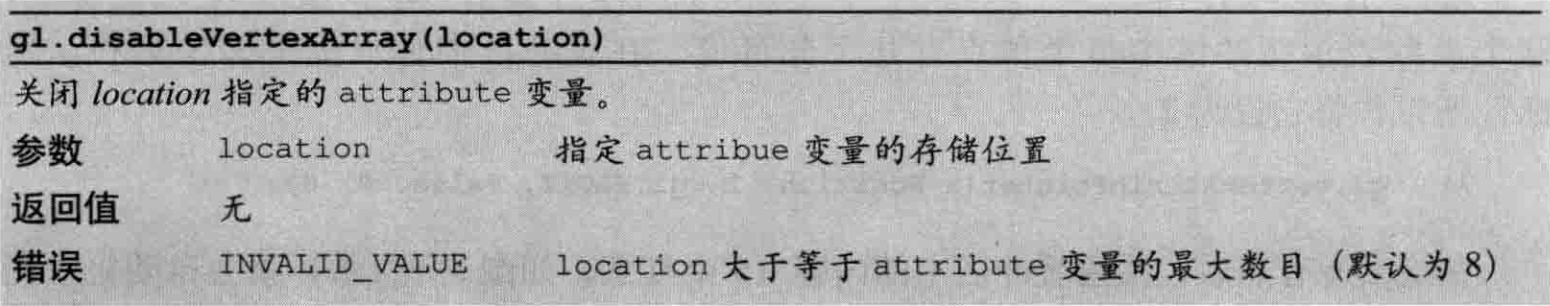

同样,你可以使用gl.disableVertexAttribArray()来关闭分配。

现在,你只需要让顶点着色器运行起来,它会自动将缓冲区中的顶点画出来。如第2章,你使用gl.drawArrays()方法去绘制了一个点,现在你要画多个点,所用的仍然是gldrawArrays()方法,但是用的是方法法中的第2个和第3个参数。

注意,开启 attribute 变量后,你就不能再用 g1.vertexAttrib[1234]f()向它传数据了,除非你显式地关闭该 attribute 变量。实际上,你无法(也不应该)同时使用这两个函数。

gl.drawArrays() 的第2 个和第3 个参数

47 gl.drawArrays(gl.POINTS, 0, n); // n 为3

由于我们仍然在绘制单个的点,第1个参数mode仍然是g1.POINTS;设置第2个参数first为0,表示从缓冲区中的第1个坐标开始画起;设置第3个参数count为3,表示我们准备绘制3个点(,n为为3)。

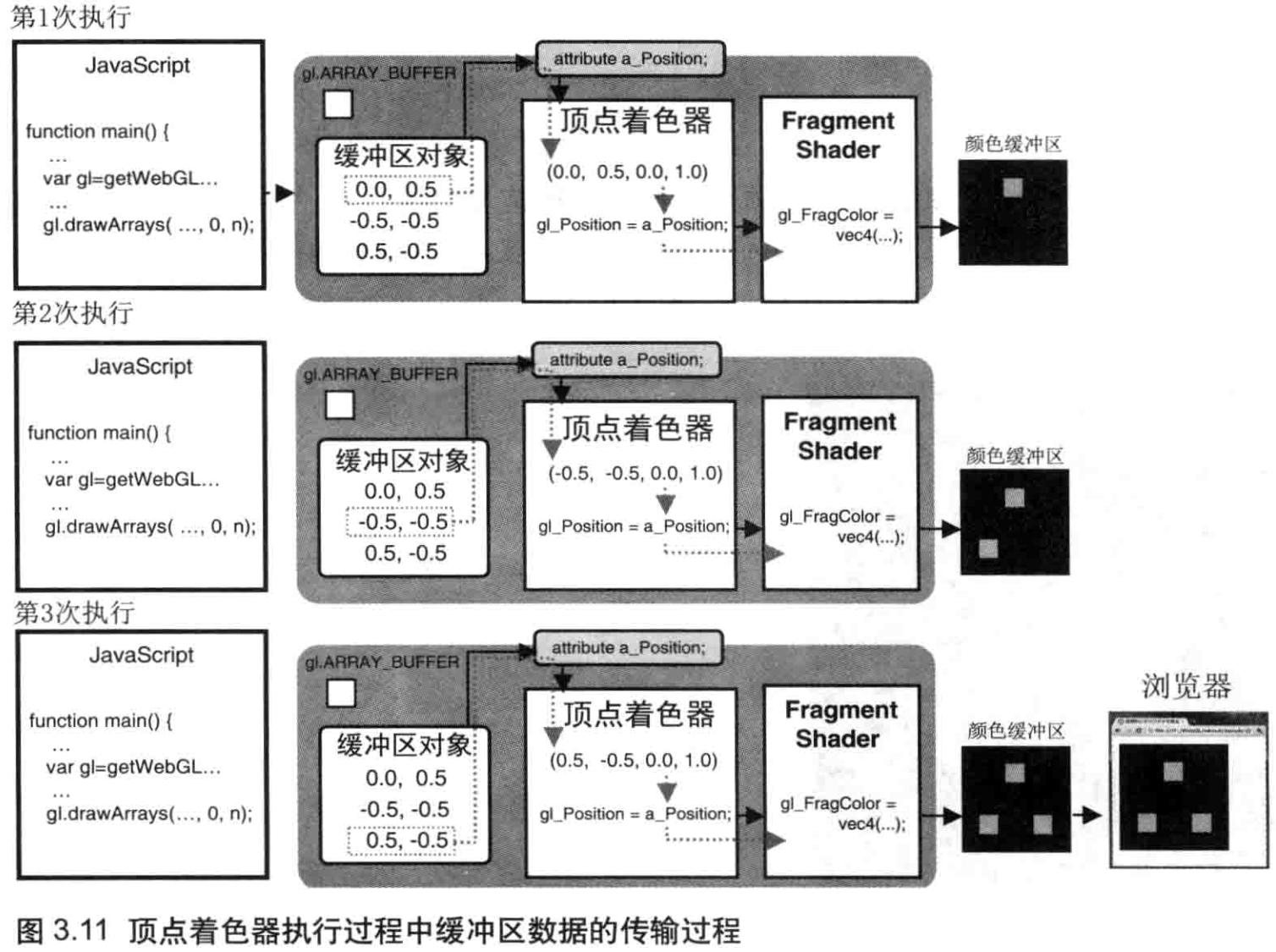

当程序运行到第47行时,实际上顶点着色器执行了count(3)次,我们通过存储在缓冲区中的顶点坐标数据被依次传给attribute变量,如图3.11所示。

注意,每次执行顶点着色器,a_Position的z和w分量值都会自动被设为0.0或1.0,因为a_Position需要4个分量(vec4),而你只提供了两个。

记住,g1.vertexAttribPointer()的第2个参数size被设为2。之前说过,这个参数表示缓冲区中每个顶点有几个分量值,在缓冲区中你只提供x坐标和y坐标,所以你将它设为2。

gl.vertexAttribPointer(a_Position, 2, gl.FLOAT, false, 0, 0);

在绘出所有点后,颜色缓冲区中的内容(3 个红点如图 3.2 所示)就会自动显示在浏览器上,其过程如图 3.11 底部所示

Hello Triangle

尝试使用上面的顶点绘制一个真正的图形(而不是单个的点)。

// HelloTriangle.js (c) 2012 matsuda

// Vertex shader program

var VSHADER_SOURCE =

'attribute vec4 a_Position;\n' +

'void main() {\n' +

' gl_Position = a_Position;\n' +

'}\n'

// Fragment shader program

var FSHADER_SOURCE =

'void main() {\n' + ' gl_FragColor = vec4(1.0, 0.0, 0.0, 1.0);\n' + '}\n'

function main() {

// Retrieve <canvas> element

var canvas = document.getElementById('webgl')

// Get the rendering context for WebGL

var gl = getWebGLContext(canvas)

if (!gl) {

console.log('Failed to get the rendering context for WebGL')

return

}

// Initialize shaders

if (!initShaders(gl, VSHADER_SOURCE, FSHADER_SOURCE)) {

console.log('Failed to intialize shaders.')

return

}

// Write the positions of vertices to a vertex shader

var n = initVertexBuffers(gl)

if (n < 0) {

console.log('Failed to set the positions of the vertices')

return

}

// Specify the color for clearing <canvas>

gl.clearColor(0, 0, 0, 1)

// Clear <canvas>

gl.clear(gl.COLOR_BUFFER_BIT)

// Draw the rectangle

gl.drawArrays(gl.LINE_LOOP, 0, n)

}

function initVertexBuffers(gl) {

var vertices = new Float32Array([0, 0.5, -0.5, -0.5, 0.5, -0.5])

var n = 3 // The number of vertices

// Create a buffer object

var vertexBuffer = gl.createBuffer()

if (!vertexBuffer) {

console.log('Failed to create the buffer object')

return -1

}

// Bind the buffer object to target

gl.bindBuffer(gl.ARRAY_BUFFER, vertexBuffer)

// Write date into the buffer object

gl.bufferData(gl.ARRAY_BUFFER, vertices, gl.STATIC_DRAW)

var a_Position = gl.getAttribLocation(gl.program, 'a_Position')

if (a_Position < 0) {

console.log('Failed to get the storage location of a_Position')

return -1

}

// Assign the buffer object to a_Position variable

gl.vertexAttribPointer(a_Position, 2, gl.FLOAT, false, 0, 0)

// Enable the assignment to a_Position variable

gl.enableVertexAttribArray(a_Position)

return n

}

与MultiPoint.js相比,两处关键的改动在于:

- 在顶点着色器中,指定点的尺寸的一行gl.Pointsize=10.0;被删去了。该语句只有在绘制单个点的时候才起作用。

- gl.drawArrays()方法的第1个参数从gl.POINTS被改为了gl.TRIANGLES。

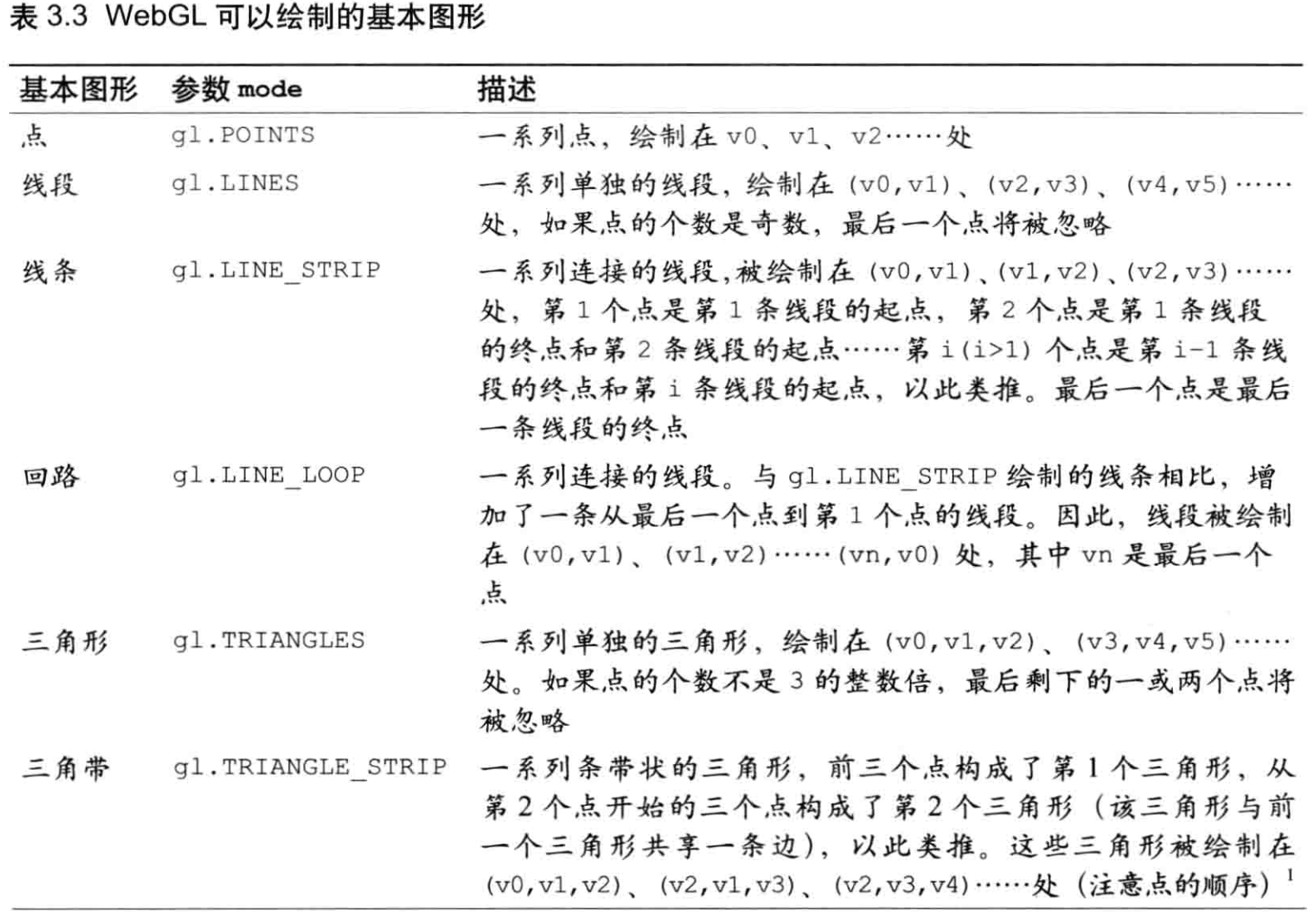

gl.drawArrays()的第1个参数mode十分强大。在这个参数上指定不同的值,我们可以按照不同的规则绘制图形。

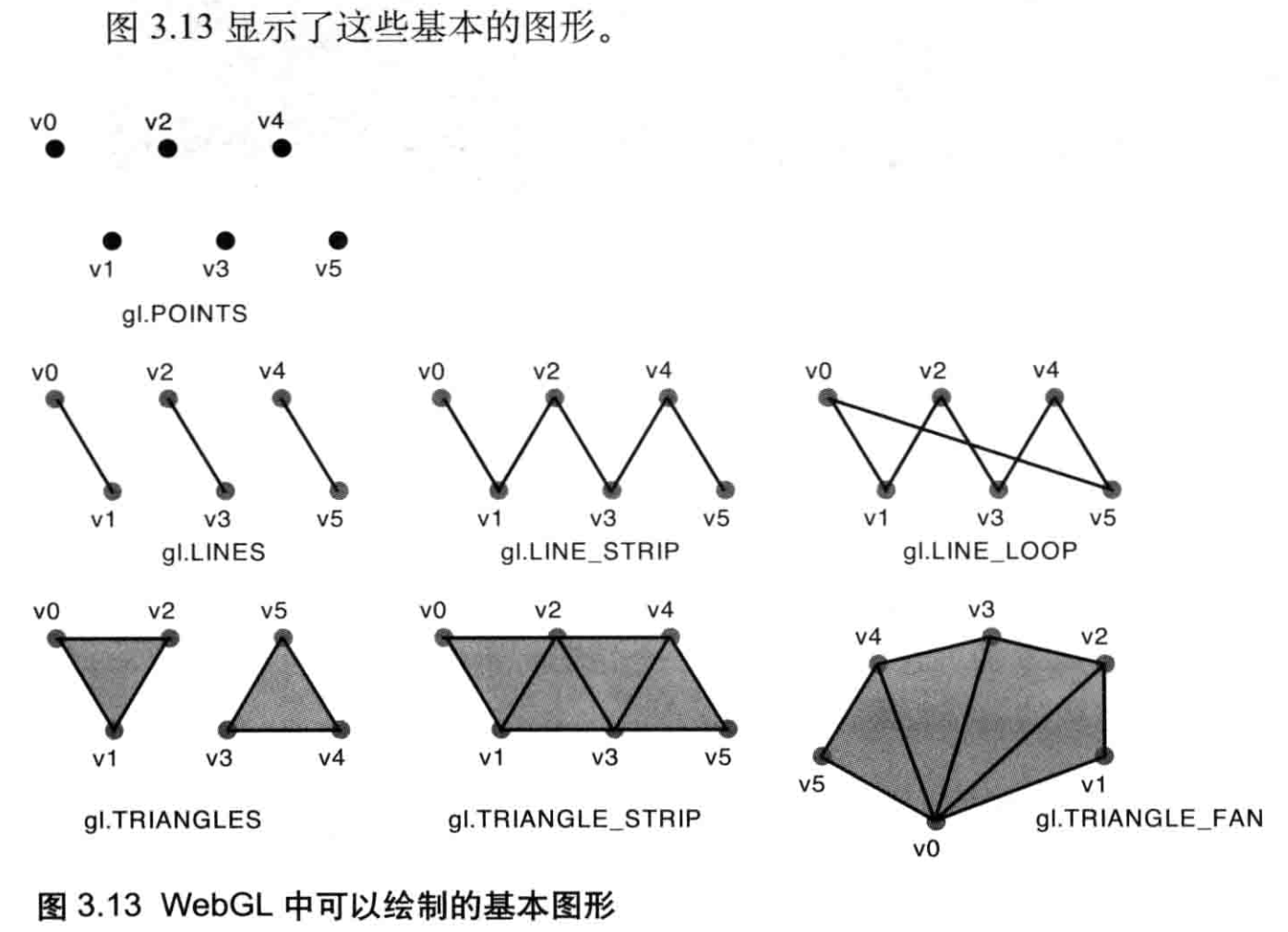

基本图形

将gl.drawArrays()方法的第1个参数mode改为g1.TRIANGLES,就相当于告诉WebGL,“从缓冲区中的第1个顶点开始,使顶点着色器执行3次(n为3),用这3个点绘制出一个三角形”;

这样,缓冲区的3个点就不再是相互独立的,而是同一个三角形中的3个顶点。

WebGL方法gl.drawArrays()既强大又灵活,这通过给第1个参数指定不同的值,我们就能以7种不同的方式来绘制图形。表3.3对此进行了详细介绍,其中v0、v1、v2等等表示缓冲区中的顶点,顶点的顺序将影响绘制的结果。

表3.3中的7种基本图形是WebGL可以直接绘制的图形,但是它们是WebGL绘制其他更加复杂的图形的基础。

如图所示,WebGL只能绘制三种图形:点、线段和三角形。但是,正如本章开头所说到的,从球体到立方体,再到游戏中的三维角色,都可以由小的三角形组成。实际上,你可以使用以上这些最基本的图形来绘制出任何东西。

Hello Rectangle(HelloQuad)

// HelloQuad.js (c) 2012 matsuda

// Vertex shader program

var VSHADER_SOURCE =

'attribute vec4 a_Position;\n' +

'void main() {\n' +

' gl_Position = a_Position;\n' +

'}\n';

// Fragment shader program

var FSHADER_SOURCE =

'void main() {\n' +

' gl_FragColor = vec4(1.0, 0.0, 0.0, 1.0);\n' +

'}\n';

function main() {

// Retrieve <canvas> element

var canvas = document.getElementById('webgl');

// Get the rendering context for WebGL

var gl = getWebGLContext(canvas);

if (!gl) {

console.log('Failed to get the rendering context for WebGL');

return;

}

// Initialize shaders

if (!initShaders(gl, VSHADER_SOURCE, FSHADER_SOURCE)) {

console.log('Failed to intialize shaders.');

return;

}

// Write the positions of vertices to a vertex shader

var n = initVertexBuffers(gl);

if (n < 0) {

console.log('Failed to set the positions of the vertices');

return;

}

// Specify the color for clearing <canvas>

gl.clearColor(0, 0, 0, 1);

// Clear <canvas>

gl.clear(gl.COLOR_BUFFER_BIT);

// Draw the rectangle

gl.drawArrays(gl.TRIANGLE_STRIP, 0, n);

}

function initVertexBuffers(gl) {

var vertices = new Float32Array([

-0.5, 0.5, -0.5, -0.5, 0.5, 0.5, 0.5, -0.5

]);

var n = 4; // The number of vertices

// Create a buffer object

var vertexBuffer = gl.createBuffer();

if (!vertexBuffer) {

console.log('Failed to create the buffer object');

return -1;

}

// Bind the buffer object to target

gl.bindBuffer(gl.ARRAY_BUFFER, vertexBuffer);

// Write date into the buffer object

gl.bufferData(gl.ARRAY_BUFFER, vertices, gl.STATIC_DRAW);

var a_Position = gl.getAttribLocation(gl.program, 'a_Position');

if (a_Position < 0) {

console.log('Failed to get the storage location of a_Position');

return -1;

}

// Assign the buffer object to a_Position variable

gl.vertexAttribPointer(a_Position, 2, gl.FLOAT, false, 0, 0);

// Enable the assignment to a_Position variable

gl.enableVertexAttribArray(a_Position);

return n;

}

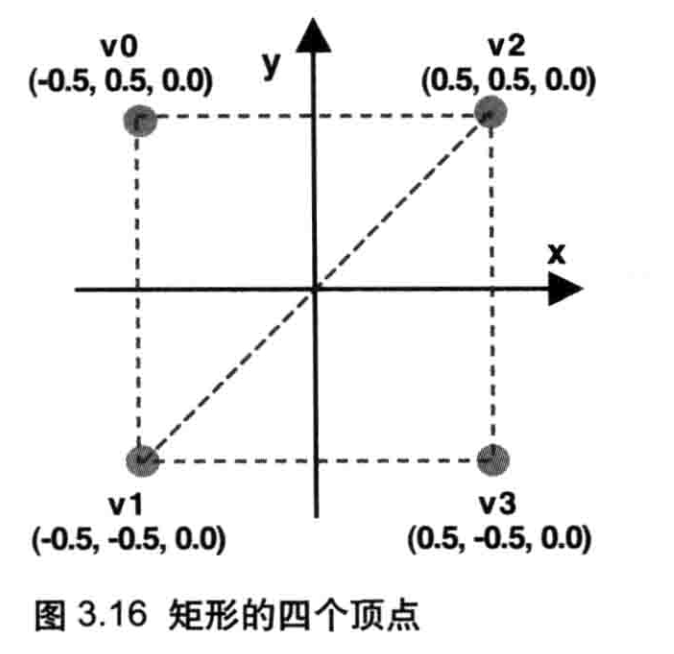

我们使用这个最基本的方法来试着绘制一个矩形。示例程序名为HelloQuad,图3.16 显示了矩形的顶点。当然,顶点的个数为4,因为这是一个矩形。

如上一节所述,WebGL不能直接绘制矩形,你需要将其划分为两个三角形(v0,v1,v2)和(v2,v1,v3),然后通过gl.TRIANGLES,gl.TRIANGLES_STRIP,或者gl.TRIANGLES_FAN 将其绘制出来。本例使用gl.TRIANGLES_STRIP进行绘制,只需要用到4个顶点。如果用g1.TRIANGLES,就需要用到6个。

注意顶点的顺序,否则不能正确绘图。

因为新添了一个顶点,所以还需要将顶点的个数n从3改成4。

移动、旋转和缩放

现在,你已经掌握了绘制图形(如三角形和矩开彭)的方法。让我们更进一步,尝试移动(平移)、旋转和缩放三角形,然后在屏幕上

绘制出来。这样的操作称为变换(transformations)或仿射变换(affinetransformations)。

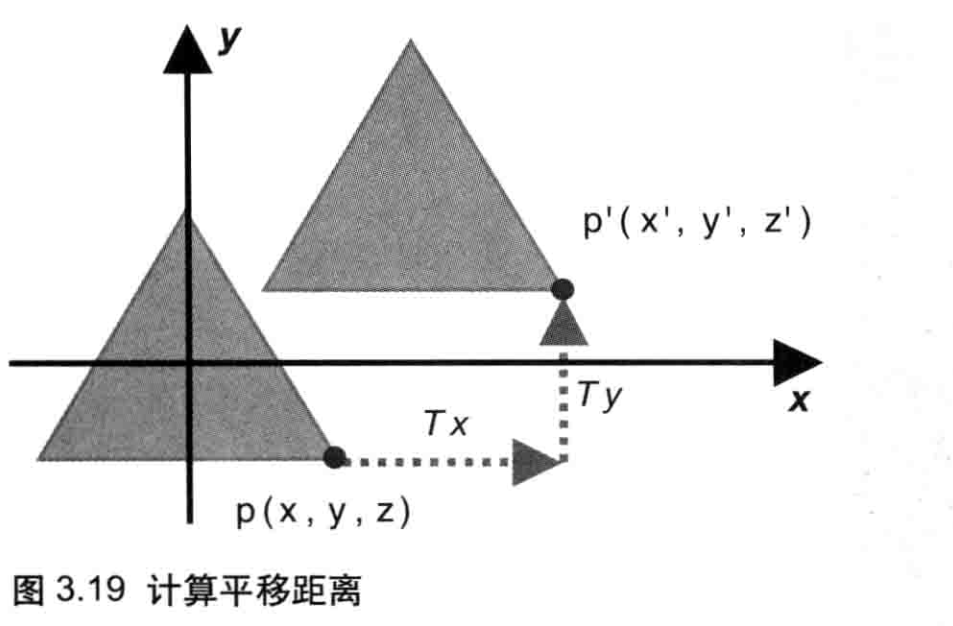

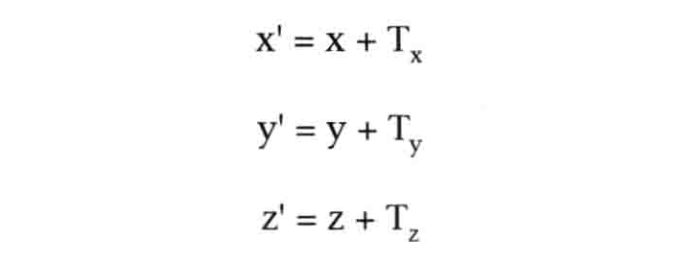

平移

考虑一下,为了平移一个三角形,你需要对它的每一个顶点做怎样的操作?答案是,你需要对顶点坐标的每个分量(x和y),加上三角形在对应轴(如X轴或Y轴)上平移的距离。比如,将点p(x,y,z)平移到 p'(x',y',z'),在X轴、Y轴、z轴三个方向上平移的距离分别为Tx,Ty,Tz,其中Tz为0,如图3.19所示。

那么在坐标的对应分量上,直接加上这些T值,就可以确定p的坐标了,如等式3.1所示。

我们只需要着色器中为顶点坐标的每个分量加上一个常量就可以实现上面的等式。显然,这是一个逐顶点操作(per-vertexoperation)而非逐片元操作,上述修改应当发生在顶点着色器,而不是片元着色器中。

一旦你理解了这一点,修改代码就很简单了:"将平移距离Tx、Ty、Tz的值传入顶点着色器,然后分别加在顶点坐标的对应分量上,再贴武值给gl_Position。下面看看修改后的示例程序。

// TranslatedTriangle.js (c) 2012 matsuda

// Vertex shader program

var VSHADER_SOURCE =

'attribute vec4 a_Position;\n' +

'uniform vec4 u_Translation;\n' +

'void main() {\n' +

' gl_Position = a_Position + u_Translation;\n' +

'}\n';

// Fragment shader program

var FSHADER_SOURCE =

'void main() {\n' +

' gl_FragColor = vec4(1.0, 0.0, 0.0, 1.0);\n' +

'}\n';

// x y z三个方向的平移距离

var Tx = 0.5, Ty = 0.5, Tz = 0.0;

function main() {

// Retrieve <canvas> element

var canvas = document.getElementById('webgl');

// Get the rendering context for WebGL

var gl = getWebGLContext(canvas);

if (!gl) {

console.log('Failed to get the rendering context for WebGL');

return;

}

// Initialize shaders

if (!initShaders(gl, VSHADER_SOURCE, FSHADER_SOURCE)) {

console.log('Failed to intialize shaders.');

return;

}

// Write the positions of vertices to a vertex shader

var n = initVertexBuffers(gl);

if (n < 0) {

console.log('Failed to set the positions of the vertices');

return;

}

// 传递平移距离给顶点着色器

var u_Translation = gl.getUniformLocation(gl.program, 'u_Translation');

if (!u_Translation) {

console.log('Failed to get the storage location of u_Translation');

return;

}

gl.uniform4f(u_Translation, Tx, Ty, Tz, 0.0);

// Specify the color for clearing <canvas>

gl.clearColor(0, 0, 0, 1);

// Clear <canvas>

gl.clear(gl.COLOR_BUFFER_BIT);

// Draw the rectangle

gl.drawArrays(gl.TRIANGLES, 0, n);

}

function initVertexBuffers(gl) {

var vertices = new Float32Array([

0, 0.5, -0.5, -0.5, 0.5, -0.5

]);

var n = 3; // The number of vertices

// Create a buffer object

var vertexBuffer = gl.createBuffer();

if (!vertexBuffer) {

console.log('Failed to create the buffer object');

return -1;

}

// Bind the buffer object to target

gl.bindBuffer(gl.ARRAY_BUFFER, vertexBuffer);

// Write date into the buffer object

gl.bufferData(gl.ARRAY_BUFFER, vertices, gl.STATIC_DRAW);

// Assign the buffer object to the attribute variable

var a_Position = gl.getAttribLocation(gl.program, 'a_Position');

if (a_Position < 0) {

console.log('Failed to get the storage location of a_Position');

return -1;

}

gl.vertexAttribPointer(a_Position, 2, gl.FLOAT, false, 0, 0);

// Enable the assignment to a_Position variable

gl.enableVertexAttribArray(a_Position);

return n;

}

因为Tx、Ty、Tz对于所有顶点来说是固定(一致)的,所以我们使用uniform变量u_Translation来表示三角形的平移距离。首先,获取uniform变量的存储位置,然后将数据传给着色器

注意,gl.uniform4f()函数需接收齐次坐标,所以我们把最后一个参数被设为0.0。

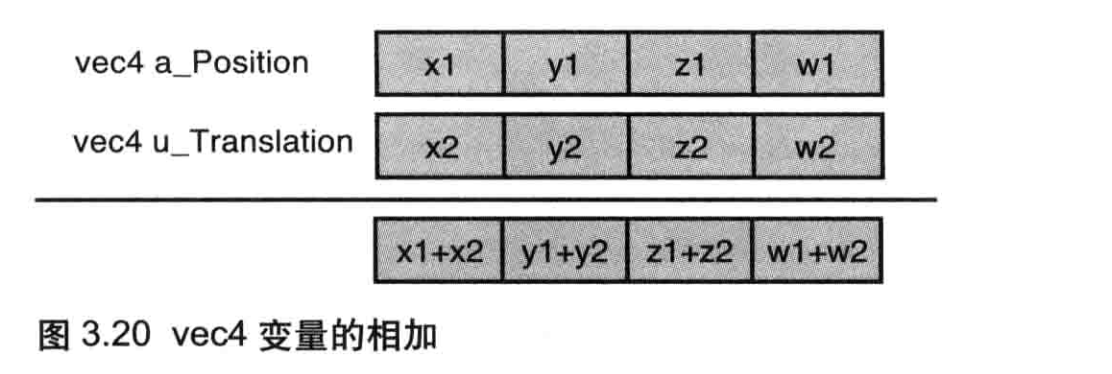

如你所见,我们新定义了uniform变量u_Translation,用来接收了三角形在各轴方向上的平移距离。该变量的类型是vec4,这样它就可以与vec4类型的顶点坐标aPosition直接相加,然后赋值给同样是vec4类型的gl_Position。记住,第2章中讲过,GLSL ES 中的赋值操作只能发生在相同类型的变量之间。

在顶点着色器中,按照等式3.1,为a_Position变量的每个分量(xy,z)加上u_Translaation变量中对应方向的平移距离(Tx,Ty,Tz),并赋值给gl_Position。

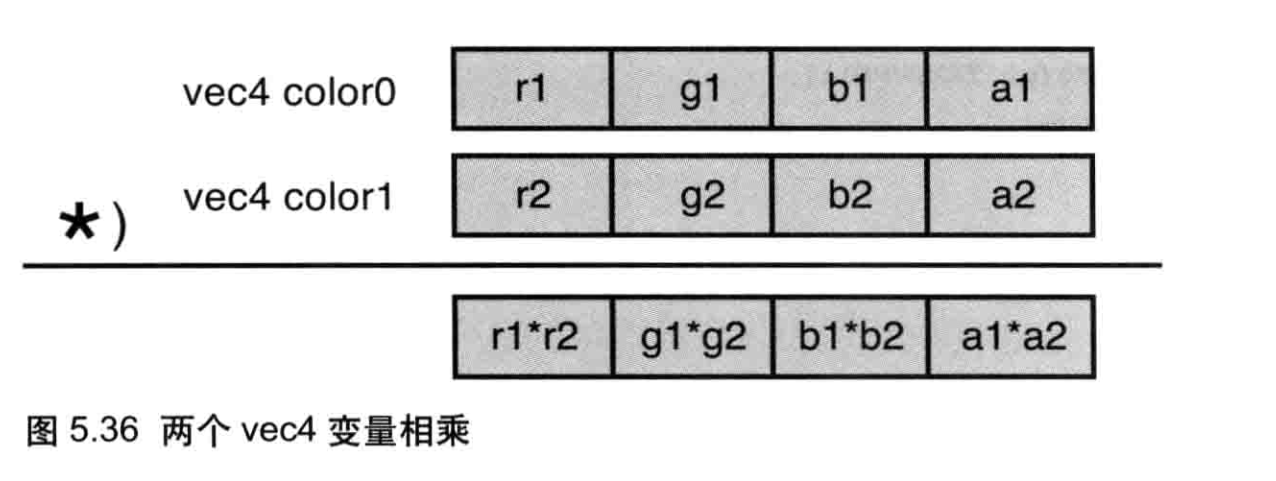

因为a_Position和u_Translation变量都是vec4类型的,所以你可以直接使用+号,两个的矢量的对应分量会被同时相加,如图3.20所示方便的矢量相加运算是GLSLES提供的特性之一,我们将在第6章更详细地讨论GLSL ES.

最后,我来解释一下齐次坐标矢量的最后一个分量w。如第2章所述,gl_Position是齐次坐标,具有4个分量。如果齐次坐标的最后一个分量是1.0,那么它的前三个分量就可以表示一个点的三维坐标。在本例中,如图3.20所示,平移后点坐标第4分量w1+w2必须是1.0(因为点的位置坐标平移之后还是一个点位置坐标),而w1是1.0(它是平移前点坐标第4分量),所以平移矢量本身的第4分量w2只能是0.0,这就是为什么gl.uniform4f()的最后一个参数为0.0**。

最后,调用gl.drawArrays(g1TRIANGLES,0,n)执行顶点着色器(第58行),每次执行都会进行以下3步:

- 将顶点坐标传给a_Position;

- 向a_Position加上u_Translation;

- 结果赋值给gl_Position。

旋转

旋转比平移稍微复杂一些,因为描述一个旋转本身就比描述一个平移复杂。为了描述一个旋转,你必须指明:

- 旋转轴(图形将围绕旋转轴旋转)。

- 旋转方向(方向:顺时针或逆时针)。

- 旋转角度(图形旋转经过的角度)。

在本节中我们这样来表述旋转操作:绕Z轴,逆时针旋转了β角度。这种表述方式同样适用于绕X轴和Y轴的情况。

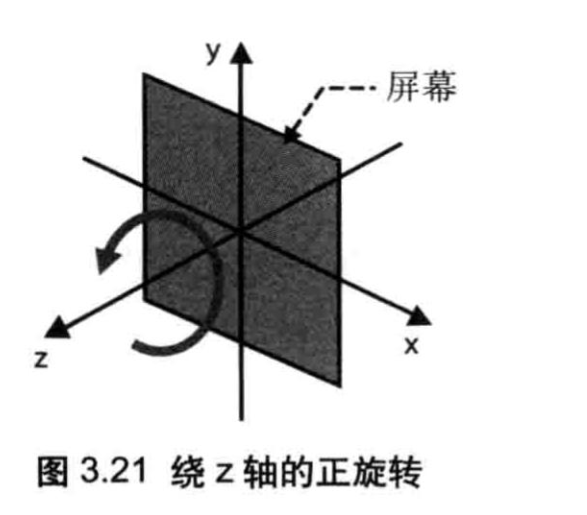

在旋转中,关于“逆时针”的约定是:如果 β是正值,观察者在Z轴正半轴某处,视线沿着Z轴负方向进行观察,那么看到的物体就是逆时针旋转的,如图 3.21 所示。这种情况又可称作正旋转(positiverotation)**。我们也也可以使用右手来确认旋转方向(正如右手坐标系一样):右手握拳,大拇指伸直并使其指向旋转轴的正方向,那么右手其余几个手指就指明了旋转的方向,因此正旋转又口可以称为右手法则旋转(right-hand-rulerotation)。在第2章中说过,右手法则旋转是本书中WebGL程序的默认设定。

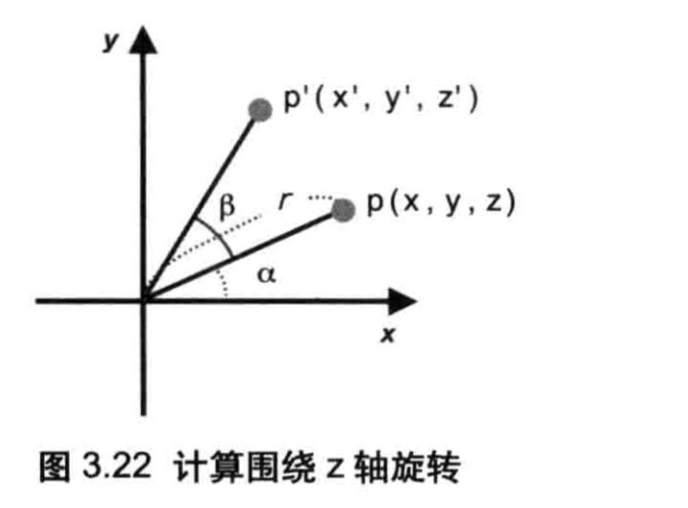

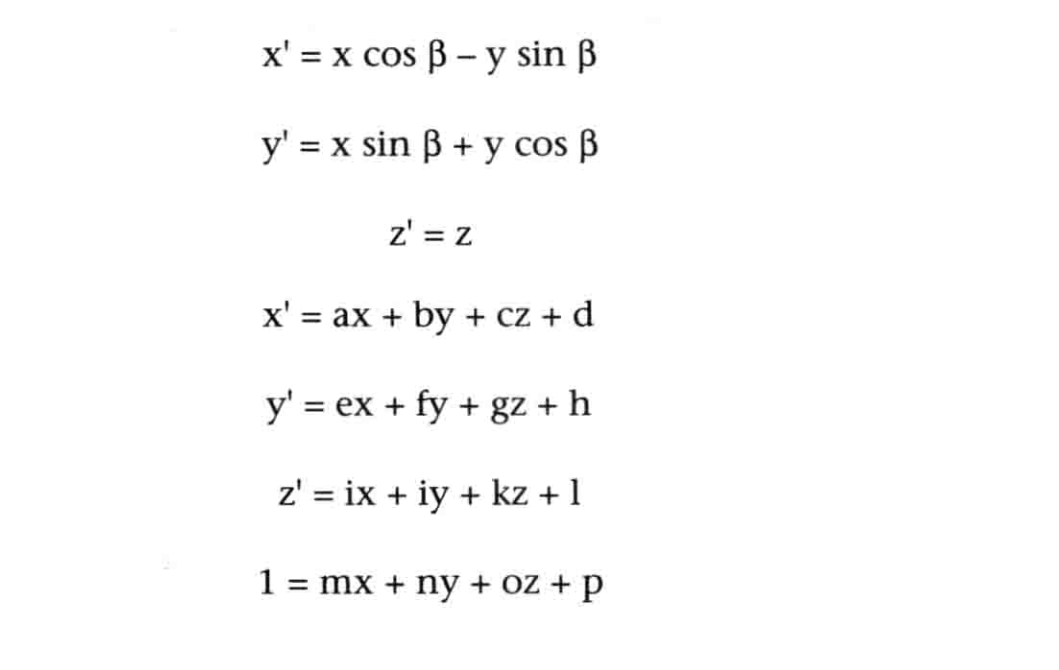

根据图3.22,假设点p(xyz)旋转β角度之后变为了点p'(x',y',z'):首先旋转是绕Z轴进行的,所以z坐标不会变,可以直接忽略;然后,x坐标和y生坐标的情况有一些复杂。

在图3.22中,r是从原点到点p的距离,而a是X轴旋转到点p的角度。用这两个变量计算出点p的坐标,如等式3.2所示。

我们可以把sinβ和cosβ的值传给顶点着色器,然后在着色器中根据等式3.3计算旋转后的点坐标,就可以实现旋转这个点的效果了。使用JavaScript内置的Math对象的sin()和cos()方法来进行三角函数运算

// RotatedTriangle.js (c) 2012 matsuda

// Vertex shader program

var VSHADER_SOURCE =

// x' = x cosβ - y sinβ

// y' = x sinβ + y cosβ Equation 3.3

// z' = z

'attribute vec4 a_Position;\n' +

'uniform float u_CosB, u_SinB;\n' +

'void main() {\n' +

' gl_Position.x = a_Position.x * u_CosB - a_Position.y * u_SinB;\n' +

' gl_Position.y = a_Position.x * u_SinB + a_Position.y * u_CosB;\n' +

' gl_Position.z = a_Position.z;\n' +

' gl_Position.w = 1.0;\n' +

'}\n';

// Fragment shader program

var FSHADER_SOURCE =

'void main() {\n' +

' gl_FragColor = vec4(1.0, 0.0, 0.0, 1.0);\n' +

'}\n';

// 旋转角度

var ANGLE = 90.0;

function main() {

// Retrieve <canvas> element

var canvas = document.getElementById('webgl');

// Get the rendering context for WebGL

var gl = getWebGLContext(canvas);

if (!gl) {

console.log('Failed to get the rendering context for WebGL');

return;

}

// Initialize shaders

if (!initShaders(gl, VSHADER_SOURCE, FSHADER_SOURCE)) {

console.log('Failed to intialize shaders.');

return;

}

// Write the positions of vertices to a vertex shader

var n = initVertexBuffers(gl);

if (n < 0) {

console.log('Failed to set the positions of the vertices');

return;

}

// 将旋转图形所需的数据传输给顶点着色器

var radian = Math.PI * ANGLE / 180.0; // 转为弧度制

var cosB = Math.cos(radian);

var sinB = Math.sin(radian);

var u_CosB = gl.getUniformLocation(gl.program, 'u_CosB');

var u_SinB = gl.getUniformLocation(gl.program, 'u_SinB');

if (!u_CosB || !u_SinB) {

console.log('Failed to get the storage location of u_CosB or u_SinB');

return;

}

gl.uniform1f(u_CosB, cosB);

gl.uniform1f(u_SinB, sinB);

// Specify the color for clearing <canvas>

gl.clearColor(0, 0, 0, 1);

// Clear <canvas>

gl.clear(gl.COLOR_BUFFER_BIT);

// Draw the rectangle

gl.drawArrays(gl.TRIANGLES, 0, n);

}

function initVertexBuffers(gl) {

var vertices = new Float32Array([

0, 0.5, -0.5, -0.5, 0.5, -0.5

]);

var n = 3; // The number of vertices

// Create a buffer object

var vertexBuffer = gl.createBuffer();

if (!vertexBuffer) {

console.log('Failed to create the buffer object');

return -1;

}

// Bind the buffer object to target

gl.bindBuffer(gl.ARRAY_BUFFER, vertexBuffer);

// Write date into the buffer object

gl.bufferData(gl.ARRAY_BUFFER, vertices, gl.STATIC_DRAW);

var a_Position = gl.getAttribLocation(gl.program, 'a_Position');

if (a_Position < 0) {

console.log('Failed to get the storage location of a_Position');

return -1;

}

// Assign the buffer object to a_Position variable

gl.vertexAttribPointer(a_Position, 2, gl.FLOAT, false, 0, 0);

// Enable the assignment to a_Position variable

gl.enableVertexAttribArray(a_Position);

return n;

}

由于目的是为了将三角形旋转90度,我们得事先计算90度的正弦值和余弦值。在JavaScript中算出这两个值,再传给顶点着色器的两个uniform变量。

你也可以将旋转的角度传人顶点着色器,并在着色器中计算正弦值和余弦值。但是,实际上所有顶点旋转的角度都是一样的,在JavaScript中算好正弦值和余弦值,然后再传递进去,只需要计算一次,效率更高。

按照本书的命名约定,两个uniform变量分别为uCosB和usinB。再次提醒,之所以使用uniform变量,是因为这两个变量的值与顶点无关。

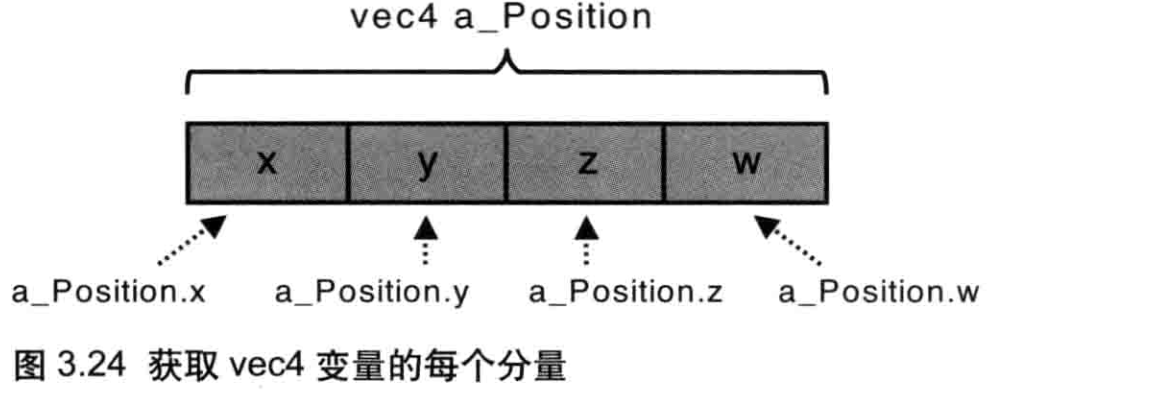

之前进行平移变换时,齐次坐标的x、y、z、w分量是作为整体进行加法运算的;而进行旋转变换时,为了计算等式33,需要单独访问a_Position的每个分量。我们使用点操作符“.”来访问分量,如a_Position.x,a_Position.y或a_Position.z(如图324所示,参见第6章)。

根据等式3.3,还需要将z原封不动地赋给z',以及将最后一个w分量设为1.0。

本例向顶点着色器传入了cosβ和sinβ值(而非平移距离Tx等)。我们使用JavaScript内置的Mathsin()和Math.cos()函数来计算ß的正弦和余弦值。但是,这两个方法必须接受弧度制(而不是角度制)的参数,所以我们还得先把β值从角度制转为弧度制:将角度值90乘以π然后除以180,访问Math.PI可以获得π的值。

在浏览器中运行程序,可见屏幕上的三角形逆时针旋转了90度;如果指定了一个负的角度值,三角形就会顺时针旋转。不论旋转方向如何,等式3.3都是通用的,如果要顺时针旋转90度的话,直接将角度赋值为-90即可,数学sin()和数学cos()将自动为你处理剩下的事情。

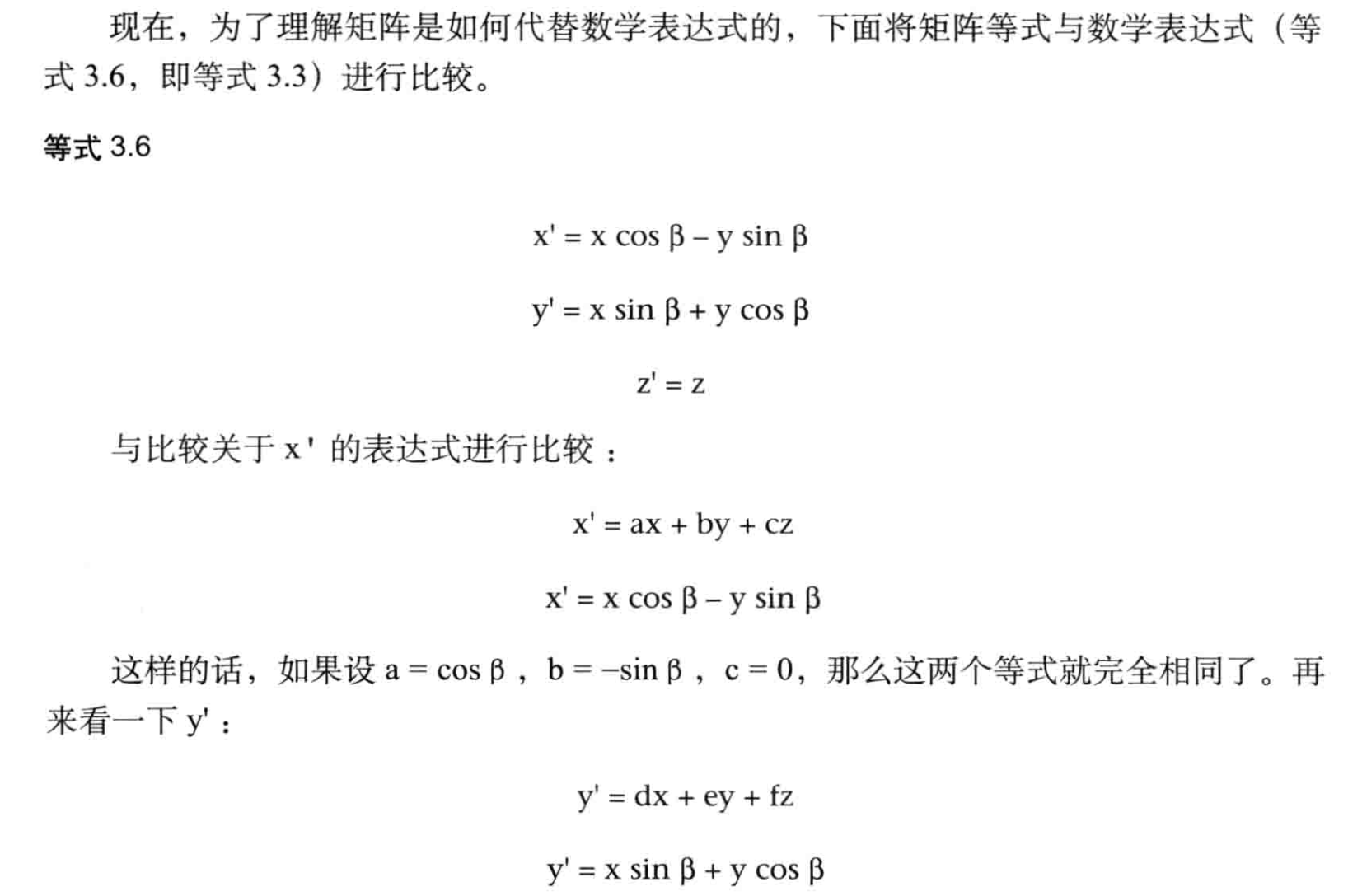

变换矩阵:旋转

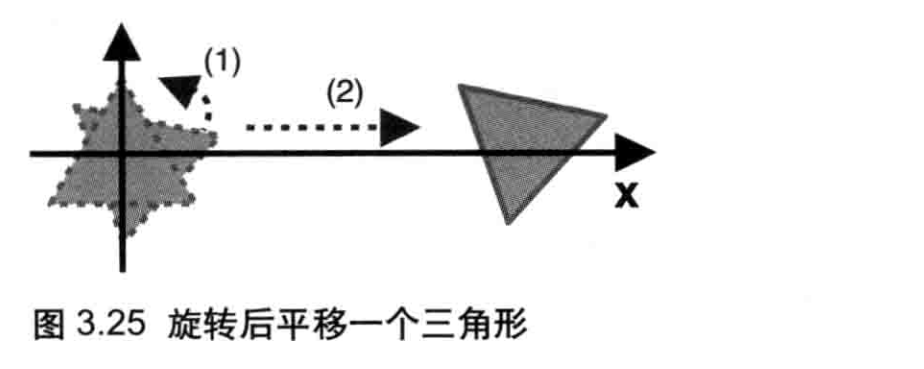

对于简单的变换,你可以使用数学表达式来实现。但是当情形逐渐变得复杂时,你很快就会发现利用表达式运算实际上相当繁琐。比如,图3.25显示了一个“旋转后平移”的过程,如果使用数学表达式,我们就需要等式3.1和等式3.3叠加,获得一个新的等式,然后在顶点着色器中实现。

但是如果这样做,每次都需要进行一次新的变换,我们就需要重新求取一个新的等式,然后实现一个新的着色器,这当然很不科学。好子在我们可以使用另一个数学工具-变换矩阵(Transformationmatrix)来完成这项工作。变换矩阵非常适合操作计算机图形。

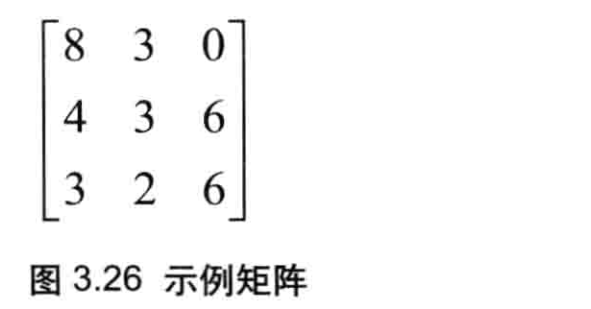

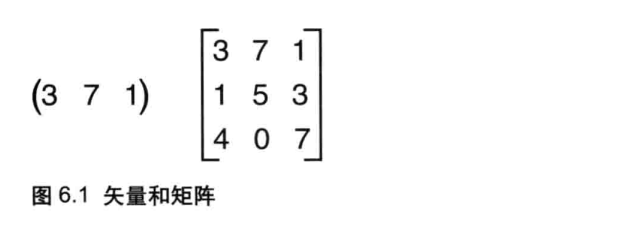

如图3.26所示,矩阵是一个矩形的二维数组,数字按照行(水平方向)和列(垂直方向)排列,数字两侧的方括号表示这些数字是一个整体一个矩阵)。我们将使用矩阵来表示前面的计算过程。

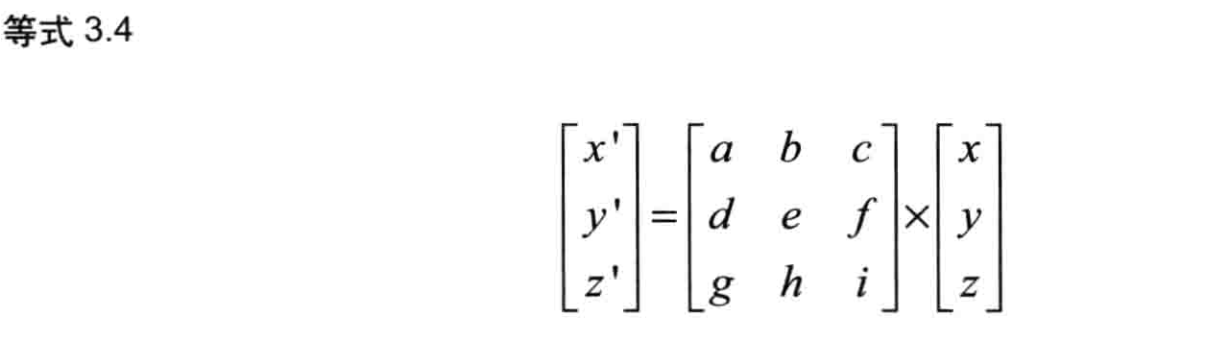

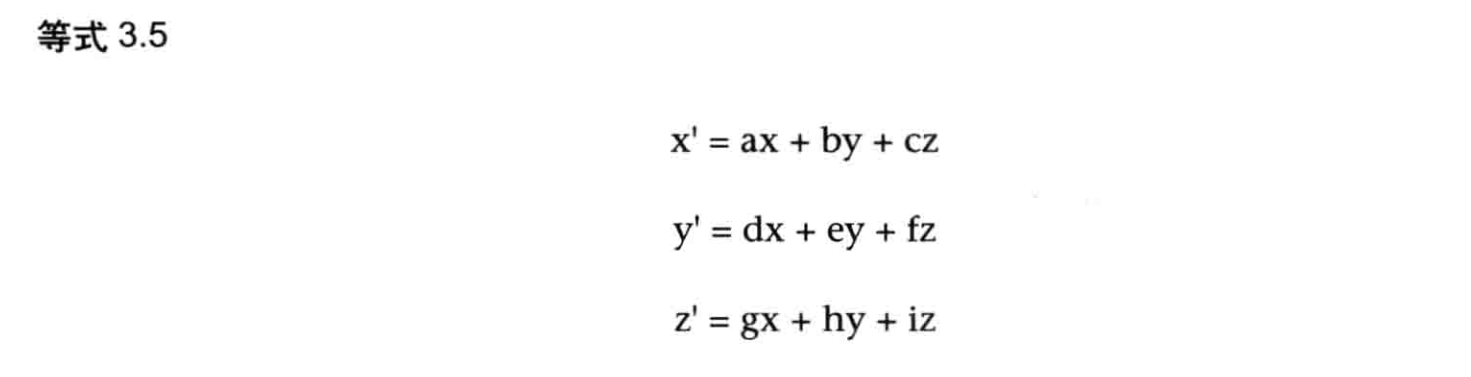

在解释如何使用变换矩阵来替代数学表达式之前,你需要理解矩阵和矢量的乘法。矢量就是由多个分量组成的对象,比如顶点的坐标(0.0,0.5,1.0)。

矩阵和矢量的乘法可以写成等式34的形式(虽然乘号“x”通常被忽略不写,但是为了强调,本书中我们总是明确地将这个符号写号出来)。可见,将矩阵(中间)和矢量(右边)相乘,就获得了一个新的矢量(左边)。注意矩阵的乘法不符合交换律也就是说AxB和BxA并不相等。第6章将更深入地讨论这些问题。

上式中的这个矩阵具有3行3列,因此又被称为3x3矩阵。矩阵右侧是一个由x、y、z组成的矢量(为了与矢量相乘,矢量被写成列的的形式,其仍然表示点的坐标)。矢量具有3个分量,因此被称为三维矢量。再次说明,数字两侧的方括号表示这些数字是一个整体(一个矢量)。**

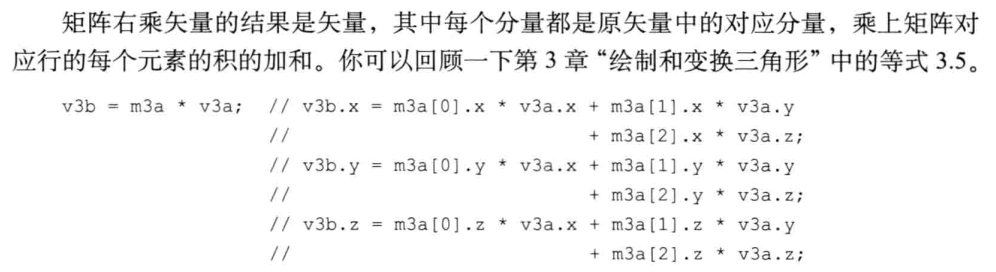

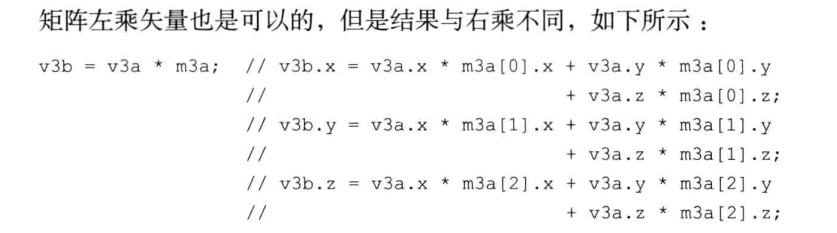

在本例中,矩阵与矢量相乘得到的新矢量,其三个分量为x、y、z,其值如等式3.5所示。注意,只有在矩阵的列数与矢量的行数相等时才可以将两者相乘。

这个矩阵就被称为变换矩阵(transformationmatrix),因为它将右侧的矢量(x,y,z)“变换”为了左侧的矢量(x',y',z')。上面这个变换矩阵进行的变换是一次旋转,所以这个矩阵又可以被称为旋转矩阵(rotationmatrix)。

可以看到,等式3.7中矩阵的元素都是等式3.6中的系数。一旦你熟悉这种矩阵表示法,进行变换就变得非常简单了。如果你不熟悉,你应当花点时间好好地理解它,变换矩阵的概念在三维图形学中非常重要。

变换矩阵在三维计算机图形学中应用得如此广法,以致于着色器本身就实现了矩阵和矢量相乘的功能。

变换矩阵:平移

比较一下等式3.5和等式3.1(平移的数学表达式),如下所示:

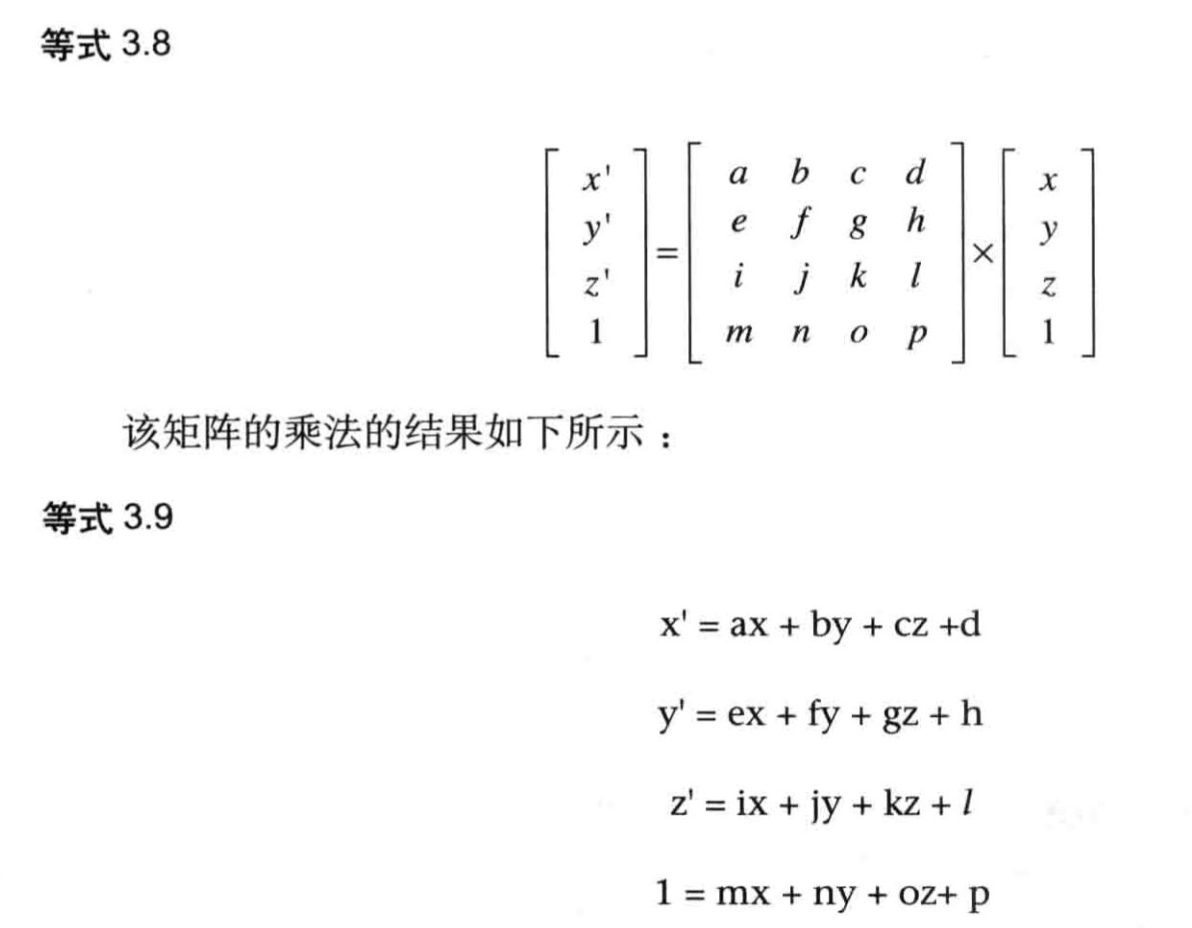

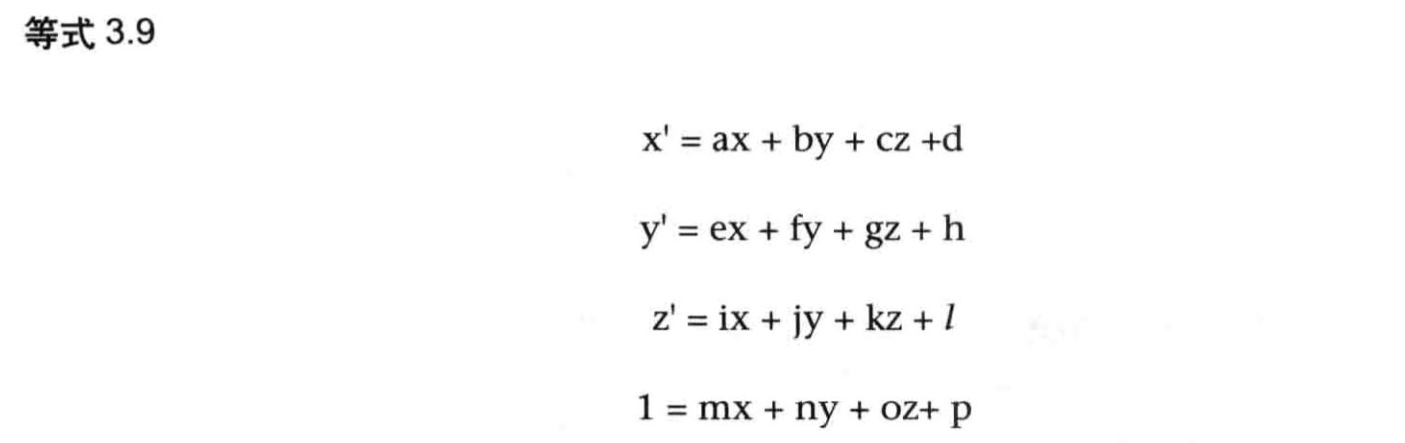

这里第二个等式的右侧有常量项Tx,第一个等式中没有,这意味着我们无法通过使用一个3x3的矩阵来表示平移。为了解决这个问是题,我们可以使用一个4x4的矩阵,以及具有第4个分量(通常被设为1.0)的矢量。也就是说,我们假设点p的坐标为(x,y,z,1),平移之后的点p'的坐标为(x',y,z,1),如等式3.8所示:

根据最后一个式子1=mx+ny+oz+p,很容易求算出系数m=0,n=0,o=0,p=1。这些方程都有常数项d、h、l和p,看上去比较适合等式3.1(因为等式3.1中也有常数项)。等式3.1(平移)如下所示,我们将它与等式3.9进行比较:

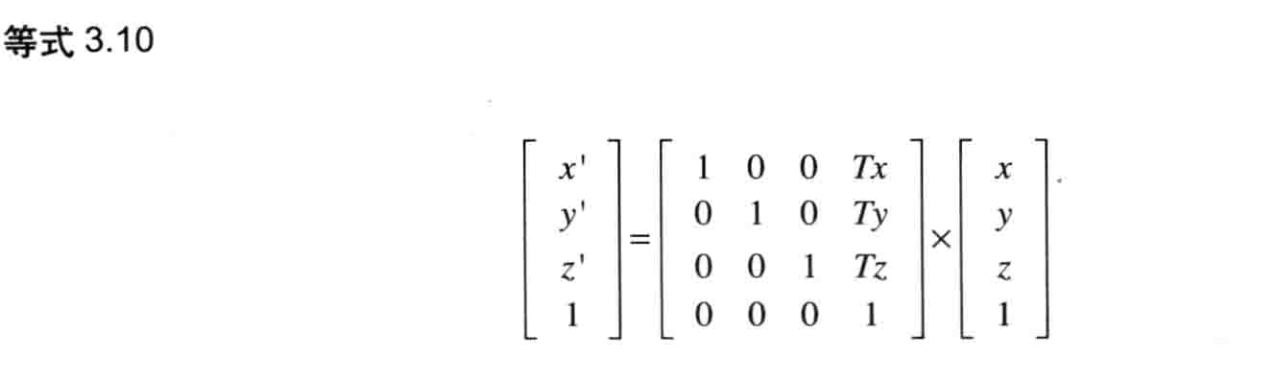

比较x',可知a=1,b=0,c=0,d=Tx;类似地,比较y',可知e=0,f=1,g=0,h=Ty;比较z',可知i=0,j=0,k=1,1=Tz。这样,你就可以写出表示平移的矩阵,又称为平移矩阵(translationmatrix),如等式3.10所示

4x4的旋转矩阵

至此,我们已经成功地创建了一个旋转矩阵和一个平移矩阵,这两个矩阵的作用与此前示例程序中的数学表达式的作用是一样的,那就是计算变换后的顶点坐标。在“先旋转再平移”的情形下,我们需要将两个矩阵组合起来(你应该记得,这也是我们使用矩阵的初衷),然而旋转矩阵(3x3矩阵)与平移知矩阵(4x4矩阵)的阶数不同。我们不能把两个阶数不一样的矩阵组合起来,所以得使用某种手段,使这两个矩阵的阶数一致。

将旋转矩阵从一个3x3矩阵转变为一个4x4知矩阵,只需要将方程3.3和方程3.9比较一下即可。

例如,当你通过比较x'=xcosβ-ysinβ与x'=ax+by+cz+d时,可知a=cosβ,b=-sinβ,c=0,d=0。以此类推,求得y'和z'等式中的系数,最终得到4x4的旋转矩阵,如等式3.11所示:

这样,我们就可以使用相同阶数(4x4)的矩阵来表示平移和旋转,实现了最初的目标!

示例程序(RotatedTriangle_Matrix.js 旋转矩阵)

// RotatedTriangle_Matrix.js (c) matsuda

// Vertex shader program

var VSHADER_SOURCE =

'attribute vec4 a_Position;\n' +

'uniform mat4 u_xformMatrix;\n' +

'void main() {\n' +

' gl_Position = u_xformMatrix * a_Position;\n' +

'}\n';

// Fragment shader program

var FSHADER_SOURCE =

'void main() {\n' +

' gl_FragColor = vec4(1.0, 0.0, 0.0, 1.0);\n' +

'}\n';

// The rotation angle

var ANGLE = 90.0;

function main() {

// Retrieve <canvas> element

var canvas = document.getElementById('webgl');

// Get the rendering context for WebGL

var gl = getWebGLContext(canvas);

if (!gl) {

console.log('Failed to get the rendering context for WebGL');

return;

}

// Initialize shaders

if (!initShaders(gl, VSHADER_SOURCE, FSHADER_SOURCE)) {

console.log('Failed to intialize shaders.');

return;

}

// Write the positions of vertices to a vertex shader

var n = initVertexBuffers(gl);

if (n < 0) {

console.log('Failed to set the positions of the vertices');

return;

}

// 创建旋转矩阵

var radian = Math.PI * ANGLE / 180.0; // 角度值转弧度制

var cosB = Math.cos(radian), sinB = Math.sin(radian);

// 注意webgl中矩阵是列主序的

var xformMatrix = new Float32Array([

cosB, sinB, 0.0, 0.0,

-sinB, cosB, 0.0, 0.0,

0.0, 0.0, 1.0, 0.0,

0.0, 0.0, 0.0, 1.0

]);

// 将旋转矩阵传输给顶点着色器

var u_xformMatrix = gl.getUniformLocation(gl.program, 'u_xformMatrix');

if (!u_xformMatrix) {

console.log('Failed to get the storage location of u_xformMatrix');

return;

}

gl.uniformMatrix4fv(u_xformMatrix, false, xformMatrix);

// Specify the color for clearing <canvas>

gl.clearColor(0, 0, 0, 1);

// Clear <canvas>

gl.clear(gl.COLOR_BUFFER_BIT);

// Draw the rectangle

gl.drawArrays(gl.TRIANGLES, 0, n);

}

function initVertexBuffers(gl) {

var vertices = new Float32Array([

0, 0.5, -0.5, -0.5, 0.5, -0.5

]);

var n = 3; // The number of vertices

// Create a buffer object

var vertexBuffer = gl.createBuffer();

if (!vertexBuffer) {

console.log('Failed to create the buffer object');

return false;

}

// Bind the buffer object to target

gl.bindBuffer(gl.ARRAY_BUFFER, vertexBuffer);

// Write date into the buffer object

gl.bufferData(gl.ARRAY_BUFFER, vertices, gl.STATIC_DRAW);

var a_Position = gl.getAttribLocation(gl.program, 'a_Position');

if (a_Position < 0) {

console.log('Failed to get the storage location of a_Position');

return -1;

}

// Assign the buffer object to a_Position variable

gl.vertexAttribPointer(a_Position, 2, gl.FLOAT, false, 0, 0);

// Enable the assignment to a_Position variable

gl.enableVertexAttribArray(a_Position);

return n;

}

u_xformMatrix变量表示等式3.11中的旋转矩阵,a_Position变量表示顶点的坐标(即等式 3.11中右侧的矢量),二者相乘得到变换后的顶点坐标,与等式3.11中相同。

代码中完成矩阵与矢量相乘的运算(gl_Position=u_xformMatrix * a_Possition)。这时因为着色器内置了常用的矢量和矩阵运算功能,这种强大特性正是专为三维计算机图形学而设计的。

由于变换矩阵是4x4的,GLSLES需要知道每个变量的类型,所以我们将u_xformMatrix定义为mat4类型。如你所料,mat4类型的变量就是4x4的矩阵。

JavaScript按照等式3.11计算旋转矩阵,然后将其传给u_xformMatrix。

// 创建旋转矩阵

var radian = Math.PI * ANGLE / 180.0; // 角度值转弧度制

var cosB = Math.cos(radian), sinB = Math.sin(radian);

// 注意webgl中矩阵是列主序的

var xformMatrix = new Float32Array([

cosB, sinB, 0.0, 0.0,

-sinB, cosB, 0.0, 0.0,

0.0, 0.0, 1.0, 0.0,

0.0, 0.0, 0.0, 1.0

]);

//...

gl.uniformMatrix4fv(u_xformMatrix, false, xformMatrix);

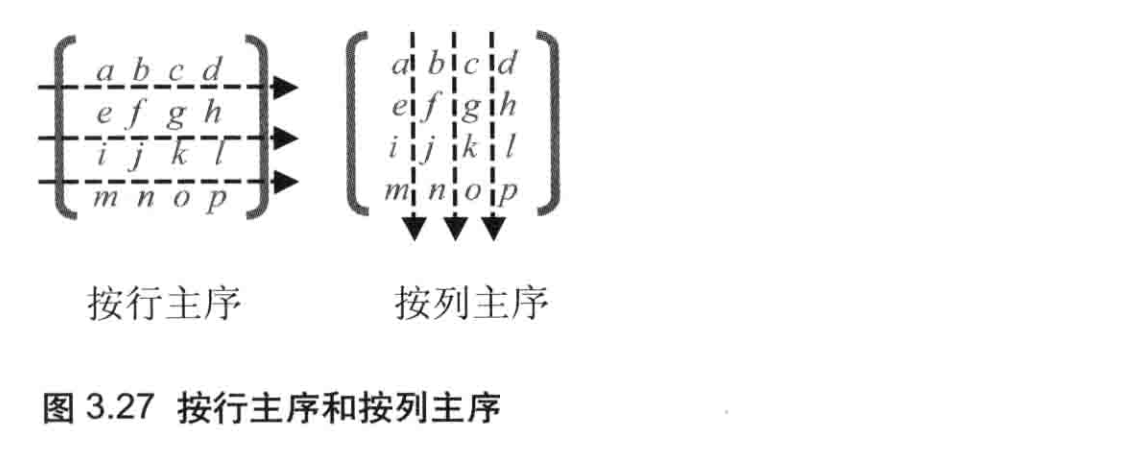

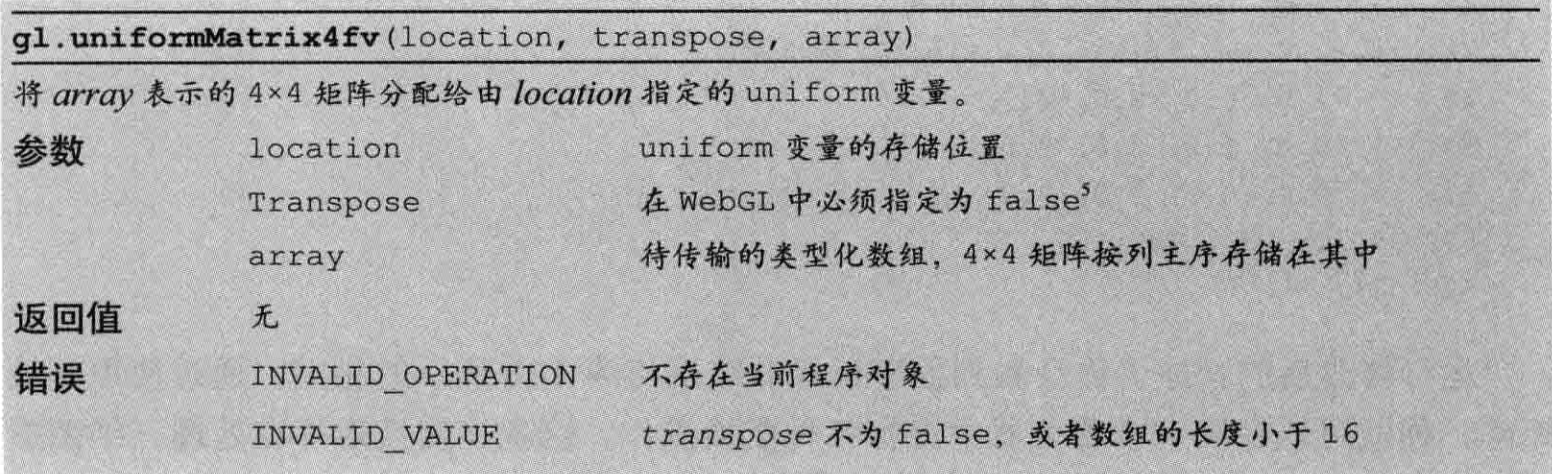

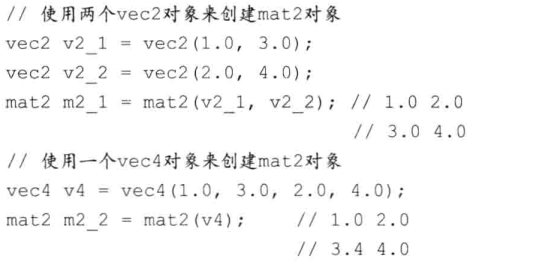

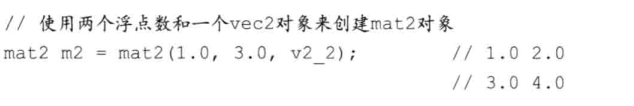

这段代码首先计算了90度的正弦值和余弦值,这两个值需要被用来构建旋转矩阵;之后创建了Float32Array类型的xformMatrix变量表示旋转矩阵(第48行)。与GLSLES不同,JavaScript并没有专门表示矩阵的类型,所以你需要使用类型化数组Float32Array。我们在数组中存储矩阵的每个元素,但问题是:矩阵是二维的,其元素按照行和列进行排列,而数组是一维的,其元素只是排成一行。这里,我们可以按照两种方式在数组中存储矩阵元素:按行主序(row major oder) 和按列主序 (columnmajor order),如图3.27所示。

WebGL 和 OpenGL 一样,矩阵元素是按列主序存储在数组中的。比如,图3.27所示的矩阵存储在数组中就是这样的:[a,e,i,m,b,f,j,n,c,g,k,o,d,n,l,p]。本例中,旋转矩阵也是按照这样的顺序存储在Float32Array类型的的数组中的(第49~52行)。

最后,我们使用gl.uniformMatrix4fv()函数,将刚刚生成的数组传给uxformMatrix变量。注意,函数名的最后一个字母是v,表示它可以向着色器传输多个数据值。

平移:相同的策略

如你所见,4x4的矩阵不仅可以用来表示平移,也可以用来表示旋转。不管是平移还是旋转,你都使用如下形式来进行矩阵和矢量的运运算以完成变换:<新坐标>=<变换矩阵>*<旧坐标>,比如在着色器中:

' gl_Position = u_xformMatrix * a_Position;\n' +

这意味着,如果我们改变数组xformMatrix中的元素,使之成为一个平移矩阵,那么就可以实现平移操作,其效果就和之前使用数学表达式进行的平移操作一样(图3.18)。

因此,修改RotatedTriangle_Matrix.js,将放旋转角度修改为与平移相关的变量:

var Tx = 0.5, Ty = 0.5, Tz = 0.0

我们还需重写创建矩阵的代码,记住,矩阵是按列主序存储的。虽然xformMatrix现在是一个平移矩阵了,但我们仍使用这个变量名。因为对于着色器而言,旋转矩阵和平移矩阵其实是一回事。最后,你不会用到ANGLEA变量,把与旋转相关的代码注释掉

//创建旋转矩阵

//varradian=MathPI*ANGLE/1800;//角度值转弧度制

//var cosB=Mathcos(radian),sinB=Mathsin(radian);

//注意:WebGL中矩阵是列主序的

var xformMatrix=newFloat32Array([

1.0,0.0,0.0,0.0,

0.0,1.0,0.0,0.0,

0.0,0.0,1.0,0.0,

Tx,Ty,Tz,1.0

]);

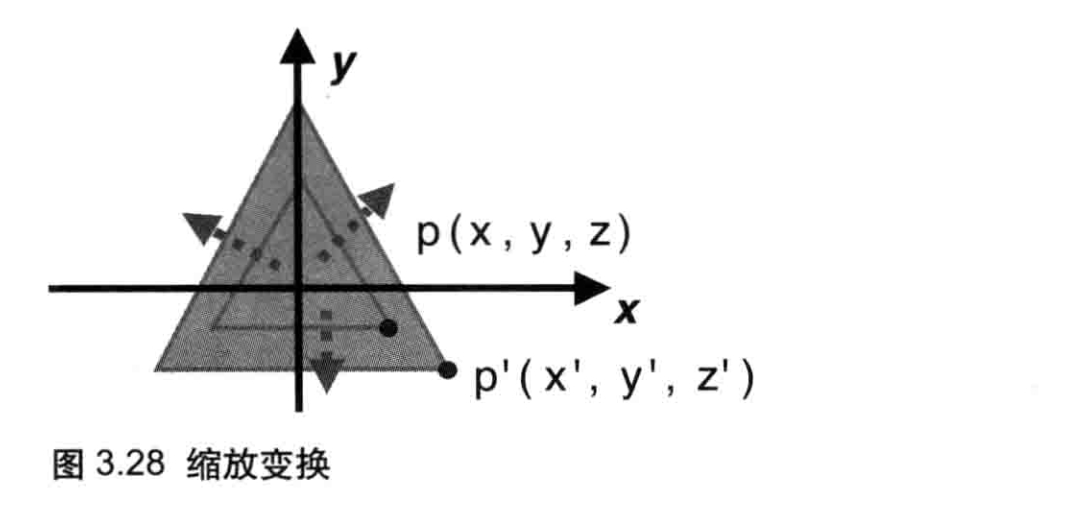

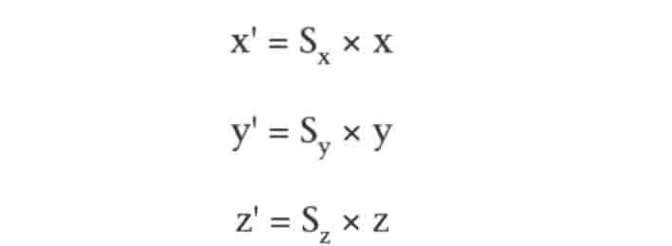

变化矩阵:缩放

仍然假设最初的点p,经过缩放操作之后变成了p'。

假设在三个方向X轴,Y轴,Z轴的缩放因子Sx,Sy,Sz,不相关,那么有:

将上式与等式3.9作比较,可知缩放操作的变换矩阵:

和之前的例子一样,我们只要将缩放矩阵传给xformMatrix变量。下面这个示例程序会将三角形在垂直方向上拉伸到1.5倍。

varSx=10,Sy=15,Sz=10;

...

//注意:WebGL中矩阵是列主序的

var xformMatrix=newFloat32Array([

Sx,0.0,0.0,0.0,

0.0,Sy,0.0,0.0,

0.0,0.0,Sz,0.0,

0.0,0.0,0.0,1.0

]

注意,如果将Sx、Sy或Sz指定为0,缩放因子就就是0.0,图形就会缩小到不可见。如果希望保持图形的尺寸不变,应该将缩放因子全部设没为1.0。

高级变换与动画基础

平移,然后旋转

矩阵变换库:cuon-matrix.js

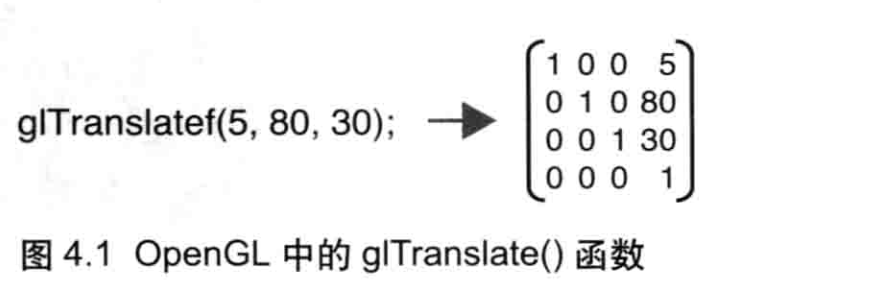

在OpenGL中,我们无须手动指定变换矩阵的每个元素,因为OpenGL提供了一系列有用的函数来帮助我们创建变换矩阵。比如通过调用glTranslate()函数并传入在XY、Z轴上的平移的距离,就可以创建一个平移矩阵(如图4.1所示)。

遗憾的是,WebGL 没有提供类似的矩阵函数,如果想要使用它们,你就得自己编写,或者使用其他人已经编写好的。因为矩阵函数非常有用,所以我为本书专门编写了一个JavaScript函数库cuon-matrixjs。该函数库允许你通过与OpenGL中类似的方式创建变换矩阵。虽然这个库是专为本书编写的,你也可以在自己的程序中使用它。

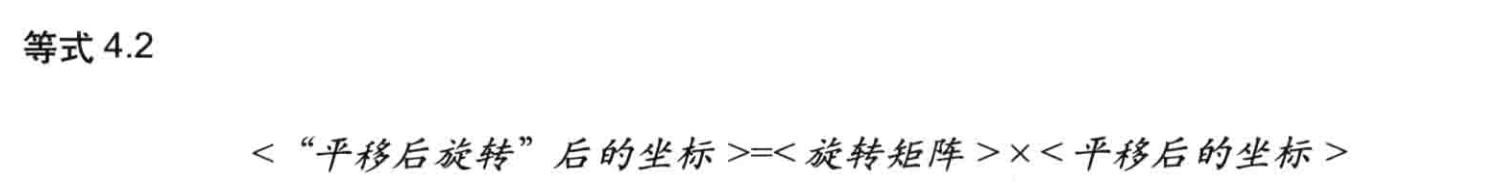

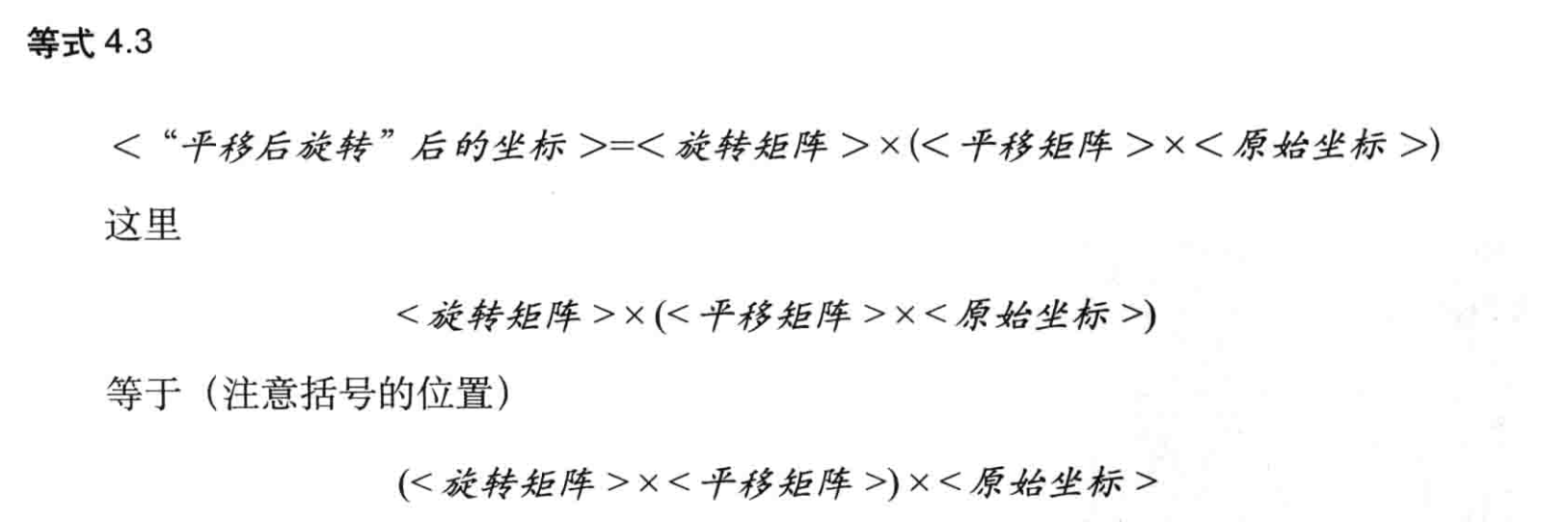

复合变换

下面就来看看如何将两次变换组合起来,即先进行一次平移,再进行一次旋转。

显然,示例中包含了以下两种变换,如图4.3所示:

- 将三角形沿着X轴平移一段距离。

- 在此基础上,旋转三角形。

讲解了这么多,我们可以先写下第1条(平移操作)中的坐标方程式。

然后对<平移后的坐标>进行旋转。

当然你也可以分步计算这两个等式,但更好的方法是,将等式41代入到等式42中,把两个等式组合起来:

最后,我们可以在JavaScript中计算<旋转矩阵>x<平移矩阵>,然后将得到的矩阵传人顶点着色器。像这样,我们就可以把多个变换复合起来了。一个模型可能经过了多次变换,将这些变换全部复合成一个等效的变换,就得到了模型变换(modeltransformation),或称建模变换(modeling transformation),相应地,模型变换的矩阵称为模型矩阵 (model matrix)。

动画

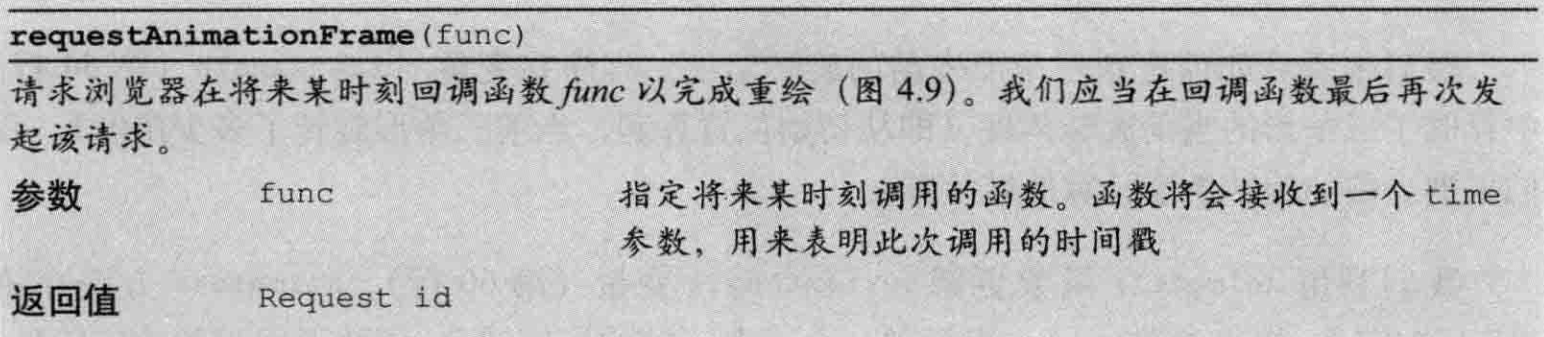

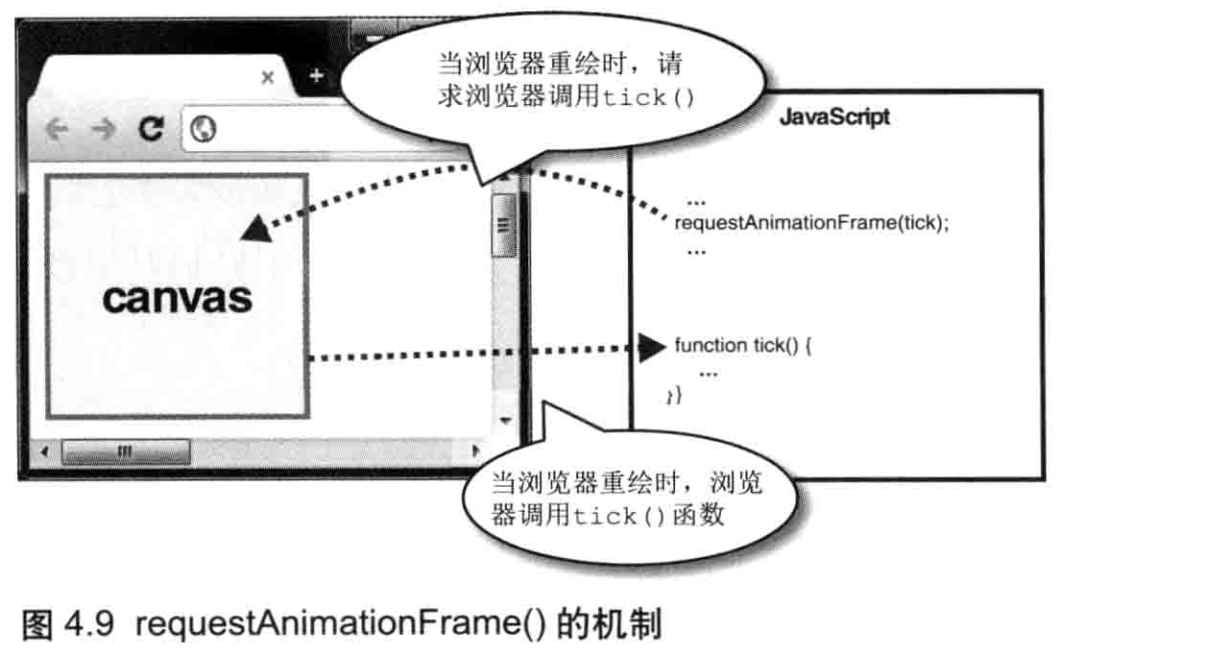

请求再次被调用(requestAnimationFrame())

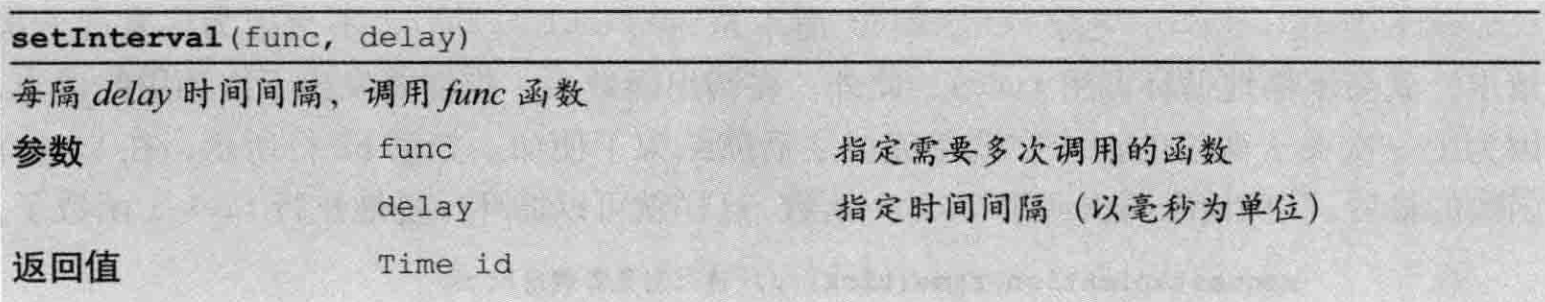

传统习惯上来说,如果你想要JavaScript重复执行某个特定的任务(函数),你可以使用setInterval()函数。

现代的浏览器都支持多个标签页,每个标签页具有单独的 JavaScript 运行环境,但是自 setInterval() 函数诞生之初,浏览器还没有开始支持多标签页。所以在现代浏览器中,不管标签页是否被激活,其中的 setInterval()函数函数都会反复调用 func,如果标签页比较多,就会增加浏览器的负荷。所以后来,浏览器又引入了requestAnimation()方法,该方法只有当标签页处于激活状态时才会生效。requestAnimationFrame()是新引入的方法,还没有实现标准化。好在Google提供的webgl-utilsjs库提供了该函数的定义并隐藏了浏览器间的差异。

使用这个函数的好处是可以避免在未激活的标签页上运行动画。注意,你无法指定重复调用的间隔;函数 func(第1个参数)会在浏览器需要网页的某个元素(第2个参数)重绘时被调用。此外还需要注意,在浏览器成功(找到了适当的时机)地调用了一次 func 后,想要再次调用它,就必须再次发起请求,因为前一次请求已经结束(也就是说,requestAnimationFrame 更像 setTimeOut 不是 setTimeInterval,不会因为你发起一次请求,就会不停地循环调用 func)。此外,在调用函数后,你需要发出下次调用的请求,因为上一次关于调用的请求在调用完成之后就结束了使命。

如果你想取消请求,需要使用 cancelAnimationFrame()

颜色与纹理

本节将介绍一下内容:

- 顶点的其他 (非坐标)数据一如颜色等一传人顶点着色器;

- 发生在顶点着色器和片元着色器之间的从图形到片元的转化,又称为图元光栅化(rasterzation process).

- 将图像 (或称纹理)映射到图形或三维对象的表面上

将非坐标数据传入顶点着色器

通过创建多个缓冲区对象将多个不同顶点数据传入顶点着色器

示例为传入顶点数据

// MultiAttributeSize.js (c) 2012 matsuda

// Vertex shader program

var VSHADER_SOURCE =

'attribute vec4 a_Position;\n' +

'attribute float a_PointSize;\n' +

'void main() {\n' +

' gl_Position = a_Position;\n' +

' gl_PointSize = a_PointSize;\n' +

'}\n';

// Fragment shader program

var FSHADER_SOURCE =

'void main() {\n' +

' gl_FragColor = vec4(1.0, 0.0, 0.0, 1.0);\n' +

'}\n';

function main() {

// Retrieve <canvas> element

var canvas = document.getElementById('webgl');

// Get the rendering context for WebGL

var gl = getWebGLContext(canvas);

if (!gl) {

console.log('Failed to get the rendering context for WebGL');

return;

}

// Initialize shaders

if (!initShaders(gl, VSHADER_SOURCE, FSHADER_SOURCE)) {

console.log('Failed to intialize shaders.');

return;

}

// Set the vertex information

var n = initVertexBuffers(gl);

if (n < 0) {

console.log('Failed to set the positions of the vertices');

return;

}

// Specify the color for clearing <canvas>

gl.clearColor(0.0, 0.0, 0.0, 1.0);

// Clear <canvas>

gl.clear(gl.COLOR_BUFFER_BIT);

// Draw three points

gl.drawArrays(gl.POINTS, 0, n);

}

function initVertexBuffers(gl) {

var vertices = new Float32Array([

0.0, 0.5, -0.5, -0.5, 0.5, -0.5

]);

var n = 3;

var sizes = new Float32Array([

10.0, 20.0, 30.0 // Point sizes

]);

// Create a buffer object

var vertexBuffer = gl.createBuffer();

var sizeBuffer = gl.createBuffer();

if (!vertexBuffer || !sizeBuffer) {

console.log('Failed to create the buffer object');

return -1;

}

// Write vertex coordinates to the buffer object and enable it

gl.bindBuffer(gl.ARRAY_BUFFER, vertexBuffer);

gl.bufferData(gl.ARRAY_BUFFER, vertices, gl.STATIC_DRAW);

var a_Position = gl.getAttribLocation(gl.program, 'a_Position');

if(a_Position < 0) {

console.log('Failed to get the storage location of a_Position');

return -1;

}

gl.vertexAttribPointer(a_Position, 2, gl.FLOAT, false, 0, 0);

gl.enableVertexAttribArray(a_Position);

// Bind the point size buffer object to target

gl.bindBuffer(gl.ARRAY_BUFFER, sizeBuffer);

gl.bufferData(gl.ARRAY_BUFFER, sizes, gl.STATIC_DRAW);

var a_PointSize = gl.getAttribLocation(gl.program, 'a_PointSize');

if(a_PointSize < 0) {

console.log('Failed to get the storage location of a_PointSize');

return -1;

}

gl.vertexAttribPointer(a_PointSize, 1, gl.FLOAT, false, 0, 0);

gl.enableVertexAttribArray(a_PointSize);

// Unbind the buffer object

gl.bindBuffer(gl.ARRAY_BUFFER, null);

return n;

}

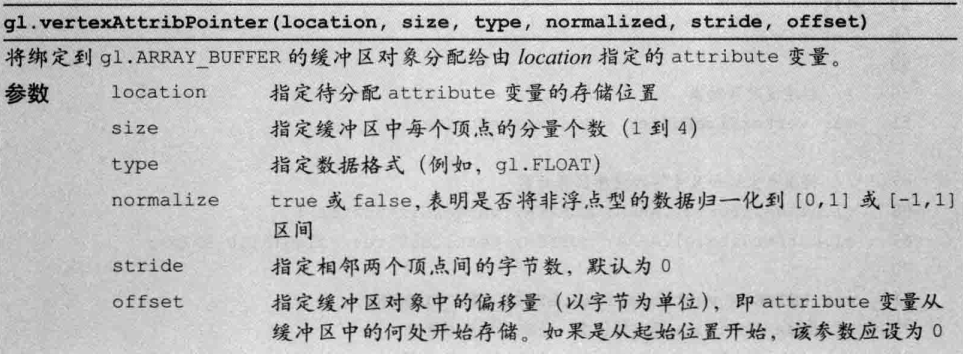

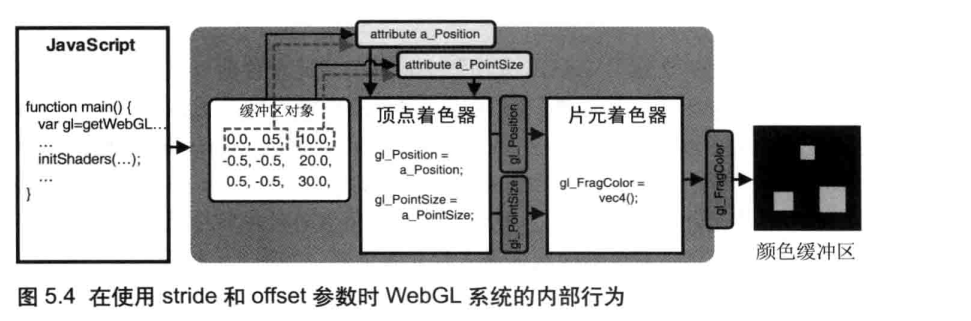

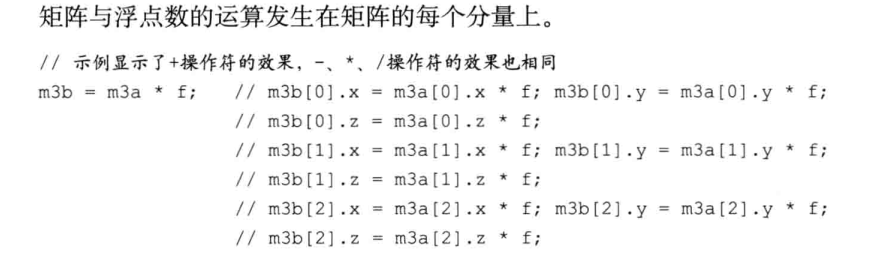

gl.vertexAttribPointer() 的步进和偏移参数

使用多个缓冲区对象向着色器传递多种数据,比较适合数据量不大的情况。当程序中的复杂三维图形具有成千上万个顶点时,维护所有的顶点数据是很困难的。然而,WebGL 允许我们把顶点的坐标和尺寸数据打包到同一个缓冲区对象中,并通过某种机制分别访问缓冲区对象中不同种类的数据。比如,可以将顶点的坐标和尺寸数据按照如下方式交错组织(interleaving),如例 5.2 所示 :

可见,一旦我们将几种“逐顶点”的数据 (坐标和尺寸)交叉存储在一个数组中,并将数组写人一个缓冲区对象。WebGL就需要有差别地从缓冲区中获取某种特定数据(坐标或尺寸),即使用gl.vertexAttribPointer()函数的第5个参数stride和第6个参数offset。下面让我们来看看示例程序。

// MultiAttributeSize_Interleaved.js (c) 2012 matsuda

// Vertex shader program

var VSHADER_SOURCE =

'attribute vec4 a_Position;\n' +

'attribute float a_PointSize;\n' +

'void main() {\n' +

' gl_Position = a_Position;\n' +

' gl_PointSize = a_PointSize;\n' +

'}\n';

// Fragment shader program

var FSHADER_SOURCE =

'void main() {\n' +

' gl_FragColor = vec4(1.0, 0.0, 0.0, 1.0);\n' +

'}\n';

function main() {

// Retrieve <canvas> element

var canvas = document.getElementById('webgl');

// Get the rendering context for WebGL

var gl = getWebGLContext(canvas);

if (!gl) {

console.log('Failed to get the rendering context for WebGL');

return;

}

// Initialize shaders

if (!initShaders(gl, VSHADER_SOURCE, FSHADER_SOURCE)) {

console.log('Failed to intialize shaders.');

return;

}

// Set vertex coordinates and point sizes

var n = initVertexBuffers(gl);

if (n < 0) {

console.log('Failed to set the vertex information');

return;

}

// Specify the color for clearing <canvas>

gl.clearColor(0.0, 0.0, 0.0, 1.0);

// Clear <canvas>

gl.clear(gl.COLOR_BUFFER_BIT);

// Draw three points

gl.drawArrays(gl.POINTS, 0, n);

}

function initVertexBuffers(gl) {

var verticesSizes = new Float32Array([

// 顶点坐标和点的尺寸

0.0, 0.5, 10.0, // 第一个点

-0.5, -0.5, 20.0, // 第二个点

0.5, -0.5, 30.0 // 第三个点

]);

var n = 3; // The number of vertices

// Create a buffer object

var vertexSizeBuffer = gl.createBuffer();

if (!vertexSizeBuffer) {

console.log('Failed to create the buffer object');

return -1;

}

// 绑定缓冲区对象到目标,并写入数据

gl.bindBuffer(gl.ARRAY_BUFFER, vertexSizeBuffer);

gl.bufferData(gl.ARRAY_BUFFER, verticesSizes, gl.STATIC_DRAW);

// 获取类型化数组中每个元素所占的字节数

var FSIZE = verticesSizes.BYTES_PER_ELEMENT;

//Get the storage location of a_Position, assign and enable buffer

var a_Position = gl.getAttribLocation(gl.program, 'a_Position');

if (a_Position < 0) {

console.log('Failed to get the storage location of a_Position');

return -1;

}

gl.vertexAttribPointer(a_Position, 2, gl.FLOAT, false, FSIZE * 3, 0);

gl.enableVertexAttribArray(a_Position); // Enable the assignment of the buffer object

// Get the storage location of a_PointSize

var a_PointSize = gl.getAttribLocation(gl.program, 'a_PointSize');

if(a_PointSize < 0) {

console.log('Failed to get the storage location of a_PointSize');

return -1;

}

gl.vertexAttribPointer(a_PointSize, 1, gl.FLOAT, false, FSIZE * 3, FSIZE * 2);

gl.enableVertexAttribArray(a_PointSize); // Enable buffer allocation

// Unbind the buffer object

gl.bindBuffer(gl.ARRAY_BUFFER, null);

return n;

}

首先,我们定义了一个类型化数组 verticesSizes 接下来创建缓冲区对象 。然后,我们将 verticeSize 数组中每个元素的大小 (字节数)存储到 FSIZE 中,稍后将会用到它。类型化数组具有BYTES_PER_ELEMENT属性,可以从中获知数组中每个元素所占的字节数。

现在,我们就需要着手把缓冲区对象分配给 attribute 变量了。首先获取 attribute变量a_Position 的存储地址,方法和之前完全相同,然后调gl.vertexAttribPointer() 函数。注意,这里的参数设置就与前例有所不同了因为在缓冲区对象中存储了两种类型的数据:顶点坐标和顶点尺寸。

在第3章中曾提到过 gl.vertexAttribpointer() 的函数规范,但是让我们再来看一下其参数sride 和 offset。

参数 stride 表示,在缓冲区对象中,单个顶点的所有数据 (这里,就是顶点的坐标和大小)的字数,也就是相邻两个顶点间的距离,即步进参数。

在前面的示例程序中,缓冲区只含有一种数据,即顶点的坐标,所以将其设置为 0即可。然而,在本例中,当缓冲区中有了多种数据(比如此例中的顶点坐标和顶点尺寸时,我们就需要考虑 stride 的值,如下图所示。

如图 5.3 所示,每一个顶点有3 个数据值 (两个坐标数据和一个尺寸数据),因此stride 应该设置为每项数据大小的三倍,即 3xESIZE(Eloat32Array 中每个元素所占的字节数)。

参数 ofser 表示当前考虑的数据项距离首个元素的距离,即偏移参数。在verticesSizes 数组中,顶点的坐标数据是放在最前面的,所以 ofser 应当为 0。因此我们调用 gl.vertexAttribArray() 函数时,如下所示传人stride 参数和offset参数。

gl.vertexAttribPointer(a_Position, 2, gl.FLOAT, false, FSIZE * 3, 0);

gl.enableVertexAttribArray(a_Position);

这样一来,我们就把缓冲区中的那部分顶点坐标数据分配给了着色器中的 attribute变量a_Position。

接下来对顶点尺寸数据采取相同的操作:将缓冲区对象中的顶点尺寸数据分配给 apointsize。然而在这个例子中,缓冲区对象还是原来那个,只不过这次关注的数据不同,我们需要将 offset 参数设置为顶点尺寸数据在缓冲区对象中的初始位置。在关于某个顶点的三个值中,前两个是顶点坐标,后一个是顶点尺寸,因此 offset应当设置为 ESIZE*2(参见图 5.3)。我们如下调用 gl.vertexAttribArray() 函数,并正确设置stride 参数和 offset参数。

gl.vertexAttribPointer(a_PointSize, 1, gl.FLOAT, false, FSIZE * 3, FSIZE * 2);

gl.enableVertexAttribArray(a_PointSize)

再次执行顶点着色器时,WebGL 系统会根据stride和 ofset 参数,从缓冲区中正确地抽取出数据,依次赋值给着色器中的各个 attribute 变量,并进行绘制 (如图 5.4 所示)。

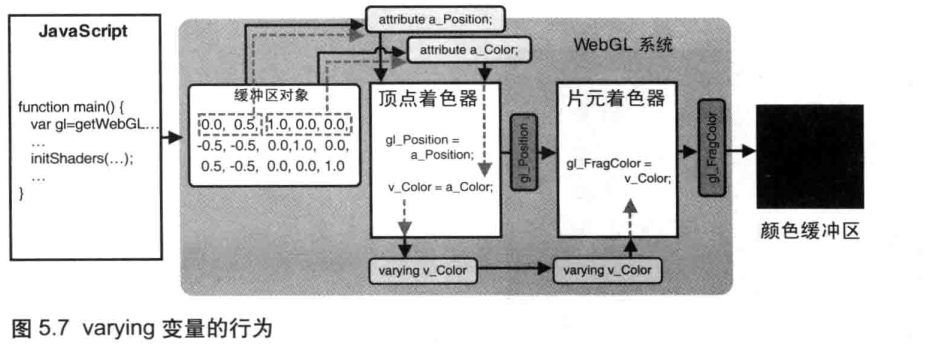

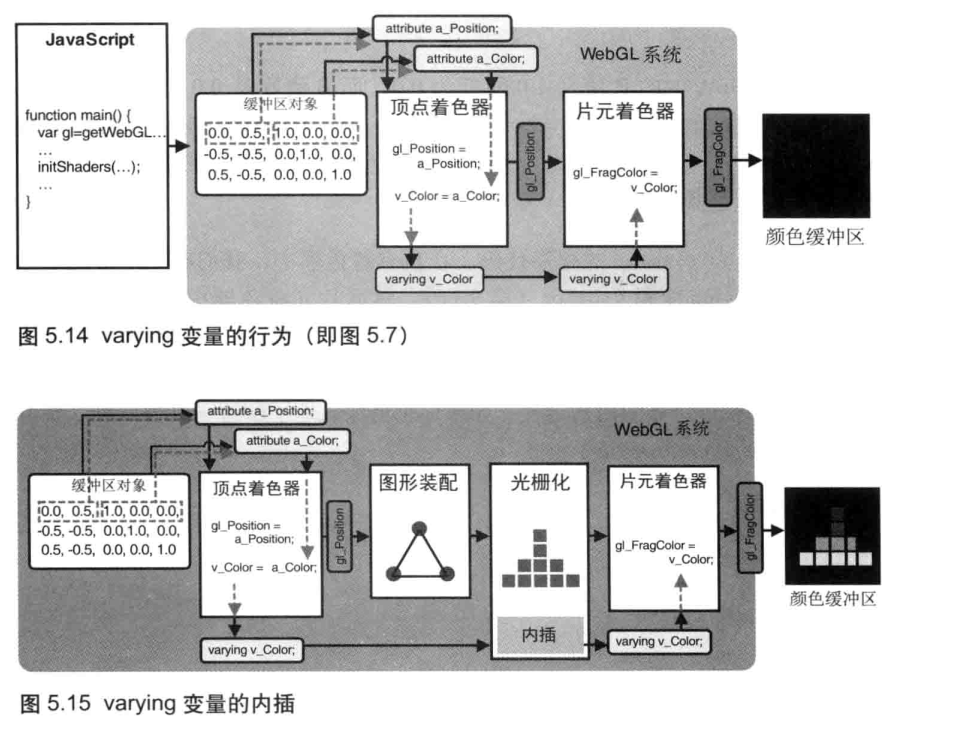

修改颜色(varying 变量)

片元着色器可以用来处理颜色之类的属性。但是到目前为止,我们都只是在片元着色器中静态地设置颜色,还没有真正地研究过片元着色器。虽然现在已经能够将顶点的颜色数据从 JavaScript 中传给顶点着色器中的 attribute 变量,但是真正能够影响绘制颜色的 gl_FragColor 却在片元着色器中。我们需要知道顶点着色器和片元着色器是如何交流的,这样才能使传人顶点着色器的数据进入片元着色器,如图 5.6 所示。

我们之前使用了一个uniform变量来将颜色信息传人片元着色器然而,因为这是个“一致的”(uniform)变量,而不是“可变的”(varying),我们没法为每个顶点都准备一个值,所以那个程序中的所有顶点都只能是同一个颜色。我们使用种新的 varying 变量(varying variable)向片元着色器中传入数据,实际上.varying 变量的作用是从顶点着色器向片元着色器传输数据。

// MultiAttributeColor.js (c) 2012 matsuda

// Vertex shader program

var VSHADER_SOURCE =

'attribute vec4 a_Position;\n' +

'attribute vec4 a_Color;\n' +

'varying vec4 v_Color;\n' + // varying变量

'void main() {\n' +

' gl_Position = a_Position;\n' +

' gl_PointSize = 10.0;\n' +

' v_Color = a_Color;\n' + // 将数据传给片元着色器

'}\n';

// Fragment shader program

var FSHADER_SOURCE =

'precision mediump float;\n' + // Precision qualifier (See Chapter 6)

'varying vec4 v_Color;\n' + // 从顶点着色器接收数据

'void main() {\n' +

' gl_FragColor = v_Color;\n' +

'}\n';

function main() {

// Retrieve <canvas> element

var canvas = document.getElementById('webgl');

// Get the rendering context for WebGL

var gl = getWebGLContext(canvas);

if (!gl) {

console.log('Failed to get the rendering context for WebGL');

return;

}

// Initialize shaders

if (!initShaders(gl, VSHADER_SOURCE, FSHADER_SOURCE)) {

console.log('Failed to intialize shaders.');

return;

}

//

var n = initVertexBuffers(gl);

if (n < 0) {

console.log('Failed to set the vertex information');

return;

}

// Specify the color for clearing <canvas>

gl.clearColor(0.0, 0.0, 0.0, 1.0);

// Clear <canvas>

gl.clear(gl.COLOR_BUFFER_BIT);

// Draw three points

gl.drawArrays(gl.POINTS, 0, n);

}

function initVertexBuffers(gl) {

var verticesColors = new Float32Array([

// Vertex coordinates and color

0.0, 0.5, 1.0, 0.0, 0.0,

-0.5, -0.5, 0.0, 1.0, 0.0,

0.5, -0.5, 0.0, 0.0, 1.0,

]);

var n = 3; // The number of vertices

// Create a buffer object

var vertexColorBuffer = gl.createBuffer();

if (!vertexColorBuffer) {

console.log('Failed to create the buffer object');

return false;

}

// Write the vertex coordinates and colors to the buffer object

gl.bindBuffer(gl.ARRAY_BUFFER, vertexColorBuffer);

gl.bufferData(gl.ARRAY_BUFFER, verticesColors, gl.STATIC_DRAW);

var FSIZE = verticesColors.BYTES_PER_ELEMENT;

//Get the storage location of a_Position, assign and enable buffer

var a_Position = gl.getAttribLocation(gl.program, 'a_Position');

if (a_Position < 0) {

console.log('Failed to get the storage location of a_Position');

return -1;

}

gl.vertexAttribPointer(a_Position, 2, gl.FLOAT, false, FSIZE * 5, 0);

gl.enableVertexAttribArray(a_Position); // Enable the assignment of the buffer object

// Get the storage location of a_Position, assign buffer and enable

var a_Color = gl.getAttribLocation(gl.program, 'a_Color');

if(a_Color < 0) {

console.log('Failed to get the storage location of a_Color');

return -1;

}

gl.vertexAttribPointer(a_Color, 3, gl.FLOAT, false, FSIZE * 5, FSIZE * 2);

gl.enableVertexAttribArray(a_Color); // Enable the assignment of the buffer object

return n;

}

在顶点着色器中,我们声明了 attribute 变量a_color 用以接收颜色数据.然后声明了新的varying变量v_color,该变量负责将颜色值将被传给片元着色器。注意,varying 变量只能是 float (以及相关的vec2,vec3,vec4,mat2,mat3和 mat4)类型的。

我们将 a_color 变量的值直接赋给之前声明的 v_color 变量。

那么,片元着色器该如何接收这个变量呢?答案很简单,只需要在片元着色器中也声明一个 (与顶点着色器中的那个 varying 变量同名) varying 变量就可以了

在 WebGL 中,如果顶点着色器与片元着色器中有类型和命名都相同的 varying 变量,那么顶点着色器赋给该变量的值就会被自动地传入片元着色器.如图 5.7 所示。

彩色三角形(ColoredTriangle.js)

这一节,我们将为三角形的每个顶点指定一个颜色,然后 WebGL 会自动在三角形表面产生颜色平滑过渡的效果。

几何形状的装配和光栅化

以第三章的HelloTriangle的示例(绘制一个红色三角形)为例;

// HelloTriangle.js (c) 2012 matsuda

// Vertex shader program

var VSHADER_SOURCE =

'attribute vec4 a_Position;\n' +

'void main() {\n' +

' gl_Position = a_Position;\n' +

'}\n'

// Fragment shader program

var FSHADER_SOURCE =

'void main() {\n' + ' gl_FragColor = vec4(1.0, 0.0, 0.0, 1.0);\n' + '}\n'

function main() {

// Retrieve <canvas> element

var canvas = document.getElementById('webgl')

// Get the rendering context for WebGL

var gl = getWebGLContext(canvas)

if (!gl) {

console.log('Failed to get the rendering context for WebGL')

return

}

// Initialize shaders

if (!initShaders(gl, VSHADER_SOURCE, FSHADER_SOURCE)) {

console.log('Failed to intialize shaders.')

return

}

// Write the positions of vertices to a vertex shader

var n = initVertexBuffers(gl)

if (n < 0) {

console.log('Failed to set the positions of the vertices')

return

}

// Specify the color for clearing <canvas>

gl.clearColor(0, 0, 0, 1)

// Clear <canvas>

gl.clear(gl.COLOR_BUFFER_BIT)

// Draw the rectangle

gl.drawArrays(gl.LINE_LOOP, 0, n)

}

function initVertexBuffers(gl) {

var vertices = new Float32Array([0, 0.5, -0.5, -0.5, 0.5, -0.5])

var n = 3 // The number of vertices

// Create a buffer object

var vertexBuffer = gl.createBuffer()

if (!vertexBuffer) {

console.log('Failed to create the buffer object')

return -1

}

// Bind the buffer object to target

gl.bindBuffer(gl.ARRAY_BUFFER, vertexBuffer)

// Write date into the buffer object

gl.bufferData(gl.ARRAY_BUFFER, vertices, gl.STATIC_DRAW)

var a_Position = gl.getAttribLocation(gl.program, 'a_Position')

if (a_Position < 0) {

console.log('Failed to get the storage location of a_Position')

return -1

}

// Assign the buffer object to a_Position variable

gl.vertexAttribPointer(a_Position, 2, gl.FLOAT, false, 0, 0)

// Enable the assignment to a_Position variable

gl.enableVertexAttribArray(a_Position)

return n

}

我们在 initvertexBuffers()函数中将顶点坐标写人了缓冲区对象,然后将缓冲区对象分配给a_Position 变量。最后调用 gl.drawArrays()执行顶点着色器。当顶点着色器执行时,缓冲区中的三个顶点坐标依次传给了a_Position 变量,再赋值给 gl_Position,这样 WebGL 系统就可以根据顶点坐标进行绘制。在片元着色器中,我们将红色的 RGBA 值(1.0,0.0,0.0,1.0)赋给gl_EragColor,这样就画出了一个红色的三角形。

可是直到现在,你还是不明白这究竟是如何做到的?在你向 gl_Position 给出了三角形的三个顶点的坐标时,片元着色器又怎样才能进行所谓的逐片元操作呢?

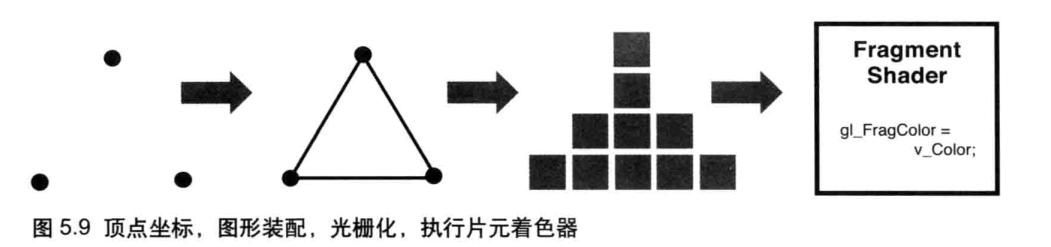

如图 5.9 显示了问题所在,程序向 gl_Position 给出了三个顶点的坐标,谁来确定这三个点就是三角形的三个顶点?最终,为了填充三角形内部,谁来确定哪些像素需要被着色?谁来负责调用片元着色器,片元着色器又是怎样处理每个片元的?

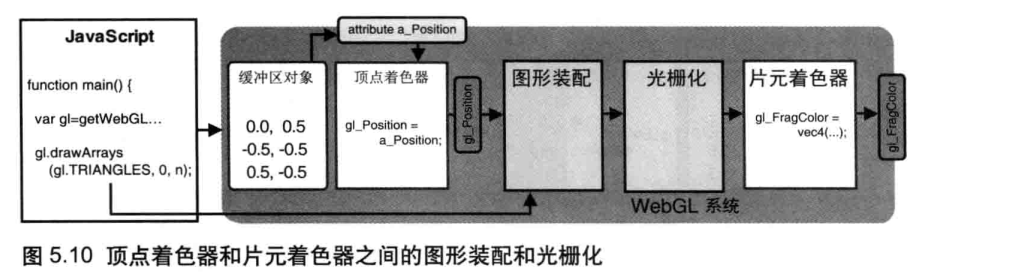

实际上,在顶点着色器和片元着色器之间,有这样两个步骤,如图 5.10 所示。

图形装配过程:这一步的任务是,将孤立的顶点坐标装配成几何图形。几何图形的类别由gl.drawArrays()函数的第一个参数决定。

光栅化过程:这一步的任务是,将装配好的几何图形转化为片元。

通过图5.10 你就会理解,gl_Position 实际上是几何图形装配(geometric shapeassembly)段的输人数据。注意,几何图形装配过程又被称为图元装配过程(primitiveassembly process),因为被装配出的基本图形 (点、线、面)又被称为图元(primitives)。

图5.11 显示了在 HelloTriangle.js 中,顶点着色器和片元着色器之间图形装配与光栅化的过程。

在例 5.5 中,gl.drawArrays() 的参数n为3,顶点着色器将被执行 3 次。

第 1步:执行顶点着色器,缓冲区对象中的第 1个坐标(0.0,0.5) 被传递给 attribute变量a_Position。 一旦一个顶点的坐标被赋值给了gl_Position,它就进入了图形装配区域,并暂时储存在那里。你应该还记得,我们仅仅显式地向 a_Position 赋了x分量和y分量,所以向z分量和 w 分量赋的是默认值进入图形装配区域的坐标其实是(0.0,0.5,0.0,1.0)。

第2步:再次执行顶点着色器,类似地,将第 2 个坐标(-0.5,-0.5,0.0,1.0) 传入并储存在装配区。

第3步:第3 次执行顶点着色器,将第3 个坐标(0.5,-0.5,0.0,1.0) 传入并储存在装配区。现在,顶点着色器执行完毕,三个顶点坐标都已经处在装配区了。

第 4步:开始装配图形。使用传人的点坐标,根据 gl.drawArrays() 的第一个参数信息 (gl.TRIANGLES)来决定如何装配。本例使用三个顶点来装配出一个三角形。

第 5步:显示在屏幕上的三角形是由片元 (像素) 组成的,所以还需要将图形转化为片元,这个过程被称为光栅化 (rasterization)。光栅化之后,我们就得到了组成这个三角形的所有片元。在图 5.11 中的最后一步,你可以看到光栅化后得到的组成三角形的片元。

上图为了示意,只显示了10个片元, 片元数目就是这个三角形最终在屏幕。实际上上所覆盖的像素数。如果修改了gl.drawArrays()的第 1 个参数,那么第 4 步的图形装配、第 5 步的片元数目和位置就会相应地变化。比如说,如果这个参数是 gI.LINE,程序就会使用前两个点装配出一条线段,舍弃第 3 个点;如果是 gl.LINE LOOP,程序就会将三个点装配成为首尾相接的折线段,并光栅化出一个空心的的三角形(不产生中间的像素)。

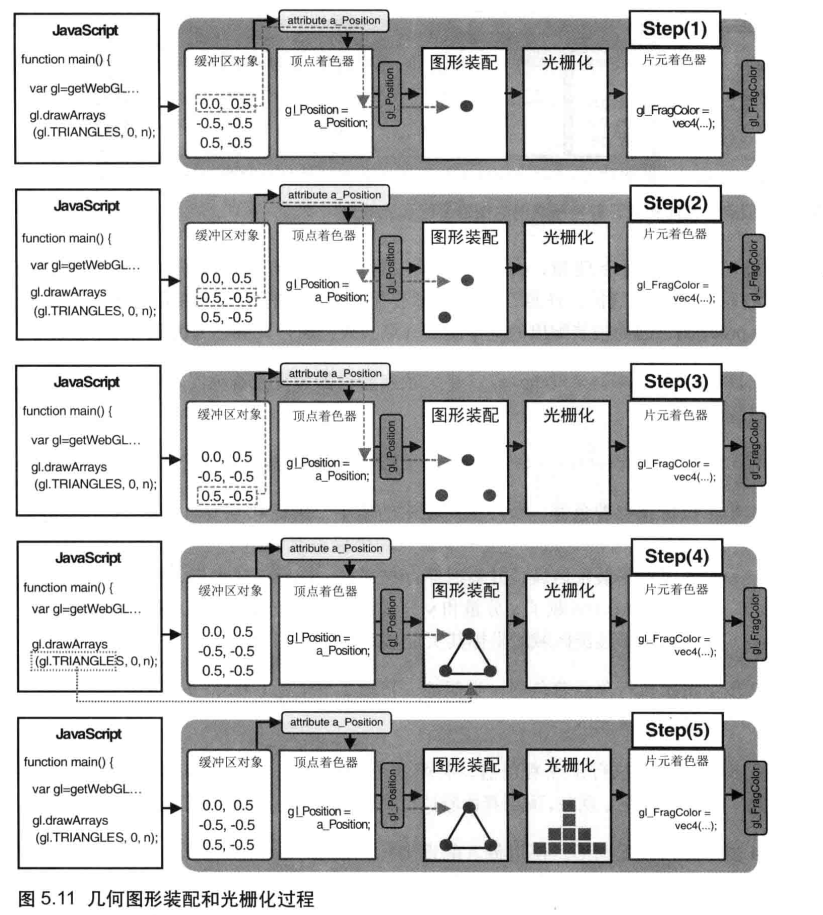

调用片元着色器

一旦光栅化过程结束后,程序就开始逐片元调用片元着色器。在图 5.12 中,片元着色器被调用了 10 次,每调用一次,就处理一个片元 (为了整洁,图5.12 省略了中间步骤)。对于每个片元,片元着色器计算出该片元的颜色,并写入颜色缓冲区。直到第 15 步最后一个片元被处理完成,浏览器就会显示出最终的结果

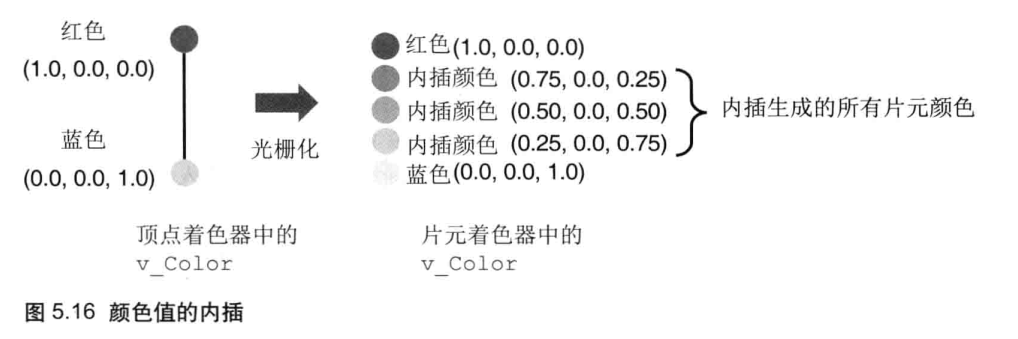

varying 变量的作用和内插过程

回到图 5.8的 coloredTriangle 程序,这个程序也可以用刚学到的知识来解释为什么在顶点着色器中只是指定了每个顶点的颜色,最后得到了一个具有渐变色彩效果的三角形呢?事实上,我们把顶点的颜色赋值给了顶点着色器中的 varying 变量v_color,它的值被传给片元着色器中的同名、同类型变量 (即片元着色器中的 varying变量v_color),如图 5.14 所示。但是,更准确地说,顶点着色器中的 v_color 变量在传入片元着色器之前经过了内插过程。所以,片元着色器中的v_color 变量和顶点着色器中的v_color 变量实际上并不是一回事,这也正是我们将这种变量称为“varying”(变化的)变量的原因.

更准确地说,在 ColoredTriangle 中,我们在 varying变量中为三角形的3个不同顶点指定了 3 种不同颜色,而三角形表面上这些片元的颜色值都是 WebGL 系统用这3 个顶点的颜色内插出来的。

例如,考虑一条两个端点的颜色不同的线段。一个端点的颜色为红色 (1.0,0.0,0.0),而另一个端点的颜色为蓝色(0.0,0.0,1.0)。我们在顶点着色器中向 varying变量v_color赋上这两个颜色 (红色和蓝色),那么 WebGL 就会自动地计算出线段上的所有点 (片元)的颜色,并赋值给片元着色器中的 varying 变量v_color (如图 5.16 所示)。

在这个例子中 RGBA 中的R值从 1.0 降低为 0.0,而B值则从 0.0上升至 1.0,线段上的所有片元的颜色值都会被恰当地计算出来一这个过程就被称为内插过程(interpolation process)。一旦两点之间每个片元的新颜色都通过这种方式被计算出来后它们就会被传给片元着色器中的 v_color 变量。

再来看例 5.6 coloredTriangle 的程序代码。在顶点着色器中,我们将三角形的3个顶点的颜色赋给了 varying变量v_color ,然后片元着色器中的 varying变量v_color 就接收到了内插之后的片元颜色。在片元着色器中,我们把片元的颜色赋值给gl_Eragcolor 变量,这样就绘制出了一个彩色的三角形,如图5.8 所示。每个 varying 变量都会经过这样的内插过程。如果你想更深入地了解这一过程,可以参考《计算机图形学》(Computer Graphics)一书。

总之,这一节着重讲述了顶点着色器和片元着色器之间的过程。光栅化是三维图形学的关键技术之一,它负责将矢量的几何图形转变为栅格化的片元 (像素)。图形被转化为片元之后,我们就可以在片元着色器内做更多的事情,如为每个片元指定不同的颜色。颜色可以内插出来,也可以直接编程指定。

在矩形表面贴上图像

在前一节中,我们了解了如何绘制彩色的图形,如何内插出平滑的颜色渐变效果。虽然这种方法很强大,但在更复杂的情况下仍然不够用。比如说,如果你想创建一张逼真的砖墙,问题就来了。你可能会试图创建很多个三角形,指定它们的颜色和位置来模拟墙面上的坑坑洼洼。如果你真这么做了,那就陷人了繁琐和无意义的苦海中。

你可能已经知道,在三维图形学中,有一项很重要的技术可以解决这个问题,那就是纹理映射(texture mapping)。纹理映射其实非常简单,就是将一张图像 (就像一张贴纸)映射 (贴) 到一个几何图形的表面上去。将一张真实世界的图片贴到一个由两个三角形组成的矩形上,这样矩形表面看上去就是这张图片。此时,这张图片又可以称为纹理图像(texture image)或纹理(texture)。

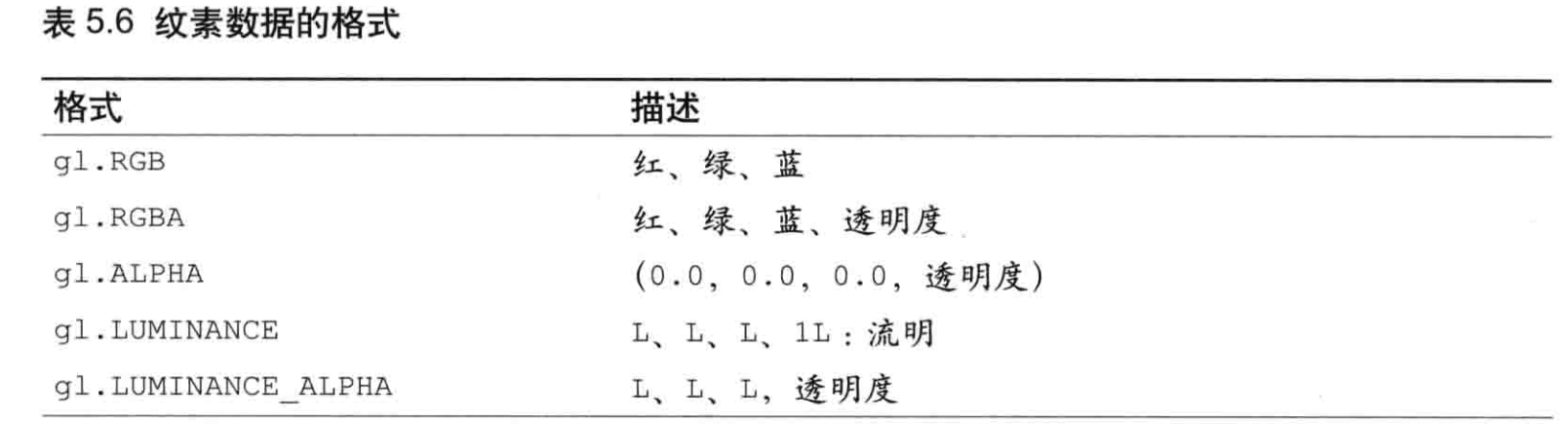

纹理映射的作用,就是根据纹理图像,为之前光栅化后的每个片元涂上合适的颜色。组成纹理图像的像素又被称为纹素(texels,texture elements),每一个纹素的颜色都使用RGB 或 RGBA 格式编码,如图 5.18 所示。

在 WebGL 中,要进行纹理映射,需遵循以下四步:

- 准备好映射到几何图形上的纹理图像。

- 为几何图形配置纹理映射方式。

- 加载纹理图像,对其进行一些配置,以在WebGL中使用它。

- 在片元着色器中将相应的纹素从纹理中抽取出来,并将纹素的颜色赋给片元。

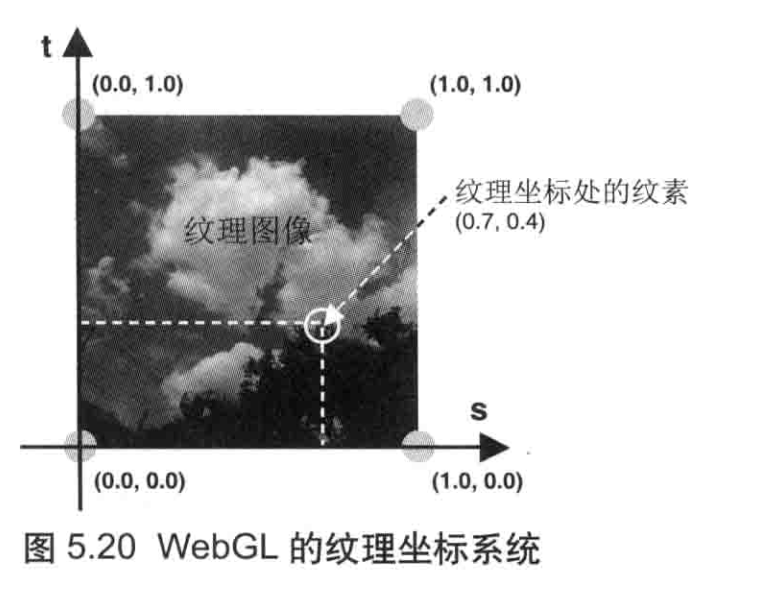

纹理坐标

第 2 步指定映射方式,就是确定“几何图形的某个片元”的颜色如何取决于“纹理图像中哪个 (或哪几个)像素”的问题(即前者到后者的映射)。我们利用图形的顶点坐标来确定屏幕上哪部分被纹理图像覆盖,使用纹理坐标(texture coordinates)来确定纹理图像的哪部分将覆盖到几何图形上。纹理坐标是一套新的坐标系统。

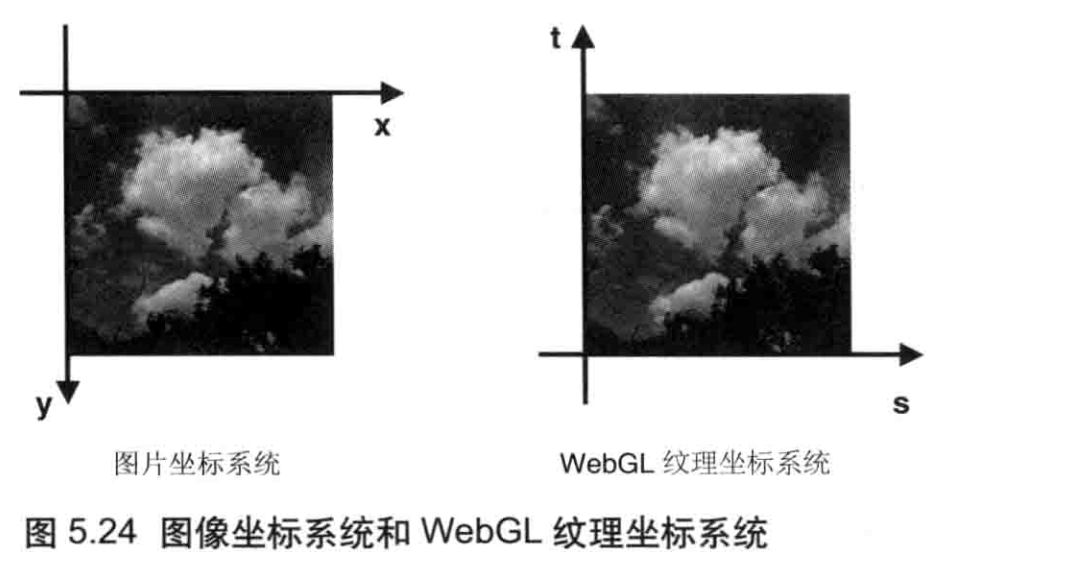

纹理坐标是纹理图像上的坐标,通过纹理坐标可以在纹理图像上获取纹素颜色。WebGL 系统中的纹理坐标系统是二维的,如图 5.20 所示。为了将纹理坐标和广泛使用的x坐标和y坐标区分开来,WebGL 使用 s 和t命名纹理坐标 (st 坐标系统)

如图 5.20 所示,纹理图像四个角的坐标为左下角 (0.0,0.0),右下角(1.0,0.0),右上角(1.0,1.0) 和左上角(0.0,1.0)。纹理坐标很通用,因为坐标值与图像自身的尺寸无关不管是 128x 128 还是 128x256 的图像,其右上角的纹理坐标始终是(1.0,1.0)。

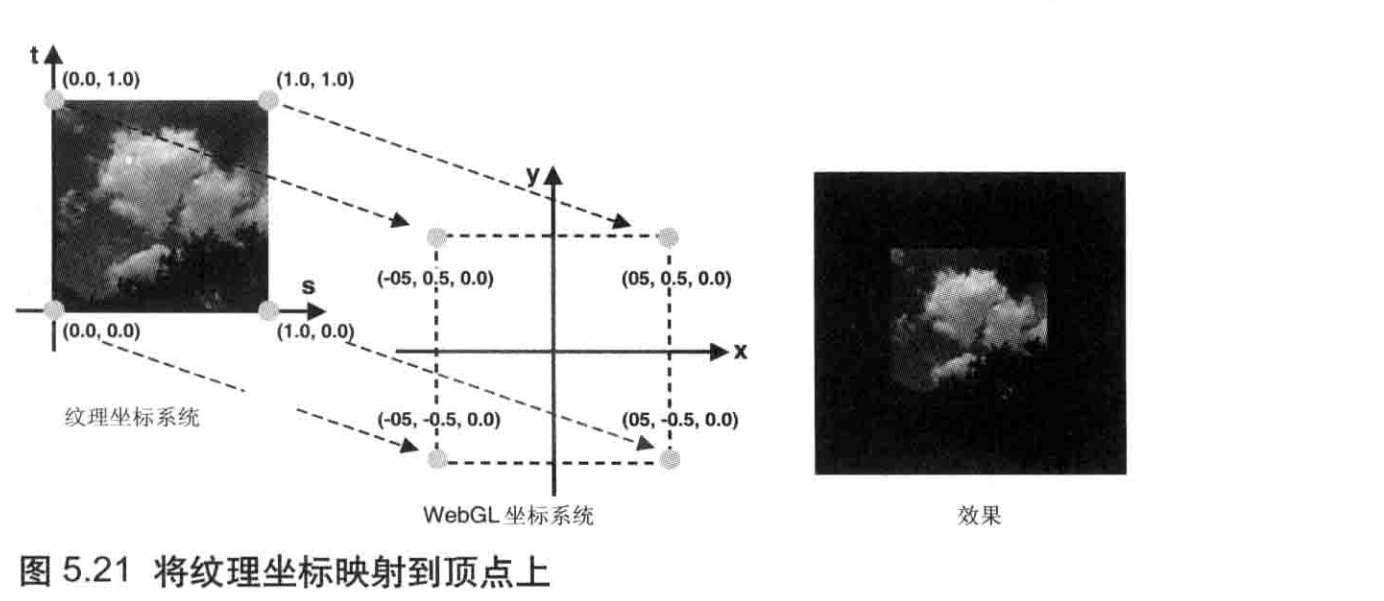

将纹理图像粘贴到几何图形上

如前所述,在 WebGL 中,我们通过纹理图像的纹理坐标与几何形体顶点坐标间的映射关系,来确定怎样将纹理图像贴上去,如图 5.21 所示。

在这里,我们将纹理坐标(0.0,1.0) 映射到顶点坐标(-0.5,-0.5,0.0) 上,将纹理坐标(1.0,1.0) 映射到顶点坐标 (0.5,0.5,0.0) 上,等等。通过建立矩形四个顶点与纹理坐标的对应关系,就获得了如图 5.21 (右)所示的结果

// TexturedQuad.js (c) 2012 matsuda and kanda

// Vertex shader program

var VSHADER_SOURCE =

'attribute vec4 a_Position;\n' +

'attribute vec2 a_TexCoord;\n' +

'varying vec2 v_TexCoord;\n' +

'void main() {\n' +

' gl_Position = a_Position;\n' +

' v_TexCoord = a_TexCoord;\n' +

'}\n';

// Fragment shader program

var FSHADER_SOURCE =

'#ifdef GL_ES\n' +

'precision mediump float;\n' +

'#endif\n' +

'uniform sampler2D u_Sampler;\n' +

'varying vec2 v_TexCoord;\n' +

'void main() {\n' +

' gl_FragColor = texture2D(u_Sampler, v_TexCoord);\n' +

'}\n';

function main() {

// Retrieve <canvas> element

var canvas = document.getElementById('webgl');

// Get the rendering context for WebGL

var gl = getWebGLContext(canvas);

if (!gl) {

console.log('Failed to get the rendering context for WebGL');

return;

}

// Initialize shaders

if (!initShaders(gl, VSHADER_SOURCE, FSHADER_SOURCE)) {

console.log('Failed to intialize shaders.');

return;

}

// 设置顶点信息

var n = initVertexBuffers(gl);

if (n < 0) {

console.log('Failed to set the vertex information');

return;

}

// Specify the color for clearing <canvas>

gl.clearColor(0.0, 0.0, 0.0, 1.0);

// 配置纹理

if (!initTextures(gl, n)) {

console.log('Failed to intialize the texture.');

return;

}

}

function initVertexBuffers(gl) {

var verticesTexCoords = new Float32Array([

// 顶点坐标, 纹理坐标

-0.5, 0.5, 0.0, 1.0,

-0.5, -0.5, 0.0, 0.0,

0.5, 0.5, 1.0, 1.0,

0.5, -0.5, 1.0, 0.0,

]);

var n = 4; // The number of vertices

// Create the buffer object

var vertexTexCoordBuffer = gl.createBuffer();

if (!vertexTexCoordBuffer) {

console.log('Failed to create the buffer object');

return -1;

}

// 将顶点坐标和纹理坐标写入缓冲区对象

gl.bindBuffer(gl.ARRAY_BUFFER, vertexTexCoordBuffer);

gl.bufferData(gl.ARRAY_BUFFER, verticesTexCoords, gl.STATIC_DRAW);

var FSIZE = verticesTexCoords.BYTES_PER_ELEMENT;

//Get the storage location of a_Position, assign and enable buffer

var a_Position = gl.getAttribLocation(gl.program, 'a_Position');

if (a_Position < 0) {

console.log('Failed to get the storage location of a_Position');

return -1;

}

gl.vertexAttribPointer(a_Position, 2, gl.FLOAT, false, FSIZE * 4, 0);

gl.enableVertexAttribArray(a_Position); // Enable the assignment of the buffer object

// Get the storage location of a_TexCoord

var a_TexCoord = gl.getAttribLocation(gl.program, 'a_TexCoord');

if (a_TexCoord < 0) {

console.log('Failed to get the storage location of a_TexCoord');

return -1;

}

// Assign the buffer object to a_TexCoord variable

gl.vertexAttribPointer(a_TexCoord, 2, gl.FLOAT, false, FSIZE * 4, FSIZE * 2);

gl.enableVertexAttribArray(a_TexCoord); // Enable the assignment of the buffer object

return n;

}

function initTextures(gl, n) {

var texture = gl.createTexture(); // 创建纹理对象

if (!texture) {

console.log('Failed to create the texture object');

return false;

}

// 获取 u_Sampler的存储位置

var u_Sampler = gl.getUniformLocation(gl.program, 'u_Sampler');

if (!u_Sampler) {

console.log('Failed to get the storage location of u_Sampler');

return false;

}

var image = new Image(); // 创建一个image对象

if (!image) {

console.log('Failed to create the image object');

return false;

}

// 注册图像加载事件的响应函数

image.onload = function(){ loadTexture(gl, n, texture, u_Sampler, image); };

// 浏览器开始加载图像

image.src = '../resources/sky.jpg';

return true;

}

function loadTexture(gl, n, texture, u_Sampler, image) {

gl.pixelStorei(gl.UNPACK_FLIP_Y_WEBGL, 1); // 对纹理图像进行y轴反转

// 开启0号纹理单元

gl.activeTexture(gl.TEXTURE0);

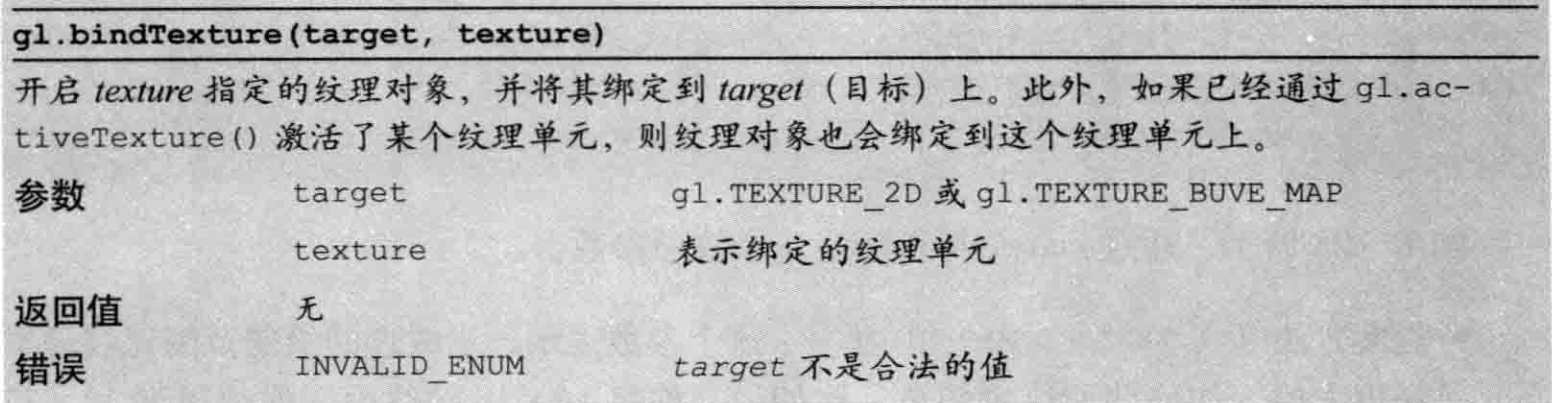

// 向target绑定纹理对象

gl.bindTexture(gl.TEXTURE_2D, texture);

// 配置纹理参数

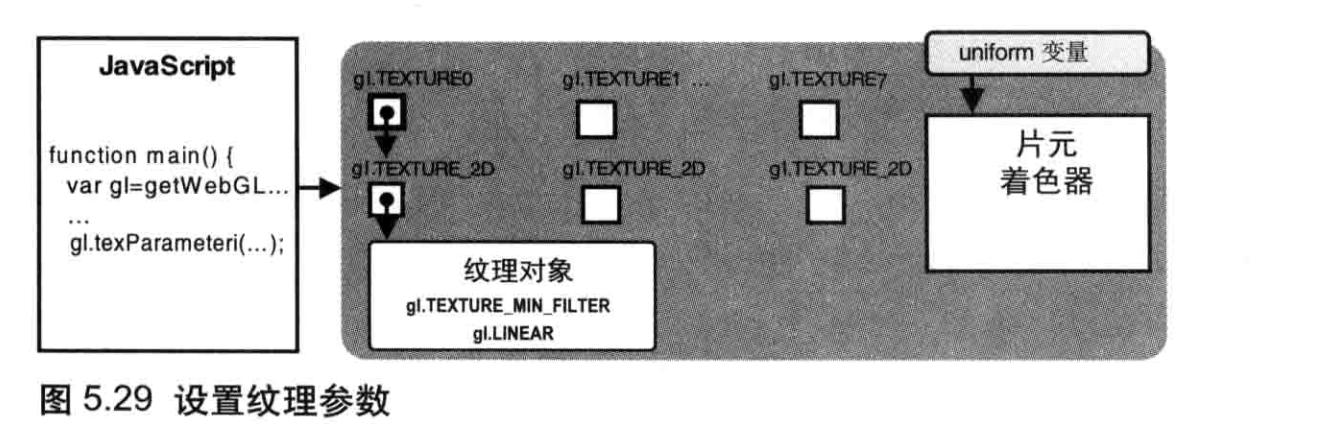

gl.texParameteri(gl.TEXTURE_2D, gl.TEXTURE_MIN_FILTER, gl.LINEAR);

// 配置纹理图像

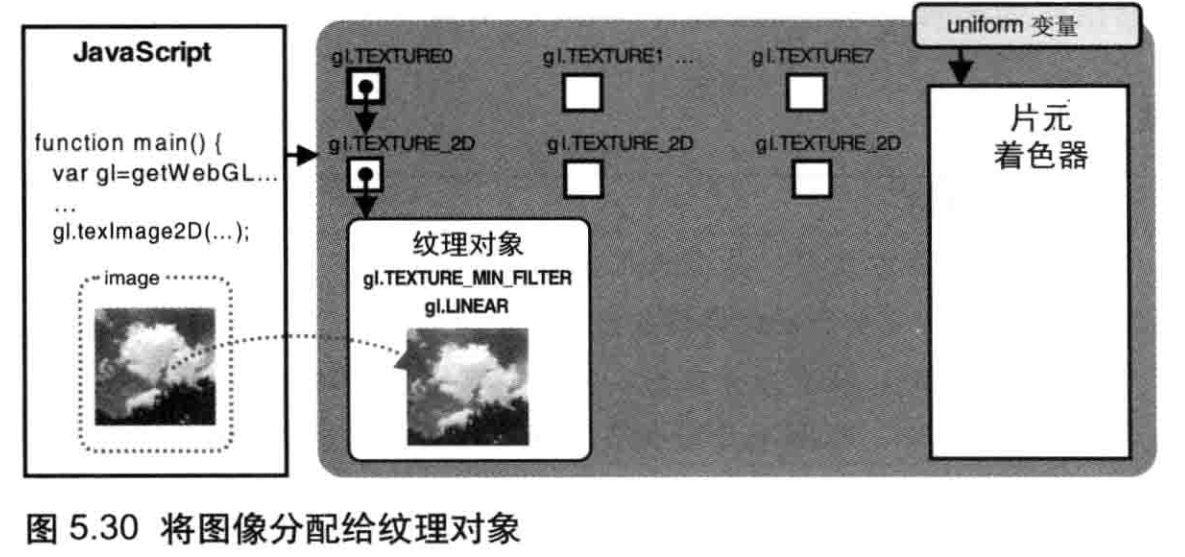

gl.texImage2D(gl.TEXTURE_2D, 0, gl.RGB, gl.RGB, gl.UNSIGNED_BYTE, image);

// 将0号纹理传递给着色器

gl.uniform1i(u_Sampler, 0);

gl.clear(gl.COLOR_BUFFER_BIT); // Clear <canvas>

gl.drawArrays(gl.TRIANGLE_STRIP, 0, n); // 绘制矩形

}

纹理映射的过程需要顶点着色器和片元着色器二者的配合:首先在顶点着色器中为每个顶点指定纹理坐标,然后在片元着色器中根据每个片元的纹理坐标从纹理图像中抽取纹素颜色。程序主要包括五个部分,已经在代码中用数字标记了出来。

这段程序主要分五个部分。

- 顶点着色器中接收顶点的纹理坐标,光栅化后传递给片元着色器。

- 片元着色器根据片元的纹理坐标,从纹理图像中抽取出纹素颜色,赋给当前片元。

- 设置顶点的纹理坐标( initVertexBuffers() )。

- 准备待加载的纹理图像,令浏览器读取它( initTextures() )。

- 监听纹理图像的加载事件,某天加载完成,就在WebGL系统中使用纹理( loadtexture() )。

设置纹理坐标(initVertexBuffers())

将纹理坐标和顶点坐标写在同一个缓冲区中;定义数组verticesTexCoords,成对记录每个顶点的顶点坐标和纹理坐标。

var verticesTexCoords = new Float32Array([

// 顶点坐标和纹理坐标

-0.5, 0.5, 0.0, 1.0,

-0.5, -0.5, 0.0, 0.0,

0.5, 0.5, 1.0, 1.0,

0.5, -0.5, 1.0, 0.0,

]);

可见,第1个顶点(-050.5)对应的纹理坐标是(001.0),第2个顶点(-0.5,-0.5)对应的纹理坐标是(000.0),第3个顶点(0.50.5)对应的纹理坐标是(1.01.0),第4个顶点(0.5-0.5)对应的纹理坐标是(1000)。图5.21显示了这种对应关系。

然后我们将顶点坐标和纹理坐标写入缓冲区对象,将其中的顶点坐标分配给a_Position变量并开启。接着,获取a_TexCoord变量的存储位置。将缓冲区中的纹理坐标分配给该变量,并开启。

配置和加载纹理( initTextures() )

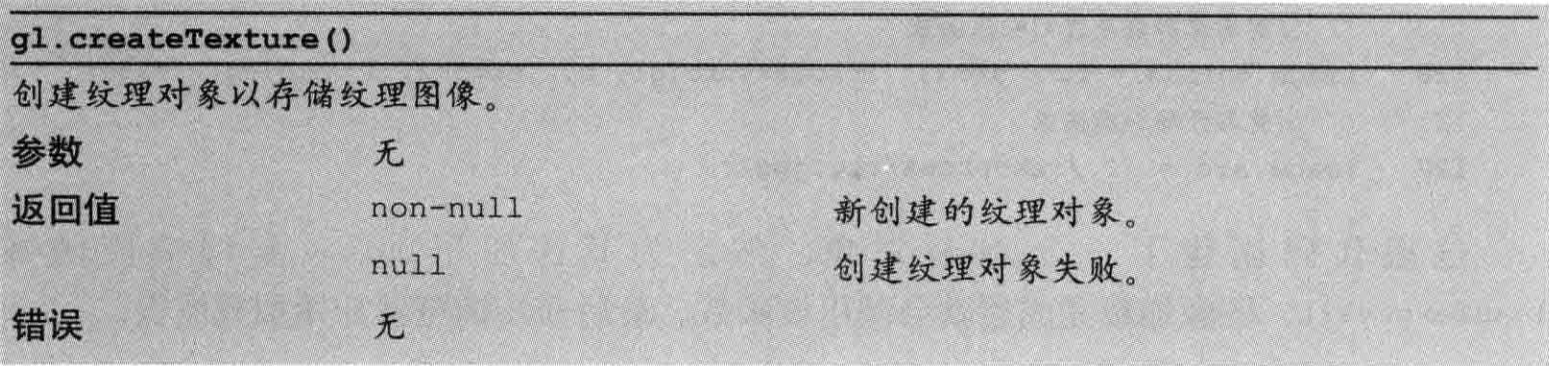

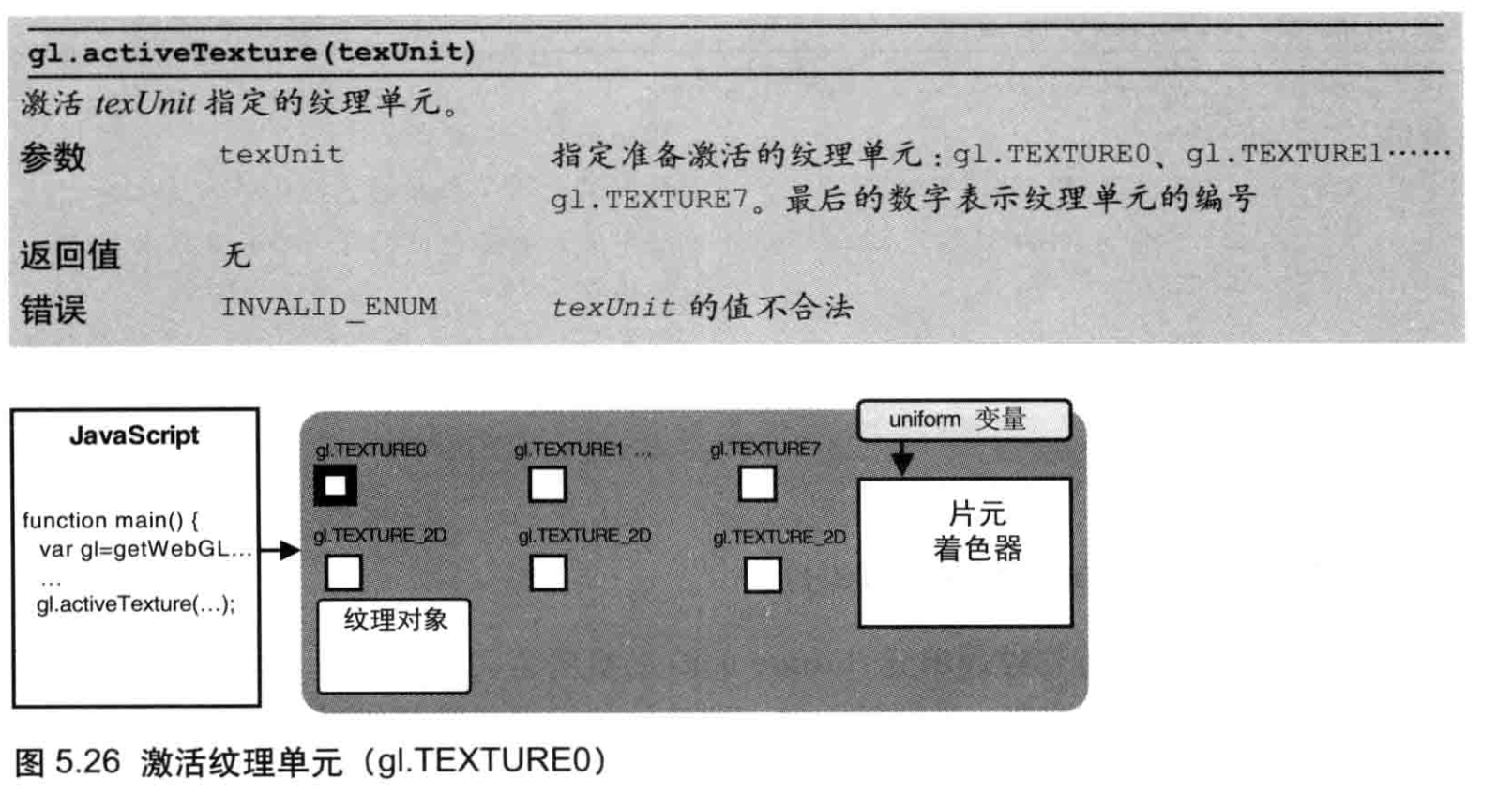

initTextures() 函数负责配置和加载纹理:首先调用gl.createTexture()创建纹理对象,纹理对象用来管理 WebGL 系统中的纹理。然后调用gl.getUniformLocation()从片元着色器中获取uniform变量u_Sampler(取样器)存储位置,该变量用来接收纹理图像。

gl.createTexture()方法可以创建纹理对象。

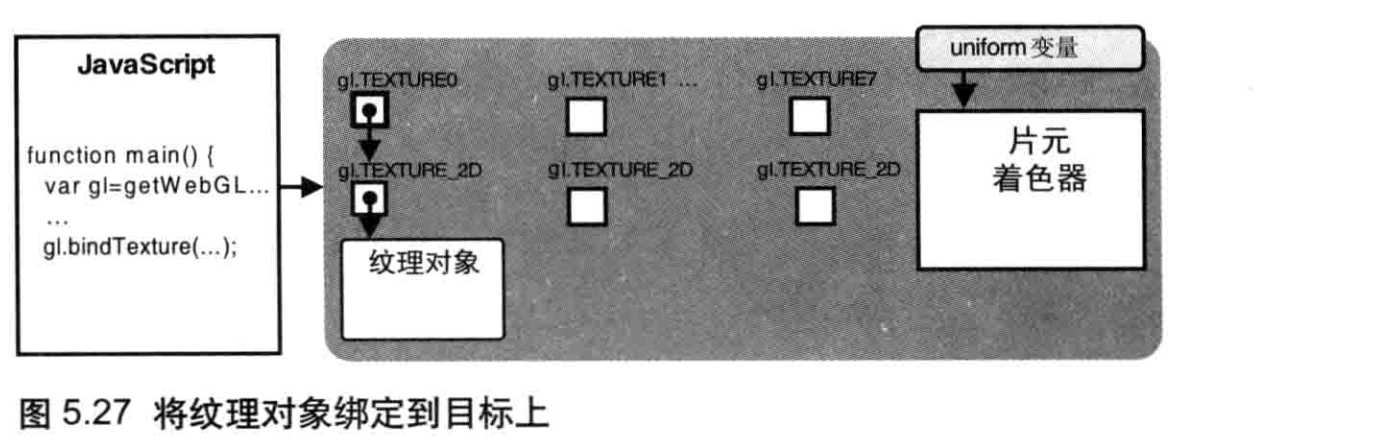

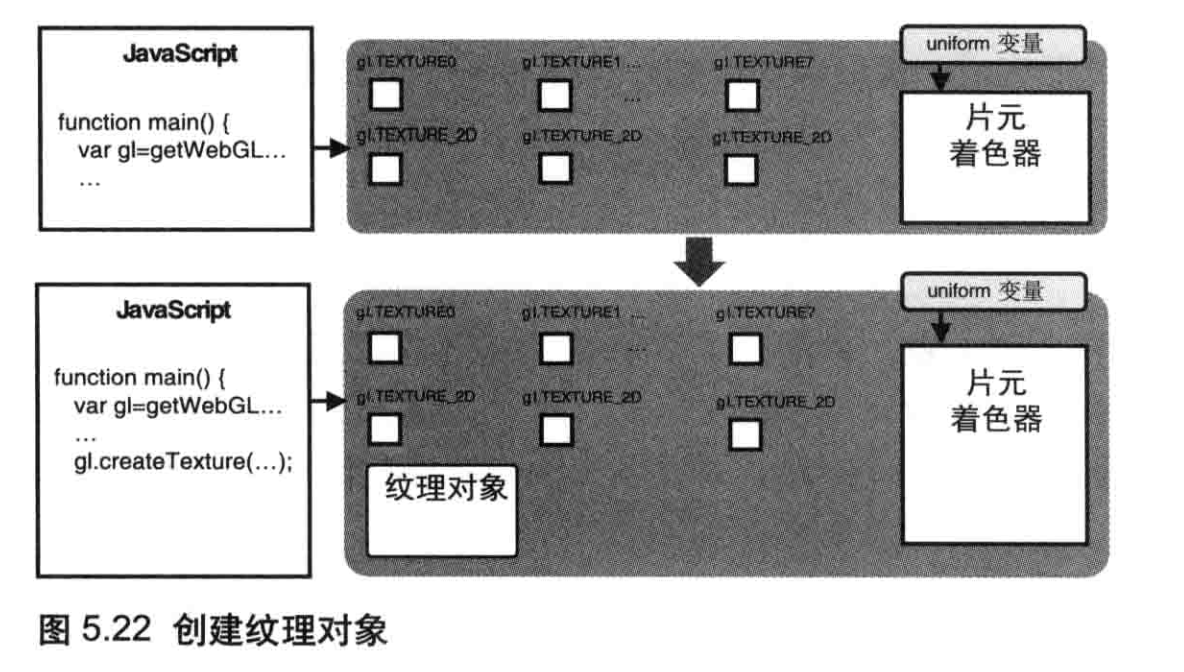

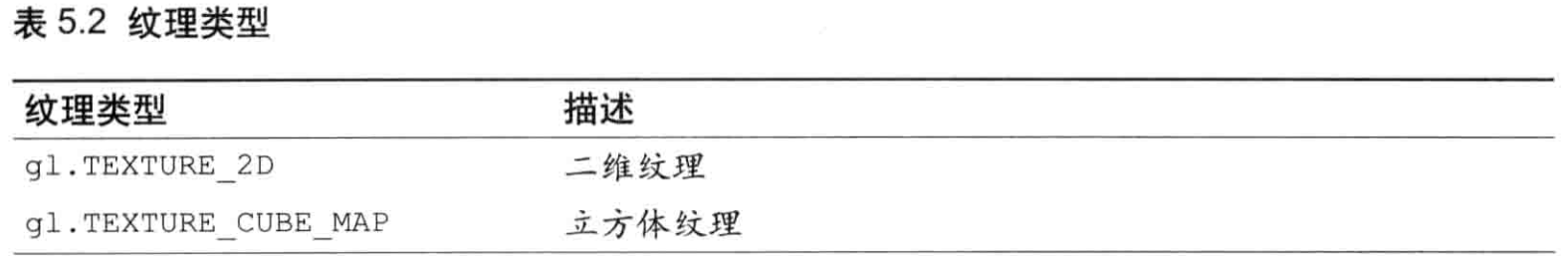

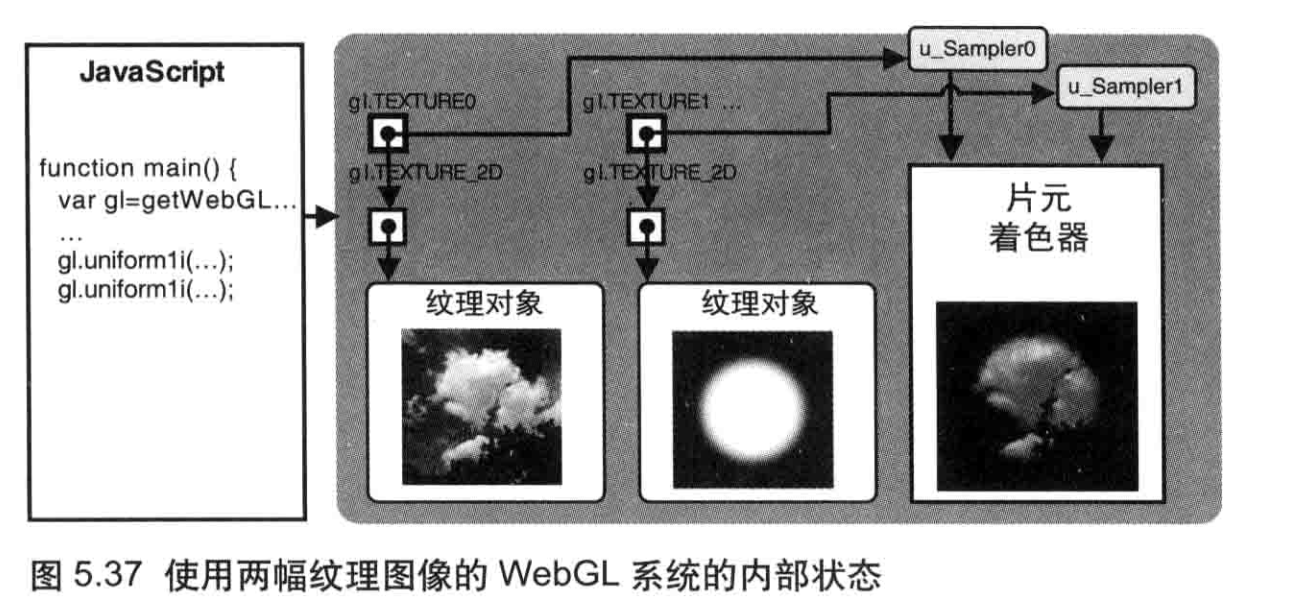

调用该函数将在WebGL系统中创建一个纹理对象,如图5.22所示。gl.TEXTURE0 到gl.TEXTURE7是管理纹理图像的8个纹理单元(稍后将详细解释),每一个都与gl.TEXTURE_2D相关联,而后者就是绑定纹理时的纹理目标。稍后将会详细解释这些内容。

同样,也可以使用gl.deleteTexture()来删除一个纹理对象。注意,如果试图删除一个已经被删除的纹理对象,不会报错也不会产生任何影响。

接下来,请求浏览器加载纹理图像供WebGL使用,该纹理图像将会映射到矩形上。

为WebGL 配置纹理( loadTexture() )

该函数的主要任务是配置纹理供WebGL使用。使用纹理对象的方式与使用缓冲区很类似,下面就让我们研究一下。

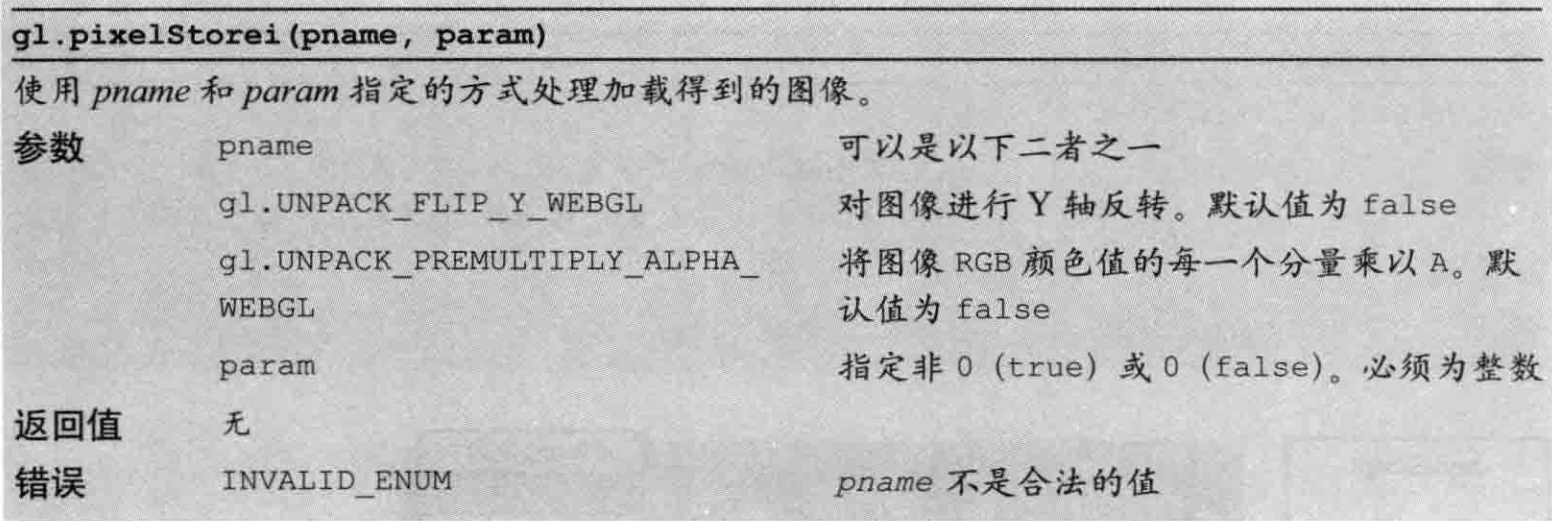

图像Y 轴反转

在使用图像之前,你必须对它进行Y轴反转。

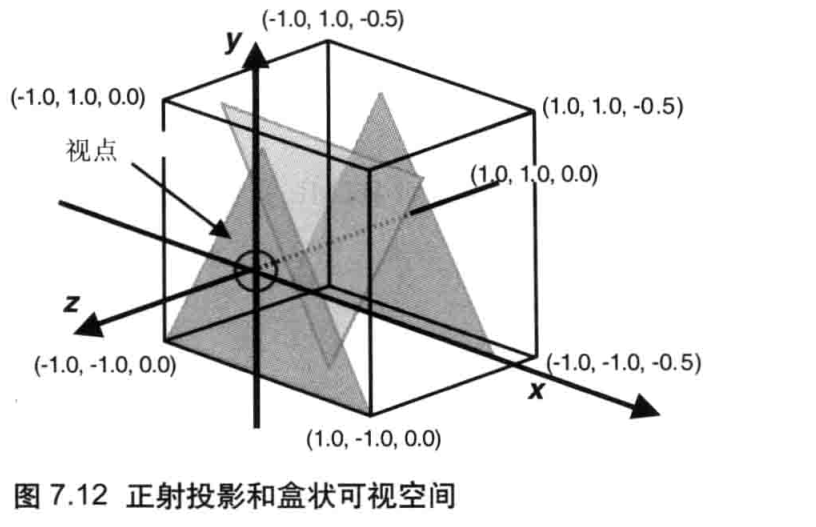

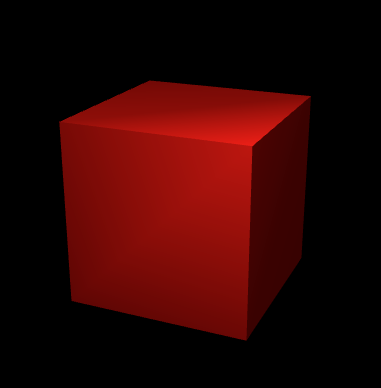

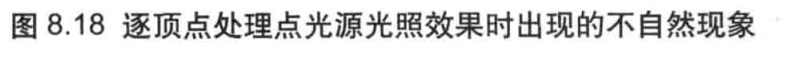

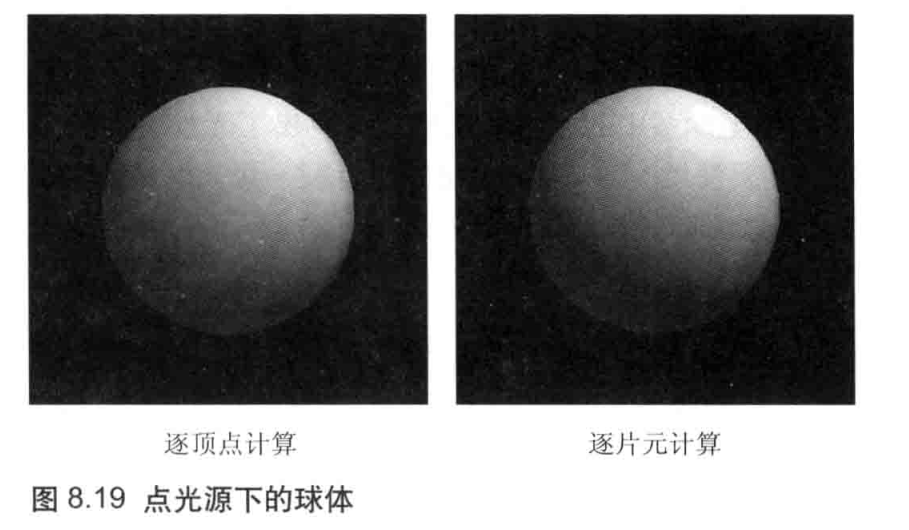

gl.pixelStorei(gl.UNPACK_FLIP_Y_WEBGL, 1); // 对纹理图像进行Y轴反转