基于Ollama的win10环境下DeepSeek安装测试

引子

之前一篇blog介绍了如何安装DeepSeek,感兴趣的童鞋请移步(https://blog.csdn.net/zzq1989_/article/details/145400876?spm=1001.2014.3001.5502)。那篇blog是根据DeepSeek官网安装步骤,只能通过API方式去调用。很多小伙伴私信我问能不能类似官方网页直接对话使用,开箱即用。必须可以的,安排,为了大家更方便的操作,这次直接只用win10系统。OK,我们开始吧。

一、 安装部署

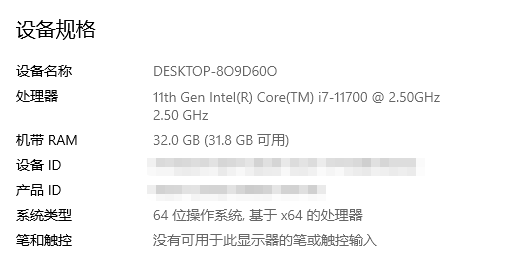

1、查看电脑配置(ps:大家应该看了很多类似视频教程,绝口不提安装电脑的配置,这点我也是很好奇),电脑右击属性查看CPU、内存信息

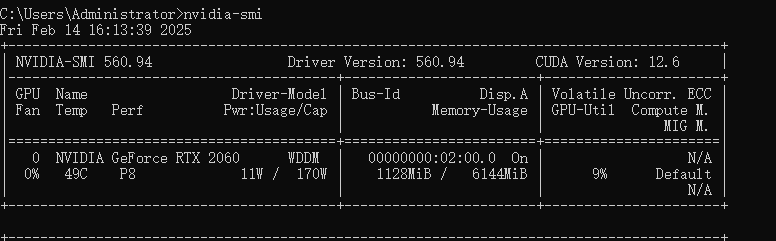

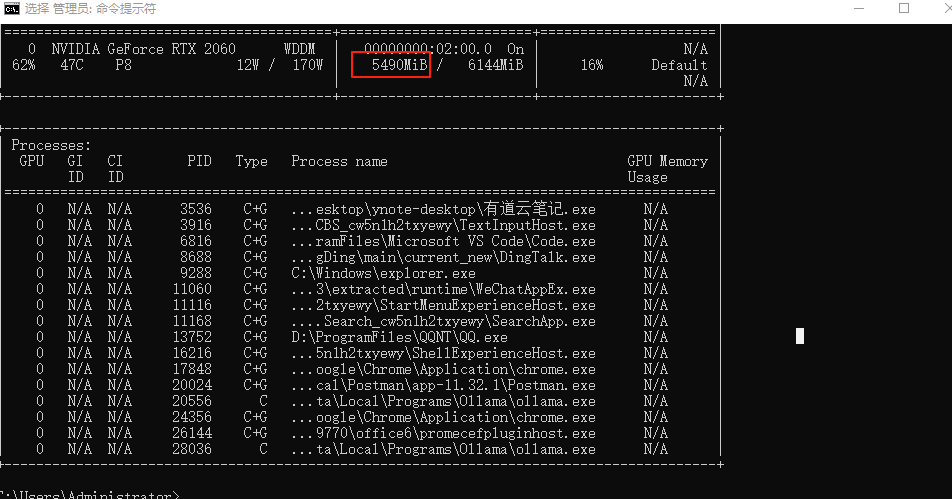

查看本地显卡配置,cmd打开,输入nvidia-smi,具体显卡驱动、cuda安装在此就不赘述了。

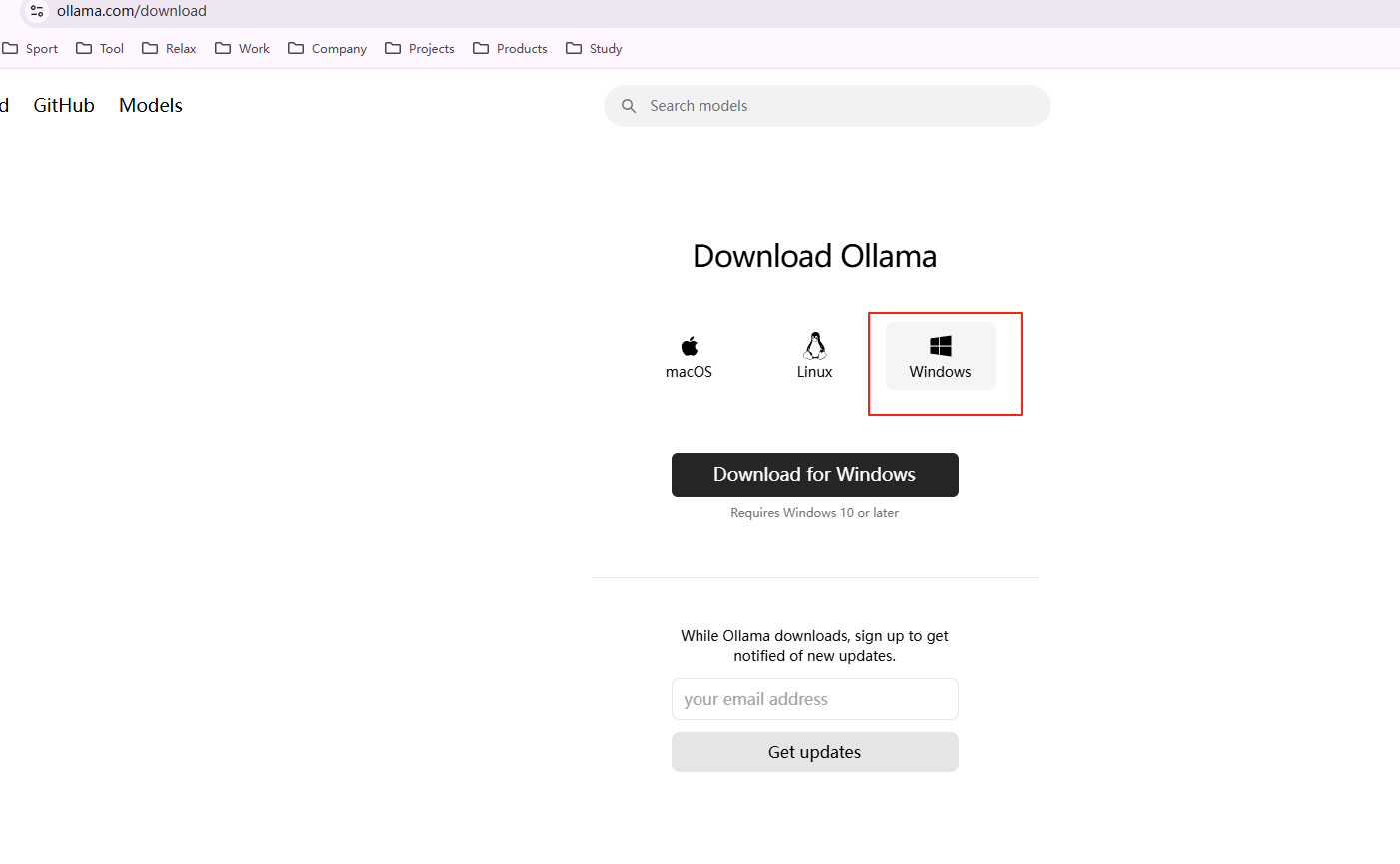

2、安装Ollama,这是运行大模型的一个基座架构,支持windows、mac、linux等平台

官网https://ollama.com/下载windows版本

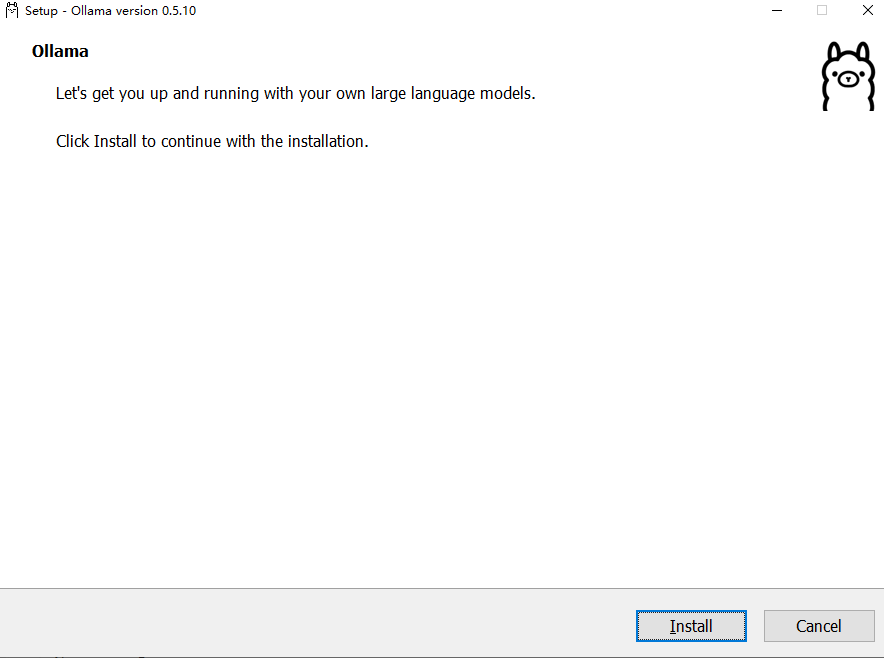

exe文件双击安装,ps只能安装在C盘

二、推理测试

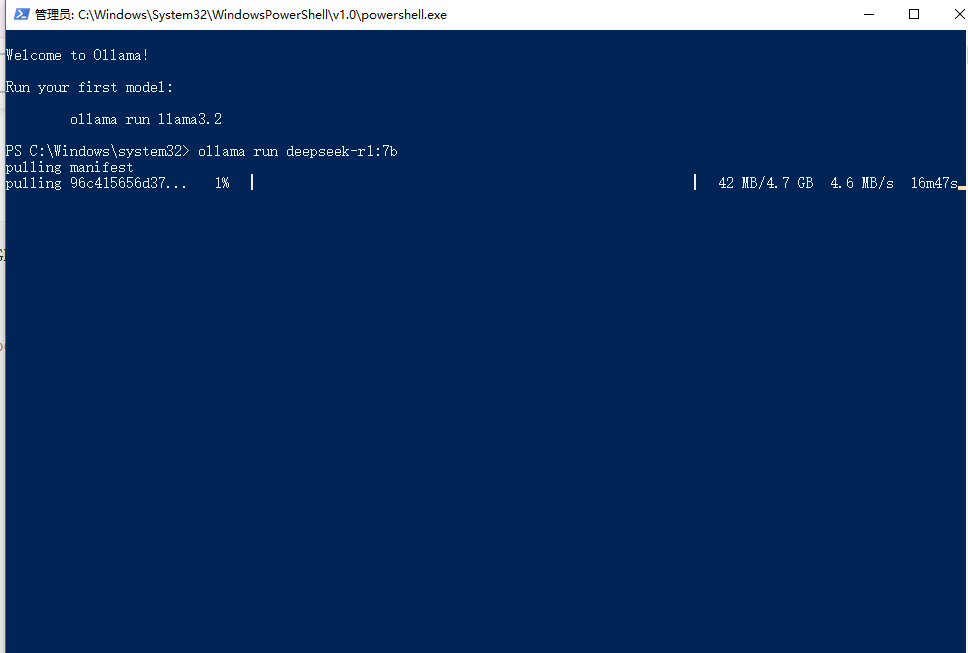

1、点击Ollama,安装DeepSeek,跑个7b模型试试

ollama run deepseek-r1:7b

自动下载模型速度飞起。

模型下载完成,即可以使用,那我们再来看看显存大小

2、最后我们来试试,广为流程的网图结果吧

浙公网安备 33010602011771号

浙公网安备 33010602011771号