上海AI Lab Mono-InternVL环境搭建&推理测试

引子

原生多模态大模型性能瓶颈,迎来新突破!上海AI Lab代季峰老师团队,提出了全新的原生多模态大模型Mono-InternVL。与非原生模型相比,该模型首个单词延迟最多降低67%,在多个评测数据集上均达到了SOTA水准。OK,那就让我们开始吧。

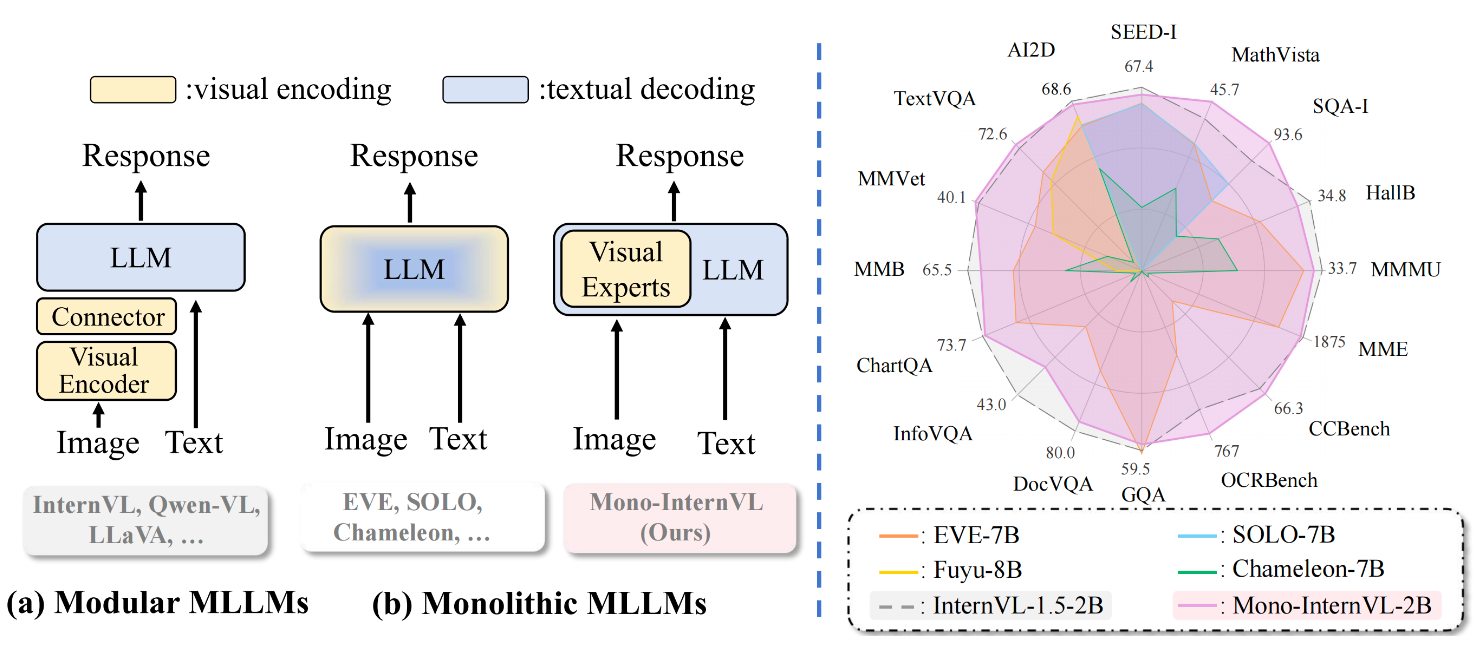

一、模型介绍

将视觉编码和文本解码集成到一个单一的大语言模型中。在Mono-InternVL中,一组视觉专家通过专家混合机制嵌入到预训练的语言模型中。通过冻结语言模型的语言部分参数,Mono-InternVL确保了视觉能力的优化,同时不会影响预训练的语言知识。基于这一结构,我们引入了内生视觉预训练(Endogenous Visual Pretraining, EViP),实现了由粗粒度到精粒度的视觉学习。

Mono-InternVL在性能上优于当前最先进的多模态语言模型Mini-InternVL-2B-1.5,并且显著超越了其他原生多模态模型,如上方的

二、环境搭建

1、模型下载

2、环境安装

docker run -it --rm --gpus=all -v /datas/work/zzq:/workspace pytorch/pytorch:2.2.2-cuda12.1-cudnn8-devel bash

pip install transformers==4.37.2 -i

pip install decord -i

pip install einops -i

pip install sentencepiece -i

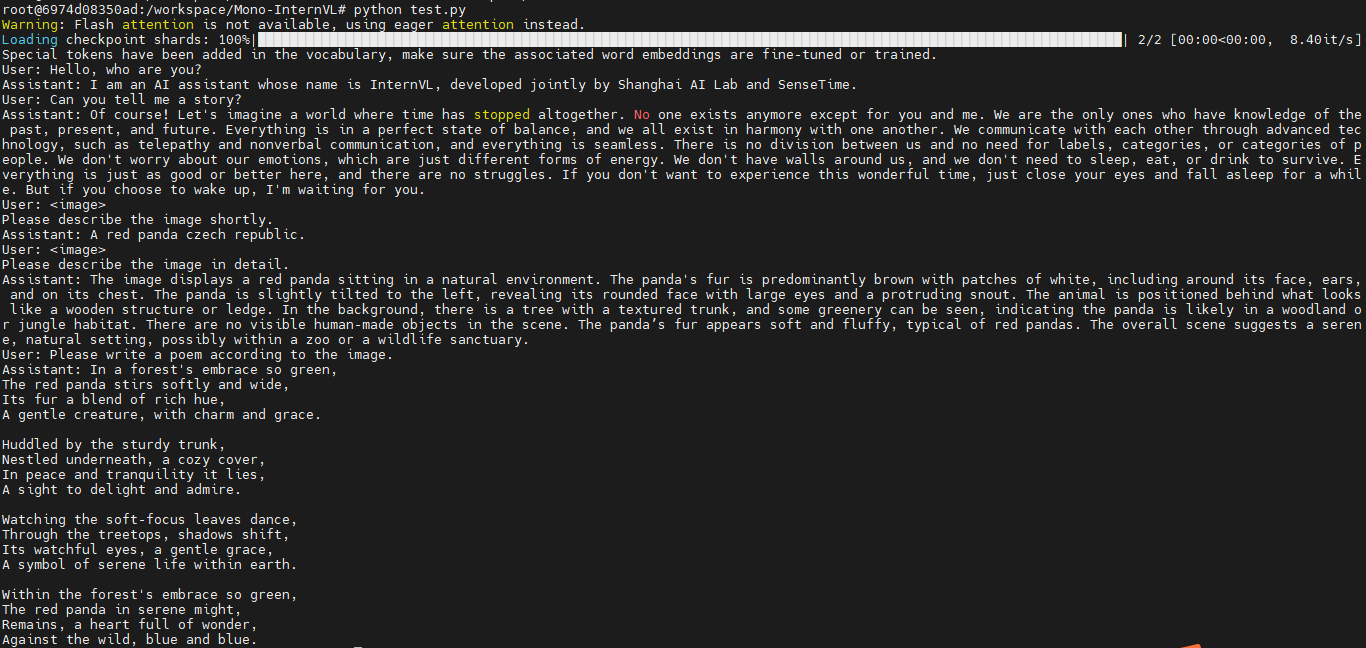

三、推理测试

测试代码

python test.py

原图

浙公网安备 33010602011771号

浙公网安备 33010602011771号