摘要:

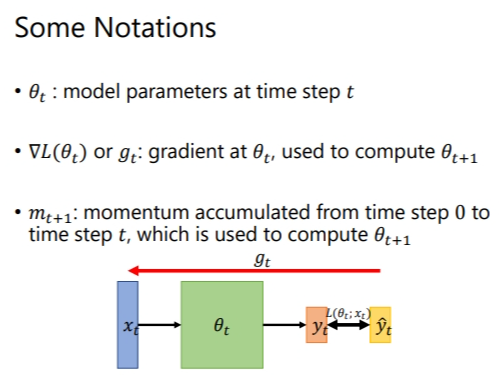

# 1. Some Nitations 在本小节开始之前,需要知道的符号含义.  # 2. What is 阅读全文

摘要:

# 1. 概念引入: Image Classification ## 1.1 基本步骤 我们做图像分类时,一般分为三步: * 所有图片都先 rescale 成大小一样 * 把每一个类别表示成一个 one-hot vector(dimension 的长度决定模型可以辨识出多少不同种类的东西) * 将图 阅读全文

摘要:

# 1. 提出背景 在前文,我们提过$error\ surface$在不同方向的斜率不一样,因此采用固定的学习率很难将模型$train$起来,上节提出了自适应学习率,这里还有一个方法就是直接将e$rror\ surface$铲平. 或许首先想要提出的是为什么会产生不同方向上斜率相差很大的现象.观察下 阅读全文

摘要:

# 1. 实验结果纪录 纪录一下调整参数带来的结果.不过语音识别这块完全不熟. ## 1.1 Simple Baseline * **acc>0.45797** 直接上传助教代码  ## 1.1 为什么需要调整学习率 首先认识一个现象.Training stuck ≠ Small Gradient 训练卡住的原因不一定是因为 gradient 太小,即critical point,也有可能是因为振荡. 阅读全文

摘要:

# 1. Batch(批次) > 对抗临界点的两个方法就是batch 和 momentum 将一笔大型资料分若干批次计算 loss 和梯度,从而更新参数.每看完一个epoch就把这笔大型资料打乱(shuffle),然后重新分批次.这样能保证每个epoch中的 batch 资料不同,避免偶然性. > 阅读全文

摘要:

# 1. When gradient is small 本小节主要讨论优化器造成的训练问题. ## 1.1 Critical Point(临界点) 如果训练过程中经过很多个epoch后,loss还是不下降,那么可能是因为梯度(斜率)接近于 0,导致参数更新的步伐接近于0,所以参数无法进一步更新,lo 阅读全文

摘要:

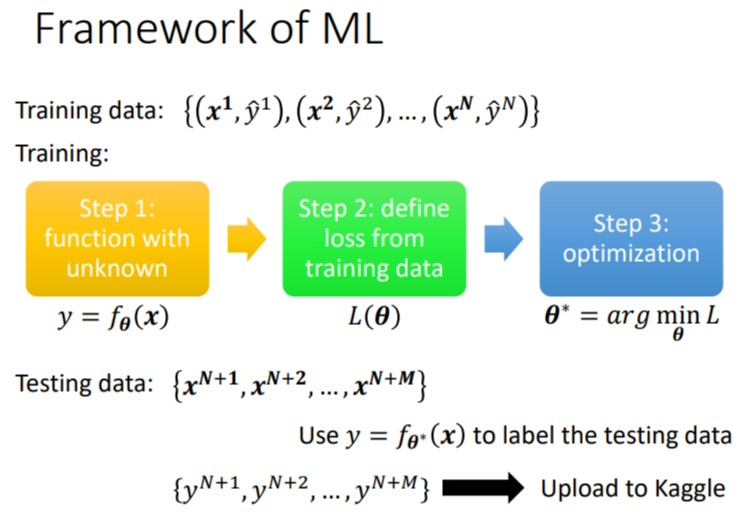

# 1. Framework of ML 训练的过程之前已经讲过了,训练主要是三个步骤.  * 第一步,你 阅读全文