1.dlib.get_frontal_face_detector() # 获得人脸框位置的检测器, detector(gray, 1) gray表示灰度图,

2.dlib.shape_predictor(args['shape_predictor']) # 获得人脸关键点检测器, predictor(gray, rect) gray表示输入图片,rect表示人脸框的位置信息

参数说明: args['shape_predoctor] 人脸检测器的权重参数地址

3.cv2.convexHull(shape[i:k]) 绘制array位置的凸包信息

参数说明:shape[i:k]表示输入的数组的位置信息

人脸关键点检测:首先通过人脸检测,检测出人脸框的位置,再使用加载的人脸关键点检测,进行人脸关键点的检测

代码:

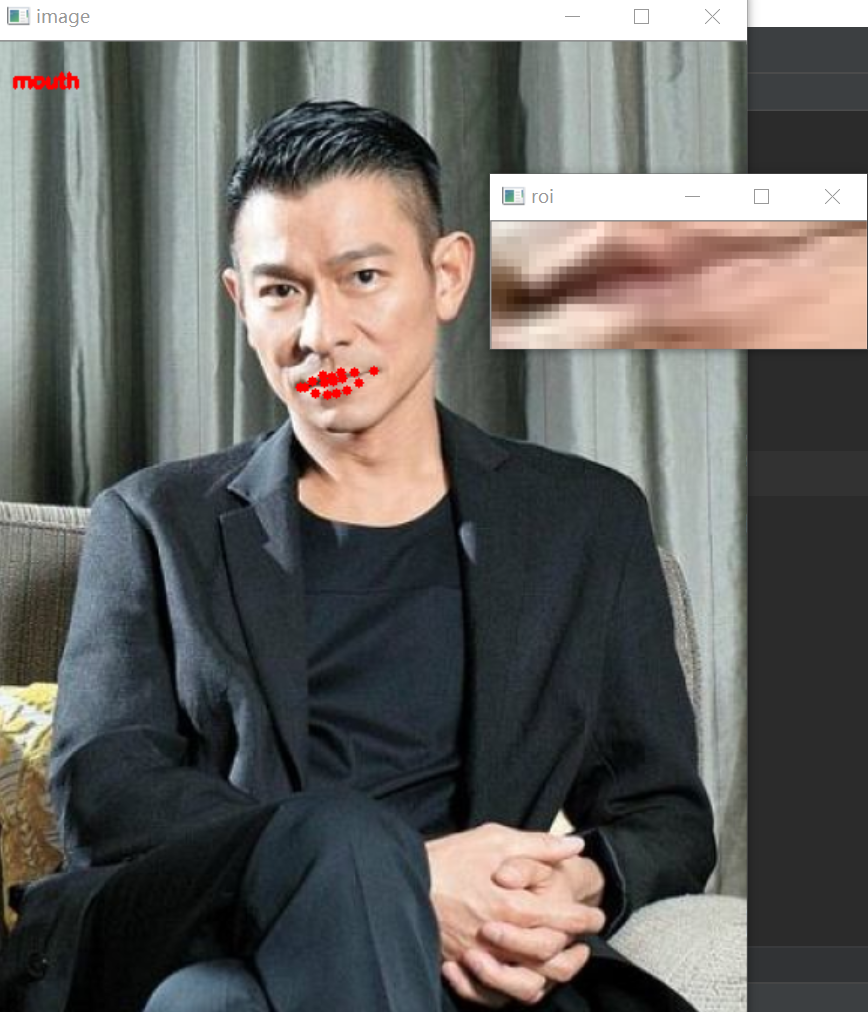

第一步:参数设置,设置权重参数和图片的位置

第二步:构造有序的字典,用于标记不同脸部部位对应的序号

第三步:构造人脸检测和人脸关键点检测的检测器

第四步:使用人脸检测器进行人脸的位置检测

第五步:循环人脸检测的位置,使用关键点检测器,检测出人脸的位置信息

第六步:由于人脸检测器的位置信息是封装的,因此构造函数,转换为array格式

第七步:循环有序的字典,在每一个部分画出圆点

第八步:使用cv2.boudingRect(np.array(shape[j:k])) 获得脸部轮廓的位置信息

第九步:使用上面(x, y, w, h)截图原始图片

第十步:进行画图操作

第十一步:构造函数画出所有的部分,对于脸部:使用cv2.line画出直线,对于其他部分,使用cv2.convexHull()获得凸包的轮廓,使用cv2.drawContour画出轮廓

# 导入工具包 from collections import OrderedDict import numpy as np import argparse import dlib import cv2 # 第一步:参数设置 ap = argparse.ArgumentParser() ap.add_argument('-p', '--shape-predictor', default='shape_predictor_68_face_landmarks.dat', help='path to facial landmark predictor') ap.add_argument('-i', '--image', default='images/liudehua.jpg', help='path to input image') args = vars(ap.parse_args()) # 第二步:使用OrderedDict构造脸部循环字典时是有序的 FACIAL_LANDMARKS_68_IDXS = OrderedDict([ ('mouth', (48, 68)), ('right_eyebrow', (17, 22)), ('left_eyebrow', (22, 27)), ('right_eye', (36, 42)), ('left_eye', (42, 48)), ('nose', (27, 36)), ('jaw', (0, 17)) ]) FACIAL_LANDMARKS_5_IDXS = OrderedDict([ ("right_eye", (2, 3)), ("left_eye", (0, 1)), ("nose", (4)), ]) def shape_to_np(shape, dtype='int'): # 创建68*2用于存放坐标 coords = np.zeros((shape.num_parts, 2), dtype=dtype) # 遍历每一个关键点 # 得到坐标 for i in range(0, shape.num_parts): coords[i] = (shape.part(i).x, shape.part(i).y) return coords def visualize_facial_landmarks(image, shape, colors=None, alpha=0.75): # 创建两个copy # overlay and one for the final output image overlay = image.copy() output = image.copy() # 设置一些颜色区域 if colors is None: colors = [(19, 199, 109), (79, 76, 240), (230, 159, 23), (168, 100, 168), (158, 163, 32), (163, 38, 32), (180, 42, 220)] for (i, name) in enumerate(FACIAL_LANDMARKS_68_IDXS.keys()): # 得到每一个点的坐标 (j, k) = FACIAL_LANDMARKS_68_IDXS[name] pts = shape[j:k] if name == 'jaw': # 用线条连起来 for l in range(1, len(pts)): ptA = tuple(pts[l-1]) ptB = tuple(pts[l]) # 对位置进行连线 cv2.line(overlay, ptA, ptB, colors[i], 2) else: # 使用cv2.convexHull获得位置的凸包位置 hull = cv2.convexHull(pts) # 使用cv2.drawContours画出轮廓图 cv2.drawContours(overlay, [hull], -1, colors[i], -1) cv2.addWeighted(overlay, alpha, output, 1-alpha, 0, output) return output # 第三步:加载人脸检测与关键点定位 detector = dlib.get_frontal_face_detector() predictor = dlib.shape_predictor(args['shape_predictor']) # 读取输入数据,预处理,进行图像的维度重构和灰度化 image = cv2.imread(args['image']) (h, w) = image.shape[:2] width = 500 r = width / float(w) dim = (width, int(r*h)) image = cv2.resize(image, dim, interpolation=cv2.INTER_AREA) gray = cv2.cvtColor(image, cv2.COLOR_BGR2GRAY) # 第四步:进行人脸检测,获得人脸框的位置信息 rects = detector(gray, 1) # 遍历检测到的框 for (i, rect) in enumerate(rects): #第五步: 对人脸框进行关键点定位 shape = predictor(gray, rect) #第六步:将检测到的关键点转换为ndarray格式 shape = shape_to_np(shape) # 第七步:对字典进行循环 for (name, (i, j)) in FACIAL_LANDMARKS_68_IDXS.items(): clone = image.copy() cv2.putText(clone, name, (10, 30), cv2.FONT_HERSHEY_SIMPLEX, 0.45, (0, 0, 255), 2) # 根据位置画点 for (x, y) in shape[i:j]: cv2.circle(clone, (x, y), 3, (0, 0, 255), -1) #第八步: 使用cv2.boundingRect获得脸部轮廓位置信息 (x, y, w, h) = cv2.boundingRect(np.array([shape[i:j]])) # 第九步:根据位置提取脸部的图片 roi = image[y:y+h, x:x+w] (h, w) = roi.shape[:2] width = 250 r = width / float(w) dim = (width, int(r*h)) roi = cv2.resize(roi, dim, interpolation=cv2.INTER_AREA) # 第十步:进行画图操作显示每个部分 cv2.imshow('ROI', roi) cv2.imshow('Image', clone) cv2.waitKey(0) # 第十一步: 进行脸部位置的画图,如果是脸部:进行连线操作,如果是其他位置,使用cv2.convexHull()获得凸包的位置信息,进行drawcontour进行画图 output = visualize_facial_landmarks(image, shape) cv2.imshow('Image', output) cv2.waitKey(0)

效果图展示 所有区域画图

浙公网安备 33010602011771号

浙公网安备 33010602011771号