Spark 个人实战系列(1)--Spark 集群安装

前言:

CDH4不带yarn和spark, 因此需要自己搭建spark集群. 这边简单描述spark集群的安装过程, 并讲述spark的standalone模式, 以及对相关的脚本进行简单的分析.

spark官网: http://spark.apache.org/downloads.html

*)安装和部署

环境: 172.16.1.109~172.16.1.111三台机器(对应域名为tw-node109~tw-node111), centos6.4, 已部署cdh4

目标是: 搭建一个spark集群(standlone), 部署目录统一为$SPARK_HOME=/root/mmxf/spark, 172.16.1.109部署Master, 172.16.1.109~172.16.1.111部署Worker节点.

预先的准备工作:

#) 在各个节点已配置/etc/hosts

172.16.1.109 tw-node109 172.16.1.110 tw-node110 172.16.1.111 tw-node111

#) 进行ssh无密钥登录设置(ssh-genkey, ssh-copy-it)

1. 下载pre-build cdh4版spark

wget http://mirrors.hust.edu.cn/apache/spark/spark-1.0.1/spark-1.0.1-bin-cdh4.tgz

2. 解压spark

tar zxvf spark-1.0.1-bin-cdh4.tgz

ln -s spark-1.0.1-bin-cdh4 spark

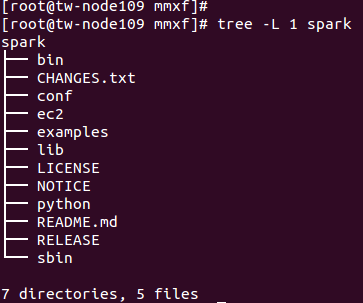

目录结构如下:

3. 配置属性

配置${SPARK_HOME}/conf/spark-env.sh

cd conf/

cp spark-env.sh.template spark-env.sh

1 2 3 | SPARK_MASTER_IP=172.16.1.109SPARK_MASTER_PORT=7077MASTER=spark://${SPARK_MASTER_IP}:${SPARK_MASTER_PORT} |

修改${SPARK_HOME}/conf/slaves

1 2 3 | tw-node109tw-node110tw-node111 |

4. 使用rsync做同步

SPARK_INSTALL_DIR=/root/mmxf

rsync -avh ${SPARK_INSTALL_DIR} <username>@<server>:${SPARK_INSTALL_DIR}

rsync -avh /root/mmxf/ root@172.16.1.110:/root/mmxf/

rsync -avh /root/mmxf/ root@172.16.1.111:/root/mmxf/

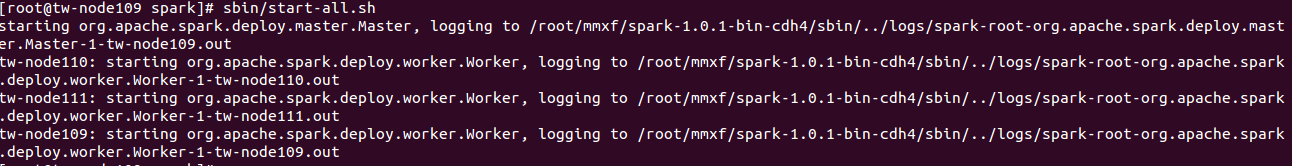

5. 启用服务

sbin/start-all.sh

sbin/stop-all.sh

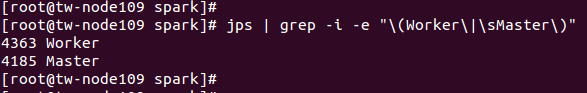

6. 验证

jps | grep -i -e "\(Worker\|\sMaster\)"

集群UI展示

官方提供的测试用例: bin/run-example SparkPi 10

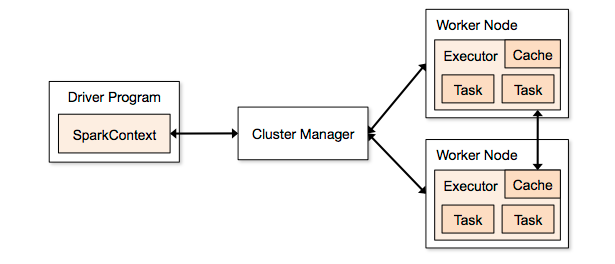

7. standlalone架构

总结:

spark集群的搭建还是很简单的, 服务启动维护亦然.

posted on 2014-07-16 14:46 mumuxinfei 阅读(733) 评论(0) 编辑 收藏 举报

【推荐】国内首个AI IDE,深度理解中文开发场景,立即下载体验Trae

【推荐】编程新体验,更懂你的AI,立即体验豆包MarsCode编程助手

【推荐】抖音旗下AI助手豆包,你的智能百科全书,全免费不限次数

【推荐】轻量又高性能的 SSH 工具 IShell:AI 加持,快人一步

· .NET Core 中如何实现缓存的预热?

· 从 HTTP 原因短语缺失研究 HTTP/2 和 HTTP/3 的设计差异

· AI与.NET技术实操系列:向量存储与相似性搜索在 .NET 中的实现

· 基于Microsoft.Extensions.AI核心库实现RAG应用

· Linux系列:如何用heaptrack跟踪.NET程序的非托管内存泄露

· TypeScript + Deepseek 打造卜卦网站:技术与玄学的结合

· 阿里巴巴 QwQ-32B真的超越了 DeepSeek R-1吗?

· 【译】Visual Studio 中新的强大生产力特性

· 10年+ .NET Coder 心语 ── 封装的思维:从隐藏、稳定开始理解其本质意义

· 【设计模式】告别冗长if-else语句:使用策略模式优化代码结构