Linux监控

Vmstat

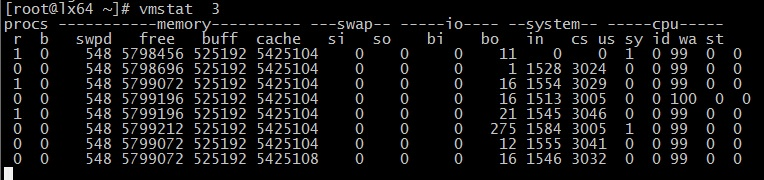

vmstat 3 (表示每3秒采集一次数据,一直采集,直到退出命令程序)

vmstat 3 2(表示每3秒采集一次数据,采集2次结束)

数据说明:

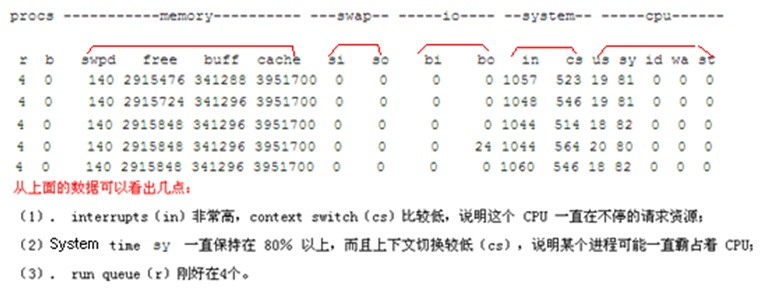

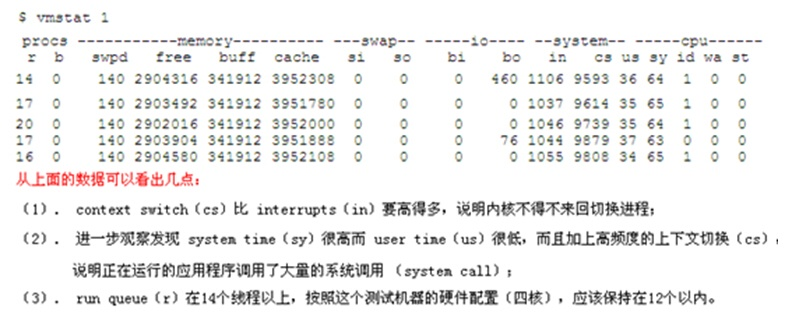

【r】 表示运行和等待cpu时间片的进程数,如果长期大于1,说明cpu不足,一般负载超过了3就比较高;需要增加cpu。

【b】 表示阻塞的进程, 表示在等待资源的进程数,比如正在等待I/O、或者内存交换等

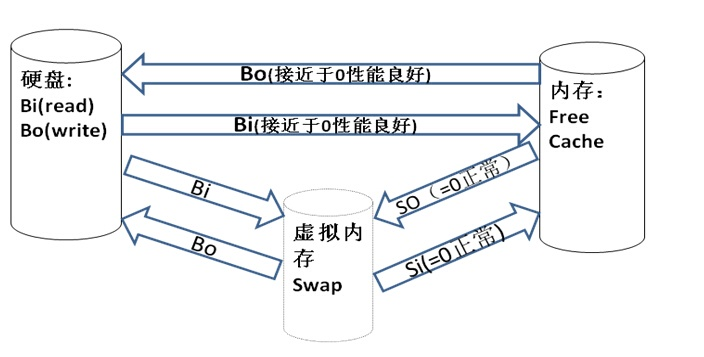

【swpd】 虚拟内存已使用的大小(单位KB),如果大于0,表示你的机器物理内存不足了,如果不是程序内存泄露的原因,那么你该升级内存了或者把耗内存的任务迁移到其他机器;这个值要看过程的,如果不是长时间的大于0是没问题的。

【free】空闲的物理内存的大小(单位KB)。

【buff】 作为buffer cache的内存数量(单位KB),比如权限等的缓存。

【cache】 作为page cache的内存数量(单位KB),cache直接用来记忆我们打开的文件,给文件做缓冲,Linux/Unix把空闲的物理内存的一部分拿来做文件和目录的缓存,是为了提高程序执行的性能,如果cache较大,说明用到cache的文件较多,如果此时IO中bi比较小,说明文件系统效率比较好。

【si】 数据从虚拟内存(Swap)或者磁盘读到内存(RAM)(单位KB),如果这个值大于0,表示物理内存不够用或者内存泄露了,要查找耗内存进程解决掉。

【so】 数据从内存(RAM)读到虚拟内存(Swap)或者磁盘(单位KB),如果这个值大于0,同上。

【bi】 从块设备(磁盘,磁带等)每秒接收(读磁盘)的块数量(block 为单位)。

【bo】 块设备每秒发送(写磁盘)的块数量,例如我们读取文件,bo就要大于0。bi和bo一般都要接近0,不然就是IO过于频繁,需要调整,而且wa值较大应该考虑均衡磁盘负载,可以结合iostat输出来分析(block 为单位)。

【wa】 显示了IO等待所占用的CPU时间的百分比,Wa参考值为30%,如果超过30%,说明IO等待严重,可能是磁盘大量随机访问造成,也可能是磁盘或者磁盘访问控制器的带宽瓶颈造成的(比如磁盘传输率)。

【in】 每秒CPU的中断次数,包括时间中断

【cs】每秒上下文切换次数,例如我们调用系统函数,就要进行上下文切换,线程的切换,也要进程上下文切换,这个值要越小越好,太大了,要考虑调低线程或者进程的数目,例如在apache和nginx这种web服务器中,我们一般做性能测试时会进行几千并发甚至几万并发的测试,选择web服务器的进程可以由进程或者线程的峰值一直下调,压测,直到cs到一个比较小的值,这个进程和线程数就是比较合适的值了。系统调用也是,每次调用系统函数,我们的代码就会进入内核空间,导致上下文切换,这个是很耗资源,也要尽量避免频繁调用系统函数。上下文切换次数过多表示你的CPU大部分浪费在上下文切换,导致CPU干正经事的时间少了,CPU没有充分利用,是不可取的。

【us】显示了用户方式下所花费 CPU 时间的百分比。us的值比较高时,说明用户进程消耗的cpu时间多,但是如果长期大于50%,需要考虑优化用户的程序

【sy】 系统CPU时间,如果太高,表示系统调用时间长,例如是IO操作频繁。

【id】 空闲 CPU时间,一般来说,id + us + sy = 100,id是空闲CPU使用率,us是用户CPU使用率,sy是系统CPU使用率。

【wa】显示了IO等待所占用的CPU时间的百分比,Wa参考值为30%,如果超过30%,说明IO等待严重,可能是磁盘大量随机访问造成,也可能是磁盘或者磁盘访问控制器的带宽瓶颈造成的(比如磁盘传输率)。

【st】 被虚拟机所占用的CPU使用状态。

内存机制

性能监测有关的两个内核进程:kswapd 和 pdflush。

(1)kswapd daemon 用来检查 pages_high 和 pages_low,如果可用内存少于 pages_low,kswapd 就开始扫描并试图释放 32个页面,并且重复扫描释放的过程直到可用内存大于 pages_high 为止。

扫描的时候检查3件事:

1)如果页面没有修改,把页放到可用内存列表里;

2)如果页面被文件系统修改,把页面内容写到磁盘上;

3)如果页面被修改了,但不是被文件系统修改的,把页面写到交换空间。

(2)pdflush daemon 用来同步文件相关的内存页面,把内存页面及时同步到硬盘上。比如打开一个文件,文件被导入到内存里,对文件做了修改后并保存后,内核并不马上保存文件到硬盘,由 pdflush 决定什么时候把相应页面写入硬盘,这由一个内核参数 vm.dirty_background_ratio 来控制,比如下面的参数显示脏页面(dirty pages)达到所有内存页面10%的时候开始写入硬盘。

# /sbin/sysctl -n vm.dirty_background_ratio

10

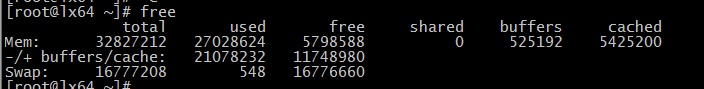

Free

单位KB

Mem 行(第一行)数据说明:

Total:表示物理内存总大小。

Used:表示总计分配给缓存(包含buffers 与cache )使用的数量,但其中可能部分缓存并未实际使用。

Free:表示未被分配的内存。

Shared:0kb。共享内存,一般系统不会用到。

Buffers:系统分配但未被使用的buffers 数量。

Cached:系统分配但未被使用的cache 数量。

-/+ buffers/cache 行(第二行)数据说明:

Used:实际使用的buffers 与cache 总量,也是实际使用的内存总量。

Free:未被使用的buffers 与cache 和未被分配的内存之和,这就是系统当前实际可用内存

Swap

如果Swap空间用完,则服务进程无法启动,通常会出现“application is out of memory”的错误,严重时会造成服务进程的死锁。

Swap空间应大于或等于物理内存的大小,最小不应小于64M,通常Swap空间的大小应是物理内存的2-2.5倍

一般来说对于4G 以下的物理内存,配置2倍的swap,4G 以上配置1倍

Swap分区的数量对性能也有很大的影响。因为Swap交换的操作是磁盘IO的操作,如果有多个Swap交换区,Swap空间的分配会以轮流的方式操作于所有的Swap,这样会大大均衡IO的负载,加快Swap交换的速度。如果只有一个交换区,所有的交换操作会使交换区变得很忙,使系统大多数时间处于等待状态,效率很低。用性能监视工具就会发现,此时的CPU并不很忙,而系统却慢。这说明,瓶颈在IO上,依靠提高CPU的速度是解决不了问题的

File Buffer Cache

文件缓存区 File Buffer Cache)读取页比从硬盘读取页要快得多,所以 Linux 内核希望能尽可能产生次缺页中断(从文件缓存区读),并且能尽可能避免主缺页中断(从硬盘读),这样随着次缺页中断的增多,文件缓存区也逐步增大,直到系统只有少量可用物理内存的时候 Linux 才开始释放一些不用的页。我们运行 Linux 一段时间后会发现虽然系统上运行的程序不多,但是可用内存总是很少,这样给大家造成了 Linux 对内存管理很低效的假象,事实上 Linux 把那些暂时不用的物理内存高效的利用起来做预存(内存缓存区)。

Network

可以通过 ethtool 工具来查看网卡的配置和工作模式:

# /sbin/ethtool eth0

Settings for eth0:

Supported ports: [ TP ]

Supported link modes: 10baseT/Half 10baseT/Full

100baseT/Half 100baseT/Full

1000baseT/Half 1000baseT/Full

Supports auto-negotiation: Yes

Advertised link modes: 10baseT/Half 10baseT/Full

100baseT/Half 100baseT/Full

1000baseT/Half 1000baseT/Full

Advertised auto-negotiation: Yes

Speed: 100Mb/s

Duplex: Full

Port: Twisted Pair

PHYAD: 1

Transceiver: internal

Auto-negotiation: on

Supports Wake-on: g

Wake-on: g

Current message level: 0x000000ff (255)

Link detected: yes

上面给出的例子说明网卡有 10baseT,100baseT 和 1000baseT 三种选择,目前正自适应为 100baseT(Speed: 100Mb/s)。可以通过 ethtool 工具强制网卡工作在 1000baseT 下:

# /sbin/ethtool -s eth0 speed 1000 duplex full autoneg off

iptraf

两台主机之间有网线(或无线)、路由器、交换机等设备,测试两台主机之间的网络性能的一个办法就是在这两个系统之间互发数据并统计结果,看看吞吐量、延迟、速率如何。iptraf 就是一个很好的查看本机网络吞吐量的好工具,支持文字图形界面,很直观。

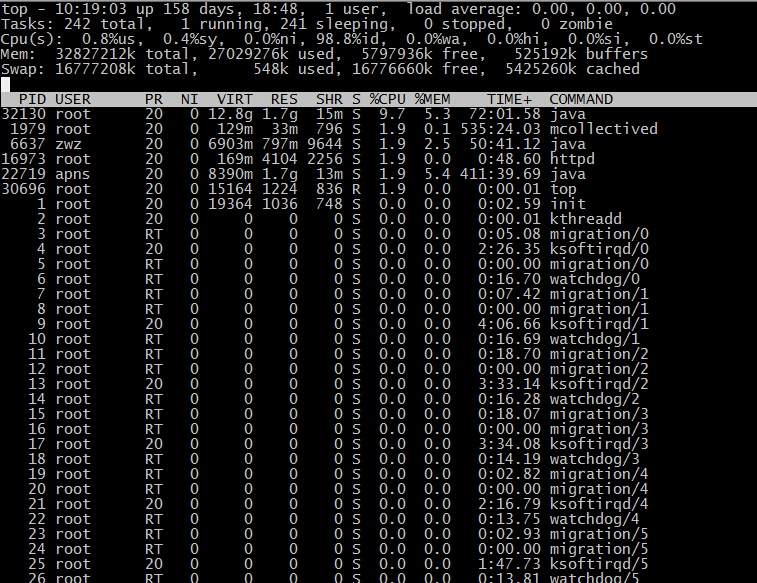

TOP

第一行:

10:01:23 — 当前系统时间

126 days, 14:29 — 系统已经运行了126天14小时29分钟(在这期间没有重启过)

2 users — 当前有2个用户登录系统

load average: 1.15, 1.42, 1.44 — load average后面的三个数分别是1分钟、5分钟、15分钟的负载情况。

load average数据是每隔5秒钟检查一次活跃的进程数,然后按特定算法计算出的数值。如果这个数除以逻辑CPU的数量,结果高于5的时候就表明系统在超负荷运转了。

第二行:

Tasks — 任务(进程),系统现在共有183个进程,其中处于运行中的有1个,182个在休眠(sleep),stoped状态的有0个,zombie状态(僵尸)的有0个。

第三行:cpu状态

6.7% us — 用户空间占用CPU的百分比。

0.4% sy — 内核空间占用CPU的百分比。

0.0% ni — 改变过优先级的进程占用CPU的百分比

92.9% id — 空闲CPU百分比

0.0% wa — IO等待占用CPU的百分比

0.0% hi — 硬中断(Hardware IRQ)占用CPU的百分比

0.0% si — 软中断(Software Interrupts)占用CPU的百分比

在这里CPU的使用比率和windows概念不同,如果你不理解用户空间和内核空间,需要充充电了。

第四行:内存状态

8306544k total — 物理内存总量(8GB)

7775876k used — 使用中的内存总量(7.7GB)

530668k free — 空闲内存总量(530M)

79236k buffers — 缓存的内存量 (79M)

第五行:swap交换分区

2031608k total — 交换区总量(2GB)

2556k used — 使用的交换区总量(2.5M)

2029052k free — 空闲交换区总量(2GB)

4231276k cached — 缓冲的交换区总量(4GB)

这里要说明的是不能用windows的内存概念理解这些数据,如果按windows的方式此台服务器“危矣”:8G的内存总量只剩下530M的可用内存。Linux的内存管理有其特殊性,复杂点需要一本书来说明,这里只是简单说点和我们传统概念(windows)的不同。

第四行中使用中的内存总量(used)指的是现在系统内核控制的内存数,空闲内存总量(free)是内核还未纳入其管控范围的数量。纳入内核管理的内存不见得都在使用中,还包括过去使用过的现在可以被重复利用的内存,内核并不把这些可被重新使用的内存交还到free中去,因此在linux上free内存会越来越少,但不用为此担心。

如果出于习惯去计算可用内存数,这里有个近似的计算公式:第四行的free + 第四行的buffers + 第五行的cached,按这个公式此台服务器的可用内存:530668+79236+4231276 = 4.7GB。

对于内存监控,在top里我们要时刻监控第五行swap交换分区的used,如果这个数值在不断的变化,说明内核在不断进行内存和swap的数据交换,这是真正的内存不够用了。

第六行是空行

第七行以下:各进程(任务)的状态监控

PID — 进程id

USER — 进程所有者

PR — 进程优先级

NI — nice值。负值表示高优先级,正值表示低优先级

VIRT — 进程使用的虚拟内存总量,单位kb。VIRT=SWAP+RES

RES — 进程使用的、未被换出的物理内存大小,单位kb。RES=CODE+DATA

SHR — 共享内存大小,单位kb

S — 进程状态。D=不可中断的睡眠状态 R=运行 S=睡眠 T=跟踪/停止 Z=僵尸进程

%CPU — 上次更新到现在的CPU时间占用百分比

%MEM — 进程使用的物理内存百分比

TIME+ — 进程使用的CPU时间总计,单位1/100秒

COMMAND — 进程名称(命令名/命令行)

多U多核CPU监控

在top基本视图中,按键盘数字“1”,可监控每个逻辑CPU的状况

top命令的补充

top命令是Linux上进行系统监控的首选命令,但有时候却达不到我们的要求,比如当前这台服务器,top监控有很大的局限性。这台服务器运行着websphere集群,有两个节点服务,就是【top视图 01】中的老大、老二两个java进程,top命令的监控最小单位是进程,所以看不到我关心的java线程数和客户连接数,而这两个指标是java的web服务非常重要的指标,通常我用ps和netstate两个命令来补充top的不足。

监控java线程数:

ps -eLf | grep java | wc -l

监控网络客户连接数:

netstat -n | grep tcp | grep 侦听端口 | wc -l

上面两个命令,可改动grep的参数,来达到更细致的监控要求。

W

显示系统当前用户及其运行进程的信息

uptime - 告诉系统已经运行了多久

uptime命令过去只显示系统运行多久。现在,可以显示系统运行多久、当前有多少的用户登录、在过去的1,5,15分钟里平均负载时多少。

# uptime

输入样例:

18:02:41 up 41 days, 23:42, 1 user, load average: 0.00, 0.00, 0.00

1可以被认为是最优的负载值,<CPU数*0.7就是良好

ps - 显示当前运行进程的快照

输出长格式

# ps -Al

输出附加全格式(显示进程在执行时传入的参数)

# ps -AlF

显示进程结构

# ps -AlFH

在进程后显示线程

# ps -AlLm

打印服务器上所有进程

# ps ax

# ps axu

打印进程树

# ps -ejH

# ps axjf

# pstree

打印安全信息

# ps -eo euser,ruser,suser,fuser,f,comm,label

# ps axZ

# ps -eM

查看使用Vivek用户名运行的进程

# ps -U vivek -u vivek u

设置自定义输出格式

# ps -eo pid,tid,class,rtprio,ni,pri,psr,pcpu,stat,wchan:14,comm

# ps axo stat,euid,ruid,tty,tpgid,sess,pgrp,ppid,pid,pcpu,comm

# ps -eopid,tt,user,fname,tmout,f,wchan

只显示Lighttpd的进程ID

# ps -C lighttpd -o pid=

或者

# pgrep lighttpd

或者

# pgrep -u vivek php-cgi

显示PID为55977的进程名称

# ps -p 55977 -o comm=

找出消耗内存最多的前10名进程

# ps -auxf | sort -nr -k 4 | head -10

找出使用CPU最多的前10名进程

# ps -auxf | sort -nr -k 3 | head -10

proc文件系统 - 各种内核信息

/proc目录下文件提供了很多不同硬件设备和内核的详细信息。更多详情参见Linux kernel /proc。一般/proc例如:

# cat /proc/cpuinfo

# cat /proc/meminfo

# cat /proc/zoneinfo

# cat /proc/mounts