备注:OpenCV版本 2.4.10

在数据的挖掘和分析中,最基本和首要的任务是对数据进行分类,解决这个问题的常用方法是机器学习技术。通过使用已知实例集合中所有样本的属性值作为机器学习算法的训练集,导出一个分类机制后,再使用这个分类机制判别一个新实例的属性,并且可以通过不间断的学习,持续丰富和优化该分类机制,使机器具有像大脑一样的思考能力。

常用的分类方法有决策树分类、贝叶斯分类等。然而这些方法存在的问题是当数据量巨大时,分类的准确率不高。对于这样的困难问题,Boosting及其衍生算法提供了一个理想的解决途径。

Boosting算法是一种把若干个分类器整合为一个分类器的方法,其基本思想是:把一个复杂的分类任务分配给多位专家进行判断。这些专家可能并不是真正的专家,而仅仅是比普通人专业一点,他们称为弱分类器,依据一定机制,综合各位专家的结论,形成强分类器,得到最终的判断。

Boosting算法中应用最为广泛也最为有效的是1995年提出的AdaBoost(Adaptive Boosting,自适应增强)方法,其自适应之处在于前一个基本分类器分错的样本会得到加强,加权后的全体样本再次被用来训练下一个分类器,每一轮训练都会产生一个弱分类器,直到达到某个预订的足够小的错误率或者达到预先定义的最大迭代次数。

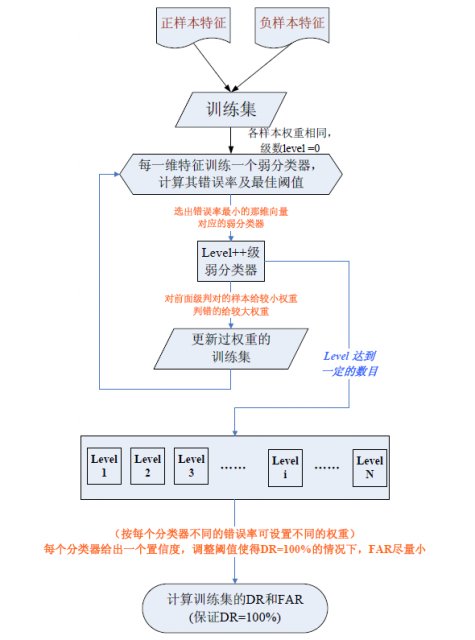

具体来说,整个AdaBoost迭代算法分为3步:

- 初始化训练数据的权值分布。如果有N个样本,则每一个训练样本最开始时都被赋予相同的权值:1/N。

- 训练弱分类器。具体训练过程中,如果某个样本点已经被准确地分类,那么在构造下一个训练集中,它的权值就被降低;相反,如果某个样本点没有被准确地分类,那么它的权值就得到提高。然后,权值更新过的样本集被用于训练下一个分类器,整个训练过程如此迭代地进行下去。

- 将各个训练得到的弱分类器组合成强分类器。各个弱分类器的训练过程结束后,加大分类误差率小的弱分类器的权重,使其在最终的分类函数中起着较大的决定作用,而降低分类误差率大的弱分类器的权重,使其在最终的分类函数中起着较小的决定作用。换言之,误差率低的弱分类器在最终分类器中占的权重较大,否则较小。

以下是AdaBoost算法在线训练流程:

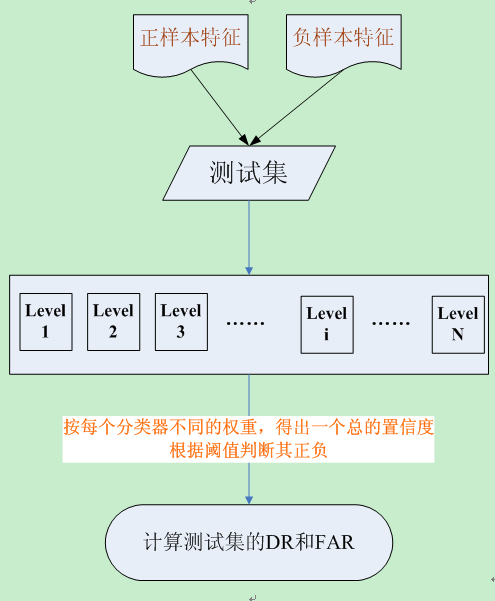

离线检测流程图:

AdaBoost与以往Boosting算法不同的是,AdaBoost的各个弱分类器是通过改变数据分布来实现的,每次训练后,根据弱分类器的评价结果,更新样本权重,进而影响下一次训练。使用AdaBoost分类器可以排除一些次要的训练数据特征,将注意力放在关键的特征上面。

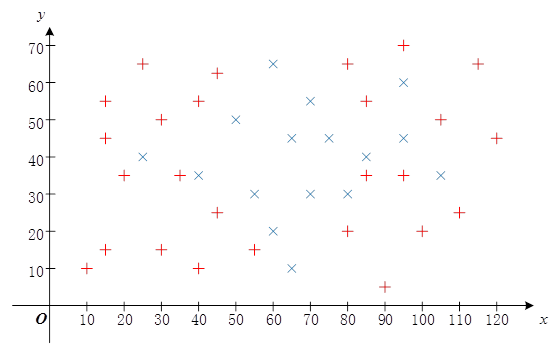

下边代码是参考赵春江博客里的一个AdaBoost算法的应用,假定有如下两类样本,一类是Red,一类是Blue,样本分布如下。AdaBoost根据提供的样品进行训练分类器,之后输入新的坐标点(55,25),用来判断输入是Red,还是Blue:

#include "opencv2/core/core.hpp"

#include "opencv2/highgui/highgui.hpp"

#include "opencv2/imgproc/imgproc.hpp"

#include "opencv2/ml/ml.hpp"

#include <iostream>

using namespace cv;

using namespace std;

int main( int argc, char** argv )

{

//训练样本

float trainingData[42][2]={ {40, 55},{35, 35},{55, 15},{45, 25},{10, 10},{15, 15},{40, 10},

{30, 15},{30, 50},{100, 20},{45, 65},{20, 35},{80, 20},{90, 5},

{95, 35},{80, 65},{15, 55},{25, 65},{85, 35},{85, 55},{95, 70},

{105, 50},{115, 65},{110, 25},{120, 45},{15, 45},

{55, 30},{60, 65},{95, 60},{25, 40},{75, 45},{105, 35},{65, 10},

{50, 50},{40, 35},{70, 55},{80, 30},{95, 45},{60, 20},{70, 30},

{65, 45},{85, 40} };

Mat trainingDataMat(42, 2, CV_32FC1, trainingData);

//训练样本的响应值

float responses[42] = {'R','R','R','R','R','R','R','R','R','R','R','R','R','R','R','R',

'R','R','R','R','R','R','R','R','R','R',

'B','B','B','B','B','B','B','B','B','B','B','B','B','B','B','B' };

Mat responsesMat(42, 1, CV_32FC1, responses);

float priors[2] = {1, 1}; //先验概率

CvBoostParams params( CvBoost::REAL, // boost_type

10, // weak_count

0.95, // weight_trim_rate

15, // max_depth

false, // use_surrogates

priors // priors

);

CvBoost boost;

boost.train ( trainingDataMat,

CV_ROW_SAMPLE,

responsesMat,

Mat(),

Mat(),

Mat(),

Mat(),

params

);

//预测样本

float myData[2] = {55, 25};

Mat myDataMat(2, 1, CV_32FC1, myData);

double r = boost.predict( myDataMat );

cout<<endl<<"result: "<<(char)r<<endl;

return 0;

}

浙公网安备 33010602011771号

浙公网安备 33010602011771号