GIT RE-BASIN: MERGING MODELS MODULO PERMUTATION SYMMETRIES (1)

在深度学习模型的训练过程中,经常会遇到这样的现象:每次训练,虽然初始值、随机种子、训练数据的顺序不一样,但是得到的loss曲线都差不多,在验证集上的结果也差不多.这篇论文从land scape的角度解释了这个问题:神经网络的loss landscape并不是我们想象中的很混乱、毫无规律,而是在permutation symmetry的意义下只有一个basin,这样即使每次训练的初始值、随机种子、训练数据的顺序不一样,最终都是进入到这个basin里面,所以loss曲线和验证集上的结果都差不多.

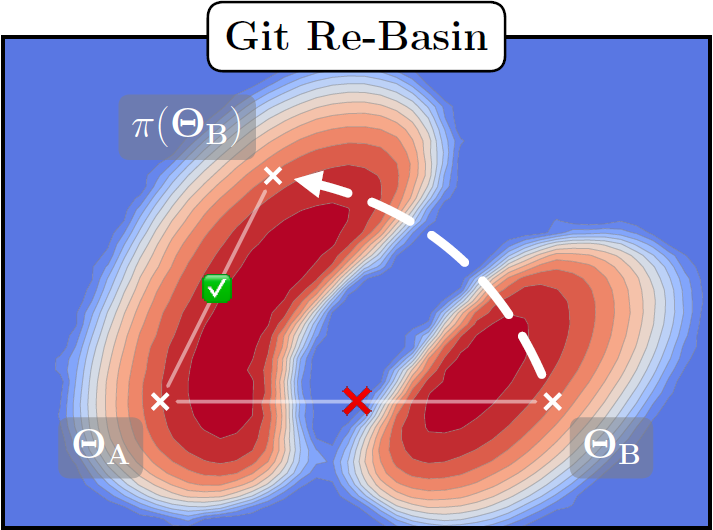

将神经网络中同一层的神经元顺序交换一下并不会改变这一层的输出,也就是说变换前后的模型在permutation symmetry的意义下是等价的,如下图所示:

ΘA与ΘB在两个不同的basin,但是通过等效变换以后,把ΘB变换到∏(ΘB),它们实际上是在同一个basin里面.

浙公网安备 33010602011771号

浙公网安备 33010602011771号