Cyclical Learning Rates

学习率的设置是深度学习中一个比较重要的问题,Cyclical Learning Rates(CLR)提出了一种新的方法,即让学习率周期性的变化,而不是像之前的方法那样让学习率单调递减变化.

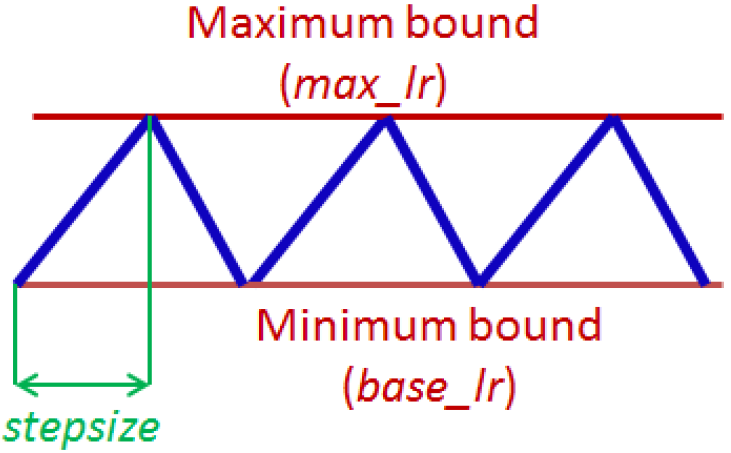

Cyclical learning rates其实比较简单,只需要3个参数:

(1)base_lr:学习率的最小值;

(2)max_lr:学习率的最大值;

(3)stepsize:变化周期的一半.

如何确定max_lr呢?给出了用不同的学习率训练CIFAR-10得到的精确度,如下图硕士,取得最高准确度的学习率的2倍就是max_lr,base_lr是max_lr的1/4~1/3.

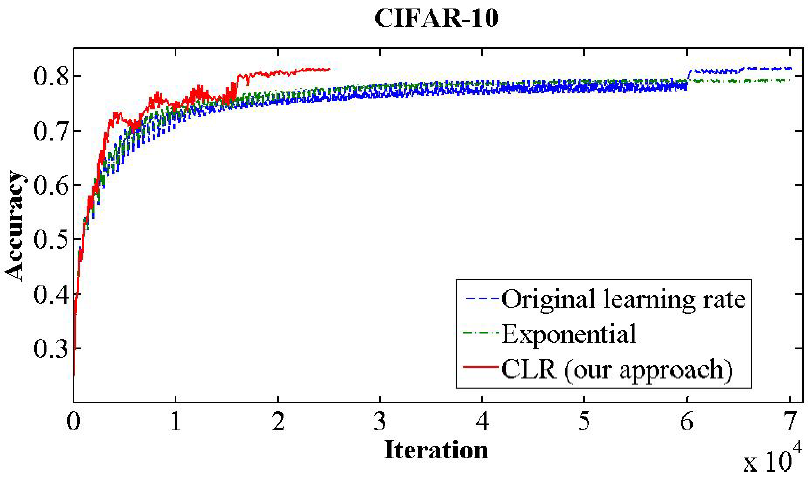

通过实验,证明了Cyclical learning rates可以用更少的迭代次数获得更高的精确度.

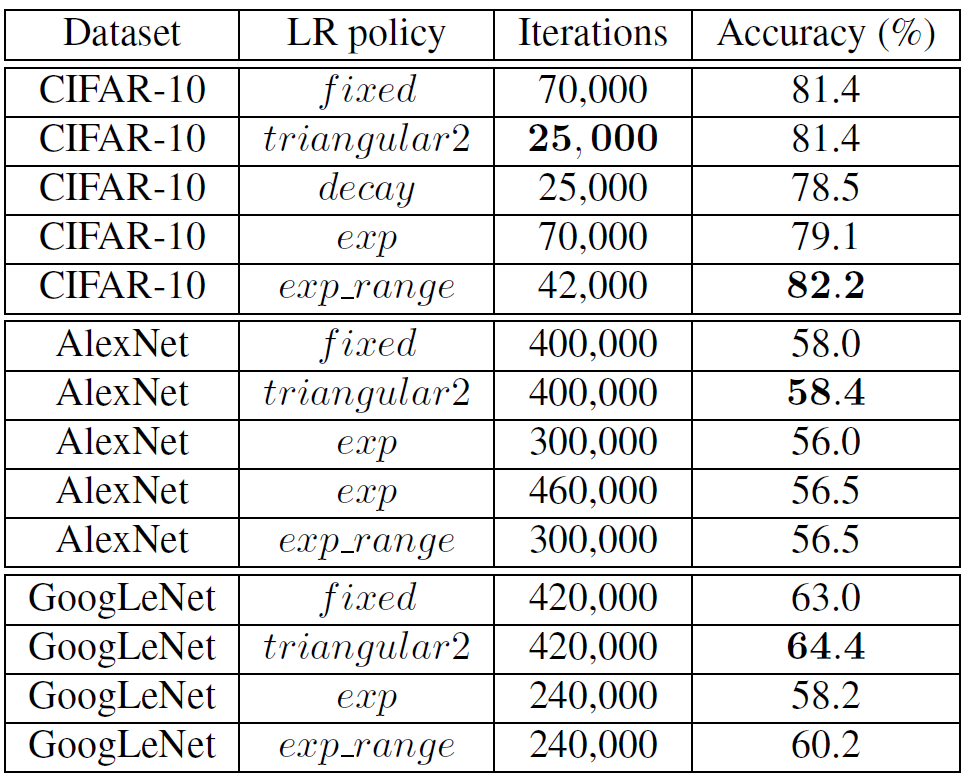

下面是更加详细的实验结果:

虽然CLR的提出是为了避免自适应学习率(Adaptive learning rates)的巨大计算量,但是在实际中,往往把两者结合起来使用,如MMDetection3D就把CLR和AdamW结合起来使用.

浙公网安备 33010602011771号

浙公网安备 33010602011771号