K8s存储

卷(Volume)

Container 中的文件在磁盘上是临时存放的,这给 Container 中运行的较重要的应用程序带来一些问题。 问题之一是当容器崩溃时文件丢失。 kubelet 会重新启动容器,但容器会以干净的状态重启。 第二个问题会在同一 Pod 中运行多个容器并共享文件时出现。 Kubernetes 卷(Volume) 这一抽象概念能够解决这两个问题。

卷类型

本地卷

emptyDir:创建一个空卷,挂载到Pod中的容器,Pod删除该卷也会被删除。

应用场景:

- Pod中容器之间的数据共享

- 缓存空间,例如基于磁盘的归并排序。

- 为耗时较长的计算任务提供检查点,以便任务能方便地从崩溃前状态恢复执行。

- 在 Web 服务器容器服务数据时,保存内容管理器容器获取的文件。

查看卷位置:docker ps 查看容器名,找到对应Pod ID

/var/lib/kubelet/pods//.....

示例:

apiVersion: v1

kind: Pod

metadata:

name: test-pd

spec:

containers:

- image: k8s.gcr.io/test-webserver

name: test-container

volumeMounts:

- mountPath: /cache

name: cache-volume

volumes:

- name: cache-volume

emptyDir: {}

hostPath:挂载Node文件系统上文件或者目录到Pod中的容器。

应用场景:

- Pod中容器需要访问宿主机文件

- 运行一个需要访问 Docker 内部机制的容器;可使用 hostPath 挂载 /var/lib/docker 路径。

- 在容器中运行 cAdvisor 时,以 hostPath 方式挂载 /sys。

- 允许 Pod 指定给定的 hostPath 在运行 Pod 之前是否应该存在,是否应该创建以及应该以什么方式存在。

支持的 type 值如下:

| 取值 | 行为 |

|---|---|

| 空字符串(默认)用于向后兼容,这意味着在安装 hostPath 卷之前不会执行任何检查。 | |

| DirectoryOrCreate | 如果在给定路径上什么都不存在,那么将根据需要创建空目录,权限设置为 0755,具有与 kubelet 相同的组和属主信息。 |

| Directory | 在给定路径上必须存在的目录。 |

| FileOrCreate | 如果在给定路径上什么都不存在,那么将在那里根据需要创建空文件,权限设置为 0644,具有与 kubelet 相同的组和所有权。 |

| File | 在给定路径上必须存在的文件。 |

| Socket | 在给定路径上必须存在的 UNIX 套接字。 |

| CharDevice | 在给定路径上必须存在的字符设备。 |

| BlockDevice | 在给定路径上必须存在的块设备。 |

示例:

apiVersion: v1

kind: Pod

metadata:

name: test-pd

spec:

containers:

- image: k8s.gcr.io/test-webserver

name: test-container

volumeMounts:

- mountPath: /test-pd

name: test-volume

volumes:

- name: test-volume

hostPath:

# 宿主上目录位置

path: /data

# 此字段为可选

type: Directory

网络卷

nfs:nfs 卷能将 NFS (网络文件系统) 挂载到你的 Pod 中。 不像 emptyDir 那样会在删除 Pod 的同时也会被删除,nfs 卷的内容在删除 Pod 时会被保存,卷只是被卸载。 这意味着 nfs 卷可以被预先填充数据,并且这些数据可以在 Pod 之间共享。

示例:

apiVersion: apps/v1 # for versions before 1.9.0 use apps/v1beta2

kind: Deployment

metadata:

name: redis

spec:

selector:

matchLabels:

app: redis

revisionHistoryLimit: 2

template:

metadata:

labels:

app: redis

spec:

containers:

# 应用的镜像

- image: redis

name: redis

imagePullPolicy: IfNotPresent

# 应用的内部端口

ports:

- containerPort: 6379

name: redis6379

env:

- name: ALLOW_EMPTY_PASSWORD

value: "yes"

- name: REDIS_PASSWORD

value: "redis"

# 持久化挂接位置,在docker中

volumeMounts:

- name: redis-persistent-storage

mountPath: /data

volumes:

# 宿主机上的目录

- name: redis-persistent-storage

nfs:

path: /k8s-nfs/redis/data

server: 192.168.8.150

ceph(cpthfs:文件存储,rbd:块存储),glusterfs

略....

公有云

aws,azure

略....

k8s资源

downwardAPI,configMap,secret

略....

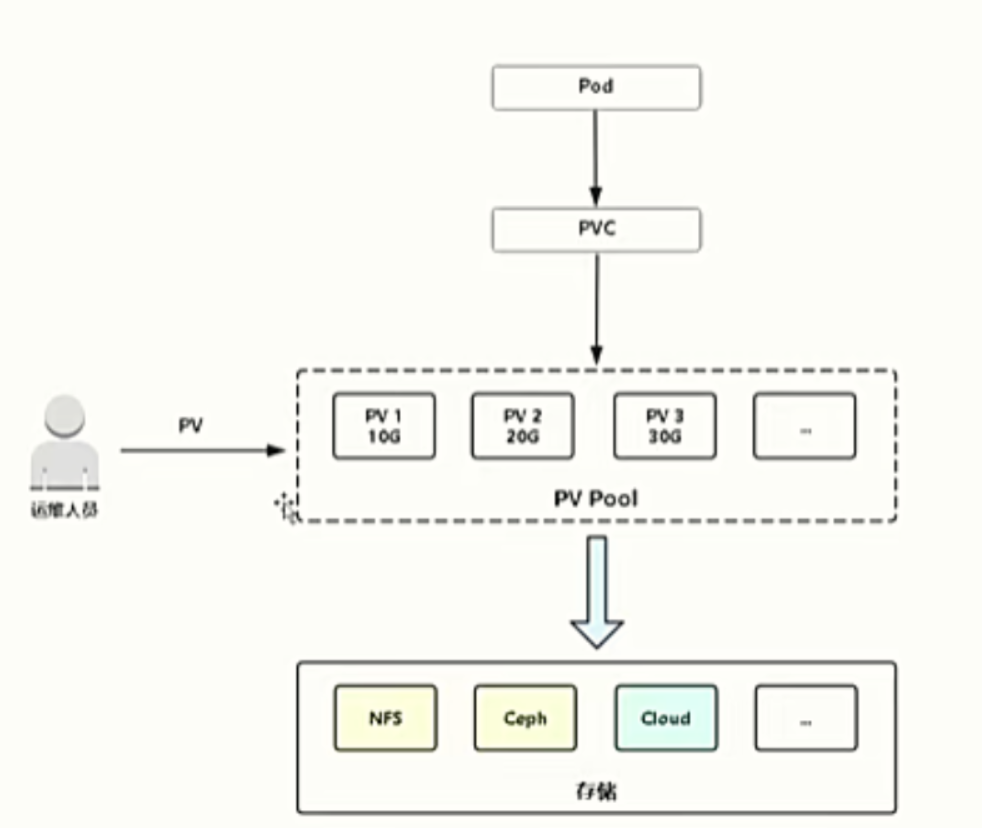

pv类型

pv分为静态pv和动态pv

持久卷(Persistent Volume)

是集群中的一块存储,可以由管理员事先制备, 或者使用存储类(Storage Class)来动态制备。 持久卷是集群资源,就像节点也是集群资源一样。PV 持久卷和普通的 Volume 一样, 也是使用卷插件来实现的,只是它们拥有独立于任何使用 PV 的 Pod 的生命周期。

持久卷申领(PersistentVolumeClaim,PVC) 表达的是用户对存储的请求。概念上与 Pod 类似。 Pod 会耗用节点资源,而 PVC 申领会耗用 PV 资源。Pod 可以请求特定数量的资源(CPU 和内存);同样 PVC 申领也可以请求特定的大小和访问模式(PVC支不支持被多个 Pod 访问,取决于访问模型 accessMode 的定义)

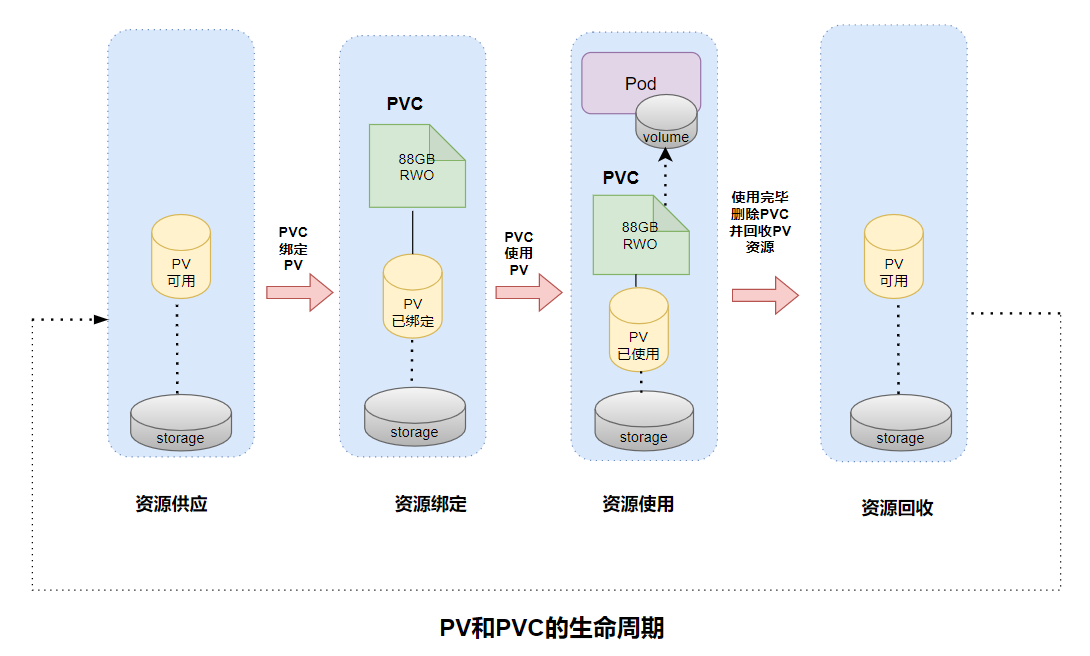

PV和PVC的生命周期如下图:

PV 持久卷是用插件的形式来实现的。Kubernetes 目前支持以下插件:

awsElasticBlockStore - AWS 弹性块存储(EBS)

azureDisk - Azure Disk

azureFile - Azure File

cephfs - CephFS volume

csi - 容器存储接口 (CSI)

fc - Fibre Channel (FC) 存储

gcePersistentDisk - GCE 持久化盘

glusterfs - Glusterfs 卷

hostPath - HostPath 卷 (仅供单节点测试使用;不适用于多节点集群;请尝试使用 local 卷作为替代)

iscsi - iSCSI (SCSI over IP) 存储

local - 节点上挂载的本地存储设备

nfs - 网络文件系统 (NFS) 存储

portworxVolume - Portworx 卷

rbd - Rados 块设备 (RBD) 卷

vsphereVolume - vSphere VMDK 卷

访问模式

PersistentVolume 卷可以用资源提供者所支持的任何方式挂载到宿主系统上。 如下表所示,提供者(驱动)的能力不同,每个 PV 卷的访问模式都会设置为对应卷所支持的模式值。 例如,NFS 可以支持多个读写客户,但是某个特定的 NFS PV 卷可能在服务器上以只读的方式导出。 每个 PV 卷都会获得自身的访问模式集合,描述的是特定 PV 卷的能力。

| 模式 | 作用 |

|---|---|

| RWO-ReadWriteOnce | 卷可以被一个节点以读写方式挂载。 ReadWriteOnce访问模式也允许运行在同一节点上的多个 Pod 访问卷。 |

| ROX-ReadOnlyMany | 卷可以被多个节点以只读方式挂载。 |

| RWX-ReadWriteMany | 卷可以被多个节点以读写方式挂载。 |

| RWOP-ReadWriteOncePod | 卷可以被单个 Pod 以读写方式挂载。 如果你想确保整个集群中只有一个 Pod 可以读取或写入该 PVC, 请使用 ReadWriteOncePod 访问模式。这只支持 CSI 卷以及需要 Kubernetes 1.22 以上版本。 |

静态pv

注:静态pv需要人为主动创建好pv,等待pvc声明使用

示例:

apiVersion: v1

kind: PersistentVolume

metadata:

name: nfs-pv

labels:

pv: nfs-pv

spec:

capacity:

storage: 10Gi

accessModes:

- ReadWriteMany

persistentVolumeReclaimPolicy: Retain

storageClassName: nfs # 注意这里使用nfs的storageClassName,如果没改k8s的默认storageClassName的话,这里可以省略

nfs:

path: /data/nfs/nginx/

server: 10.198.1.155

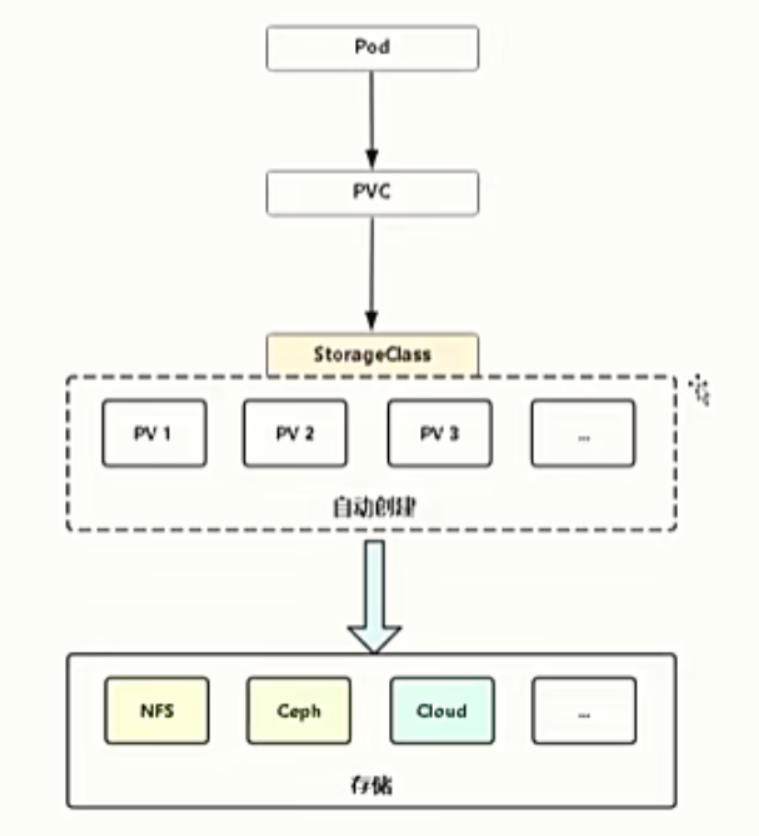

动态pv

注:动态pv由原来人为创建pv变成由StorageClass声明存储插件,自动创建pv

动态pv有存储类(StorageClass)的概念,简称sc,目前sc支持的内置制备器(Provisioner:供应者)如下:

存储制备器

| 卷插件 | 内置制备器 | 配置例子 |

|---|---|---|

| AWSElasticBlockStore | ✓ | AWS EBS |

| AzureFile | ✓ | Azure File |

| AzureDisk | ✓ | Azure Disk |

| CephFS | - | - |

| Cinder | ✓ | OpenStack Cinder |

| FC | - | - |

| FlexVolume | - | - |

| Flocker | ✓ | - |

| GCEPersistentDisk | ✓ | GCE PD |

| Glusterfs | ✓ | Glusterfs |

| iSCSI | - | - |

| Quobyte | ✓ | Quobyte |

| NFS | - | NFS |

| RBD | ✓ | Ceph RBD |

| VsphereVolume | ✓ | vSphere |

| PortworxVolume | ✓ | Portworx Volume |

| ScaleIO | ✓ | ScaleIO |

| StorageOS | ✓ | StorageOS |

| Local | - | Local |

由于官方目前还不支持nfs制备器,所以得去社区找到对应的外部制备器,如下就是nfs的外部制备器制作

准备三个文件:deployment.yaml、rbac.yaml、class.yaml

deployment.yaml:pvc声明使用存储类,利用deployment控制器动态创建pv

rbac.yaml:对接入nfs的授权

class.yaml:创建可被pvc声明的StorageClass资源

- rbac.yaml

apiVersion: v1

kind: ServiceAccount

metadata:

name: nfs-client-provisioner

namespace: default #根据实际环境设定namespace,下面类同

---

kind: ClusterRole

apiVersion: rbac.authorization.k8s.io/v1

metadata:

name: nfs-provisioner-runner

rules:

- apiGroups: [""]

resources: ["persistentvolumes"]

verbs: ["get", "list", "watch", "create", "delete"]

- apiGroups: [""]

resources: ["persistentvolumeclaims"]

verbs: ["get", "list", "watch", "update"]

- apiGroups: ["storage.k8s.io"]

resources: ["storageclasses"]

verbs: ["get", "list", "watch"]

- apiGroups: [""]

resources: ["events"]

verbs: ["create", "update", "patch"]

- apiGroups: [""]

resources: ["services", "endpoints"]

verbs: ["get"]

- apiGroups: ["extensions"]

resources: ["podsecuritypolicies"]

resourceNames: ["nfs-provisioner"]

verbs: ["use"]

---

kind: ClusterRoleBinding

apiVersion: rbac.authorization.k8s.io/v1

metadata:

name: run-nfs-provisioner

subjects:

- kind: ServiceAccount

name: nfs-client-provisioner

# replace with namespace where provisioner is deployed

namespace: default

roleRef:

kind: ClusterRole

name: nfs-provisioner-runner

apiGroup: rbac.authorization.k8s.io

---

kind: Role

apiVersion: rbac.authorization.k8s.io/v1

metadata:

name: leader-locking-nfs-provisioner

rules:

- apiGroups: [""]

resources: ["endpoints"]

verbs: ["get", "list", "watch", "create", "update", "patch"]

---

kind: RoleBinding

apiVersion: rbac.authorization.k8s.io/v1

metadata:

name: leader-locking-nfs-provisioner

subjects:

- kind: ServiceAccount

name: nfs-client-provisioner

# replace with namespace where provisioner is deployed

namespace: default

roleRef:

kind: Role

name: leader-locking-nfs-provisioner

apiGroup: rbac.authorization.k8s.io

- deployment.yaml

apiVersion: apps/v1

kind: Deployment

metadata:

name: nfs-client-provisioner

labels:

app: nfs-client-provisioner

# replace with namespace where provisioner is deployed

namespace: default

spec:

replicas: 1

strategy:

type: Recreate ## 更新策略为删除再创建

selector:

matchLabels:

app: nfs-client-provisioner

template:

metadata:

labels:

app: nfs-client-provisioner

spec:

serviceAccountName: nfs-client-provisioner

containers:

- name: nfs-client-provisioner

image: lizhenliang/nfs-client-provisioner:latest ## 实际中可以使用阿里云海外构建所需镜像

volumeMounts:

- name: nfs-client-root

mountPath: /persistentvolumes

env:

- name: PROVISIONER_NAME

value: k8s-sc/k8s-nfs-provisioner ## 后面存储类的provisioner值要和这个保持一致

- name: NFS_SERVER

value: 10.3.243.101 ## 必须和volumes设置保持一致

- name: NFS_PATH

value: /ifs/kubernetes ## 必须和volumes设置保持一致

volumes:

- name: nfs-client-root

nfs:

server: 10.3.243.101

path: /ifs/kubernetes

- class.yaml

apiVersion: storage.k8s.io/v1

kind: StorageClass

metadata:

name: nfs-client

annotations:

storageclass.kubernetes.io/is-default-class: "true" #---设置为默认的storageclass

provisioner: k8s-sc/k8s-nfs-provisioner #---动态卷分配者名称,必须和上面创建的"PROVISIONER_NAME"变量中设置的Name一致

parameters:

archiveOnDelete: "true" #---设置为"false"时删除PVC不会保留数据,"true"则保留数据

动态pv示例1:

kind: PersistentVolumeClaim

apiVersion: v1

metadata:

name: nfs-dynamic-claim

spec:

storageClassName: example-nfs #--需要与上面创建的storageclass的名称一致

accessModes:

- ReadWriteMany

resources:

requests:

storage: 90Gi

动态pv示例2:

apiVersion: apps/v1

kind: StatefulSet

metadata:

name: web

spec:

selector:

matchLabels:

app: nginx

serviceName: "nginx"

replicas: 1

template:

metadata:

labels:

app: nginx

spec:

terminationGracePeriodSeconds: 10

containers:

- name: nginx

image: nginx

ports:

- containerPort: 80

name: web

volumeMounts:

- name: www

mountPath: /usr/share/nginx/html

volumeClaimTemplates:

- metadata:

name: www

spec:

accessModes: [ "ReadWriteOnce" ]

storageClassName: "pmp-nfs"

resources:

requests:

storage: 1Gi

阿里云subpath方式创建sc

apiVersion: storage.k8s.io/v1

kind: StorageClass

metadata:

name: ailab-nas-subpath

mountOptions:

- nolock,tcp,noresvport

- vers=3

parameters:

volumeAs: subpath

server: "3ffd6486ed-coi20.cn-shanghai.nas.aliyuncs.com:/zht"

provisioner: nasplugin.csi.alibabacloud.com

reclaimPolicy: Retain

---

#测试创建pvc

kind: PersistentVolumeClaim

apiVersion: v1

metadata:

name: nas-csi-pvc-test

spec:

accessModes:

- ReadWriteMany

storageClassName: ailab-nas-subpath

resources:

requests:

storage: 1Gi

浙公网安备 33010602011771号

浙公网安备 33010602011771号