DeepSeek 模型 Qwen 与 Llama 区别?以及1.5b、7b、8b、14b、32b、70b和671b有啥区别?

DeepSeek 开源模型 Qwen 与 Llama 区别,以及量化介绍

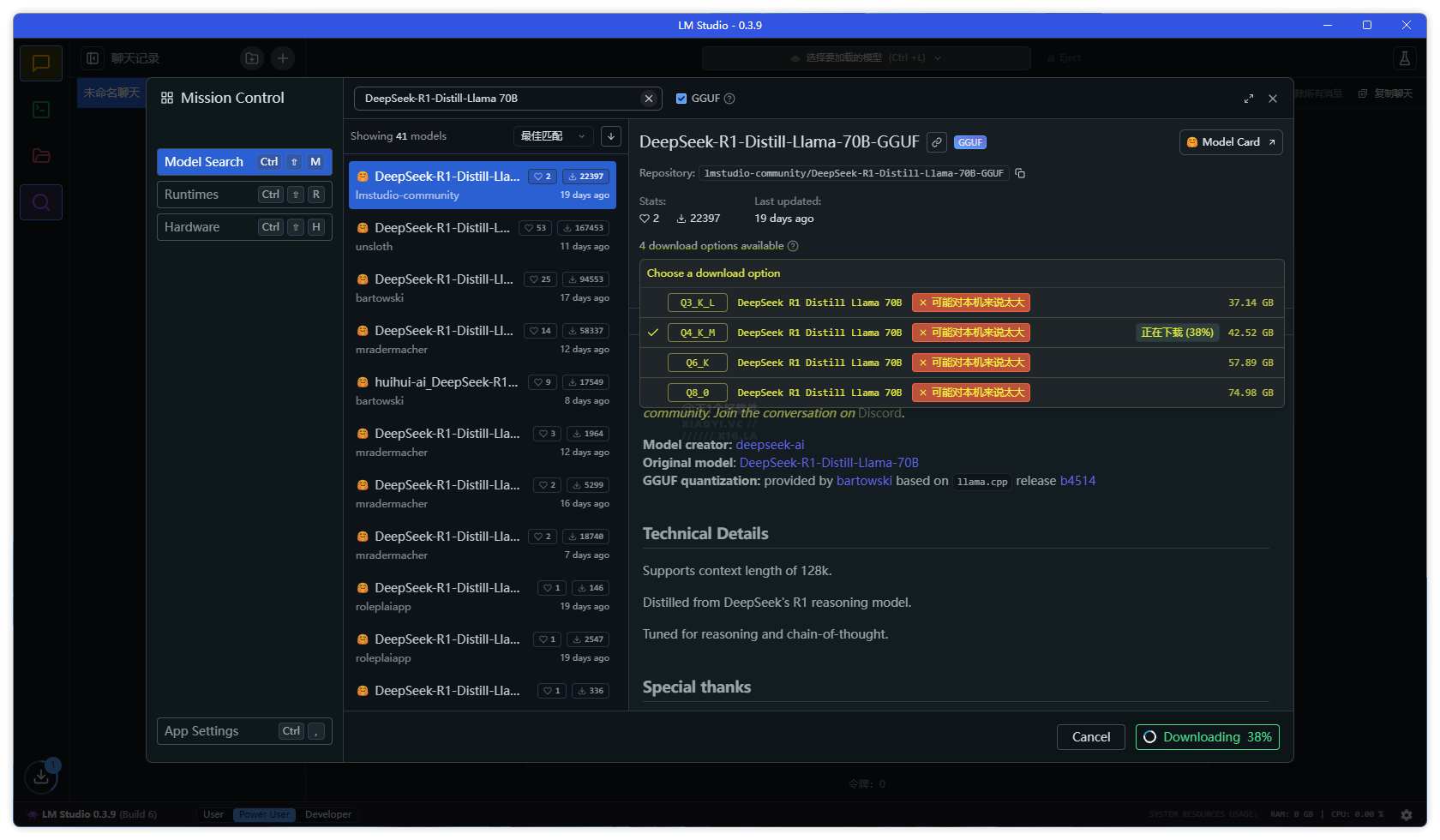

DeepSeek 开源的大模型,有些小伙伴在本地部署下载 DeepSeek 模型时会看到 Qwen 与 Llama 蒸馏模型,以及 Q2、Q3、Q4、Q5、Q8 等的代号,不知道如何选择版本。例如教过大家的👉 超简单!3 步部署国产 AI 神器「DeepSeek」到你的电脑。又或者通过 LM Studio 本地部署模型工具里面搜索到的 DeepSeek 模型有很多版本。

本文给大家介绍 Qwen 与 Llama 区别,以及量化介绍,让你根据环境需求、硬件要求、是否需要更快的推理速度还是更高的精度,来选择相关的模型版本。

| 模型名称 | 参数量 | 基础架构 | 适用场景 |

|---|---|---|---|

| DeepSeek-R1-Distill-Qwen-1.5B | 1.5B | Qwen2.5 | 适合移动设备或资源受限的终端 |

| DeepSeek-R1-Distill-Qwen-7B | 7B | Qwen2.5 | 适合普通文本生成工具 |

| DeepSeek-R1-Distill-Llama-8B | 8B | Llama3.1 | 适合小型企业日常文本处理 |

| DeepSeek-R1-Distill-Qwen-14B | 14B | Qwen2.5 | 适合桌面级应用 |

| DeepSeek-R1-Distill-Qwen-32B | 32B | Qwen2.5 | 适合专业领域知识问答系统 |

| DeepSeek-R1-Distill-Llama-70B | 70B | Llama3.3 | 适合科研、学术研究等高要求场景 |

Qwen 与 Llama 的区别

Qwen (通义千问)

-

开发者:阿里巴巴达摩院

-

架构:基于 Transformer,支持更长上下文窗口

-

训练数据:侧重中文语料,兼顾多语言

-

应用场景:中文 NLP 任务优化

Llama (Meta)

-

开发者:Meta (Facebook)

-

架构:基于 Transformer,优化稀疏注意力机制

-

训练数据:以英文为主,涵盖部分多语言数据

-

应用场景:通用任务,适配英文环境更好

量化介绍

Q2、Q3、Q4、Q5、Q8 的代号属于模型量化技术的标识符,主要取决于量化工具(如 GGUF 格式)。量化旨在降低模型存储和计算成本,常见规则如下:

Q2_K

-

位宽:2-bit

-

精度损失:高

-

内存占用:极低

-

推理速度:极快

Q3_K_M

-

位宽:3-bit

-

精度损失:中

-

内存占用:低

-

推理速度:快

Q4_K_S

-

位宽:4-bit

-

精度损失:低

-

内存占用:中等

-

推理速度:中等

Q5_K_M

-

位宽:5-bit

-

精度损失:极低

-

内存占用:较高

-

推理速度:较慢

Q8_0

-

位宽:8-bit

-

精度损失:可忽略

-

内存占用:高

-

推理速度:慢

省流

中文处理优先选择 Qwen 版本,量化参数根据自己的需求和硬件来选(本地部署「DeepSeek」模型硬件配置要求),例如低配置电脑,优先选择 Q3_K_M 或者 Q4_K_S,也可根据推理速度需求来选一个平衡的参数模型。富哥请随意。

出处:https://www.jamlee.net/archives/1714/

=======================================================================================

deepseek-r1的1.5b、7b、8b、14b、32b、70b和671b有啥区别?

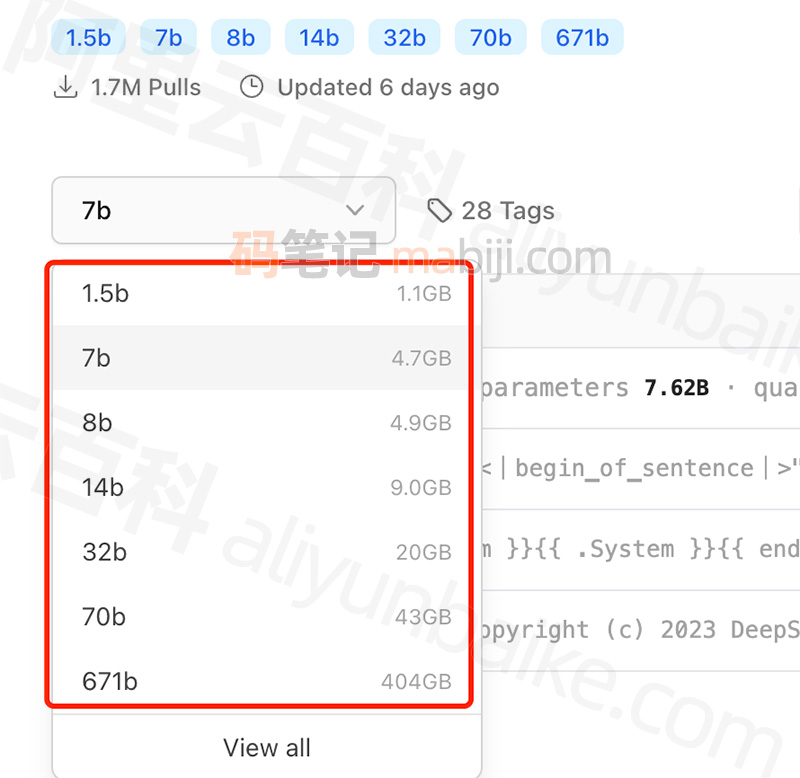

deepseek-r1的1.5b、7b、8b、14b、32b、70b和671b有啥区别?码笔记mabiji.com分享:1.5B、7B、8B、14B、32B、70B是蒸馏后的小模型,671B是基础大模型,它们的区别主要体现在参数规模、模型容量、性能表现、准确性、训练成本、推理成本和不同使用场景:

更新时间:2025年2月9日,关于不同尺寸的DeepSeek-R1版本介绍、参数量、特点、使用场景和硬件配置,可以参考下表:

| DeepSeek模型版本 | 参数量 | 特点 | 适用场景 | 硬件配置 |

|---|---|---|---|---|

| DeepSeek-R1-1.5B | 1.5B |

轻量级模型,参数量少,模型规模小

|

适用于轻量级任务,如短文本生成、基础问答等

|

4核处理器、8G内存,无需显卡 |

| DeepSeek-R1-7B | 7B | 平衡型模型,性能较好,硬件需求适中 |

适合中等复杂度任务,如文案撰写、表格处理、统计分析等

|

8核处理器、16G内存,Ryzen7或更高,RTX 3060(12GB)或更高 |

| DeepSeek-R1-8B | 8B | 性能略强于7B模型,适合更高精度需求 | 适合需要更高精度的轻量级任务,比如代码生成、逻辑推理等 | 8核处理器、16G内存,Ryzen7或更高,RTX 3060(12GB)或4060 |

| DeepSeek-R1-14B | 14B | 高性能模型,擅长复杂的任务,如数学推理、代码生成 |

可处理复杂任务,如长文本生成、数据分析等

|

i9-13900K或更高、32G内存,RTX 4090(24GB)或A5000 |

| DeepSeek-R1-32B | 32B | 专业级模型,性能强大,适合高精度任务 | 适合超大规模任务,如语言建模、大规模训练、金融预测等 | Xeon 8核、128GB内存或更高,2-4张A100(80GB)或更高 |

| DeepSeek-R1-70B | 70B | 顶级模型,性能最强,适合大规模计算和高复杂任务 | 适合高精度专业领域任务,比如多模态任务预处理。这些任务对硬件要求非常高,需要高端的 CPU 和显卡,适合预算充足的企业或研究机构使用 | Xeon 8核、128GB内存或更高,8张A100/H100(80GB)或更高 |

| DeepSeek-R1-671B | 671B | 超大规模模型,性能卓越,推理速度快,适合极高精度需求 |

适合国家级 / 超大规模 AI 研究,如气候建模、基因组分析等,以及通用人工智能探索

|

64核、512GB或更高,8张A100/H100 |

参数规模

参数规模的区别,模型越大参数数量逐渐增多,参数数量越多,模型能够学习和表示的知识就越丰富,理论上可以处理更复杂的任务,对各种语言现象和语义理解的能力也更强。比如在回答复杂的逻辑推理问题、处理长文本上下文信息时,70B的模型可能会比1.5B的模型表现得更出色。

- 671B:参数数量最多,模型容量极大,能够学习和记忆海量的知识与信息,对各种复杂语言模式和语义关系的捕捉能力最强。

- 1.5B-70B:参数数量相对少很多,模型容量依次递增,捕捉语言知识和语义关系的能力也逐渐增强,但整体不如671B模型丰富。

关于DeepSeek部署安装教程,可以部署到本地电脑、阿里云或腾讯云上,小白零基础教程如下:

- 本地部署: DeepSeek爆火,如何免费部署到你的电脑上?获取顶级推理能力教程来了

- 阿里云:小白必看:DeepSeek安装部署——阿里云PAI零代码1分钟成功教程!

- 腾讯云:1分钟:DeepSeek-R1大模型一键部署教程by腾讯云HAI,如此简单!

准确性和泛化能力

随着模型规模的增大,在各种基准测试和实际应用中的准确性通常会有所提高。例如在回答事实性问题、进行文本生成等任务时,大规模的模型如 70B、32B 可能更容易给出准确和合理的答案,并且对于未曾见过的数据和任务的泛化能力也更强。小模型如 1.5B、7B 在一些简单任务上可能表现尚可,但遇到复杂或罕见的问题时,准确性可能会降低。

- 671B:在各类任务上的准确性通常更高,如在数学推理、复杂逻辑问题解决、长文本理解与生成等方面,能更准确地给出答案和合理的解释。

- 1.5B-70B:随着参数增加准确性逐步提升,但小参数模型在面对复杂任务或罕见问题时,准确性相对较差,如 1.5B、7B、8B 模型可能在一些简单任务上表现尚可,但遇到复杂问题容易出错。

训练成本

模型参数越多,训练所需的计算资源、时间和数据量就越大。训练70B的模型需要大量的GPU计算资源和更长的训练时间,相比之下,1.5B的模型训练成本要低得多。

- 671B:训练需要大量的计算资源,如众多的高性能 GPU,训练时间极长,并且需要海量的数据来支撑,训练成本极高。

- 1.5B-70B:训练所需的计算资源和时间相对少很多,对数据量的需求也相对较小,训练成本较低。

推理成本

推理成本在实际应用中,推理阶段大模型需要更多的内存和计算时间来生成结果。例如在部署到本地设备或实时交互场景中,1.5B、7B等较小模型可能更容易满足低延迟、低功耗的要求,而 70B、32B等大模型可能需要更高性能的硬件支持,或者在推理时采用量化等技术来降低资源需求。

- 671B:推理时需要更多的内存来加载模型参数,生成结果的计算时间也较长,对硬件性能要求很高。

- 1.5B-70B:在推理时对硬件要求相对较低,加载速度更快,生成结果的时间更短,能更快速地给出响应。

适用场景

轻量级应用,需要快速响应需求可以选择1.5B、7B 这样的小模型可以快速加载和运行,能够在较短时间内给出结果,满足用户的即时需求,小模型适合一些对响应速度要求高、硬件资源有限的场景,如手机端的智能助手、简单的文本生成工具等;在科研、学术研究、专业内容创作等对准确性和深度要求较高的领域,选择70B、32B等大模型更适合。

- 671B:适用于对准确性和性能要求极高、对成本不敏感的场景,如大型科研机构进行前沿科学研究、大型企业进行复杂的商业决策分析等。

- 1.5B-7B:适合对响应速度要求高、硬件资源有限的场景,如移动端的简单智能助手、轻量级的文本生成工具等,可快速加载和运行。

- 8B-14B:可用于一些对模型性能有一定要求,但又没有超高性能硬件支持的场景,如小型企业的日常文本处理、普通的智能客服等。

- 32B-70B:能满足一些对准确性有较高要求,同时硬件条件相对较好的场景,如专业领域的知识问答系统、中等规模的内容创作平台等。

关于DeepSeek大模型费用价格,请参考这篇文章:DeepSeek模型价格:R1+V3最新收费标准,低至0.1元百万tokens

云服务器租用优惠价格,2025年最新:

出处:https://www.mabiji.com/deepseek/deepseekr115b7b8b14b32b70b671b.html

如果,您希望更容易地发现我的新博客,不妨点击一下绿色通道的【关注我】。(●'◡'●)

因为,我的写作热情也离不开您的肯定与支持,感谢您的阅读,我是【Jack_孟】!

本文来自博客园,作者:jack_Meng,转载请注明原文链接:https://www.cnblogs.com/mq0036/p/18712786

【免责声明】本文来自源于网络,如涉及版权或侵权问题,请及时联系我们,我们将第一时间删除或更改!

posted on 2025-02-13 11:28 jack_Meng 阅读(5456) 评论(0) 编辑 收藏 举报

【推荐】编程新体验,更懂你的AI,立即体验豆包MarsCode编程助手

【推荐】凌霞软件回馈社区,博客园 & 1Panel & Halo 联合会员上线

【推荐】抖音旗下AI助手豆包,你的智能百科全书,全免费不限次数

【推荐】博客园社区专享云产品让利特惠,阿里云新客6.5折上折

【推荐】轻量又高性能的 SSH 工具 IShell:AI 加持,快人一步

· 一个费力不讨好的项目,让我损失了近一半的绩效!

· 清华大学推出第四讲使用 DeepSeek + DeepResearch 让科研像聊天一样简单!

· 实操Deepseek接入个人知识库

· CSnakes vs Python.NET:高效嵌入与灵活互通的跨语言方案对比

· Plotly.NET 一个为 .NET 打造的强大开源交互式图表库

2017-02-13 C#检查网络是否可以连接互联网

2014-02-13 消息队列在VB.NET数据库开发中的应用

2014-02-13 使用C#和MSMQ开发消息处理程序

2014-02-13 MSDN Windows XP Professional x64 Edition with SP2 +VL简体中文语言包+序列号