java面试题

一、基础

1. 如何用io创建文件

java中创建文件的五种方法:

1、Java 8 Files.newBufferedWriter

java8 提供的newBufferedWriter可以创建文件,并向文件内写入数据。可以通过追加写模式,向文件内追加内容。

@Test

void testCreateFile1() throws IOException {

String fileName = "D:\\data\\test\\newFile.txt";

Path path = Paths.get(fileName);

// 使用newBufferedWriter创建文件并写文件

// 这里使用了try-with-resources方法来关闭流,不用手动关闭

try (BufferedWriter writer =

Files.newBufferedWriter(path, StandardCharsets.UTF_8)) {

writer.write("Hello World -创建文件!!");

}

//追加写模式

try (BufferedWriter writer =

Files.newBufferedWriter(path,

StandardCharsets.UTF_8,

StandardOpenOption.APPEND)){

writer.write("Hello World -字母哥!!");

}

}

2、Java 7 Files.write

下面的这种方式Files.write,是笔者推荐的方式,语法简单,而且底层是使用Java NIO实现的。同样提供追加写模式向已经存在的文件种追加数据。这种方式是实现文本文件简单读写最方便快捷的方式。

@Test

void testCreateFile2() throws IOException {

String fileName = "D:\\data\\test\\newFile2.txt";

// 从JDK1.7开始提供的方法

// 使用Files.write创建一个文件并写入

Files.write(Paths.get(fileName),

"Hello World -创建文件!!".getBytes(StandardCharsets.UTF_8));

// 追加写模式

Files.write(

Paths.get(fileName),

"Hello World -字母哥!!".getBytes(StandardCharsets.UTF_8),

StandardOpenOption.APPEND);

}

3、PrintWriter:PrintWriter是一个比较古老的文件创建及写入方式,从JDK1.5就已经存在了,比较有特点的是:PrintWriter的println方法,可以实现一行一行的写文件。

@Test

void testCreateFile3() throws IOException {

String fileName = "D:\\data\\test\\newFile3.txt";

// JSD 1.5开始就已经存在的方法

try (PrintWriter writer = new PrintWriter(fileName, "UTF-8")) {

writer.println("Hello World -创建文件!!");

writer.println("Hello World -字母哥!!");

}

// Java 10进行了改进,支持使用StandardCharsets指定字符集

/*try (PrintWriter writer = new PrintWriter(fileName, StandardCharsets.UTF_8)) {

writer.println("first line!");

writer.println("second line!");

} */

}

4、File.createNewFile()

createNewFile()方法的功能相对就比较纯粹,只是创建文件不做文件写入操作。 返回true表示文件成功,返回 false表示文件已经存在.可以配合FileWriter 来完成文件的写操作

@Test

void testCreateFile4() throws IOException {

String fileName = "D:\\data\\test\\newFile4.txt";

File file = new File(fileName);

// 返回true表示文件成功

// false 表示文件已经存在

if (file.createNewFile()) {

System.out.println("创建文件成功!");

} else {

System.out.println("文件已经存在不需要重复创建");

}

// 使用FileWriter写文件

try (FileWriter writer = new FileWriter(file)) {

writer.write("Hello World -创建文件!!");

}

}

5、最原始的管道流方法

最原始的方式就是使用管道流嵌套的方法,但是笔者觉得这种方法历久弥新,使用起来非常灵活。你想去加上Buffer缓冲,你就嵌套一个BufferedWriter,你想去向文件中写java对象你就嵌套一个ObjectOutputStream。但归根结底要用到FileOutputStream。

@Test

void testCreateFile5() throws IOException {

String fileName = "D:\\data\\test\\newFile5.txt";

try(FileOutputStream fos = new FileOutputStream(fileName);

OutputStreamWriter osw = new OutputStreamWriter(fos);

BufferedWriter bw = new BufferedWriter(osw);){

bw.write("Hello World -创建文件!!");

bw.flush();

}

}

2. 过滤器、拦截器、监听器对比及使用场景分析

过滤器

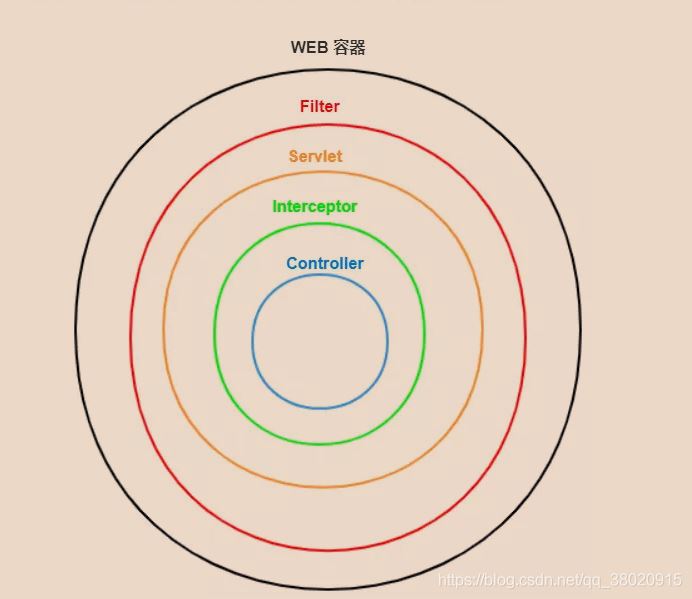

过滤器(Filter)是处于客户端与服务器目标资源之间的⼀道过滤技术。

● 生活中的过滤器:净⽔器,空气净化器

● web中的过滤器:当访问服务器的资源时,过滤器可以将请求拦截下来,完成⼀些特殊的功能。

过滤器作用

● 执行是在Servlet之前,客户端发送请求时,会先经过Filter,再到达目标Servlet中;响应时, 会根据执行流程再次反向执行Filter

● ⼀般用于完成通用的操作。如:登录验证、统⼀编码处理、敏感字符过滤

常见的过滤器用途主要包括:对用户请求进行统一认证、对用户的访问请求进行记录和审核、对用户发送的数据进行过滤或替换、转换图象格式、对响应内容进行压缩以减少传输量、对请求或响应进行加解密处理、触发资源访问事件等**。

生命周期

过滤器的配置比较简单,直接实现Filter 接口即可,也可以通过@WebFilter注解实现对特定URL拦截,看到Filter 接口中定义了三个方法。

- init() :该方法在容器启动初始化过滤器时被调用,它在 Filter 的整个生命周期只会被调用一次。注意:这个方法必须执行成功,否则过滤器会不起作用。

- doFilter() :容器中的每一次请求都会调用该方法, FilterChain 用来调用下一个过滤器 Filter。

- destroy(): 当容器销毁 过滤器实例时调用该方法,一般在方法中销毁或关闭资源,在过滤器 Filter 的整个生命周期也只会被调用一次。

@Component

@WebFilter("/myservlet1")//过滤路径

public class MyFilter implements Filter {

@Override

public void init(FilterConfig filterConfig) throws ServletException {

System.out.println("Filter 前置");

}

@Override

public void doFilter(ServletRequest servletRequest, ServletResponse servletResponse, FilterChain filterChain) throws IOException, ServletException {

System.out.println("Filter 处理中");

filterChain.doFilter(servletRequest, servletResponse);

}

@Override

public void destroy() {

System.out.println("Filter 后置");

}

}

值得注意的是doFilter()方法,它有三个参数(ServletRequest,ServletResponse,FilterChain),从前两个参数我们可以发现:过滤器可以完成任何协议的过滤操作!

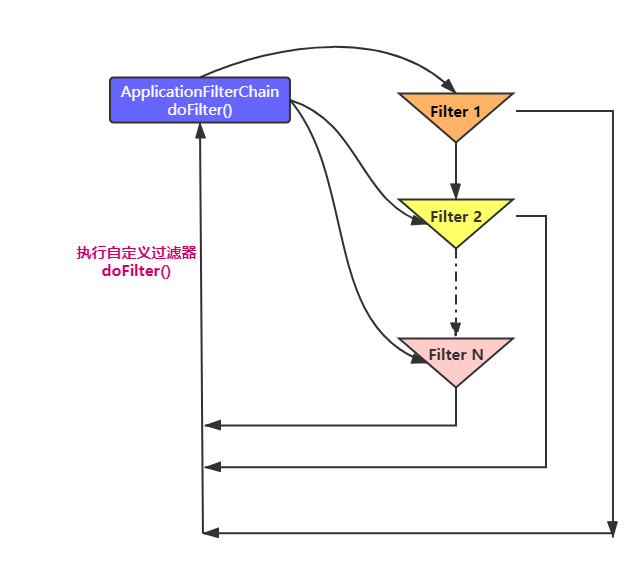

在Java中就使用了链式结构。把所有的过滤器都放在FilterChain里边,如果符合条件,就执行下一个过滤器(如果没有过滤器了,就执行目标资源)。

过滤器链和优先级

过滤器链

客户端对服务器请求之后,服务器调用Servlet之前会执行⼀组过滤器(多个过滤器),那么这组过滤 器就称为⼀条过滤器链。

每个过滤器实现某个特定的功能,当第⼀个Filter的doFilter方法被调用时,Web服务器会创建⼀个代 表Filter链的FilterChain对象传递给该方法。在doFilter方法中,开发⼈员如果调用了FilterChain对象 的doFilter方法,则Web服务器会检查FilterChain对象中是否还有filter,如果有,则调用第2个filter, 如果没有,则调用目标资源。

优先级:

● 如果为注解的话,是按照类全名称的字符串顺序决定作用顺序

● 如果web.xml,按照 filter-mapping注册顺序,从上往下

● web.xml配置高于注解方式

过滤器路径

过滤器的过滤路径通常有三种形式:

- 精确过滤匹配 ,比如/index.jsp /myservlet1

- 后缀过滤匹配,比如.jsp、.html、*.jpg

- 通配符过滤匹配/,表示拦截所有。注意过滤器不能使用/匹配。 /aaa/bbb/ 允许

过滤器应用

@WebFilter(urlPatterns = "/*")

@Component

public class EncodingFilter implements Filter {

@Override

public void init(FilterConfig filterConfig) throws ServletException {

}

@Override

public void doFilter(ServletRequest servletRequest, ServletResponse servletResponse,

FilterChain filterChain) throws IOException, ServletException {

//统⼀处理请求和响应的乱码

servletRequest.setCharacterEncoding("UTF-8");

servletResponse.setContentType("text/html;charset=utf-8");

filterChain.doFilter(servletRequest,servletResponse);

}

@Override

public void destroy() {

}

}

拦截器

拦截器作用

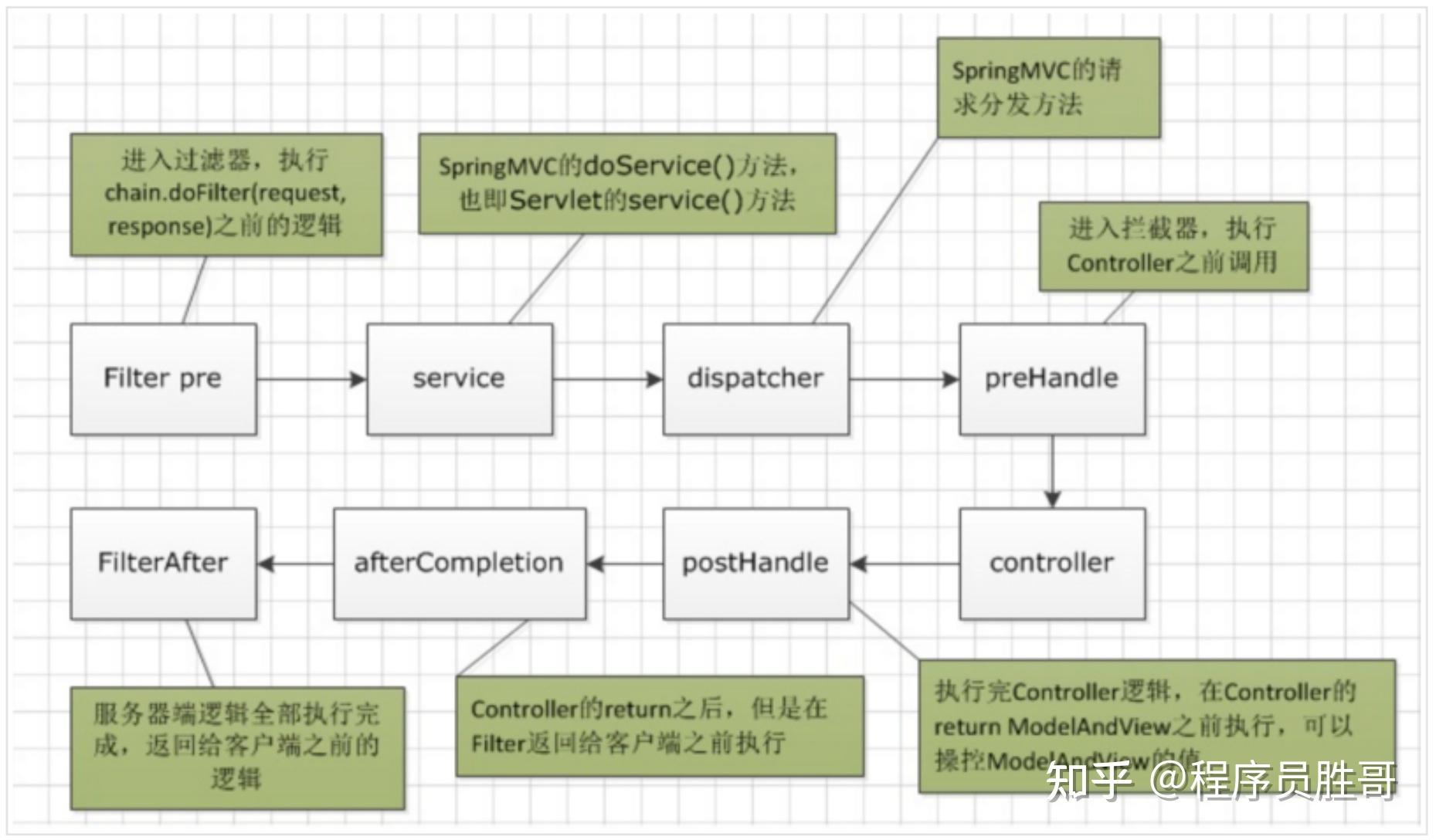

拦截器采用AOP的设计思想, 它跟过滤器类似, 用来拦截处理方法在之前和之后执行一些 跟主业务没有关系的一些公共功能:

比如:可以实现:权限控制、日志、异常记录、记录方法执行时间.....

自定义拦截器

SpringMVC提供了拦截器机制,允许运行目标方法之前进行一些拦截工作或者目标方法运行之后进行一下其他相关的处理。自定义的拦截器必须实现 HandlerInterceptor接口。

HandlerInterceptor 接口中定义了三个方法。

- preHandle(HttpServletRequest request, HttpServletResponse response, Object handler) :这个方法将在请求处理之前进行调用。注意:如果该方法的返回值为false ,将视为当前请求结束,不仅自身的拦截器会失效,还会导致其他的拦截器也不再执行。

- postHandle(HttpServletRequest request, HttpServletResponse response, Object handler):只有在 preHandle() 方法返回值为true 时才会执行。会在Controller 中的方法调用之后,DispatcherServlet 返回渲染视图之前被调用。 此时我们可以通过modelAndView(模型和视图对象)对模型数据进行处理或对视图进行处理,modelAndView也可能为null。

- afterCompletion(HttpServletRequest request, HttpServletResponse response, Object handler):只有在 preHandle() 方法返回值为true 时才会执行。在整个请求结束之后, DispatcherServlet 渲染了对应的视图之后执行。如性能监控中我们可以在此记录结束时间并输出消耗时间,还可以进行一些资源清理,类似于trycatchfinally中的finally,但仅调用处理器执行链中preHandle返回true的拦截器才会执行。

import org.springframework.web.method.HandlerMethod;

import org.springframework.web.servlet.HandlerInterceptor;

import org.springframework.web.servlet.ModelAndView;

import javax.servlet.http.HttpServletRequest;

import javax.servlet.http.HttpServletResponse;

import java.util.Arrays;

public class MyFirstInterceptor implements HandlerInterceptor {

/**

* 在处理方法之前执 日志、权限、 记录调用时间

* @param request 可以在方法请求进来之前更改request中的属性值

* @param response

* @param handler 封装了当前处理方法的信息

* @return true 后续调用链是否执行/ false 则中断后续执行

* @throws Exception

*/

@Override

public boolean preHandle(HttpServletRequest request, HttpServletResponse response, Object handler) throws Exception {

// 在请求映射到对应的处理方法映射,实现类才是HandlerMethod。

// 如果是视图控制器,实现类ParameterizableViewController

if(handler instanceof HandlerMethod ) {

HandlerMethod handMethod = (HandlerMethod) handler;

}

/*System.out.println("-------类["+handMethod.getBean().getClass().getName()+"]" +

"方法名["+handMethod.getMethod().getName()+"]" +

"参数["+ Arrays.toString(handMethod.getMethod().getParameters()) +"]前执行--------preHandle");*/

System.out.println(this.getClass().getName()+"---------方法后执行,在渲染之前--------------preHandle");

return true;

}

/**

* 如果preHandle返回false则会不会允许该方法

* 在请求执行后执行, 在视图渲染之前执行

* 当处理方法出现了异常则不会执行方法

* @param request

* @param response 可以在方法执行后去更改response中的信息

* @param handler 封装了当前处理方法的信息

* @param modelAndView 封装了model和view.所以当请求结束后可以修改model中的数据或者新增model数据,也可以修改view的跳转

* @throws Exception

*/

@Override

public void postHandle(HttpServletRequest request, HttpServletResponse response, Object handler, ModelAndView modelAndView) throws Exception {

System.out.println(this.getClass().getName()+"---------方法后执行,在渲染之前--------------postHandle");

}

/**

* 如果preHandle返回false则会不会允许该方法

* 在视图渲染之后执行,相当于try catch finally 中finally,出现异常也一定会执行该方法

* @param request

* @param response

* @param handler

* @param ex Exception对象,在该方法中去做一些:记录异常日志的功能,或者清除资源

* @throws Exception

*/

@Override

public void afterCompletion(HttpServletRequest request, HttpServletResponse response, Object handler, Exception ex) throws Exception {

System.out.println(this.getClass().getName()+"---------在视图渲染之后--------------afterCompletion");

}

}

在spring boot 项目中配置

实现 WebMvcConfigurer 接口 并重写 addInterceptors方法。

import org.springframework.context.annotation.Bean;

import org.springframework.context.annotation.Configuration;

import org.springframework.web.servlet.config.annotation.InterceptorRegistry;

import org.springframework.web.servlet.config.annotation.WebMvcConfigurer;

@Configuration

public class InterceptorAdapter implements WebMvcConfigurer {

@Bean

public MyFirstInterceptor myInterceptor(){

return new MyFirstInterceptor();

}

public void addInterceptors(InterceptorRegistry registry) {

registry.addInterceptor(myInterceptor()).addPathPatterns("/**").excludePathPatterns("/*.html");

}

}

@RequestMapping("/test01")

public String test01(){

System.out.println("请求方法执行中...");

return "admin";

}

}

输出结果

demo.springboot.web.MyFirstInterceptor---------方法后执行,在渲染之前--------------preHandle 请求方法执行中... demo.springboot.web.MyFirstInterceptor---------方法后执行,在渲染之前--------------postHandle demo.springboot.web.MyFirstInterceptor---------在视图渲染之后--------------afterCompletion

通过运行结果能够发现拦截器的执行顺序如下:

可以看到先执行拦截器的preHandle方法》执行目标方法》执行 拦截器的postHandle方法》执行页面跳转》执行拦截器的afterCompletion方法 。

在配置拦截器的时候有两个需要注意的点:

1、如果prehandle方法返回值 为false,那么意味着不放行,那么就会造成后续的所有操作都中断

2、如果执行到方法中出现异常,那么后续流程不会处理但是 afterCompletion方法会执行

配置多个拦截器

import org.springframework.web.servlet.HandlerInterceptor;

import org.springframework.web.servlet.ModelAndView;

import javax.servlet.http.HttpServletRequest;

import javax.servlet.http.HttpServletResponse;

public class MySecondInterceptor implements HandlerInterceptor {

@Override

public boolean preHandle(HttpServletRequest request, HttpServletResponse response, Object handler) throws Exception {

System.out.println(this.getClass().getName()+"‐‐‐‐‐‐‐ >preHandle");

return true;

}

@Override

public void postHandle(HttpServletRequest request, HttpServletResponse response, Object handler, ModelAndView modelAndView) throws Exception {

System.out.println(this.getClass().getName()+"--------------postHandle");

}

@Override

public void afterCompletion(HttpServletRequest request, HttpServletResponse response, Object handler, Exception ex) throws Exception {

System.out.println(this.getClass().getName()+"-------------afterCompletion");

}

}

@Configuration

public class InterceptorAdapter implements WebMvcConfigurer {

@Bean

public MyFirstInterceptor myInterceptor(){

return new MyFirstInterceptor();

}

@Bean

public MySecondInterceptor mySecondInterceptor(){

return new MySecondInterceptor();

}

public void addInterceptors(InterceptorRegistry registry) {

registry.addInterceptor(myInterceptor()).addPathPatterns("/**").excludePathPatterns("/*.html");

registry.addInterceptor(mySecondInterceptor()).addPathPatterns("/**").excludePathPatterns("/*.html");

}

}

运行结果:

demo.springboot.web.MyFirstInterceptor---------方法后执行,在渲染之前--------------preHandle demo.springboot.web.MySecondInterceptor‐‐‐‐‐‐‐ >preHandle

请求方法执行中...

demo.springboot.web.MySecondInterceptor--------------postHandle

demo.springboot.web.MyFirstInterceptor---------方法后执行,在渲染之前--------------postHandle demo.springboot.web.MySecondInterceptor-------------afterCompletion

demo.springboot.web.MyFirstInterceptor---------在视图渲染之后--------------afterCompletion

大家可以看到对应的效果,谁先执行取决于配置的顺序。

如果执行的时候核心的业务代码出问题了,那么已经通过的拦截器的 afterCompletion会接着执行。

拦截器跟过滤器的区别

定义过滤器

@WebFilter("/*")

public class MyFilter implements Filter {

@Override

public void init(FilterConfig filterConfig) throws ServletException {

}

@Override

public void doFilter(ServletRequest servletRequest, ServletResponse servletResponse, FilterChain filterChain) throws IOException, ServletException {

System.out.println("===================过滤器前===================");

filterChain.doFilter(servletRequest,servletResponse);

System.out.println("===================过滤器后===================");

}

@Override

public void destroy() {

}

}

定义拦截器

public class MyFirstInterceptor implements HandlerInterceptor {

@Override

public boolean preHandle(HttpServletRequest request, HttpServletResponse response, Object handler) throws Exception {

System.out.println("---------方法后执行,在渲染之前--------------preHandle");

return true;

}

@Override

public void postHandle(HttpServletRequest request, HttpServletResponse response, Object handler, ModelAndView modelAndView) throws Exception {

System.out.println("---------方法后执行,在渲染之前--------------postHandle");

}

@Override

public void afterCompletion(HttpServletRequest request, HttpServletResponse response, Object handler, Exception ex) throws Exception {

System.out.println("---------在视图渲染之后--------------afterCompletion");

}

}

运行结果:

=过滤器前=

---------方法后执行,在渲染之前--------------preHandle

请求方法执行中...

---------方法后执行,在渲染之前--------------postHandle

---------在视图渲染之后--------------afterCompletion

=过滤器后=

过滤器Filter执行了两次,拦截器Interceptor只执行了一次。

过滤器和拦截器区别:

1、过滤器是基于函数回调的,而拦截器是基于java反射的

在我们自定义的过滤器中都会实现一个 doFilter()方法,这个方法有一个FilterChain 参数,而实际上它是一个回调接口。ApplicationFilterChain是它的实现类, 这个实现类内部也有一个 doFilter() 方法就是回调方法。

public interface FilterChain {

void doFilter(ServletRequest var1, ServletResponse var2) throws IOException, ServletException;

}

ApplicationFilterChain里面能拿到我们自定义的xxxFilter类,在其内部回调方法doFilter()里调用各个自定义xxxFilter过滤器,并执行 doFilter() 方法。

public final class ApplicationFilterChain implements FilterChain {

@Override

public void doFilter(ServletRequest request, ServletResponse response) {

...//省略

internalDoFilter(request,response);

}

private void internalDoFilter(ServletRequest request, ServletResponse response){

if (pos < n) {

//获取第pos个filter

ApplicationFilterConfig filterConfig = filters[pos++];

Filter filter = filterConfig.getFilter();

...

filter.doFilter(request, response, this);

}

}

}

而每个xxxFilter 会先执行自身的 doFilter() 过滤逻辑,最后在执行结束前会执行filterChain.doFilter(servletRequest, servletResponse),也就是回调ApplicationFilterChain的doFilter() 方法,以此循环执行实现函数回调。

@Override

public void doFilter(ServletRequest servletRequest, ServletResponse servletResponse, FilterChain filterChain) throws IOException, ServletException {

filterChain.doFilter(servletRequest, servletResponse);

}

2、过滤器依赖于servlet容器,而拦截器不依赖与Servlet容器,拦截器依赖SpringMVC

3、过滤器几乎对所有的请求都可以起作用,而拦截器只能对SpringMVC请求起作用

4、拦截器可以访问处理方法的上下文,而过滤器不可以

5、触发时机不同,过滤器Filter是在请求进入容器后,但在进入servlet之前进行预处理,请求结束是在servlet处理完以后。

拦截器 Interceptor 是在请求进入servlet后,在进入Controller之前进行预处理的,Controller 中渲染了对应的视图之后请求结束。

6、控制执行顺序不同

实际开发过程中,会出现多个过滤器或拦截器同时存在的情况,不过,有时我们希望某个过滤器或拦截器能优先执行,就涉及到它们的执行顺序。

过滤器用@Order注解控制执行顺序,通过@Order控制过滤器的级别,值越小级别越高越先执行。

@Order(Ordered.HIGHEST_PRECEDENCE)

@Component

public class MyFilter2 implements Filter {

拦截器默认的执行顺序,就是它的注册顺序,也可以通过Order手动设置控制,值越小越先执行。

@Override

public void addInterceptors(InterceptorRegistry registry) {

registry.addInterceptor(new MyInterceptor2()).addPathPatterns("/**").order(2);

registry.addInterceptor(new MyInterceptor1()).addPathPatterns("/**").order(1);

registry.addInterceptor(new MyInterceptor()).addPathPatterns("/**").order(3);

}

看到输出结果发现,先声明的拦截器 preHandle() 方法先执行,而postHandle()方法反而会后执行。

postHandle() 方法被调用的顺序跟 preHandle() 居然是相反的!如果实际开发中严格要求执行顺序,那就需要特别注意这一点。

我们要知道controller 中所有的请求都要经过核心组件DispatcherServlet路由,都会执行它的 doDispatch() 方法,而拦截器postHandle()、preHandle()方法便是在其中调用的。

protected void doDispatch(HttpServletRequest request, HttpServletResponse response) throws Exception {

try {

...........

try {

// 获取可以执行当前Handler的适配器

HandlerAdapter ha = getHandlerAdapter(mappedHandler.getHandler());

// Process last-modified header, if supported by the handler.

String method = request.getMethod();

boolean isGet = "GET".equals(method);

if (isGet || "HEAD".equals(method)) {

long lastModified = ha.getLastModified(request, mappedHandler.getHandler());

if (new ServletWebRequest(request, response).checkNotModified(lastModified) && isGet) {

return;

}

}

// 注意: 执行Interceptor中PreHandle()方法

if (!mappedHandler.applyPreHandle(processedRequest, response)) {

return;

}

// 注意:执行Handle【包括我们的业务逻辑,当抛出异常时会被Try、catch到】

mv = ha.handle(processedRequest, response, mappedHandler.getHandler());

if (asyncManager.isConcurrentHandlingStarted()) {

return;

}

applyDefaultViewName(processedRequest, mv);

// 注意:执行Interceptor中PostHandle 方法【抛出异常时无法执行】

mappedHandler.applyPostHandle(processedRequest, response, mv);

}

}

...........

}

看看两个方法applyPreHandle()、applyPostHandle()具体是如何被调用的,就明白为什么postHandle()、preHandle() 执行顺序是相反的了。

boolean applyPreHandle(HttpServletRequest request, HttpServletResponse response) throws Exception {

HandlerInterceptor[] interceptors = this.getInterceptors();

if(!ObjectUtils.isEmpty(interceptors)) {

for(int i = 0; i < interceptors.length; this.interceptorIndex = i++) {

HandlerInterceptor interceptor = interceptors[i];

if(!interceptor.preHandle(request, response, this.handler)) {

this.triggerAfterCompletion(request, response, (Exception)null);

return false;

}

}

}

return true;

}

void applyPostHandle(HttpServletRequest request, HttpServletResponse response, @Nullable ModelAndView mv) throws Exception {

HandlerInterceptor[] interceptors = this.getInterceptors();

if(!ObjectUtils.isEmpty(interceptors)) {

for(int i = interceptors.length - 1; i >= 0; --i) {

HandlerInterceptor interceptor = interceptors[i];

interceptor.postHandle(request, response, this.handler, mv);

}

}

}

发现两个方法中在调用拦截器数组 HandlerInterceptor[] 时,循环的顺序竟然是相反的。。。,导致postHandle()、preHandle() 方法执行的顺序相反。

总结

过滤器就是筛选出你要的东西,比如requeset中你要的那部分 拦截器在做安全方面用的比较多,比如终止一些流程

过滤器(Filter) :可以拿到原始的http请求,但是拿不到你请求的控制器和请求控制器中的方法的信息。

拦截器(Interceptor):可以拿到你请求的控制器和方法,却拿不到请求方法的参数。

切片(Aspect): 可以拿到方法的参数,但是却拿不到http请求和响应的对象

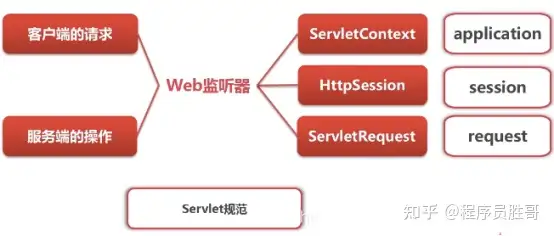

监听器

主要作用是:做一些初始化的内容添加工作、设置一些基本的内容、比如一些参数或者是一些固定的对象等等。

监听器定义为接口,监听的方法需要事件对象传递进来,从而在监听器上通过事件对象获取得到事件源,对事件源进行修改!

监听器组件

- 事件源:拥有事件

- 监听器:监听事件源所拥有的事件(带事件对象参数的)

- 事件对象:事件对象封装了事件源对象

当事件源发生某个动作的时候,它会调用事件监听器的方法,并在调用事件监听器方法的时候把事件对象传递进去。

我们在监听器中就可以通过事件对象获取得到事件源,从而对事件源进行操作!

分类

listener具体分为八种,能够监听包括request域,session域,application域的产生,销毁和属性的变化;

ServletContextAttributeListener、HttpSessionAttributeListener、ServletRequestAttributeListener分别监听着Context、Session、Request对象属性的变化。

按监听的对象划分

可以分为:

- ServletContext对象的监听器

- HttpSession对象的监听器

- ServletRequest对象的监听器

按监听的事件划分

可以分为:

- 对象自身的创建和销毁的监听器

- 对象中属性的创建和消除的监听器

- session中的某个对象的状态变化的监听器

Servlet监听器

在Servlet规范中定义了多种类型的监听器,它们用于监听的事件源分别 ServletContext, HttpSession和ServletRequest这三个域对象

和其它事件监听器略有不同的是,servlet监听器的注册不是直接注册在事件源上,而是由WEB容器负责注册,开发人员只需在web.xml文件中使用标签配置好监听器。

ServletContextListener:监听ServletContext对象的创建和销毁

包含两个方法:

void contextDestroyed(ServletContextEvent sce) :ServletContext对象被销毁之前会调用

void contextInitialized(ServletContextEvent sce) :ServletContext对象创建后会调用该方法

自定义监听器:

使用注解@WebListener

import javax.servlet.*;

import javax.servlet.http.*;

import avax.servlet.annotation.*;

@WebListener

@Component

public class ListenerDemo2 implements ServletContextListener {

public ListenerDemo2() {

}

@Override

public void contextInitialized(ServletContextEvent sce) {

/* This method is called when the servlet context is initialized(when the Web application is deployed). */

//加载资源 //1,获取ServletContext对象

ServletContext servletContext = servletContextEvent.getServletContext();

//2,加载资源⽂件

String contextLoadConfig = servletContext.getInitParameter("contextLoadConfig"); System.out.println("contextLoadConfig:"+contextLoadConfig);

System.out.println("ListenerDemo2 contextInitialized....");

}

@Override

public void contextDestroyed(ServletContextEvent sce) {

/* This method is called when the servlet Context is undeployed or Application Server shuts down. */

System.out.println("ListenerDemo2 contextDestroyed....");

}

}

监听对象的创建和销毁

HttpSessionListener、ServletContextListener、ServletRequestListener分别监控着Session、Context、Request对象的创建和销毁。

package demo.springboot.web;

import org.springframework.stereotype.Component;

import javax.servlet.ServletContextEvent;

import javax.servlet.ServletContextListener;

import javax.servlet.ServletRequestEvent;

import javax.servlet.ServletRequestListener;

import javax.servlet.annotation.WebListener;

import javax.servlet.http.HttpSessionEvent;

import javax.servlet.http.HttpSessionListener;

@Component

@WebListener

public class Listener1 implements ServletContextListener, HttpSessionListener, ServletRequestListener {

public Listener1() {

}

public void contextInitialized(ServletContextEvent sce) {

System.out.println("容器创建了");

}

public void contextDestroyed(ServletContextEvent sce) {

System.out.println("容器销毁了");

}

@Override

public void sessionCreated(HttpSessionEvent se) {

System.out.println("Session创建了");

}

@Override

public void sessionDestroyed(HttpSessionEvent se) {

System.out.println("Session销毁了");

}

@Override

public void requestDestroyed(ServletRequestEvent servletRequestEvent) {

}

@Override

public void requestInitialized(ServletRequestEvent servletRequestEvent) {

}

}

监听器监听到ServletContext的初始化了,Session的创建和ServletContext的销毁。(服务器停掉,不代表Session就被销毁了。Session的创建是在内存中的,所以没看到Session被销毁了)

监听对象属性变化

ServletContextAttributeListener、HttpSessionAttributeListener、ServletRequestAttributeListener分别监听着Context、Session、Request对象属性的变化

这三个接口中都定义了三个方法来处理被监听对象中的属性的增加,删除和替换的事件,同一个事件在这三个接口中对应的方法名称完全相同,只是接受的参数类型不同。

- attributeAdded()

- attributeRemoved()

- attributeReplaced()

public class Listener2 implements ServletContextAttributeListener {

@Override

public void attributeAdded(ServletContextAttributeEvent servletContextAttributeEvent) {

System.out.println("Context对象增加了属性");

}

@Override

public void attributeRemoved(ServletContextAttributeEvent servletContextAttributeEvent) {

System.out.println("Context对象删除了属性");

}

@Override

public void attributeReplaced(ServletContextAttributeEvent servletContextAttributeEvent) {

System.out.println("Context对象替换了属性");

}

}

测试方法

@GetMapping("/test")

public String get(@RequestParam("msg") String msg, HttpServletRequest request){

System.out.println(msg);

request.setAttribute("aa", "123");

return msg;

}

Context对象增加了属性

监听Session内的对象

监听Session内的对象,分别是HttpSessionBindingListener和HttpSessionActivationListener

应用场景

拦截器是在DispatcherServlet这个servlet中执行的,因此所有的请求最先进入Filter,最后离开Filter。其顺序如下。

Filter->Interceptor.preHandle->Handler->Interceptor.postHandle->Interceptor.afterCompletion->Filter

拦截器应用场景

拦截器本质上是面向切面编程(AOP),符合横切关注点的功能都可以放在拦截器中来实现,主要的应用场景包括:

- 登录验证,判断用户是否登录。

- 权限验证,判断用户是否有权限访问资源,如校验token

- 日志记录,记录请求操作日志(用户ip,访问时间等),以便统计请求访问量。

- 处理cookie、本地化、国际化、主题等。

- 性能监控,监控请求处理时长等。

- 通用行为:读取cookie得到用户信息并将用户对象放入请求,从而方便后续流程使用,还有如提取Locale、Theme信息等,只要是多个处理器都需要的即可使用拦截器实现)

过滤器应用场景

- 过滤敏感词汇(防止sql注入)

- 设置字符编码

- URL级别的权限访问控制

- 压缩响应信息

3. 接口和抽象类的区别

相似点:

(1)接口和抽象类都不能被实例化

(2)实现接口或继承抽象类的普通子类都必须实现这些抽象方法

不同点:

(1)抽象类可以包含普通方法和代码块,接口里只能包含抽象方法,静态方法和默认方法,

(2)抽象类可以有构造方法,而接口没有

(3)抽象类中的成员变量可以是各种类型的,接口的成员变量只能是 public static final 类型的,并且必须赋值

4. 重载和重写的区别

重载发生在同一个类中,方法名相同、参数列表、返回类型、权限修饰符可以不同

重写发生在子类中,方法名相、参数列表、返回类型都相同,权限修饰符要大于父类方法,声明异常范围要小于父类方法,但是final和private修饰的方法不可重写

5. ==和equals的区别

比较基本类型,比较的是值,比较引用类型,比较的是内存地址

equlas是Object类的方法,本质上与==一样,但是有些类重写了equals方法,比如String的equals被重写后,比较的是字符值,另外重写了equlas后,也必须重写hashcode()方法

6. 异常处理机制

(1)使用try、catch、finaly捕获异常,finaly中的代码一定会执行,捕获异常后程序会继续执行

(2)使用throws声明该方法可能会抛出的异常类型,出现异常后,程序终止

7、HashMap原理

1.HashMap在Jdk1.8以后是基于数组+链表+红黑树来实现的,特点是,key不能重复,可以为null,线程不安全

2.HashMap的扩容机制:

HashMap的默认容量为16,默认的负载因子为0.75,当HashMap中元素个数超过容量乘以负载因子的个数时,就创建一个大小为前一次两倍的新数组,再将原来数组中的数据复制到新数组中。当数组长度到达64且链表长度大于8时,链表转为红黑树

3.HashMap存取原理:

(1)计算key的hash值,然后进行二次hash,根据二次hash结果找到对应的索引位置

(2)如果这个位置有值,先进性equals比较,若结果为true则取代该元素,若结果为false,就使用高低位平移法将节点插入链表(JDK8以前使用头插法,但是头插法在并发扩容时可能会造成环形链表或数据丢失,而高低位平移发会发生数据覆盖的情况)

8、想要线程安全的HashMap怎么办?

(1)使用ConcurrentHashMap

(2)使用HashTable

(3)Collections.synchronizedHashMap()方法

9、ConcurrentHashMap原如何保证的线程安全?

JDK1.7:使用分段锁,将一个Map分为了16个段,每个段都是一个小的hashmap,每次操作只对其中一个段加锁

JDK1.8:采用CAS+Synchronized保证线程安全,每次插入数据时判断在当前数组下标是否是第一次插入,是就通过CAS方式插入,然后判断f.hash是否=-1,是的话就说明其他线程正在进行扩容,当前线程也会参与扩容;删除方法用了synchronized修饰,保证并发下移除元素安全

10、HashTable与HashMap的区别

(1)HashTable的每个方法都用synchronized修饰,因此是线程安全的,但同时读写效率很低

(2)HashTable的Key不允许为null

(3)HashTable只对key进行一次hash,HashMap进行了两次Hash

(4)HashTable底层使用的数组加链表

11、ArrayList和LinkedList的区别

ArratList的底层使用动态数组,默认容量为10,当元素数量到达容量时,生成一个新的数组,大小为前一次的1.5倍,然后将原来的数组copy过来;因为数组在内存中是连续的地址,所以ArrayList查找数据更快,由于扩容机制添加数据效率更低

LinkedList的底层使用链表,在内存中是离散的,没有扩容机制;LinkedList在查找数据时需要从头遍历,所以查找慢,但是添加数据效率更高

12、如何保证ArrayList的线程安全?

(1)使用collentions.synchronizedList()方法为ArrayList加锁

(2)使用Vector,Vector底层与Arraylist相同,但是每个方法都由synchronized修饰,速度很慢

(3)使用juc下的CopyOnWriterArrayList,该类实现了读操作不加锁,写操作时为list创建一个副本,期间其它线程读取的都是原本list,写操作都在副本中进行,写入完成后,再将指针指向副本。

13、List如何排序?

方式1:JAVA中我们可以使用java.util.Collections类的sort(List list)方法对list集合中的元素排序。

方式2:JDK8之后特别是lambda表达式的盛行,而且Collections的sort方法其实是调用了List接口自己的sort方法;所以可以使用List接口自己的sort方法排序

方式3:Stream流的sort方法写法

集合元素是基本类型包装类型

public static void main(String[] args) {

List<Integer> numList=new ArrayList<>();

numList.add(999);

numList.add(123);

numList.add(456);

numList.add(66);

numList.add(9);

Collections.sort(numList); //使用Collections类的方法排序

numList.sort(new Comparator<Integer>() {//使用List接口的方法排序

@Override

public int compare(Integer o1, Integer o2) {

return o1.compareTo(o2);

}

});

//lambda表达式实现List接口sort方法排序

numList.sort((num1,num2)->{return num1.compareTo(num2);});

System.out.println(numList);

}

对象的集合根据某个属性排序

public static void main(String[] args) {

List<User> numList=new ArrayList<>();

User u=new User();

u.setAge(12);

numList.add(u);

User u1=new User();

u1.setAge(34);

numList.add(u1);

User u2=new User();

u2.setAge(6);

numList.add(u2);

User u3=new User();

u3.setAge(99);

numList.add(u3);

//Collections类的sort方法对对象集合排序,要传集合和Comparator接口两个参数

Collections.sort(numList, new Comparator<User>() {

@Override

public int compare(User o1, User o2) {

Integer age1= o1.getAge();

Integer age2= o2.getAge();

return age1.compareTo(age2);

}

});

//List接口自身的sort方法对对象集合排序,重写Comparator接口方法即可

numList.sort(new Comparator<User>() {

@Override

public int compare(User u1, User u2) {

Integer age1= u1.getAge();

Integer age2= u2.getAge();

return age1.compareTo(age2);

}

});

//List接口的sort方法,lambda表达式写法

numList.sort((u4,u5)->{

Integer age1= u4.getAge();

Integer age2= u5.getAge();

return age1.compareTo(age2);

});

System.out.println(numList);

}

使用Stream流排序

1.首先你需要list.parallelStream().sorted 进行流处理,使用parallelStream可以充分调度多核CPU。

2.使用Comparator.comparing进行排序,reversed()进行倒序排列,thenComparing进行下一个排序。

3.Comparator.comparing()里面的内容,也是就是Object::getter,例如KeywordCounterDTO::getKeyword

4.最后格式化为需要的格式 List 是.collect(Collectors.toList()) , Map 是 .collect(Collectors.toMap(KeywordCounterDTO::getKey, KeywordCounterDTO::getValue))

根据年龄倒序排

public static void main(String[] args) {

List<User> numList=new ArrayList<>();

User u=new User();

u.setAge(12);

numList.add(u);

User u1=new User();

u1.setAge(34);

numList.add(u1);

User u2=new User();

u2.setAge(6);

numList.add(u2);

User u3=new User();

u3.setAge(99);

numList.add(u3);

numList = numList.stream().sorted(Comparator.comparing(User::getAge).reversed()).collect(Collectors.toList());

}

先对学生的班级做排序,然后同班级做倒序

public static void main(String[] args) {

List<User> numList=new ArrayList<>();

User u=new User();

u.setClass(1);

u.setAge(12);

numList.add(u);

User u1=new User();

u.setClass(1);

u1.setAge(34);

numList.add(u1);

User u2=new User();

u.setClass(2);

u2.setAge(6);

numList.add(u2);

User u3=new User();

u.setClass(2);

u3.setAge(99);

numList.add(u3);

numList = numList.parallelStream().sorted(

Comparator.comparing(User::getClass).reversed().thenComparing(User::getAge)

).collect(Collectors.toList());

}

# 当集合中存在null元素时,可以使用针对null友好的比较器,null元素排在集合的最前面:nullsFirst

public static void main(String[] args) {

List<User> numList=new ArrayList<>();

User u=new User();

u.setClass(1);

u.setAge(12);

numList.add(u);

User u1=new User();

u.setClass(1);

u1.setAge(34);

numList.add(u1);

User u2=new User();

u.setClass(2);

u2.setAge(6);

numList.add(u2);

User u3=new User();

u.setClass(2);

u3.setAge(99);

numList.add(u3);

numList = numList.parallelStream().sorted(

Comparator.nullsFirst(User::getClass).reversed().thenComparing(User::getAge)

).collect(Collectors.toList());

}

14、排序方法

交换排序

所谓交换,就是序列中任意两个元素进行比较,根据比较结果来交换各自在序列中的位置,以此达到排序的目的。

1、冒泡排序

冒泡排序是一种简单的交换排序算法,以升序排序为例,其核心思想是:

- 从第一个元素开始,比较相邻的两个元素。如果第一个比第二个大,则进行交换。

- 轮到下一组相邻元素,执行同样的比较操作,再找下一组,直到没有相邻元素可比较为止,此时最后的元素应是最大的数。

- 除了每次排序得到的最后一个元素,对剩余元素重复以上步骤,直到没有任何一对元素需要比较为止。

用 Java 实现的冒泡排序如下

public void bubbleSortOpt(int[] arr) {

if(arr == null) {

throw new NullPoniterException();

}

if(arr.length < 2) {

return;

}

int temp = 0;

for(int i = 0; i < arr.length - 1; i++) {

for(int j = 0; j < arr.length - i - 1; j++) {

if(arr[j] > arr[j + 1]) {

temp = arr[j];

arr[j] = arr[j + 1];

arr[j + 1] = temp;

}

}

}

}

2、快速排序

快速排序的思想很简单,就是先把待排序的数组拆成左右两个区间,左边都比中间的基准数小,右边都比基准数大。接着左右两边各自再做同样的操作,完成后再拆分再继续,一直到各区间只有一个数为止。

举个例子,现在我要排序 4、9、5、1、2、6 这个数组。一般取首位的 4 为基准数,第一次排序的结果是:

2、1、4、5、9、6

可能有人觉得奇怪,2 和 1 交换下位置也能满足条件,为什么 2 在首位?这其实由实际的代码实现来决定,并不影响之后的操作。以 4 为分界点,对 2、1、4 和 5、9、6 各自排序,得到:

1、2、4、5、9、6

不用管左边的 1、2、4 了,将 5、9、6 拆成 5 和 9、6,再排序,至此结果为:

1、2、4、5、6、9

为什么把快排划到交换排序的范畴呢?因为元素的移动也是靠交换位置来实现的。算法的实现需要用到递归(拆分区间之后再对每个区间作同样的操作)

public void quicksort(int[] arr, int start, int end) {

if(start < end) {

// 把数组中的首位数字作为基准数

int stard = arr[start];

// 记录需要排序的下标

int low = start;

int high = end;

// 循环找到比基准数大的数和比基准数小的数

while(low < high) {

// 右边的数字比基准数大

while(low < high && arr[high] >= stard) {

high--;

}

// 使用右边的数替换左边的数

arr[low] = arr[high];

// 左边的数字比基准数小

while(low < high && arr[low] <= stard) {

low++;

}

// 使用左边的数替换右边的数

arr[high] = arr[low];

}

// 把标准值赋给下标重合的位置

arr[low] = stard;

// 处理所有小的数字

quickSort(arr, start, low);

// 处理所有大的数字

quickSort(arr, low + 1, end);

}

}

插入排序

插入排序是一种简单的排序方法,其基本思想是将一个记录插入到已经排好序的有序表中,使得被插入数的序列同样是有序的。按照此法对所有元素进行插入,直到整个序列排为有序的过程。

1、直接插入排序

直接插入排序就是插入排序的粗暴实现。对于一个序列,选定一个下标,认为在这个下标之前的元素都是有序的。将下标所在的元素插入到其之前的序列中。接着再选取这个下标的后一个元素,继续重复操作。直到最后一个元素完成插入为止。我们一般从序列的第二个元素开始操作。

用 Java 实现的算法如下:

public void insertSort(int[] arr) {

// 遍历所有数字

for(int i = 1; i < arr.length - 1; i++) {

// 当前数字比前一个数字小

if(arr[i] < arr[i - 1]) {

int j;

// 把当前遍历的数字保存起来

int temp = arr[i];

for(j = i - 1; j >= 0 && arr[j] > temp; j--) {

// 前一个数字赋给后一个数字

arr[j + 1] = arr[j];

}

// 把临时变量赋给不满足条件的后一个元素

arr[j + 1] = temp;

}

}

}

2. 希尔排序

某些情况下直接插入排序的效率极低。比如一个已经有序的升序数组,这时再插入一个比最小值还要小的数,也就意味着被插入的数要和数组所有元素比较一次。我们需要对直接插入排序进行改进。

怎么改进呢?前面提过,插入排序对已经排好序的数组操作时,效率很高。因此我们可以试着先将数组变为一个相对有序的数组,然后再做插入排序。

希尔排序能实现这个目的。希尔排序把序列按下标的一定增量(步长)分组,对每组分别使用插入排序。随着增量(步长)减少,一直到一,算法结束,整个序列变为有序。因此希尔排序又称缩小增量排序。

一般来说,初次取序列的一半为增量,以后每次减半,直到增量为一。

用 Java 实现的算法如下:

public void shellSort(int[] arr) {

// gap 为步长,每次减为原来的一半。

for (int gap = arr.length / 2; gap > 0; gap /= 2) {

// 对每一组都执行直接插入排序

for (int i = 0 ;i < gap; i++) {

// 对本组数据执行直接插入排序

for (int j = i + gap; j < arr.length; j += gap) {

// 如果 a[j] < a[j-gap],则寻找 a[j] 位置,并将后面数据的位置都后移

if (arr[j] < arr[j - gap]) {

int k;

int temp = arr[j];

for (k = j - gap; k >= 0 && arr[k] > temp; k -= gap) {

arr[k + gap] = arr[k];

}

arr[k + gap] = temp;

}

}

}

}

}

选择排序

选择排序是一种简单直观的排序算法,首先在未排序序列中找到最小(大)元素,存放到排序序列的起始位置,然后,再从剩余未排序元素中继续寻找最小(大)元素,然后放到已排序序列的末尾。以此类推,直到所有元素均排序完毕。

1. 简单选择排序

选择排序思想的暴力实现,每一趟从未排序的区间找到一个最小元素,并放到第一位,直到全部区间有序为止。

public void selectSort(int[] arr) {

// 遍历所有的数

for (int i = 0; i < arr.length; i++) {

int minIndex = i;

// 把当前遍历的数和后面所有的数进行比较,并记录下最小的数的下标

for (int j = i + 1; j < arr.length; j++) {

if (arr[j] < arr[minIndex]) {

// 记录最小的数的下标

minIndex = j;

}

}

// 如果最小的数和当前遍历的下标不一致,则交换

if (i != minIndex) {

int temp = arr[i];

arr[i] = arr[minIndex];

arr[minIndex] = temp;

}

}

}

2. 堆排序

我们知道,对于任何一个数组都可以看成一颗完全二叉树。堆是具有以下性质的完全二叉树:每个结点的值都大于或等于其左右孩子结点的值,称为大顶堆;或者每个结点的值都小于或等于其左右孩子结点的值,称为小顶堆。如下图:

像上图的大顶堆,映射为数组,就是 [50, 45, 40, 20, 25, 35, 30, 10, 15]。可以发现第一个下标的元素就是最大值,将其与末尾元素交换,则末尾元素就是最大值。所以堆排序的思想可以归纳为以下两步:

- 根据初始数组构造堆

- 每次交换第一个和最后一个元素,然后将除最后一个元素以外的其他元素重新调整为大顶堆

重复以上两个步骤,直到没有元素可操作,就完成排序了。

我们需要把一个普通数组转换为大顶堆,调整的起始点是最后一个非叶子结点,然后从左至右,从下至上,继续调整其他非叶子结点,直到根结点为止。

/**

* 转化为大顶堆

* @param arr 待转化的数组

* @param size 待调整的区间长度

* @param index 结点下标

*/

public void maxHeap(int[] arr, int size, int index) {

// 左子结点

int leftNode = 2 * index + 1;

// 右子结点

int rightNode = 2 * index + 2;

int max = index;

// 和两个子结点分别对比,找出最大的结点

if (leftNode < size && arr[leftNode] > arr[max]) {

max = leftNode;

}

if (rightNode < size && arr[rightNode] > arr[max]) {

max = rightNode;

}

// 交换位置

if (max != index) {

int temp = arr[index];

arr[index] = arr[max];

arr[max] = temp;

// 因为交换位置后有可能使子树不满足大顶堆条件,所以要对子树进行调整

maxHeap(arr, size, max);

}

}

/**

* 堆排序

* @param arr 待排序的整型数组

*/

public static void heapSort(int[] arr) {

// 开始位置是最后一个非叶子结点,即最后一个结点的父结点

int start = (arr.length - 1) / 2;

// 调整为大顶堆

for (int i = start; i >= 0; i--) {

SortTools.maxHeap(arr, arr.length, i);

}

// 先把数组中第 0 个位置的数和堆中最后一个数交换位置,再把前面的处理为大顶堆

for (int i = arr.length - 1; i > 0; i--) {

int temp = arr[0];

arr[0] = arr[i];

arr[i] = temp;

maxHeap(arr, i, 0);

}

}

归并排序

归并排序是建立在归并操作上的一种有效,稳定的排序算法。该算法采用分治法的思想,是一个非常典型的应用。归并排序的思路如下:

- 将 n 个元素分成两个各含 n/2 个元素的子序列

- 借助递归,两个子序列分别继续进行第一步操作,直到不可再分为止

- 此时每一层递归都有两个子序列,再将其合并,作为一个有序的子序列返回上一层,再继续合并,全部完成之后得到的就是一个有序的序列

关键在于两个子序列应该如何合并。假设两个子序列各自都是有序的,那么合并步骤就是:

- 创建一个用于存放结果的临时数组,其长度是两个子序列合并后的长度

- 设定两个指针,最初位置分别为两个已经排序序列的起始位置

- 比较两个指针所指向的元素,选择相对小的元素放入临时数组,并移动指针到下一位置

- 重复步骤 3 直到某一指针达到序列尾

- 将另一序列剩下的所有元素直接复制到合并序列尾

用 Java 实现的归并排序如下:

/**

* 合并数组

*/

public static void merge(int[] arr, int low, int middle, int high) {

// 用于存储归并后的临时数组

int[] temp = new int[high - low + 1];

// 记录第一个数组中需要遍历的下标

int i = low;

// 记录第二个数组中需要遍历的下标

int j = middle + 1;

// 记录在临时数组中存放的下标

int index = 0;

// 遍历两个数组,取出小的数字,放入临时数组中

while (i <= middle && j <= high) {

// 第一个数组的数据更小

if (arr[i] <= arr[j]) {

// 把更小的数据放入临时数组中

temp[index] = arr[i];

// 下标向后移动一位

i++;

} else {

temp[index] = arr[j];

j++;

}

index++;

}

// 处理剩余未比较的数据

while (i <= middle) {

temp[index] = arr[i];

i++;

index++;

}

while (j <= high) {

temp[index] = arr[j];

j++;

index++;

}

// 把临时数组中的数据重新放入原数组

for (int k = 0; k < temp.length; k++) {

arr[k + low] = temp[k];

}

}

/**

* 归并排序

*/

public static void mergeSort(int[] arr, int low, int high) {

int middle = (high + low) / 2;

if (low < high) {

// 处理左边数组

mergeSort(arr, low, middle);

// 处理右边数组

mergeSort(arr, middle + 1, high);

// 归并

merge(arr, low, middle, high);

}

}

基数排序

基数排序的原理是将整数按位数切割成不同的数字,然后按每个位数分别比较。为此需要将所有待比较的数值统一为同样的数位长度,数位不足的数在高位补零。

使用 Java 实现的基数排序:

/**

* 基数排序

*/

public static void radixSort(int[] arr) {

// 存放数组中的最大数字

int max = Integer.MIN_VALUE;

for (int value : arr) {

if (value > max) {

max = value;

}

}

// 计算最大数字是几位数

int maxLength = (max + "").length();

// 用于临时存储数据

int[][] temp = new int[10][arr.length];

// 用于记录在 temp 中相应的下标存放数字的数量

int[] counts = new int[10];

// 根据最大长度的数决定比较次数

for (int i = 0, n = 1; i < maxLength; i++, n *= 10) {

// 每一个数字分别计算余数

for (int j = 0; j < arr.length; j++) {

// 计算余数

int remainder = arr[j] / n % 10;

// 把当前遍历的数据放到指定的数组中

temp[remainder][counts[remainder]] = arr[j];

// 记录数量

counts[remainder]++;

}

// 记录取的元素需要放的位置

int index = 0;

// 把数字取出来

for (int k = 0; k < counts.length; k++) {

// 记录数量的数组中当前余数记录的数量不为 0

if (counts[k] != 0) {

// 循环取出元素

for (int l = 0; l < counts[k]; l++) {

arr[index] = temp[k][l];

// 记录下一个位置

index++;

}

// 把数量置空

counts[k] = 0;

}

}

}

}

八种排序算法的总结

| 排序法 | 最好情形 | 平均时间 | 最差情形 | 稳定度 | 空间复杂度 |

|---|---|---|---|---|---|

| 冒泡排序 | O(n) | O(n^2) | O(n^2) | 稳定 | O(1) |

| 快速排序 | O(nlogn) | O(nlogn) | O(n^2) | 不稳定 | O(nlogn) |

| 直接插入排序 | O(n) | O(n^2) | O(n^2) | 稳定 | O(1) |

| 希尔排序 | 不稳定 | O(1) | |||

| 直接选择排序 | O(n^2) | O(n^2) | O(n^2) | 不稳定 | O(1) |

| 堆排序 | O(nlogn) | O(nlogn) | O(nlogn) | 不稳定 | O(nlogn) |

| 归并排序 | O(nlogn) | O(nlogn) | O(nlogn) | 稳定 | O(n) |

15、String、StringBuffer、StringBuilder的区别

String 由 char[] 数组构成,使用了 final 修饰,对 String 进行改变时每次都会新生成一个 String 对象,然后把指针指向新的引用对象。

StringBuffer可变并且线程安全

StringBuiler可变但线程不安全。

操作少量字符数据用 String;单线程操作大量数据用 StringBuilder;多线程操作大量数据用 StringBuffer。

16、hashCode和equals

hashCode()和equals()都是Obkect类的方法,hashCode()默认是通过地址来计算hash码,但是可能被重写过用内容来计算hash码,equals()默认通过地址判断两个对象是否相等,但是可能被重写用内容来比较两个对象

所以两个对象相等,他们的hashCode和equals一定相等,但是hashCode相等的两个对象未必相等

如果重写equals()必须重写hashCode(),比如在HashMap中,key如果是String类型,String如果只重写了equals()而没有重写hashcode()的话,则两个equals()比较为true的key,因为hashcode不同导致两个key没有出现在一个索引上,就会出现map中存在两个相同的key

17、面向对象和面向过程的区别

面向对象有封装、继承、多态性的特性,所以相比面向过程易维护、易复用、易扩展,但是因为类调用时要实例化,所以开销大性能比面向过程低

18、深拷贝和浅拷贝

深拷贝和浅拷贝

这两个概念是在项目中比较常见的,在很多时候,都会遇到拷贝的问题,我们总是需要将一个对象赋值到另一个对象上,但可能会在改变新赋值对象的时候,忽略掉我是否之后还需要用到原来的对象,那么就会出现当改变新赋值对象的某一个属性时,也同时改变了原对象,此时我们就需要用到拷贝这个概念了。

Java中的对象拷贝(Object Copy)指的是将一个对象的所有属性(成员变量)拷贝到另一个有着相同类类型的对象中去。举例说明:比如,对象A和对象B都属于类S,具有属性a和b。那么对对象A进行拷贝操作赋值给对象B就是:B.a=A.a; B.b=A.b;在程序中拷贝对象是很常见的,主要是为了在新的上下文环境中复用现有对象的部分或全部数据。Java中的对象拷贝主要分为:浅拷贝(Shallow Copy)、深拷贝(Deep Copy)。先介绍一点铺垫知识:Java中的数据类型分为基本数据类型和引用数据类型。对于这两种数据类型,在进行赋值操作、用作方法参数或返回值时,会有值传递和引用(地址)传递的差别。

深拷贝和浅拷贝的区别

1.浅拷贝: 将原对象或原数组的引用直接赋给新对象,新数组,新对象/数组只是原对象的一个引用

2.深拷贝: 创建一个新的对象和数组,将原对象的各项属性的“值”(数组的所有元素)拷贝过来,是“值”而不是“引用”

一、浅拷贝(Shallow Copy)

①对于数据类型是基本数据类型的成员变量,浅拷贝会直接进行值传递,也就是将该属性值复制一份给新的对象。因为是两份不同的数据,所以对其中一个对象的该成员变量值进行修改,不会影响另一个对象拷贝得到的数据。

②对于数据类型是引用数据类型的成员变量,比如说成员变量是某个数组、某个类的对象等,那么浅拷贝会进行引用传递,也就是只是将该成员变量的引用值(内存地址)复制一份给新的对象。因为实际上两个对象的该成员变量都指向同一个实例。在这种情况下,在一个对象中修改该成员变量会影响到另一个对象的该成员变量值。

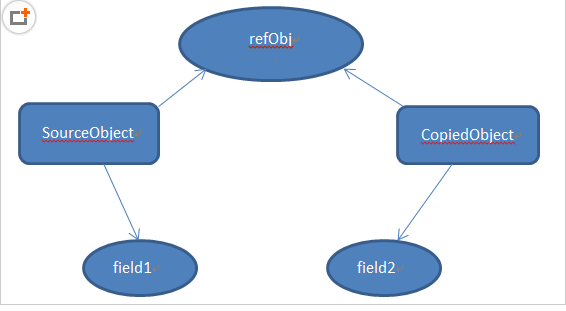

具体模型如图所示:可以看到基本数据类型的成员变量,对其值创建了新的拷贝。而引用数据类型的成员变量的实例仍然是只有一份,两个对象的该成员变量都指向同一个实例。

浅拷贝的实现方式主要有三种:

1)通过拷贝构造方法实现浅拷贝:

拷贝构造方法指的是该类的构造方法参数为该类的对象。使用拷贝构造方法可以很好地完成浅拷贝,直接通过一个现有的对象创建出与该对象属性相同的新的对象。

代码参考如下:

/* 拷贝构造方法实现浅拷贝 */

public class CopyConstructor {

public static void main(String[] args) {

Age a=new Age(20);

Person p1=new Person(a,"摇头耶稣");

Person p2=new Person(p1);

System.out.println("p1是"+p1);

System.out.println("p2是"+p2);

//修改p1的各属性值,观察p2的各属性值是否跟随变化

p1.setName("小傻瓜");

a.setAge(99);

System.out.println("修改后的p1是"+p1);

System.out.println("修改后的p2是"+p2);

}

}

class Person{

//两个属性值:分别代表值传递和引用传递

private Age age;

private String name;

public Person(Age age,String name) {

this.age=age;

this.name=name;

}

//拷贝构造方法

public Person(Person p) {

this.name=p.name;

this.age=p.age;

}

public void setName(String name) {

this.name=name;

}

public String toString() {

return this.name+" "+this.age;

}

}

class Age{

private int age;

public Age(int age) {

this.age=age;

}

public void setAge(int age) {

this.age=age;

}

public int getAge() {

return this.age;

}

public String toString() {

return getAge()+"";

}

}

运行结果为:

- p1是摇头耶稣 20

- p2是摇头耶稣 20

- 修改后的p1是小傻瓜 99

- 修改后的p2是摇头耶稣 99

结果分析:这里对Person类选择了两个具有代表性的属性值:一个是引用传递类型;另一个是字符串类型(属于常量)。通过拷贝构造方法进行了浅拷贝,各属性值成功复制。其中,p1值传递部分的属性值发生变化时,p2不会随之改变;而引用传递部分属性值发生变化时,p2也随之改变。

要注意:如果在拷贝构造方法中,对引用数据类型变量逐一开辟新的内存空间,创建新的对象,也可以实现深拷贝。而对于一般的拷贝构造,则一定是浅拷贝。

2)通过重写clone()方法进行浅拷贝:

Object类是类结构的根类,其中有一个方法为protected Object clone() throws CloneNotSupportedException,这个方法就是进行的浅拷贝。有了这个浅拷贝模板,我们可以通过调用clone()方法来实现对象的浅拷贝。但是需要注意:

- Object类虽然有这个方法,但是这个方法是受保护的(被protected修饰),所以我们无法直接使用。

- 使用clone方法的类必须实现Cloneable接口,否则会抛出异常CloneNotSupportedException。对于这两点,我们的解决方法是,在要使用clone方法的类中重写clone()方法,通过super.clone()调用Object类中的原clone方法。

参考代码如下:对Student类的对象进行拷贝,直接重写clone()方法,通过调用clone方法即可完成浅拷贝。

/* clone方法实现浅拷贝 */

public class ShallowCopy {

public static void main(String[] args) {

Age a=new Age(20);

Student stu1=new Student("摇头耶稣",a,175);

//通过调用重写后的clone方法进行浅拷贝

Student stu2=(Student)stu1.clone();

System.out.println(stu1.toString());

System.out.println(stu2.toString());

//尝试修改stu1中的各属性,观察stu2的属性有没有变化

stu1.setName("大傻子");

//改变age这个引用类型的成员变量的值

a.setAge(99);

//stu1.setaAge(new Age(99)); 使用这种方式修改age属性值的话,stu2是不会跟着改变的。因为创建了一个新的Age类对象而不是改变原对象的实例值

stu1.setLength(216);

System.out.println(stu1.toString());

System.out.println(stu2.toString());

}

}

/** 创建年龄类*/

class Age{

//年龄类的成员变量(属性)

private int age;

//构造方法

public Age(int age) {

this.age=age;

}

public int getAge() {

return age;

}

public void setAge(int age) {

this.age = age;

}

public String toString() {

return this.age+"";

}

}

/** 创建学生类*/

class Student implements Cloneable{

//学生类的成员变量(属性),其中一个属性为类的对象

private String name;

private Age aage;

private int length;

//构造方法,其中一个参数为另一个类的对象

public Student(String name,Age a,int length) {

this.name=name;

this.aage=a;

this.length=length;

}

//eclipe中alt+shift+s自动添加所有的set和get方法

public String getName() {

return name;

}

public void setName(String name) {

this.name = name;

}

public Age getaAge() {

return this.aage;

}

public void setaAge(Age age) {

this.aage=age;

}

public int getLength() {

return this.length;

}

public void setLength(int length) {

this.length=length;

}

//设置输出的字符串形式

public String toString() {

return "姓名是: "+this.getName()+", 年龄为: "+this.getaAge().toString()+", 长度是: "+this.getLength();

}

//重写Object类的clone方法

public Object clone() {

Object obj=null;

//调用Object类的clone方法,返回一个Object实例

try {

obj= super.clone();

} catch (CloneNotSupportedException e) {

e.printStackTrace();

}

return obj;

}

}

String类型非常特殊,所以我额外设置了一个字符串类型的成员变量来进行说明。首先,String类型属于引用数据类型,不属于基本数据类型,但是String类型的数据是存放在常量池中的,也就是无法修改的!也就是说,当我将name属性从“摇头耶稣”改为“大傻子"后,并不是修改了这个数据的值,而是把这个数据的引用从指向”摇头耶稣“这个常量改为了指向”大傻子“这个常量。在这种情况下,另一个对象的name属性值仍然指向”摇头耶稣“不会受到影响。

二、深拷贝(Deep Copy)

首先介绍对象图的概念。设想一下,一个类有一个对象,其成员变量中又有一个对象,该对象指向另一个对象,另一个对象又指向另一个对象,直到一个确定的实例。这就形成了对象图。那么,对于深拷贝来说,不仅要复制对象的所有基本数据类型的成员变量值,还要为所有引用数据类型的成员变量申请存储空间,并复制每个引用数据类型成员变量所引用的对象,直到该对象可达的所有对象。也就是说,对象进行深拷贝要对整个对象图进行拷贝!简单地说,深拷贝对引用数据类型的成员变量的对象图中所有的对象都开辟了内存空间;而浅拷贝只是传递地址指向,新的对象并没有对引用数据类型创建内存空间。

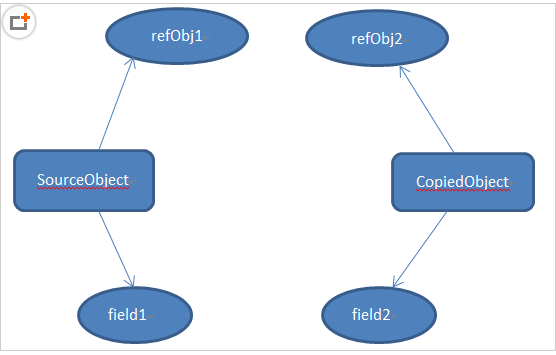

深拷贝模型如图所示:可以看到所有的成员变量都进行了复制。

因为创建内存空间和拷贝整个对象图,所以深拷贝相比于浅拷贝速度较慢并且花销较大。

深拷贝的实现方法主要有两种:

1)通过重写clone方法来实现深拷贝

与通过重写clone方法实现浅拷贝的基本思路一样,只需要为对象图的每一层的每一个对象都实现Cloneable接口并重写clone方法,最后在最顶层的类的重写的clone方法中调用所有的clone方法即可实现深拷贝。简单的说就是:每一层的每个对象都进行浅拷贝=深拷贝。

参考代码如下:

package linearList;

/* 层次调用clone方法实现深拷贝 */

public class DeepCopy {

public static void main(String[] args) {

Age a=new Age(20);

Student stu1=new Student("摇头耶稣",a,175);

//通过调用重写后的clone方法进行浅拷贝

Student stu2=(Student)stu1.clone();

System.out.println(stu1.toString());

System.out.println(stu2.toString());

System.out.println();

//尝试修改stu1中的各属性,观察stu2的属性有没有变化

stu1.setName("大傻子");

//改变age这个引用类型的成员变量的值

a.setAge(99);

//stu1.setaAge(new Age(99)); 使用这种方式修改age属性值的话,stu2是不会跟着改变的。因为创建了一个新的Age类对象而不是改变原对象的实例值

stu1.setLength(216);

System.out.println(stu1.toString());

System.out.println(stu2.toString());

}

}

/** 创建年龄类*/

class Age implements Cloneable{

//年龄类的成员变量(属性)

private int age;

//构造方法

public Age(int age) {

this.age=age;

}

public int getAge() {

return age;

}

public void setAge(int age) {

this.age = age;

}

public String toString() {

return this.age+"";

}

//重写Object的clone方法

public Object clone() {

Object obj=null;

try {

obj=super.clone();

} catch (CloneNotSupportedException e) {

e.printStackTrace();

}

return obj;

}

}

/** 创建学生类*/

class Student implements Cloneable{

//学生类的成员变量(属性),其中一个属性为类的对象

private String name;

private Age aage;

private int length;

//构造方法,其中一个参数为另一个类的对象

public Student(String name,Age a,int length) {

this.name=name;

this.aage=a;

this.length=length;

}

public String getName() {

return name;

}

public void setName(String name) {

this.name = name;

}

public Age getaAge() {

return this.aage;

}

public void setaAge(Age age) {

this.aage=age;

}

public int getLength() {

return this.length;

}

public void setLength(int length) {

this.length=length;

}

public String toString() {

return "姓名是: "+this.getName()+", 年龄为: "+this.getaAge().toString()+", 长度是: "+this.getLength();

}

//重写Object类的clone方法

public Object clone() {

Object obj=null;

//调用Object类的clone方法——浅拷贝

try {

obj= super.clone();

} catch (CloneNotSupportedException e) {

e.printStackTrace();

}

//调用Age类的clone方法进行深拷贝

//先将obj转化为学生类实例Student stu=(Student)obj;

//学生类实例的Age对象属性,调用其clone方法进行拷贝stu.aage=(Age)stu.getaAge().clone();return obj;}

}

运行结果为:

- 姓名是: 摇头耶稣, 年龄为: 20, 长度是: 175

- 姓名是: 摇头耶稣, 年龄为: 20, 长度是: 175

- 姓名是: 大傻子, 年龄为: 99, 长度是: 216

- 姓名是: 摇头耶稣, 年龄为: 20, 长度是: 175

分析结果可以验证:进行了深拷贝之后,无论是什么类型的属性值的修改,都不会影响另一个对象的属性值。

2)通过对象序列化实现深拷贝

虽然层次调用clone方法可以实现深拷贝,但是显然代码量实在太大。特别对于属性数量比较多、层次比较深的类而言,每个类都要重写clone方法太过繁琐。将对象序列化为字节序列后,默认会将该对象的整个对象图进行序列化,再通过反序列即可完美地实现深拷贝。

参考代码如下:

import java.io.ByteArrayInputStream;

import java.io.ByteArrayOutputStream;

import java.io.IOException;

import java.io.ObjectInputStream;

import java.io.ObjectOutputStream;

import java.io.Serializable;/* 通过序列化实现深拷贝 */

public class DeepCopyBySerialization {

public static void main(String[] args) throws IOException, ClassNotFoundException {

Age a=new Age(20);

Student stu1=new Student("摇头耶稣",a,175);

//通过序列化方法实现深拷贝

ByteArrayOutputStream bos=new ByteArrayOutputStream();

ObjectOutputStream oos=new ObjectOutputStream(bos);

oos.writeObject(stu1);

oos.flush();

ObjectInputStream ois=new ObjectInputStream(new ByteArrayInputStream(bos.toByteArray()));

Student stu2=(Student)ois.readObject();

System.out.println(stu1.toString());

System.out.println(stu2.toString());

System.out.println();

//尝试修改stu1中的各属性,观察stu2的属性有没有变化stu1.setName("大傻子");

//改变age这个引用类型的成员变量的值

a.setAge(99);

stu1.setLength(216);

System.out.println(stu1.toString());

System.out.println(stu2.toString());

}

}

/** 创建年龄类*/

class Age implements Serializable{

//年龄类的成员变量(属性)

private int age;

//构造方法

public Age(int age) {

this.age=age;

}

public int getAge() {

return age;

}

public void setAge(int age) {

this.age = age;

}

public String toString() {

return this.age+"";

}

}

/** 创建学生类*/

class Student implements Serializable{

//学生类的成员变量(属性),其中一个属性为类的对象

private String name;

private Age aage;

private int length;

//构造方法,其中一个参数为另一个类的对象

public Student(String name,Age a,int length) {

this.name=name;

this.aage=a;

this.length=length;

}

//eclipe中alt+shift+s自动添加所有的set和get方法

public String getName() {

return name;

}

public void setName(String name) {

this.name = name;

}

public Age getaAge() {

return this.aage;

}

public void setaAge(Age age) {

this.aage=age;

}

public int getLength() {

return this.length;

}

public void setLength(int length) {

this.length=length;

}

//设置输出的字符串形式

public String toString() {return "姓名是: "+this.getName()+", 年龄为: "+this.getaAge().toString()+", 长度是: "+this.getLength();}

}

运行结果为:

- 姓名是: 摇头耶稣, 年龄为: 20, 长度是: 175

- 姓名是: 摇头耶稣, 年龄为: 20, 长度是: 175

- 姓名是: 大傻子, 年龄为: 99, 长度是: 216

- 姓名是: 摇头耶稣, 年龄为: 20, 长度是: 175

可以通过很简洁的代码即可完美实现深拷贝。不过要注意的是,如果某个属性被transient修饰,那么该属性就无法被拷贝了。以上是浅拷贝的深拷贝的区别和实现方式。

19、多态的作用

多态的实现要有继承、重写,父类引用指向子类对象。它的好处是可以消除类型之间的耦合关系,增加类的可扩充性和灵活性。

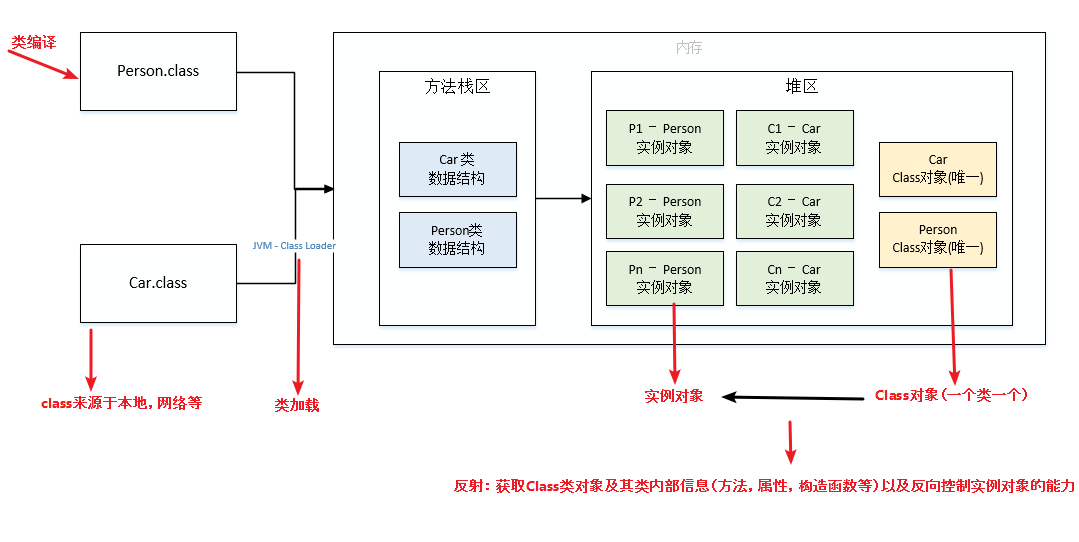

20、什么是反射?

反射是通过获取类的class对象,然后动态的获取到这个类的内部结构,动态的去操作类的属性和方法。

应用场景有:要操作权限不够的类属性和方法时、实现自定义注解时、动态加载第三方jar包时、按需加载类,节省编译和初始化时间;

获取class对象的方法有:class.forName(类路径),类.class(),对象的getClass()

21、反射机制

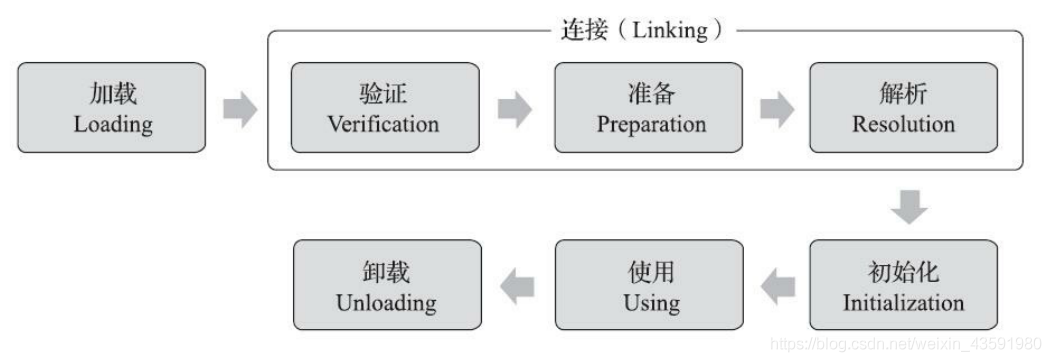

反射的原理(类加载)

类加载机制流程

反射的原理图解

二. 反射的作用

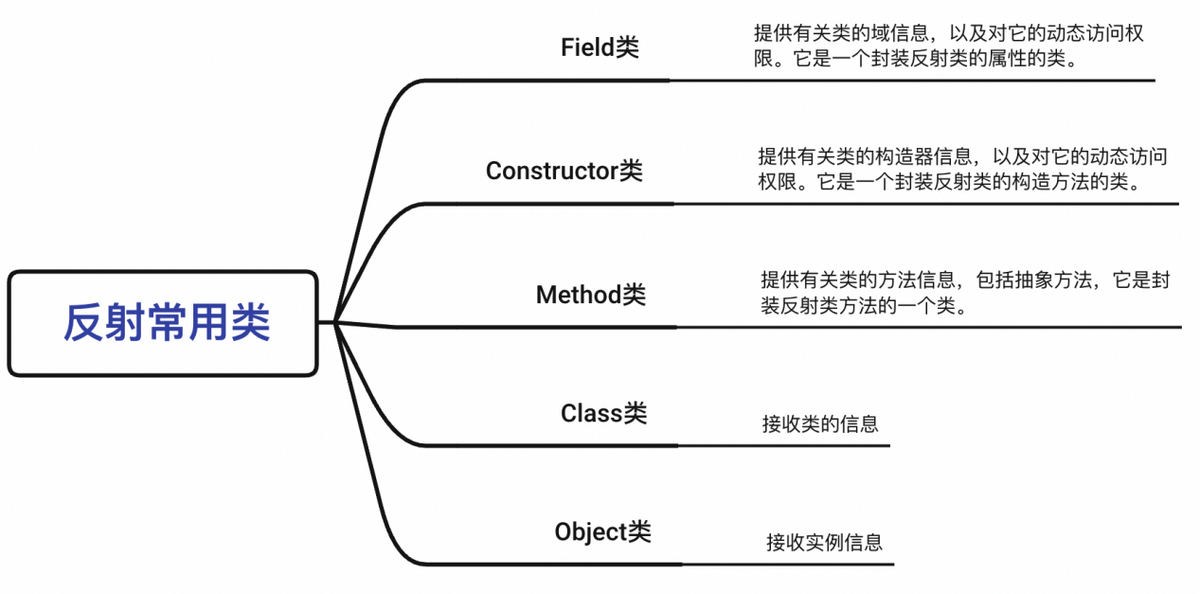

一个类的成员包括以下三种:域信息、构造器信息、方法信息。

而反射则可以在运行时动态获取到这些信息,在使用反射时,我们常用的类有以下五种。

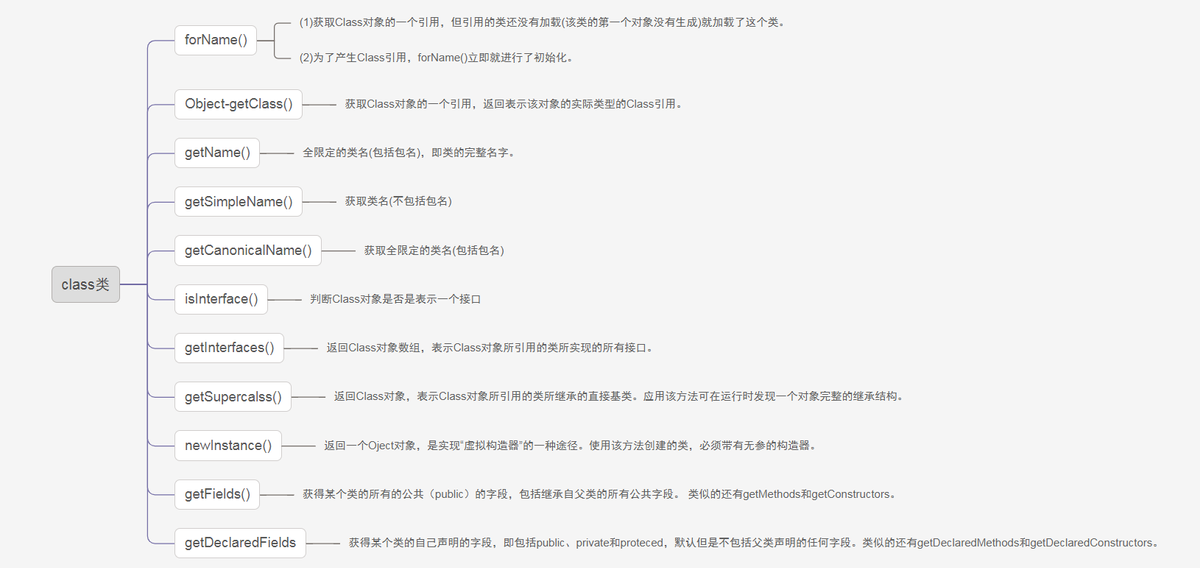

Class类对象的获取

1、获得Class:主要有三种方法:

(1)Object–>getClass

(2)任何数据类型(包括基本的数据类型)都有一个“静态”的class属性

(3)通过class类的静态方法:forName(String className)(最常用)

package fanshe;

public class Fanshe {

public static void main(String[] args) {

//第一种方式获取Class对象

Student stu1 = new Student();

//这一new 产生一个Student对象,一个Class对象。

Class stuClass = stu1.getClass();

//获取Class对象

System.out.println(stuClass.getName());

//第二种方式获取Class对象

Class stuClass2 = Student.class;

System.out.println(stuClass == stuClass2);

//判断第一种方式获取的Class对象和第二种方式获取的是否是同一个

//第三种方式获取Class对象

try {

Class stuClass3 = Class.forName("fanshe.Student");

//注意此字符串必须是真实路径,就是带包名的类路径,包名.类名

System.out.println(stuClass3 == stuClass2);

//判断三种方式是否获取的是同一个Class对象

} catch (ClassNotFoundException e) {

e.printStackTrace();

}

}

}

注意,在运行期间,一个类,只有一个Class对象产生,所以打印结果都是true;

三种方式中,常用第三种,第一种对象都有了还要反射干什么,第二种需要导入类包,依赖太强,不导包就抛编译错误。一般都使用第三种,一个字符串可以传入也可以写在配置文件中等多种方法。

Class类的方法

getName、getCanonicalName与getSimpleName的区别:

- getSimpleName:只获取类名

- getName:类的全限定名,jvm中Class的表示,可以用于动态加载Class对象,例如Class.forName。

- getCanonicalName:返回更容易理解的表示,主要用于输出(toString)或log打印,大多数情况下和getName一样,但是在内部类、数组等类型的表示形式就不同了。

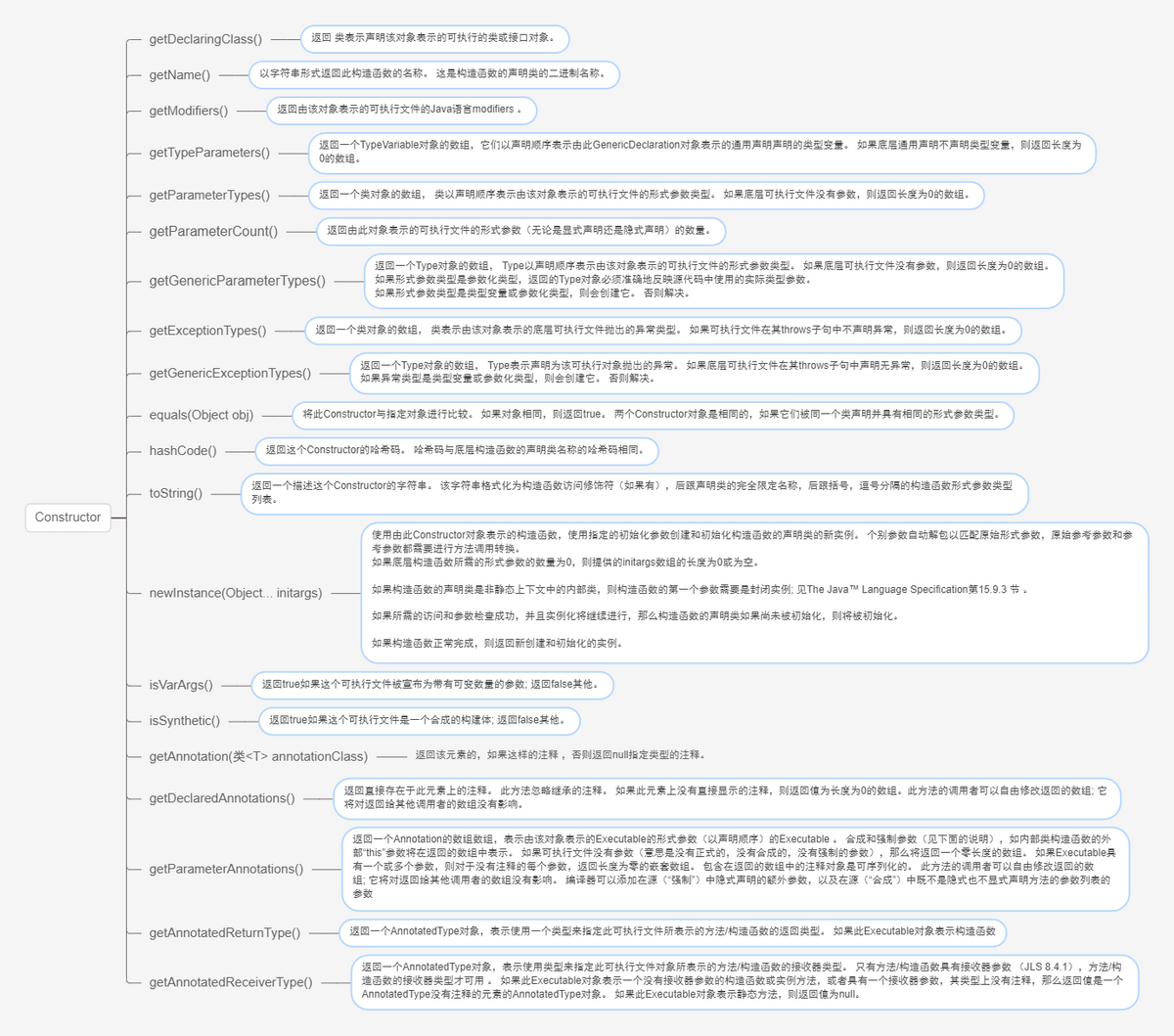

Constructor类及其获取对象方法

- Constructor提供了一个类的单个构造函数的信息和访问。

- Constructor允许在将实际参数与newInstance()与底层构造函数的形式参数进行匹配时进行扩展转换,但如果发生缩小转换,则抛出IllegalArgumentException 。

Constructor类的方法

获取Constructor对象是通过Class类中的方法获取的,Class类与Constructor相关的主要方法如下:

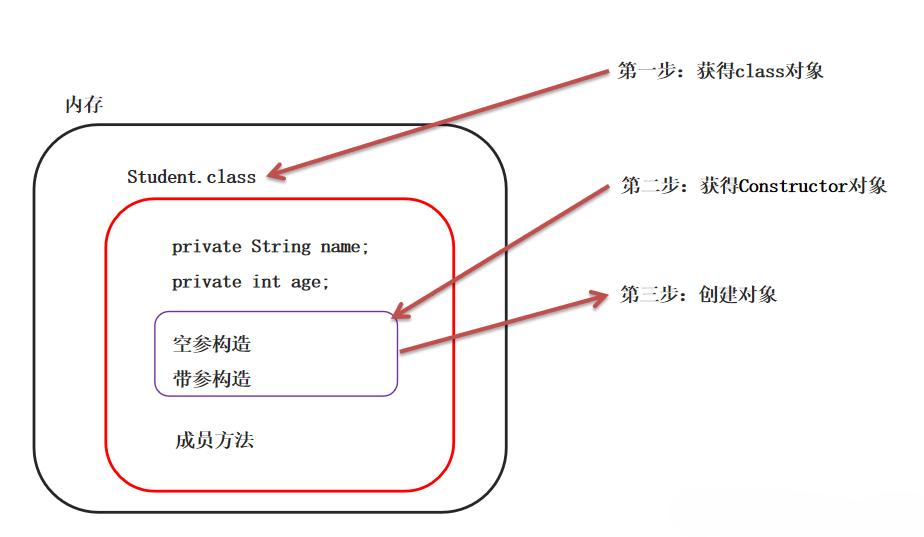

使用反射技术获取构造器对象并使用

@Testpublic void test2() throws NoSuchMethodException {

Class<Student> sc = Student.class;

// 1. 拿到所有的构造器

Constructor<?>[] constructors = sc.getDeclaredConstructors();

// 输出构造器的名称+参数个数

for (Constructor<?> constructor : constructors) {

System.out.println(constructor.getName() + " 参数个数:" + constructor.getParameterCount() + "个");

}

// 2. 拿到单个构造器

Constructor<Student> constructor = sc.getDeclaredConstructor(String.class, String.class);

System.out.println(constructor.getName() + "参数个数:" + constructor.getParameterCount());

}

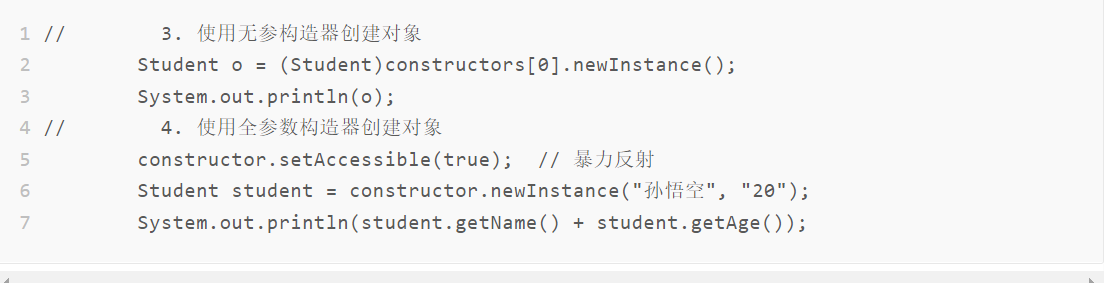

使用反射技术获取构造器对象并使用获取到的内容创建出一个对象

反射得到构造器之后的作用仍是创建一个对象,如果说构造器是public,就可以直接new对象,如果说是构造器是私有的private,需要提前将构造器进行暴力反射,再进行构造对象。

反射是可以直接破换掉封装性的,私有的也是可以执行的

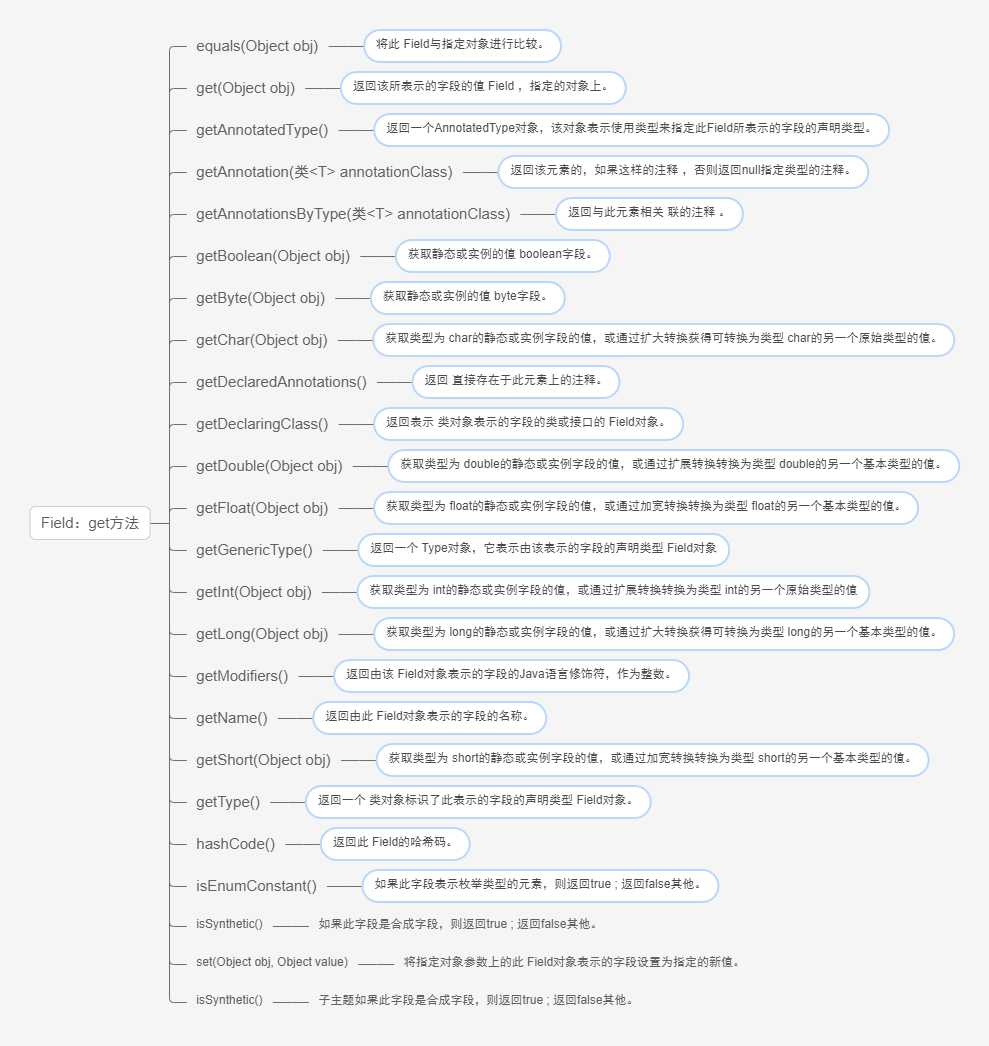

Field类及其用法

Field 提供有关类或接口的单个字段的信息,以及对它的动态访问权限。反射的字段可能是一个类(静态)字段或实例字段。

Field类涉及的get方法

同样的道理,我们可以通过Class类的提供的方法来获取代表字段信息的Field对象,Class类与Field对象相关方法如下:

下面的代码演示了上述方法的使用过程

public class ReflectField {

public static void main(String[] args) throws ClassNotFoundException, NoSuchFieldException {

Class<?> clazz = Class.forName("reflect.Student");

//获取指定字段名称的Field类,注意字段修饰符必须为public而且存在该字段,

// 否则抛NoSuchFieldException

Field field = clazz.getField("age");

System.out.println("field:" + field);

//获取所有修饰符为public的字段,包含父类字段,注意修饰符为public才会获取

Field fields[] = clazz.getFields();

for (Field f : fields) {

System.out.println("f:" + f.getDeclaringClass());

}

System.out.println("================getDeclaredFields====================");

//获取当前类所字段(包含private字段),注意不包含父类的字段

Field fields2[] = clazz.getDeclaredFields();

for (Field f : fields2) {

System.out.println("f2:" + f.getDeclaringClass());

}

//获取指定字段名称的Field类,可以是任意修饰符的自动,注意不包含父类的字段

Field field2 = clazz.getDeclaredField("desc");

System.out.println("field2:" + field2);

}

/**

输出结果:

field:public int reflect.Person.age

f:public java.lang.String reflect.Student.desc

f:public int reflect.Person.age

f:public java.lang.String reflect.Person.name

================getDeclaredFields====================

f2:public java.lang.String reflect.Student.desc

f2:private int reflect.Student.score

field2:public java.lang.String reflect.Student.desc

*/

}

class Person {

public int age;

public String name;

//省略set和get方法

}

class Student extends Person {

public String desc;

private int score;

//省略set和get方法

}

上述方法需要注意的是,如果我们不期望获取其父类的字段,则需使用Class类的

getDeclaredField/getDeclaredFields方法来获取字段即可,倘若需要连带获取到父类的字段,那么请使用Class类的getField/getFields,但是也只能获取到public修饰的的字段,无法获取父类的私有字段。下面将通过Field类本身的方法对指定类属性赋值,代码演示如下:

//获取Class对象引用

Class<?> clazz = Class.forName("reflect.Student");

Student st= (Student) clazz.newInstance();

//获取父类public字段并赋值

Field ageField = clazz.getField("age");

ageField.set(st,18);

Field nameField = clazz.getField("name");

nameField.set(st,"Lily");

//只获取当前类的字段,不获取父类的字段

Field descField = clazz.getDeclaredField("desc");

descField.set(st,"I am student");

Field scoreField = clazz.getDeclaredField("score");

//设置可访问,score是private的

scoreField.setAccessible(true);

scoreField.set(st,88);

System.out.println(st.toString());

//输出结果:Student{age=18, name='Lily ,desc='I am student', score=88}

//获取字段值System.out.println(scoreField.get(st));// 88

其中的set(Object obj, Object value)方法是Field类本身的方法,用于设置字段的值,而get(Object obj)则是获取字段的值,当然关于Field类还有其他常用的方法如下:

上述方法可能是较为常用的,事实上在设置值的方法上,Field类还提供了专门针对基本数据类型的方法,如setInt()/getInt()、setBoolean()/getBoolean、setChar()/getChar()等等方法,这里就不全部列出了,需要时查API文档即可。需要特别注意的是被final关键字修饰的Field字段是安全的,在运行时可以接收任何修改,但最终其实际值是不会发生改变的。

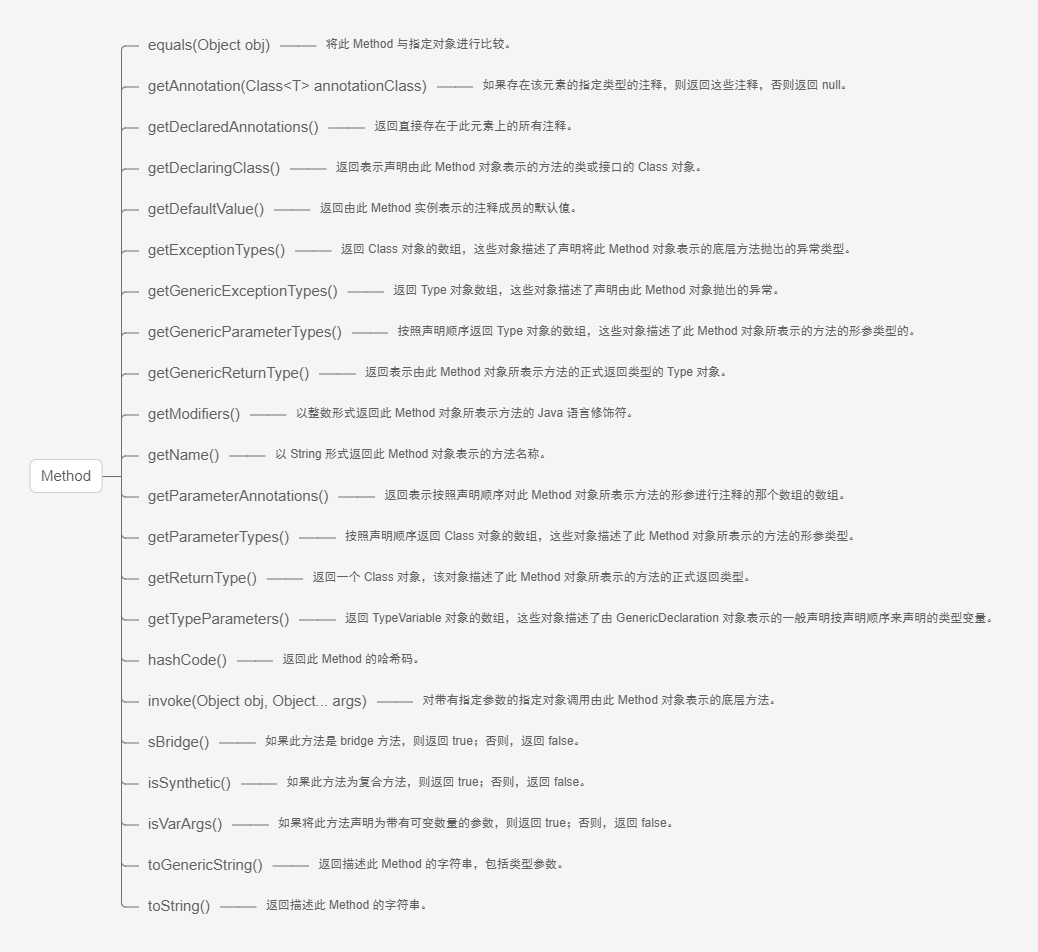

Method类及其用法

Method 提供关于类或接口上单独某个方法(以及如何访问该方法)的信息,所反映的方法可能是类方法或实例方法(包括抽象方法)。

Method类的主要方法

下面是Class类获取Method对象相关的方法:

同样通过案例演示上述方法:

import java.lang.reflect.Method;public class ReflectMethod {

public static void main(String[] args) throws ClassNotFoundException, NoSuchMethodException {

Class clazz = Class.forName("reflect.Circle");

//根据参数获取public的Method,包含继承自父类的方法

Method method = clazz.getMethod("draw", int.class, String.class);

System.out.println("method:" + method);

//获取所有public的方法:

Method[] methods = clazz.getMethods();

for (Method m : methods) {

System.out.println("m::" + m);

}

System.out.println("=========================================");

//获取当前类的方法包含private,该方法无法获取继承自父类的method

Method method1 = clazz.getDeclaredMethod("drawCircle");

System.out.println("method1::" + method1);

//获取当前类的所有方法包含private,该方法无法获取继承自父类的method

Method[] methods1 = clazz.getDeclaredMethods();

for (Method m : methods1) {

System.out.println("m1::" + m);

}

}

}

class Shape {

public void draw() {

System.out.println("draw");

}

public void draw(int count, String name) {

System.out.println("draw " + name + ",count=" + count);

}

}

class Circle extends Shape {

private void drawCircle() {

System.out.println("drawCircle");

}

public int getAllCount() {

return 100;

}

}

在通过getMethods方法获取Method对象时,会把父类的方法也获取到,如上的输出结果,把Object类的方法都打印出来了。而

getDeclaredMethod/getDeclaredMethods方法都只能获取当前类的方法。我们在使用时根据情况选择即可。下面将演示通过Method对象调用指定类的方法:

Class clazz = Class.forName("reflect.Circle");

//创建对象

Circle circle = (Circle) clazz.newInstance();

//获取指定参数的方法对象

MethodMethod method = clazz.getMethod("draw",int.class,String.class);

//通过Method对象的invoke(Object obj,Object... args)方法调用

method.invoke(circle,15,"圈圈");

//对私有无参方法的操作

Method method1 = clazz.getDeclaredMethod("drawCircle");

//修改私有方法的访问标识

method1.setAccessible(true);

method1.invoke(circle);

//对有返回值得方法操作

Method method2 =clazz.getDeclaredMethod("getAllCount");

Integer count = (Integer) method2.invoke(circle);

System.out.println("count:"+count);

输出结果

draw 圈圈,count=15

drawCircle

count:100

在上述代码中调用方法,使用了Method类的invoke(Object obj,Object... args)第一个参数代表调用的对象,第二个参数传递的调用方法的参数。这样就完成了类方法的动态调用。

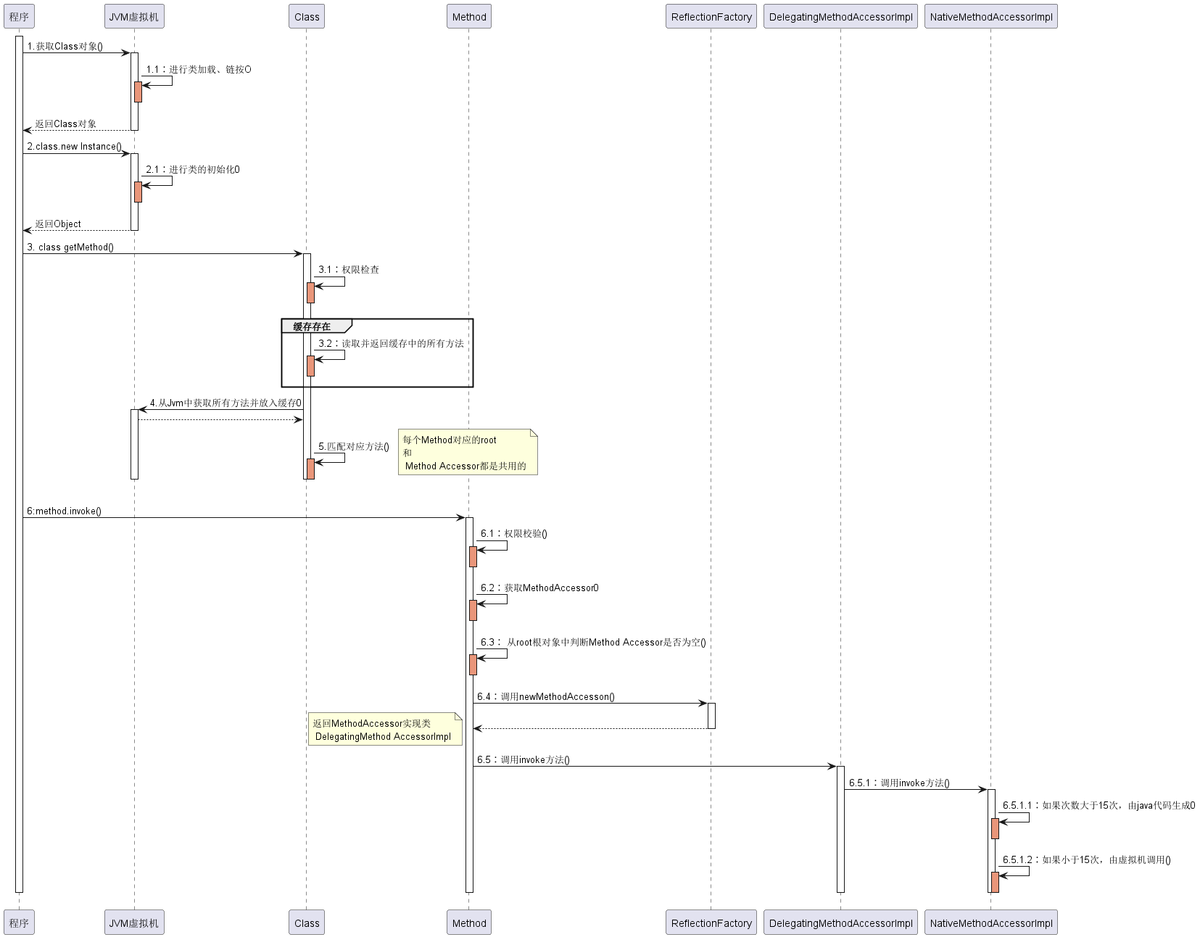

三、反射机制执行的流程

执行流程图

反射获取类实例

首先调用了 java.lang.Class 的静态方法,获取类信息。

@CallerSensitive

public static Class<?> forName(String className) throws ClassNotFoundException {

// 先通过反射,获取调用进来的类信息,从而获取当前的

classLoader Class<?> caller = Reflection.getCallerClass();

// 调用native方法进行获取class信息

return forName0(className, true, ClassLoader.getClassLoader(caller), caller);

}

forName()反射获取类信息,并没有将实现留给了java,而是交给了jvm去加载。

主要是先获取 ClassLoader, 然后调用 native 方法,获取信息,加载类则是回调 java.lang.ClassLoader.

最后,jvm又会回调 ClassLoader 进类加载。

// public Class<?> loadClass(String name) throws ClassNotFoundException { return loadClass(name, false); }

// sun.misc.Launcher

public Class<?> loadClass(String var1, boolean var2) throws ClassNotFoundException {

int var3 = var1.lastIndexOf(46);

if(var3 != -1) {

SecurityManager var4 = System.getSecurityManager();

if(var4 != null) {

var4.checkPackageAccess(var1.substring(0, var3));

}

}

if(this.ucp.knownToNotExist(var1)) {

Class var5 = this.findLoadedClass(var1);

if(var5 != null) {

if(var2) {

this.resolveClass(var5);

}

return var5;

} else {

throw new ClassNotFoundException(var1);

}

} else {

return super.loadClass(var1, var2);

}

}

// java.lang.ClassLoader

protected Class<?> loadClass(String name, boolean resolve) throws ClassNotFoundException {

// 先获取锁

synchronized (getClassLoadingLock(name)) {

// First, check if the class has already been loaded

// 如果已经加载了的话,就不用再加载了

Class<?> c = findLoadedClass(name);

if (c == null) {

long t0 = System.nanoTime();

try {

// 双亲委托加载

if (parent != null) {

c = parent.loadClass(name, false);

} else {

c = findBootstrapClassOrNull(name);

}

} catch (ClassNotFoundException e) {

// ClassNotFoundException thrown if class not found

// from the non-null parent class loader

}

// 父类没有加载到时,再自己加载

if (c == null) {

// If still not found, then invoke findClass in order

// to find the class.

long t1 = System.nanoTime();

c = findClass(name);

// this is the defining class loader; record the stats

sun.misc.PerfCounter.getParentDelegationTime().addTime(t1 - t0);

sun.misc.PerfCounter.getFindClassTime().addElapsedTimeFrom(t1);

sun.misc.PerfCounter.getFindClasses().increment();

}

}

if (resolve) {

resolveClass(c);

}

return c;

}

}

protected Object getClassLoadingLock(String className) {

Object lock = this;

if (parallelLockMap != null) {

// 使用 ConcurrentHashMap来保存锁

Object newLock = new Object();

lock = parallelLockMap.putIfAbsent(className, newLock);

if (lock == null) {

lock = newLock;

}

}

return lock;

}

protected final Class<?> findLoadedClass(String name) {

if (!checkName(name))return null;

return findLoadedClass0(name);

}

下面来看一下 newInstance() 的实现方式。

// 首先肯定是 Class.newInstance

@CallerSensitive

public T newInstance() throws InstantiationException, IllegalAccessException {

if (System.getSecurityManager() != null) {

checkMemberAccess(Member.PUBLIC, Reflection.getCallerClass(), false);

}

// NOTE: the following code may not be strictly correct under

// the current Java memory model.

// Constructor lookup

// newInstance() 其实相当于调用类的无参构造函数,所以,首先要找到其无参构造器

if (cachedConstructor == null) {

if (this == Class.class) {

// 不允许调用 Class 的 newInstance() 方法

throw new IllegalAccessException("Can not call newInstance() on the Class for java.lang.Class");

}

try {

// 获取无参构造器

Class<?>[] empty = {};

final Constructor<T> c = getConstructor0(empty, Member.DECLARED);

// Disable accessibility checks on the constructor

// since we have to do the security check here anyway

// (the stack depth is wrong for the Constructor's

// security check to work)

java.security.AccessController.doPrivileged(

new java.security.PrivilegedAction<Void>() {

public Void run() {

c.setAccessible(true);

return null;

}

});

cachedConstructor = c;

} catch (NoSuchMethodException e) {

throw (InstantiationException)

new InstantiationException(getName()).initCause(e);

}

}

Constructor<T> tmpConstructor = cachedConstructor;

// Security check (same as in java.lang.reflect.Constructor)

int modifiers = tmpConstructor.getModifiers();

if (!Reflection.quickCheckMemberAccess(this, modifiers)) {

Class<?> caller = Reflection.getCallerClass();

if (newInstanceCallerCache != caller) {

Reflection.ensureMemberAccess(caller, this, null, modifiers);

newInstanceCallerCache = caller;

}

}

// Run constructor

try {

// 调用无参构造器

return tmpConstructor.newInstance((Object[]) null);

} catch (InvocationTargetException e) {

Unsafe.getUnsafe().throwException(e.getTargetException());

// Not reached

return null;

}

}

newInstance() 主要做了三件事:

- 权限检测,如果不通过直接抛出异常;查找无参构造器,并将其缓存起来;调用具体方法的无参构造方法,生成实例并返回;

下面是获取构造器的过程:

private Constructor<T> getConstructor0(Class<?>[] parameterTypes, int which) throws NoSuchMethodException {

// 获取所有构造器

Constructor<T>[] constructors = privateGetDeclaredConstructors((which == Member.PUBLIC));

for (Constructor<T> constructor : constructors) {

if (arrayContentsEq(parameterTypes, constructor.getParameterTypes())) {

return getReflectionFactory().copyConstructor(constructor);

}

}

throw new NoSuchMethodException(getName() + ".<init>" + argumentTypesToString(parameterTypes));

}

getConstructor0() 为获取匹配的构造方器;分三步:

- 先获取所有的constructors, 然后通过进行参数类型比较;找到匹配后,通过 ReflectionFactory copy一份constructor返回;否则抛出 NoSuchMethodException;

返回构造器的实例后,可以根据外部进行进行类型转换,从而使用接口或方法进行调用实例功能了。

反射获取方法

- 第一步,先获取 Method;

// java.lang.Class

@CallerSensitive

public Method getDeclaredMethod(String name, Class<?>... parameterTypes) throws NoSuchMethodException, SecurityException {

checkMemberAccess(Member.DECLARED, Reflection.getCallerClass(), true);

Method method = searchMethods(privateGetDeclaredMethods(false), name, parameterTypes);

if (method == null) {

throw new NoSuchMethodException(getName() + "." + name + argumentTypesToString(parameterTypes));

}

return method;

}

... TODO 后续学习

反射调用流程小结

最后,用几句话总结反射的实现原理:

反射类及反射方法的获取,都是通过从列表中搜寻查找匹配的方法,所以查找性能会随类的大小方法多少而变化;

每个类都会有一个与之对应的Class实例,从而每个类都可以获取method反射方法,并作用到其他实例身上;

反射也是考虑了线程安全的,放心使用;

反射使用软引用relectionData缓存class信息,避免每次重新从jvm获取带来的开销;

反射调用多次生成新代理Accessor, 而通过字节码生存的则考虑了卸载功能,所以会使用独立的类加载器;

当找到需要的方法,都会copy一份出来,而不是使用原来的实例,从而保证数据隔离;

调度反射方法,最终是由jvm执行invoke0()执行

21、Java创建对象得五种方式?

1)new关键字 (2)Class.newInstance (3)Constructor.newInstance (4)Clone方法 (5)反序列化

22 、设计模式 单例模式

单例模式定义与特点

定义:

单例模式(Singleton)指一个类只有一个实例,并且该类能自行创建这个实例的一种模式。例如,Windows 中只能打开一个任务管理器,这样可以避免因打开多个任务管理器窗口而造成内存资源的浪费,或出现各个窗口显示内容的不一致等错误。

特点:

- 单例类只有一个实例对象;

- 该单例对象必须由单例类自行创建;

- 单例类对外提供一个访问该单例的全局访问点;

单例模式的两种模式

两种单例模式实现方式:饿汉式、懒汉式

1. 饿汉式

该模式的特点是类一旦加载就创建一个单例,保证在调用 getInstance 方法之前单例已经存在了。

package com.fs.singleton;

/**

* 饿汉模式

*/

public class HungrySingleton {

/**

* 私有实例,静态变量会在类加载的时候初始化,是线程安全的

*/

private static final HungrySingleton instance=new HungrySingleton();

/**

* 私有构造方法

*/

private HungrySingleton(){

System.out.println("private HungrySingleton()");

}

/**

* 唯一公开获取实例的方法(静态工厂方法)

*

* @return

*/

public static HungrySingleton getInstance() {

return instance;

}

public static void otherMethod(){

System.out.println("otherMethod()");

}

}

懒汉式

package com.fs.singleton;

/**

* 懒汉模式

*/

public class LazySingleton {

/**

* 私有实例

*/

private static LazySingleton instance=null;

/**

* 私有构造方法

*/

private LazySingleton(){

System.out.println("private LazySingleton()");

}

/**

* 唯一公开获取实例的方法(静态工厂方法),

*

* @return

*/

public static LazySingleton getInstance(){

if(instance==null){

instance=new LazySingleton();

}

return instance;

}

public static void otherMethod(){

System.out.println("otherMethod()");

}

}

单例模式的应用场景

在应用场景中,某类只要求生成一个对象的时候,比如一个班级生成一个班长。

当对象需要被共享的场合。由于单例模式只允许创建一个对象,共享该对象可以节省内存,并加快对象访问速度。如 Web 中的配置对象、数据库的连接池等。

当某类需要频繁实例化,而创建的对象又频繁被销毁的时候,如多线程的线程池、网络连接池等。

23、树、二叉树、红黑树、B+tree

24、map集合

1. 简介

Map集合是一种以键值对形式存储和操作数据的数据结构,建立了key-value之间的映射关系,常用于存储和处理复杂的数据。同时Map也是一种双列集合接口,它有多个实现类,包括HashMap、TreeMap、LinkedHashMap等,最常用的是HashMap类。其中,HashMap是按哈希算法来实现存取键对象的,这是我们开发时最常用的Map子类,而TreeMap类则可以对键对象进行排序。

Map集合中的每个元素,都包含了一个键(key)和一个值(value),key和value组成了键-值的映射表,我们称其为键值对。键用于唯一标识一个元素,值用于存储该元素的数据,一般情况下,这个key和value可以是任何引用类型的数据。其中,键key是无序、无下标、不重复的,最多只能有一个key为null。值value是无序、无下标、可重复的,可以有多个value为null。

并且这个key和value之间是单向的一对一关系,即通过指定的key,总能找到唯一的、确定的value。当我们想从Map中取出数据时,只要给出指定的key,就能取出对应的value。

2. 特点

根据上面我们对Map概念的讲解,把Map的主要特点给大家总结如下:

- Map和List不同,Map是一种双列集合;

- Map存储的是key-value的映射关系;

- Map不保证顺序。在遍历时,遍历的顺序不一定是put()时放入的key的顺序,也不一定是key的排序顺序。

3. 实现方式

在Java中,Map集合的实现方式主要有两种:基于哈希表和基于树结构。接下来给大家简单介绍一下基于这两种结构的Map集合。

3.1 基于哈希表的Map集合

基于哈希表的Map,其底层是基于哈希表作为数据结构的集合,主要的实现类是HashMap。在HashMap中,每个元素都包含一个键和一个值。当我们在添加元素时,HashMap会根据键的哈希值计算出对应的桶(Bucket),并将元素存储到该桶中。如果不同的键具有相同的哈希值,就会出现哈希冲突,此时HashMap会使用链表或红黑树等数据结构来解决冲突。基于哈希表的Map集合具有快速的添加、删除和查找元素的特点,但元素的顺序是不确定的。

3.2 基于树结构的Map集合

基于树结构的Map集合,其底层是基于红黑树作为数据结构的集合,主要的实现类是TreeMap。在TreeMap中,每个元素也都包含一个键和一个值。我们在添加元素时,TreeMap会根据键的比较结果,将元素存储到正确的位置上,使得元素可以按照键的升序或降序排列。基于树结构的Map集合,具有快速查找和遍历元素的特点,但添加和删除元素的速度较慢。

4. 常用方法

Map集合的使用和其他集合类似,主要包括添加、删除、获取、遍历元素等操作。当我们调用put(K key, V value)方法时,会把key和value进行映射并放入Map。当调用V get(K key)时,可以通过key获取到对应的value;如果key不存在,则返回null。如果我们只是想查询某个key是否存在,可以调用containsKey(K key)方法。另外我们也可以通过 Map提供的keySet()方法,获取所有key组成的集合,进而遍历Map中所有的key-value对。

下表中就是Map里的一些常用方法,大家可以记一下,这些方法在Map的各实现子类中也都存在。

5. 常用实现类

Java中有多个Map接口的实现类,接下来就给大家逐一简单介绍一下

5.1 HashMap

HashMap是Java中最常用的Map集合实现类,它基于哈希表实现,具有快速查找键值对的优点。HashMap的存储方式是无序的,也就是说,遍历HashMap集合时,得到的键值对顺序是不确定的。下面是创建HashMap集合的代码示例:

HashMap<String, Object> map = new HashMap<>();

5.2 TreeMap

TreeMap是Java中另一个常用的Map集合实现类,它基于红黑树实现,具有自动排序键值对的优点。TreeMap的存储方式是有序的,也就是说,遍历TreeMap集合时得到的键值对,是按照键的自然顺序或指定比较器的顺序排序的。下面是创建TreeMap集合的代码示例

Map<String, Integer> treeMap = new TreeMap<>();

5.3 LinkedHashMap

LinkedHashMap是Java中另一个Map集合实现类,它继承自HashMap,并保持了插入顺序。也就是说,遍历LinkedHashMap集合时,得到的键值对的顺序是按照插入顺序排序的。下面是创建LinkedHashMap集合的代码示例:

5.4 Hashtable

Hashtable是Java中另一个Map集合实现类,它与HashMap非常相似,但Hashtable是线程安全的。Hashtable的存储方式是无序的,也就是说,遍历Hashtable集合时,得到的键值对的顺序是不确定的。下面是创建Hashtable集合的代码示例

5.5 ConcurrentHashMap

ConcurrentHashMap是Java中的另一个Map集合实现类,它与Hashtable非常相似,但是ConcurrentHashMap是线程安全的,并且性能更高。ConcurrentHashMap的存储方式是无序的,也就是说,遍历ConcurrentHashMap集合时,得到的键值对的顺序是不确定的。下面是创建ConcurrentHashMap集合的代码示例:

需要注意的是,虽然ConcurrentHashMap是线程安全的,但仍然需要注意多线程环境下的并发问题。

6.线程安全:

使用Hashtable

使用Collections.synchronizedMap(new Hashtable())

使用ConcurrentHashMap

二、Java多线程篇

线程的返回值

1.进程和线程的区别,进程间如何通信

进程:系统运行的基本单位,进程在运行过程中都是相互独立,但是线程之间运行可以相互影响。

线程:独立运行的最小单位,一个进程包含多个线程且它们共享同一进程内的系统资源

进程间通过管道、 共享内存、信号量机制、消息队列通信

2. 什么是线程上下文切换

当一个线程被剥夺cpu使用权时,切换到另外一个线程执行

3.什么是死锁

死锁指多个线程在执行过程中,因争夺资源造成的一种相互等待的僵局

4.死锁的必要条件

互斥条件:同一资源同时只能由一个线程读取

不可抢占条件:不能强行剥夺线程占有的资源

请求和保持条件:请求其他资源的同时对自己手中的资源保持不放

循环等待条件:在相互等待资源的过程中,形成一个闭环

想要预防死锁,只需要破坏其中一个条件即可,比如使用定时锁、尽量让线程用相同的加锁顺序,还可以用银行家算法可以预防死锁

5.Synchrpnized和lock的区别

(1)synchronized是关键字,lock是一个类

(2) synchronized在发生异常时会自动释放锁,lock需要手动释放锁

(3)synchronized是可重入锁、非公平锁、不可中断锁,lock的ReentrantLock是可重入锁,可中断锁,可以是公平锁也可以是非公平锁

(4)synchronized是JVM层次通过监视器实现的,Lock是通过AQS实现的

6.什么是AQS锁?

AQS是一个抽象类,可以用来构造锁和同步类,如ReentrantLock,Semaphore,CountDownLatch,CyclicBarrier。

AQS的原理是,AQS内部有三个核心组件,一个是state代表加锁状态初始值为0,一个是获取到锁的线程,还有一个阻塞队列。当有线程想获取锁时,会以CAS的形式将state变为1,CAS成功后便将加锁线程设为自己。当其他线程来竞争锁时会判断state是不是0,不是0再判断加锁线程是不是自己,不是的话就把自己放入阻塞队列。这个阻塞队列是用双向链表实现的

可重入锁的原理就是每次加锁时判断一下加锁线程是不是自己,是的话state+1,释放锁的时候就将state-1。当state减到0的时候就去唤醒阻塞队列的第一个线程。

7.为什么AQS使用的双向链表?

因为有一些线程可能发生中断 ,而发生中断时候就需要在同步阻塞队列中删除掉,这个时候用双向链表方便删除掉中间的节点

8.有哪些常见的AQS锁

AQS分为独占锁和共享锁

ReentrantLock(独占锁):可重入,可中断,可以是公平锁也可以是非公平锁,非公平锁就是会通过两次CAS去抢占锁,公平锁会按队列顺序排队

Semaphore(信号量):设定一个信号量,当调用acquire()时判断是否还有信号,有就获取一个信号量,没有就阻塞等待其他线程释放信号量,当调用release()时释放一个信号量,唤醒阻塞线程。

应用场景:允许多个线程访问某个临界资源时,如上下车,买卖票

CountDownLatch(倒计数器):给计数器设置一个初始值,当调用CountDown()时计数器减一,当调用await() 时判断计数器是否归0,不为0就阻塞,直到计数器为0。

应用场景:启动一个服务时,主线程需要等待多个组件加载完毕,之后再继续执行

CyclicBarrier(循环栅栏):给计数器设置一个目标值,当调用await() 时会计数+1并判断计数器是否达到目标值,未达到就阻塞,直到计数器达到目标值

应用场景:多线程计算数据,最后合并计算结果的应用场景

9.sleep()和wait()的区别

(1)wait()是Object的方法,sleep()是Thread类的方法

(2)wait()会释放锁,sleep()不会释放锁

(3)wait()要在同步方法或者同步代码块中执行,sleep()没有限制

(4)wait()要调用notify()或notifyall()唤醒,sleep()自动唤醒

10.yield()和join()区别

join和yield的区别是:

yield()方法是暂停当前正在执行的线程对象,并执行其他线程。

jion()方法:线程实例的join()方法可以使得一个线程在另一个线程结束后再执行,即也就是说使得当前线程可以阻塞其他线程执行。

yield()方法

暂停当前正在执行的线程对象,并执行其他线程。理论上,yield意味着放手,放弃,投降。一个调用yield()方法的线程告诉虚拟机它乐意让其他线程占用自己的位置。这表明该线程没有在做一些紧急的事情。注意,这仅是一个暗示,并不能保证不会产生任何影响。

yield()应该做的是让当前运行线程回到可运行状态,以允许具有相同优先级的其他线程获得运行机会。因此,使用yield()的目的是让相同优先级的线程之间能适当的轮转执行。但是,实际中无法保证yield()达到让步目的,因为让步的线程还有可能被线程调度程序再次选中。

结论:yield()从未导致线程转到等待/睡眠/阻塞状态。在大多数情况下,yield()将导致线程从运行状态转到可运行状态,但有可能没有效果。

jion()方法

线程实例的join()方法可以使得一个线程在另一个线程结束后再执行,即也就是说使得当前线程可以阻塞其他线程执行;

thread.Join把指定的线程加入到当前线程,可以将两个交替执行的线程合并为顺序执行的线程。

比如在线程B中调用了线程A的Join()方法,直到线程A执行完毕后,才会继续执行线程B。

线程实例的join()方法可以使得一个线程在另一个线程结束后再执行。如果join()方法在一个线程实例上调用,当前运行着的线程将阻塞直到这个线程实例完成了执行。例如下面代码所示,t将阻塞t1知道t执行完毕后在执行t1;

在join()方法内可以设定超时,使得join()方法在超时后无效。当超时时,主方法和任务线程申请运行的时候是平等的。然而,当涉及sleep时,join()方法依靠操作系统计,所以你不应该假定join()方法将会等待你指定的时间。

像sleep,join通过抛出InterruptedException对中断做出回应。

11.线程池七大参数

核心线程数:线程池中的基本线程数量

最大线程数:当阻塞队列满了之后,逐一启动

最大线程的存活时间:当阻塞队列的任务执行完后,最大线长的回收时间

最大线程的存活时间单位

阻塞队列:当核心线程满后,后面来的任务都进入阻塞队列

线程工厂:用于生产线程

任务拒绝策略:阻塞队列满后,拒绝任务,有四种策略(1)抛异常(2)丢弃任务不抛异常(3)打回任务(4)尝试与最老的线程竞争

public ThreadPoolExecutor(int corePoolSize,

int maximumPoolSize,

long keepAliveTime,

TimeUnit unit,

BlockingQueue<Runnable> workQueue,

ThreadFactory threadFactory,

RejectedExecutionHandler handler)

关键参数:

- 核心线程数corePoolSize,也就是即使线程数小于核心线程数也不会回收。除非设置了allowCoreThreadTimeOut

- 最大线程数maximumPoolSize,也就是可以容纳的最大线程数量包括核心线程和非核心线程。非核心线程空闲的时候会被回收。

- 最大存活时间keepAliveTime,非核心线程超过该时间是闲置的就回收该线程。

- 时间单位

- 任务队列workQueue, 线程池中维护了一个任务队列 , 线程池启动后 , 会不停的从任务队列中取出任务 , 如果有新任务 , 执行如下操作 ;

如果线程数小于核心线程数 ( CoreSize ) , 那么创建核心线程 , 执行上述任务 ;

如果 线程数 大于核心线程数 ( CoreSize ) , 小于最大线程数 ( MaxSize ) , 那么创建非核心线程 , 执行上述任务 ;

如果 线程数 超过 最大线程数 ( MaxSize )

如果 任务队列没满 , 则将任务放入任务队列 ;

如果 任务队列满了 , 则抛出异常 ; 这里一般情况下需要手动处理这种情况 , 任务拒绝后 , 处理善后 - 线程工厂,控制如何产生线程。

- 拒绝策略RejectedExecutionHandler,若线程池中的核心线程数被用完且阻塞队列已排满,则此时线程池的资源已耗尽,线程池将没有足够的线程资源执行新的任务。为了保证操作系统的安全,线程池将通过拒绝策略处理新添加的线程任务。

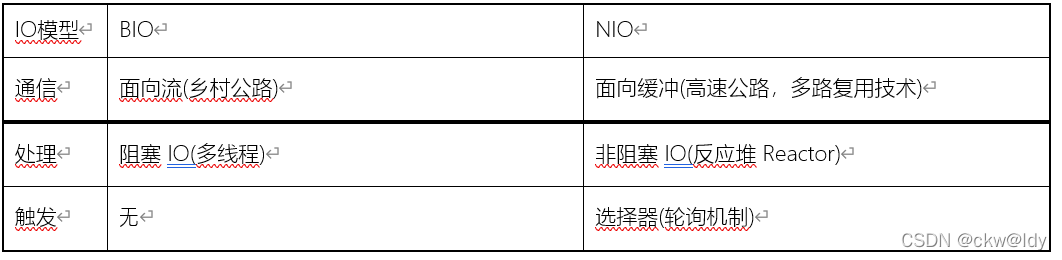

12.Java内存模型

主内存与工作内存

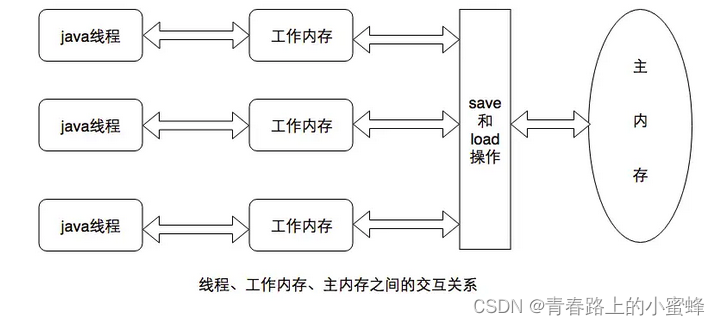

Java内存模型规定了所有的变量都存储在主内存(Main Memory)中(此处的主内存与介绍物理硬件时的主内存名字一样,两者也可以互相类比,但此处仅是虚拟机内存的一部分)。每条线程还有自己的工作内存(Working Memory,可与前面讲的处理器高速缓存类比),线程的工作内存中保存了被该线程使用到的变量的主内存副本拷贝,线程对变量的所有操作(读取、赋值等)都必须在工作内存中进行,而不能直接读写主内存中的变量。不同的线程之间也无法直接访问对方工作内存中的变量,线程间变量值的传递均需要通过主内存来完成。线程、主内存、工作内存三者的交互关系如图所示:

内存间交互操作

关于主内存与工作内存之间具体的交互协议,即一个变量如何从主内存拷贝到工作内存、如何从工作内存同步回主内存的实现细节,Java内存模型规定了以下8种操作来完成,虚拟机实现时必须保证下面提及的每一种操作都是原子的、不可再分的(对于double和long类型的变量来说,load、store、read和write操作在某些平台上允许有例外)

- lock(锁定):作用于主内存中的变量,一个变量在同一时间只能一个线程独占,该操作表示这条线程独占这个变量。

- unlock(解锁):作用于主内存的变量,表示这个变量的状态由处于锁定状态被释放,这样其他线程能对该变量进行锁定。

- read(读取):作用于主内存变量,表示把一个主内存变量的值传输到线程的工作内存,以便随后的load操作使用。

- load(载入):作用于线程的工作内存的变量,表示把read操作从主内存中读取的变量的值放到工作内存的副本中(副本相对于主内存的变量而言的)

- use(使用):作用于线程的工作内存的变量,表示把工作内存中的一个变量的值传递给执行引擎,每当虚拟机遇到一个需要使用变量的值的字节码指令时就会执行该操作

- assign(赋值):作用于线程的工作内存中的变量,表示把执行引擎返回的结果赋值给工作内存中的变量,每当虚拟机遇到一个给变量赋值的字节码指令时就会执行该操作

- store(存储):作用于线程的工作内存中的变量,把工作内存中的一个变量的值传递给主内存,以便随后的write操作使用