【2022.11.01】机器学习名词记录

学习来源均来自:https://www.bilibili.com/video/BV1Wv411h7kN

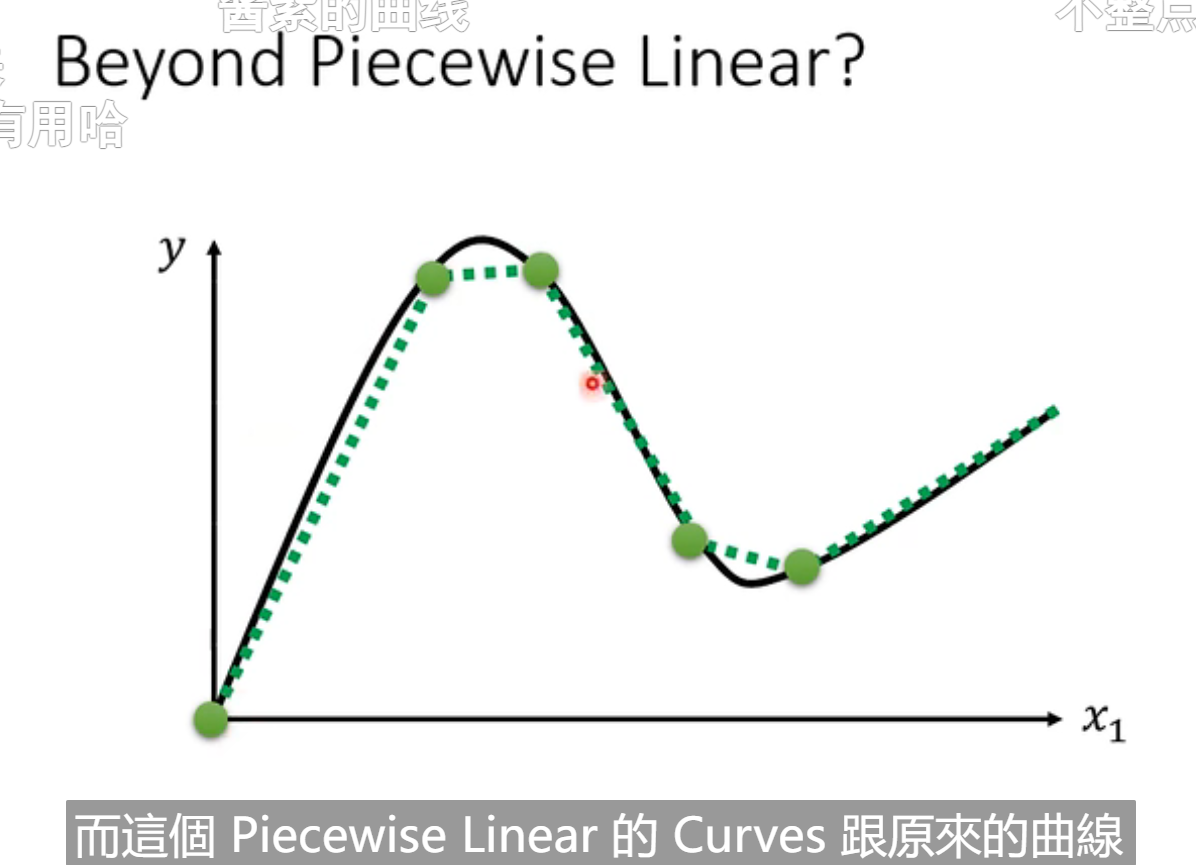

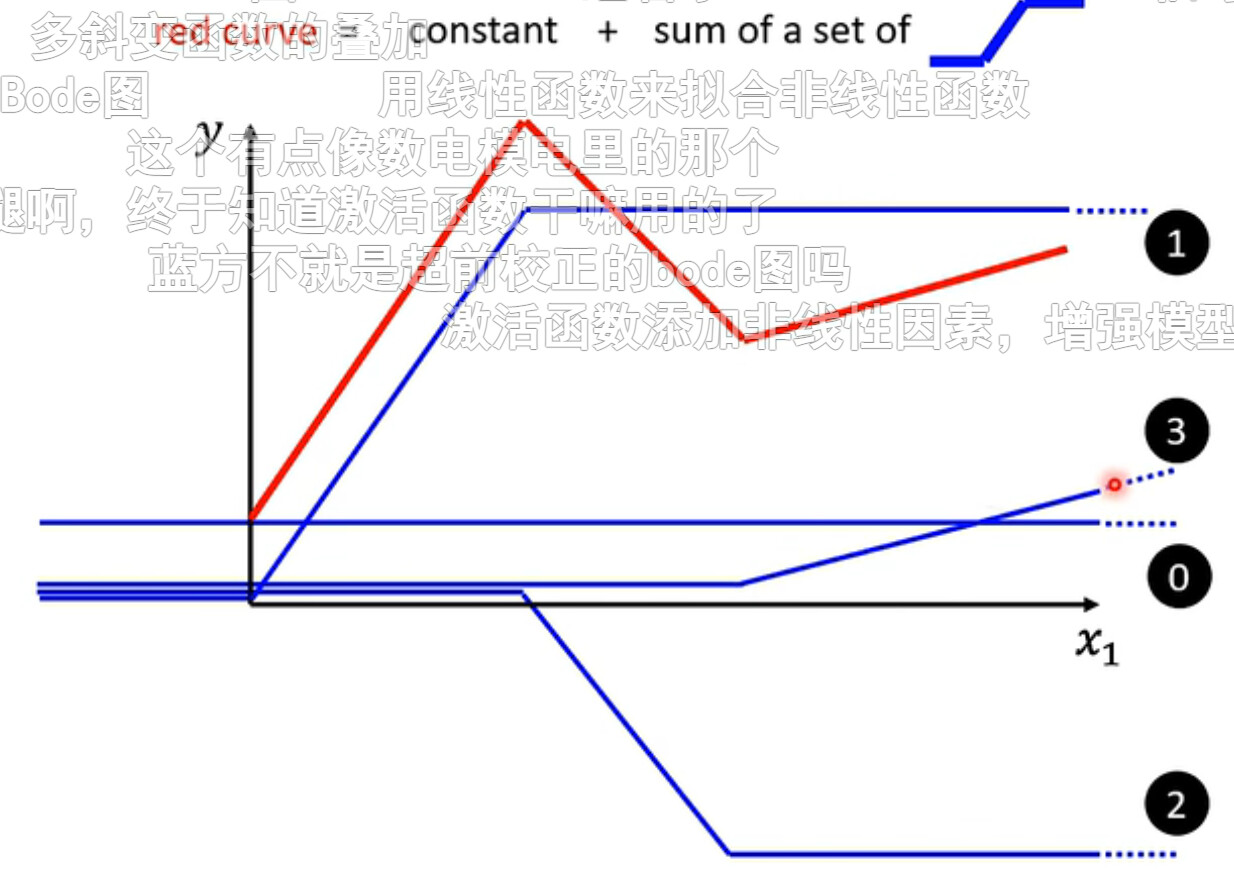

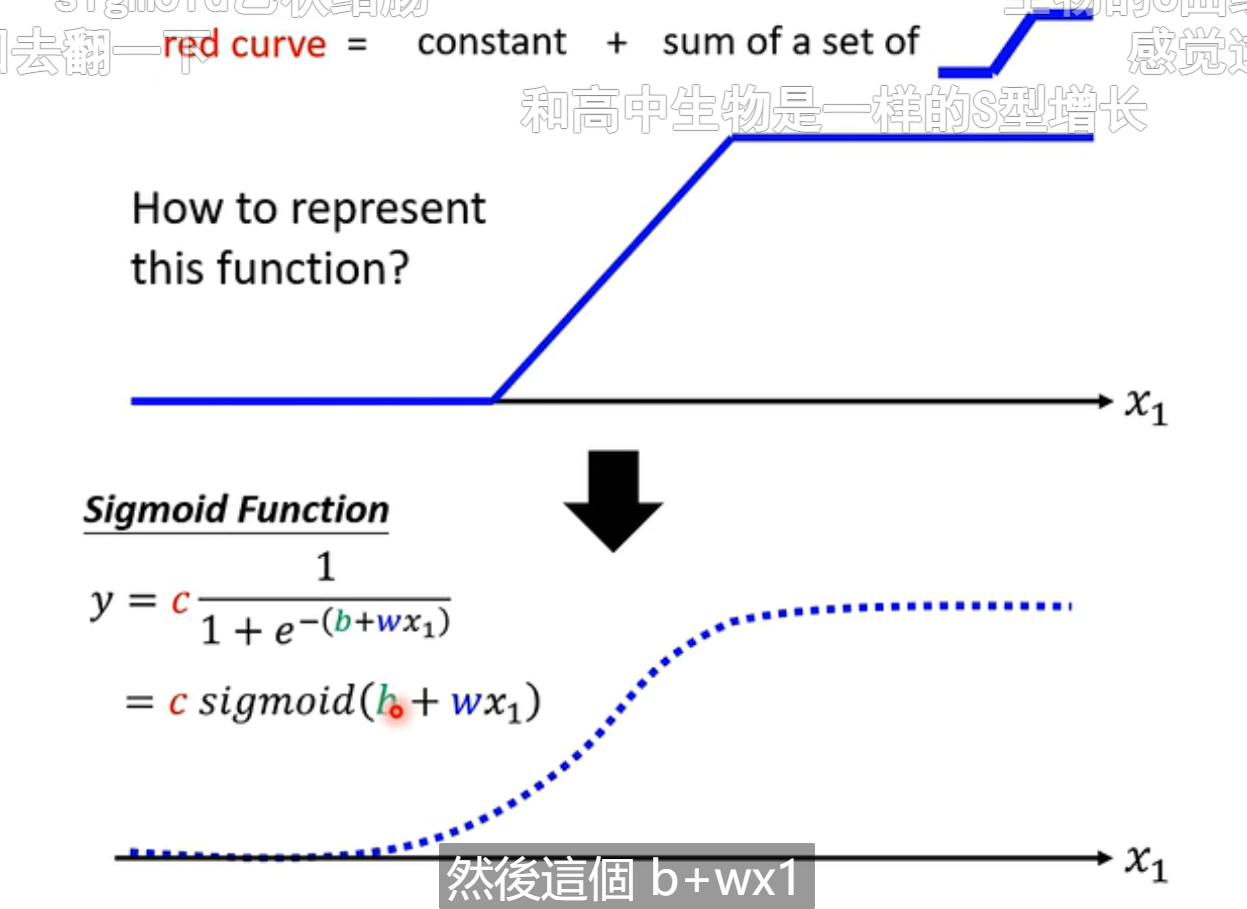

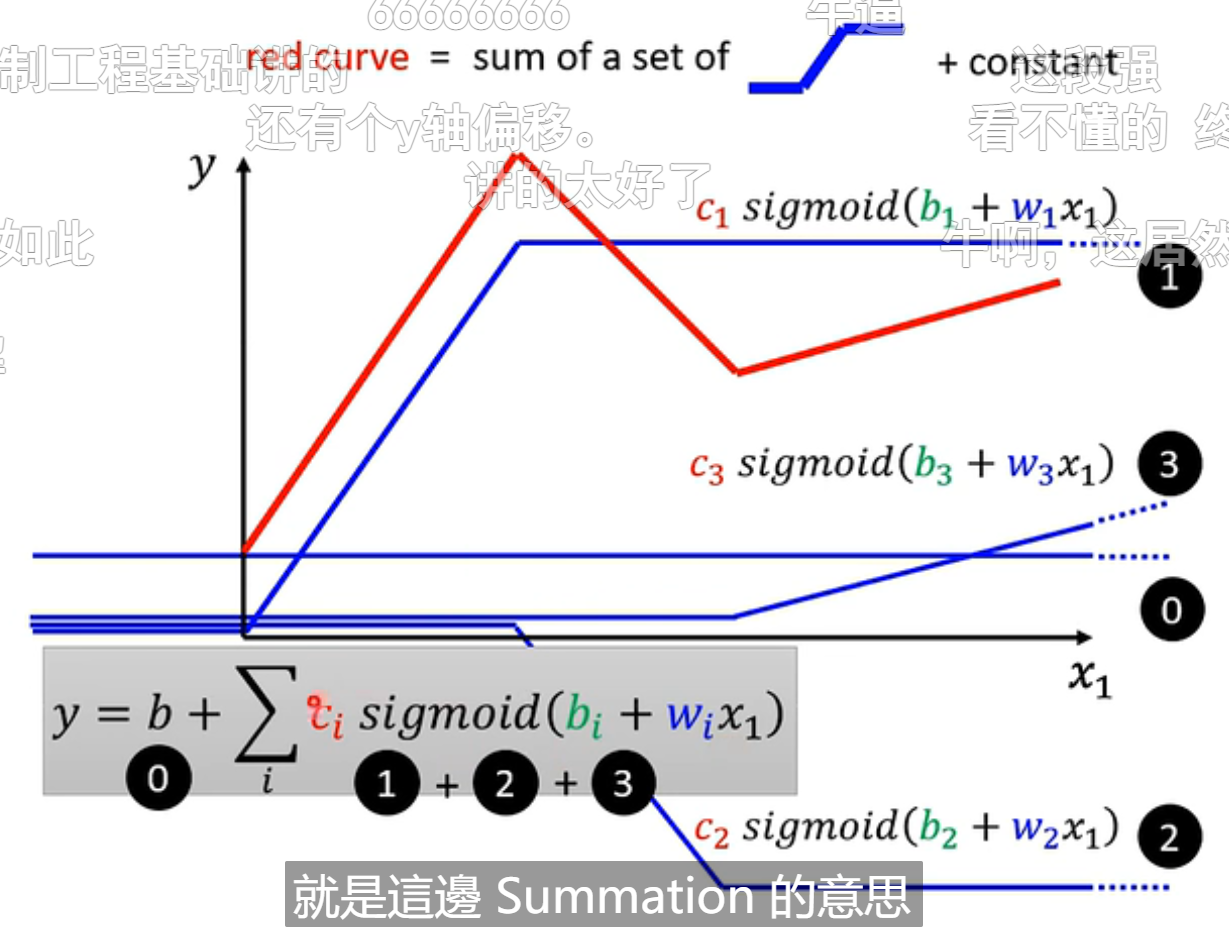

当我们设定函数的时候,不一定是线性的情况下,可以将一个曲线图拆分成多个函数相加

正如下图中的红色图,是由四条曲线相加得到

如果要将折线图模拟成曲线图的话,一般使用sigmoid来逼近原来的折线图

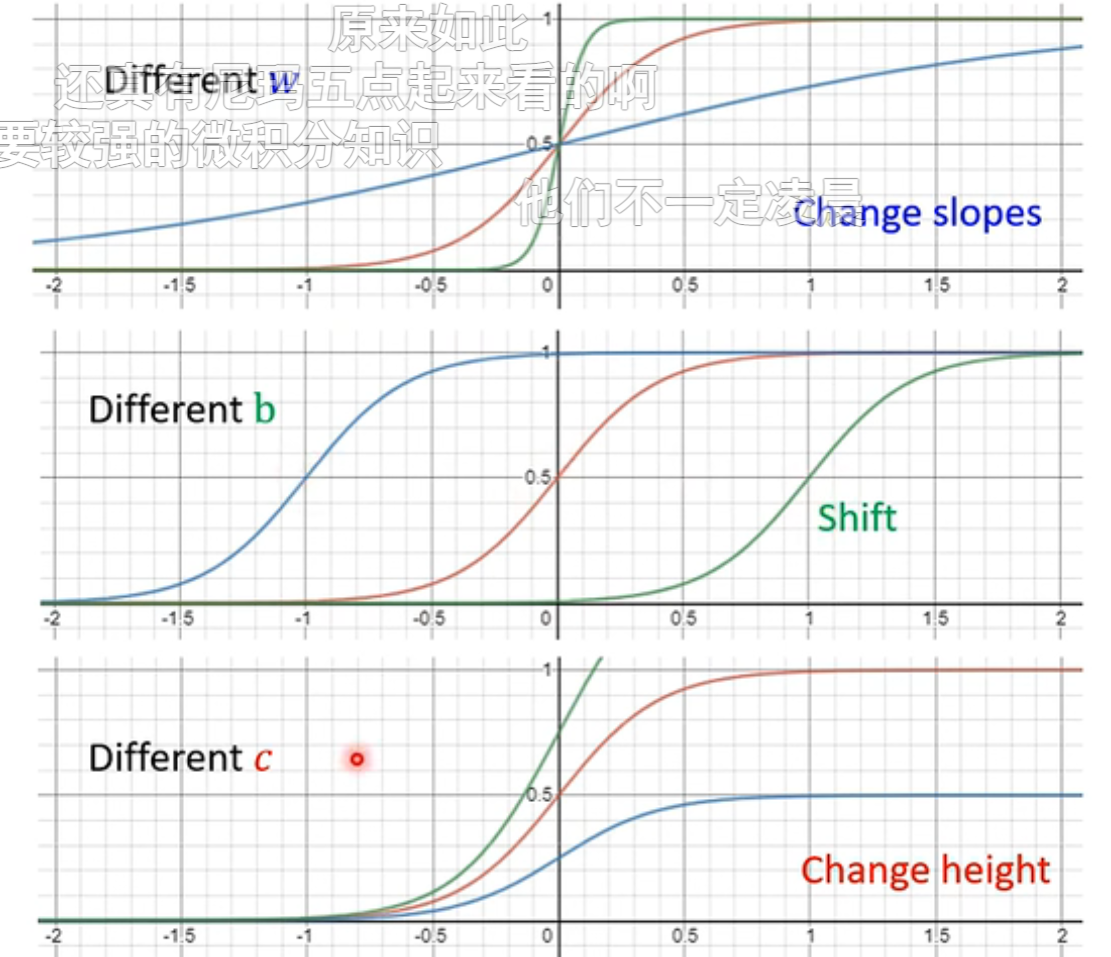

改变不同的参数获得的不同结果

上面的红色折线图就可以由四个sigmoid函数组成

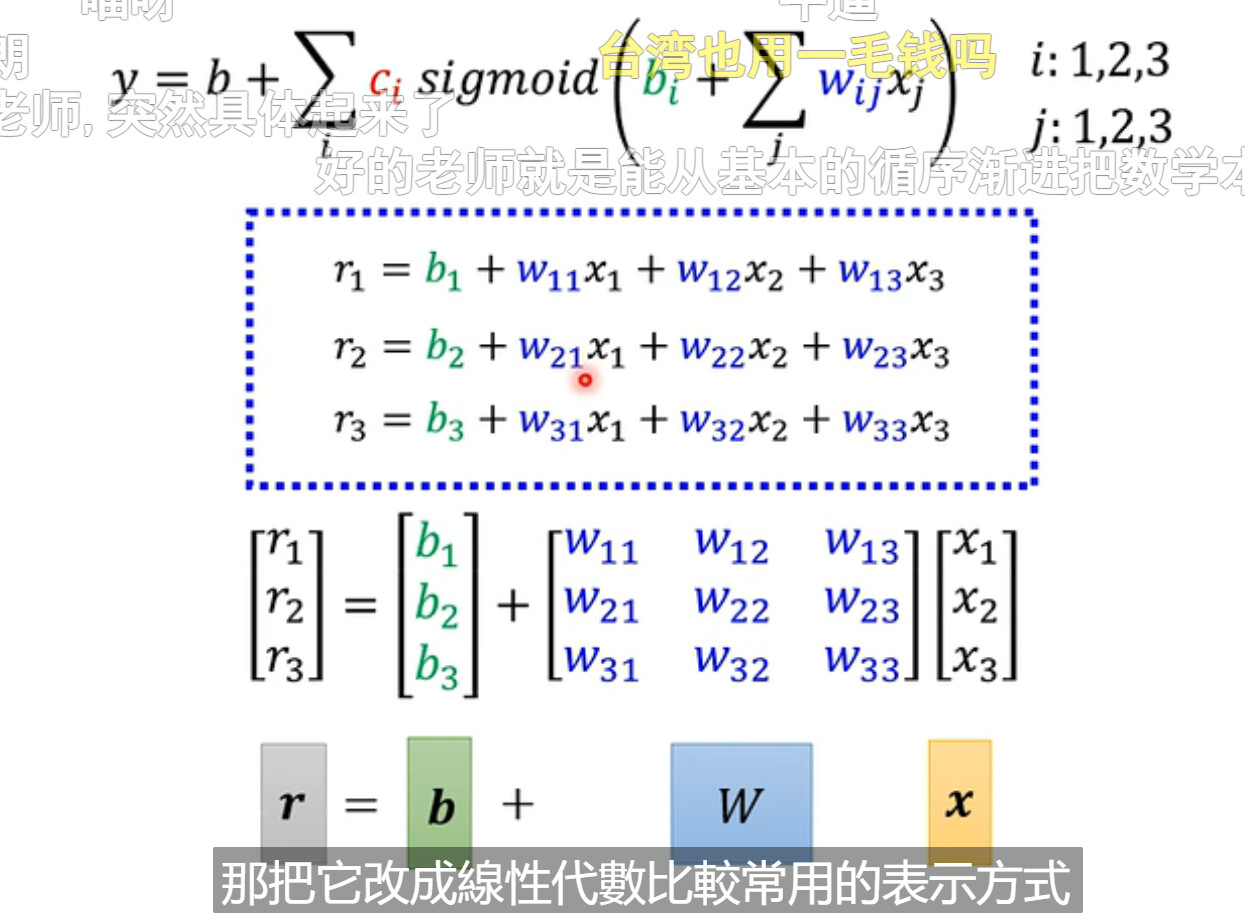

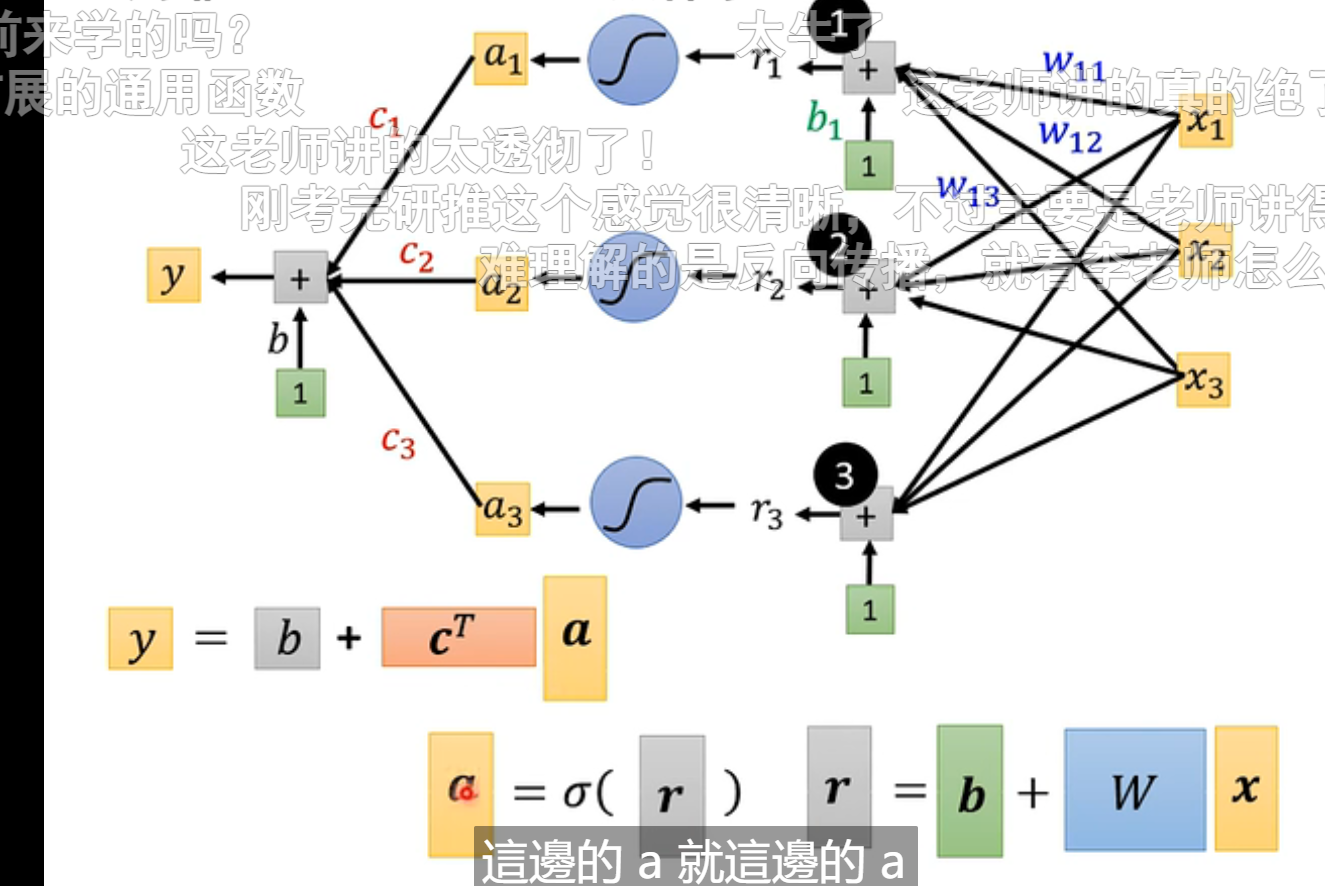

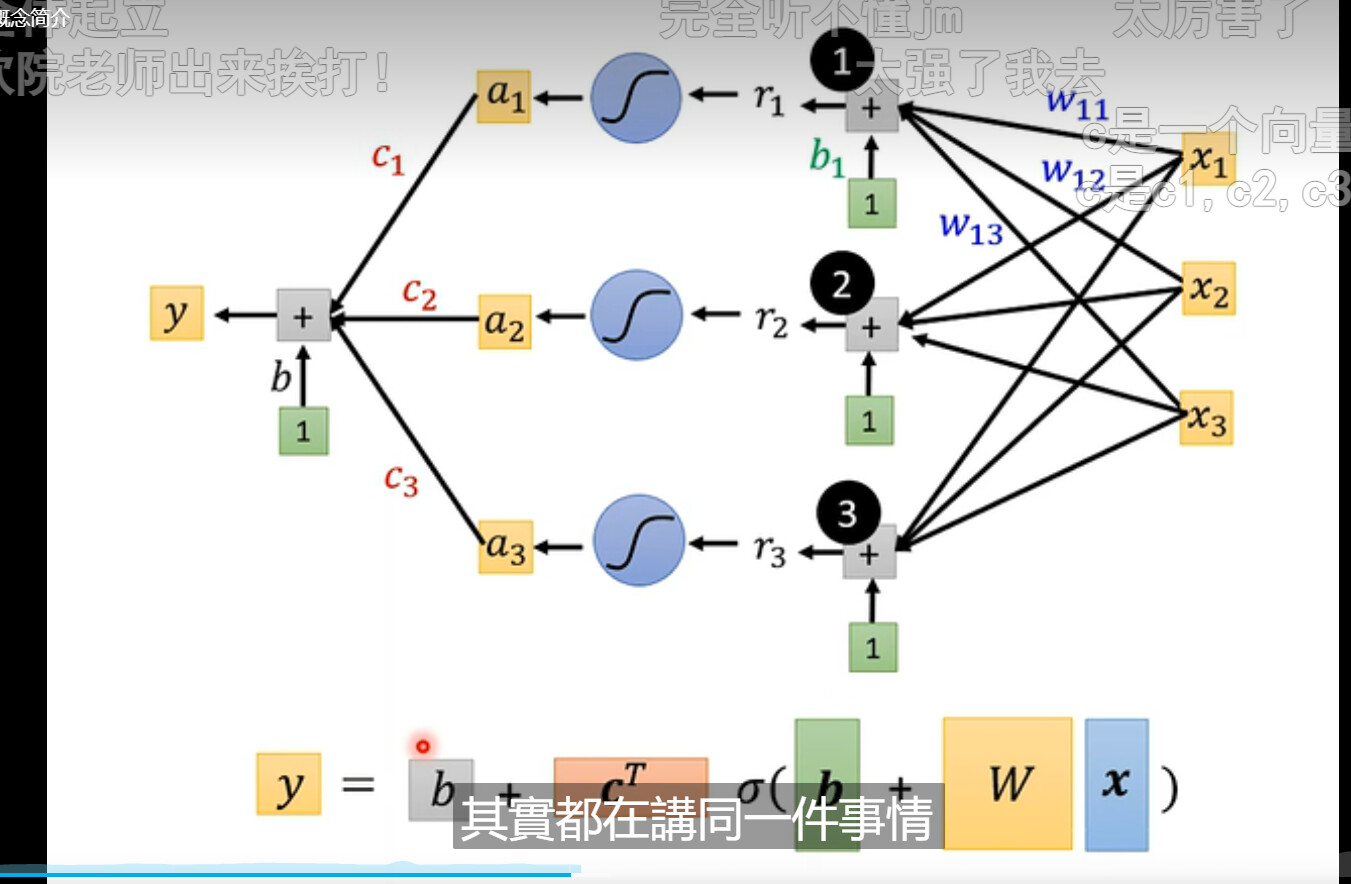

然后将我们想要的内容整理一下,就可以将上图灰框内的数字整合成下面图中的样子

最后整理一下就可以得到结果

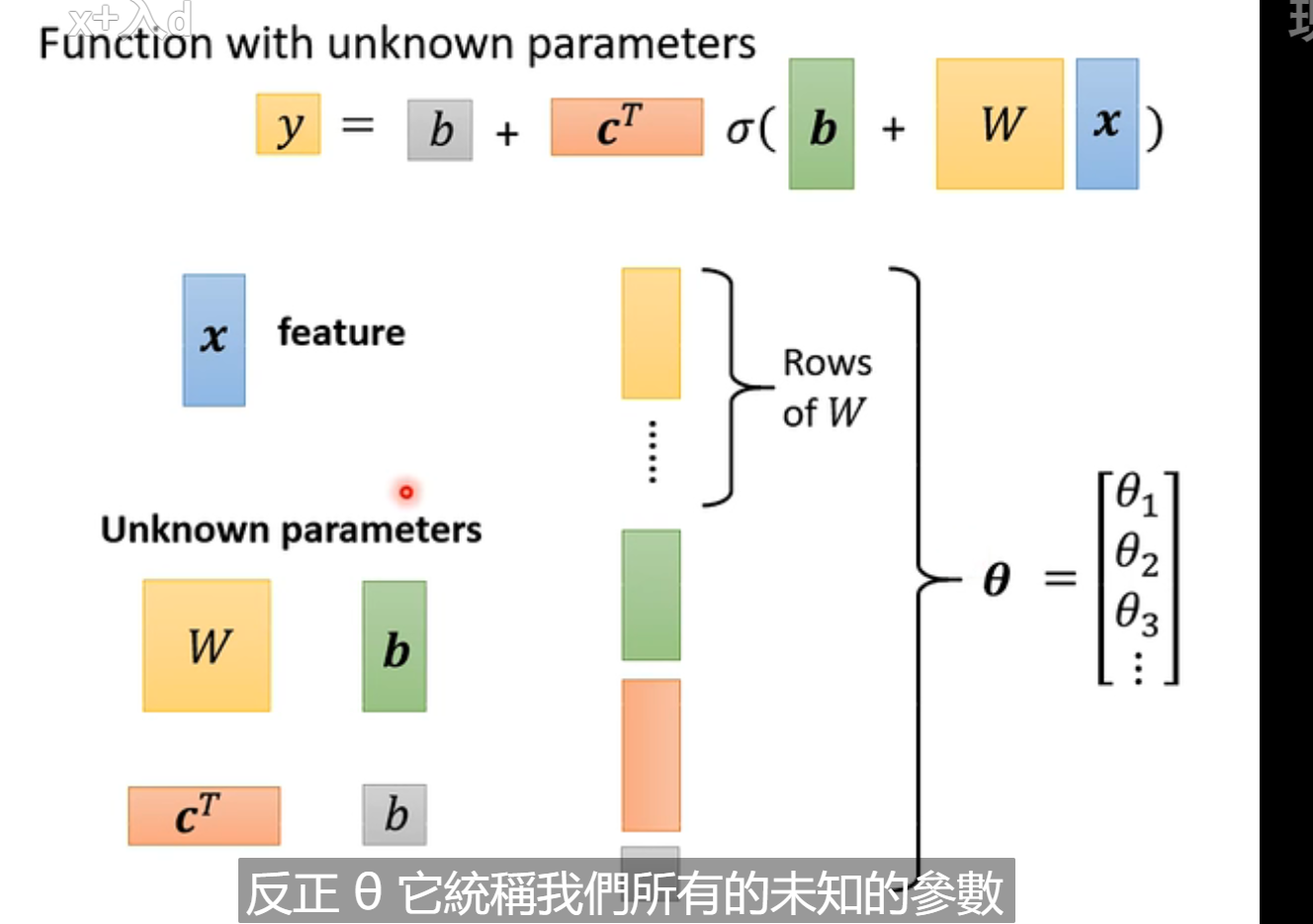

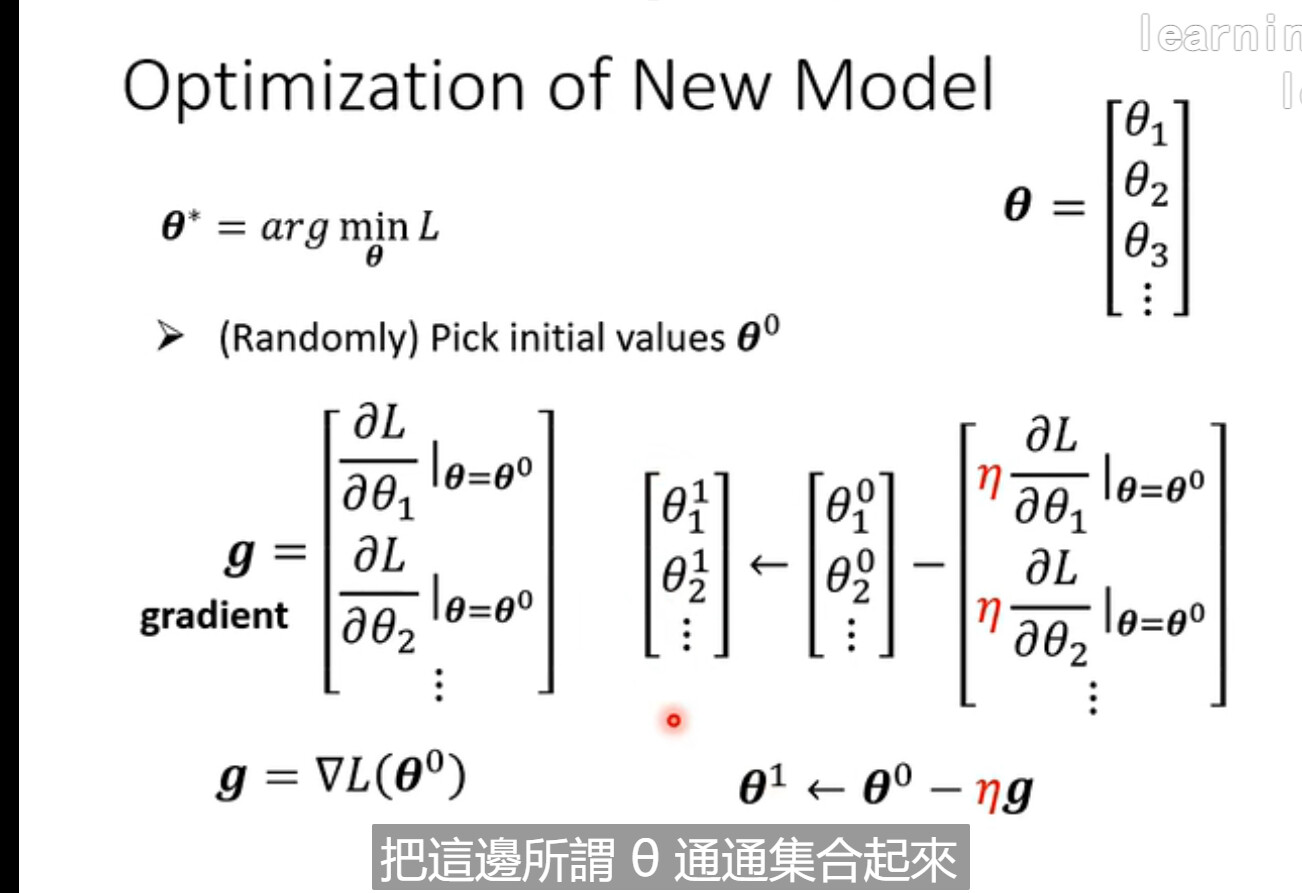

将所有的未知数放到一列

当参数很少的时候,可以使用暴力的方法,试出所有的未知数

sigmoid的函数越多的时候可以越逼近原来的函数图像

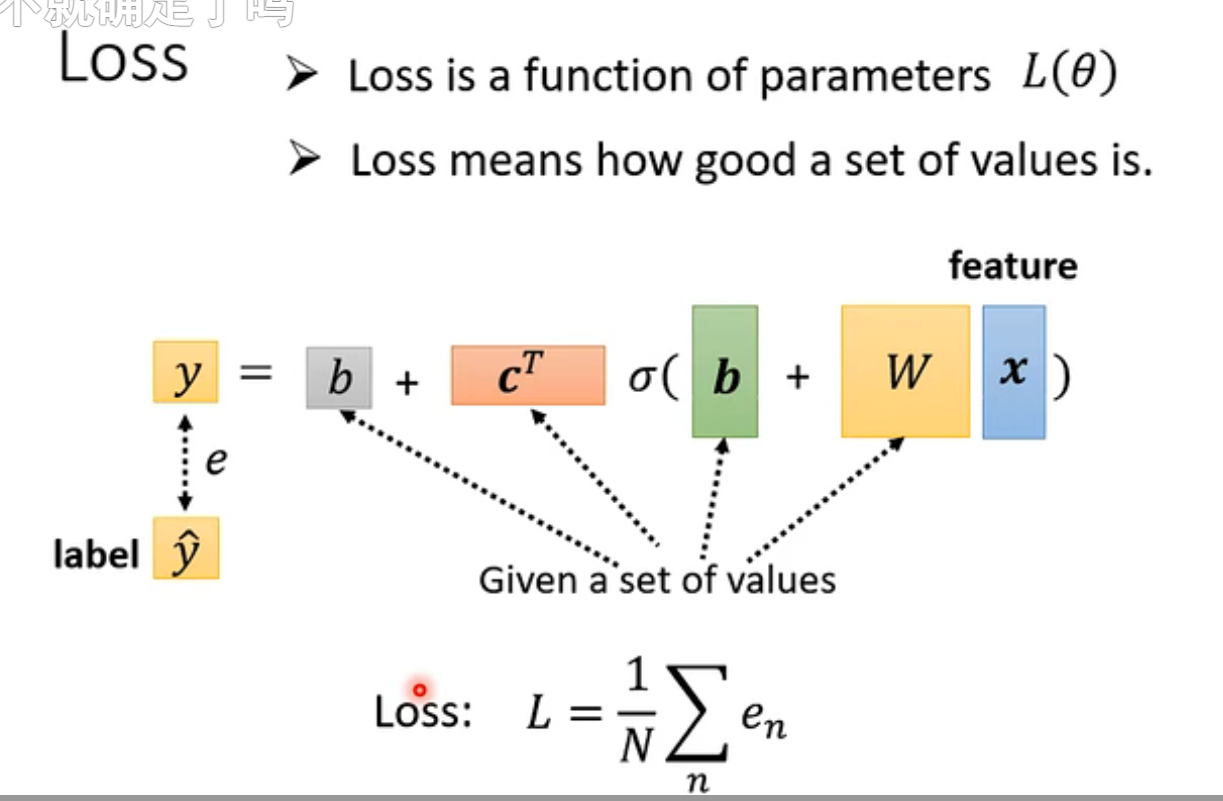

当尝试了几次后,得到一个预估的y,其差值可以得到一个LOSS函数

未知数拉长作为一个未知量的时候,成为一个向量,可以找出θ的start

然后要对每一个位置的参数进行求微分,集合起来就是一个向量

这里的g是梯度gradient

将θ0的向量减去学习率×微分值,得到新的θ1

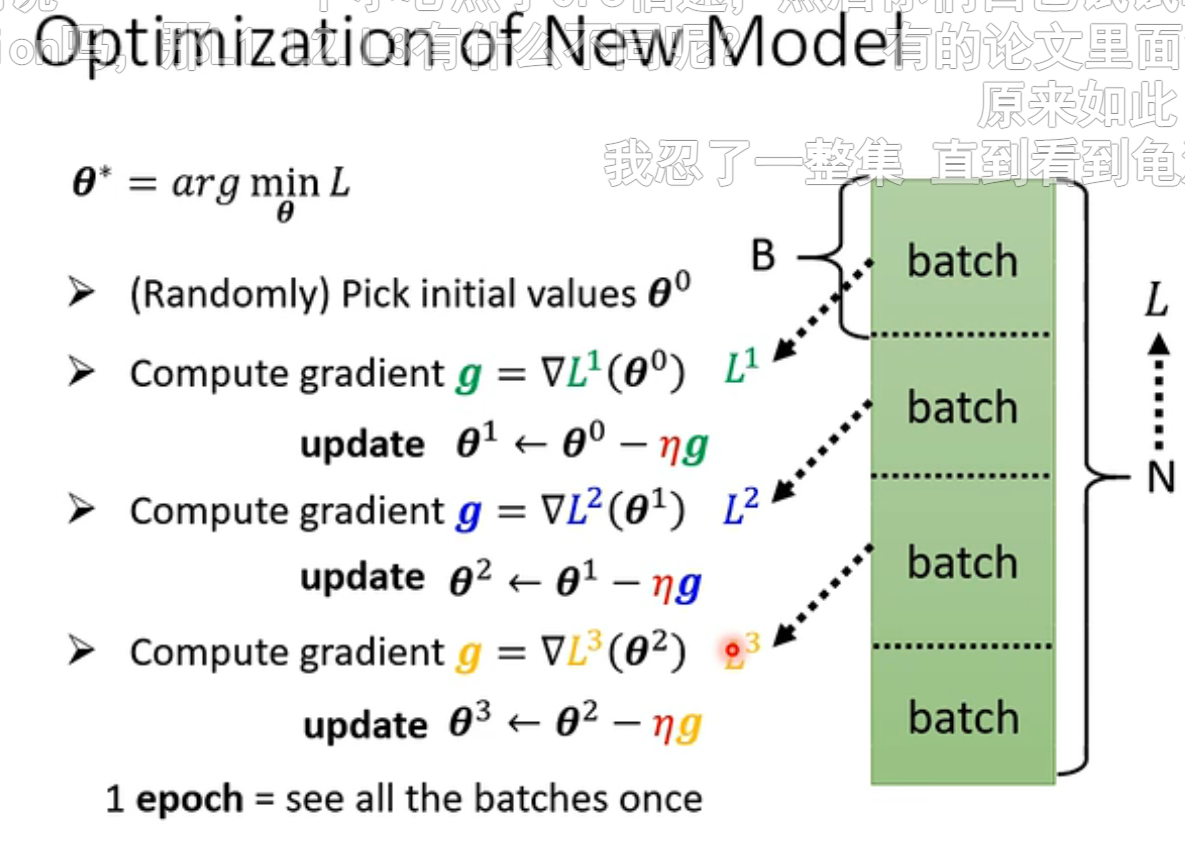

而在实际的机器学习中,并不会拿一个大L来计算梯度,而是将其拆分成多个Batch,分多次计算损失

每次更新一次参数叫做update,对每个batch变化也称为update

把所有的batch都看过一遍,叫做一个Epoch,可以有多次update,取决于batchSize有多大

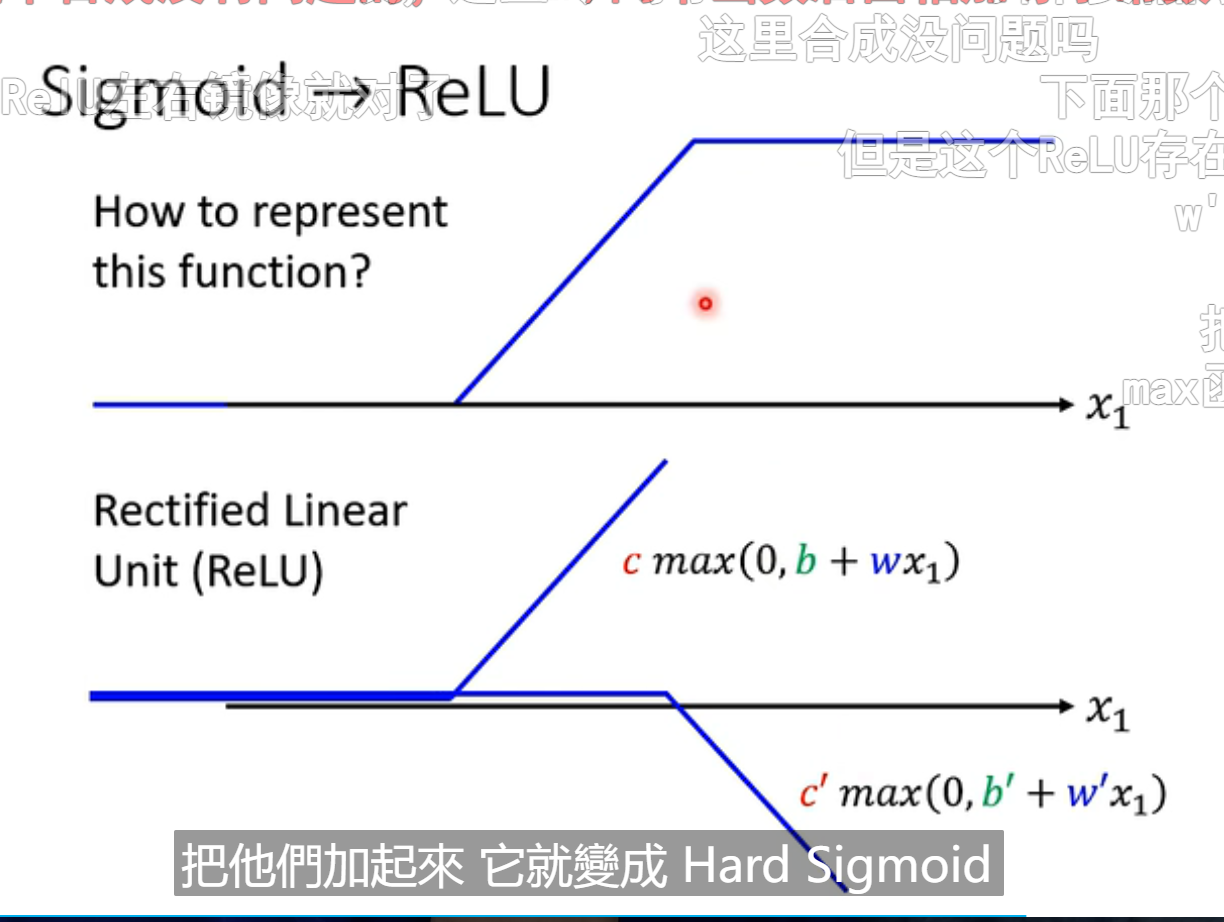

sigmoid比较难以计算,所以一个sigmoid可以看成是relu相加,第二个拐点后相加后位直线

relu是0与另一条直线的取大值得到的结果

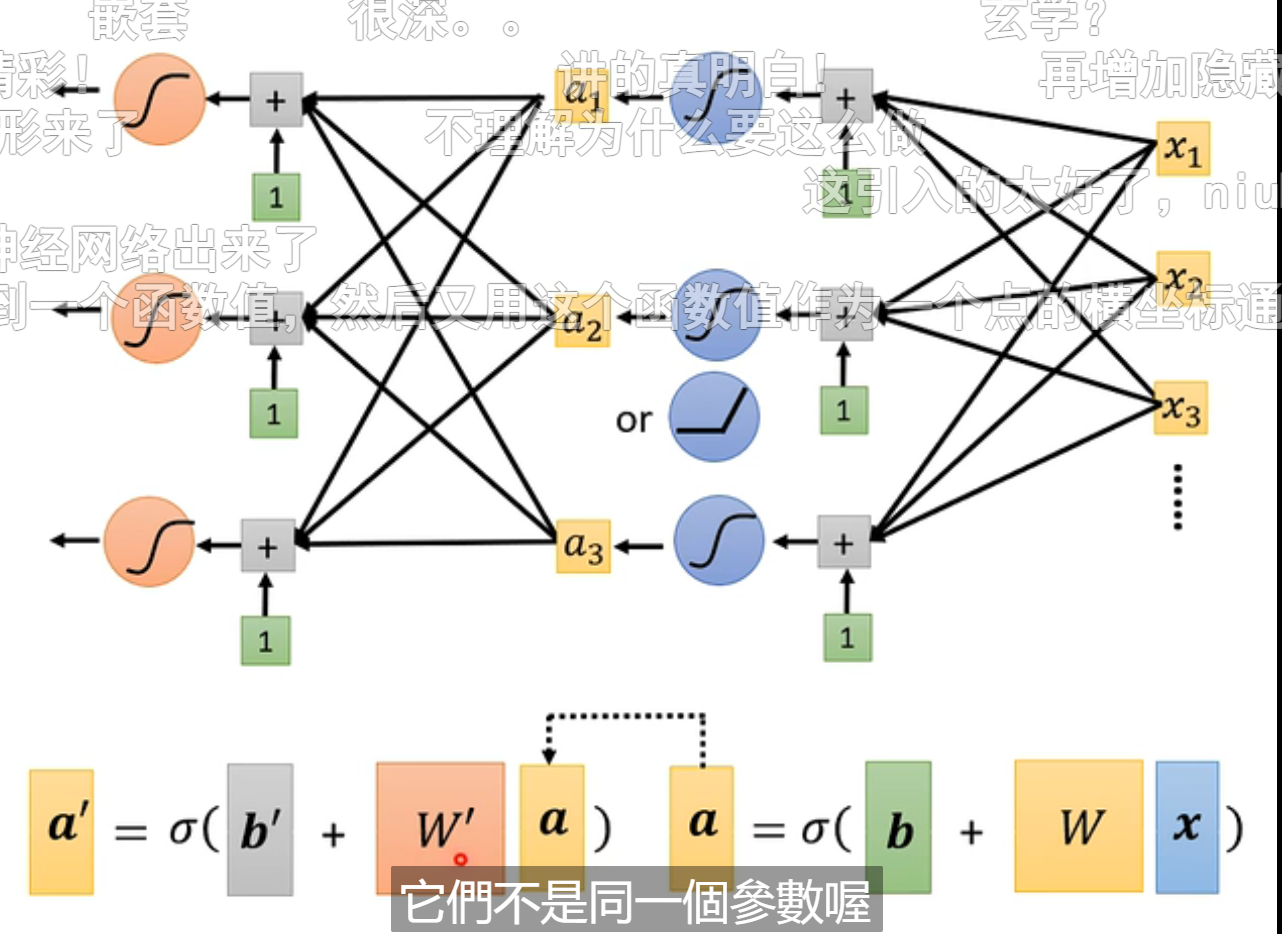

我们之前是只用了一层sigmoid来模拟原来的数据,我们可以将第一层的结果,放入下一个层数得到新的数据

其中的权重W‘和偏置b'是全新的未知数

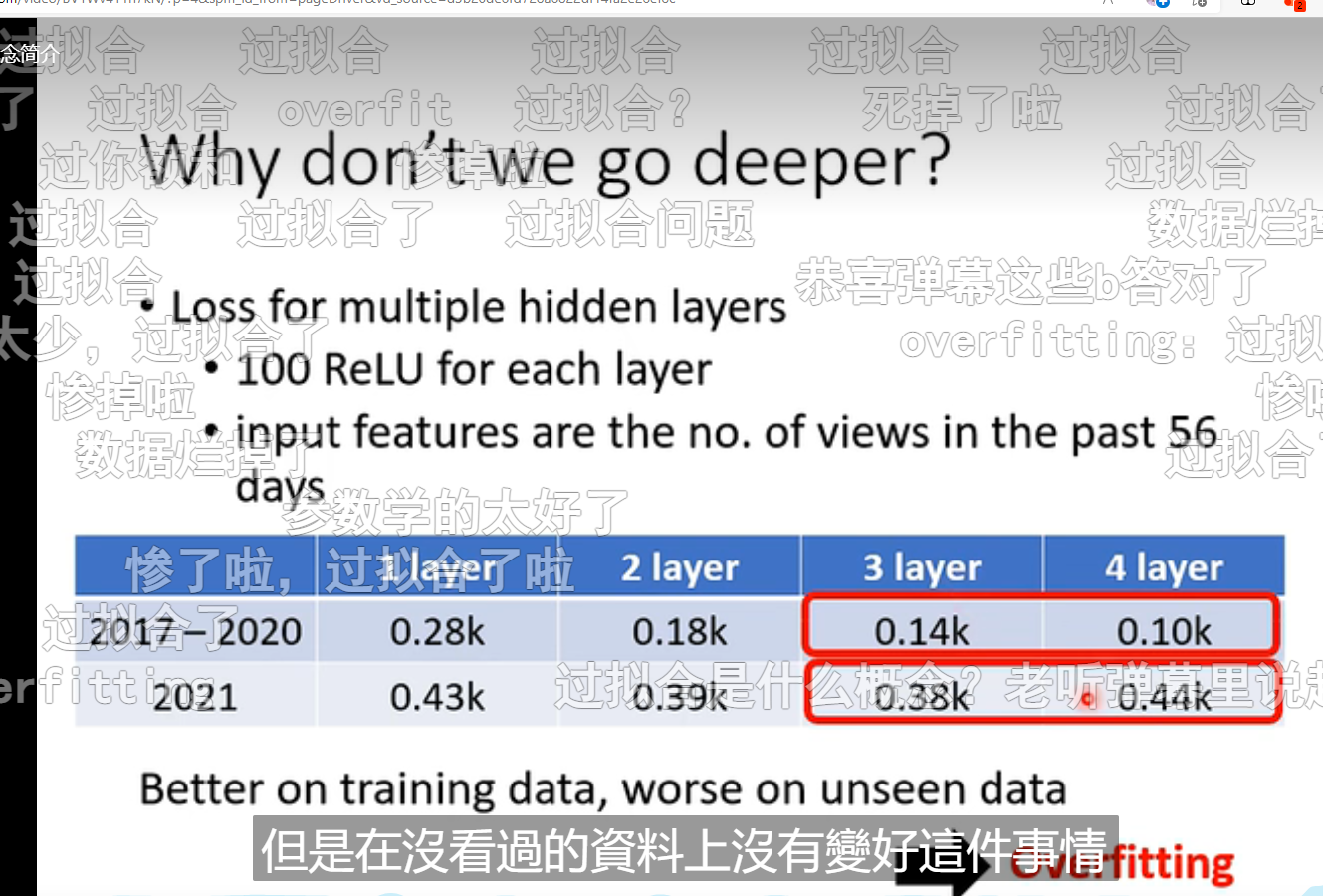

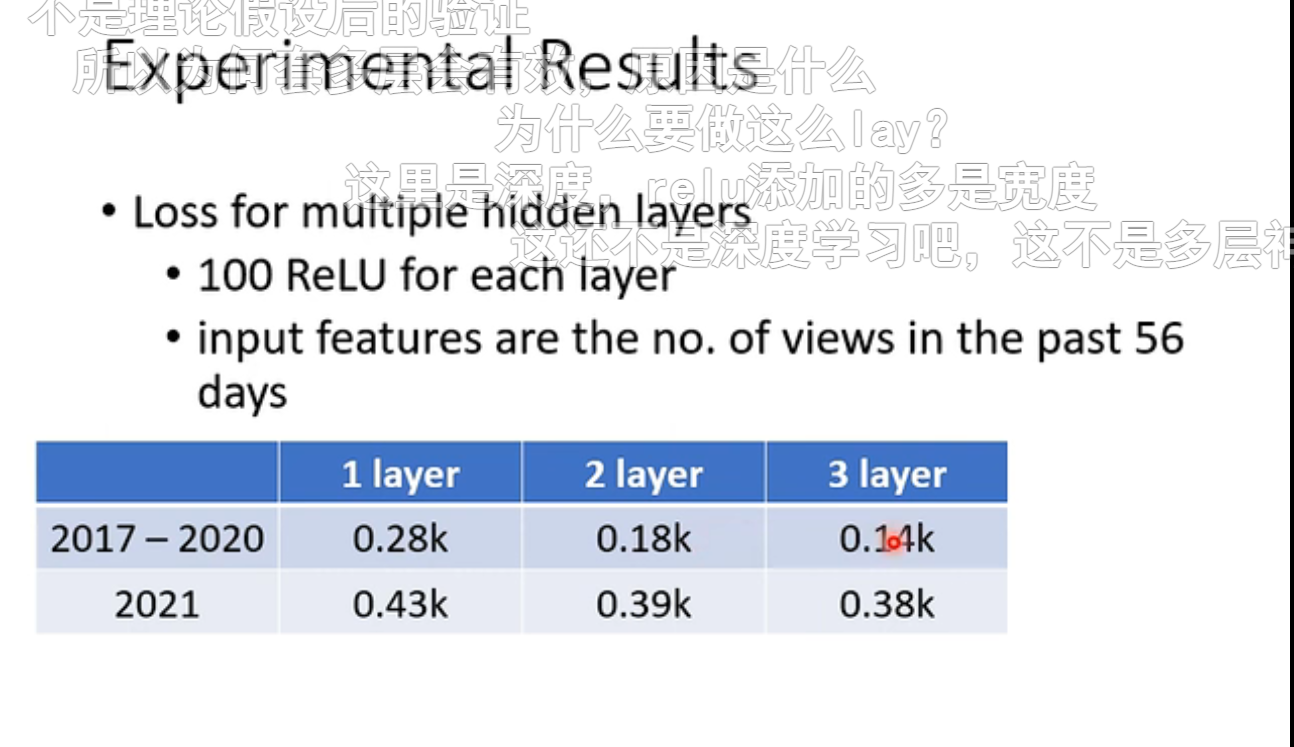

布置多层后,可以降低损失函数的数值

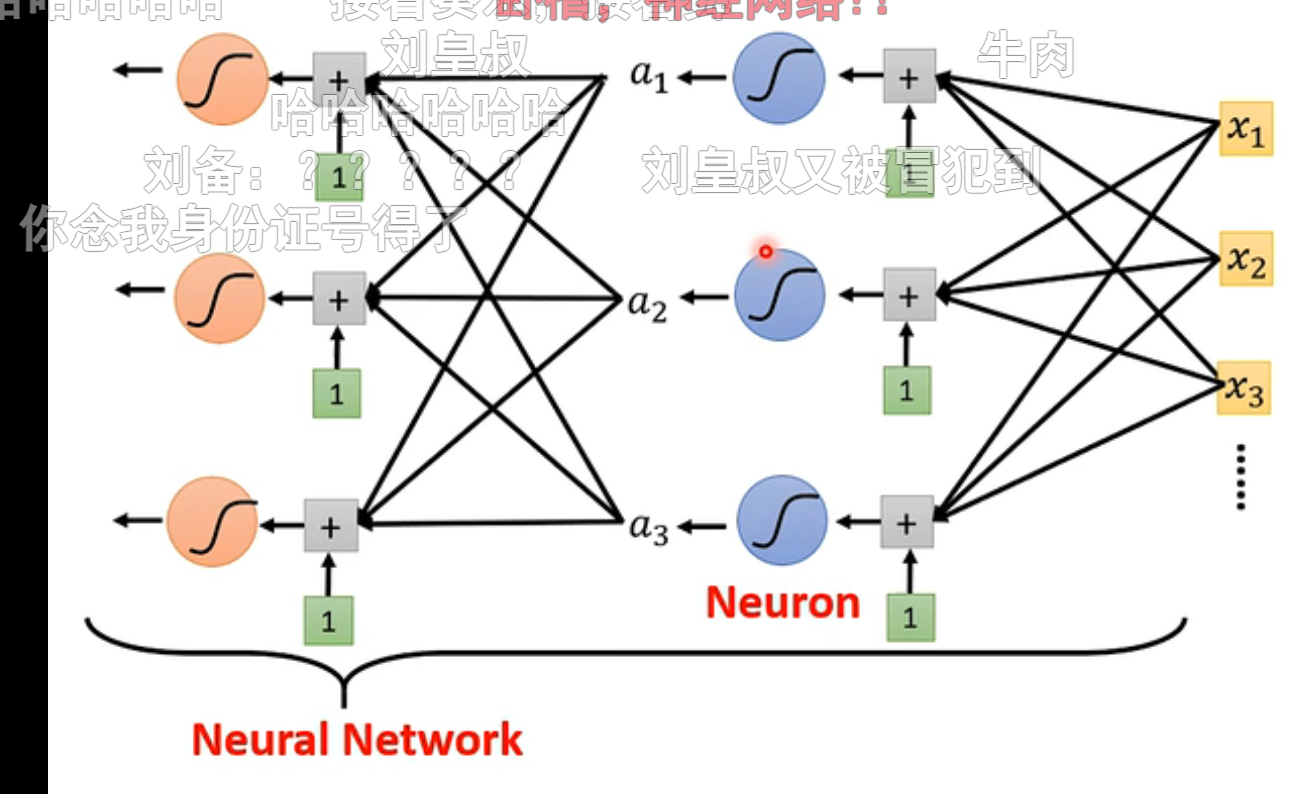

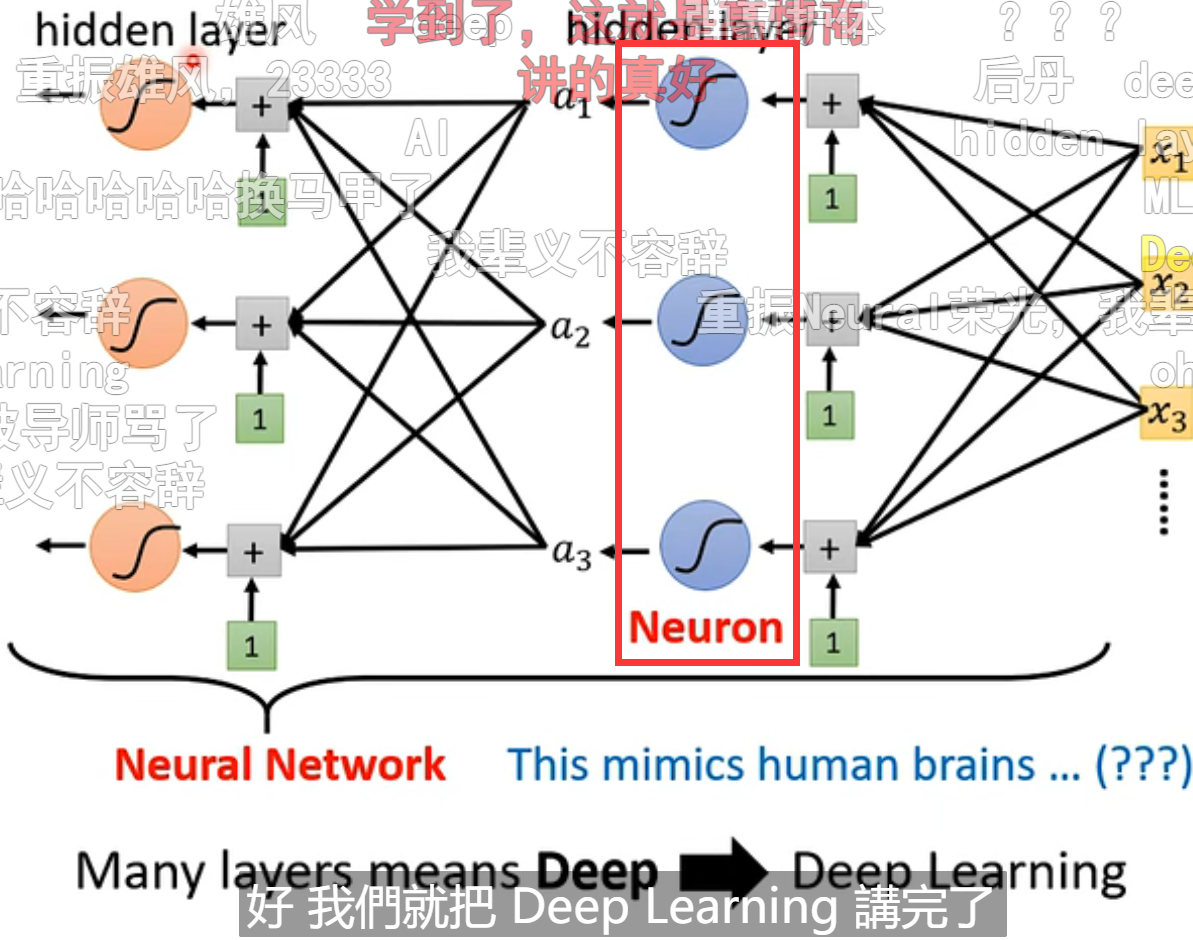

我们一般将这些sigmoid和relu称之为神经元,很多的neuron就是神经网络

其中每一层neuron被称之为layer,多层的layer被称为深度学习

过拟合overfitting指的是在增加层数的基础上,在已知的数据上获得更好的数据,而在未知的数据上得到更差的结果