【Spark】【RDD】从HDFS创建RDD

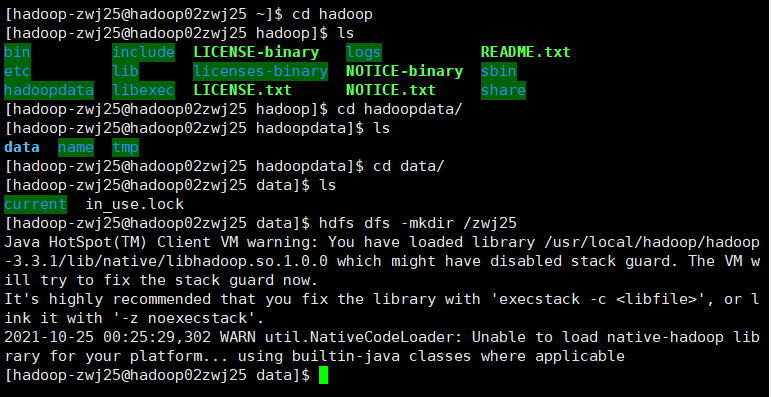

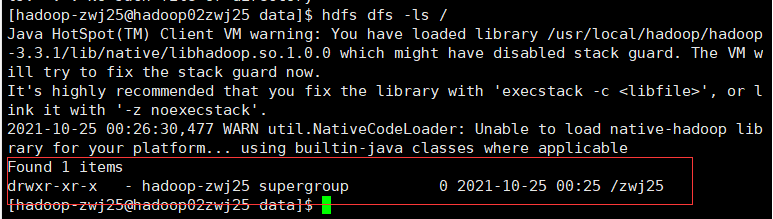

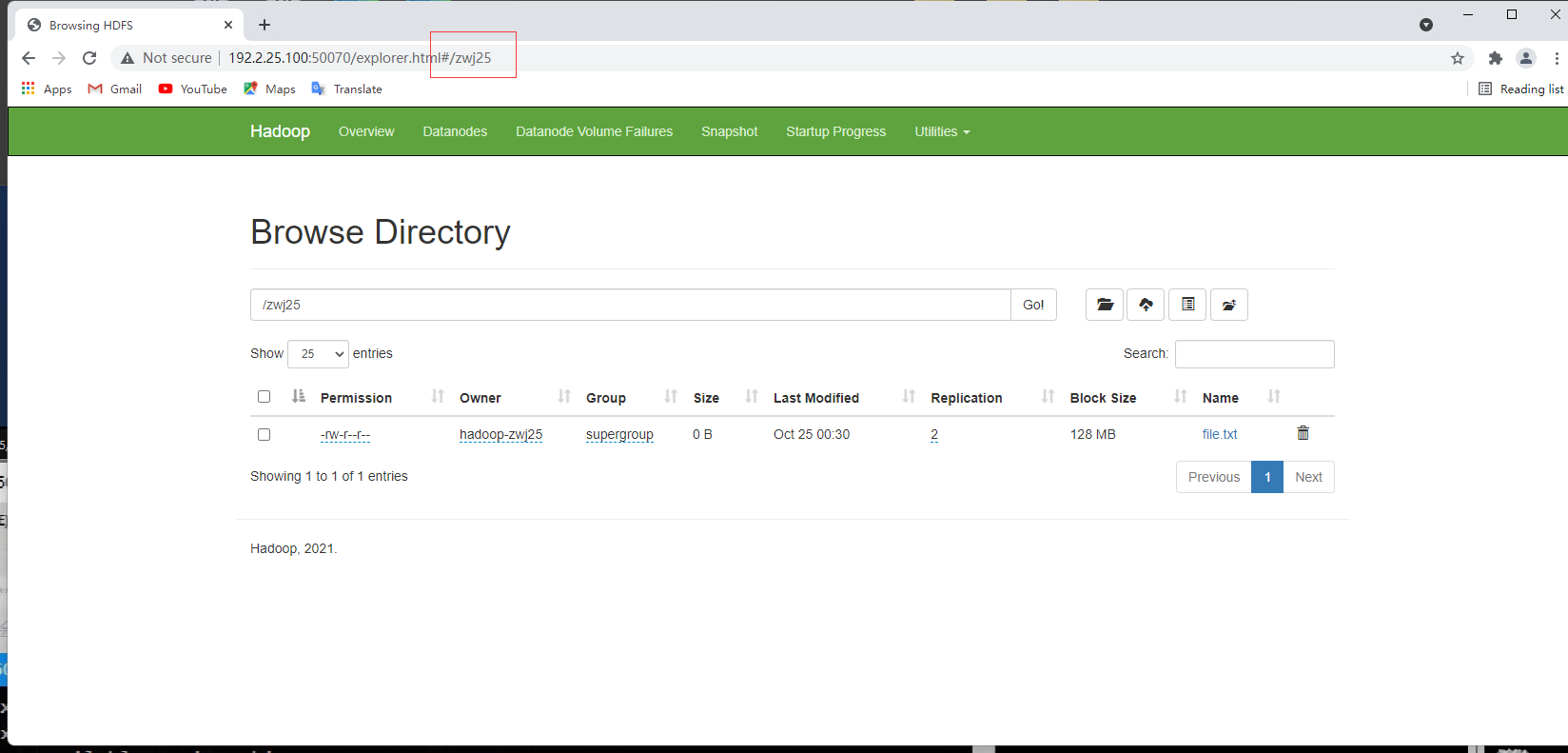

1.在HDFS根目录下创建目录(姓名学号)

hdfs dfs -mkdir /zwj25

hdfs dfs -ls /

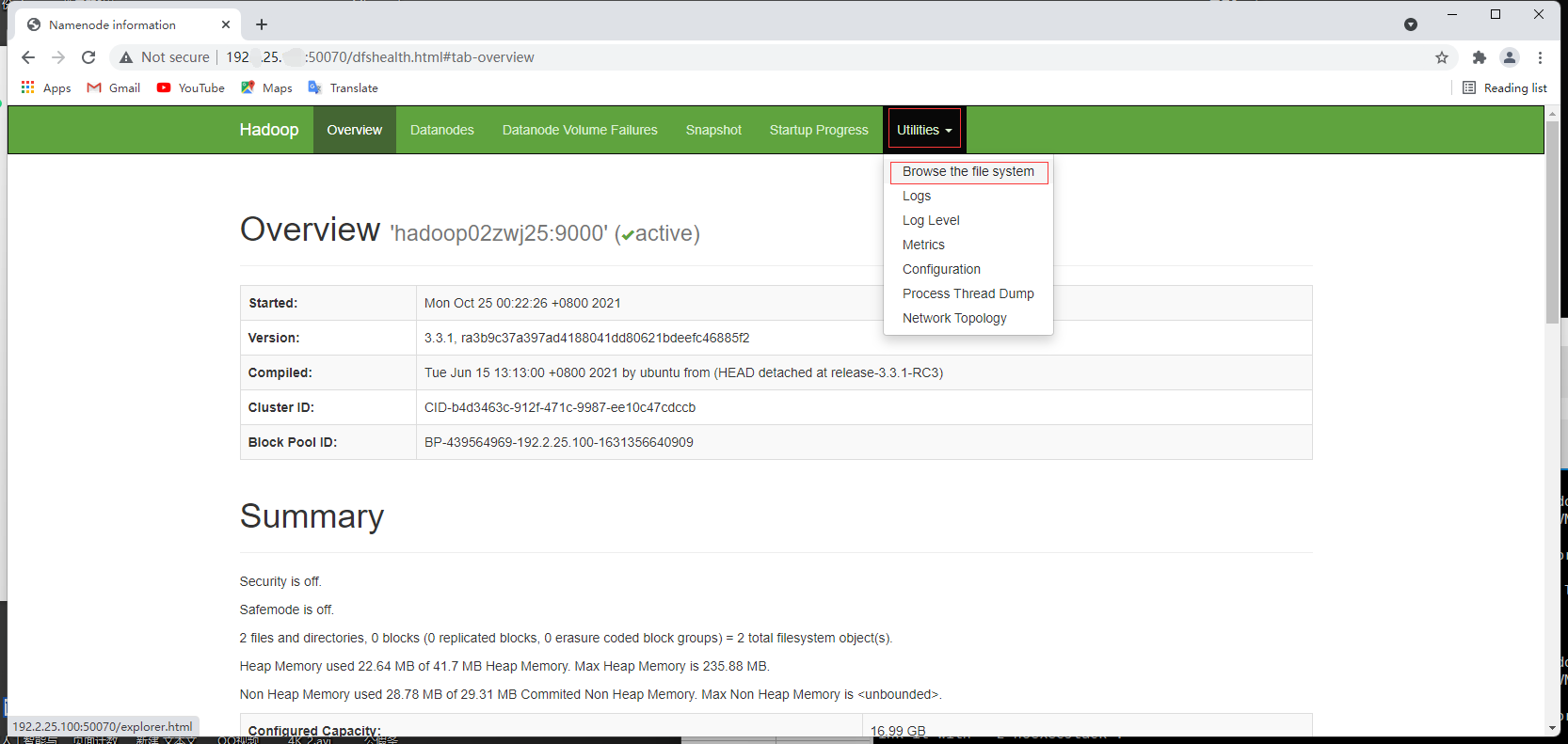

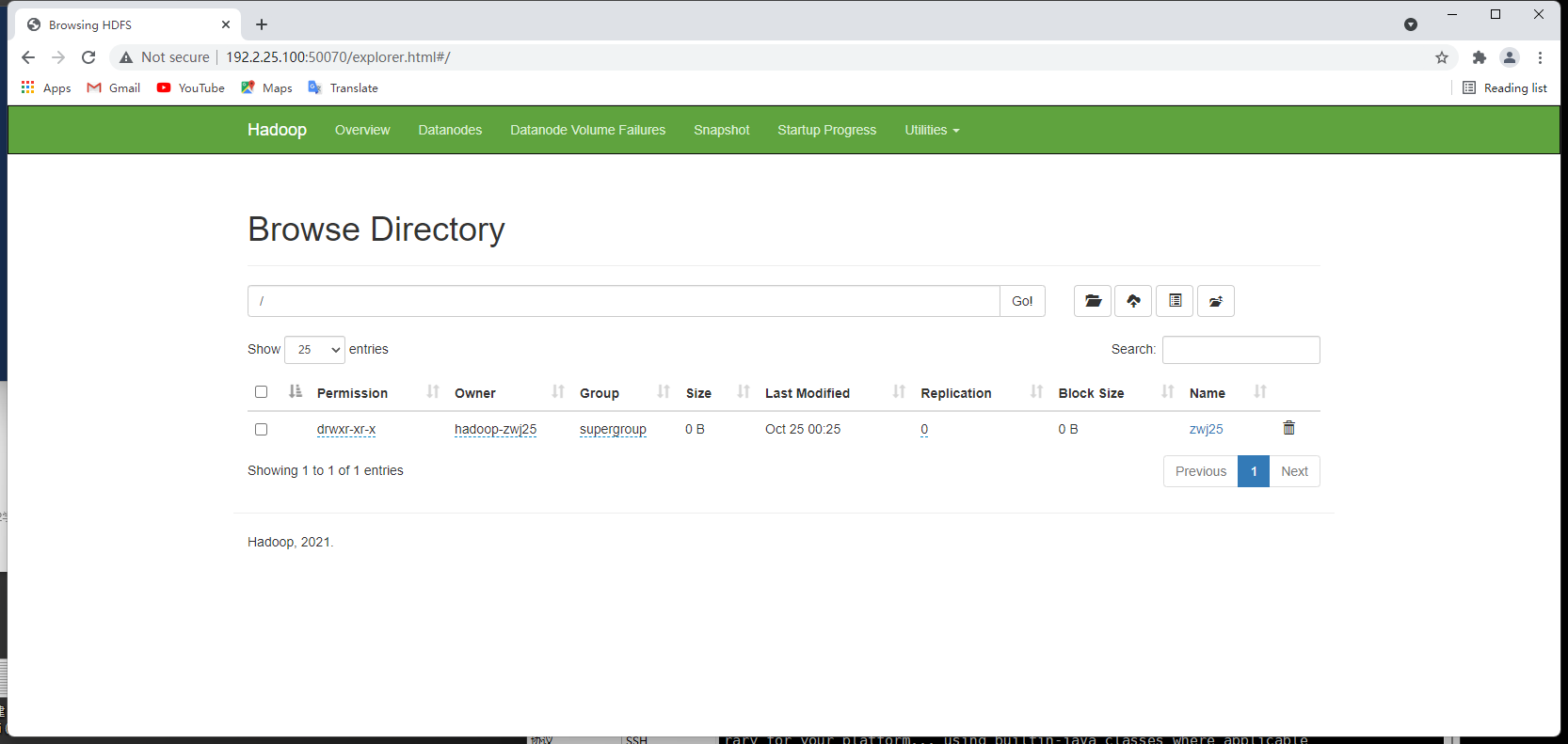

访问 http://[IP]:50070

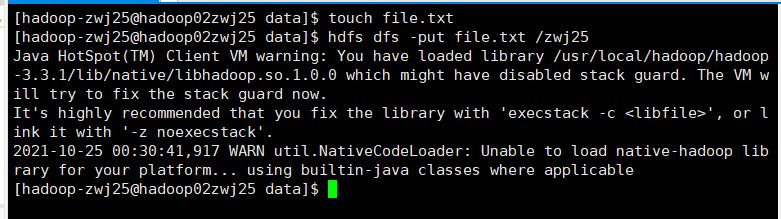

2.上传本地文件到HDFS

hdfs dfs -put file.txt /zwj25

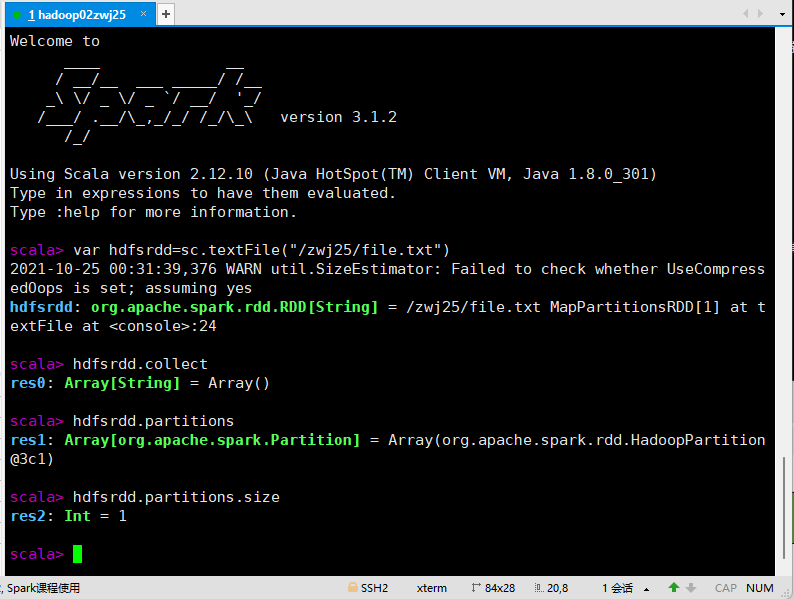

3.进入spark4-shell

var hdfsrdd=sc.textFile("/zwj25/file.txt")

hdfsrdd.collect

hdfsrdd.partitions

hdfsrdd.partitions.size

sc.defaultMinPartitions=min(sc.defaultParallelism,2)

rdd分区数=max(hdfs文件的block数目,sc.defaultMinPartitions)

版 权 声 明

作者:萌狼蓝天

QQ:3447902411(仅限技术交流,添加请说明方向)

转载请注明原文链接:https://www.cnblogs.com/mllt/p/spark_rdd_useHDFScreateRDD.html