Machine Learning - Regression - Week2

linear regression with multiple features

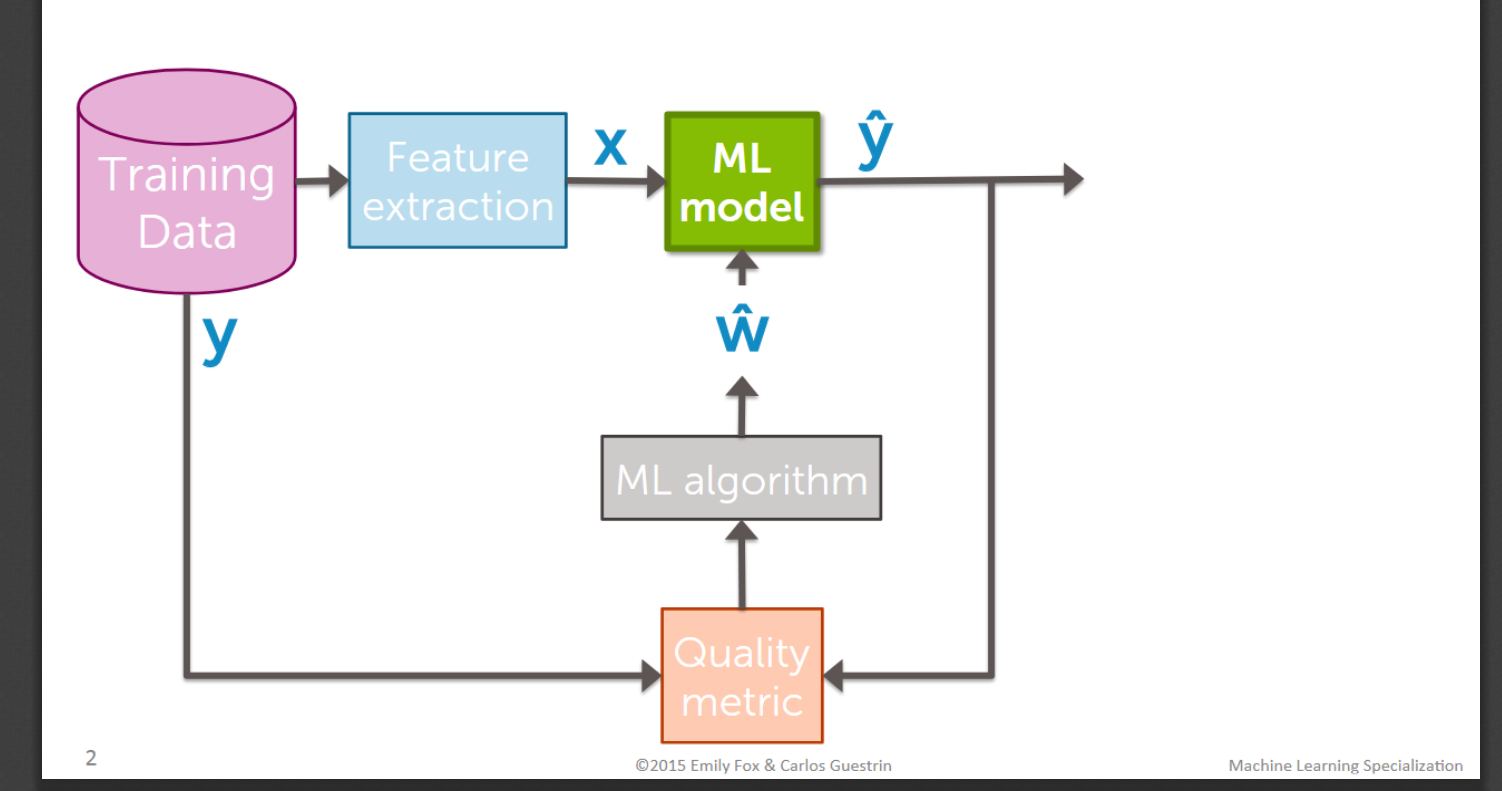

the basic progress for this type of ML problem

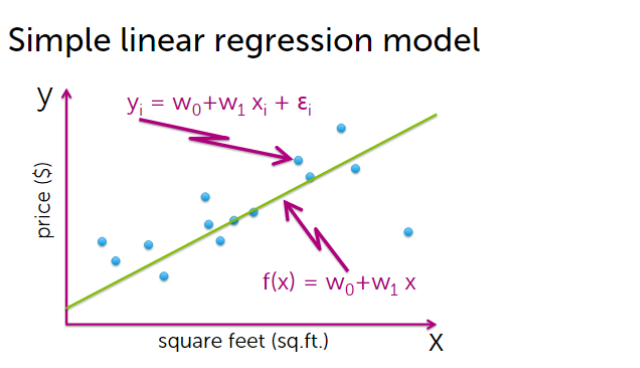

1. Let’s look at the simple linear regression model ahead.

简单的线性回归是一个因变量一个自变量,由于一个变量很难解释一个特征的全部信息,所以我们往往需要考虑多个特征。

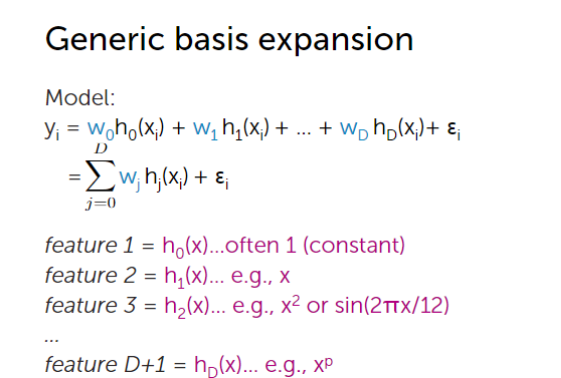

首先我们来看看多项式回归

2.Polynomial regression

y

i

=

w

0

+

w

1

x

i

+

w

2

x

i

2

+

.

.

.

+

w

p

x

i

p

+

ϵ

i

y_i = w_0 + w_1x_i+w_2x_i^2+...+w_px_i^p+\epsilon_i

yi=w0+w1xi+w2xi2+...+wpxip+ϵi

我们可以将每个多项式看做一个特征,通常第一个特征默认为1.如下图

更为一般的,我们可以将每个特征看做一个原始特征的函数

接下来我们来具体看看多元回归相关的一些概念与方法

3.Multiple regression

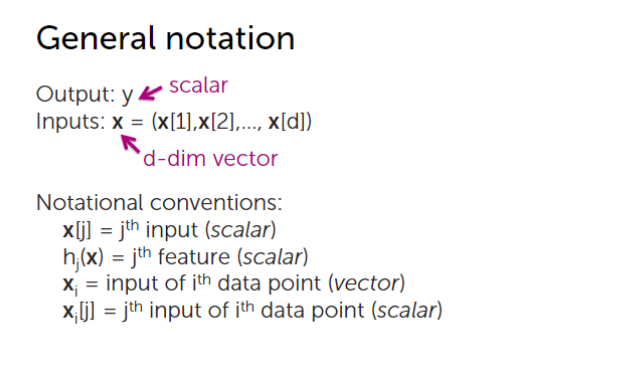

3.1General notation

x

[

j

]

x[j]

x[j] :表示第j个特征

x

i

x_i

xi :表示第i个样本

3.2Interpreting the fitted function

当我们对变量进行解释时,我们选择其中一个变量,固定所有其他的变量,则该变量的系数表示每增加一单位该变量,y的改变。

注意:当为多项式回归时,我们无法固定其他变量不变,也就无法解释其系数。

3.3Fit D-dimensional curves

-

step1: Rewrite the regression model

y i = w j h j ( x i ) + ϵ i y_i = w_jh_j(x_i) + \epsilon_i yi=wjhj(xi)+ϵi

-

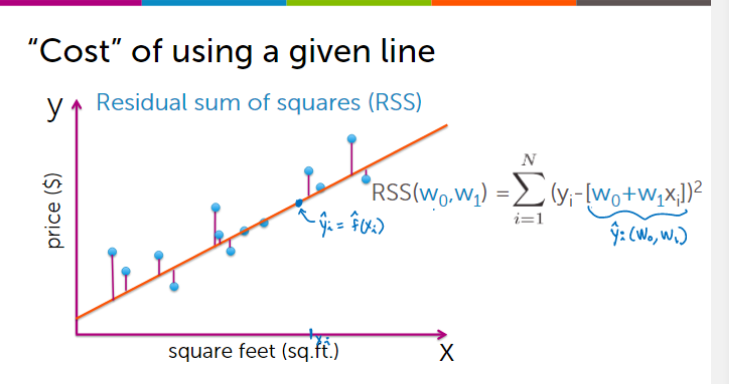

step2:Compute the cost

![在这里插入图片描述]()

-

step3:计算梯度

Step4:求解方法

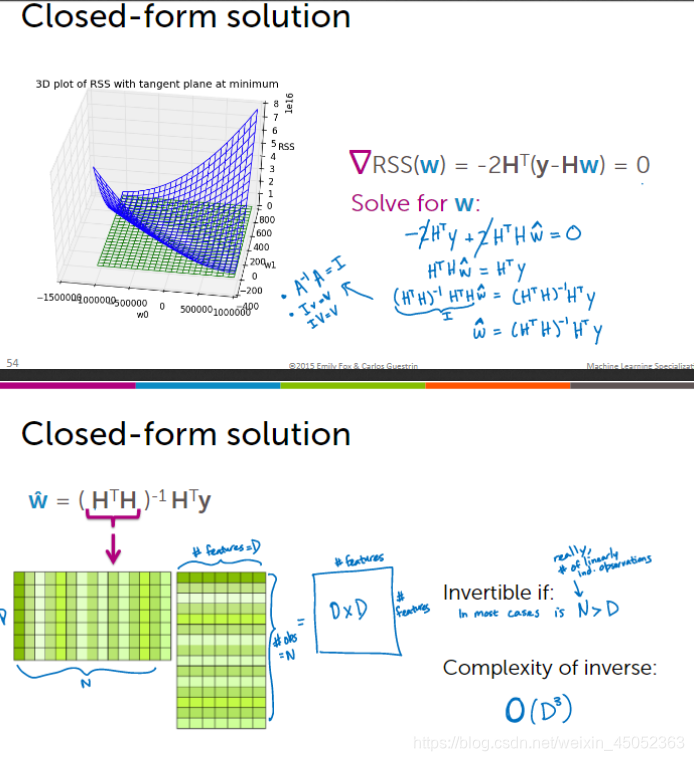

方法一:闭式解法(也就是解析解法)(closed-form solution)

这种方法是求的解析解,可以求出一个具体的表达式,可以通过带入具体数值来进行获得

求解思路:让梯度等于0

这种方法求解需要注意两个问题:

- 是否可逆

- 求解复杂度:

求逆的复杂度为 O ( D 3 ) O(D^3) O(D3)

求矩阵的复杂度为 O ( N D 2 ) O(ND^2) O(ND2)

例如一个m×n的矩阵与一个n×s的矩阵相乘,则复杂度为m×n×s

方法二:梯度下降法(Gradient descent)

这种方法求的是一个数值近似解,即需要具体的数据来计算

基本思路:不断同梯度下降最快的方向进行,知道收敛(一般到

1

0

−

3

10^-3

10−3)

注意:

当多个特征时,我们要同时更新所有的特征

浙公网安备 33010602011771号

浙公网安备 33010602011771号