初始化ha环境下的hadoop的hdfs

1)启动zookeeper

2)启动所有的journalnode

[hadoop@datanode1 ~]$ ~/hadoop-2.7.3/sbin/hadoop-daemon.sh start journalnode

3)主节点执行初始化操作namenode1

~/hadoop-2.7.3/bin/hdfs namenode -format

报错:https://blog.csdn.net/humanmonkey/article/details/50543342

org.apache.hadoop.hdfs.qjournal.client.QuorumException

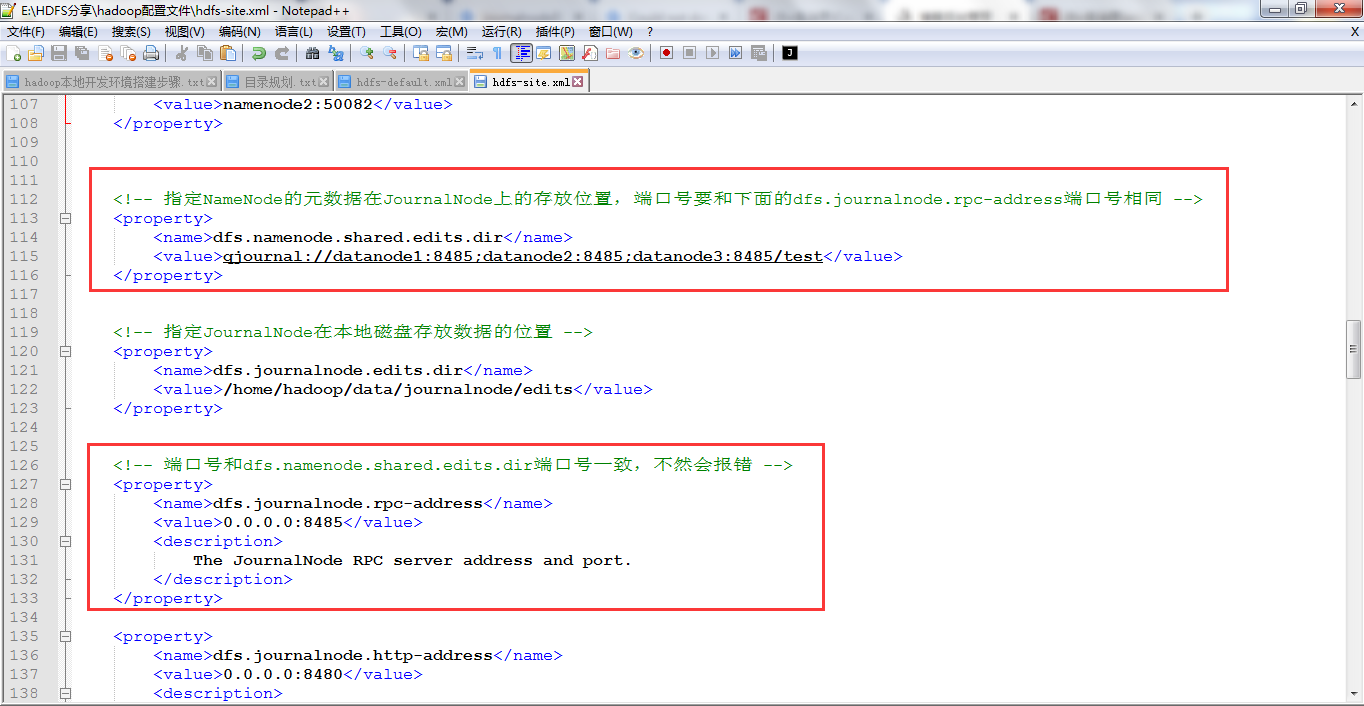

报错原因是dfs.namenode.shared.edits.dir和dfs.journalnode.rpc-address端口不一致,一开始我

dfs.namenode.shared.edits.dir端口是8488,dfs.journalnode.rpc-address端口是8485,两者都改成一致后,重新格式化namenode,报错消失。

4)向zookeeper注册znode

~/hadoop-2.7.3/bin/hdfs zkfc -formatZK

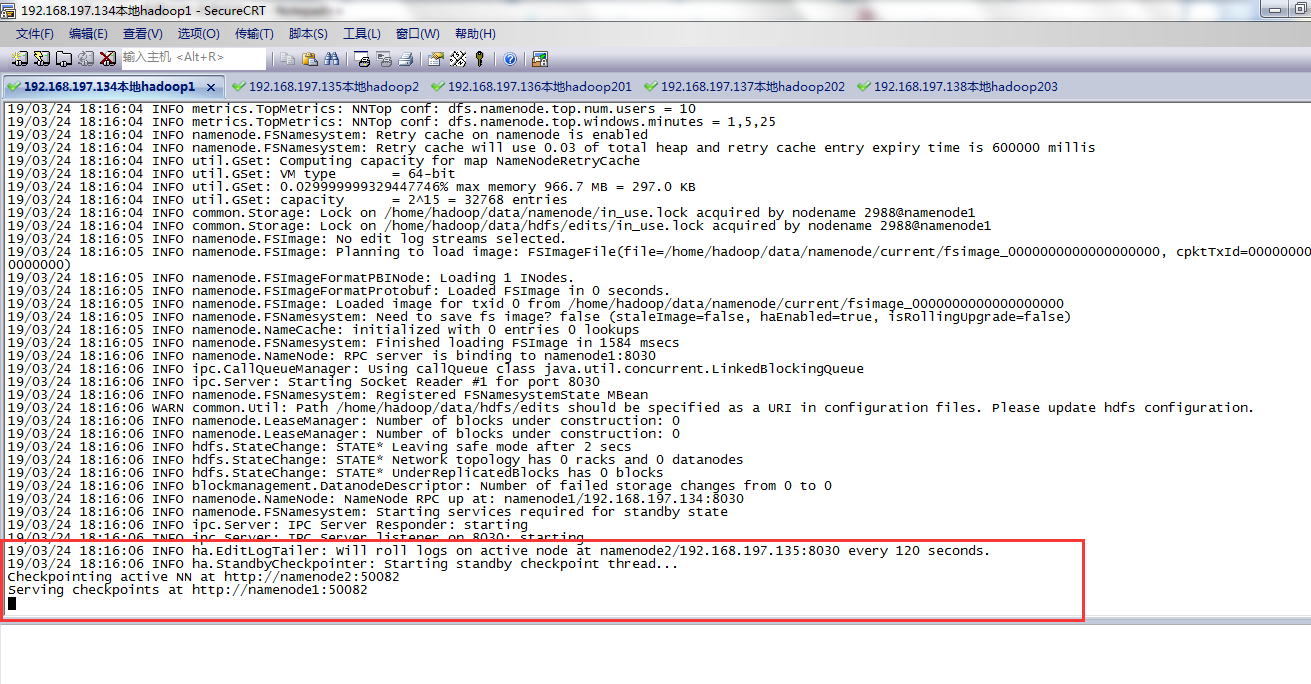

5)初始化active namenode

~/hadoop-2.7.3/bin/hdfs namenode

执行后,线程会进入等待状态,等待standby namenode进行初始化:

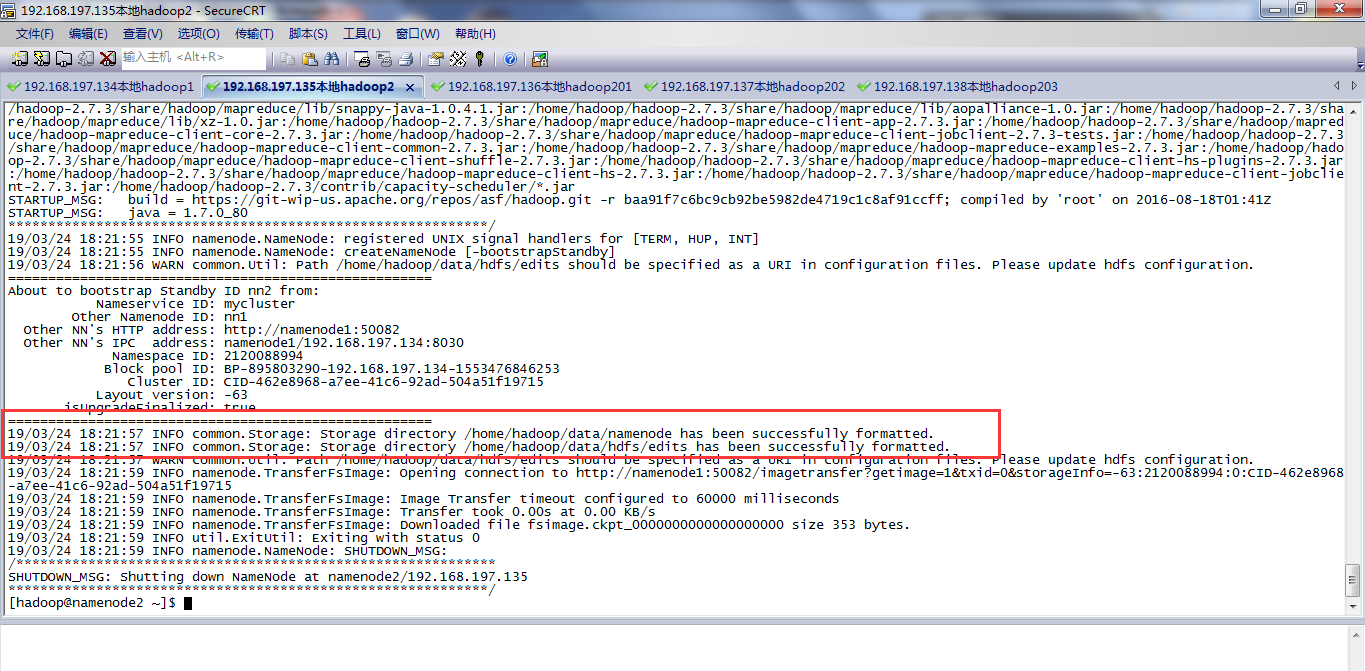

6)备份节点同步数据namenode2,standby namenode

~/hadoop-2.7.3/bin/hdfs namenode -bootstrapStandby

如何查看stanby namenode时候同步完active namenode的初始化状态?

7)停止hdfs(到这里就已经初始化完成)

在master按下ctrl+c结束active namenode

在各个节点停掉journalnode

~/hadoop-2.7.3/sbin/hadoop-daemon.sh stop journalnode