[NLP]分词模型、创建词库

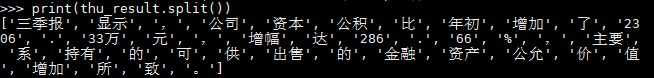

金融领域的专有名词较多,使用通用的分词工具的话效果很不好,我使用了4个分词工具:lac,pkuseg,thulac,jieba,针对分词效果来说,thulac能考虑到金融名词,但是在数字的切词上很奇怪,其余三个则是完全不考虑金融名词,具体过程如下:

原句:三季报显示,公司资本公积比年初增加了2306.33万元,增幅达286.66%,主要系持有的可供出售的金融资产公允价值增加所致。

(1)lac

(2)jieba

(3)thulac

(4)pkuseg

没办法,只能自己训练分词模型或者使用金融词典。

解决办法如下:

1、 jieba+金融词典:如果公司金融词典那是最好了,但如果没有的话就需要自己去做词典。

做词典的方法:

(1)新词发现(或者无监督构建词库):

https://kexue.fm/archives/6920

http://www.matrix67.com/blog/archives/5044

(2)手动构建词典:首先构建搜狗输入法的金融词库;词典构建成功后,可以使用关联词扩展等方法进行词汇扩充。

注:搜狗scel转换为txt方法:

https://blog.csdn.net/qq_37788558/article/details/78716794#

2、 pkuseg,jieba,thulac等训练自己的分词模型,但由于缺少原始数据,因此该方法不易做。

浙公网安备 33010602011771号

浙公网安备 33010602011771号