函数

1.3.3 tanh函数

𝑓(𝑥)=tanh(𝑥)=21+𝑒−2𝑥−1=2sigmoid(2𝑥)−1tanh𝑥=𝑒𝑥−𝑒−𝑥𝑒𝑥+𝑒−𝑥f(x)=tanh(x)=21+e−2x−1=2sigmoid(2x)−1tanhx=ex−e−xex+e−x

这个tanh函数又被称作双曲正切函数,可以看出它的函数范围是(-1,1)而均值为0。

缺点:该函数依旧没有解决梯度消失和幂运算的问题。

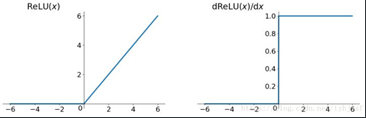

1.3.4 ReLu函数

ReLu函数是当前最常用的一个激活函数,尤其是在卷积神经网络和层次较深的神经网络中。

Relu =max(0,𝑥) Relu =max(0,x)

优点:

- 解决了gradient vanishing问题 (在正区间),因为大于0的梯度始终为1

- 计算速度非常快,只需要判断输入是否大于0,不含数学运算

- 收敛速度远快于 sigmoid 和 tanh

缺点:对于小于0的这部分值,梯度会迅速降为0而不再影响网络训练。这会造成部分神经元从来不被激活,也称作“死区”。

【推荐】国内首个AI IDE,深度理解中文开发场景,立即下载体验Trae

【推荐】编程新体验,更懂你的AI,立即体验豆包MarsCode编程助手

【推荐】抖音旗下AI助手豆包,你的智能百科全书,全免费不限次数

【推荐】轻量又高性能的 SSH 工具 IShell:AI 加持,快人一步

· AI与.NET技术实操系列:基于图像分类模型对图像进行分类

· go语言实现终端里的倒计时

· 如何编写易于单元测试的代码

· 10年+ .NET Coder 心语,封装的思维:从隐藏、稳定开始理解其本质意义

· .NET Core 中如何实现缓存的预热?

· 25岁的心里话

· 闲置电脑爆改个人服务器(超详细) #公网映射 #Vmware虚拟网络编辑器

· 基于 Docker 搭建 FRP 内网穿透开源项目(很简单哒)

· 零经验选手,Compose 一天开发一款小游戏!

· 一起来玩mcp_server_sqlite,让AI帮你做增删改查!!