浏览器自动化与AI Agent结合项目browser-use初探

1.与LLMs进行在IDE中直接、无需提示的交互是工具构建者探索的一个有希望的未来方向2.将爬虫与大语言模型结合3.AvaloniaChat:一个基于大语言模型用于翻译的简单应用4.最佳实践:在AvaloniaChat中接入SiliconCloud5.AvaloniaChat—从源码构建指南6.SimpleRAG:基于WPF与Semantic Kernel实现的一个简单的RAG应用7.Semantic Kernel/C#:接入智谱AI的两种方式8.AvaloniaChat-v0.0.2:兼容智谱AI 快速使用指南9.使用SiliconCloud快速体验SimpleRAG(手把手教程)10.使用Ollama本地离线体验SimpleRAG(手把手教程)11.在NextChat中接入SiliconCloud API 体验不同的开源先进大语言模型12.AI Agents有哪些风险?哪些措施可以减少风险?13.来自OpenAI官网的Function calling介绍与最佳实践14.在LobeChat中使用SiliconCloud,一键拥有你自己的 ChatGPT/Gemini/Claude/Ollama 应用15.Semantic Kernel/C#:一种通用的Function Calling方法,文末附经测试可用的大模型16.在SimpleRAG中使用SiliconCloud快速测试Function Calling17.SimpleTranslationAIAgent:基于C#与LLM的翻译AI Agent18.SimpleTranslationAIAgent借助SiliconCloud API 构建自己的专属翻译助手19.SimpleAISearch:C# + DuckDuckGo 实现简单的AI搜索20.SimpleAIAgent:使用免费的glm-4-flash即可开始构建简单的AI Agent应用21.SimpleRAG-v1.0.3:增加文件对话功能22.如何自己动手实现一个图片解答小助手23.Microsoft.Extensions.AI 初探24.AI工具推荐——Cherry Studio25.AI提效工具推荐——Sider26.VLM-OCR-Demo:一个使用VLM用于OCR任务的示例27.使用C#构建一个论文总结AI Agent28.PaperAssistant:使用Microsoft.Extensions.AI实现29.C# AIModelRouter:使用不同的AI模型完成不同的任务30.AutoGen入门-让两个AI自行聊天完成任务31.DeepSeekV3+Roo Code,智能编码好助手32.使用Chainlit快速构建一个对话式人工智能应用体验DeepSeek-R133.AI工具推荐——open-interpreter

34.浏览器自动化与AI Agent结合项目browser-use初探

browser-use介绍

browser-use是将您的 AI 代理连接到浏览器的最简单方式。它通过提供一个强大且简单的接口来实现 AI 代理访问网站的自动化。

实践

上手也非常简单,创建一个python虚拟环境,pip install browser-use,再playwright install即可。

现在需要进行LLM的配置,官方推荐使用gpt-4o,但是为了降低成本,方便让看了教程感兴趣的人能够方便上手,这里我使用的是硅基流动提供的模型。目前硅基流动注册送14元不过期额度,够用一段时间的了,邀请链接:https://cloud.siliconflow.cn/i/Ia3zOSCU。如果你的额度不够了,但是也想体验一下,可以私聊我,我可以提供一个api key暂时供你快速上手体验,额度用差不多了,我就停止了。

创建一个.env文件,这样写:

Silicon_Cloud_API_KEY=xxx

Base_URL=https://api.siliconflow.cn

Model=Qwen/Qwen2.5-72B-Instruct

创建一个test脚本,这样写:

from langchain_openai import ChatOpenAI

from browser_use import Agent

from dotenv import load_dotenv

import os

load_dotenv()

import asyncio

api_key = os.getenv('Silicon_Cloud_API_KEY')

base_url = os.getenv('Base_URL')

model = os.getenv('Model')

llm = ChatOpenAI(model=model, api_key=api_key, base_url=base_url)

async def main():

agent = Agent(

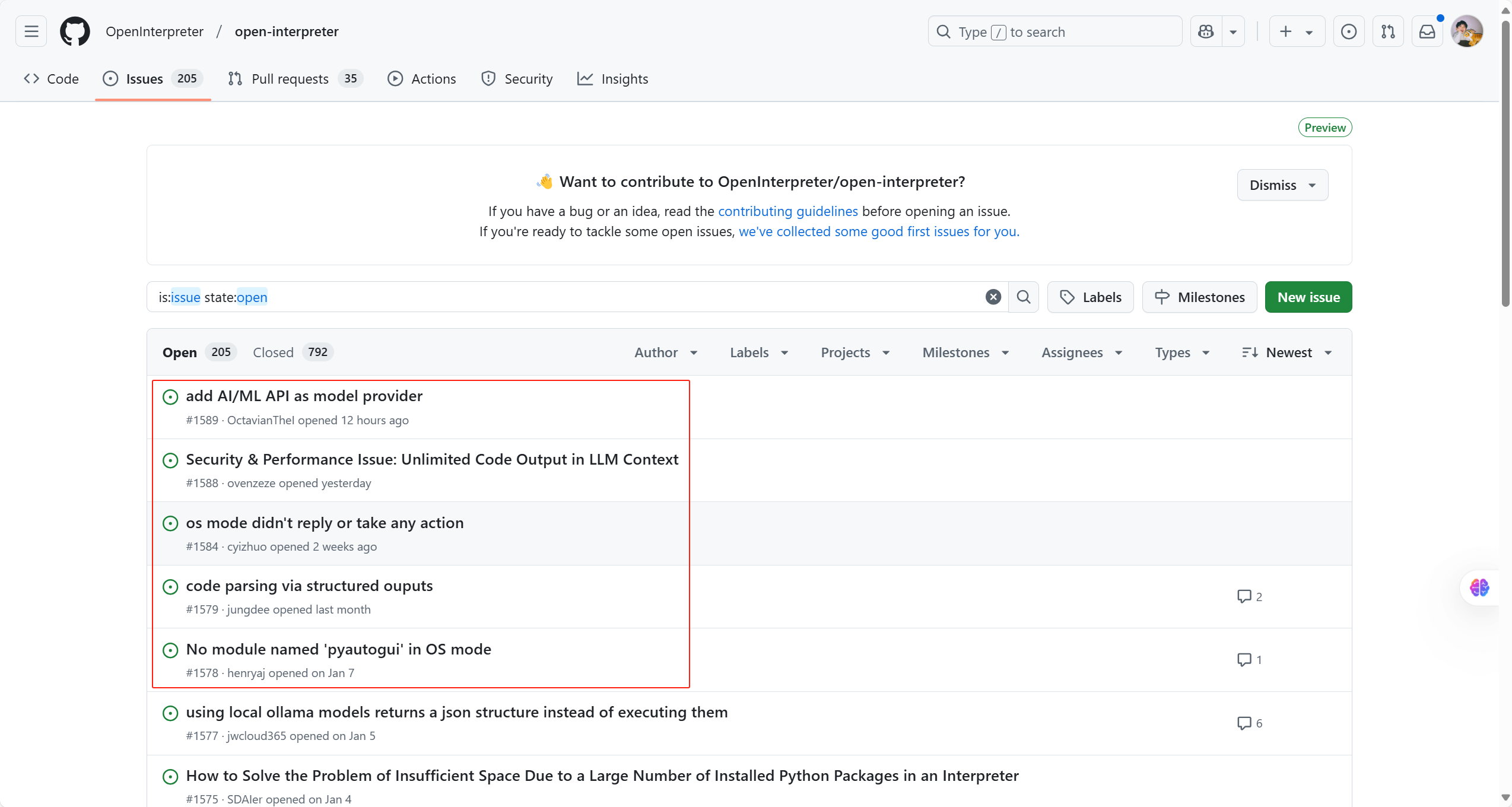

task="获取https://github.com/OpenInterpreter/open-interpreter仓库的前五个问题",

llm=llm,

use_vision=False,

)

result = await agent.run()

print(result)

asyncio.run(main())

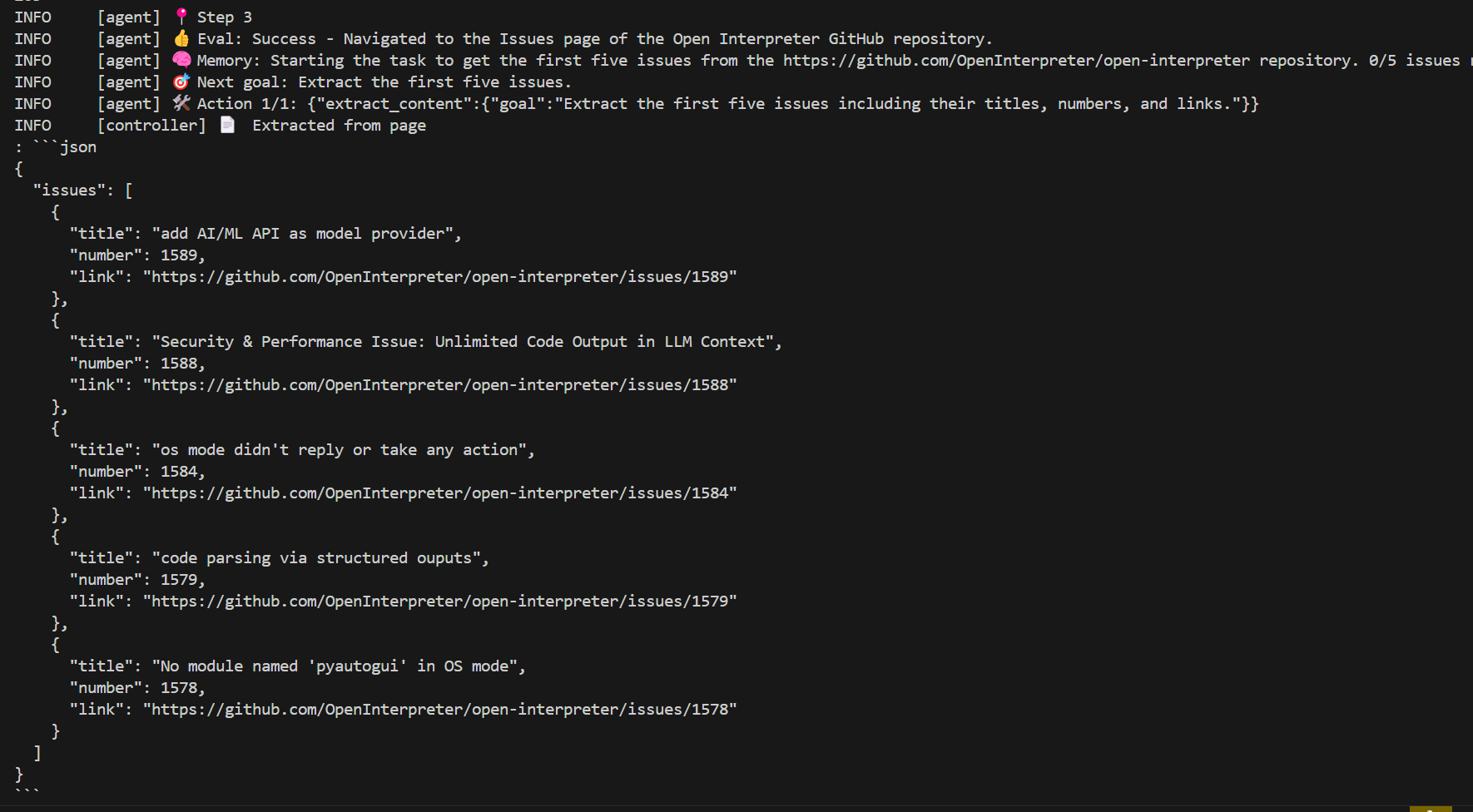

查看效果:

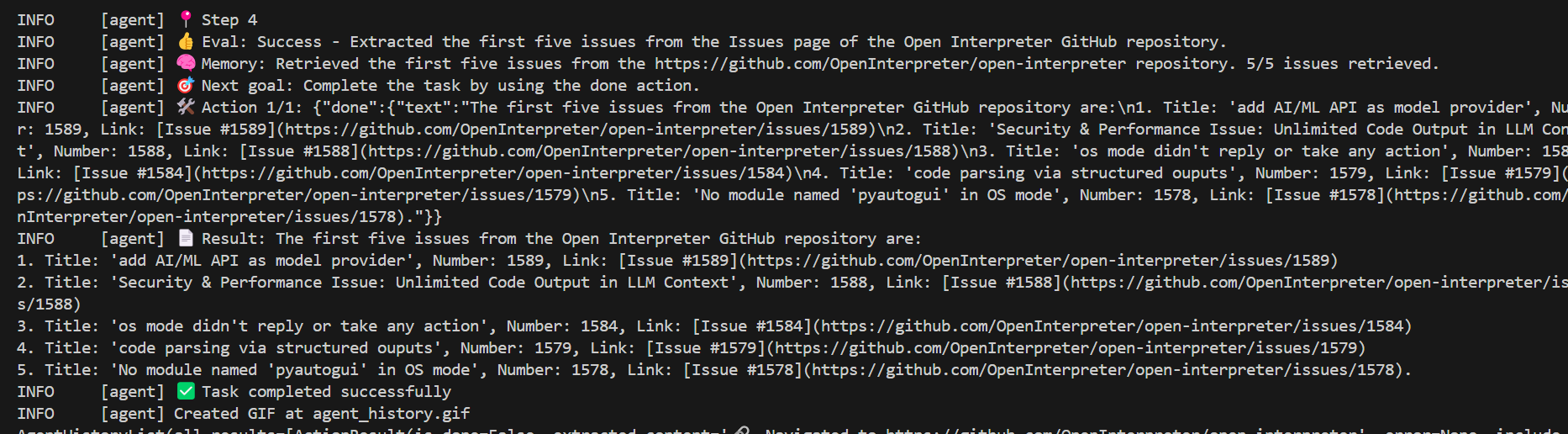

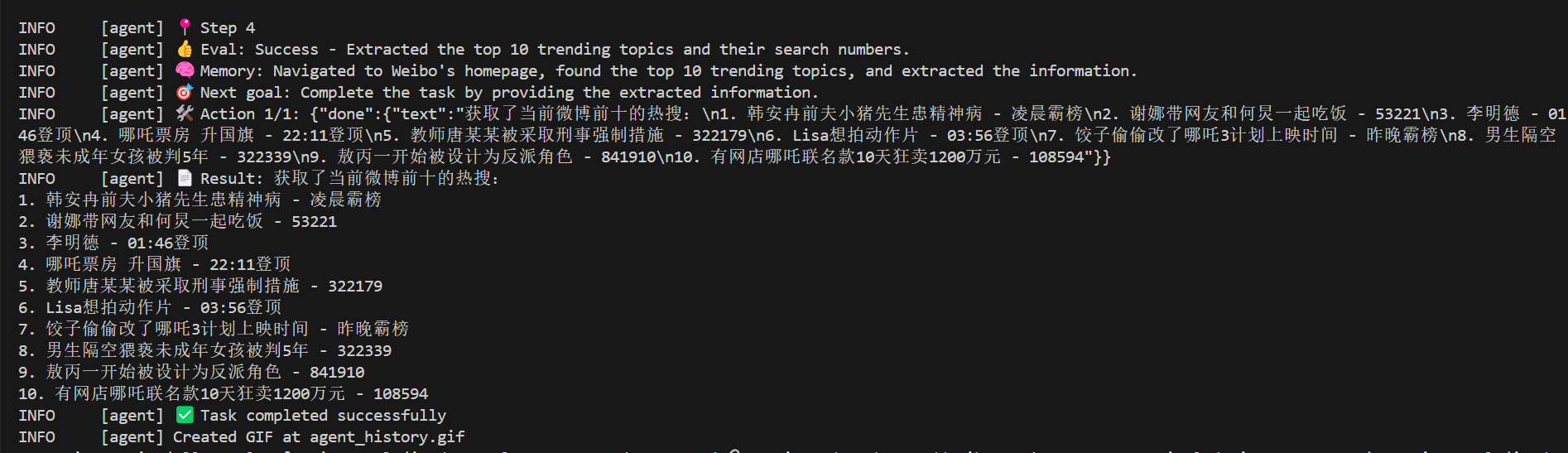

还生成了一个agent_history.gif可以查看流程:

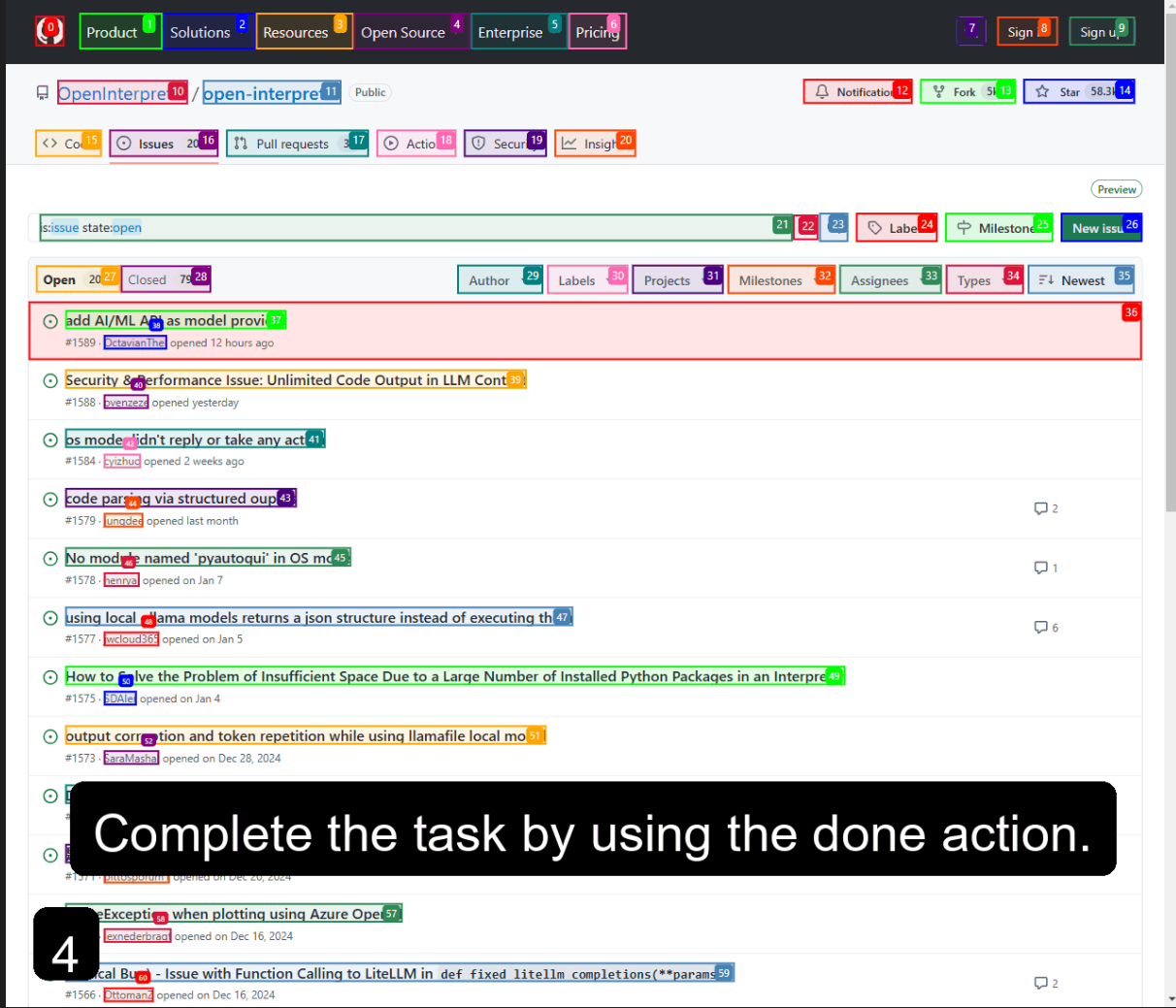

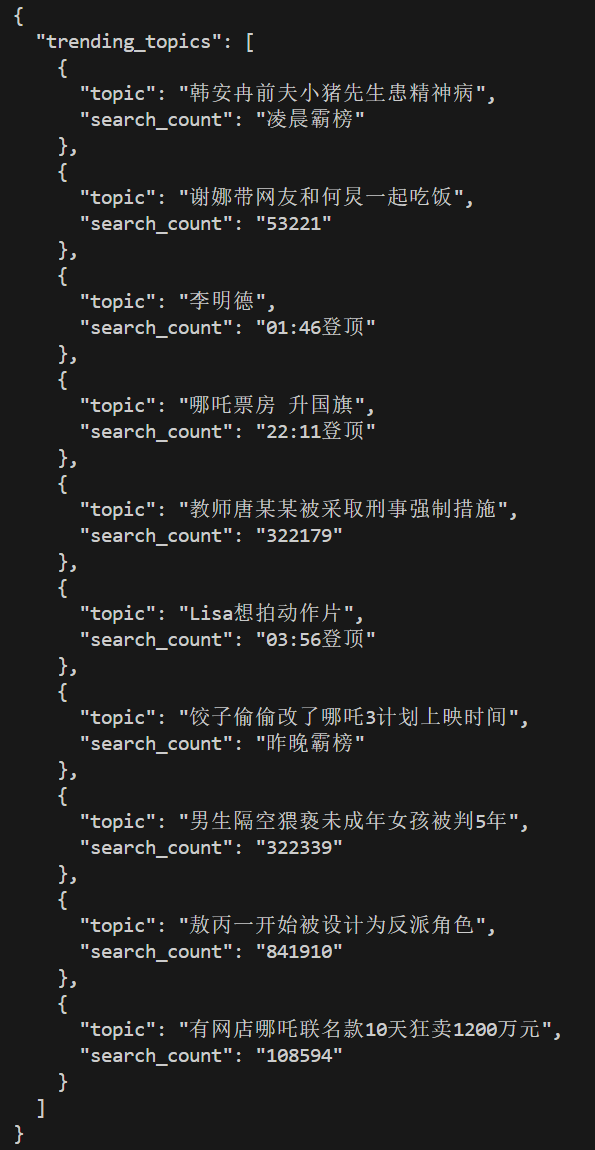

将结果与实际对比:

可以发现browser-use非常准确的获取了。

再使用一个更普遍的例子,就是获取当前微博前十的热搜。

from langchain_openai import ChatOpenAI

from browser_use import Agent

from dotenv import load_dotenv

import os

load_dotenv()

import asyncio

api_key = os.getenv('Silicon_Cloud_API_KEY')

base_url = os.getenv('Base_URL')

model = os.getenv('Model')

llm = ChatOpenAI(model=model, api_key=api_key, base_url=base_url)

async def main():

agent = Agent(

task="获取当前微博前十的热搜",

llm=llm,

use_vision=False,

)

result = await agent.run()

print(result)

asyncio.run(main())

最后

以上就是使用硅基流动中的Qwen/Qwen2.5-72B-Instruct快速体验browser-use的效果。初步体验感觉是一个很有潜力的项目,将AI Agent与浏览器自动化结合确实可以做很多事情。

【推荐】编程新体验,更懂你的AI,立即体验豆包MarsCode编程助手

【推荐】凌霞软件回馈社区,博客园 & 1Panel & Halo 联合会员上线

【推荐】抖音旗下AI助手豆包,你的智能百科全书,全免费不限次数

【推荐】轻量又高性能的 SSH 工具 IShell:AI 加持,快人一步

· DeepSeek-R1本地部署如何选择适合你的版本?看这里

· 开源的 DeepSeek-R1「GitHub 热点速览」

· 传国玉玺易主,ai.com竟然跳转到国产AI

· 揭秘 Sdcb Chats 如何解析 DeepSeek-R1 思维链

· 自己如何在本地电脑从零搭建DeepSeek!手把手教学,快来看看! (建议收藏)